Panne et paralysie mondiale : une mise à jour CrowdStrike provoque des bugs en cascade

SPOF !

Une gigantesque panne affecte actuellement de nombreuses structures, y compris de grosses entreprises, des aéroports et des hôpitaux. En cause apparemment, une mise à jour des logiciels de cybersécurité de CrowdStrike. Elle provoque des écrans bleus sur les machines équipées de Windows, ainsi que des redémarrages en boucle.

Le 19 juillet 2024 à 11h46

5 min

Sécurité

Sécurité

Partout dans le monde, des entreprises et autres structures rapportent être partiellement ou totalement bloquées. Une cyberattaque ? A priori non. Le problème vient d’une mise à jour déployée par CrowdStrike pour son EDR (détection et intervention sur les points de terminaison) Falcon Sensor. Des banques, des aéroports, des hôpitaux, des magasins, des chaines de télévision ou encore des organes de presse sont touchés.

Le symptôme est le même partout : un écran bleu de Windows et un redémarrage du système. Falcon Sensor étant un produit destiné aux entreprises, le grand public n'est pas censé être concerné.

De très nombreuses structures touchées

Les exemples sont très nombreux. Parmi les plus retentissants, la bourse de Londres, dont le service de nouvelles « est actuellement confronté à un problème technique global d'une tierce partie, empêchant la publication de nouvelles sur www.londonstockexchange.com ». De nombreux aéroports sont touchés, dont ceux de Berlin, Melbourne, Hong-Kong, Prague ou plusieurs en Inde. Aux États-Unis, tous les avions de Delta, United et American Airlines sont cloués au sol.

Citons également les groupes médias ABC aux États-Unis et Sky News au Royaume-Uni, dont les services sont perturbés. Même chose pour les trains au Royaume-Uni.

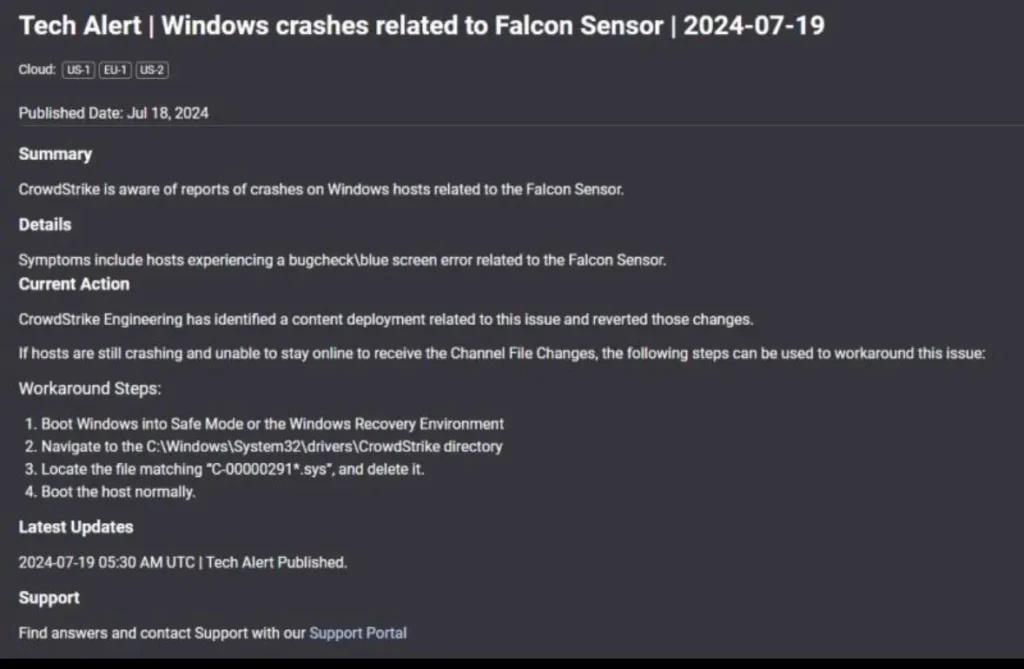

CrowdStrike au courant, un début de solution

CrowdStrike indique être au courant de la situation dans une note, qui réclame malheureusement un compte pour la lire. La société ajoute qu’elle enquête sur le problème, qui semble lié à un souci de déploiement. La modification a été annulée.

Sur Reddit, la solution présentée dans la page « cachée » de CrowdStrike est mise en avant. Elle consiste à :

- redémarrer Windows en mode sans échec

- se rendre dans le dosser C:\Windows\System32\drivers\CrowdStrike et à

- y effacer un fichier de type « C-00000291*.sys ».

Après le redémarrage, le problème disparaitrait. Mais, comme indiqué dans de nombreuses réponses sur Reddit : il est presque impossible d’accéder aux machines actuellement. En outre, la solution serait impossible à appliquer sur les machines où BitLocker (solution de chiffrement intégral de Microsoft) est actif.

En France, le CERT vient également de communiquer : « Le CERT-FR a été informé ce jour d'un incident majeur affectant les systèmes Microsoft Windows disposant de l'EDR CrowdStrike Falcon. Cet incident semble provoquer un écran bleu système entraînant un redémarrage du poste. À ce stade, le CERT-FR n'a pas d'élément indiquant que cet incident est lié à une attaque informatique ». Le Centre ajoute suivre « avec attention les évolutions de cet incident ». Même son de cloche à l’ANSSI, qui a mis en ligne un bulletin d’alerte.

La nouvelle pourrait fortement impacter CrowdStrike. Avant même l’incident, l’entreprise voyait son action chuter à cause de divers problèmes de valorisation. Hier, on a également appris que le cabinet d’analyse Redburn Atlantic baissait sa note pour CrowdStrike (et Palo Alto Networks), citant le prix trop élevé de son action et des conditions changeantes sur le marché.

Comment en est-on arrivés là ?

Sur X, le CEO de CrowdStrike, George Kurtz, a fini par prendre la parole :

« CrowdStrike travaille activement avec les clients touchés par un défaut détecté dans une seule mise à jour de contenu pour les hôtes Windows. Les hôtes Mac et Linux ne sont pas impactés. Il ne s’agit pas d’un incident de sécurité ou d’une cyberattaque. Le problème a été identifié, isolé et un correctif a été déployé. Nous renvoyons les clients au portail d'assistance pour connaître les dernières mises à jour et continuerons à fournir des mises à jour complètes et continues sur notre site Web. Nous recommandons en outre aux organisations de s'assurer qu'elles communiquent avec les représentants CrowdStrike via les canaux officiels. Notre équipe est pleinement mobilisée pour assurer la sécurité et la stabilité des clients CrowdStrike. »

De nombreuses questions restent cependant ouvertes. Dont la plus évidente : comment une telle mise à jour a-t-elle pu passer les différentes étapes de vérification ?

While current evidence points to a CrowdStrike update gone wrong — let's not forget that causing this level of outage, by a single application, should not be possible in the first place.

— Lars Veelaert (@larsveelaert) July 19, 2024

How did 1. Windows, 2. process isolation and 3. null-safe kernel code also fail to catch it?

Quelques heures auparavant, Microsoft avait des problèmes avec Azure et Microsoft 365, mais ils semblent désormais réglés et sans lien apparent avec les soucis du jour. Ces derniers viennent pour rappel d’une mise à jour de chez CrowdStrike, pas d’un problème chez Microsoft.

Panne et paralysie mondiale : une mise à jour CrowdStrike provoque des bugs en cascade

-

De très nombreuses structures touchées

-

CrowdStrike au courant, un début de solution

-

Comment en est-on arrivés là ?

Commentaires (128)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousLe 19/07/2024 à 12h00

Ce qui me semble bizarre, c'est que si c'est une mise à jour de l'agent (Falcon sensor ?), ca voudrait dire que toutes ces entreprises déploient les nouvelles versions dès leurs publications en automatique, étonnant.

Le 19/07/2024 à 12h29

Je suis comme toi surpris que des déploiements de ce type se fassent de manière totalement automatiques sans jamais passer par des serveurs de pré-prod de ces compagnies (pour les plus grosses d'entre elles).

Est-ce que cela touche uniquement les serveurs dans le Cloud et/ou on-premises ?

Le 19/07/2024 à 12h53

Le 19/07/2024 à 13h00

Même en prod, en règle générale, tu fais 1%, 10%, 25%... sur plusieurs lots, en évitant de mettre dans le même lot une machine et son backup identifié.

On ne parle pas de tatie Huguette, on parle de gros groupes avec des SI conséquents quand même :/

Le 19/07/2024 à 13h03

Le 19/07/2024 à 14h35

Le 19/07/2024 à 14h47

Il s'infiltre dans pas mal de pans du système, pour surveiller pas mal de choses, et fait de l'analyse heuristique pour détecter de potentielles attaques.

Pour faire tout ça l'outil a besoin d'un accès au noyau de Windows, probablement réalisé au moyen d'un driver qui tourne en kernel-space. Si celui-ci est buggé, c'est le BSOD quasi assuré.

Le 19/07/2024 à 15h55

discutent 'Techniques de développement'.

Le premier dit au second 'Moi, ça me coûte un fric et un temps fou de tester mes

logiciels avant de les commercialiser'.

L'ingénieur Microsoft lui réponds 'Tu testes tes logiciels toi-même ? T'as pas

de clients pour faire ça ?'

Le 19/07/2024 à 21h30

Des écrans bleu liés a un driver système on a pas fini d'en voir vu ce qu'implique l'architecture les utilisant.

Modifié le 19/07/2024 à 12h03

C'est assez affolant qu'une telle panne puisse arriver et la solution de passer par le mode sans échec un peu inquiétante, vu le nombre de postes / serveurs potentiellement impactés :-/

Un beau strike !

EDIT : concernant la panne Azure, c'est visiblement (encore) lié à un changement de configuration qui a fait tout planté :

https://www.bleepingcomputer.com/news/microsoft/major-microsoft-365-outage-caused-by-azure-configuration-change/

Le 19/07/2024 à 12h21

Passer en mode sans échec, c'est la galère, sur une flotte de PC, difficile à faire faire par un utilisateur, et le service IT peu pas physiquement allez sur toutes les machines rapidement.

Le 19/07/2024 à 12h14

https://securite.developpez.com/actu/360418/Les-entreprises-omettent-la-moitie-du-temps-d-evaluer-la-securite-des-principales-mises-a-jour-des-applications-logicielles-car-cela-est-complique-couteux-et-prend-du-temps-d-apres-CrowdStrike/

Le 19/07/2024 à 12h21

Le 19/07/2024 à 12h27

Le 19/07/2024 à 12h23

Toute solution "full disk encryption" doit pouvoir permettre l'accès offline à mes yeux.

Avec VeraCrypt, pas de problème. Avec LUKS on va un cran plus loin, possible de réinstaller l'OS sur le disque chiffré. Évidemment pour VeraCrypt, pas leur faute. Et encore, je n'ai jamais essayé, c'est peut-être possible (mais ça me semble douteux).

Le 19/07/2024 à 12h26

Le 19/07/2024 à 12h30

Donc pour une boite, ça implique un tech qui fait la manipulation sur chaque PC de la flotte (et des gens en présentiel)

Le 19/07/2024 à 12h57

Le plus simple est de ne pas déployer des mises à jour sur des systèmes de prod sans les tester avant...

Le 19/07/2024 à 12h34

Modifié le 19/07/2024 à 12h59

Et si le support lui-même n'a pas ses clés, c'est qu'ils se sont loupés quelque part.

Pour les particuliers, par défaut la clé est sauvegardée dans le compte Microsoft de l'utilisateur, sinon c'est que l'utilisateur a choisis de configurer ça autrement et a opté pour une autre méthode de backup de la clé.

Le 19/07/2024 à 13h08

Le 19/07/2024 à 14h35

Un jour, lors d'une recherche de clef BT dans AD, on constaté qu'à partir d'une date inconnue, AD avait arrêté de les stocker, sans changement de l'option le lui demandant... Étant fan de la technique dite ceinture + bretelles, j'avais continué à les sauvegarder en txt, du moins celles que j'avais généré.

Moralité, méfiez vous du backup AD des clefs BT ;)

Le 19/07/2024 à 13h16

Le 19/07/2024 à 13h19

Le 19/07/2024 à 13h27

En tout cas il le proposait quand j'avais testé, dans un fichier qu'on garde ensuite où on veut, mais j'ai pas testé de le faire à l'installation.

Le 19/07/2024 à 13h32

Sauf si tu es sur un réseau entreprise, où elle est directement stockée dans le contrôleur de domaine.

Modifié le 19/07/2024 à 13h56

En entreprise, c'est un faux problème, la clef doit remonter sur le contrôleur de domaine, comme dit plus haut.

Le même contrôleur qui est hautement à risque, donc rarement seul doit surement très bien être backupé. Donc si le seul DC est touché, il faut taper dans les sauvegardes.

Mais vu la taille des groupes concernés, ce serait juste dément de n'avoir qu'un DC et d'y déployer des MAJ d'agent en auto dès leur mise à dispo. Surtout que dans le cas présent, je pense même que certains ont les clés dans Azure AD...

En tous cas ca pourrait bien finir en procès cette affaire.

Modifié le 19/07/2024 à 13h57

Ils ont balancé leur maj sur 100% des machines sur la planètes, c'est juste WTF...

Pour cela que c'est le chaos un peu partout...

Le 19/07/2024 à 14h19

Mais ca ne change pas qu'ils doivent pouvoir utiliser leurs backup de DC, par contre forcément ca demande un peu de temps... Au final, quoi qu'on en dise, mettre son AD en Hybride MS entra, c'est pas déconnant au final.

Modifié le 19/07/2024 à 15h23

"Ils ont balancé leur maj sur 100% des machines sur la planètes, c'est juste WTF..."

Je savais pas que CrowdStrike était installé sur les ordinateurs du monde entier !!! Et ils se sont pas encore pris de procès pour position monopolistique ?!

"c'est Crowdstrike qui décide les maj, personne n'a la main dessus..."

A priori les clients avaient la main pour décider de ne pas installer sur leur prod un outil sur lequel ils n'ont aucun contrôle... (je parle des décideurs, pas des admins sys qui vont subir la crise)

Modifié le 19/07/2024 à 15h22

Le 19/07/2024 à 21h35

Le 20/07/2024 à 05h38

Le 22/07/2024 à 14h14

En gros, lorsque l'on branche un disque chiffré avec Bitlocker (ça peut être un disque interne comme une clé USB), Windows va demander de saisir le mot de passe du disque, mais on peut également saisir la clé de secours (qui est celle que Microsoft nous demande de sauvegarder lors de l'activation de Bitlocker).

Le 22/07/2024 à 17h14

Le 19/07/2024 à 12h24

Je vais être le premier à dire que la sécurité c'est primordial, notamment faire rapidement les mises à jour, mais rien ne doit être poussé en prod sans contrôle !

Le 19/07/2024 à 13h07

Le 19/07/2024 à 15h00

Le truc c'est que le Falcon Agent c'est un peu comme un "antivirus" donc c'est CrowdStike qui "pousse" les maj et pas le client qui les "tire". Quand ça marche bien c'est très bien, quand ça foire ... ça foire très bien aussi :p

Le 19/07/2024 à 15h16

Le 22/07/2024 à 06h58

Modifié le 19/07/2024 à 18h51

Après, dans les sociétés impactées, il y en a beaucoup qui doivent avoir les moyens de réaliser cela, or celà n'a pas été fait (peut-être une impossibilité dans CrowdStrike d'après certains commentaire).

Moi, ce qui me surprend, ce n'est pas que Windows plante. Comme indiqué, c'est le pendant d'un driver de bas niveau si celui-ci est défectueux.

Là, c'est plutôt que ce drivers plante en lisant une base de définition qui m'interpelle. Cette base aurait pu être corrompue par d'autres moyen qu'une mise à jour et donc les développeurs auraient dû prévoir ce cas dans leur logiciel.

Le 19/07/2024 à 22h21

Oui ça coute de l'argent de bien faire les choses. Ça coute combien quand on fait mal les choses et qu'on se prend ce genre d'incident dans les dents ?

"Cette base aurait pu être corrompue par d'autres moyen qu'une mise à jour et donc les développeurs auraient dû prévoir ce cas dans leur logiciel"

Alors, le mauvais développeur, on lui donne des specs, et il code. Alors que le bon développeur, tu vois, on lui donne des specs et il code, mais c'est un bon développeur.

Plus sérieusement, il y a clairement eu des lacunes côté dev et QA. Mais bon tu comprends, les tests unitaires c'est chiants.

Le 19/07/2024 à 12h24

Microsoft : -2%

Microsoft a une part de responsabilité importante dans ce fiasco. La solution manuelle de restauration n'est pas au niveau attendu pour une telle entreprise.

Le 19/07/2024 à 12h29

Le 19/07/2024 à 12h39

Le 19/07/2024 à 13h00

Le 19/07/2024 à 13h23

L'outil surveille un peu tout ce qui se passe sur les machines :

*Les adresses locales et externes auxquelles l’hôte est connecté

Tous les comptes utilisateur qui se sont connectés sur site et à distance

Un résumé des modifications survenues au niveau des clés ASP, des fichiers exécutables et de l’utilisation des outils d’administration

L’exécution des processus

Des informations récapitulatives et détaillées sur l’activité réseau associée aux processus, notamment les requêtes DNS, les connexions et les ports ouverts

La création de fichiers d’archives, notamment aux formats RAR et ZIP

L’utilisation de supports amovibles*

Pour pouvoir faire ça, il faut des droits importants au niveau de la machine. Comme la solution pour supprimer le problème est de supprimer un fichier .sys, on en conclut qu'ils ont développé un driver Windows faisant cela et que c'est lui qui génère un BSOD. De toute façon, il me semble qu'il n'y a que les drivers qui génèrent des BSOD.

Je ne suis plus/pas trop au courant de ce qui est exigé de la part de Microsoft pour la certification des drivers et c'est peut-être là la faiblesse chez eux, mais un driver de ce type (qui ne gère pas forcément du matériel, c'est un peu complexe à qualifier pour Microsoft ; c'est donc à celui qui le fournit de le qualifier sérieusement.

L'idéal serait que Microsoft offre des services pour les applis de ce type pour accéder aux données et interdise ce genre de driver, un peu comme les antivirus s'appuient maintenant sur des services Windows.

Modifié le 19/07/2024 à 14h11

Je ne sais pas non plus, mais qqsoit la couverture de test (jamais 100%) simplement avoir prévu un mécanisme de probation (par exemple ne pas avoir une poignée de redémarrages impromptus consécutifs suite à un problème kernel bloquant) qui, s'il n'est pas atteint, va provoquer un retour à l'état antérieur à la dernière mise à jour de manière automatique c'est pas non plus le Pérou! En fait, dans l'embarqué tout le monde fait cela...

Le 19/07/2024 à 12h40

Tout comme l'étaient les BSOD à cause des drivers mal codés en 1998.

L'impréparation des services IT est également en cause oui, et bien évidemment CrowdStrike en 1er lieu.

Le 19/07/2024 à 13h02

Le 19/07/2024 à 13h25

Remarque : comme c'est une solution cloud, je ne suis même pas sûr qu'il soit possible de gérer soi-même les mises à jour.

Le 19/07/2024 à 15h34

Le 19/07/2024 à 14h23

Le 19/07/2024 à 14h40

Depuis pas mal d'années, les seuls vrais moyen d'avoir des BSOD c'est soit un problème matériel, soit un soft buggé avec accès noyau, souvent des drivers (et encore, de nos jours beaucoup de drivers ne tourne même plus en kernel-space, mais en user-space, et d'ailleurs ça a gueulé quand MS a mis ça en place).

SI sur un système Linux tu vas modifier le système pour charger un module noyau buggé qui cause des kernel panic, il va pas se retirer tout seul non plus. Il va falloir booter en init 1 et virer le module. Et à aucun moment ce ne serait la faute des dev du kernel Linux, juste du dev du module et du gars qui l'a déployé.

Le 19/07/2024 à 21h26

Le 19/07/2024 à 22h33

Oui il y a des ES qui ont des double bootrom, et qui switchent en cas de souci, mais ce n'est pas non plus la norme.

Les gars de Crowdstrike ils font mumuse avec le noyau, et ce serait à Microsoft de prévoir des garde-fous dans le noyau au cas où ils se plante ? Ce que Microsoft a fait c'est de virer du kernel-space tout ce qu'ils ont pu (et les gens étaient pas content), et c'était la bonne chose à faire. Pour ceux qui doivent rester en kernel-space pour des raisons d'accès spécifiques et/ou de performances, ils ont mis en place la certification WHQL. Après, quand on touche au noyau, ça reste toujours risqué.

Je veux bien que tu me donnes un exemple d'OS serveur qui serait capable de se sauver tout seul si la même chose arrivait. Clairement Linux ce n'est pas le cas, macOS ça fait longtemps que je ne m'y intéresse plus, mais de mémoire ce n'était pas le cas (il me semble avoir lu ailleurs dans les commentaires qu'ils n'autorisent juste plus les kernel extensions, à vérifier).

Le 19/07/2024 à 14h46

- Un PRA n'est pas un PCA ; dans une telle situation, la reprise d'activité est quasi garantie à moyen terme et "quelques heures/jours" ça peut être un risque accepté par la direction.

- Même un bon PRA/PCA peut ne pas suffire dans une telle situation ; typiquement, si la sauvegarde est gérée par une infra MS (avec Veam ou une autre solution), rétablir les sauvegardes peut s'avérer compliqué si le système est dans une salle distante (voire nécessitant un processus avec des accréditations et des contrôles qui peuvent être contraints eux-mêmes pas la situation).

- Normalement, les clés de déchiffrement des serveurs critiques doivent être dans un coffre fort physique ; en pratique, c'est rarement le cas (ou il peut y avoir des soucis d'accès au coffre, surtout en période estivale ou de mid-year)

- Ici, j'ai envie de dire que le responsable est uniquement CrowdStrike. On peut imputer une partie de la responsabilité à MS pour ne pas avoir de mécanisme d'isolement, mais les solutions d'EDR sont parfois implantées dans le système avec des stratégies similaires à des rootkits, donc on est peut-être dans une situation où l'OS n'est pas en mesure de lever correctement les bonnes barrières (et peut-être que le BSOD/reboot est justement la seule barrière qui reste à l'OS pour se protéger et protéger le système)

Modifié le 19/07/2024 à 15h32

Le 19/07/2024 à 18h08

C'est problématique à bien des niveaux (sécurité de l'infra, sécurité des données de l'entreprise, problèmes relatifs à la vie privée des employés...).

Les solutions d'EDR internalisables sont moins courantes (et nécessitent une équipe de supervision connectée de façon permanente, ce que les entreprises ont du mal à assumer).

Le 19/07/2024 à 20h26

Le 19/07/2024 à 12h27

Le 19/07/2024 à 12h28

Ça concerne uniquement les clients ou les Windows servers sont aussi touchés ?

Le 19/07/2024 à 12h37

Le 19/07/2024 à 13h06

Le 19/07/2024 à 14h00

Généralement tu balances juste des stratégies différentes sur Desktop / Laptop / Serveur..

Le 19/07/2024 à 14h22

l'EDR fait de l'analyse comportementale pour remonter des actions suspectes sur un PC (genre ouvrir tous les fichiers excel et remplacer le contenu par autre chose en 3sec), exécuter des scripts en admin allant télécharger du code sur internet etc..

Le 19/07/2024 à 16h07

Je sais aussi que mon Sophos (pro) par exemple à une partie EDR.

Bref les différences me paraissent pas super claires.

Le 19/07/2024 à 16h34

Pour l'EDR, c'est probablement une évolution "spécialisée" de cette fonction tout en ajoutant de de nouveaux services.

on tend à séparer les fonctions antivirus et annexes pour mieux vendre plusieurs produits :)

trouvé dans les liens sources de wikiceci dit il n'y a pas que Crowstrike dans le monde de l'EDR... Qualys, fireeye, même Trend

Le 19/07/2024 à 16h38

Le 19/07/2024 à 16h44

C'était moins le cas avec les AV "à l'ancienne" qui se contentaient de scanner les fichiers et comparer leurs signature avec une base de données, mais avec la multiplication des méthodes de détection, et les actions de réponse aux détections, les outils interagissent de plus en plus avec le noyau pour récupérer les infos dont ils ont besoin, et effectuer les actions de blocage des menaces.

Le 19/07/2024 à 16h45

Le 19/07/2024 à 12h28

Coucou @sebsauvage https://sebsauvage.net/links/?v1ki1w 😋

Le 19/07/2024 à 12h39

Même si MS n'est pas la cause principale, Windows montre une fragilité là.

Le 19/07/2024 à 13h18

Comme déjà dit plus haut, c'est pas spécifique à Win, les Kernel Panic sous Linux, ça existe aussi ...

Modifié le 19/07/2024 à 13h52

Tout ce qui remonte upstream (l'immense majorité de ce qui existe) est quand même bien contrôlé et au niveau source car c'est une boite-blanche, pas juste du test comme dans un modèle boite-noire/sources-fermés.

Certes, il est possible de coder et même distribuer (tant qu'on n'utilise pas du EXPORT_SYMBOL_GPL) ses modules noyau fermés pour Linux, mais on a alors un joli "kernel tained" dans le tampon de message au boot et bon courage pour obtenir de l'aide avec cela! Ce sera demerden zizich...

Modifié le 19/07/2024 à 13h58

https://support.apple.com/fr-fr/guide/deployment/depa5fb8376f/web

Donc si c'est la faute à Microsoft de continuer à permettre ce genre de choses… Là pour des raisons de sécurité (ou contre la triche pour les jeux vidéos).

Modifié le 19/07/2024 à 15h08

Alors oui, on peut aussi tout bloquer tout interdire, ca limite les risques.

Et clairement, j’ai du mal à comprendre cette notion de toute de suite comparer à Linux ou Mac OS, comme si ces deux n’avaient pas aussi leurs propres problèmes. Et clairement si Mac OS avait 78% de PDM sur son domaine, Apple découvrirai plein de problématiques et ferait surement des choix différents, qui sait..

Le 19/07/2024 à 14h24

Le 19/07/2024 à 15h08

En effet, merci j'ai corrigé.

Le 19/07/2024 à 14h33

Rappel historique:

1) Billy-Bug-Gates au Comdex 1998:

"Si General Motors avait eu la même progression technologique que l’industrie informatique, nous conduirions aujourd’hui des autos coûtant 25 dollars et qui parcourraient 1000 miles avec un seul gallon d’essence."

2) Réplique du PDG d'alors de GM:

"Si General Motors avait développé sa technologie comme Microsoft, les voitures que nous conduirions aujourd’hui auraient les propriétés suivantes :

-Votre voiture aurait un accident sans raison compréhensible 2 fois par jour.

-Chaque fois que les lignes blanches seraient repeintes, il faudrait racheter une nouvelle voiture.

-Occasionnellement, une auto quitterait l’autoroute sans raison connue [1]. Il faudrait simplement l’accepter, redémarrer l’auto et reprendre la route.

-Parfois, lors de manoeuvres particulières, comme par exemple prendre une courbe a gauche, l’auto ferait un simple tout droit puis refuserait de repartir. Pour cela, il faudrait procéder à un échange standard du moteur.

-Les autos ne seraient livrées qu’avec un seul siège, car il faudrait choisir entre "Car95" et "CarNT". Chaque siège supplémentaire devrait être commandé à l’unité.

-Macintosh développerait des voitures fonctionnant à l’énergie solaire, fiable, cinq fois plus rapides et deux fois plus légères. Mais elles ne pourraient emprunter que 5% des routes.

-Les témoins d’huile, de température et de batterie seraient remplacés par un unique témoin "Défaillance Générale". Les sièges exigeraient que chaque passager ait la même taille et le même poids.

-L’airbag demanderait "Êtes-vous sûr ?" avant de s’ouvrir. Occasionnellement la condamnation centralisée de la voiture se bloquerait. Vous ne pourriez alors la rouvrir qu’au moyen d’une astuce, comme par exemple simultanément tirer la poignée de porte, tourner la clé dans la serrure et d’une autre main attraper l’antenne radio.

-General Motors vous forcerait à acheter avec chaque voiture un jeu de cartes routières Deluxe de la société Rand McNally (depuis peu filiale de GM), même lorsque vous ne souhaitez pas ou n’avez pas besoin de ces cartes. Au cas ou vous ne prendriez pas cette option, la voiture roulerait 50% moins vite (au mieux). A cause de cela, GM deviendrait une cible fréquente de procès.

-A chaque fois que GM sortirait un nouveau modèle, chaque conducteur devrait réapprendre à conduire, car aucune des commandes ne fonctionnerait exactement comme dans les modèles précédents.

-Enfin, il faudrait appuyer sur le bouton "Démarrer" pour stopper le moteur."

Bon, vu ce que deviennent les bagnoles avec Tesla qui fait de véritables dumb-phones sur roues... les temps changent! Ta bagnole te mettra toute seule dans le mur, idéalement sans te laisser une chance (qui peut se jouer en quelques dixièmes de secondes) de reprendre la main.

Le 19/07/2024 à 15h10

Le 19/07/2024 à 14h32

La plupart des autres OS (Windows, Linux et autre) sont plus permissifs sur ce que tu peux installer, mais cela implique d'être plus responsable sur ce qu'on installe.

Le 19/07/2024 à 14h39

Le 19/07/2024 à 14h51

Le 19/07/2024 à 14h20

Le 19/07/2024 à 12h45

N'empêche que CrowdStrike qui ne test pas ses produits c'est complétement fou !

Les conditions pour que la panne survienne ne semblent pas être si complexes que ça, ce qui rend la situation encore plus dommageable pour l'entreprise de l'EDR.

La communication du PDG me semble vraiment pas super. Préciser que c'est dans une seule mise à jour, sonne comme un "On reste bon puisque ça n'arrive que sur une mise à jour".

Modifié le 19/07/2024 à 13h05

Et on est content de pas avoir Crowdstrike sur nos PC, uniquement sur les serveurs...

Bon, on va devoir changer d'EDR en tout cas, ils vont pas survivre à cela

Le 19/07/2024 à 13h13

Le 19/07/2024 à 13h55

Le 19/07/2024 à 15h50

Le 19/07/2024 à 13h20

On voit les limites d'un réseau homogène. C'est tout ou rien. On diversifie ou on utilise le meêm produit pour tout

Modifié le 19/07/2024 à 14h50

Sans minimiser le raté monumental de CrowdStrike sur ce coup, qui doit bien faire payer cher sa solution, dans le cas d'une protection

antivirusEDR, on peut aussi considérer qu'un déploiement rapide est parfois nécessaire. Une fois que t'as identifié une menace, difficile de se dire qu'on va attendre 3 mois pour déployer sur l'ensemble des postes protégés !Évidemment, ça n'empêche pas que le truc doit être testé avant.

Le 19/07/2024 à 13h55

Le 19/07/2024 à 20h57

Le 19/07/2024 à 14h05

Le 19/07/2024 à 15h12

Le 19/07/2024 à 14h24

Le 19/07/2024 à 14h57

Et oui, on se demande comment un truc pareil a pu passer ...

Le 19/07/2024 à 14h59

- https://access.redhat.com/solutions/7068083

- https://forums.rockylinux.org/t/crowdstrike-freezing-rockylinux-after-9-4-upgrade/14041

Bref, Linux, c'est aussi de la merde codé avec les pieds ^^

(ce troll est sponsorisé par Trolldi, le jour où le troll est permis \o/)

Le 19/07/2024 à 15h57

« Microsoft équipe des armes françaises et le ministère de la Défense. Tout va bien ? Vous comprenez enfin ce que veut dire indépendance nationale et souveraineté ? », s’est par exemple insurgé Jean-Luc Mélenchon sur X

Modifié le 19/07/2024 à 16h05

1) ça se saurait

2) on n'aurait jamais eu le pare feu OpenOffice

[edit]

Pour être sérieux 2min (promis, pas plus) :

- une solution souveraine n'aurait pas empêché ce type d'incident de survenir

- un problème survenant n'aurait alors touché que la France, pas le reste du monde.

Le côté souverain n'aurait protégé de rien du tout ici

Modifié le 19/07/2024 à 18h16

La licence de Windows interdit l'usage de Windows pour commander une arme.

Et quand on sait que des systèmes de défense du porte avion Charles de Gaulle sont contrôlé par des ordinateur sous Windows, ca laisse rêveur.

- Chef, y a un missile qui se dirige vers nous.

- M'embête pas je dois redémarrer Windows après une mise à jour .....

Scène fictive. Toute ressemblance .....

Le 19/07/2024 à 21h01

Le 19/07/2024 à 16h43

Apparemment ça dépend des dates, certaines maj plantent certain OS.

Le 19/07/2024 à 15h16

Lu sur leur site https://www.crowdstrike.com/fr-fr/Même pas des Russes, je suis déçu

Et un petit pour la route:

https://framapiaf.org/@bronco/112812608310071326

Le 19/07/2024 à 15h29

Vécu de l'intérieur ce matin vers 06h30. Je bosse dans une chaine TV. Quand la régie finale m'a appelé et que je vais vu le carnage

Le 19/07/2024 à 15h33

Le 19/07/2024 à 15h56

discutent 'Techniques de développement'.

Le premier dit au second 'Moi, ça me coûte un fric et un temps fou de tester mes

logiciels avant de les commercialiser'.

L'ingénieur Microsoft lui réponds 'Tu testes tes logiciels toi-même ? T'as pas

de clients pour faire ça ?'

Le 19/07/2024 à 18h38

Le 19/07/2024 à 19h21

L'arrivé au taf à 7h30 avec toutes les VMs KO, j'ai adoré !

Le 19/07/2024 à 19h32

Le 19/07/2024 à 19h43

surtout qu'à la base, je savais pas si c'était une panne de courant, un ransomware, ou autre.

c'est un collègue qui regarde l'erreur, voit le pilote en cause et me dit " ah mais c'est Crowdstrike, ma femme a ça mais pas sur un serveur mais sur son PC" et ensuite on a réalisé que c'était mondial.

Le 19/07/2024 à 21h32

Les conséquences prévisibles :

- CrowdStrike va être attaqué pour obtenir des réparations

- Des DSI vont changer de fournisseur rapidement

- Pour une partie de celles qui ne veulent pas le faire, la direction exigera un changement de fournisseur.

- Leur cours de bourse va baisser ces prochains mois quand les conséquences inéluctables pour CrowdStrike apparaitront plus clairement aux investisseurs et ils finiront racheté pour une poignée de dollars.

Pourquoi ? Parce qu'ils ont déployé chez tous leurs clients une mise à jour pas testée.

Au final il risque d'y avoir un changement sur l'acceptabilité de ce que peux faire les solutions de sécurité.

Le 19/07/2024 à 23h15

Humm attention, certains pourraient dire "Finalement, à qui profite le crime?"! ;)

Le 19/07/2024 à 23h04

Chez nous, tous nos postes clients et serveurs sont protégés avec bitlocker (clés en bdd mecm) et laps.

On a des milliers de postes clients touchés dont

des centaines postes isolés tournant dans des centres commerciaux avec personne pour aller virer le driver sys.

Juste avant un week-end on va perdre un max d’argent…

Plein de nos sites de production à l’arrêt avec leurs IT partis en vacances.

Et même sur nos sites commerciaux, avec tous les teletravailleurs et it en vacances ça va être une misère à organiser (coucou Paris avec les JO et le télétravail obligatoire jusqu’a fin août…)

Pour l’instant on a réussi à by-pass bitlocker en faisant démarrer les postes clients en recovery et en modifiant le démarrage avec bcdedit mais même comme ça je vois ps trop comment nos supports vont organiser ça avec nos utilisateurs…(surtout avec nos politiques de génération de mdp laps claquées du fion)

Sinon, on a eu aussi des milliers de serveurs impactés avec qqs serveurs physiques également sans idrac et sans IT non plus <3

Un régal.

PS: ceux qui s’étonnent que les maj soient poussées automatiquement sur l’ensemble des potes d’une entreprise, on parle pas ici de pousser la maj d'un client hein, on parle de maj des bases.

Modifié le 20/07/2024 à 10h12

Même les scénaristes d’Hollywood n’auraient sûrement pas imaginé une histoire aussi abracadabrantesque et hors sol…

La réalité a dépassé la fiction ici…

.

Modifié le 20/07/2024 à 10h32

Certaines fonctions avaient une parenthèse "(" dans le début de la fonction de maths de pré-affiché… Si on avait le malheur de finir l’expression avec un ], là c’était blocage complet et hard/factory reset (soit en une seconde seulement des heures évaporées à rentrer à la main toutes les formules de maths/physiques de 2 années de cours).

J’avais montré le bug à un camarade de classe sur sa HP, ben il n’avait pas aimé, mais alors vraiment pas du tout… le factory reset...

.

Le 22/07/2024 à 09h10

Amstrad a tout géré à la Amstrad: correction (manuelle au début) du mode d'emploi pour l'indiquer.

Le 22/07/2024 à 09h47

Le 22/07/2024 à 13h04

Le 22/07/2024 à 20h09

Modifié le 23/07/2024 à 10h48

Le 20/07/2024 à 13h21

des millions d'appareils touchés, pendant des heures.

le PDG avait carrément fait des excuses publiques sur youtube à l'époque.

pas mieux que bitdefender en l'année d'avant..

Le 22/07/2024 à 11h29

ya un tool en WINPE fait par MS pour aider les admin locaux

https://go.microsoft.com/fwlink/?linkid=2280386

microsoft-releases-windows-repair-tool-to-remove-crowdstrike-driver/

Le 22/07/2024 à 12h16

Le 22/07/2024 à 12h22

il y a surement la version de la N*A avec bypass bitlocker, mais ils se sont dit que diffuser la clé magique qui déverrouille tous les disques ça la foutait mal

Le 23/07/2024 à 10h49

Le 23/07/2024 à 11h18