Hybrid Immersion Liquid Cooling d’OVHcloud : une baie 48U avec des serveurs watercoolés et immergés

Plouf !

Le 13 octobre 2022 à 08h55

6 min

Sciences et espace

Sciences

Afin de réduire la consommation électrique de ses datacenters (et ainsi améliorer son PUE), OVHcloud présente une « nouvelle » manière de refroidir ses serveurs. En plus du watercooling pour les CPU et GPU, la carte mère est plongée dans un fluide diélectrique. Explications.

Depuis près de 20 ans, OVHcloud exploite du watercooling au sein de ses datacenters. Nous vous avions d'ailleurs expliqué le mode de fonctionnement de l'hébergeur lors d'une visite de son datacenter Roubaix 4 il y a une dizaine d'années déjà. Aujourd'hui, la société passe au cran du dessus avec l'immersion des serveurs dans un fluide diélectrique. Ce n'est pas une surprise, puisque Octave Klaba avait déjà vendu la mèche fin 2020 et de nouveau en octobre 2021.

Quoi qu'il en soit, l'entreprise communique officiellement sur le sujet et explique avoir développé son propre système afin « d'atteindre plusieurs objectifs allant de l'amélioration de l'empreinte du datacenter à la réduction de la consommation d'énergie, afin de s'adapter aux nouvelles conditions d'exploitation et pour améliorer la fiabilité de manière générale ».

On plonge tout le monde dans un liquide diélectrique

Le principe de base de l'immersion est connu depuis longtemps et les fabricants s'en servent notamment pour des démonstrations à l'occasion de grands salons afin d'attirer le chaland. Voir des ordinateurs/serveurs fonctionner alors qu'ils sont plongés dans un liquide interpelle toujours les visiteurs.

Ce système de refroidissement consiste à plonger la carte mère avec son processeur, les barrettes de mémoire, la carte graphique et finalement tous les composants dans un liquide diélectrique, c'est-à-dire non conducteur d'électricité. Le liquide vient occuper tous les espaces vides et enveloppe ainsi l'ensemble des composants, qui diffusent leur chaleur à travers le liquide. La surface de contact est ainsi optimale.

La théorie vs la pratique

C'est la théorie. Si plonger des machines dans un aquarium géant pour une démonstration est une chose, industrialiser la technique en est une autre, d'autant qu'en pratique certains obstacles sont à prendre en compte, notamment la capacité du fluide à dissiper plus ou moins de chaleur et le besoin de pouvoir intervenir sur une machine sans couper celles d'à coté.

D'ailleurs, OVHcloud ne se prive pas de rappeler que les solutions existantes utilisent « généralement des pompes, des dissipateurs de chaleur, des échangeurs de chaleur, des condenseurs, des équipements d'évaporation étanches, etc., qui soit consomment de grandes quantités d'énergie [...] soit occupent des superficies relativement importantes ». Ce n'est pas le cas de sa solution affirme le fabricant, qui présenterait de nombreux avantages.

Voici le Hybrid Immersion Liquid Cooling d'OVHcloud

OVHcloud a développé sa propre solution, baptisée Hybrid Immersion Liquid Cooling. Comme son nom l'indique, il s'agit d'un système deux en un. Les CPU et GPU conservent un système de refroidissement « classique » (ou presque) par watercooling. Leur TDP nécessite en effet plus qu'un contact direct avec le fluide diélectrique. On retrouve ainsi des waterblocks reliés à « une bobine de convection placée dans le réservoir et déployant via sa forme de serpentin une surface additionnelle de refroidissement ». Le serpentin, plongé dans le liquide diélectrique, fait office de dissipateur thermique et remplace en quelque sorte le radiateur.

Chaque serveur et son serpentin sont « logés dans un châssis indépendant au format livre où toute l’électronique est submergée dans un fluide diélectrique », comme on peut le voir sur la photo ci-dessous. Comme indiqué, chaque châssis est indépendant et peut donc être retiré de la baie sans arrêter ses petits voisins (voir image d'illustration en tête de l'actualité). Le Roubaisien affirme que son système Hybrid Immersion Liquid Cooling fait l'objet de 16 demandes de dépôt de brevets.

Une baie de 48U : 3x 16 serveurs en 1U ou 3x 8 serveurs 2U

L'ensemble prend la forme d'une baie comprenant trois étages pour un total de 48 serveurs 1U ou 24 serveurs 2U. Chaque étage peut contenir 16 serveurs au format 1U ou 8 serveurs 2U. Ils sont dans tous les cas positionnés à la verticale. Pour reprendre la métaphore littéraire d'OVHcloud, chaque châssis est un livre installé sur une rangée de bibliothèque.

Le système de refroidissement de chaque rack n'a pas besoin de pompe ou de ventilateur ; il ne consomme donc aucune électricité. Le fluide utilisé est non volatil (aucune évaporation), non corrosif, non toxique, non allergène, biodégradable en 30 jours et a une durée de vie de cinq ans nous précise OVHcloud.

« Chaque serveur est immergé dans son propre réservoir pour un refroidissement indépendant permettant des déploiements à grande échelle. De plus, chaque serveur bénéficie d'un système de surveillance dédié de tous les facteurs environnementaux, garantissant un fonctionnement sûr et sécurisé », explique OVHcloud.

Sur les images ci-dessous, les tubulures en cuivre qui se trouvent de chaque côté de la baie « correspondent aux circuits d’entrée/sortie de l’eau : chaque serveur étant connecté indépendamment au système water cooling pour une maintenance facilitée », nous confirme OVHcloud.

(P)PUE en baisse, WUE à 0 selon la température ambiante

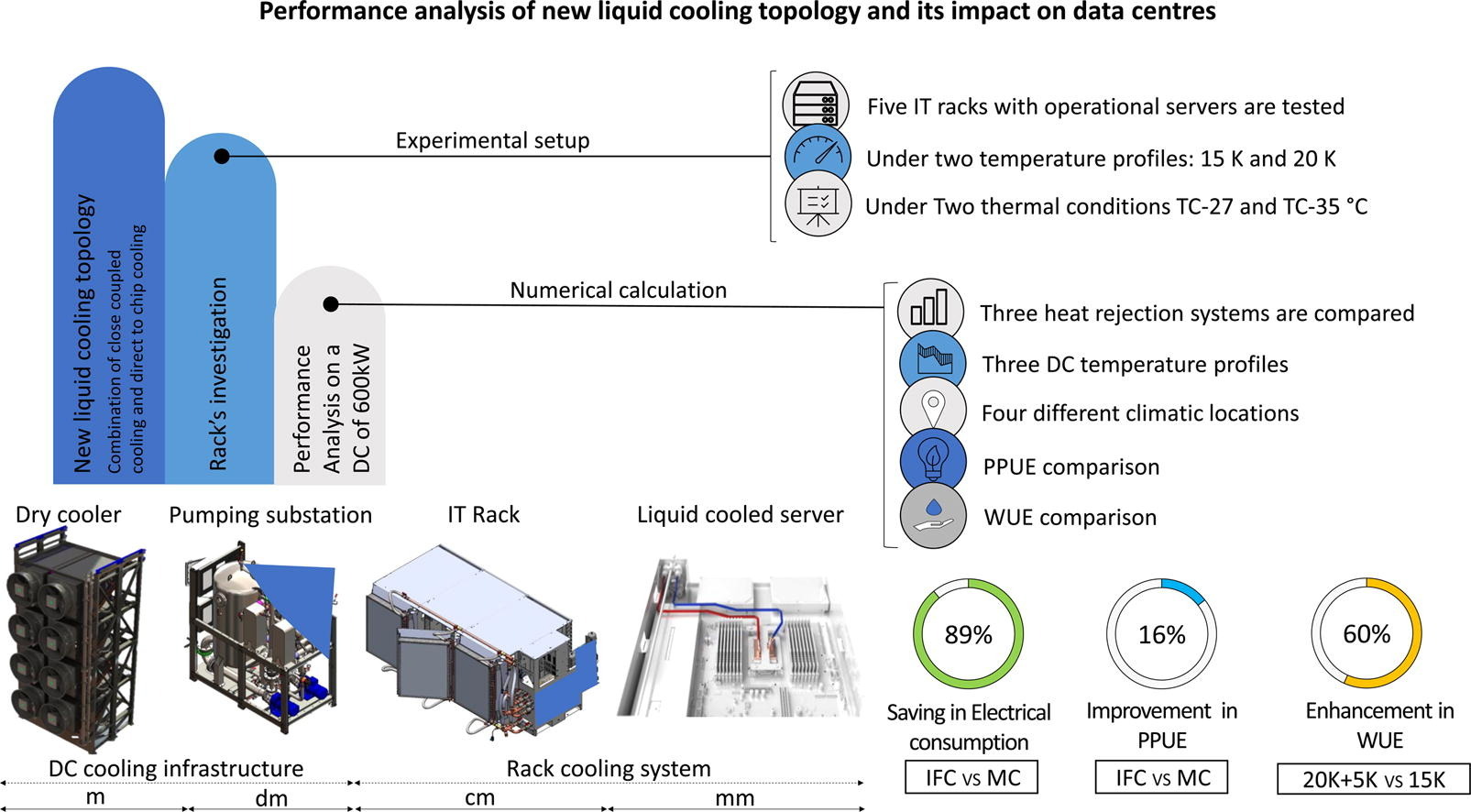

Comparé à ses datacenters watercoolés, la société attend une réduction « jusqu’à 20,7% de la consommation électrique de l’infrastructure de refroidissement au niveau du DC ». Il est aussi question d'« opportunités pour des systèmes de valorisation de la chaleur » (qui est ainsi réutilisée pour d'autres usages, du chauffage par exemple), mais sans plus de précision pour le moment.

Concernant la consommation d'eau, OVHcloud annonce que le WUE (water usage effectiveness) est à 0 lorsque la température ambiante est à moins de 43 °C. Dans le cas contraire, le WUE serait tout de même amélioré de 60 %.

OVHcloud annonce un PPUE – ou Partial PUE (Power Usage Effectiveness, un indicateur d'efficacité énergétique) – de 1,004, alors que sur « les serveurs OVHcloud avec watercooling, le PPUE est estimé entre 1,007 et 1,021 », nous précise le service presse d'OVHcloud. Le Partial PUE ne prend en compte que la consommation du système de refroidissement (Pcooling) et l'informatique du serveur (Pit), pas le reste de l'installation du datacenter, notamment les onduleurs.

L'entreprise s'attend à ce que « le PUE global s’améliore de manière similaire avec l’inclusion des pertes d’énergie dans le système de distribution électrique ». Elle précise que le PUE sera publié « dès que les données obtenues seront significatives sur un laps de temps suffisamment important et pour un emplacement précis ».

Des serveurs immergés déjà en fonctionnement depuis des mois

Des serveurs en immersion sont déjà en fonctionnement chez OVHcloud, comme l'a indiqué Octave Klaba en juin de cette année : « ALPHA d’immersion tourne depuis plusieurs mois. prévu dans qq mois en BETA ». Il ne s'agit donc pas uniquement d'un paper launch, mais on n'est pas non plus sur un déploiement à grande échelle. Il faudra encore attendre avant d'avoir un PUE global pour cette technologie.

Hybrid Immersion Liquid Cooling d’OVHcloud : une baie 48U avec des serveurs watercoolés et immergés

-

On plonge tout le monde dans un liquide diélectrique

-

La théorie vs la pratique

-

Voici le Hybrid Immersion Liquid Cooling d'OVHcloud

-

Une baie de 48U : 3x 16 serveurs en 1U ou 3x 8 serveurs 2U

-

(P)PUE en baisse, WUE à 0 selon la température ambiante

-

Des serveurs immergés déjà en fonctionnement depuis des mois

Commentaires (46)

Le 13/10/2022 à 09h12

Intéressant, par contre ça je ne comprend pas bien :

“Le système de refroidissement de chaque rack n’a pas besoin de pompe ou de ventilateur”

Il y a des tuyaux pour la circulation du fluide du circuit de watercooling pour chaque serveur, qui sont mutualisés à l’échelle de l’armoire. Il doit y avoir des pompes pour faire circuler tout ça

À moins que ce ne soit conçu pour avoir une circulation passive par convection mais ce n’est pas précisé

Edit : ça doit être pour parler du système de fluide uniquement, sur lequel le watercooling vient se rajouter, je crois que j’ai compris x)

Le 13/10/2022 à 09h54

oui la nuance est dans le “chaque rack” ^^

Le 13/10/2022 à 09h36

Oui ça doit être logiquement ça. Le fluide se débrouille, mais de l’eau passe dans les serpentins pour le refroidir.

Et l’eau est avec des pompes, comme actuellement pour leur watercooling. Mais il doit suffire de gérer la pression a l’entrée de la baie voir même avant

Le 13/10/2022 à 09h50

Sa doit aussi rendre les salles beaucoup plus silencieuse qu’avec les flux d’air.

Un fluide parfait ?! A tient il manque son coût !

Et finalement une projection du coût - consommation et infra comprise - de ce systeme VS un équivalent avec refroidissement standard…

Si l’infra / materiel coute 5 fois plus que l’économie d’Energie réalisé, sa risque de rester utopique

Le 13/10/2022 à 09h51

Dommage que l’acronyme PUE ne soit pas expliqué dans l’article… c’est quoi ?

Le 13/10/2022 à 11h13

Comme répondu par Carbier : PUE signifie Power Usage Effectiveness, c’est un indicateur d’efficacité énergétique ;) (J’ai ajouté la précision dans l’actu du coup)

Le 16/10/2022 à 20h57

Merci pour le rajout dans l’article ❤️ (et merci carbier !)

Le 13/10/2022 à 10h07

De ce que j’en comprend au vue des images d’illustrations, il y a 2 boucles générales pour le watercooling (une froide + une chaude). Sur chaque boucle, tu fait des piquages pour chaque baies, qui redistribue ensuite à chaque rack. Au final tu as une arrivé d’eau froide direct dans un serpentin, qui vien refroidir le liquide diélectrique, et passe ensuite dans les waterblocks CPU, pour repartir dans la boucle Chaude.

Voilà comment je le comprend :)

Le 13/10/2022 à 10h43

Un fluide (chauffé par les composants) qui une durée de vie de 5 ans, mais qui est biodégradable en 30 jours…

How?

Traitement UV pour empêcher le développement de microorganismes?

Greenwashing?

Le 13/10/2022 à 11h31

Peut-être soluble dans l’eau et non polluant (minéraux tenus par une molécule organique par ex)

Secret industriel.

Le 13/10/2022 à 11h45

Je me posais la même question.

Le 13/10/2022 à 19h25

Il y a 20 ans de ça je trainais sur CCM (avant rachat et multiplication des pub) et trouvais pertinentes les interventions de Sebsauvage. Etait ce toi?

Le 14/10/2022 à 10h45

Oui c’est lui

Le 18/10/2022 à 07h00

Hello.

Oui c’était bien moi ^^

Le 13/10/2022 à 10h48

Rien que pour ça, ça me donne très envie !

Le 13/10/2022 à 10h54

Power Usage Effectiveness

Le 13/10/2022 à 10h55

Il s’agit peut-être d’une huile minérale comme pour les transformateurs électriques ? on finira bien par savoir

Le 13/10/2022 à 11h05

Dommage qu’on n’ait pas plus d’information sur le fluide utilisé. Le Fluorinert est encore autorisé ?

Le 13/10/2022 à 11h12

Il existe des fluides diélectriques à base d’huile végétale fortement biodégradable.

Après dans les faits je ne sais pas ce que cela donne.

Le 13/10/2022 à 11h14

On imagine que tout le secret de la techno consiste spécifiquement en cette information !

Il reste aussi à comprendre pourquoi la durée de vie n’est “que” de 5 ans pour un liquide supposé plutôt inerte (est-ce qu’il y a un risque de dénaturer le liquide au point d’endommager le matériel ou juste une perte d’efficacité énergétique ?)

En tout cas c’est hyper intéressant, surtout dans le cadre de la guerre naissante contre la consommation des datacenters. A voir ce que ça donnera dans quelques mois/années !

Le 13/10/2022 à 11h29

Pratique, comme ça en cas d’incendie, les serveurs peuvent éteindre le feu avant l’arrivée des pompiers

Le 13/10/2022 à 11h34

Ben non. C’est déjà pris en compte avec un gaz inerte sprinklé à la place de l’eau…

Mais si l’aquarium se perce il doit bien avoir des combustibles réagissants avec l’oxygène dans les composants.

Le 13/10/2022 à 11h55

J’ai aussi été fortement tenté de faire ce troll :p

Le 13/10/2022 à 12h27

Intéressant comme système.

Ca doit quand même être galère à gérer… Quand tu as des remplacements de pièces ou autres, c’est un sacrée cassette de liquide à sortir. Je serais curieux aussi de voir si les composants apprécies sur la durée.

C’est ce que je me suis dit dans mon esprit de troll :) Pour éviter les incendits, maintenant ils foutent les composant dans l’eau

Je me suis fait la réflexion sur le poids, ca doit pas être léger une salle complète..

Le 13/10/2022 à 13h34

Sauf si le fluide est une huile. Dans ce cas, les serveurs nourriront le feu. Mais, là aussi, c’est tout bénef pour les pompiers. Il ne devrait rien rester à éteindre à leur arrivée.

Le 13/10/2022 à 11h33

C’est pour cela que la piste liquide diélectrique végétal est envisageable: biodégradable et faible résistance à l’oxydation (= durée de vie faible)

Le 13/10/2022 à 11h36

Oui mais alors l’intervalle de vidange de 5ans ne colle pas.

Le 13/10/2022 à 11h37

Le 13/10/2022 à 11h44

Arrête d’abuser du Perfluorocarbure.

Le 13/10/2022 à 11h51

Le support technique pilote des drones sous marins

Le 13/10/2022 à 11h54

Oui mais lequel ?

C’est ce que j’adore avec ces talks, on t’explique qu’on serait pas loin de 1:1 en conso sans en donner la valeur en kW…

Le 13/10/2022 à 12h14

Moi qui ne voit que la contrainte sur le faux plancher ou de la dalle en béton pour supporter tout se poids au m².

Donc refroidissement en single-phase immersion cooling.

Au vu des informations, ce n’est pas du 3M Novec qui est utilisé chez ovh. Je verrais bien du BitCool BC-888 qui est synthétique mais biodégradable.

Le 13/10/2022 à 13h15

Ou alors ils parlent juste de 5 ans car ils n’ont pas de retour plus long.

Et vu qu’ils sont en bourse, c’est mieux de dire “ça tiens 5 ans” et que ça fonctionne durant 10 ans, que l’inverse

Le 13/10/2022 à 13h17

Certains déchets sont biodégradable, mais on besoin de chaleur et/ou d’oxygène pour se dégrader. Sans ça, ça reste inerte.

Si OVH est certain de l’étanchéité à l’oxygène durant 5 ans …

Le 13/10/2022 à 13h57

Super article, merci !1

Le 13/10/2022 à 15h19

Je vois pas ininflammable dans la liste.

Jdçjdr.

Le 13/10/2022 à 19h39

Comme on me dit que toute la magie d’un liquide biodégradable et qui ne se change que tout les 5 ans réside dans le secret industriel…

je vais faire totalement confiance en cet industriel qui a développé un super liquide qui n’a que des avantages sans un seul inconvénient!

Juste un question sur le fournisseur de liquide, c’est Monsanto ou la Seita? :-)

Le 13/10/2022 à 20h35

Arôme nautile pour répulser les hackers.

Le 14/10/2022 à 05h23

ça a déjà été fait par Microsoft je crois

Le 15/10/2022 à 08h05

Oui et non.

Oui Microsoft a immergé un (ou des) conteneurs contenant une salle serveur complète et fonctionnelle.

Non, le support technique n’était pas en tenue de plongée. Le conteneur était scellé et les pannes restaient des pannes jusqu’à la maintenance complète du conteneur.

Je crois qu’ils pariaient sur un taux de panne fixe pour ne sortir le conteneur qu’au bout de 3 ou 5 ans…

Joli sarcasme mais non, c’est un onduleur qui a mit le feu aux poudres à Strasbourg. Même avec tous les liquides du monde pour les serveurs, ça ne change pas le problème….

Si c’est ça, ils ont intérêt à bien contrôler la température processeur

Parce que même si le watercooling est indépendant, il ne faudrait pas qu’il y ait un point de chaleur…

It not classified as flammable, but will burn at temperatures over 200 to 244°F/90 to 120°C.

Source: https://www.shell.com/business-customers/chemicals/safe-product-handling-and-transportation/product-stewardship-summaries/_jcr_content/par/expandablelist/expandablesection_1815106617.stream/1525709608519/f9c57aec7f6036a27fb997157740957c77fccf43/mpg-pss-december-2017.pdf

Le 14/10/2022 à 07h09

Tout le monde semble phantasmer sur ce mystérieux fluide magique de refroidissement, mais le monopropylène glycol colle déjà parfaitement à la description….. Pas sûr qu’ils aient ré inventé un truc nouveau

Le 14/10/2022 à 13h07

Ca règle les problèmes de “trop chaud” d’OVH ?

Genre Strasbourg …

Le 17/10/2022 à 13h02

On ne voit pas les disques durs

Le 19/10/2022 à 08h29

C’est parce qu’ils flottent à la surface; ils sont étanches de toutes façons maintenant avec l’hélium

Le 19/10/2022 à 08h33

Je ne les vois sur aucune photo et je ne vois pas de solution pour les remplacer de façon simple comme dans un serveur normal.

Le 19/10/2022 à 09h03

C’était une boutade ma reflexion;

Je pense qu’en mode serveur ils ont du SSd en U2 ou M2 pour l’acces local, puis des gros SANs ensuite.

Pour les DDs, le refroidissement n’est pas aussi exigent, juste une plaque watercoolée sur les côtés ça doit suffire a évacuer les 15W de chaque DD je pense.