Pédocriminalité : l’usine à gaz européenne pour scanner photos et vidéos dans les messageries

Pedo barred

Le texte de « compromis » proposé par la Belgique pour lutter contre les « abus sexuels concernant les enfants » propose de scanner l'ensemble des photos, vidéos et URL avant qu'elles soient envoyées dans les messageries, y compris chiffrées de bout en bout.

Le 04 juin 2024 à 17h24

21 min

Droit

Droit

La Belgique, qui préside le Conseil de l'Union européenne jusqu'au 30 juin, a proposé un « compromis » pour la proposition de règlement « établissant des règles pour prévenir et combattre les abus sexuels concernant les enfants ».

Surnommé #ChatControl par ses opposants, le projet vise à créer un système de détection et de signalement des contenus pédosexuels (ou CSAM, pour « child sexual abuse material »), y compris dans les messageries chiffrées. Ce qui pourrait contrevenir au respect de la correspondance et de la vie privée, mais également relever d'une forme de « surveillance de masse ».

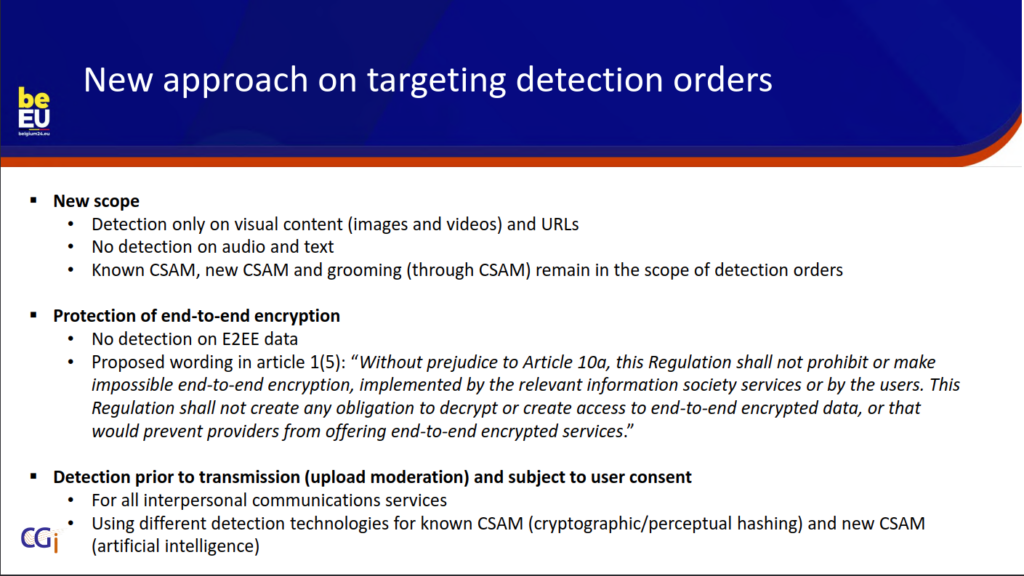

Le nouveau texte propose d'exclure les communications audio des injonctions de détection. Dans ses versions précédentes, « seules les communications audio en temps réel étaient exclues des nouvelles règles », rappelle Euractiv.

Ne seraient désormais concernés que les contenus visuels (images, photos et vidéos) et URL partagés via un service de communication interpersonnelle, « y compris ceux dotés d’un système de chiffrement de bout en bout (E2EE) », souligne le média européen.

Un consentement imposé, en mode chantage...

Autre nouveauté : les utilisateurs devront consentir à cette détection. Ils auront aussi la possibilité de refuser, mais ne pourront dès lors plus partager d'images ni d'URL.

Ce qui revient à accepter d'être placé sous surveillance ou d'être limité dans ce que l'on aurait le droit de partager, résume l'ONG EDRi de défense des libertés numériques, dans un communiqué intitulé « Be scanned – or get banned! », :

« Si les États membres de l'UE acceptent la nouvelle approche de la Belgique, ils interdiront effectivement le partage d'images, de vidéos et de liens dans l'UE en n'"autorisant" ce type de contenu que dans les communications privées sous surveillance de masse. On se croirait dans un épisode de Black Mirror, mais si les gouvernements ne défendent pas nos droits et les preuves scientifiques, cela pourrait bientôt s'appliquer à tous nos appareils. »

En évoquant les « preuves scientifiques », EDRi fait référence aux études d'universitaires, de chercheurs et de scientifiques ayant démontré l'infaisabilité technique de cette proposition de « scan côté client » des contenus. Elles sont si nombreuses que l'ONG en est venue à qualifier le texte de « projet de loi européen le plus critiqué de tous les temps ».

Début mai, plus de 300 scientifiques de 35 pays cosignaient d'ailleurs une lettre ouverte dénonçant les modalités de la proposition, notamment « parce qu'elles sont faciles à contourner par ceux qui veulent échapper à la détection, et qu'elles sont sujettes à des erreurs de classification ».

Meredith Whittaker, chercheuse en éthique de l'intelligence artificielle et présidente de la Signal Foundation – qui encadre et finance le développement de la pionnière des messageries chiffrées de bout en bout – a d'ores et déjà prévenu que si la proposition était adoptée, Signal quitterait le marché de l'UE « plutôt que d'affaiblir nos garanties en matière de protection de la vie privée ».

Signal strongly opposes this proposal.

Let there be no doubt: we will leave the EU market rather than undermine our privacy guarantees.

This proposal--if passed and enforced against us--would require us to make this choice.

It's surveillance wine in safety bottles. https://t.co/i8D4Mlcrgd

— Meredith Whittaker (@mer__edith) May 31, 2024

Docteure en droit privé et spécialiste des questions de protection des libertés et de la vie privée, Estelle de Marco, qui avait consacré une thèse à l'anonymat en ligne, relève de son côté que « cette proposition est une violation du droit de correspondance protégé par la CEDH et la Charte des droits fondamentaux de l'UE ».

... alors qu'il devrait être obtenu librement

Au-delà des oppositions de principe, la mise en œuvre pratique de ces injonctions de détection recèle, elle aussi, de nombreuses chausse-trappes.

Le principe sous-entendu par la nouvelle approche belge « semble être que si les personnes consentent à être scannées, il ne s'agit pas d'une surveillance de masse », relève par exemple EDRi :

« Il s'agit là d'un grave malentendu, non seulement sur la surveillance de masse, mais aussi sur le consentement. Selon la législation européenne, le consentement au traitement des données doit être donné librement. Il ne peut pas être imposé sous la menace que, sans ce consentement, vous ne pourrez plus partager des photos avec votre famille, envoyer des liens à vos collègues, et bien d'autres choses encore. »

En outre, souligne l'ONG, « il est difficile d'imaginer comment un tel mécanisme pourrait être efficace ». On imagine mal en effet ceux qui voudraient réellement partager des images ou URL à caractère pédosexuel consentir à ce type d'injonction.

A contrario, on peut raisonnablement penser que la quasi-totalité des personnes qui consentiront à voir leurs images et URL surveillées, afin de « prévenir et combattre les abus sexuels concernant les enfants », ne prendront pas le risque d'y partager des contenus de type CSAM.

Dit autrement, et comme l'avait résumé Philip Zimmermann, créateur du logiciel de chiffrement à clef publique Pretty Good Privacy (PGP), en réponse à ceux qui voulaient l'interdire aux débuts des années 1990, « si la vie privée est mise hors la loi, seuls les hors-la-loi auront une vie privée ».

Un risque non négligeable de « faux positifs »

Les utilisateurs qui consentiraient néanmoins à l'injonction de détection prendraient aussi le risque de voir leurs contenus être identifiés à tort, « qu'il s'agisse d'adolescents dont les images sexuelles consensuelles seront repérées et signalées, ou de personnes dont le contenu sera marqué par erreur comme étant du matériel pédopornographique », relève EDRi.

On a ainsi vu des pères de famille être accusés à tort de pédophilie par Google pour avoir envoyé via GMail, à la demande de médecins, une photo du sexe de leurs enfants. On peut dès lors craindre que des médecins et patients puissent eux aussi être identifiés à tort, tout comme des parents ou animateurs de colonies de vacances, entraîneurs ou accompagnateurs sportifs partageant des photos d'enfants en maillots de bain ou petites tenues, sans parler des nudistes ou des photographes d'enfants.

Un risque d'autant moins négligeable que le texte (.pdf) de 205 pages, dont Netzpolitik s'est procuré une version datée du 28 mai et adressée par la présidence belge au groupe de travail des forces de l'ordre, opte pour une conception particulièrement étendue du CSAM.

Il prévoit en effet que l'expression « abus sexuel d'enfants en ligne » puisse couvrir « non seulement la diffusion de matériel précédemment détecté et confirmé comme constituant du matériel d'abus sexuel d'enfants », mais également des contenus qui n'avaient encore jamais été détectés et qui seraient « susceptibles de constituer du matériel d'abus sexuel d'enfants, mais qui n'a pas encore été confirmé comme tel », ainsi que « les activités constituant la sollicitation d'enfants ("grooming") ».

Le texte précise par ailleurs que les injonctions de détection ne s’appliqueront pas aux comptes utilisés par l’État à des fins de sécurité nationale, d’application de la loi ou à des fins militaires.

Il n'envisage jamais, 11 ans après les révélations Snowden, qu'une part non négligeable de l'opinion publique, des défenseurs des droits humains, avocats et journalistes, seront, eux aussi, peu enclins à consentir à ce type de surveillance préventive et indiscriminée des images et URL qu'ils voudraient partager.

Le chiffrement de bout en bout « est important », mais...

Le texte qualifie par ailleurs le chiffrement de bout en bout d'« outil important pour garantir la sécurité et la confidentialité des communications des utilisateurs, y compris celles des enfants », et précise que le projet ne vise aucunement à l'interdire ou à le rendre ineffectif :

« Compte tenu de la disponibilité de technologies qui peuvent être utilisées pour satisfaire aux exigences du présent règlement tout en permettant le chiffrement de bout en bout, aucune disposition du présent règlement ne doit être interprétée comme interdisant, exigeant de désactiver ou rendant impossible l'utilisation de technologies de chiffrement de bout en bout. »

Les fournisseurs doivent dès lors « rester libres d'offrir des services utilisant le chiffrement de bout en bout » et ne sauraient être « obligés par le présent règlement de déchiffrer les données ou de créer un accès aux données chiffrées de bout en bout ».

Néanmoins, tempère la proposition, il est tout aussi essentiel que les services utilisant le chiffrement de bout en bout « ne deviennent pas par inadvertance des zones sécurisées où du matériel pédosexuel peut être partagé ou diffusé sans conséquences possibles ».

Par conséquent, les contenus CSAM doivent « rester détectables dans tous les services de communication interpersonnelle grâce à l'application de technologies approuvées, lorsqu'il est téléchargé, à condition que les utilisateurs donnent leur consentement explicite » :

« Cela garantit que le mécanisme de détection peut accéder aux données sous leur forme non chiffrée pour une analyse et une action efficaces, sans compromettre la protection fournie par le chiffrement de bout en bout une fois que les données sont transmises. »

Une prophétie autoréalisatrice façon Hadopi

Un nouvel article 10a, intitulé « Technologies de modération des téléchargements » (« Technologies for upload moderation », en VO), résume la proposition comme suit :

« Afin de mettre en œuvre le présent règlement, les fournisseurs de services de communications interpersonnelles installent et exploitent des technologies permettant de détecter, avant la transmission, la diffusion de matériel connu relatif aux abus pédosexuels ou de nouveau matériel relatif aux abus pédosexuels. »

Le texte ne détaille nullement comment ces technologies procéderont pour exécuter les injonctions de détection, se bornant à préciser qu'elles devront être mises à disposition, « gratuitement », aux hébergeurs et fournisseurs de services de communications interpersonnelles, après avis du Comité européen de la protection des données (CEPD), par le Centre européen chargé de coordonner le dispositif :

« En coopération avec les autorités de coordination, les fournisseurs de services d'hébergement et les fournisseurs de services de communications interpersonnelles et, le cas échéant, des experts indépendants, le Centre UE développe ou facilite le développement ultérieur de technologies permettant de détecter les abus pédosexuels en ligne, de manière à garantir que ces technologies sont capables de satisfaire aux exigences du présent règlement. »

Une prophétie autoréalisatrice rappelant furieusement la réponse donnée par Olivier Henrard sur l'absence de logiciel permettant à un particulier de s’assurer que son accès Internet ne fasse pas l’objet d’une « utilisation qui méconnaît les droits de propriété littéraire et artistique », et qu'il n’en existerait jamais. En 2008, le « père » de la Hadopi avait balayé le problème d'un revers de manche, renvoyant à la loi du marché, de l'offre et de la demande :

« La réponse dépend des acteurs économiques : ce n’est pas un produit proposé à ce jour, mais ça ne présente pas de difficulté technique majeure, pour peu qu’existe une demande. Et comme les usagers vont demander de tels dispositifs de prévention et de filtrage à leurs FAI, c’est aux acteurs économiques de combler le vide. »

Une détection des contenus pédosexuels inconnus grâce à l'IA

Le texte invite par ailleurs les fournisseurs à « assurer une surveillance humaine et, le cas échéant, une intervention humaine, adaptées au type de technologies de détection et au type d'abus pédosexuels en ligne en cause », afin d'évaluer « en permanence » les performances des technologies de détection « et de s'assurer qu'elles sont suffisamment fiables, ainsi que d'identifier les faux positifs et d'éviter dans une large mesure les signalements erronés » :

« Cette surveillance devrait comprendre une évaluation régulière des taux de faux négatifs et de faux positifs générés par les technologies, sur la base d'une analyse d'échantillons de données représentatifs et anonymes. »

Une annexe (.pdf) de 13 pages esquisse plus en détails le fonctionnement de cette « nouvelle approche » de la détection des contenus pédosexuels. On apprend dans le document, lui aussi adressé par la présidence belge, qu'elle reposera en bonne partie sur de l'intelligence artificielle.

« Les conditions générales du fournisseur de services pourraient informer l'utilisateur du fait que la détection avant la transmission peut être déployée si le fournisseur reçoit un ordre de détection », précise l'annexe, de sorte qu'il ait alors le choix entre :

-

- consentir à la détection des contenus visuels et des URL, auquel cas il aurait accès à l'ensemble des fonctionnalités de ce service et notamment au partage des contenus visuels et des URL, ou

- ne pas consentir à la détection des contenus visuels et des URL, auquel cas l'utilisateur aura accès à l'ensemble des fonctionnalités de ce service, à l'exception du partage des contenus visuels et des URL.

Des algos entraînés sur de grands ensembles de contenus pédo

Avant d'être partagés, les contenus feront d'abord l'objet d'une fonction de hachage, afin que leurs empreintes soient comparées avec la base de contenus dûment identifiés comme relevant du CSAM. Y compris via le « perceptual hashing », capable d'identifier des CSAM « similaires » à des CSAM connus sur la base de valeurs de hachage similaires, et « même si elles ne sont pas entièrement identiques au niveau du pixel » :

« Le hachage cryptographique n'est capable de détecter que deux images exactes, tandis que la valeur ajoutée du hachage perceptuel, tel que PhotoDNA, la fonction de hachage PDQ de Facebook et la fonction NeuralHash d'Apple, réside dans le fait que le hachage généré est résistant aux transformations d'images courantes telles que le redimensionnement, la compression, le flou, le bruit, etc, tout en étant sensible à la similarité perceptuelle. »

Les contenus n'ayant pas été identifiés comme relevant du CSAM feront ensuite l'objet d'une « détection basée sur l'intelligence artificielle » et des algorithmes d'apprentissage automatique « formés sur de grands ensembles de données de CSAM pour apprendre des modèles et des caractéristiques associés aux CSAM (après confirmation qu'il s'agit ou non de CSAM) ».

Or, précise l'annexe, « cette méthode nécessite toutefois l'analyse du contenu visuel des images et des vidéos plutôt que le hachage ». Les images, photos et vidéos devraient donc être transmises aux autorités, entraînant non seulement des coûts en termes de bande passante, mais aussi et surtout en termes de puissance de calcul, les IA étant particulièrement consommatrices.

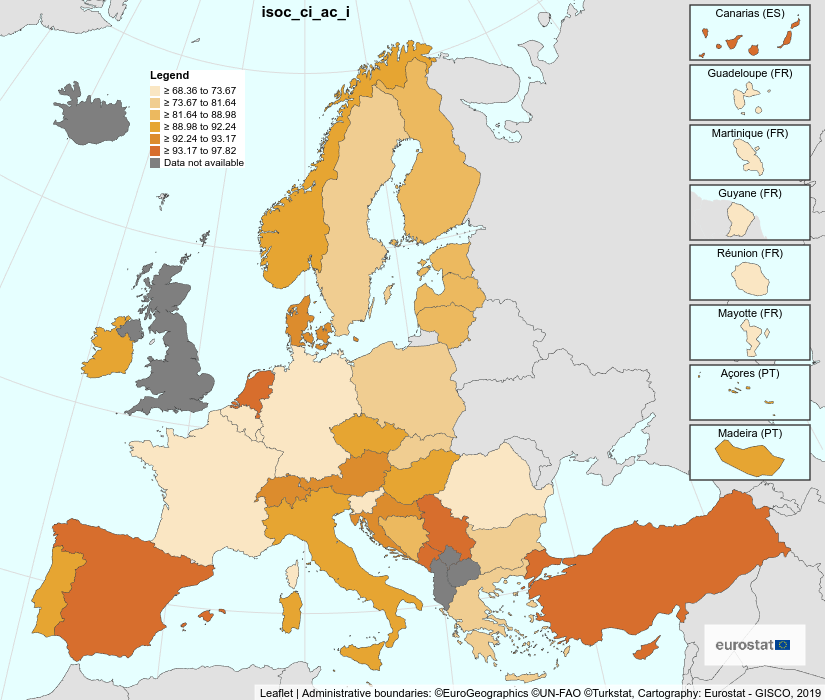

Nous n'avons pas trouvé d'estimation du nombre d'images, photos et vidéos partagées, quotidiennement, par les utilisateurs européens de « service de communication interpersonnelle », mais le taux de possesseurs français de téléphones mobiles se servant d'applications de messageries instantanées est passé de 17 % en 2014 à 80 % en 2023.

Eurostat estime par ailleurs que 91 % de la population européenne (estimée à près de 450 millions d'habitants, à quoi il convient de retirer les mineurs et personnes âgées non dotées de téléphones portables) s'est connectée à internet au cours des trois derniers mois et que 82 % utilise des applications de messagerie instantanée.

Pourcentage d'utilisateurs de messageries instantanées -Eurostat

À défaut de savoir combien de « services de communication interpersonnelle » seraient concernés par ce type d'injonctions de détection, on peut estimer qu'il faudrait passer à la moulinette de ces IA des dizaines (voire centaines) de millions de contenus, par jour.

« Solutionnisme technologique » & « comédie sécuritaire »

Dans son étude d'impact, le Parlement européen soulignait que si 0,1 % (une « estimation optimiste ») de tous les messages sont marqués à tort comme CSAM et que ce pourcentage est appliqué à un milliard de messages échangés chaque jour, cela donnerait « 1 million de faux positifs par jour ».

Or, « il faut environ 10 secondes » à une personne pour déterminer si un contenu signalé est effectivement du CSAM ou s'il s'agit d'un faux positif. Cela signifie qu'une personne peut classer « environ 2 500 messages par jour » :

« Pour 1 milliard de messages, il faudrait 400 personnes en permanence pour classer ces images. Si l'on tient compte des formations, des vacances et des week-ends, il est plus probable qu'une équipe de 800 personnes soit nécessaire pour classer ces images. Cette charge de travail est jugée irréalisable, qu'elle relève de la responsabilité d'un centre [européen] ou des forces de l'ordre. »

De plus, et comme l'avait brillamment expliqué le cryptographe Bruce Schneier, au lendemain des attentats du 11 septembre 2001, sur l'hypothétique déploiement d'algorithmes de reconnaissance faciale dans les aéroports, « en supposant qu'un passager sur dix millions, en moyenne, soit un terroriste », un algorithme ayant un taux de seulement 0,01 % d'erreurs générerait « 1 000 fausses alertes pour chaque vrai terroriste » :

« Supposons que ce logiciel de reconnaissance faciale magiquement efficace soit précis à 99,99 %. Autrement dit, si quelqu'un est un terroriste, il y a 99,99 % de chances que le logiciel indique "terroriste", et si quelqu'un n'est pas un terroriste, il y a 99,99 % de chances que le logiciel indique "non terroriste". Supposons qu'un passager sur dix millions, en moyenne, soit un terroriste. Le logiciel est-il bon ? Non. Le logiciel générera 1 000 fausses alertes pour chaque vrai terroriste. Et chaque fausse alerte signifie que tous les agents de sécurité suivent toutes les procédures de sécurité. »

Ce qui l'avait conduit à développer le concept de « Security Theater » (ou « Comédie sécuritaire) pour qualifier ces « mesures de sécurité destinées à donner au public une impression de sécurité sans pour autant améliorer réellement la sécurité réelle ». Tout en aggravant, a contrario, le risque pour des personnes pourtant « présumées innocentes » d'être considérées comme « présumées suspectes ».

L'annexe de la présidence belge se réfère par ailleurs aux applications développées à l'époque de la pandémie de COVID-19 pour estimer, via Bluetooth, le risque putatif d'être devenu « cas contact ». Nous avions alors souligné dans plusieurs articles qu'elles étaient au mieux « approximatives », déplorant les travers et les risques posés par ce type de « solutionnisme technologique ».

Pseudonymisation et chiffrement homomorphe

Consciente que l'utilisation de l'intelligence artificielle « produit plus de faux positifs que le hachage », la présidence belge propose deux contre-feux. D'une part, « retarder le signalement » auprès des autorités afin que seuls les utilisateurs ayant vu deux de leurs contenus identifiés comme CSAM potentiel ne soient signalés.

D'autre part, pseudonymiser les métadonnées relatives aux informations personnelles des utilisateurs. Elle suggère que « les techniques de brouillage des visages pourraient même être envisagées », avant que les contenus potentiellement suspects ne soient vérifiés par un être humain :

« En cas de concordance avec un nouveau CSAM possible, le fournisseur pseudonymiserait les métadonnées incluses dans le rapport au Centre de l'UE, de sorte que ce dernier ne puisse pas savoir à qui appartiennent les données avant d'avoir vérifié que le contenu n'est pas manifestement infondé. Dans ce cas, le Centre de l'UE informerait le fournisseur et ce dernier partagerait avec le Centre de l'UE les métadonnées en clair, afin que le Centre de l'UE puisse les transmettre aux services répressifs. »

L'annexe propose en outre de stocker les images dans la « secure enclave » des téléphones portables, puis de les envoyer dans une base de données sécurisée via un chiffrement homomorphe, pour pouvoir effectuer lesdites opérations sans avoir à déchiffrer les données au préalable.

L'« usine à gaz » belge et la présidence hongroise

Le texte ne précise pas les informations qui seront envoyées aux personnes dont les images ou URL auraient été identifiées CSAM, non plus que les procédures qu'elles pourraient mettre en œuvre pour contester ce type de signalement.

Il n'évoque pas non plus les mesures qui pourraient être prises pour ne pas alerter les utilisateurs dont les contenus relèveraient véritablement de CSAM ou du « grooming ». Un pédophile découvrant que les images ou URL qu'il prévoyait d'envoyer ont été bloquées pourrait en effet être tenté d'effacer les autres traces susceptibles de l'incriminer.

L'intention (« prévenir et combattre les abus sexuels concernant les enfants ») est bien évidemment louable, mais la mise en œuvre de cette proposition de « modération des téléchargements », non contente d'attenter aux droits fondamentaux et de mettre en place une « surveillance de masse », s'apparente dès lors à une « usine à gaz » dispendieuse et impossible à mettre en œuvre techniquement, eu égard au nombre de « faux positifs » et donc de personnes « présumées innocentes » risquant pourtant d'être « présumées suspectes ».

Dans un second article, publié dans le cadre d'un dossier consacré aux « principaux dossiers législatifs en suspens dont le prochain Parlement européen héritera », Euractiv estime que le projet, « malgré son importance, risque d’être abandonné en raison de l’impasse législative », et qu' « il est peu probable qu’une approche générale soit atteinte d’ici la fin de son mandat en juin ».

De plus, et si la présidence hongroise prendra en charge le dossier en juillet, « celui-ci ne sera probablement pas une priorité durant son mandat » :

« Faute de progrès, certains prédisent qu’il pourrait "s’éteindre" complètement, à l’instar de la directive sur la protection de la vie privée dans le secteur des communications électroniques, qui a fait l’objet de retards prolongés. »

Pédocriminalité : l’usine à gaz européenne pour scanner photos et vidéos dans les messageries

-

Un consentement imposé, en mode chantage...

-

… alors qu’il devrait être obtenu librement

-

Un risque non négligeable de « faux positifs »

-

Le chiffrement de bout en bout « est important », mais…

-

Une prophétie autoréalisatrice façon Hadopi

-

Une détection des contenus pédosexuels inconnus grâce à l’IA

-

Des algos entraînés sur de grands ensembles de contenus pédo

-

« Solutionnisme technologique » & « comédie sécuritaire »

-

Pseudonymisation et chiffrement homomorphe

-

L’« usine à gaz » belge et la présidence hongroise

Commentaires (41)

Modifié le 04/06/2024 à 17h35

Le 04/06/2024 à 17h40

Le 04/06/2024 à 17h54

#votepirate un peu quand même, merci Patrick Breyer pour le boulot déjà fait. ça suffira sans doute pas mébon.

Modifié le 04/06/2024 à 17h56

Interdisez TLS, AES et compagnie et ça ira plus vite.

Bande de nazes.

Après tout, le principe de proportionnalité c'est du flan.

Le 04/06/2024 à 18h03

Chapeau les artistes!

Le 04/06/2024 à 18h39

"C'est une blague belge ce texte?"

Voilà c'est fait.

Plus sérieusement, la plupart des mesures ne tiennent pas la route trchniquement. Exemple: stocker des images dans la secure enclave... Il se passe quoi si l'image dépasse 256 bits ? Pire, si j'envoie 2 icônes pédophiles? Ou si mon PC pédophile n'a pas de secure enclave?

Une secure enclave ne peut pas stocker d'image.

Franchement cette loi ne me fait pas peur car tout simplement inapplicable sauf à avoir l'intranet chinois. Mais a ce moment là, on aura d'autres soucis et agirons différemment.

Le 04/06/2024 à 19h27

L'image dans la secure enclave, ça veut probablement dire que l'image est chiffrée par une clé de chiffrement protégée par la secure enclave.

Le 04/06/2024 à 19h12

Et au milieu, ca sera étendu à la défense du droit d'auteur évidemment, qui est la première des libertés.

Et sinon, gros scoop : les pédophiles, ils sont pas idiots, ils vont juste utiliser des applis libres qui se fichent de ces lois. Du coup, on va fliquer toute la population sur ses activités normales alors que la criminalité aura bougé sur des canaux alternatifs.

Le but de ces lois n'est jamais de lutter contre la pédophilie, c'est juste un pretexte pour imposer un contrôle de la population. Et le but du FNAEG dès le départ était de ficher 100% de la population.

Le 04/06/2024 à 20h04

Le 04/06/2024 à 23h22

Le 05/06/2024 à 09h27

Le 04/06/2024 à 19h20

En tout cas, la Hongrie est très intéressée par cette directive pour faire la chasse aux parents qui vivraient en couples de même sexe (un couple de même sexe ne peut pas élever un enfant selon la loi hongroise). Et les autres extrêmes droites voudraient bien ce texte pour identifier les déviants sexuels (LGBTQ+) et pour "protéger" les enfants de ces derniers.

Enfin bon, si jamais le prétexte de la lutte contre la pédophilie devait être accepté par la CJUE pour détruire le droit à la confidentialité de la correspondance, tous les droits fondamentaux seraient en danger face à la lutte contre les crimes de droit commun.

Le 04/06/2024 à 19h32

Apple a mis son projet "en pause"... en gros ils ont donnée le résumé du fonctionnement aux gouvernements et attendent qu'on les oblige à l'implémenter pour aller de l'avant... tout en mettant la faute sur les gouvernements. Et ça va "nettoyer" le marché des concurrents qui refuseront d'implémenter leur système.

Le 04/06/2024 à 19h38

Le 04/06/2024 à 20h17

Apple a aussi habitué la population à l'idée en lançant leur solution puis en la mettant "en pause".

Et pas mal de fanboys d'Apple se sont mis à défendre le système religieusement car c’est Apple qui le proposait.

Bref, évidemment le plus important c'est que le texte ne passe pas, mais Apple a un rôle énorme dans l'affaire.

Le 04/06/2024 à 23h34

https://fortune.com/europe/2023/09/26/thorn-ashton-kutcher-ylva-johansson-csam-csa-regulation-european-commission-encryption-privacy-surveillance/

https://safer.io/

https://www.prnewswire.com/news-releases/thorn-partners-with-hive-to-bring-csam-detection-and-mitigation-to-hundreds-of-online-platforms-302128786.html

Alors oui, Apple a essayé de laver plus blanc en venant avec une contre-proposition, mais c'est loin d'être le cœur du problème, ça a juste rajouté au vocabulaire le coup de l'enclave citée en annexe du règlement, et qui est juste une pirouette de dernière minute (à l'échelle du processus législatif) pour essayer de nous faire prendre des vessies pour des lanternes genre "ah mais si on peut faire de l'eau qui ne mouille pas".

Apple n'est pas une présence positive dans ce dossier, mais ce n'est pas l’instigateur du texte.

Le 04/06/2024 à 23h55

La proposition de la commission date de mai 2022.

C'est bien Apple qui a créé la technologie, puis vendu au public l'idée que tous les media sur leur appareil seraient scannés par une IA, et ce moins d'un an avant que la commission ne propose l'idée. Sans Apple cette proposition n'aurai simplement pas pu exister, et n'aurai pas été acceptée.

Le 05/06/2024 à 00h54

En septembre 2020, la commission propose de mettre en place, sur base volontaire, un filtrage sur les contenus, tout en laissant la liberté de la technologie aux différents acteurs.

https://www.europarl.europa.eu/RegData/docs_autres_institutions/commission_europeenne/com/2020/0568/COM_COM(2020)0568_EN.pdf

Ashton Kutsher rentre en scène fin 2020

https://edition.cnn.com/2020/12/07/tech/europe-privacy-law-child-abuse-intl/index.html

En 2021, on voit Thorn.org apparaître dans les discussions et les rapports d'Europol, et comme promis en 2020, la base volontaire v1 se transforme en base réglementaire v2. Thorn, en tant qu'ONG, assiste gracieusement la commission dans la rédaction du texte et fournis des arguments et du vocabulaire pour s'attaquer entre-autres au chiffrement e2e.

Le texte proposé en mai 2022 ne parle aucunement d'enclave ou autres technologies liées à Apple, le modèle de Chatcontrol 2.0 reposant fondamentalement sur le principe que la plateforme de messagerie analyse tous les messages en transit. Le texte de mai 2022 ne parle pas de scan côté client.

Le 05/06/2024 à 02h50

En effet Thorn a eu une influence décisive.

Le 04/06/2024 à 19h43

Le 04/06/2024 à 21h47

Le 04/06/2024 à 22h23

Rarement, un pédophile qui débarque au coin de la rue et abuse du bambin qui passait par là.

Mais, il est plus facile d'avoir cette image là que de remettre en question son entourage ou des institutions fautives (clergé, école, enfants placés)

La remarque est valable pour les viols, rarement fait au détour d'une ruelle à minuit…

Le 05/06/2024 à 08h02

Le 05/06/2024 à 10h39

Le 09/06/2024 à 17h40

«Le grand-père filmait sa petite-fille nue à son insu

Le grand-père est poursuivi pour voyeurisme et agression sexuelle sur sa petite-fille mineure. Il détenait aussi des milliers d’images pédopornographiques dans son ordinateur.»

«En 2021, elle découvre une microcaméra cachée dans sa chambre face à son lit.

(...)elle passe tous les week-ends chez ses grands-parents(..). Sa chambre jouxte celle de son grand-père. À l’époque, la présence de la caméra ne l’interpelle pas plus que ça. Il y en a d’autres dans la maison. (...) En mars 2022, elle cherche une clé USB. Elle sait que son grand-père en possède plusieurs. Elle fouille et trouve une clé sur laquelle son prénom est inscrit. Celle-ci enferme beaucoup de photos. (...)Elles ont été prises par la caméra posée dans la chambre, elles montrent l’adolescente de 16 ans nue, l’objectif a zoomé sur ses parties (...).»

« Il confirme avoir posé une caméra dans la chambre car il craignait que sa petite-fille se scarifie. Il avait constaté des traces sur ses poignets. Il assure aussi qu’il ne regardait pas ces images. »

Le 04/06/2024 à 22h28

… je trouve que c’est la tendance à la volonté la surveillance de masse par défaut et le cheminement habituel « pédoporn only -> + terrorisme quelques années plus tard -> + mafia et gangs quelques années plus tard -> + réseaux de narco trafic quelques années plus tard -> droit commun au final » qui sont de manière macro les plus problématiques.

Les représentants des exécutifs européens sont de plus en plus ouvertement prêts à remettre en question le chiffrement (comme au bon vieux temps des années 80/90), afin de pouvoir tout lire « au cas où » . Et couplé à l’habitude bien installée de commencer par instaurer des textes intrusifs contre le pédoporn puis les élargir à d’autres sujets mandats après mandats (sans qu’il n’y ait une volonté consciente de le faire par les assemblées d’origine), on en arrive à discuter de système de surveillance de masse de facto, sans qu’aucun exécutif n’ai le sentiment de franchir une ligne rouge…

C’est effrayant.

Modifié le 05/06/2024 à 09h12

Oh wait...

Note: Les mafias et les narco, sont combattus, mais luttes vraiment pas mises en avant.

Modifié le 04/06/2024 à 22h29

Le 05/06/2024 à 07h35

Le 05/06/2024 à 07h48

Le 05/06/2024 à 07h52

On est en train de clarifier le retour visuel pour info

Le 05/06/2024 à 09h13

Le 05/06/2024 à 12h16

Modifié le 06/06/2024 à 07h59

J'ai peu de plugins. Ghostery, UB Origin et Noscript désactivés pour test, idem.

Par contre, j'ai le lien de l’article copié dans mon bloc note.

Le 06/06/2024 à 10h29

Le 07/06/2024 à 08h35

Le 05/06/2024 à 10h06

Une fois ça fait, on peut les traiter de façon approprié (goulag ?).

Ensuite avec celles qui ont accepté l'analyse, on peut activer la détection de chose plus graves, comme le refus de la pensé unique.

Modifié le 05/06/2024 à 13h59

Au passage j’ignore sa prévalence et le nombre de faits connus ou estimés (par rapport aux homicides aux US par exemple, ~ 30 000 tués/an).

En tout cas, je trouve très curieux que c’est l’argument N°1 qui revient toujours dans 95% des propositions qui visent au final à casser le secret des correspondances entre individus. Pourquoi alors durant les années 60-2000 on n’aurait pas voté une loi pour ouvrir tous les courriers entre particuliers au cas où des pervers se serraient échangé des photos Kodak pédopornographiques par la Poste ?

Ha parce que là maintenant, les Etats pourraient jouer à Big Brother, le remake... 1984 v2.0

Le 05/06/2024 à 14h54

Modifié le 05/06/2024 à 16h27

Il s'agit du vote d'avril pour faire perdurer l'actuelle dérogation au droit de l'union pour la phase volontaire.

les députés et groupes sous le + ont voté pour la prolongation, ceux sous le - sont contre, et ceux sous le 0 se sont abstenus.

Pour faire simple, en France, toute la droite et l’extrême droite ont voté pour la prolongation, les socialistes ont voté pour, Aubry a aussi voté pour ...

En France il n'y a que les verts à s'être opposés (en général, à l'U.E., les verts sont du bon côté des droits humains sur les dossiers technologiques)

Mais bon, ce vote passé n'est pas une garantie des votes futurs.

Le 10/06/2024 à 15h45