Orange et HPE construiront le supercalculateur classifié dédié à l’IA de défense

Pas mal non ? C'est français

© DGA/MIP

Le ministère des Armées l’a confirmé jeudi : la mise en place du « plus puissant supercalculateur classifié dédié à l’IA en Europe » est désormais confiée au groupement constitué par HPE et Orange, vainqueurs face à Atos. Le projet doit aboutir à une mise en service d’ici fin 2025, sous la houlette de l’agence ministérielle pour l’IA de défense, qui franchit la barre des 100 ingénieurs.

Le 25 octobre à 15h23

6 min

Économie

Économie

Atos, qui discute actuellement avec l’État au sujet de l’acquisition de ses activités stratégiques, ne construira finalement pas le futur supercalculateur dédié à l’IA dans la défense française. Le ministère des Armées a en effet annoncé jeudi (PDF) avoir sélectionné le groupement constitué par HPE (Hewlett-Packard Enterprise) et Orange pour la réalisation de ce centre de données, qualifié de « plus importante capacité de calcul classifiée dédiée à l’intelligence artificielle d’Europe ».

Deux candidats en lice

Installé au Mont-Valérien à Suresnes, aux portes de Paris, le supercalculateur sera hébergé et infogéré par la direction interarmées des réseaux d'infrastructure et des systèmes d'information de la Défense (Dirisi). Son exploitation sera quant à elle confiée à l’Amiad, l’Agence ministérielle de l'intelligence artificielle de défense, créée et installée en mars dernier.

Deux candidats s’affrontaient pour la réalisation de ce projet, dont l’enveloppe prévisionnelle gravite entre 200 et 300 millions d’euros. Atos, acteur historique du supercalcul grâce aux activités de Bull, faisait pour beaucoup office de favori. L’entreprise dispose d’une légitimité en la matière, elle travaille depuis 2004 avec la Direction des applications militaires (DAM) du CEA, et lui a fourni ses derniers systèmes dédiés en 2021. Enfin, Atos présente l’avantage d’être une entreprise française, là où son concurrent Orange a fait le choix de s’allier avec un acteur américain.

« Ce calculateur ne sera pas connecté à internet et sa maintenance sera réalisée par des citoyens français habilités au secret de la défense nationale », prend soin de préciser le ministère des Armées dans sa communication. Une façon de souligner que même si les composants sont américains, la souveraineté de l’infrastructure et des traitements qui y seront effectués est garantie.

Souveraineté et composants américains

C’est aussi le point de vue qu’a défendu Sébastien Lecornu, ministre des Armées, le 15 octobre dernier, devant la commission de défense du Sénat (voir vidéo, à partir de 54 minutes environ).

« La souveraineté en la matière est un bon débat, précisément parce qu’il n’y en a pas », a fait valoir le ministre, expliquant que 90 à 95% des GPU équipant les supercalculateurs dans le monde provenaient de NVIDIA, et soulignant que les deux offres, Atos d’un côté et Orange / HPE de l’autre, s’approvisionnaient chez le numéro un.

Le ministre a par ailleurs appelé à ne pas confondre sécurité et souveraineté, expliquant que le cahier des charges s’appliquait en des termes similaires aux deux candidats. « Quels que soient ceux qui mettront en œuvre cette affaire, toutes les procédures seront respectées. Comme je le dis souvent, beaucoup d’ordinateurs du ministère des Armées ont Microsoft, c’est comme ça, il n’y a pas de solution française. C’est plutôt la mise en œuvre de ce soft, la manière dont les ingénieurs le mettent en œuvre, avec nos protocoles de sécurité, qui nous permet justement de ne pas avoir d’ingérence », a-t-il illustré.

Toute considération sur les systèmes d’exploitation mise à part, quels sont dans ce cas les critères qui ont présidé au choix de l’offre Orange / HPE ? Le ministère ne livre aucune information à ce sujet, mais le processus de décision semble ne pas avoir été de tout repos.

« Sur les deux réponses en cours, vous avez une réponse qui apparaît sûrement anormalement faible, et une réponse dont on pourrait se poser la question (…) d’une proportion anormalement forte », a révélé Sébastien Lecornu en commission, évoquant des décalages « sur le critère des délais, du prix, de la performance et du staff humain qui est mis à disposition ». Du fait de ces écarts « anormaux », le ministre ajoute qu’il a demandé au Contrôle général des armées de reprendre l’ensemble du processus d’attribution.

Moins de dix jours plus tard, celui-ci a donc finalement validé la procédure, et déclenché l’attribution du marché. « Le supercalculateur sera livré à l’autonome 2025 et pleinement opérationnel fin 2025 », annonce le ministère.

Un supercalculateur pour l’armement « info-valorisé »

Quels en seront les usages ? Il « permettra à la France de traiter souverainement de données confidentielles, pour le besoin des armées ainsi qu’aux entreprises de défense », explique le ministère.

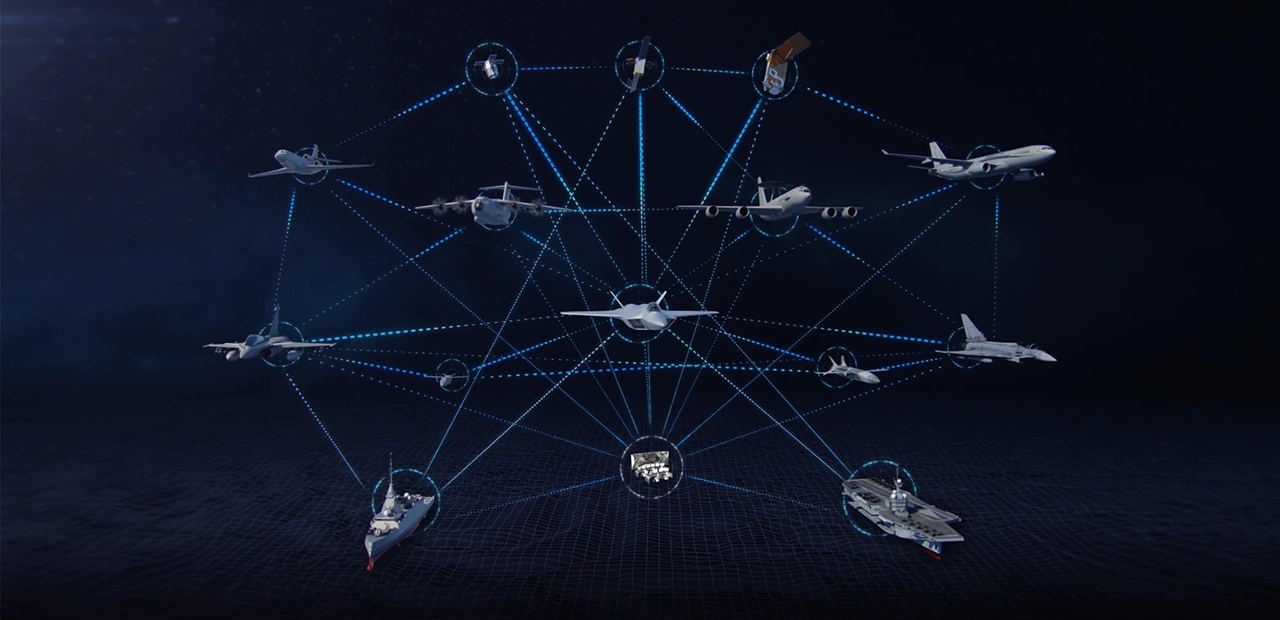

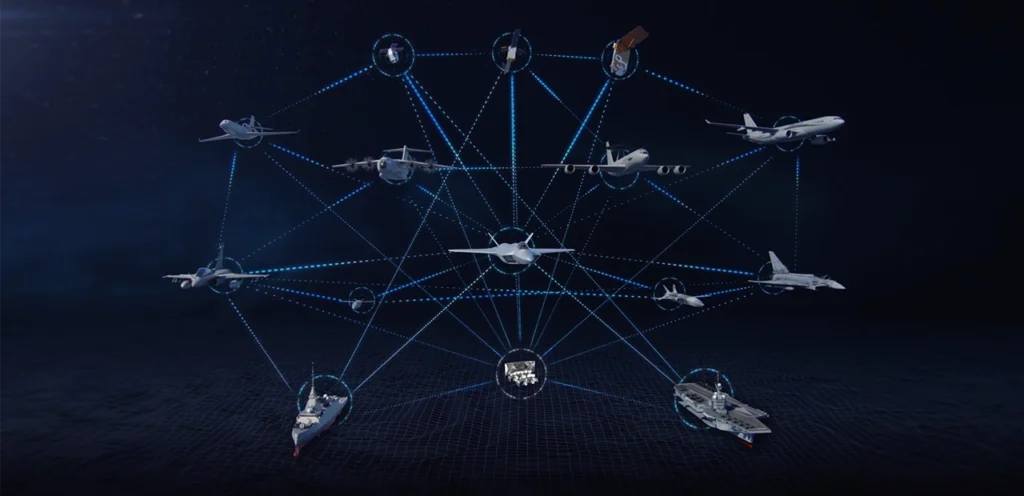

Cette nouvelle infrastructure – nom de code Asgard – doit notamment soutenir les travaux des Armées et des industriels de défense autour des dispositifs d’armement « info-valorisés », c’est-à-dire soutenus par l’intelligence artificielle, à l’image des programmes Scorpion (véhicules terrestres médians) et SCAF (Système de combat aérien du futur).

Elle a également vocation à soutenir les nombreux projets de recherche relatifs à l’IA, à l’échelle des différents corps de l’Armée. En mai dernier, le Centre d’interprétation et de reconnaissance acoustique, spécialisé dans l’écoute sous-marine, indiquait par exemple qu’il ferait appel à l’Amiad pour soutenir le travail de ses « oreilles d’or » grâce à l’IA.

Il sous-tendra également les différents projets de l’Amiad, qui se félicite à cette occasion d’accueillir bientôt son centième ingénieur – sur un plan de recrutement qui prévoyait 300 ingénieurs, chercheurs et doctorants, civils ou militaires, d’ici 2026. L’agence annonce ainsi avoir débuté le déploiement de Génial, un agent conversationnel, « équivalent d’un ChatGPT défense », dont l’accès sera ouvert à tous les agents du ministère des Armées dès la fin de l’année.

Orange et HPE construiront le supercalculateur classifié dédié à l’IA de défense

-

Deux candidats en lice

-

Souveraineté et composants américains

-

Un supercalculateur pour l’armement « info-valorisé »

Commentaires (42)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousLe 25/10/2024 à 15h49

Le 25/10/2024 à 16h07

Le 25/10/2024 à 16h19

Le 25/10/2024 à 17h03

Il est devenu quoi d'ailleurs ce soft ? O:-)

Le 25/10/2024 à 17h12

ça a été remplacé y'a quelques années par un autre soft, Source Solde, que cette fois l'Armée a eu le bon sens de ne pas développer en interne. De mémoire, c'est Sopra qui pilote maintenant

Le 25/10/2024 à 20h53

D'apres chatGPT (si quelqu'un à une meilleure source...) :

- Louvois a été confié à Eurogroup Consulting et Mc2i Groupe

- Puis Steria

- Puis Sopra (qui a fusionné avec Steria)

Le 26/10/2024 à 09h43

Wikipedia est une source qui cite elle-même ses sources.

On y voit que chatGPT ne raconte pas l'histoire correctement.

Le 25/10/2024 à 22h32

Eurogroup et MC2i étaient là pour la déploiement avec Steria.

Je souhaite qu'ils aient appris de leurs erreurs.

Modifié le 25/10/2024 à 17h04

Ils sont absolument adorables et méritent d'être protégés, c'est un fait, mais désolé, les "compioutaires", ils s'en fichent comme de leur premier brin d'algue...

(EDIT: en fait, plus ça va, plus je pense que les AI actuelles sont juste pour compenser le fait qu'on n'a toujours pas découvert de civilisations extra, du coup l'humanité qui ne croit plus au Père Noël se sent horriblement seule et abandonnée, du coup : IA qui parle, n'importe quoi pour meubler le vide, intérieur et extérieur...

Le 25/10/2024 à 18h49

N'hésite pas à écrire à la DGA pour leur dire que tu peux remplacer toutes les équipes qui travaillent sur ces sujets au sein des forces de défense, en tant que sommité.

À la réflexion, vu toutes tes autres interventions, tu peux même demander à l'ONU directement un poste de "sachant bienveillant illuminé ultime", ça ira même plus vite comme ça.

Le 25/10/2024 à 22h47

Modifié le 25/10/2024 à 23h03

Tout le monde sait que penser par soi-même, avoir son propre avis (qui n'est pas plus important que n'importe quel autre avis), ça ne devrait pas exister !

#Il #FAUT #penser #exactement #comme #les #réseaux #sociaux, #et #pas #autrement, #épissétout !

"Toute déviation est très dangereuse et devrait être éliminée." Bienvenue à Mouton Land !

P.S. Même s'il est vrai que je n'y connais rien, je me réfère aux spécialistes interrogé.e.s par Mathilde Saliou, qui connaissent bien le sujet et surtout ses conséquences concrètes.

Le 25/10/2024 à 23h48

Je sais qu'il est de bon ton de critiquer l'IA, surtout quand on y comprend rien. Mais c'est extrêmement présomptueux de parler de "merdes", "d'alternatives" etc face au travail d'équipes entières, tout ça pour s'avouer incompétent au plus au point à peine un message après.

Modifié le 26/10/2024 à 11h03

P.S. : Un complément d'information, par un autre spécialiste en IA, à voir en entier, passionnant et édifiant !

(Lien de @gg40, que je remercie).

P.S. 2 : Un deuxième complément d'information pour appuyer mon propos.

Modifié le 27/10/2024 à 12h03

Le 28/10/2024 à 04h52

Si tu ne vois pas la différence entre donner son avis de néophyte et se promouvoir donneur de leçons sur tous les sujets sans rien y connaître, je comprends pourquoi tu le défends avec tant de vigueur...

Modifié le 26/10/2024 à 18h06

L'IA est aussi utilisée pour l'aide au dépistage des cancers du sein, possibilité de faire un premier dépistage de cancer de la peau en pharmacie, aide au diagnostique de l'épilepsie pour prendre des exemples de mise en application positives des technologies autour du deep learning.

L'Inserm avait publié un long article plutôt intéressant en 2018, rafraîchi en début 2024 sur des cas d'usage de l'IA dans la santé, et équilibré en matière de recul sur le bullshit autour des technologies et ses risques à prendre en compte.

Modifié le 27/10/2024 à 12h04

Le 27/10/2024 à 12h03

D'ordre général, elle vomit sur les raisonnements binaires "bien/mal", "vrai/faux", "blanc/noir".

Un mot important se trouvait dans mon message, saurez-vous le trouver ?

Modifié le 27/10/2024 à 12h07

Le 27/10/2024 à 12h46

Le 27/10/2024 à 13h41

Le 27/10/2024 à 15h28

"Tous les agents" inclus donc aussi des non-spécialistes, et ça, AMHA ça ne passe pas du tout !

Par contre, que des algorithmes très spécialisés ET entraînés dans ladite spécialité ET interrogés par des spécialistes et uniquement par des spécialistes, puissent être utiles à la Science avec un grand S, je le conçois fort aisément ! J'étais au courant de l'utilisation de l'IA dans les recherches en cancérologie, grâce à un article dans un magazine scientifique dont j'ai oublié le nom... Je crois que c'est Epsiloon, mais je n'en suis pas sûr...

Et j'ai aussi l'impression persistante que toutes ces projets de recherche / développement avec le mot magique "IA" dedans ont complètement "bouffé" toute l'attention et les crédits accordés aux chercheurs et autres pionniers en informatique, qui ne tournent pas tous autour de l'IA. Il existe plein, plein de domaines différents, comme les réseaux ou la cryptographie par exemple, qui ont aussi besoin de crédits et d'attention.

Le 27/10/2024 à 21h15

Pour la petite anecdote, j'ai travaillé sur ce dernier cas et j'avais considéré le besoin métier comme overkill par rapport à la finalité. Le support voulait un chat bot pour que les exploitants N1 (profil = 1er type choppé dans la rue avec comme seul critère savoir parler anglais) obtiennent des infos sur des procédures type pilotage. J'ai pas trouvé celui-ci très pertinent et j'avais plutôt préconisé d'utiliser la BDD de l'ITSM pour exploiter les dix ans d'incidents et problèmes qu'elle contenait comme support de connaissance. Ca ne c'est pas fait, hélas.

Néanmoins, cette implémentation, et je l'ai vue plusieurs fois, c'est du RAG. Le modèle sert avant tout à traiter de vraies données en direct (le tout stocké dans des bases vectorielles, plus adaptées pour le ML) et va rechercher dans des vrais docs. Le risque de biais ou d'erreur est moins élevé car on utilise pas les "connaissances" du modèle (en dehors des cas d'usage pour exploiter les capacités d'analyse sémantique des LLM, reposer uniquement là-dessus est une connerie, je l'ai déjà répété plusieurs fois ici d'ailleurs) mais des données réelles. Par contre il réside toujours un risque de déformation du contenu, cela dépend avant tout du paramétrage (trop déterministe ou trop aléatoire). C'est d'ailleurs pour ça que la traduction par un LLM est sujette à précaution. Le LLM ne traduit pas, il réécrit le texte (de mémoire, il est conseillé d'utiliser des paramètres plus déterministes pour ça). Ça dépend aussi de l'efficacité du modèle. Dans mes bricolages perso, j'ai vu de sacrés écarts entre Mixtral et Llama par exemple (en la défaveur du premier, mais celui-ci commence à être vieillot et je pense que Large se fera moins avoir).

Dans le cas du RAG, le modèle récupère des informations et, surtout, cite les documents sur lesquels il s'est appuyé pour produire son résultat. Et si celui-ci a fait l'objet d'un entraînement spécialisé sur les données de la défense, le risque qu'il se plante est réduit. Un peu comme un modèle spécialisé dans le juridique entraîné sur les textes de loi, les décisions de justice, etc. De manière hyper vulgarisée, un modèle de langage il apprend à lire quand on l'entraîne. Plus on l'entraîne sur une masse de données, plus il sera capable de comprendre la sémantique. Et plus on l'entraîne sur des données spécialisées (fine tuning), plus il sera pertinent dessus.

De mon côté, dans les expériences pro que j'ai pu avoir avec les produits d'IA générative, j'ai pu tester l'intégration de GitHub Copilot avec des devs (les retours furent intéressants et même assez prévisibles, les juniors enthousiastes, les seniors trouvant vite les limites du produit), ou encore la conversion de code entre deux versions majeures d'un framework spécifique qui avait permis de déblayer du 70/30.

Du côté de l'algorithmie pure et dure, je suis incompétent dans le domaine, c'est pas mon métier. Là où les modèles de langage, de text to speech et inversement, ou de diffusion, restent des logiciels du marché qu'on intègre dans un SI. Et là, c'est mon métier et j'aime bien ouvrir le capot pour comprendre un minimum comment ça marche

Pour ton dernier point, je déplore aussi ces effets de mode dans le public et le privé qui détournent l'attention que d'autres projets mériteraient d'avoir. On nous a vendu ces dernières années de la blockchain, du metavers, et j'en passe et des meilleurs, là où les entreprises n'en ont pas grand chose à faire. J'ai quand même observé que pour l'IA générative, le métier s'est montré plus moteur dans la recherche de cas d'usages car c'était plus concret pour eux que la techno à la mode du moment. C'est aussi une des rares technos "récente" (parce qu'elle est quand même vieille) pour qui on peut avoir des résultats visibles (bons et mauvais, souvent mauvais par méconnaissance et inexpérience) et des PoC parlants. Là où un commercial qui vendait de la blockchain et du NFT, c'était que de la projection nébuleuse.

Modifié le 27/10/2024 à 23h37

Ton témoignage est important dans le sens où nous en apprenons un peu plus sur l'aspect "intégration du ou des modèle.s" intégration qui du coup apparaît être une phase excessivement délicate. Suivant le talent de l'intégrateur (et la connerie du client...

(Concernant la traduction automatique, je me suis déjà exprimé sur le sujet dans ces colonnes, en tant que traducteur amateur (bénévole) de sous-titres de séries tv, curieux de tester la chose (exemple : DeepL), j'ai vite compris les limites et l'inutilité des AI de traduction pour tout ce qui touche de près ou de loin à une œuvre d'art, et pour moi les séries télé / web et anime sont des œuvres d'art qui méritent d'être respectées.

Pour cela une recherche contextuelle / vocabulaires spécialisés métiers / expressions urbaines ou argotiques est absolument indispensable, si on veut un minimum de qualité, le tout adapté à un public Français qui n'a pas forcément toutes les refs. Et ça, les IA en sont incapables... pour le moment !)

Enfin, concernant la blockchain, mon texte de référence, incroyablement bien argumenté et construit, avec des exemples concrets, est celui-ci : Blockchain, the amazing solution for almost nothing.

(scroller vers le bas pour lire l'article, en regrettant amèrement au passage que le très remarquable site de réflexion "The Correspondent" qui m'a tant apporté ait dû fermer ses portes...

Le 28/10/2024 à 08h29

Mais derrière, il faut déjà commencer à donner un bon system prompt au modèle, qu'est-ce qu'il doit faire et ne pas faire.

Exemple : tu es un assistant pour un accueillir les clients d'une assurance, tu ne parles pas des autres compagnies. Dans le cas de celui sur lequel j'avais bossé, le system prompt indiquait que le bot ne traitait pas d'autres questions que celles relatives aux incidents à analyser (ex : demande lui où acheter une playstation, il refusera de répondre).

Ensuite, l'efficacité du modèle à bien le prendre en compte est importante. Sans oublier les paramètres de température, les top je-sais-plus-quelle-lettre, pour le rendre plus ou moins déterministe ou créatif, etc.

Un article que je recommande pour comprendre comment fonctionne GPT (et certainement les autres modèles de langage) d'une façon accessible et imagée : How GPT works: A Metaphoric Explanation of Key, Value, Query in Attention, using a Tale of Potion.

Tiens, ce week end j'ai voulu essayer de me faire un petit assistant de relecture pour mes écrits (il fait un résumé, relève les fautes de français, les tournures lourdes, et propose une critique). En raison de la limite technique, j'avais dit au modèle "attend que l'auteur te dise quand procéder". J'envoyais les morceaux de texte petit à petit parce que le prompt allait être trop gros.

Sur Llama 3, il répondait à chaque entrée de texte : "OK, dites moi quand je peux y aller". Puis je lui donnai le go et il me fit son rapport. La qualité du rapport était correcte mais évasive sur la liste des erreurs et tournure (mais mon system prompt devait jouer).

Sur Mixtral (plus vieux), il fut incapable de s'arrêter et balança direct l'analyse sans attendre que j'ai mis tout le texte, un véritable ado en pleine puberté. Le rapport était à chier, il inventait des fautes, ne comprenait pas les tirets cadratins, et parfois il confondait les guillemets anglais et français.

J'ai pas pu aller trop loin car la machine qui faisait tourner le modèle était limitée et les gros prompts plantaient le bazar. J'ai essayé le même exercice sur les modèles hébergés par Infomaniak, mais ils ont aussi des limitations techniques je pense, car au bout de 3 gros prompts plus de réponse.

Un article sur Next avait parlé d'un POC en Australie qui n'avait pas abouti (j'ai pas réussi à le retrouver, le moteur de recherche est toujours perfectible). Dans ma lecture du document, j'y voyais que le temps accordé à l'étude fut très réduit et qu'ils ont pas eu la possibilité de raffiner le paramétrage et le system prompt. Le résultat fut inefficace, et pas surprenant en raison du délai accordé.

Bref, s'pas magique contrairement à ce que les vendeurs font croire.

J'avais lu ton retour d'expérience sur la traduction automatisée et j'avais trouvé le point de vue très intéressant :)

Merci pour l'article sur la blockchain, je garde ça de côté.

Le 25/10/2024 à 18h17

Modifié le 25/10/2024 à 18h37

Et le chat de "schrodinger" il sera mort ou vivant une fois le projectile tiré?

Le 25/10/2024 à 21h03

Donc quoi, la seule différence entre les deux cas c’est la phase de test (pour la partie scientifiques) ?

Le 25/10/2024 à 21h19

Donc, comme pour un humain, c'est son type d'entrainement/expérience qui permettra à une IA d'être performante. Comme le disait Holmes, 'a quoi cela me sert (dans mes enquêtes) de savoir que le soleil tourne autour de la terre ?' ...

Le 26/10/2024 à 11h50

Le 25/10/2024 à 21h11

Heureusement, ce n'est pas un article sur le cyclimse...

Le 25/10/2024 à 22h03

Quand on prends du Nvidia on attend plus longtemps, beaucoup de boites n'arrivent pas à avoir des GPU Nvidia. Je dirais plutôt 2026 que 2025

Le 25/10/2024 à 22h21

Le 25/10/2024 à 23h05

Modifié le 25/10/2024 à 22h44

HPE (et oui je pense pas que ce soit HP), est un choix raisonnable mais Atos est français. Oui, ils ne produisent pas leur propre matériel, mais c'est pas de leur faute. La France n'a pas les politiques adaptés à ses cerveaux, et puis il faudrait pas vexer les américains & Ursula.

Par contre, le "comme je le dis souvent, beaucoup d’ordinateurs du ministère des Armées ont Microsoft, c’est comme ça, il n’y a pas de solution française. C’est plutôt la mise en œuvre de ce soft, la manière dont les ingénieurs le mettent en œuvre, avec nos protocoles de sécurité, qui nous permet justement de ne pas avoir d’ingérence"

Et comme je le dis souvent les politiques sont les derniers de classes en informatique ! (Au tiens, encore un gars sortant de fac de droits... De là en tirer une causalité....)L. a solution française monsieur le ministre des armées, c'est un buget et des ingénieurs pour maintenir une distro Linux adapté ! Vu la gabagies de la Macronie, ça doit bien pouvoir se trouver, non ?!

Et là monsieur le ministre, c'est français, souverain et sécurisé !!

PS : ça vous parle le IME, la NSA, le Dual EC RGB et le principe de Kerchkoff et Palentir ?

Le 26/10/2024 à 09h50

Pour le réseau, je suppose que ça dépends assez fortement des critères personnels sur ce qui est bon ou pas.

HP je suis pas fan non plus mais plus sur l'aspect commercial (coder les SFP et les disques pour qu'on puisse ne mettre que ceux acheté 10x le prix chez HP par exemple) que sur le matériel , sur lequel j'ai eu, statistiquement, plus de panne que sur du Dell par exemple (je parle de serveurs) - et là encore impossible de savoir "ce qui se passe" , le support réponds "achetez un nvx serveur car le votre est plus sous garantie".

Le 26/10/2024 à 16h15

Malheureusement pour Orange, ils n'ont jamais réussi à construire une infrastructure cloud efficace en leur temps. D'où le fait, que mis à part le réseau je ne vois pas l'intêret d'Orange sur le plan technique.

En revanche, si on dézomme un peu on peut en voir un. Les états-unis utilise les entreprises françaises comme vecteur pour infiltrer nos derniers marchés (Comme Thalès avec son cloud US mais normalement SecNum...). Et toute le monde est gagnant à court terme. Les US ont leur marché chez nous et nous affaiblissent (note que les politiques français aident aussi de leur coté) et les boîtes françaises ont des rentrées d'argent sous forme d'un "loyer". Mais sur le moyen ou long terme, si on ne se dépêche pas de stopper ceci on est bon pour être dépendant des US comme un drogué de son dealer...

Le support de ces boites que tu cites je ne les aime pas. Faut batailler des heures pour avoir quelqu'un de compétent techniquement qui ne lie pas sa fiche. Par contre, une fois que tu arrives à cette personne, les problèmes sont vite résolus. Pour le support commercial... Je n'ai jamais eu assez de points en diplomatie pour pouvoir parlementer avec eux, merci aux collègues qui pouvait me remplacer :)

Le 27/10/2024 à 14h07

C’est juste pas mis en avant parce que Cloud Avenue, le navire amiral (et FCA/FE/FCP en leur temps) sont des usines à gaz, avec trop d’intervenants et de commerciaux, chefs de projets et toute l’armée mexicaine. (Et probablement quelques décisions discutables dues à des tentatives de faire simple)

Ça n’est pas tellement compatible avec une tentative de cost-killer tel que les GAFAM les ont construits…

Il y a des clients privés, qui ont leur cloud privé, qui sont très contents de ce qu’on leur a construit.

Le 28/10/2024 à 21h38

Mais néanmoins, si je comprends mieux la position d'Orange je vois pas le lien avec le HPC. L'infra est une chose, mais les outils derrières (toolchains, compilateurs), le portage des libs et l'optimisation des codes, etc.... C'est pour la partie HPE ?

Parce qu'HPE, Eviden et co j'en ai entendu parlé sans soucis, mais je n'ai jamais vu ni eu un interlocuteur d'Orange dans ce domaine.

Le 29/10/2024 à 10h27

Le 26/10/2024 à 15h38

Comme je ne connaissais pas, j'ai cherché ce que c'était.