Gigabyte MC12-LE0 : analyse d’une carte mère AM4 (B550) avec IPMI/BMC, pensée pour les serveurs

Allô, les revendeurs ?

Le 23 août 2022 à 09h02

6 min

Sciences et espace

Sciences

Dans le domaine des cartes mères pour serveurs, Gigabyte a su se démarquer ces dernières années, notamment avec une offre destinée aux processeurs AMD de plus en plus étoffée. Le constructeur propose depuis peu un modèle sur socket AM4 qui pourrait en intéresser plus d'un, notamment pour un Home Lab.

Lorsque l'on parle de cartes mères pour serveurs, il est souvent question de modèles nécessitant des processeurs spécifiques, avec de couteuses options. De quoi décourager ceux qui cherchent simplement un modèle abordable, équipé d'IPMI/BMC pour en assurer la gestion distante même en cas de problème.

ASRock Rack l'a bien compris et a surfé sur la mode des Home Lab ces dernières années en proposant des modèles « serveur » destinés à des processeurs grand public ou pour station de travail. Plus récemment, la branche destinée aux entreprises du Taïwanais Gigabyte a décidé de suivre la même tendance.

On l'a vu lors de notre test de leur MX33-BS0 ou de l'annonce de nouveaux modèles AMD. La mise sur le marché de la MC12-LE0 suit la même tendance. Basée sur le chipset B550, elle permet de placer un simple Ryzen dans des serveurs. Une tendance qui intéresse bien au-delà des Home Lab : même les hébergeurs s'y mettent.

Mais en pratique, qu'est-ce qu'elle a dans le ventre ? Nous l'avons analysée pour nous faire une idée.

Une carte basique mais complète, parfaite pour un NAS

Première bonne nouvelle : Gigabyte n'a pas joué la carte de la débauche côté caractéristiques. La MC12-LE0 est ainsi un modèle Micro ATX avec un chipset milieu de gamme mais récent, le B550, qui peut apporter tout ce qui est nécessaire à un serveur sans verser dans l'excès. Certains regretteront néanmoins l'absence de réseau à 10 Gb/s.

En effet, on a simplement droit à 2x 1 Gb/s (Intel I210-AT) en plus du port RJ45 servant à la gestion distante (Realtek RTL8211E). Celui-ci est relié à une solution ASpeed AST2500. On peut néanmoins compléter la carte via l'un de ses deux ports PCIe 4.0 : un x16 et un x4. Le premier est suffisamment espacé du second pour que l'on y place une carte occupant deux emplacements. Attention néanmoins, c'est là que se trouve le seul connecteur M.2 2242/2280.

Autre regret, celui-ci est de type PCIe 3.0 x1, n'espérez donc pas y placer un foudre de débit. Pensez également à l'utiliser avec un dissipateur si une carte graphique est utilisée par exemple. Pour certains, le principal sera ailleurs : la carte dispose de six ports S-ATA, de quoi utiliser de nombreux HDD, pour un NAS par exemple.

Pour le reste, on dispose d'une connectique plutôt classique : deux USB 3.1 (5 Gb/s), des ports VGA et série pour la sortie console, de quoi ajouter des ports USB 2.0 et 3.1 (5 Gb/s) sur le PCB, on a même droit à un connecteur Type-A directement, à utiliser lors d'une installation initiale ou pour laisser un périphérique dans le serveur.

Une carte bel et bien destinée aux serveurs

Un connecteur TPM permet d'en connecter un de manière physique (CTM010), pour ceux ne voulant pas de sa déclinaison logicielle, gérée par le processeur. Côté mémoire, on a droit à quatre emplacements pour de la DDR4, jusqu'à 3,2 GHz. Les modèles ECC et non ECC sont gérés, jusqu'à 4x 32 Go selon Gigabyte.

Modèle pour serveur oblige, le socket AM4 est placé à 90° par rapport à une carte mère classique, pour favoriser un refroidissement allant de l'avant à l'arrière du serveur. Il en est de même pour les emplacements DDR4 qui ne doivent ici pas freiner le flux d'air des ventilateurs dans un rack. On trouve d'ailleurs six connecteurs PWM pour ces derniers et d'autres raffinements comme un bouton d'identification à LED que l'on peut allumer à distance.

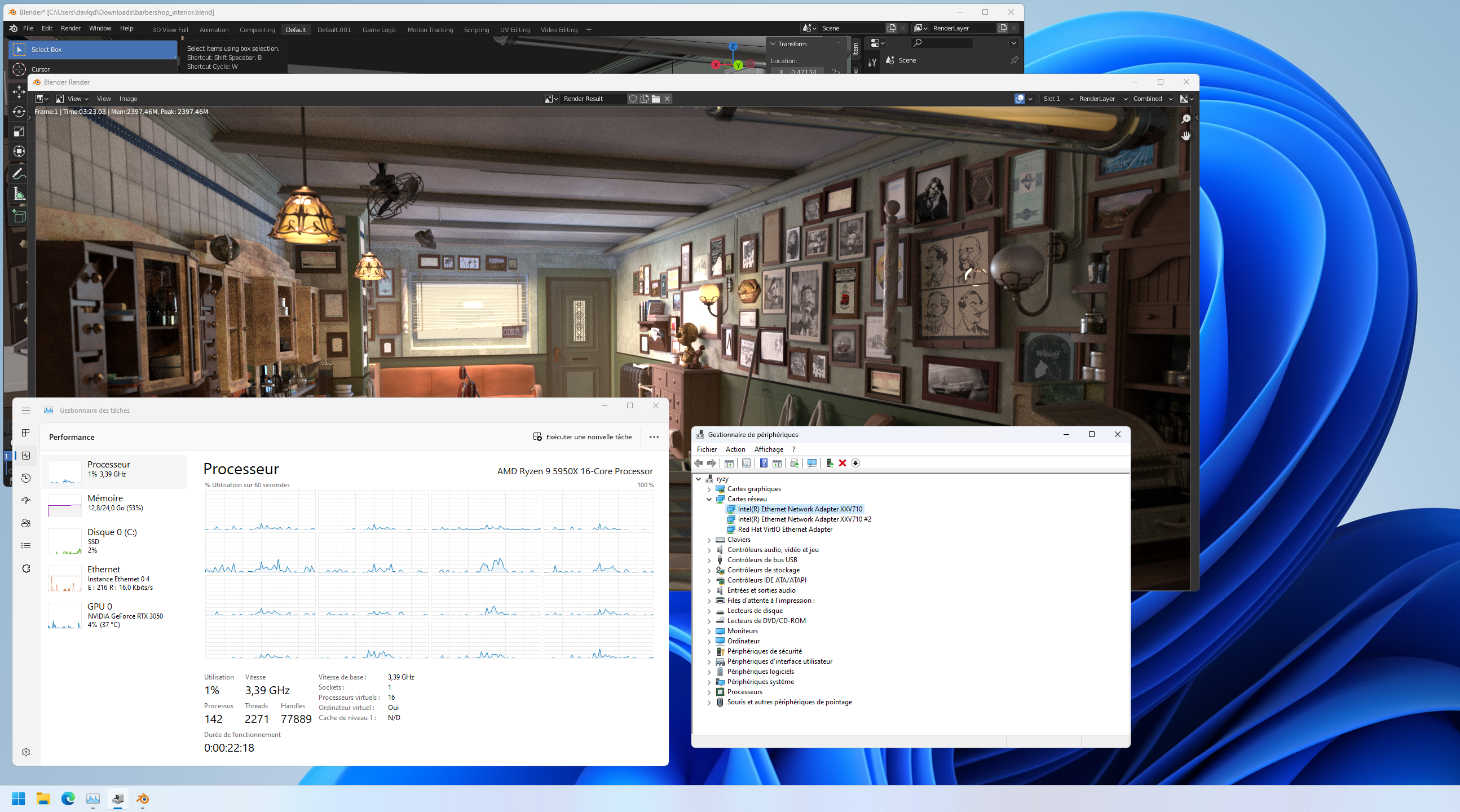

Le BIOS est assez complet et l'on appréciera que, contrairement à la MX33-BS0, le support d'IOMMU soit bien de la partie, avec la possibilité de gérer le passthrough PCIe. Nous avons ainsi pu partager une carte réseau et une carte graphique avec une machine virtuelle installée via Proxmox VE 7.2 (voir la capture en fin d'article).

La gestion distante se fait via l'habituel BMC et son interface HTML5, notamment pour le KVM. Attention, le mot de passe par défaut correspond au numéro de série de la carte (plutôt que les habituels admin/admin). Par contre il faudra toujours faire sans clavier français, seuls l'anglais et le chinois étant proposés.

L'ensemble est plutôt classique, toujours assez complet. On apprécie néanmoins la présence de quelques options que l'on ne voyait pas habituellement comme la possibilité de sélectionner le périphérique de boot dans l'interface HTML5 du KVM, on peut aussi accéder au BIOS dans une interface web, etc.

La gestion distante peut également se faire à travers le standard IPMI ou les outils spécifiques de Gigabyte tels que Server Management (GSM) ou la CLI maison. Ils s'appuient sur IPMI mais également le standard Redfish pour assurer une gestion plus souple et notamment de flottes de serveurs.

Ils permettent d'ailleurs un accès depuis un appareil mobile avec une intégration à VMware vCenter.

Une carte intéressante mais peu disponible

Seul regret finalement : que ce modèle ne soit pas encore vraiment distribué via des canaux classiques. Espérons que des revendeurs comme LDLC, qui ont su proposer des modèles ASRock Rack afin de les rendre accessibles au plus grand nombre, proposeront également cette référence dans les semaines à venir à un prix raisonnable.

Pour le moment, il faudra vous tourner vers Gigabyte pour de la vente en direct ou via ses importateurs en France, le tarif dépendra alors de la quantité demandée. On note d'ailleurs que la B550D4-4L d'ASRock Rack n'est pas mieux distribuée chez nous, dommage. On la trouve à un peu moins de 330 dollars outre-Atlantique.

Cette MC12-LE0 est en tous cas composée de manière à ce que chacun puisse y trouver son compte : amateurs de HDD, adeptes de réseau rapide ou de GPU, le tout dans un design compact et passif. Certes, on aurait aimé une déclinaison avec des cages SFP+, mais cela pourra venir dans un second temps. Et pourquoi pas en AM5 ?

Ceci est une machine virtuelle avec GPU et réseau à 25 Gb/s en passthrough PCIe

Gigabyte MC12-LE0 : analyse d’une carte mère AM4 (B550) avec IPMI/BMC, pensée pour les serveurs

-

Une carte basique mais complète, parfaite pour un NAS

-

Une carte bel et bien destinée aux serveurs

-

Une carte intéressante mais peu disponible

Commentaires (82)

Le 23/08/2022 à 09h13

Merci David pour l’article !

Petite question : As-tu connaissance de CM similaires avec des dual sockets pour de l’AMD pour du grand public ? Je sais qu’on peut en trouver chez SuperMicro mais je n’ai toujours pas compris comment faire pour en acheter. Je dois être un peu idiote .

.

Le 23/08/2022 à 10h30

En dual-socket t’auras des cartes mères avec du LGA4094 c’est à dire pour les EPYC, en terme de tarif c’est pas donné

Le 23/08/2022 à 11h36

Merci, je savais déjà cette fonctionnalité était l’apanage des EPYC (et non Ryzen ni des ThreadRippers). Ce qui me pose problème, c’est pour en commander une en tant que particulier. Parce des EPYC, j’arrive en trouver facilement. Mais des CM dual-socket, il faut être une entreprise pour.

Le 23/08/2022 à 10h18

La même en mini itx.

Le 23/08/2022 à 11h03

Pas mal du tout. Dommage qu’on puisse pas faire un RAID 1 natif de M.2…

Le 23/08/2022 à 11h26

J’aimerais bien une avec au minimum un header Thunderbolt pour pouvoir brancher des boîtier 6 ou 8 HDD en TB.

Le 24/08/2022 à 15h23

Là on est dans une optique serveur, pas workstation. Brancher un DAS Thunderbolt ça ne se fait pas vraiment dans le monde serveur. On va plutôt brancher un HBA avec port SFF externe.

Le 23/08/2022 à 12h38

Intéressant en effet pour un homelab. Sur leurs spécifications seul Windows 10 est supporté. Ceci ferme pas mal de portes et le parait étonnant vu la cible. Aucune idée du support pour GNU/Linux (et proxmox en particulier) ?

Le 23/08/2022 à 12h51

C’est clairement une carte serveur (IPMI, etc.), et là Linux est ultra-majoritaire.

Le support Windows sur les cartes serveur est aussi bon que le support Linux sur les cartes desktop (i.e. chacun se démerde).

Le 23/08/2022 à 12h47

question probablement con, mais ce genre de carte permet d’overclocker (ou downclocker) ou pas … ?

Boot possible sans GPU ? (j’imagine que oui mais bon..)

Le 23/08/2022 à 14h52

Sachant que j’ai une carte mère chinoise pour xeon, sans aucune sortie écran qui boot sans GPU (c’est même mon utilisation courante), j’imagine difficilement une carte mère de marque connue avec un port VGA qui boot pas sans GPU.

Le 23/08/2022 à 12h53

Les entreprises, clientes typique des cartes dual-CPU, commandent habituellement des serveurs complets et assemblent rarement leurs machines. Il est logique que le marché de détail de ce type de carte mère soit une niche.

En cherchant moins d’une minute, j’ai trouvé ça :

https://www.senetic.fr/product/ROME2D16-2T

(ils vendent aux particuliers).

Le 23/08/2022 à 13h07

Tu penses qu’on peut leur faire confiance à ce site ? J’en ai bien sûr trouver des sites comme ça. Mais au vu du prix de ses bestioles je veux être sûr de ne pas me faire avoir.

Le 24/08/2022 à 08h37

J’ai commandé en perso et pro sur ce site, jamais eu de problème.

C’est un gros fournisseur, pour la France, ca part d’Europe de l’Est généralement, Pologne il me semble.

Le 23/08/2022 à 14h49

Effectivement la carte est référencée, mais par contre il faudrait qu’elle soit en stock !

Le 23/08/2022 à 14h01

yeah ! le retour du homelab de @david \o/

Le 23/08/2022 à 14h29

Pas de PCIE Gen4… dommage pour moi :-(

C pour ça que je parts plutôt sur la ASRock Rack X570D4U (dispo sur ldlc)

Le 23/08/2022 à 14h42

Pour moi, R.A.S., Senetic est un gros revendeur français de Mikrotik / Ubiquiti de ce que j’en sais.

Le 23/08/2022 à 15h48

Perso, quand je sais que la machine va rester idle pendant un temps (genre la nuit) et que je ne peux pas l’éteindre, j’interagis directement avec le pilote (chez Intel, mais je pense que c’est le cas aussi chez AMD) pour bloquer la fréquence à la fréquence min. du CPU, désactiver le turbo, mettre le gouverneur au minimum et parfois, désactiver l’HT. Je dis pas que c’est aussi bien que la mise en veille ou autres, mais j’ai noté une baisse de la consommation de quelques dizaines de watts (désolé, j’ai plus les valeurs en tête).

Le 23/08/2022 à 14h43

David, qui a rédigé l’article dit, et montre à la fin, une VM windows dans proxmox avec passthrough PCIe, donc il semblerait que ca fonctionne sans problème.

Le 23/08/2022 à 14h48

Ce qui m’embête avec AMD, c’est que la consommation idle de leur CPU est bien plus élevée que leur équivalent Intel. Sachant que pour un homelab, la machine passe 100% de son temps à ne rien faire… c’est un peu du gachi.

Personnellement, j’ai suivi la hype AMD et j’ai monté un PC à base de 3700x il y a deux ans. Quand je vois la conso idle de ma config à 60W sans aucun hdd, je pleure. Mon ancienne config à base de i5-6600 tournait à 35W idle (et je trouvais déjà ca beaucoup)… Et il semblerait que les E-Core des Intels récent sont vraiment intéressants (sous windows uniquement encore).

Le 23/08/2022 à 17h36

Je serais personnellement intéressé par quelque chose de similaire avec CPU ARM ou RISC-V, pour une chauffe/conso électro plus adaptée à un home lab :)

J’avais entendu parler des Solidrun en ARM et des SiFive HiFive Unmatched en RISC-V, mais ça me semblait difficile d’accès depuis la France…

Le 23/08/2022 à 17h52

Tu n’aurais pas un logiciel ou un pilote qui empêche le CPU de se mettre dans un état de veille suffisamment profond en idle ? Un exemple tout bête, c’est MSI AfterBurner qui, s’il est efficace pour jouer sur les fréquences GPU à la hausse comme à la baisse, a le défaut de bloquer le CPU dans un état où il surconsomme.

En temps normal CPU et mobo ne consomment pas autant en idle.

Le 23/08/2022 à 18h17

Quelqu’un peut m’expliquer comment la partie kVm (video) fonctionne ? Sans GPU ? Et si je mets un GPU, comment je récupère la vidéo ? (Ie comment la puce de management la récupère ?)

Le 23/08/2022 à 19h22

Un GPU est intégré à la puce de management Aspeed. C’est lui qui fait la récupération de domaine.

Si tu mets un GPU, l’OS une fois booté peut passer sur le GPU externe ou rester sur le GPU Aspeed.

Le 23/08/2022 à 20h16

Ce qui me fait toujours rire avec ces cartes sous windows 10, c’est qu’elles ont 2 ports réseaux et qu’il est toujours impossible de les utiliser en Trunk sous windows 10.

Ou est l’intérêt donc de vouloir installler Windows 10 dessus ou de mettre 2 ports dans ce cas la ?

Le 23/08/2022 à 21h36

J’ai déjà joué avec les paramètres CPU pour voir l’impact coté conso. Alors c’était pas le but de le laisser ces paramètres, mais juste voir leur impact.

Bref, rien n’y fait, ou très peu genre baisse de 2W… Quand on regarde un les thread reddit, on va dire que pour une config AMD, c’est “normal”.

Bref, mon prochain PC sera très probablement un Intel à nouveau, même si ça consomme plus en charge (jeux vidéos), c’est largement rattrapé par tout le temps que le PC est “idle” (net, bureautique).

Le 25/08/2022 à 10h17

Je ne parlais de jouer avec les paramètres de l’UEFI mais directement avec le sysfs du noyau. Je me souviens d’une CM sous AMD où mon noyau n’en avait rien à faire de mes configurations concernenant le CPU.

Mon grain de sel est qu’en faisant ceci sur mon laptop Intel (MSI GE65 Raidser 9SE, Fedora 36, GPU Nvidia idle (mais pas off).), j’arrive à gagner ~2h15 d’autonomie en faisant du surf (NXI, Gitlab, Wiki, Elsevier) et de la bureautique légère (LaTeX).

Le même comportement avec l’UEFI (pourtant autant que je peux contrôler les coeurs logiques, le turbo et leur fréquence), je n’arrive qu’à ~1h45. L’écart me parait trop grand pour être simplement attribuer à des écarts de comportements et de mesures.

Le 23/08/2022 à 21h38

Quelle idée de vouloir mettre windows sur un serveur… Et si vraiment y a pas le choix faut le mettre dans une VM sous Proxmox, comme ca, plus de problème de vlan.

Le 23/08/2022 à 21h58

Attention à ne pas confondre consommation et efficience.

Un HP Prodesk 400 G3 mini (que je possède) avec un CPU G3900T + 16 Go de RAM + NVMe + SSD SATA, ca consomme 7W idle avec un Proxmox qui tourne dessus. Mesuré au wattmetre à la prise 220V. Et en terme de puissance, c’est 3 fois plus performant qu’un RPi4 qui consomme 4W idle avec moins de RAM, et stockage SD.

Si l’objectif est vraiment l’ultra basse conso, je pense pas qu’il y ai beaucoup de choix en x86. Donc pour faire tourner un DNS de ou des bricoles domotique, ca passe. Sinon, je trouve qu’il y a du bon matos efficient en x86 également, avec le bénéfice d’avoir un UEFI, du PCIe pour le stockage, du SATA, de la RAM extensibe, etc…

En cherchant un peu, je suis tombé la dessus: https://uni.hi.is/helmut/2021/06/07/power-consumption-of-raspberry-pi-4-versus-intel-j4105-system/

Une plateforme à base de j4105, ca descend même à 4W, soit autant qu’un Rpi4.

Le 24/08/2022 à 16h25

Merci beaucoup pour la réponse complète

Ce qui m’intéresserait serait effectivement l’ultra-basse consommation “au repos”, mais où je ne serai pas non plus trop limité.

Mais en soi, le fait que la carte SiFive Unmatched soit dans un format standard (mini-ITX, pouvant donc être mise dans un boitier), a des E/S courantes et tout de même 16GB de DDR4, peut-elle ne pas constituer un home-lab de base ? Quitte à avoir à compiler soi-même quelques trucs…

Quant à l’exemple que j’avais donné en ARM (les SolidRun), je viens de retrouver la gamme en question : https://www.solid-run.com/arm-servers-networking-platforms/honeycomb-lx2/ ; mais effectivement de mémoire ça ne poussait pas aussi loin niveau performances que du Ampere.

Le 24/08/2022 à 05h16

Dual Socket = forcément EPYC. Tu peux trouver des revendeurs qui proposent des cartes, mais plutôt en ASRock Rack/Gigabyte qu’en SuperMicro qui est plus focus sur les intégrateurs/partenaires que la vente à l’unité (tu trouves quelques références via Amazon mais bon). Tu peux aussi regarder du côté des serveurs complets mais ça aura forcément un coût. PCSpecialist en propose de mémoire, avec un peu de personnalisation possible.

Tu as des réfs sur des designs compacts, genre la X570D4I-2T d’ASrock Rack

NVMe/TCP est ton ami

Bonne chance sur de l’AMD. Certains l’on fait mais ça reste rare et c’est tout sauf la priorité sur une carte serveur. Mais là aussi : NVMe/TCP et iSCSI sont tes amis

Un conseil : lire l’article attentivement

OC oui tu as des options, après l’intérêt pratique… Je l’ai déjà expliqué dans de précédents articles, mais l’intérêt sur des Ryzen est que ce genre de carte n’a pas besoin de GPU puisqu’il y en a un intégré sur le BMC pour l’accès Remote (la puce ASPeed). C’est aussi pour ça que tu peux passer le GPU principal en passthrough PCIe.

Senetic est un site qui revend pas mal aux PME mais qui est accessible à tous. Je n’ai jamais commandé chez eux à titre perso mais normalement c’est un site sérieux

C’est plutôt ça mon Home Lab du moment

Tu parles du NVMe ? Je serais curieux de savoir ce qui te pousse à viser le PCIe 4.0 spécifiquement, côté besoin concret je veux dire ?

Si tu peux économiser plusieurs dizaines de watts sur une machine Intel, c’est que tu as un souci de gestion de ton passage au repos. Une plateforme Intel ça consomme à peine 20 watts au repos pour info.

En ARM ce sera forcément du Ampere Computing, donc serveur complet uniquement. Par contre en RISC-V aucune chance de voir ça à court terme. Pour rappel, les cartes SiFive (j’en avais testé une) c’est du dev board assez cher avec très peu de perf et pas du tout orienté serveur (avec IPMI/BMC & co).

Pour faire court : parce qu’il y a un GPU ;)

Le 24/08/2022 à 07h15

Question bête, si j’installe Proxmox sur mon serveur qui a une carte graphique, ai je besoin (ou puis je) faire du passthrough avec une autre carte graphique pour des VM ?

Le 24/08/2022 à 07h23

En passthrough, la carte (ou le disque, ou le port USB) est dédiée à la VM et ne peut pas être partagée, même avec l’OS hôte.

Par contre, la plupart du temps les VM fonctionnent sur une carte graphique virtuelle (genre une carte VGA standard), elles ne dépendent pas de la carte graphique de l’ordi.

Le passthrough graphique est utile si tu as besoin des fonctionnalités de la carte graphique: pour lancer des jeux à streamer (par exemple avec steam), ou pour du calcul GPGPU.

Il y a aussi il me semble des pilotes capables de partager les ressources d’une carte graphique entre plusieurs VM, mais le pilote est alors spécial côté hôte et côté VM, et il me semble que c’est orienté calcul GPGPU.

Le 24/08/2022 à 08h36

Le 24/08/2022 à 07h51

Si je constate aussi une conso supérieure, ce n’est quand même pas de ce niveau!

As-tu le bon profil de performances sélectionné? As-tu changé d’alim entre les deux?

Remarque: le 3700x semble être connu pour cela.

Ce qui m’a surtout dérangé pour passer à AMD pour le serveur, c’est une expérience malheureuse avec un 3400GE et une Asrock desk mini X300: sous proxmox, les SSD “disparaissaient” en route (avec kernel panic et tout le toutim) au bout de quelques secondes, quelques minutes, …

J’ai tout revendu et suis resté sous Intel.

Le 24/08/2022 à 08h21

Perso, je suis passé sous AMD il y a un bout de temps pour mes labos (machines avec 3800X + B550 avec 128GiB de ram), et je ne vois ni consommation exagérée ni instabilité du matériel.

Le 24/08/2022 à 07h52

Dommage qu’il n’y ai pas de connecteurs SAS

Le 24/08/2022 à 08h39

Non clairement, ce n’est pas la même config. Mais le CPU est en cause, j’en suis vraiment persuadé.

Mon wattmetre donne la conso moyenne par seconde chaque seconde. Rien que bouger la souris, je passe de 60W idle à 120W… Avec l’ancienne config, je passais de 35W idle à environ 60W. (c’est de mémoire, je n’ai plus la config, mais l’ordre d’idée est là).

Le 24/08/2022 à 08h42

Les Ryzen en charge, a génération équivalente chez Intel, sont plus efficient. Après, pour certain, 35W ou 65W, ca ne les affoles pas plus que ca. Et si la machine travail, ce n’est plus un problème.

Le 24/08/2022 à 08h56

PC21.fr (en RP mais livre partout en France) ont des CM dual socket.

Le site est visuellement à vomir, mais derrière ils sont bien, j’ai commandé laptop, tour, DD, écran 34” et quelques autres trucs chez eux, depuis Paris et depuis Toulouse où je suis maintenant.

Le 24/08/2022 à 09h06

et Gigbyte reconnais enfin Linux ou ils nous font toujours un fuck ?

Sinon visuellement c’est proche de la version AsrockRack. C’est bien qu’il y ai de nouveau chalenger dans l’arène.

Le 24/08/2022 à 09h27

Si tout a changé: CG, RAM, CPU, format de carte mère, alim … aucun moyen de dire que c’est le CPU.

Le choix d’alim est déjà important pour avoir une conso à vide faible, surtout si on a monté une config avec une grosse alim - avec une alim de 200/300W, la conso à vide est plus facile à garder faible que avec une alim de 750W, et ce malgré les différents labels “80+”)

Même ma config, dont j’ai changé la CM, la RAM et le CPU, je vois bien une plus grosse conso à vide (de l’ordre de plus ou moins 10W), mais ça peut être la RAM (DDR4 vs DDR3) ou la carte mère (plus de ports USB3), ou un mix de tout.

Je suis sûr que ça marche bien dans la plupart des cas (quoique le passthrough, ça a longtemps été la bête noire). Mais difficile de savoir d’avance si ça va marcher ou pas … d’où l’intérêt de cartes mères de ce type!

Pour info, mes problèmes étaient liés à l’activation des IOMMU pour faire du passthrough sur une carte réseau. Par contre, sans cela, juste à démarrer des VM avec tout de virtuel, ça fonctionnait très bien.

Le 24/08/2022 à 10h40

Tests DPDK avec https://www.fs.com/fr/products/160017.html

Le 24/08/2022 à 14h20

Moi je me méfie des wattmètres sur des charges non-résistives. Il faut déjà savoir ce qu’il mesure (puissance apparente, puissance active ?), et s’il est fiable si la consommation est hachée (ce qui est rarement le cas sur les wattmètres d’entrée de gamme). Parce qu’une alimentation de PC, c’est une belle alim à découpage, et le PFC ne donne un résultat convaincant qu’en charge, alors qu’en idle la courbe de courant reste dégueulasse, ce qui induit en erreur beaucoup de wattmètres bas de gamme.

Le 24/08/2022 à 22h15

Je prends bien ca en compte, t’inquiète pas. C’est une BeQuiet straight power 11 750W, à 50W, on est a environ 75% de rendement, soit le même rendement que mon ancienne OCZ ModXStream 500W. Et même avec un écart de 10%, ca jouerait sur 3~4W maximum, pas 25~30W

J’ai retrouvé une vidéo qui montrait la conso réelle moyenné des Ryzen vs Intel:

YouTube

YouTube

En plus des infos qu’il montre, j’en ai repéré une autre intéressante, regarde le comparatif à 4:17, la 2ème colonne de nombre, c’est le minimum atteint:

12900k => 10W

5950x => 34W

Le Ryzen ne descend jamais en dessous de 34W. Alors que l’Intel 12900k tombe a 10W idle.

On retrouve les 25W que j’ai de différence à la prise entre mon r7-3700x et mon ancien i5-6600. Et je trouve ca bien plus important que la conso ponctuelle à 200W (AMD) vs 150W (Intel) en charge. Le idle, c’est 99% du temps.

Le 24/08/2022 à 22h20

C’est un wattmetre Belkin, qui est plutot fiable, même à de très basse conso. J’ai testé avec un chargeur 5W Apple, au 220V coté prise et avec un voltmetre USB coté USB et c’est plutot précis, la différence correspondant à de la perte lors de la conversion 220V->5V. Donc sur des puissance de 50W, j’ai pas vraiment de doute sur la précision. Et encore une fois, même avec une précision a 1W, l’ordre de grandeur ici, c’est plutot 25-50W.

Le 24/08/2022 à 23h19

Je suis très curieux de savoir comment ces chiffres sont obtenus… est-ce qu’il utilise des fonctions d’auto-diagnostique de la CM ou du processeur? ou un système de sonde normalisée?

Le 25/08/2022 à 04h19

Tu n’as besoin de rien. Une VM peut fonctionner sans GPU, le passthrough ne servant qu’à dédier une carte PCIe à une VM comme si elle lui était physiquement attachée dans un PC.

C’est pour ça que je parlais de “besoin concret” dans ma question

Après l’E810 CAM1 est x16 parce qu’elle fonctionne aussi bien en PCIe 3.0 que 4.0, tu n’as pas besoin d’autant de lignes en PCIe 4.0 pour sortir 100G (source).

Mais dans tous les cas les ports PCIe de la carte sont en 4.0, c’est simplement le M.2 qui est en 3.0

Non. Pour comprendre pourquoi : Next INpact

Next INpact

Ils présentent ça comme du Workstation pas serveur (même s’ils proposent un kit 1U avec deux cartes). Du coup il n’y a pas d’IPMI/BMC ce qui limite pas mal l’usage dans un contexte de gestion distante, tout se fait en USB/UART de ce que j’ai compris.

Pour le reste, c’est 16 coeurs ARM, un Ampere Altra c’est 80 ou 128, effectivement, ce n’est pas la même chose Et à 800 $ la carte… Mais bon, c’est présenté comme une carte de dév, donc produite en petite quantité, c’est toujours assez cher (comme celles de SiFive).

Et à 800 $ la carte… Mais bon, c’est présenté comme une carte de dév, donc produite en petite quantité, c’est toujours assez cher (comme celles de SiFive).

C’est de l’extraction de données software donc tu es dépendant de la fiabilité de la source et ce n’est dans tous les cas pas strictement comparable. Ce qui fait foi au mieux dans ce genre de cas c’est la consommation à la sortie de la prise, parce que c’est ce que tu paies

Le 26/08/2022 à 18h11

Merci beaucoup pour les éclaircissements, et pour les infos sur la consommation du serveur présenté ici

Le 25/08/2022 à 05h43

Et encore, moi je compare une 3570K 77W de 2013 avec un 4650GE de 35W… La conso a vide se prend 10W en tout, je ne pensais pas.

Si tu veux un homelab qui ne consomme pas trop mais a de la patate, tu peux chercher d’occas des mini pc (type dell optiplex mini, lenovo thinkcentre, hp prodesk/elitedesk) en 9500T ou 10500T (9500T, tu le trouves jusqu’à 200€).

C’est en gros 10W en conso à vide, mais tu ne peux évoluer que par USB…

Le 26/08/2022 à 11h53

Après tout dépend des CPU. En plateforme AMD, j’avais relevé une machine Lenovo à 5 watts au repos par exemple. Mais c’était une puce prévue pour le mobile : Next INpact

Next INpact

Le 25/08/2022 à 06h12

Pour ceux qui se posent la question. La consommation du serveur ici présenté (R9 5950X, 32 Go de RAM, un SSD en S-ATA) à la prise, au repos, sans modifications, sous Proxmox :

Le 25/08/2022 à 07h42

Le problème de précision des wattmètres n’est pas en rapport avec une consommation forte ou faible, mais avec les alimentations à découpage.

Grosso modo, un wattmètre d’entrée de gamme mesure U et I crête, en déduit U et I efficace, vu qu’on est en alternatif sinusoïdal, et fait la multiplication, et c’est tout. Un poil plus sophistiqué, il y a ceux qui mesurent aussi cos phi, puisque la méthode précédente donne la puisse apparente et non la puissance active qui est celle facturée.

Cette méthode est correcte si tu mesures la puissance d’un grille pain ou d’une ampoule à incandescence, mais est complètement à côté de la plaque sur une alimentation à découpage. Concrètement, une alimentation à découpage redresse le courant, puis on a un hacheur, et enfin différentes façon d’obtenir la bonne tension selon la topologie d’alimentation à découpage. Mais on commence toujours par un étage de redressement, avec pont de diodes et condensateurs. Après le pont de diodes, on a un courant en simple alternance. Le condensateur va ensuite lisser ça en se chargeant (en absorbant du courant) pendant que la tension est en haut, et en se déchargeant (en rendant le courant) pendant que la tension est en bas.

Il apparaît donc clairement que, selon que l’on tire plus ou moins sur l’alimentation, le condensateur va créer des pics de courants qui seront variables en intensité et en durée. Si l’alimentation est chargée, les pics seront larges, et on ne sera pas loin des conditions sinusoïdales. En revanche, si l’alimentation est peu chargée, alors à chaque cycle ça va très peu décharger le condensateur, donc il n’aura pas besoin de se recharger beaucoup, et donc le pic de courant sera très bref. Dans ce cas, on sera très très loin d’un courant sinusoïdal, et donc le wattmètre se plantera lamentablement parce que lui suppose que c’est sinusoïdal et qu’il suffit de mesurer le courant crête pour connaître toutes les caractéristiques du courant. Et donc ce cas se produit non pas pour les petits courants qui seraient trop ténus pour le wattmètre, mais quand une alimentation à découpage est près de son régime idle. Si ton alim de PC fait 500W, si tu tires dessus 10W ou 30W, on est dans ce cas. Et là, le wattmètre donne une puissance vraiment très très surévaluée.

Les wattmètres de base qu’on trouve à 15-20€ sont tous dans ce cas. Il existe des méthodes pour avoir la puissance exacte. Il suffit de mesurer tension et courant à haute fréquence et calculer l’intégrale de leur produit sur une certaine période. Si la fréquence n’est pas assez élevée, on peut encore se faire avoir en surévaluant la largeur des pics. Si la fréquence est bonne, alors on a la vraie puissance. Mais ça donne un wattmètre plus complexe, et donc plus cher. Peu de constructeurs annoncent clairement comment marche leur wattmètre.

Personnellement, moi j’utilise le wattmètre ultime, celui qui fait foi : le compteur EDF. Je récupère la téléinfo, donc j’ai tout sans bouger de mon siège, mais on a les infos aussi en direct sur le compteur avec le Linky. Il suffit de regarder le delta de consommation quand on allume ou coupe l’appareil que l’on mesure. On peut recommencer plusieurs fois pour amortir les perturbations (pour peu que le frigo se mette en route pile à ce moment-là). Il me semble que la puissance instantanée donnée est la puissance apparente et non la puissance active, mais sur une installation complète, où on trouve aussi bien des chargées réactives que capacitives, le cos phy ne doit pas être si dégueu que ça, et au final on n’est pas loin de la vérité.

Le 25/08/2022 à 08h46

Merci pour l’explication d’une alimentation à découpage, j’ai une formation (lointaine) en électronique, mais je m’étais jamais intéressé au fonctionnement.

Par contre, à plus haut niveau, les alimentations a découpage de plus de xx watt sont PFC (norme FR ou EU, je sais plus). Le but du PFC est justement de rendre la charge résistive et donc ne fausse la mesure du wattmetre.

https://www.tomshardware.fr/fonctionnement-dune-alimentation-2eme-partie-2/7/

Concernant le relevé au compteur, je le fais déjà en quasi temps réel. J’ai bricolé un truc avec un Rpi Zero W + boitier optocoupleur et je récupère les infos sur le bornier contact sec:

D’ailleurs, je constate des infos intéressantes sur le graph généré:

Une petite conclusion, le jour ou Enedis facture la conso réel (VA) au lieu de la conso apparente (W), ca va piquer :)

Le 25/08/2022 à 08h24

Je suis passé à coté de cette ref.

Je regardais plus la B550D4ID-2L2T mais elle n’est plus vendu.

Le 25/08/2022 à 08h48

Merci, du coup, soit mon 3700x n’est pas efficient du tout, soit le reste de la config n’est pas super économe. Si j’al le temps ce midi, j’essayerai en remplaçant la 3060ti par une quadro nvs295 voir si c’est pas le GPU le problème.

Le 25/08/2022 à 22h43

Bon, j’ai testé avec la nvs295, mais elle ne boot pas en UEFI, et j’ai pas envi d’activer le mode de rétro compatibilité de peur de flinguer les paramètres de boot…

Le 25/08/2022 à 09h34

Ce sont les chiffres données par le CPU.

Le 25/08/2022 à 09h35

Merci!

Le 25/08/2022 à 09h43

Pour moi, ENEDIS facture la conso réelle réexprimée en Wh depuis les compteurs blancs. C’est un des points des détracteurs du linky: quand on passe d’un compteur “à roue” à un électronique, la facture augmente… Parce que leur compteur comptait de l’apparent seulement…

Le 25/08/2022 à 10h35

C’est exactement l’inverse. EDF facture bien la puissance active, mais elle est inférieure à la puissance apparente.

Petit moyen mnémotechnique : la puissance active est en X, la puissance réactive est en Y, la puissance apparente est l’hypoténuse du triangle rectangle. Pythagore te dit que la puissance apparente est donc supérieure à la puissance active.

Là où il y a confusion, c’est que le seuil de disjonction se fait sur une puissance apparente, mais la facturation est toujours sur la puissance active.

L’augmentation lors du passage d’un vieux compteur mécanique à un compteur Linky, c’est qu’à la longue, la roue perd de sa lubrification et tourne moins vite que ce qu’elle devrait. Et ça fait mal le jour où tu retrouves un compteur exact.

Le 25/08/2022 à 12h13

Le débat sur la facture, c’est que les anciens disjoncteurs mécanique déclenchait sur la puissance apparente, alors que les linky déclenchent sur la puissance réelle maintenant. A cela, il faut ajouter la marge d’erreur qui était accordé à l’époque, car moins précis.

Aujourd’hui, le déclencheur mécanique ne sert que de protection et est paramétré sur 60A quelque soit l’abonnement choisi, et c’est le linky, bien plus précis, qui “saute” électroniquement en cas de dépassement de la puissance souscrite.

Donc entre la réduction de la marge d’erreur, et le fait que les linky saute sur la puissance réelle font que certain foyer doivent passer à l’abonnement supérieur: 3kVa => 9kVa => 12kVa et donc payer plus cher.

A noter quand même que les linky ne sautent pas instantanément, mais autorise un dépassement ponctuel. C’est si ce dépassement dure que ca saute. Si quelqu’un a des infos précise à ce sujet, je suis intéressé.

Le 25/08/2022 à 09h53

Oui, il y a une norme UE qui impose le PFC au-delà de 75W. Mais attention, un PFC n’est pas forcément un PFC actif. Ça peut être du PFC passif (une simple bobine), et là, la correction est loin d’être idéale.

C’est logique. Toutes les alimentations à découpage sont par nature des charges capacitives (réactance négative), et forment l’essentiel de le consommation en veille d’une maison (box, réveil, veille de la tv, ampoules led, etc.). En revanche, la consommation du frigo, c’est le moteur du compresseur, donc un grosse bobine, c’est-à-dire une charge inductive, comme tous les moteurs, ce qui ramène la réactance vers le positif. Au final, ça se compense, réactance presque nulle.

Le 25/08/2022 à 09h59

Sinon, on parle de homelab, de IPMI, …

Depuis des années il y a des fonctionnalités intégrées dans mes ordis (que je désactive systématiquement) telles que Intel AMT, AMD DASH, qui permettent de contrôler l’ordi à distance (en VNC), de passer les BIOS, modifier les fonctionnalités de cryptage mémoire à la volée…

Je les désactive par crainte des virus, mais finalement c’est aussi puissant qu’un IPMI, non?

Le 25/08/2022 à 10h19

Merci à vous !

Le 25/08/2022 à 12h17

Autant j’utilise Linux 8h par jour sur mon PC pour bosser, sur les milliers de serveurs au boulot, mes truc maison, proxmox, rpi, domotique, etc… autant mon pc pour jouer, bah il tourne sous windows :) j’essayerai à l’occasion sur une live. Merci des pistes en tout cas.

Le 25/08/2022 à 12h51

Cherche le fichier Linky-tic-specs (exemple: https://github.com/JordanMartin/linky-teleinfo/blob/master/linky-tic-specs.pdf) vers la page 30.

Le 25/08/2022 à 13h04

250s à 1.4 fois la puissance max, et encore 40s avec un dépassement de 2.5 ? C’est carrément laxiste !

Le 25/08/2022 à 13h02

Non, mais ce qui m’intéresse c’est d’anticiper.

Typiquement, j’hésite entre prendre une telle carte maintenant ou miser sur les archi Zen4 dans pas longtemps qui auront le support CLX sur PCIe Gen4.

Même si la E810 n’a pas ce support, ce sera le cas des suivantes…

Le 25/08/2022 à 14h06

Tu arrives à utiliser les toutes dernières technos? Quand je vois la lotterie qu’était l’activation de l’iommu sur les Ryzen (si le chipset ET le CPU le supportaient, la CM pouvait ne pas l’implémenter), j’ai tendance à ne pas porter une grande attention à ce qui est “nouveau” - en tout

cas à mon niveau d’achat.

Et pourtant Linky est critiqué pour “sauter” plus vite. En plus, il émet un signal de dépassement pour déclencher un délestage (genre couper les radiateurs et le chauffe-eau)

Le 25/08/2022 à 17h13

Merci!

J’ai maintenant une année complète de mesure de conso avec une granularité de 10s et je dépasse très rarement les 6kVa.

Du coup, avec ton document, je vois déjà qu’à 1,1x la puissance, soit 6,6kVa (que je ne dépasse jamais) c’est “toléré”… et quand je dépasse, ca dépasse vraiment de peu, et moins que les 4mn requises avant de couper.

Franchement, je me tate pour passer à 6kVa (actuellement à 9, et j’étais à 12 au départ…)

Le 25/08/2022 à 19h31

On est complètement hors sujet là … mais j’ai pareil: Homeassistant fait le relevé de la conso, et je regarde pour capter le signal de surconso et dire aux relais shelly de couper chauffe-eau et radiateurs électriques…

Le 25/08/2022 à 19h31

Mmm vraiment rien à offrir (à part le prix… et encore) par rapport à une Asrock X570D4U-2L2T… Où sont passées les lignes PCI-E ??

Le 25/08/2022 à 19h52

Cette référence chez Newegg c’est plus de 800 $ ;) En france on la trouve référencée à 670 euros TTC, mais bon, sans dispo.

Le 25/08/2022 à 20h13

Donc en gros, pas super fiable… il faudrait mesurer la conso avec le même matériel. Sondes différentes= résultats différents.

Le 25/08/2022 à 22h38

Tu me met l’eau à la bouche la. Bon par contre, je pourrais rien faire de mon coté… Vu que c’est une pompe à chaleur (3kW en pointe s’il fait ultra froid dehors) pour eau chaude et le chauffage, on peut pas l’éteindre et la rallumer à l’arrache… Et quand je dépasse, c’est avec les plaques à induction connecté en 32A, que je ne vais pas délester puisque je m’en sers…

Bon après, tout ca, c’est surtout pour le principe, 6kVa, 9kVa, c’est 2€ par mois de différence… le plus important, c’est de consommer le moins possible en général.

Le 26/08/2022 à 06h47

C’est fiable, mais pas forcément comparable effectivement. Mais vu les ordres de grandeurs, il y a une différence.

Le 26/08/2022 à 08h35

Si les sondes ne sont pas calibrées pareil et ne mesurent pas exactement la même chose, on peut avoir des différences.

En plus, si ce n’est même pas en ligne avec des mesures faites à la prise pour un système complet comme indiqué par David_L, on peut juste prendre ces mesures avec de très grosses pincettes et s’abstenir de tirer rapidement des conclusions.

La question n’est pas d’aimer plus AMD ou intel, la question est que si on prétend présenter des faits comme le fait ce youtuber, on prend essaye d’avoir un minimum de rigueur scientifique et si on a pas de méthodologie fiable pour mesurer la conso du CPU, on fait une mesure standardisée à la prise ou en sortie des lignes de l’alim sur des systèmes minimalistes équivalents.

Le 26/08/2022 à 09h39

On est parfaitement d’accord. Ca donne une idée “grosses mailles” niveau CPU, mais pour la conso à vide, tout le système est à considérer, y compris le soft! Il semble relativement complexe sur les gros AMD de désigner les bons CPU sur lesquels faire tourner les tâches pour limiter le nombre d’unités actives. Ca fonctionne quand même bien, à vide mon PC Ryzen 5 3400GE (donc un Zen+) est à moins de 15W (mais plus haut que mon Intel 9500T qui reste autour de 10W)

Le 26/08/2022 à 15h37

Merci David!!

Juste une petite question : peut-on spliter la pcie x16 en x4x4x4x4 ou x8x4x4 ou autre stp?

Pcie bifurcation je crois?

Le 26/08/2022 à 20h16

Ha j’ai oublié une autre question:

Avec cette orientation « serveur », on met quoi comme aircooling heatsink stp?

Merci ☺️