Apple M1 Pro et M1 Max : qu’est-ce que ces SoC ont dans le ventre ?

Pleins de transistors

Le 19 octobre 2021 à 05h32

6 min

Hardware

Hardware

Un an après l'annonce du M1 et son passage à une architecture ARM64, Apple revient à la charge avec non pas une, mais deux versions améliorées de son SoC : les M1 Pro et Max. Des modèles dans la continuité mais avec quelques évolutions bienvenues. L'effet d'annonce passé, voici ce que nous pouvons en retenir.

Hier soir, Apple dévoilait de nouveaux services et accessoires, mais a également lancé ses premiers MacBook Pro équipés de l'une de ses deux nouvelles puces maison, toujours gravées en 5 nm par TSMC : les M1 Pro et M1 Max. Ils font suite au M1 lancé l'année dernière, s'adaptant pour viser un public plus exigeant, ayant soif de performances.

M1 Pro/Max : moins d'évolutions qu'il n'y parait

Pour cela, Apple a revu ses chiffres à la hausse. Le M1 Pro est composé de 33,7 milliards de transistors pour 8 + 2 cœurs CPU, 16 cœurs GPU et autant pour le calcul matriciel et l'IA (Neural Engine, 11 TOPS). La mémoire passe d'un maximum de 16 Go de LPDDR4X sur le M1 à 32 Go de LPDDR5 (256 bits), soit 200 Go/s de bande passante.

Le M1 Max compte 57 milliards de transistors. Pour autant, on reste sur 8 + 2 cœurs CPU et un Neural Engine à 16 cœurs (11 TOPS). Par contre le GPU voit son nombre d'unités doubler à 32 cœurs, tout comme le nombre d'écrans externes gérés (4), la bande passante mémoire (512 bits, 400 Go/s) via l'utilisation de 4 puces, soit un maximum de 64 Go. Elle est toujours intégrée sur le packaging et unifiée : elle peut être utilisée par le CPU ou le GPU.

Comme à son habitude, Apple a indiqué avoir amélioré ses SoC à tous les niveaux. Mais plus concrètement, on reste sur des cœurs CPU « Performance » à architecture « ultra-wide execution », qui n'ont guère évolué. Ils embarquent toujours 192 ko de cache d'instruction et 128 ko de cache de données (L1), mais un L2 partagé qui a doublé à 24 Mo, ce qui semble logique puisque le nombre de cœurs a suivi la même tendance.

Les cœurs « Efficiency » ne bougent pas : 128 + 64 ko de L1 et toujours 4 Mo de L2 partagé malgré leur division par deux. Apple évoque une amélioration des performances de 70 %. Le point intéressant ici est donc surtout le changement d'équilibre au sein de la puce, qui passe d'une architecture 4 + 4 à 8 + 2 plutôt que 8 + 4 par exemple.

Sur le terrain du GPU on est à 128 unités d'exécution par cœur, soit 2 048 au total pour le M1 Pro, pouvant gérer 49 512 threads, annonçant 5,2 TFLOPS, 164 GTexels/s, 82 GPixels/s et donc le double pour le M1 Max. Pour rappel, le M1 qui avait 8 cœurs annonçait 2,6 TFLOPS, 82 GTexels/s et 41 GPixels/s, il n'a donc pas évolué.

À titre de comparaison, les GeForce GTX 1650 et 1660 sont données pour 6 et 10 TFLOPS, mais à puissance de calcul similaire, elles ont environ deux fois moins de ROP (GPixels/s) et d'unités de texturing (GTexels/s).

Apple évoque par contre des avancées du côté de son moteur de traitement multimédia gérant l'accélération H.264, HEVC, mais aussi ProRes (Raw) désormais avec un moteur de compression et un de décompression sur le M1 Pro et deux fois plus sur le M1 Max (sauf pour la décompression H.264/HEVC). De quoi gérer 30 flux 4K ProRes 422 ou 7 flux 8K ProRes 422 selon l'entreprise qui vise clairement les « créateurs » avec ses nouveaux MacBook Pro.

Ces puces gèrent deux et quatre écrans externes. Le PCIe 4.0 est de la partie pour le stockage puisque le SSD utilisé au sein des nouveaux MacBook Pro annonce un débit maximal de 7,4 Go/s.

De (très) grosses puces, mais un TDP limité

Pour rappel, le M1 annonçait 4 + 4 cœurs CPU, 8 cœurs GPU et déjà un Neural Engine à 11 TOPS. Il ne gérait à l'époque qu'un écran externe. Sa bande passante mémoire n'avait pas été annoncée mais Apple dit qu'elle a été doublée avec le M1 Pro, elle devait donc se situer aux alentours de 100 Go/s. Selon les estimations d'Anandtech, elle mesurait aux alentours de 120 mm² contre 245 mm² pour le M1 Pro et 432 mm² pour le M1 Max.

À titre de comparaison, une puce Zen 2 (Ryzen de 3e génération) d'AMD gravée en 7 nm, comportant huit cœurs est contenue dans un die de 74 mm², ses Ryzen Mobile 5000 (Zen 3), aussi gravés en 7 nm tiennent dans 180 mm² environ pour 10,78 milliards de transistors. C'est 3 à 5 fois moins que les nouvelles puces d'Apple.

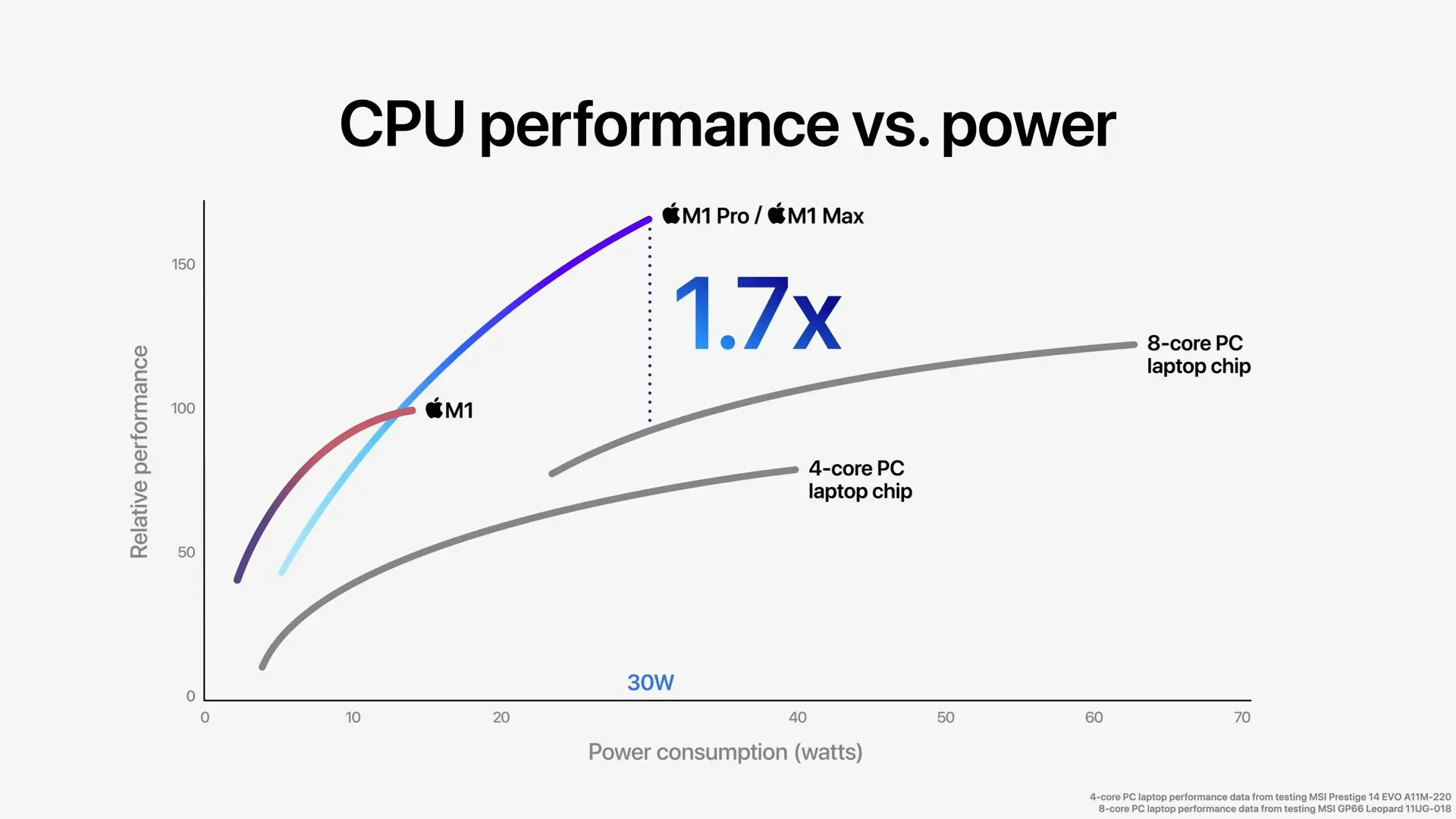

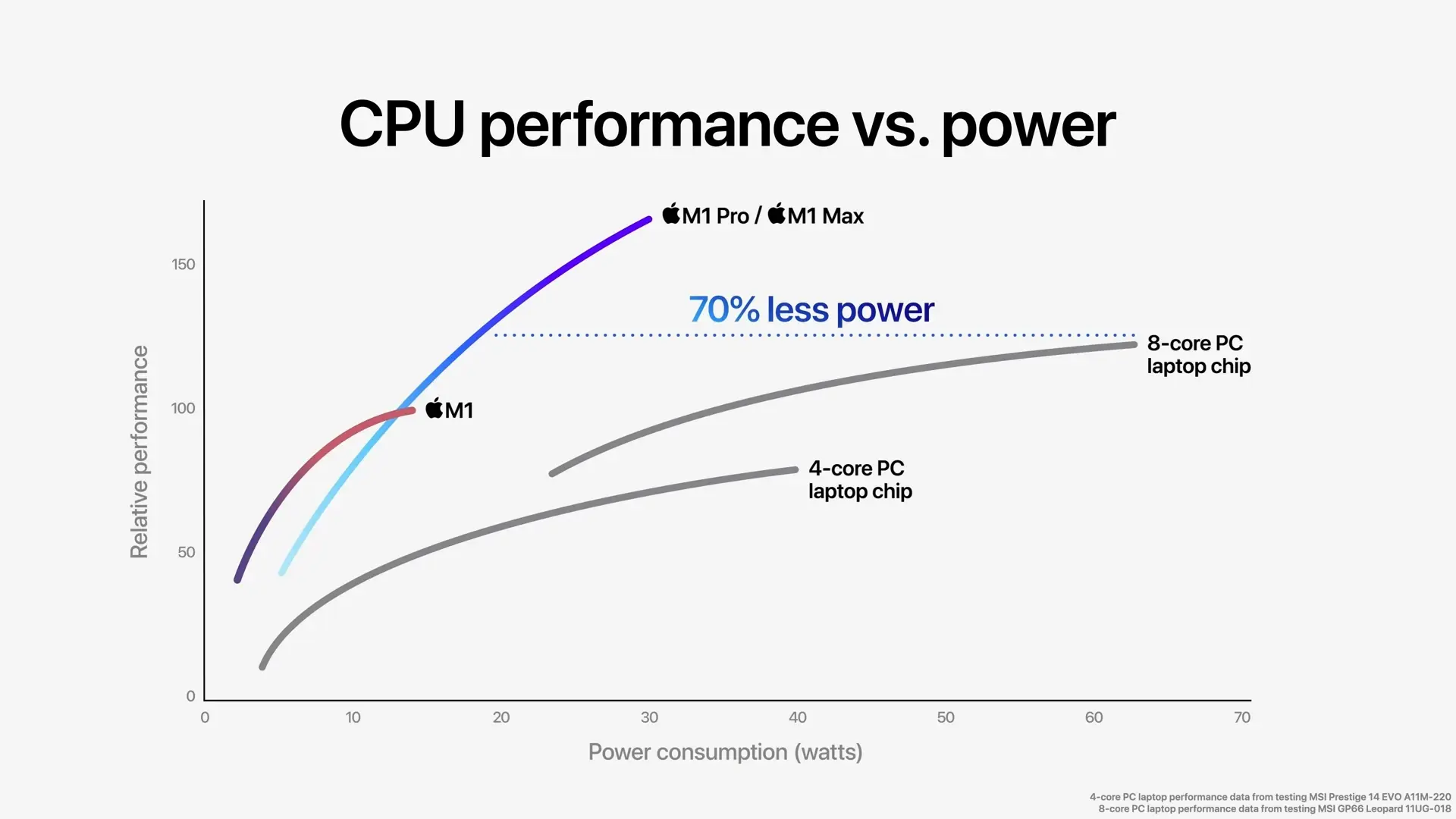

Là où le constructeur fait fort, c'est dans l'efficacité énergétique de ces puces (à la fréquence non révélée), bien meilleures que les solutions concurrentes d'AMD ou Intel. Avec ses M1 Pro/Max il revendique un CPU 1,7x plus performant à même niveau de consommation (30 watts) face à un GP66 Leopard 11UG-018 (11UG-018) et son Core i7-11800H (8C/16T). C'est un peu plus face au MSI Prestige 14 EVO (A11M-220) à base de Core i7-1158G7 (4C8T).

Côté GPU, l'entreprise compare son M1 Pro à un Lenovo Legion 5 (82JW0012US) à base de GeForce RTX 3050 Ti (5 TFLOPS) pour indiquer qu'il consomme aux alentours de 30 watts, 70 % moins à même niveau de performances. De son côté, le M1 Max est opposé à un MSI GE76 Raider (11UH-053) à base de GeForce RTX 3080 (20 TFLOPS) et cette fois Apple indique avoir le même niveau de performances à 50 watts que son concurrent à 150 watts.

Mais on ne sait pas sur quel type de tests et dans quelles conditions exactement. Il faudra donc attendre que les nouveaux MacBook Pro arrivent chez les testeurs pour se faire une idée concrète. Apple précise que désormais une ventilation est nécessaire pour assurer le refroidissement de ses puces, mais elle est semi-passive et ne s'active donc que si nécessaire. Est-ce que ces Mac seront bruyants ? Nous verrons.

Cela montre néanmoins que tant AMD, qu'Intel et NVIDIA vont avoir à redoubler d'efforts d'ici l'année prochaine. Car en 2022, Apple ne se contentera sans doute pas de faire évoluer l'existant et pourrait arriver avec un M2 encore plus percutant, profitant d'une nouvelle finesse de gravure. Il sera alors grand temps de s'inquiéter.

Apple M1 Pro et M1 Max : qu’est-ce que ces SoC ont dans le ventre ?

-

M1 Pro/Max : moins d'évolutions qu'il n'y parait

-

De (très) grosses puces, mais un TDP limité

Commentaires (68)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 19/10/2021 à 06h04

En gros le M1 pro c’est deux M1 sur le même Die !

Le 19/10/2021 à 06h06

À voir ce qu’il en sera dans la réalité, une fois les produits sortis et testés dans des conditions plus réelles. Mais j’ai l’impression qu’Apple a choisi la bonne voie en développant son propre SoC de par son expérience mobile.

Les seuls que je vois pouvoir réellement rivaliser, rapidement, sont NVIDIA. AMD et Intel ont une trop grosse inertie amha et vont avoir du mal à adapter du x86 à un aussi gros ratio perf/watt.

Je vois bien le futur avec la majorité des laptops sous archi ARM et le fixe rester sous x86, où je vois mal de l’ARM percer (pas les même besoins en général, la conso est moins problématique, etc). On verra bien

Le 19/10/2021 à 06h06

Pas exactement, mais il y a pas mal d’éléments doublés, d’autres non (neural engine par exemple). Parfois le doublement vient d’ailleurs (LPDDR4X -> LPDDR5).

NVIDIA ne fait pas vraiment de CPU pour ordinateur, ils se moquent un peu de ce marché (Serveurs, embarqué, toussa) qu’ils laissent à des partenaires (MediaTek notamment). Et ils toucheront sur la licence ARM d’Apple si le rachat se fait ;) Pour AMD et Intel, je sais que je me répète, mais parler d’inertie n’a pas de sens. Un SoC annoncé en 2021 c’est un design débuté en 2016.

Des alternatives se préparent depuis quelques années, mais le temps de conception d’un CPU, c’est pas vraiment un meeting et deux semaines en usine. Apple a une offre intéressante avec ses M1, ils renforcent leur produit et vont sans doute gagner des parts de marché (vu les tarifs, pas énorme, mais ça permet de redonner un peu de prestige au Mac). Ce qui sera intéressant, ce sera le match période 2023⁄2025 à mon avis. Là on saura qui aura décidé (et réussi) à revenir au score réellement.

Le 19/10/2021 à 06h24

Belles bêtes. La réussite du iGPU face à ceux d’Intel et AMD est certainement très liée à la BP de la RAM, très impressionnante (et les tests de latence du M1 le plaçait plus proche d’intel que d’AMD sur ce terrain).

A se demander si un x86 basé sur de l’ARM avec un traducteur en amont ne serait pas faisable pour de la basse conso (c’était faisable en 2000 avec Transmeta et autre chose que ARM).

Après, avec Windows en ARM, on s’en moque un peu, si quelque constructeur arrive à faire de l’ARM aussi avancé qu’Apple.

Le 19/10/2021 à 06h36

Comparer le M1 Max à une 3080 même mobile, en octobre 2021 je l’aurai pas parié.

C’est dingue de se dire qu’une puce ARM aussi peu consommatrice peut arriver à ce niveau de perf, on avait été habitué coté cpu, mais là c’est la goutte d’eau…

Hâte de voir les bench en condition “réel”.

2020-2030 sur le monde du cpu/gpu ça va être fun #popcorn.

Le 19/10/2021 à 06h40

Avec une puce 3x plus grosse c’est pas compliqué en même temps, plus que l’unification de la RAM

C’est comparer 10 TFLOPS et 20 TFLOPS pour faire une équivalence, ça a peu de sens. Par contre ça repositionne un peu le marché de l’intègré, ce sera intéressant de voir quand Apple décidera de sortir le GPU (qui est le plus gros morceau de son SoC)

Le 19/10/2021 à 06h44

Je débarque un peu sur ces discussions techniques mais une question me taraude :

Pourquoi proposer un GPU performant sous MacOS sachant que peu de jeux tourne dessus, ou alors mes souvenirs sont pas à jour et aujourd’hui bien plus de jeux sortent sous MacOS.

C’est pour concurrencer les CG Pro sur de la conception 3D ?

Le 19/10/2021 à 06h55

La taille de la puce est impressionnante en effet. Mais du coup ça doit coûter bonbon à fabriquer…

Après on ne peut pas vraiment comparer Intel AMD et Apple sur le marché des processeurs. D’une part parce qu’il n’y a pratiquement aucune chance que ces puces Apple se retrouvent ailleurs que dans des produits de la marque.

Et ensuite parce qu’eux seuls sont capables de faire ce genre de paris fous.

Ils peuvent se permettre d’avoir une puce “custom” parce que derrière ils ont leur propre écosystème logiciel. Il peuvent se permettre de “tout casser”, de dire la rétrocompatibilité vous l’oubliez, ils la gèreront comme ils veulent.

A contrario AMD/INTEL doivent assurer qu’un nouveau processeur comprend toujours les anciens jeux d’instruction.

Ceci dit, c’est intéressant qu’ils aient fait une approche du type “le besoin définit le processeur” . Et du coup le résultat est très différent de ce qu’on avait l’habitude de voir jusqu’à présent.

On a plus affaire à un SOC de téléphone doppé aux stéroïdes plutôt qu’un processeur “standard”

Mais avec les logiciels optimisés pour ça, l’efficacité est quand même impressionnante

Mais la tendance est clairement aux processeurs “hybrides” avec des petites portions hyper éfficaces en énergie, et d’autres avec des grosses performances. L’ère du proco monolithique semble définitivement appartenir au passé

Le 19/10/2021 à 06h57

Oui en logiciel pro les GPU sont de plus en plus utilisé (et pas qu’en 3D) et Apple qui c’est rajouté à la liste des sponsor de Blender il y a quelques jours ce n’est probablement pas un hasard mais pour s’assurer que ses API soit supporté.

Apple édite aussi des jeux maintenant Apple Arcade.

Après il faut relativiser la comparaison avec la 3080 est déplacé, les GPU Apple reste 2 à 3 fois moins puissant mais dans un portable c’est vraiment correct et ça rivalise sans soucis avec les laptop haut de gamme PC mais reste loin de ce que tu peux obtenir en desktop (le point faible des iMac qui reste des laptop déguisé).

Le 19/10/2021 à 06h57

Parce qu’un GPU ce n’est pas que du jeu (et au pire ça attirera les développeurs ;)

Il suffit de voir les prix. Ceux qui gueulent sur un i9 à 900 balles après ça…

C’est un processeur monolithique

Le 19/10/2021 à 06h57

Les softs montage vidéo et retouche photo sont aussi friands de GPU

Le 19/10/2021 à 06h58

C’est à la fois pour la 3d et la 2d (montage, trucage et design) qui sont deux domaines consommateurs de ressources…

Le 19/10/2021 à 07h13

1- sans doute déjà parce qu’ils le peuvent , tout simplement. Leur puce graphique consomme tellement peu qu’ils peuvent la multiplier à volonté.

(Les rumeurs qui avaient juste sur le M1Max annoncent une partie graphique à 128 cores pour le Mac Pro)

2- oui pour certains usages pro de niche, c’est extrêmement utile ! (J’ai ai besoin par exemple pour du rendu 3D)

3- les génies du marketing d’Apple ont réussi à maquiller ce qui n’est qu’une option graphique (le M1Max n’améliore le M1Pro que sur la partie graphique) en tout nouveau processeur incroyable.

Les gens se jetteront dessus bien plus que sur un upgrade de carte, malin 😂

Le 19/10/2021 à 07h31

Vu tout ce qui est intégré, l’autre exploit c’est d’avoir des yield correct sur ces SoC. Surtout que le pro ne peut être une version “recyclage” des max avec défauts, vu les surfaces différentes et la conception monolithique.

Le 19/10/2021 à 07h38

En fait je me suis mal exprimé, c’est vrai qu’au sens technique, du moment que tout est gravé en même temps sur la même puce c’est monolithique. Ce que je voulais plutôt dire, c’est que ce n’est plus simplement un “bloc” avec des gros coeurs identiques regroupés sur la même puce. C’est vraiment toute une floppée de sous systèmes plus ou moins spécialisés.

Le 19/10/2021 à 07h41

Apple compte des coeurs CPU et des coeurs GPU, mais rien ne te dit que les coeurs GPU ne sont pas utilisés par certaines fonctions qui, sur d’autres processeurs, seraient CPU ou semi-CPU.

C’est leur avantage: ils maitrisent la chaine de A à Z, jusqu’au framework des applications. Il leur est facile de maitriser les fonctions utiliser, et dans quel type de “case” il est préférable de les trouver.

Le 19/10/2021 à 07h42

Non.

Les GPU externes étaient la révolution souhaitable et la logique du closed hardware y a mis fin sur mac.

Que le rapport perf/conso soit bon ne change rien avec la possibilité hypothétique de raccorder en externe des gammes de GPU type pro (radeon, Quatro) bien plus pertinentes pour la tache spécifique et économes en watts pour donc de l’usage rendu ou montage vidéo.

C’est l’idée du marketing : repacker les bonnes idées des clients pour revendre leurs optimisations au plus grand nombre.

Le 19/10/2021 à 07h43

Ils ont deja segmenté la gamme avec un nombre de coeurs CPU et GPU differents, je suppose pour avoir un yield correct:

M1

M1 Pro

M1 Max

Le 19/10/2021 à 07h47

Tandis que les autres devs peuvent se brosser pour exploiter la ressource en ARM.

C’est un super argument marketing c’est vrai.

Le 19/10/2021 à 07h57

7000€ pour le + cher des laptop, j’ai regardé après la présentation.

Après, qui a besoin d’un SSD 8TB?

Le 19/10/2021 à 08h00

On ne connaît pas le yield ;)

Le 19/10/2021 à 08h09

C’est la tendance actuelle (exemple: intel GNA). Le GPGPU a montré que le CPU n’est pas capable de suivre sur plusieurs types de calcul qui sont de plus en plus courants/répandus.

Par ailleurs, le paradigme actuel “périph -> CPU -> RAM -> CPU pour le calcul -> RAM -> périph” est bien remis en cause aussi.

Autant faire périph qui calcule <-> RAM.

Remettre le CPU non pas au centre comme en x86, mais sur le bus au même titre que toute autre unité. Laisser les unités travailler à leur rythme, parfois plus vite que le CPU ne pourrait, et surtout avec moins de latence que si le CPU doit tout orchestrer lors d’échanges.

Ce que je crains, c’est qu’avec les directstorage et autres, Apple finisse par mettre le SSD aussi sur la puce.

Le 19/10/2021 à 08h21

Oui, pour la performance tout mettre au même endroit c’est l’idéal, mais on va certainement perdre ce qui faisait encore un peu la force des PC fixes: avoir une carte mère et des éléments interconnectés qu’on peut choisir individuellement

Certains diront que la transition date pas d’hier, et qu’a part quelques barbus la plupart des gens achètent leur PC d’un bloc, et le remplacent intégralement dès qu’il devient trop lent….

Et les PC portables, ça devient fréquent d’avoir de la ram soudée….

Pour le SSD soudé, y a qu’a voir ce qui a été fait sur la PS5…. nul doute que la pratique se généralisera sur les PC tout en un et les portables

Le 19/10/2021 à 08h25

Je ne m’y connais pas trop en hardware à ce niveau la, mais autant la partie CPU est impressionnante mais pas incroyable (ARM64 vs x64), autant la partie GPU j’ai incroyablement du mal à y croire. Des perfs égales à une 3080 pour seulement 50W ?

J’avoue que je ne connais pas trop quel serait la raison, à part d’architecture. J’imagine l’API utilisée (Metal vs dx12 par exemple), mais c’est impossible que Metal ai autant d’avantage que ca au niveau des instructions.

Le 19/10/2021 à 08h33

Ça m’intéresse énormément pour le jeu, parce qu’il y en a un peu quand même sur Mac, on le vois sur GOG. Mais la dissipation thermique fait peur. Le bruit ventilo aussi.

J’ai lu sur Audiofanzine que les perfs sur Ableton Live (ou autre même genre) faisait que la M1 semblait super (attention, pas de support natif de Live pour l’instant), mais que le problèmes de manque de Ram qui existe sous windows, devenait quasi inexistant avec la M1… alors cette monté en puissance de Ram sera t’elle encore justifié pour certains ?

Hâte de voir des tests arriver avec du natif sur certains soft.

(La suite Affinity sur M1, c’était juste bluffant)

Le 19/10/2021 à 09h29

AMD qui bouscule Intel ces dernières années, juste pour qu’Apple débarque et face passer leur rivalité pour quelque chose sans importance.

Difficile de s’enthousiasmer des CPU x86, du moins sur laptop, avec ce qu’Apple a fait.

On verra ce que nous apporte Alder Lake, mais c’est déjà mal parti avec du “Intel 7” (ex-10nm) face à du “5nm” de TSMC.

Moi qui ai toujours évité Apple, leur avance technologique rend plus désagréable de leur résister. Heureusement que ça reste très cher pour ne pas avoir de regrets.

Le 19/10/2021 à 09h35

Surtout que j’ai remarqué la disparition totale du MacBook Air, quand j’ai regardé le site ce matin.

Étrange de dégager une machine qui s’adressait très bien aux utilisateurs à “faible nécessité technique”.

Peut-être pour pousser à l’adoption de l’iPad…

Le 19/10/2021 à 09h49

“la disparition totale du MacBook Air”

MacBook Air 13 pouces

Puce Apple M1 avec CPU 8 cœurs, GPU 7 cœurs et Neural Engine 16 cœurs

8 Go de mémoire unifiée

SSD de 256 Go

=> 1 129,00 €

Puce Apple M1 avec CPU 8 cœurs, GPU 8 cœurs et Neural Engine 16 cœurs

8 Go de mémoire unifiée

SSD de 512 Go

=> 1 399,00 €

Le 19/10/2021 à 09h58

Ah, Ils l’ont séparé d’onglets…

Bein, bien vu !

Merci

Le 19/10/2021 à 10h25

Question de de point de vue… Pour beaucoup de monde, ces processeurs n’étant vendus que dans des machines Apple tournant sur l’OS Apple, ils n’ont de fait aucun intérêt

Le 19/10/2021 à 10h28

À quoi sert exactement ce « neural engine » ? Est-ce que les librairies traditionnelles de machine learning comme pytorch peuvent l’exploiter ?

Le 19/10/2021 à 11h06

Oui enfin on parle pas du tout des mêmes clients ^^

AMD a attaqué Intel entre autres sur la tarification.

On ne peut pas dire de même d’Apple, dont les puces ne sont pas disponibles hors achat d’un Mac complet.

Si Apple proposait ses M1 à un tarif similaire à un Ryzen mobile je pourrais parler d’attaque.

Pour moi Apple fait comme d’hab, des trucs dans son coin pour ceux qui peuvent se le permettre.

C’est ni bon, ni mauvais,mais ça reste hors de prix pour beaucoup.

Le 19/10/2021 à 11h18

Un macbook air m1 qu’on trouve entre 850 euros et 1500 euros, avec son niveau de performance et d’autonomie et fanless, c’est l’ordinateur portable le plus efficace et le moins cher jamais vu honnêtement.

Le 19/10/2021 à 11h22

Ca consomme combien une 3080 en plein charge ? Cowcotland indique 327W.

Parce que là, l’article nous parle d’une perf équivalente à 50W pour Apple et à 150W pour la 3080, ce qui ne veut pas dire grand chose. Peut-être qu’à 25% de sa conso la 3080 ne sort que 10% de sa puissance de calcul par exemple… Donc si le iGPU est capé à 50W, la 3080 va calculer toujours bien plus vite, ça ne veut pas pour autant dire qu’ils font jeu égal.

Le 19/10/2021 à 11h30

La mémoire n’est pas sur la puce. Elle est proche du SoC et sur le packaging, mais ce sont des puces à part (pour la modularité notamment). Le SSD sera toujours interface en PCIe où qu’il soit, le mettre sur le packaging n’aurait pas vraiment d’intérêt et pour gagner en latence il y a mieux à faire. Et de toutes façons, ce sont déjà des composants soudés la plupart du temps.

C’est le souci des benchs publiés : est-ce un jeu, CPU/GPU bound, à quelle définition/niveau de détail ? Ce serait un test de pixel fillrate en 720p que ce serait pareil. D’où l’importance des tests indépendant (et franchement de telles comparaisons ne devraient pas être permises sans plus de détails diffusés en direct).

Alder Lake a été pensé pour faire face aux M1, donc forcément ;) Mais bon, comme dit plus haut, on verra si avec le temps l’écart se ressert ou se creuse. Ce sera la seule chose qui comptera.

C’est Apple donc on te dira sans doute d’aller regarder du côté de CoreML. Mais de mémoire il y a des outils de conversion depuis les frameworks Python, à vérifier dans la doc développeur. Il faudrait aussi vérifier ce qui tourne nativement ou pas dans l’écosystème Python (ça reste une base BSD), j’ai pas regardé depuis un moment.

Le 19/10/2021 à 11h43

Franchement j’aimerai vraiment tester les mac avec M1, j’ai un Mac Book pro avec proco intel et c’est une vrai catastrophe, chauffe, lent , bruyant…..

Le 19/10/2021 à 12h11

C’est facile c’est tout l’inverse, et pourtant je suis 100% PC sauf en ce moment car il n’y a pas d’équivalent en PC quel que soit le prix.

Le 19/10/2021 à 12h30

pas mieux que Snakesolid !

Je suis admin système de mon entreprise et le Macbook M1 que j’ai en ce moment couvre 100% de mes besoins. Pas de gros calculs pour moi mais beaucoup d’interventions à distance sur serveur et postes clients. Bref , l’autonomie, la réactivité, l’ergonomie le silence de fonctionnement il n’y a pas d’équivalent sur le marché et de loin.

Beaucoup disent pourtant que Apple c’est trop cher, mais un ultraportable avec une grosse autonomie et un processeur haut de gamme vaut bien plus cher qu’un MacBook Air …

Le 19/10/2021 à 13h34

Ce que je veux dire c’est que ça remet en perspective la rivalité Intel/AMD, où les différences entre les deux dans les laptops peuvent maintenant faire rouler des yeux comparativement au fossé qui s’est creusé avec Apple. Maintenant côté Intel/AMD on a l’impression de choisir entre bof et bof bof, ça fait soupirer et c’est difficile d’admirer l’un ou l’autre pour avoir repris la couronne du x86. C’est un peu comme si on devait choisir entre un HDD 7 200 rpm et un HDD 10 000 rpm alors qu’on sait que les SSD existent.

Le 19/10/2021 à 13h37

Oué mais moi je préfères une machine moins parfaite, et réparable même si c’est un peu compliqué.

Parce qu’ajouter de la RAM, changer le disque et changer la batterie sont absolument essentiel pour qu’un ordinateur dure longtemps.

Le 19/10/2021 à 13h45

Autant changer la batterie et le SSD me semble important, autant la ram me semble désormais inutile

Les besoins en ram n’augmente plus vraiment au dela de 16/32/64 sauf cas spécifique

Perso ça va faire 10 ans que j’utilise 16 go sur tout mes pc, alors que si je prend la décennie d’avant je suis passé de 512mo a 8 go

il y à une forte probabilité que dans 10 ans on utilise difficilement plus que 32go et que 16go soit toujours utilisable

Le 19/10/2021 à 13h56

Idem.

Y a-t-il un constructeur qui propose un ultraportable fanless avec des performances équivalentes ? À ma connaissance non, faute de processeur x86 suffisamment puissant adapté à ce type d’assemblage.

J’utilise toujours un vaillant MacBook Air mid-2012 (i5-3427U/8Go/128Go) car macOS Catalina est toujours maintenu par Apple.

Il sera remplacé sans la moindre hésitation par un MacBook Air fanless lorsqu’Apple le rééquipera avec un connecteur d’alimentation MagSafe (très certainement dans la prochaine itération).

NXi considère qu’il faut changer son Mac s’il n’est plus compatible avec le dernier OS d’Apple. Drôle de vision de la durabilité…

C’est totalement faux.

Un appareil est durable à partir du moment où il reste utilisable dans des conditions de sécurité optimales et où la compatibilité des services est assurée, deux choses difficilement reprochables à Apple.

Pour en revenir à ma brouette de MacBook Air actuel, il sera recyclé sous Linux pour ses vieux jours lorsque son remplaçant arrivera. Comme quoi, un Mac n’est pas si fermé que certains le prétendent.

Le 19/10/2021 à 14h07

Bonne chance pour faire pareil avec un Mac M1

(Pour le reste je ne réponds pas, je suppose qu’on a déjà eu un échange sur le sujet et je n’ai pas envie de remettre une pièce dans la machine, ton avis à l’air de te convenir, tant mieux )

)

Le 19/10/2021 à 14h39

Y’a t’il déjà eu un précédent où des tests indépendants ont donné des chiffres très différents de la comm’ officielle d’Apple ? (Différents à la baisse j’entends… car j’en ai déjà vu où les tests indép montraient que les perfs étaient meilleures qu’annoncées dans certains cas)

Le 19/10/2021 à 14h41

Tout à fait. On a l’impression que c’est une vieille bataille sur des enjeux qui ne sont plus d’actualité.

Si un constructeur ARM réussi à faire une puce presque équivalente au M1 mais pour PC, Windows on ARM va décoller. Enfin, si elle ne coûte pas le double du prix pour 30% des perfs du PC comme ça a été le cas (en exagérant) avec les dernières tentatives.

Car un des problèmes des PC basse conso, ça a été qu’ils ont été fortement décrié non pas pour ce qu’ils étaient, mais pour ce qu’ils n’étaient pas (les transmeta en 2000, les PC en atom avec CG de portable vers 2010, les derniers portables ARM). On ne leur a laissé aucune chance car ils ne faisaient pas tourner les applis qui ne leur étaient pas destinées.

Sera-ce toujours le cas? J’ai plusieurs ordis en 8Go de RAM, mon ordi de jeu est une 3570K en 8Go de RAM, j’ai juste mon poste de dev en 16Go de RAM… Ca suffit amplement pour mes usages (et ils sont nombreux).

Si un ordi est optimisé avec une OS optimisé (donc pas … Android), 8Go de RAM peuvent largement suffire.

Le 19/10/2021 à 15h02

Ça n’a pas vraiment de sens d’installer un Linux sur un Mac M1 à l’heure actuelle. Mais d’ici l’abandon du support des Mac M1 actuels (dans une 10aine d’années donc), Linux sera certainement supporté depuis un bon moment. En tout cas certains y travaillent déjà :

Le 19/10/2021 à 15h13

Je crois qu’Apple c’est du PowerVR, donc plus efficace que ce que peut faire NVidia / AMD. Après Metal est peut-être plus adapté à cette architecture…

C’est sûr qu’Intel / NVidia / AMD prennent un gros coup de vieux après cette présentation.

Le 19/10/2021 à 15h34

La différence entre un test indépendant et la comm’ c’est qu’on ne te montrera pas que les use case idéaux. Par exemple tu ne verras jamais Apple fait un comparatif entre ses puces M1 et un CPU/GPU sous Blender

Oui, mais on a toujours raison quand on choisi le contexte. Tu parles de liberté, tu me réponds qu’elle n’a pas d’intérêt. De mon point de vue, l’intérêt n’est pas le sujet. La liberté c’est assez binaire, tu l’as ou pas. Et si un jour il y a “support” de Linux, il ne sera pas du fait d’Apple.

Oui et non, il ne faut jamais oublier que la puce est performante parce qu’elle est énorme (et donc très coûteuse). Faire ça dans un écosystème ultra limité, c’est une chose, mais c’est aussi se faciliter la vie. Là où Apple fait fort c’est dans le perf/watts, le reste est mis en musique par le marketing qui cherche à faire oublier que pour passer d’un modèle de SoC/RAM à l’autre il faut parfois débourser près de 1200 euros.

Le 19/10/2021 à 16h30

La puce M1 Max fait 432mm2 pour une puce dans un engin qui vaut 3000 euros, le SOC amd de la xbox series X fait déja 360mm2 dans une machine qui vaut 500 euros

C’est plus une question de volume que de prix

Le 19/10/2021 à 16h32

Ce n’est donc pas totalement abouti avec un écart de prix dont on imagine facilement la raison : vendre une technologie même comparable à une 3080 revient à toucher 20% à la louche de la clientelle existante et prête à switcher son mbpro intel pour arm.

C’est plus une démo technique à mon sens pour dire : on va par là dans 5-6 ans.

Un peu comme nvidia qui aura mis ses 3-4 ans pour justifier le rtx inclus par défaut.

Le 19/10/2021 à 16h48

Pas vraiment, les modèles économiques des deux ne sont pas similaires. Surtout que tu compares en mm² des puces en 5 nm et en 7 nm. Cela présuppose que le coût du wafer est identique entre ces deux process. Spoiler : ce n’est pas le cas.

Le haut de gamme est toujours un aperçu de l’offre mainstream de demain (à quelques exceptions près). Attention tout de même : comparaison n’est pas raison. RTX par défaut s’explique par bien des raisons, ne voir ça que par le prisme du jeu qui met 3 à 4 ans à se justifier c’est louper l’essentiel. RTX a été exploité day one là où il était nécessaire, le gaming, c’est du bonus différenciant.

Le 19/10/2021 à 17h00

Probablement pas effectivement mais je doute fortement que la puce M1 coûte 6x le soc AMD

Le 19/10/2021 à 17h13

Oui, mais tu n’en sais rien, surtout si tu rapportes le coût en R&D au volume vendu par exemple (merci les iPhone d’éponger le différentiel ). Et in fine, on juge de ce qui est tangible dans des conditions comparables.

). Et in fine, on juge de ce qui est tangible dans des conditions comparables.

Le 19/10/2021 à 19h02

Petite remarque sur la taille / conso des puces : Apple annonce 100g de plus pour MacBook Pro 16” (2,1 vs 2,2 kg) avec M1 Max plutôt que M1 Pro. Première fois que je vois un ordi changer de masse en fonction du choix de la puce.

Apple

Apple

Il y a sûrement de l’arrondi, et le système de refroidissement est sûrement plus grand, mais c’est suffisamment inédit pour être remarqué !

Le 19/10/2021 à 19h18

Attention, la ils parlent de la 3080 mobile, ce n est pas la meme puce qu en desktop. En perf c’est bien en dessous d une 3070 desktop.

Le 19/10/2021 à 20h30

Ca ne parait pas primordial mais ça peut rester nécessaire.

En plus, je dépanne au moins un pc par an où la barrette de ram est le facteur de plantage.. Si la ram est HS et soudée, ça fait un ordinateur jeté pour 3 fois rien..

Le 19/10/2021 à 20h53

Linux, c’est pas un système juste pour faire durer les vieilles machines. On peut vouloir Linux pour plein de raisons, par exemple pour avoir quelque chose d’un peu moins obtus que MacOS en cas d’utilisation entreprise (vieux souvenirs d’arrachage de cheveux entre MacOS/iOS et le réseau Cisco), ou pour avoir des fonctionnalités moins bridées que ce que certains OS propriétaires proposent.

Et puis il y a le côté sport/ultra snob.

Si on se rappelle l’époque des P2 & Celeron 400, c’est plus une question de segmentation de marché que de prix de revient.

Apple a créé un M1 qui fait très fort, et placent leurs prix en-deçà des Apple x64 précédents de performances inférieures, histoire de bien montrer la supériorité du matériel Apple.

J’imagine bien qu’ils margent encore bien fort (et je pense qu’ils le méritent, ce n’est pas un reproche), mais il faut reconnaître que sur les Mac “pro” x64 précédent, les prix étaient très très très forts…

Les M1 vont certainement rester un moment moins chers, le temps de sortir toute la gamme. Ensuite, soit ils augmenteront de prix, soit (et je pense que c’est probable) ils seront légèrement simplifiés car je pense qu’une partie des transistors est une aide pour l’émulation x64.

Pour le moment on est dans une phase de pénétration de marché. Une fois bien en place, ils pourront marger plus, potentiellement sans bouger les prix.

Le 20/10/2021 à 07h23

Ce n’est pas une critique du système ou pour le rabaisser aux vieilles machines, juste un constat que pour l’instant Linux gère très mal la nouvelle plateforme Apple. A moins de vouloir participer activement au développement des distributions dédiées au M1 ça n’a donc pas d’intérêt.

Le 20/10/2021 à 08h39

Ça arrivera bien…

Le 20/10/2021 à 10h44

Ah oui si on parle de la version mobile en plus… Ca doit pas aller beaucoup plus loin qu’un IGP Intel en somme

Le 20/10/2021 à 11h25

Mouais… ils indiquent quels softs ils ont utilisé et c’est assez varié.

En tout cas, j’en reviens à ma question initiale : leurs promesses ont-elles déjà été franchement mises en défaut un jour ?

Pas à ma connaissance… Généralement, quand ils disent qu’ils fracassent la concurrence, ils la fracassent pour de vrai et ils ne le font pas à moitié. Sinon, ils se contentent de dire que le nouveau iDevice est meilleur que le modèle précédent.

Le 20/10/2021 à 11h40

La 3080 mobile utilise la puce de la 3070ti avec un tdp divisé par 2 et de la mémoire inférieure.

Le 20/10/2021 à 13h43

Si Apple ne mettait pas de bâtons dans les roues, le support aurait déjà pu être parfait.

Le 20/10/2021 à 14h06

J’en rêve. Je garde mon MBA m1 juste dans cette optique.

J’ai eu beaucoup de demande autour de moi pour me le racheter quand j’ai échangé mon ancien iMac pour le nouveau avec m1, mais j’espère le voir tourner en natif sur Linux un jour pour remplacer mon trop vieux laptop…

Le 20/10/2021 à 14h28

Quels batons dans les roues ? Y’a pas de doc officielle, donc c’est forcement galere à faire, mais à ma connaissance ils ne freinent pas le dev. Surtout que le processus de boot est concu pour supporter plusieurs OS (Cf https://asahilinux.org/2021/03/progress-report-january-february-2021/), ce qui n’a aucun intérêt pour Apple, c’est bien qu’ils sont -un peu- ouvert à l’idée.

Le 20/10/2021 à 14h46

Disons que l’absence totale de documentation, couplée à l’utilisation d’énormément de choses non-standard rend les choses inutilement compliquées. Pas d’UEFI, un point d’entrée dans le noyau codé en dur, pas de possibilité de booter sur un périphérique externe, même la gestion des interruptions ne correspond pas à ce qui se fait habituellement sur ARM64. On a connu plus accueillant comme plate-forme !

Avec des docs (qui existent en interne, indubitablement, il suffirait de les rendre publiques), Linux tournerait parfaitement sur M1 depuis longtemps.

Le 20/10/2021 à 14h55

je dirais que Apple semble se diriger vers de puce graphique haute performance, à mettre en parallèle de leur investissement récent dans la fondation blender. Me demande comment va se passer arm propriété de Nvidia si Apple joue sur les plate bande de Nvidia sur les pc portable.

https://www.blender.org/press/apple-joins-blender-development-fund/

Le 25/10/2021 à 16h19

Je suis curieux de voir ce que vaut cette puce sous de forte charge de travail sur une longue durée. J’ai de très mauvais souvenir du MacBook Pro que j’avais au boulot qui m’avait été vendu en mode “C’est de la bombe, tu peux tirer à fond, Apple gère bien leur truc”. Mouais, pour l’usage de bureau et du forte de charge de court instant, ça tient (comme presque n’importe quel PC). Par contre, dès que le charge est intense et longue dans le temps (>5min), tu peux aller te brosser ! Le cpu se met à throttle rà mort parce que le système de refroidissement ne soutient pas la charge. (Sans parler de la batterie qui se vide plus qu’elle ne se recharge malgré le secteur branché).

En tout cas, balèze. Vivement que Linux tourne dessus pour s’amuser un peu dessus.