Aux impôts, les agents contestent l’utilité de l’intelligence artificielle

Ouvrez le dialogue social technologique

Tangi Bertin pour Unsplash

À l’occasion de la publication de son livre « L’IA aux Impôts », Solidaires Finances Publiques a donné une conférence de presse pour détailler ses constats et inquiétudes relatifs au déploiement de l’intelligence artificielle au fisc. Next y était.

Le 10 décembre 2024 à 15h04

11 min

IA et algorithmes

IA

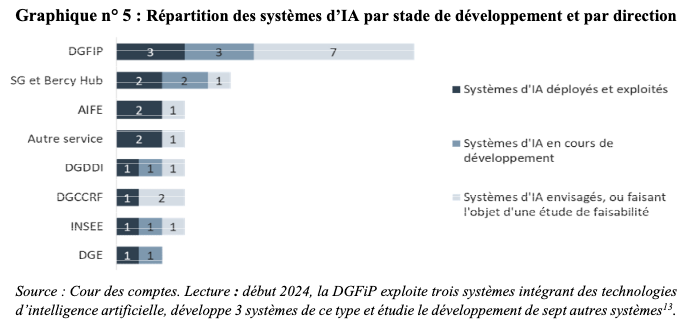

Des chercheuses indépendantes s’allient pour obliger les administrations françaises à être plus transparentes sur leur usage de l’intelligence artificielle, la Cour des Comptes alerte sur le manque de pilotage des déploiements d’IA au sein du ministère de l’Économie et des finances… mais qu’en pensent celles et ceux qui se retrouvent à manipuler ces outils au quotidien ? Comment les agentes et agents de l’administration envisagent les technologies d’IA déployées dans leurs services ?

Solidaires Finances Publiques s’est posé la question et l’a transmise aux plus de 90 000 agents de la direction générale des Finances publiques (DGFiP), fin 2023. Le 6 décembre, elle publiait les premiers résultats de cette campagne. Sur les 4 199 répondants à travers le pays, 20 % déclarent utiliser des outils d’IA dans leurs missions.

« L’IA nous est vendue comme permettant d’être plus efficace et de mettre fin aux tâches chronophages », souligne Linda Sehili, du bureau national de Solidaires Finances Publiques. Sur le terrain, cela dit, l’efficacité de ces outils reste « relative » : plus de 85 % de leurs usagers déclarent que ces outils ne leur permettent pas de se « consacrer à d’autres tâches plus intéressantes », et plus de 90 % déclarent que l’utilisation de l’IA ne donne pas « plus de sens à [leur] travail ».

Évolution des missions, des conditions de travail et du service rendu

Depuis le lancement de son questionnaire, Solidaires Finances Publiques a pris la question du déploiement de l’intelligence artificielle au sein de sa direction générale à bras-le-corps. « La DGFiP est le fer de lance de l’expérimentation et du déploiement de l’IA dans l’administration », a déclaré la secrétaire générale du syndicat Sandra Demarcq ce 9 décembre. « Nous avons considéré que ce développement avait des conséquences sur nos missions, sur notre travail, mais aussi que cela transformait le champ du service public de proximité que nous fournissons. »

Pour détailler les implications de ces bouleversements, le syndicat a donc publié L’IA aux impôts, Réflexions et actions syndicales aux éditions Syllepses, riche analyse des effets concrets du déploiement de ces technologies au sein d’une administration française. « Nous ne sommes ni concepteurs ni data scientists, nous ne sommes pas technophobes non plus, mais nous sommes résolument technocritiques, explique encore Sandra Demarcq. Nous revendiquons le droit de remettre l’IA en cause quand elle n’est pas synonyme de progrès social, quand elle est le reflet d’intérêts privés et que son déploiement est seulement motivé par la suppression d’emplois. »

Or, outre les 85 % d’agents utilisant de l’IA sans y gagner de temps, plus de 51 % d’entre eux signalent que l’utilisation de l’IA dans leurs missions « génère des erreurs » (35,26 %), voire « beaucoup d’erreurs » (16,07 %). Et Linda Sehili d’illustrer avec le projet Ciblage fraude et valorisation des requêtes (CFVR) : en 2022, « 52 % des entreprises contrôlées l’ont été suite à une programmation par data mining » (c’est-à-dire suite aux résultats du projet CFVR). Pour autant, cette dernière n’est à l’origine « que de 13,6 % des droits et pénalités de recouvrement » réalisés la même année.

Opacité technique et par externalisation

Les membres de Solidaires Finances Publiques relèvent par ailleurs que le fonctionnement opaque des systèmes déployés crée de brusques surcharges d’alertes inexpliquées – par exemple celles relatives aux dépenses de carburant, autrefois validées sans difficultés. Quand les entités contrôlées demandent aux agents de justifier les demandes de documents, ces derniers se retrouvent à leur tour dans l'incapacité de fournir une explication. Une dynamique susceptible de créer le mécontentement des contribuables comme celui des agents, qui se plaignent de leur manque de maîtrise des résultats des systèmes.

Solidaires explique ce manque de transparence par des raisons techniques, d'abord, qui compliquent la compréhension précise des résultats fournis par un système d’apprentissage machine. Mais le syndicat alerte aussi sur la perte de maîtrise de l’administration : certains projets informatiques sont externalisés à plus de 80 %. « Or, pour la direction interministérielle du numérique (Dinum), un taux d’externalisation supérieur à 70 % constitue un risque », rappellent les auteurs de L'IA aux impôts.

Le recours à des sociétés de conseils (principalement CapGemini, CGI France et Sopra Steria) se traduit aussi, dans certains cas, par des enjeux de souveraineté. Ces dernières ayant toute latitude en matière de sous-traitance, le syndicat relève ainsi que la partie reconnaissance d’image du système Foncier Innovant est réalisée par Google, géant états-unien habile en optimisation fiscale.

Dans le même ordre d’idée, le projet de chatbot e-contact a été créé dans l’idée de faciliter le traitement des 12 millions de mails reçus par l’administration fiscale – présupposé que Solidaires remet en question, soulignant que le contexte de suppression d’emplois ne facilite pas le traitement des demandes. D’après son contrat de transformation (.pdf), ce projet (d’un coût global de 6,4 millions d’euros, pour des économies prévisionnelles, chiffrées en termes de suppression de 138 emplois, soit 4,8 millions d’euros) s’appuie notamment sur les « services cognitifs tiers » d’IBM Watson.

Morcellement des tâches et surcharge de travail

Outre générer des résultats inexplicables, soit pour raisons techniques, soit faute d’interlocuteurs intégrés à l’administration, les machines déployées au sein de la DGFiP produisent des erreurs que les agents doivent corriger avant de reprendre le cours de leurs activités. Dans les réponses à l’enquête de Solidaires, un nécessaire « apurement des listes » et une « exclusion des faux positifs » sont régulièrement évoqués. Cela crée chez certains un « sentiment d’abattage de masse ».

En outre, en croisant énormément de données au niveau national, un système comme CFVR permet de détecter des fraudes simples. « Mais l’IA est incapable de détecter des fraudes complexes, ne serait-ce que parce que ces schémas reposent souvent sur l’absence de données », illustre Linda Sehili. Si les agents y parviennent, c’est parce qu’eux savent repérer les schémas suspicieux d’absence de facturation, de carrousels de TVA ou encore d’entreprises qui se créent, puis disparaissent.

Citant le biais d’automatisation, qui tend à faire plus confiance aux résultats d'une machine qu’à son propre jugement, Benjamin Gandouin souligne le risque que les fonctionnaires perdent en initiative dans l’enquête de schémas de fraude plus complexes que ce que la machine est capable de détecter. « Les fonctionnaires craignent une perte de technicité et d’autonomie au fil des années » résume Linda Sehili.

Là où la plupart avaient une relative vision d’ensemble auparavant, « ils se retrouvent désormais avec une succession de petites tâches à accomplir, donc une vision parcellaire de leur emploi ». Derrière les nouvelles tâches et l’absence de sens dans le travail relevé dans les témoignages des agents, Solidaires Finances Publiques craint la multiplication de risques psychosociaux. Depuis plusieurs décennies, les études se succèdent, qui soulignent en effet un lien direct entre perte de sens au travail et accroissement des risques de maladies professionnelles.

Dégradation du service rendu

Comme la Cour des Comptes, qui relevait en novembre 2023 la difficulté à évaluer l’efficacité du système CFVR (sauf en matière de suppression d’emplois), les équipes de Solidaires Finances Publiques constatent l’absence de communication des bilans des projets déployés, donc l’absence de données sur leurs effets concrets. Un vide qui rappelle les difficultés des institutions à dresser le bilan de leurs expérimentations en termes de vidéosurveillance et de vidéosurveillance algorithmique.

En tirant la réflexion, le syndicat interroge l’évolution du service public, auquel les méthodes de gestion du secteur privé, puis une numérisation croissante, ont été appliqués au motif d’une recherche d’efficacité. Demandant à ses lecteurs si « le service public est compatible avec l’idée de rentabilité », Solidaires Finances Publiques le conteste aussitôt, soulignant que cette recherche de rentabilité ne semble fondée que sur de la réduction d’emplois.

Dans son ouvrage, le syndicat souligne également que l’imposition de mesures administratives totalement numériques engendre « un transfert de charges et de responsabilité sur l’usager.e ». En 2022, un rapport de la Défenseure des droits sur le sujet relevait pourtant que « 35 % de la population rencontre, à un titre ou un autre, des difficultés pour utiliser les outils numériques ».

En interne, il s’inquiète des effets du déploiement de systèmes informatiques sur la qualité du travail réalisé, et de la propension qu’a cette tendance à éloigner l’administration de ses administrés. Moins nombreux, les géomètres vont par exemple moins sur le terrain. L’association de leur travail à celui de systèmes d’IA commence à avoir des effets concrets sur le cadastre, « qui devient un peu moins bon, explique Linda Sehili, alors que la France est connue au niveau européen, voire mondial pour avoir un super plan cadastral ».

Outillage pour un dialogue social technologique

Défendant un service public « technicien, de proximité et de qualité », selon les mots de Sandra Demarcq, Solidaires Finances Publiques a aussi dû adapter ses pratiques pour tenter de créer ce qu’il qualifie de « dialogue social technologique ».

Pour mener son enquête, agir au quotidien et écrire L’IA aux impôts, le syndicat a multiplié les liens avec des chercheurs, des associations et d’autres acteurs de la société civile. En échangeant avec Maxime Cornet et Clément Le Ludec, deux doctorants en sociologie travaillant sur l’externalisation du travail du clic « à la française », « nous avons par exemple appris que le système de Foncier innovant était entraîné à Madagascar, où le salaire mensuel pour ce type de tâches ne dépasse pas les 150 à 200 euros », indique Benjamin Gandouin.

Aux contacts de journalistes et d’associations comme la Quadrature du Net, le syndicat s’est par ailleurs mis à chercher les informations qui lui manquaient en sources ouvertes, ou par l’intermédiaire de demandes de documents administratifs auprès des personnes responsables de l’accès aux documents administratifs (PRADA), voire en saisissant la Commission d’accès aux documents administratifs (CADA).

Il prévoit désormais de demander régulièrement les analyses d’impact relatives à la protection des données (AIPD) des projets pour faciliter sa cartographie du déploiement d’outils d’IA. En partenariat avec l’Institut de recherches économiques et sociales (IRES), et de nombreux syndicats des secteurs publics et privés, Solidaires Finances publiques a aussi participé à la fabrication de DialIA, un outil concret de création de registre des projets d’intelligence artificielle. Il en facilite le suivi du financement, de l’intégralité de la chaîne de sous-traitance, l’identification des données utilisées et de celles à risque, etc.

Témoignant de la difficulté d’obtenir des informations, Benjamin Gandouin ajoute : « Il nous arrive de demander l’appui de personnalités politiques locales ou nationales. Quelquefois, des questions prioritaires de constitutionnalité nous permettent de récupérer de l’information, tout en sensibilisant les élus. »

Aux impôts, les agents contestent l’utilité de l’intelligence artificielle

-

Évolution des missions, des conditions de travail et du service rendu

-

Opacité technique et par externalisation

-

Morcellement des tâches et surcharge de travail

-

Dégradation du service rendu

-

Outillage pour un dialogue social technologique

Commentaires (22)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousModifié le 10/12/2024 à 15h27

Beaucoup de chiffres cités dans l'article sont objectifs (52 % des entreprises contrôlées l’ont été suite à [préselection IA, mais ne représentent] que 13,6 % des droits et pénalités de recouvrement), mais d'autres sont carrément subjectifs (plus de 90 % déclarent que l’utilisation de l’IA ne donne pas « plus de sens à [leur] travail ».)

Et un peu de connotation politique : Google qui devrait être persona non grata car il est "habile en optimisation fiscale".

Le 10/12/2024 à 16h23

Personnellement, solidaires informatique me donne des boutons : ils sont extrémistes, ce qui les disqualifie à mes yeux. Bon, ce n'est que mon avis perso qui n'intéresse que moi, mais du coup, j'ai tendance à me dire qu'il y a forcément un biais dans leur étude, qui prouve (évidemment) ce qu'ils avaient prévu de prouver en faisant le sondage et l'étude. Bref, une démarche pas scientifique mais militante.

Pour faire bon poids dans ma critique : "système d'IA", ça ne veut rien dire. On se reportera avec grand intérêt à https://framamia.org/fr/#understand_families qui liste 6 familles d'IA profondément différentes.

Modifié le 10/12/2024 à 16h58

Ceci dit, revenons au sujet.

Je ne veux pas cracher pas dans la soupe, je ne connais pas vraiment Solidaires car ce syndicat n'est pas représentatif chez mon employeur, mais c'est vrai que nos délégués syndicaux ont un rôle que j'apprécie quand je vois ma convention collective (on l'a "hérité" de notre maison mère qui n'est pas une SSII).

Mais ils produisent tous des documents à dessein, et donc à manipuler avec précaution.

Le 10/12/2024 à 16h49

Le 10/12/2024 à 18h51

Le 10/12/2024 à 18h53

Mais je pense que j'ai marché dedans.

Le 11/12/2024 à 10h03

Le 11/12/2024 à 12h23

avec une image "sous les claviers, la rage, débranchons le patronat". heu... désolé, mais chez moi, ça ne passe pas.

(quand on lit le détail de l'article, il y a beaucoup de choses avec lesquelles je suis plutôt d'accord sur le fond. Sur la forme pas du tout et je pense que ça sort du cadre syndical)

Le 11/12/2024 à 18h56

Le 11/12/2024 à 22h03

Ensuite tu balances des chiffons rouges pour montrer quoi?

SolInfo, ils ont dévoilés avec d'autres, les problèmes de harcèlement sexuel au sein d'Ubisoft et aidé les salariés.

Tu vas aussi leur reprocher leur façon de faire?

Tu aurais fait mieux toi tu penses ? 🤔

Le 12/12/2024 à 17h00

Je suis à peu près au courant des problèmes au-delà d'Ubisoft, c'est très bien qu'ils les aient dénoncés et aidé les salariés, il n'y a aucun doute là-dessus dans mon esprit, je ne confonds pas tout (je ne sais pas quel part a joué SI là-dedans)

Allez, je balance le troll final : ce genre de syndicat semble penser que tous les patrons sont des salauds. Il y a des patrons voyous, c'est clair. Mais tous les patrons ne sont pas voyous, non. C'est comme dire "les politiques, tous des vendus" ou "les fonctionnaires, tous des glandeurs".

PS : sinon, moi, toujours sans le moindre doute : non, je n'aurais pas fait mieux (pb ubisoft).

Modifié le 10/12/2024 à 16h42

Ils ne sont pas là pour arriver à la meilleure solution pour le pays mais à celle qui permet de préserver le plus d'emplois publics épanouissants et bien payés (normal, c'est leur rôle de syndicats). Sauf que le pays est en faillite et qu'on ne peut plus continuer comme avant en espérant que ça se passe bien. On change pour se moderniser et être plus efficaces, ou on continue de couler.

Le 10/12/2024 à 17h48

Le 10/12/2024 à 18h23

Imho, sur un sujet aussi complexe, notre rôle est de ne surtout pas sauter aux conclusions. Notre boulot c'est d'essayer, à la mesure de nos petits bras musclés, de vous fournir la matière pour que vous, lecteurs, puissiez vous forger un avis éclairé. Pour ça, on s'intéresse à ce que disent tous les observateurs un minimum avisés du sujet. On passerait imho à côté d'un pan du sujet si on ne s'intéressait pas à ce qu'en disent les agents concernés, dont le syndicat est, quoi qu'on en pense, l'une des représentations...

Il y a eu beaucoup d'articles consacrés à Foncier Innovant sur Next ;-)

Modifié le 10/12/2024 à 18h38

Et je peux le dire avec la connaissance de la réalité du terrain : non le projet n'est pas une catastrophe, loin de là, oui ça fonctionne et plutôt bien. Le seul truc c'est que c'est évidemment imparfait, que des choses sont détectées alors qu'il ne faudrait pas, et inversement.

Les choses détectées a tord, y'a un contrôle humain qui est en partie appliqué et donc limite. Mais les contrôles ont de plus tendances à ne se baser que sur l'IA, et que du coup, si on est un peu malin, on saura passer entre les failles et c'est toujours les mêmes qu'on va viser ( comme avec les algos de la CAF qui visent les plus pauvres )

L'IA devrait être un outil au service des agents et non un outil qui dicte le travail des agents

Le 11/12/2024 à 00h56

Le 10/12/2024 à 19h49

Aucun outil ne devrait permettre de déresponsabiliser l'État de sa mission.

Rappelons aujourd'hui que les processus dits "intelligents" utilisés aujourd'hui et massivement imposés aux salariés du privé le sont pour des raisons de recherche de profit en éliminant des emplois ("fonctions") support et les salaires associés, quand il n'ont pas déjà massivement été déplacés hors du territoire.

Le coût en salaire est remplacé par du coût en matériel avec l'espoir d'amortir et/ou abaisser ces coûts sur la durée, tandis que les salaires vont devoir être payés à vie (et augmenter) pour respecter la dignité humaine.

Ces outils ne peuvent être utilisés que par des personnes capables d'en comprendre le fonctionnement et la sortie, et être ainsi capable de continuer à en endosser la responsabilité. Des experts du domaine faisant l'objet du traitement, en somme.

On parle d'usages éventuellement sur de l'aide à (et non remplacement de) décision, mais ni détection ni remplacement d'humains.

Ce n'est pas ce que l'on peut constater aujourd'hui.

Le public n'a vocation ni à copier ni à envier la brutalité déshumanisée & déshumanisante du secteur privé.

Il y a pourtant bien d'autres usages de la technologie que l'on pourrait faire pour améliorer nos vies & nos services publics, et non les abîmer.

Pourquoi ne nous intéressons pas plutôt à des outils simples permettant d'améliorer la qualité du service rendu ? Et ce après avoir déjà suffisamment équipé nos services publics en moyens humains & financiers ?

Le 10/12/2024 à 21h11

Je n'ai pas d'avis sur la question honnêtement, mais pour faire court, tu bosses autour de la fonction publique, non ?

Modifié le 10/12/2024 à 21h25

C'est un sujet récurrent dans le privé.

Il est irritant de chercher la rentabilité sur ces sujets, alors qu'on loupe une bonne partie de cette taxation par défaut.

Plus de moyens exigent plus de résultats.

Mais Cahuzac n'est pas content du résultat par exemple.

Reste à lui expliquer la notion de taxation.

...

Le 10/12/2024 à 22h17

La CAF se cache derrière des algorithme pour mettre à mal des population déjà mal en point pour ne pas distribuer la thune due aux gens.

Un CEO de compagnie d'assurance santé vient de se faire assassiner parce que sa boite a mis tout un système en place fondé sur des algos divers et variés pour ne pas faire leur taf et juste prendre la thune.

Les chatbots des services supports du monde entier (wink wink aux compagnies aériennes, mes préférées) sont magnifiquement taillée pour ne pas permettre d'accéder à quoi que ce soit où il faudrait payer quelque-chose au client. (pour être transparent, elles sont suffisamment foireuses pour pas donner non plus accès à des trucs où le client voudrait payer qqch).

Faire enrager un client/assuré/contribuable devant un bout de code anonyme protège le responsable (politique/corporate/whatever) de l'immense majorité des conséquences de ses actes.

On n'en est plus, depuis longtemps, à pouvoir prétendre que la technologie est neutre et que c'est juste que les gens s'en servent mal.

Le 11/12/2024 à 09h35

Les IA chatbot, je suis 100% d'accord avec toi, ça ne sert à rien, et ça ne sais répondre à aucune question qui n'est pas déjà répondue dans le site.

Ce qui serait bien, c'est que ce que dit un bot ai la même valeur juridique qu'un humain. Donc un bot qui ne me donne pas une facture lorsque j'en demande une doit être considéré comme un refus de me fournir une facture. Ça permettrait de responsabiliser les sociétés.

Par contre pour les impôts. La conclusion que je fais de l'article, c'est que l'IA n'est tout simplement pas suffisamment entraînée.

Si l'IA permet de choper tous les petits fraudeurs faciles, ça permet aux agents de se focus sur les gros. Ajouter au dataset ces nouvelles grosses fraudes pour les détecter automatiquement, puis passer aux encore plus grosses fraudes.

Ca me rappelle un "reportage" de Cash Investigation à la CAF. Ils montraient "l'employé de l'année" qui avait réussi a chopper une infirmière qui fraudait une somme énorme (ouh là là!), genre 200.000€.

Je vais être caricatural et méchant, mais pour chopper les infirmiers/infirmières qui fraudent des grosses sommes, il suffit de trier en descendant la colonne "dépense" de la feuille Excel... On prend le top10 et c'est quasi sure que ce sont des fraudeurs.

En étant plus factuel, une IA est parfaitement adaptée à faire ce boulot, c'est à dire de trouver ceux et celles qui sortent du cadres.

J'ai l'impression que les agents coûtent plus cher que ce qu'ils arrivent à récupérer des fraudes.

Bref, pour les fraudes faciles, il faut évidement que ce soit des algos ou des IA qui les choppent. On va pas mettre un agent qui coûte au contribuable 50000€ à l'année (au doigt mouillé) pour récupérer 2€ d'une boite de Doliprane.

Modifié le 11/12/2024 à 11h16

est ce que l'usage d'un chatbot engage l'entreprise ? (devoir de conseil, etc)

Il y a bien la jurisprudence d'air Canada, mais (1) ce n'est pas du droit français et (2) elle date de 3 ans, soit une éternité à l'échelle de l'IA

https://www.lemondeinformatique.fr/actualites/lire-l-hallucination-du-chatbot-d-air-canada-revele-la-responsabilite-juridique-des-entreprises-face-a-l-ia-93025.html