[Édito] IA : il nous faut un traitement plus nuancé

IA quoi ?

![[Édito] IA : il nous faut un traitement plus nuancé [Édito] IA : il nous faut un traitement plus nuancé](https://next.ink/wp-content/uploads/2024/05/Ia-oui-oui.webp)

Flock

Alors que la machine médiatique participe à amplifier le buzz autour de l'intelligence artificielle, Next se demande comment traiter le sujet à sa juste mesure.

Le 03 juin 2024 à 14h37

7 min

IA et algorithmes

IA

Mise à jour du 4 juin 2024 : ajout de la mention de Shaping AI

Comment parler correctement d’intelligence artificielle ? Il y a quelques semaines, auprès de la BBC, le professeur d’intelligence artificielle à la Liverpool Hope University David Reid déclarait : « je situerais la couverture médiatique de l’IA quelque part autour de 2 sur 10 ». Sa critique principale : le monde médiatique parle du champ comme d’une entité unique, alors qu’il ne l’est pas. Et d’appeler à une couverture plus nuancée.

La critique n’est ni neuve, ni cantonnée au monde britannique. À en croire Emily Bell, directrice du Tow Center for Digital Journalism de l’Université de Columbia, aux États-Unis, elle peut même s’expliquer par l’accélération du cycle de l’actualité, qui rend plus complexe, encore, la couverture de l’explosion de l’IA générative que ne l’a été celle de l’explosion d’internet en 2000 ou celle des smartphones en 2007.

Quoi qu'il en soit, les chiffres sont là : au Royaume-Uni, 60 % des articles relatifs à l’intelligence artificielle concernaient en 2018 des produits, des initiatives et des annonces de l’industrie technologiques. 33 % des sources identifiables venaient du secteur privé, soit deux fois plus que celles issues du monde académique. Pour certains chercheurs cités par le Reuters Institue, une partie du traitement du domaine s’apparente carrément à une « épidémie de mésinformation », dans laquelle les médias se contentent d'amplifier un buzz alimenté par les constructeurs.

La problématique se traduit, aussi, dans le type de sources relevées dans les articles de presse tech comme généralistes : dans l’ultra-majorité des cas, il s’agit d’une poignée d’informaticiens, d’entrepreneurs et de politiciens aux positions quasi unanimes, en faveur du développement et du déploiement de ces technologies.

Sauf qu’au Canada comme ailleurs, les liens entre intérêts universitaires, industriels et politiques, en matière d’IA, sont finement intriqués, les premiers cherchant financement chez les deux autres, qui interagissent par ailleurs pour la création d’un écosystème favorable à la promotion de l’IA. Ce qu’il manque, dans tout cela, ce sont les voix de ceux qui s’intéressent au reste, aux externalités sociales, environnementales, aux effets concrets et présents de l’expansion de cette industrie.

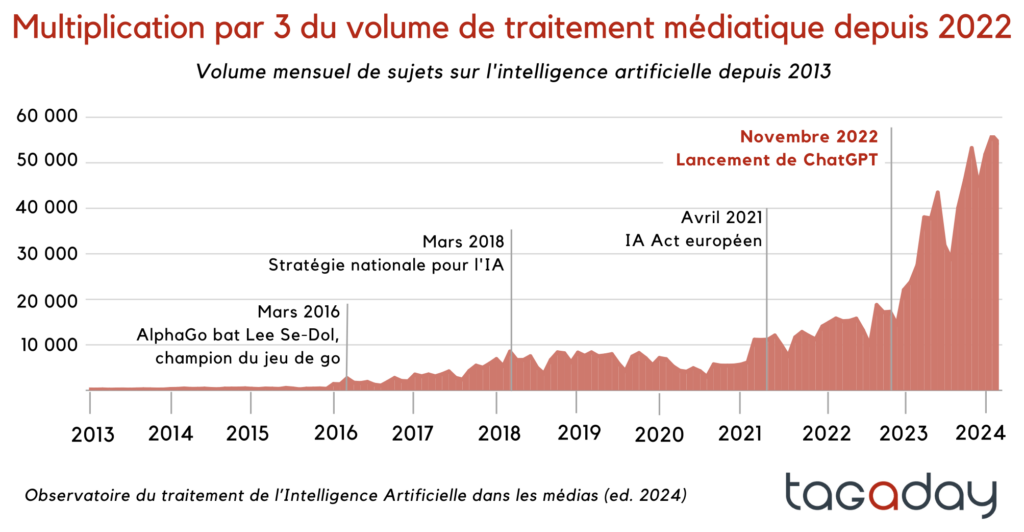

Côté francophone, on trouve des chiffres sur le succès médiatique du champ technologique : depuis 2022, selon la plateforme de veille Tagaday, le volume d’articles relatifs à l’IA a été multiplié par trois, sachant qu’au 1er trimestre 2023, un article sur 100 était consacré au sujet. Selon l’entreprise, une telle visibilité médiatique a quelque chose de comparable… « au conflit Israël - Hamas ». Si bien qu’entre 70 % et 80 % de la population interrogée par le Reuters Institute dans six pays (dont la France) a entendu parler de l‘IA générative… alors qu'à peine 15 % des Français utilisent un outil comme ChatGPT au moins une fois par mois.

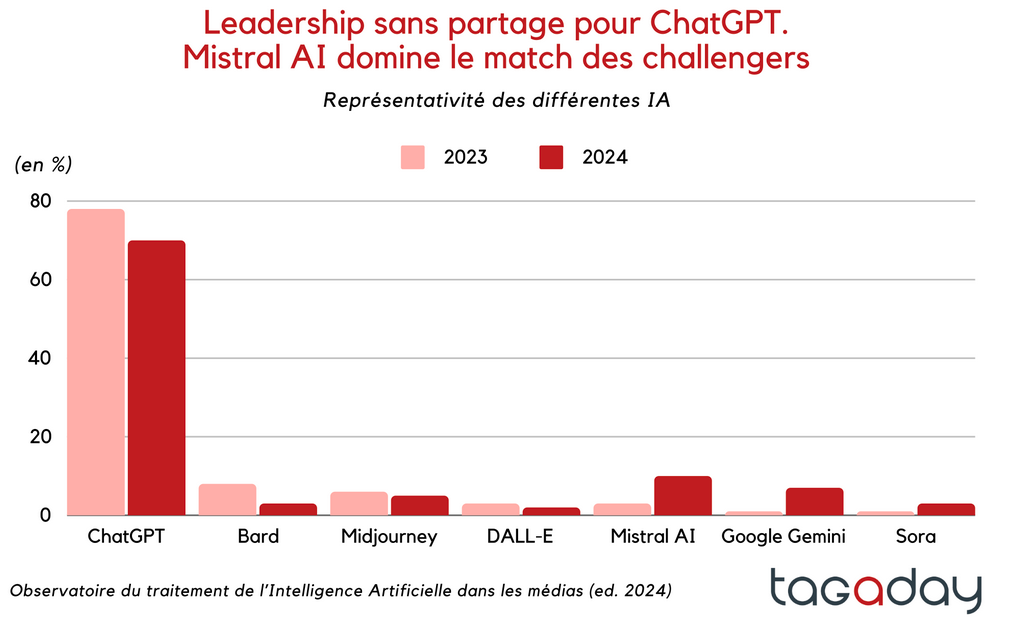

Sur un corpus d'articles de presse produits sur dix ans, entre 2011 et 2021, le projet Shaping AI du médialab de SciencesPo relève 19,05 % d'articles « associés à un discours de promesse technologique » et 9,5 % « associés à un discours critique ou de menace lié à ces technologies ». En éliminant les articles catégorisés « neutres », l'équipe de recherche constate une constante de deux tiers d'articles optimistes pour un tiers d'articles critiques. Un nombre croissant d’articles se penchent aussi sur le casse-tête que l’intelligence artificielle, générative ou non, pose dans les rédactions (pour, contre, ou les deux ? Quels types de modèles ? Pour quels types d’usages ? De la modération ? De l’enquête ? Du bâtonnage de dépêche chiffrée ?). Quant à Tagaday , sur les plus de 162 000 articles ou sujets audiovisuels analysés, elle rapporte une surreprésentation très nette de ChatGPT parmi les noms de modèles génératifs évoqués.

En 2023, nous revenions aussi sur le travail des sociologues Anne Bellon et Julia Velkovska, qui rapportait une évolution globale du traitement de l’IA en France (moins d’utilisation du terme « robot » à partir de 2016, plus d’occurrence de l’expression « IA » depuis). Comme d’autres, elles soulignent qu’une petite poignée de personnalités (Yann Le Cun, Ray Kurzweil ou, plus franco-français, Cédric Villani) est très largement citée, dont certains présentent une expertise débattue. Ainsi de Stephen Hawking, qui n’était pas expert de l’IA, et surtout de Laurent Alexandre, cinquième personnalité la plus présente dans leur corpus.

Les enjeux sont multiples, pourtant, et les seuls représentants de l’industrie numérique ne permettront pas de les décortiquer avec la nuance nécessaire. Il y a à peine six mois, ces leaders appelaient eux-mêmes à une pause dans le développement de l’IA. De pause, il n’y a pas eu. À la place, pointe la journaliste Julia Angwin, nous voilà aux prises avec des technologies génératives instables, qui inondent le web de contenus de faible qualité, mais peinent à prouver leur utilité.

Ça n’est pas la première fois que le monde médiatique se fait avoir par les promesses délirantes des industriels de la tech. Avons-nous seulement appris du passé ? De la bulle internet ? De celle des cryptos ? Du métavers ?

Il ne s'agit pas de tout jeter. Les technologies déployées par le champ de l'intelligence artificielle sont multiples, pour certaines anciennes, et sont là pour rester. Il s'agit de reconnaître, en revanche, que les questions auxquelles il nous faut chercher des réponses sont multiples.

Sur les modèles eux-mêmes, pour commencer : GPT-4 a-t-il réellement réussi haut la main l’examen du barreau, comme le clamait OpenAI en mars 2023 ? Un réexamen du chercheur Eric Martínez laisse penser qu’il s’est plutôt trompé pour une question sur deux. Quid de la capacité de ces modèles à répondre à des questions simples ? En contexte médical, une étude de Stanford montre que si un médecin sur dix utilise déjà ChatGPT au quotidien aux États-Unis, le grand modèle de langage produit trop d’erreurs pour être utilisable.

Les cadrages économiques aussi demandent de la nuance : quand Emmanuel Macron promeut l’intelligence artificielle en France, quelles mesures proposent-ils concernant les emplois qui seront touchés, forcés à muter ? Quelle évolution des cadres de travail, outre la réduction de l’assurance-chômage ?

Dans un autre domaine, la conférence Vivatech fait le plein de tables rondes sur les intérêts du nucléaire. Le président de la République joue, lui aussi, de cet argument pour attirer les géants numériques. Et c’est vrai, l’électricité française peut se targuer d’être peu carbonée.

Mais quid des autres effets du numérique sur l’environnement ? Sur quels terrains seront construits les data centers ? Avec quelle eau les refroidira-t-on ? En cas de canicule, comment l’arbitrage entre les usages des entreprises et ceux des citoyens sera-t-il organisé ?

Chez Next, on essaie d’aborder l’intelligence artificielle en gardant ce type de questions en tête. On s’interroge aussi sur l’utilité des technologies que l’on croise avant de s’y attarder. Notre problème, évidemment, est qu’il est matériellement impossible de traiter la totalité des applications concrètes de l’IA. Chaque jour, il nous faut donc faire des choix.

Et vous, comment voudriez-vous entendre parler d’intelligence artificielle ?

Commentaires (40)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousLe 03/06/2024 à 14h58

Le 03/06/2024 à 17h32

C'est moins grand-public, mais le machine learning est massivement utilisé en science et les réseaux de neurones ont pas mal percé.

Le 03/06/2024 à 14h58

Modifié le 03/06/2024 à 15h24

Je rejoins wagaf, j'aimerais des articles moins polarisés, plus orientés techniques, impact sociétal réel et non fantasmé (quid des programmes des écoles en informatique ou des cursus de maths ?), etc. Il y a déjà pas mal de choses comme cet édito, les penses-bêtes entre autres mais j'ai quand même l'impression que Next a pris une posture critique systématique avec une sorte de repli idéologique selon lequel l'IA "çaymal" ou "çaybullshit". Peut-être par réflexe épidermique face au déluge d'articles dopés à l'IA d'une façon (aide à la rédaction) ou d'une autre (buzz word).

Le 03/06/2024 à 15h27

Le 03/06/2024 à 15h51

.. et encore, ça simplifie trop. Je trouve qu'à trop vouloir dire "ils aiment / aiment pas" on en vient à ruiner la complexité du sujet à la fois dans son côté technique et dans la façon dont un média comme Next le traite. Les articles sont pas nécessairement tous à charge ni trop à charge, il y a une variété de points de vue que justement il y a pas dans un journal ou une chaine télé dites "d'opinion".

Modifié le 03/06/2024 à 16h30

J'aimerais aussi quelques articles plus axés sur l'aspect technique (ou + des tutos pour utiliser les modèles qui fonctionnent en local ?), mais force est de reconnaître que ça demande un investissement colossal niveau temps & connaissances, et que, comme cité dans l'article, ça pourrait aussi participer à la hype aveugle, sans prendre le recul pour juger ça à l'échelle médiatique ou à l'échelle de la société.

Pour le coup, je n'y vois aucun « repli » ni jugement manichéen. Heureusement que Next avait cette même posture à l'époque des NFT ou du Métavers, qu'on a pas été inondés d'articles sur « comment ça marche » ni un article qui en ferait les louanges pour chaque article qui en faisait la critique.

Perso, cet édito me parle beaucoup, d'autant qu'il y a quelque jours, on m'a partagé une vidéo de MiCode qui me paraît aller directement dans cette direction : un acteur médiatique qui se fait le pur relai publicitaire des « Big Tech », qui pousse le buzz, et participe à donner une image « cool » et « incroyable » de ces nouveaux outils et des entreprises qui sont derrières.

Le 03/06/2024 à 18h57

À choisir je préfère une position de principe peut-être un peu méfiante, mais qui au moins fait un pas de côté par rapport à la communication hypée à l'extrême de l'industrie, qu'une position enthousiaste au possible... non parce que si c'est pour dire "c'est trop génial" j'ai pas besoin d'un organe de presse : OpenAI, Meta, Mistral et autres font déjà ça très bien.

Surtout qu'au final il y a à redire sur ce GPT4o, pas du tout aussi dinguissime qu'affirmé. Et ça fait partie du job d'un canard pour moi, de me prévenir quand on essaye de me survendre un service, qu'il soit gratuit (c'est moi le produit) ou payant.

Le 03/06/2024 à 15h26

Mais jamais rien de technique, même sur NXI je n'ai pas vu d'article très poussé sur le fonctionnement de ces IA génératives, leurs points forts, leurs points faibles, mais j'ai peut-être râté :)

Le 03/06/2024 à 15h48

Mais moi non plus, je ne me souviens pas d'articles expliquant le fonctionnement de GPT ou de la génération d'image. J'avais proposé à Next une vulgarisation du fonctionnement de GPT et Stable Diffusion, avec un retour d'expérience sur l'usage, mais j'ai jamais eu de retour.

Le 03/06/2024 à 16h21

C'est vraiment un aspect qui est peu couvert dans la presse en général à mon avis, alors qu'on dépend beaucoup trop de services en lignes contrôlés par OpenIA, Microsoft et Google.

Le 03/06/2024 à 16h30

Concernant ton dernier point : Mixtral est dispo chez Infomaniak, un hébergeur suisse qui a un fort engagement en matière de vie privée mais aussi environnement. Mangez-en ! Perso, depuis qu'ils ont intégré ce LLM, je n'utilise plus ChatGPT.

Le 03/06/2024 à 17h40

Pourquoi pas une interview des personnes derrière Mistral AI etc.

Le 03/06/2024 à 16h29

Le 03/06/2024 à 16h35

Même si en soi les paramètres des modèles bougent pas trop (CFG, Steps, etc), avec depuis SD Turbo et compagnie c'est plus varié. Perso je me contente de rester sur du SDXL malgré la durée plus longue de génération (et ça réchauffe les doigts de pieds). Turbo c'est bluffant pour la vitesse d'output, mais les résultats m'ont souvent déçu. Ou alors j'ai pas su m'en servir correctement.

Sinon, expliquer le concept même de Stable Diffusion, de l'espace latent, le VAE, les Schedulers, ControlNet, LoRA, toussa, c'est plutôt pérenne dans le temps je pense. Au même titre que la mécanique de GPT ne semble pas trop changer.

Le 03/06/2024 à 16h44

J'utilise celui de automatic1111, mais purée ce que c'est pas clair, sans parler du choix du machin qui s'appelle euler, latent, sdchaipasquoi, c'est pas intuitif XD

Modifié le 03/06/2024 à 18h20

Après oui, les params restent cryptiques pour des non initiés. Généralement je me base sur les reco du modèle pour le scheduler et le reste.

Le 03/06/2024 à 18h44

Automatic1111 est un peu aride pour les débutants (et y a pire... ne regarde jamais ComfyUI tu vas faire une syncope). En plus le système de file d'attente d'EasyDiffusion permet d'essayer plein de paramètres très rapidement, puis de laisser le PC mouliner tranquillement tes différents essais pendant que tu fais autre chose. La dernière fois que j'ai regardé, Automatic1111 ne proposait toujours pas ça.

Le 03/06/2024 à 18h46

Modifié le 03/06/2024 à 20h03

J'utilise une ancienne config de jeu basée sur un i5 de 2016 + 21GB de RAM et une 1080GTX avec 8GB de VRAM.

En ce qui me concerne, quand j'ai commencé avec SD 1.0 il me fallait 10min pour une image l'année dernière. SDXL a un ratio perf/rapidité qui me convient sur ma machine.

Je génère mes images à environ 800x1200 car je l'utilise principalement pour créer les couvertures de mes livres, mais aussi pour générer des scènes afin de m'inspirer (auquel cas l'alterne entre portrait et paysage). Dans tous les cas, SDXL travaille nativement en 1024x1024. Cela ne sert pas à grand chose de générer plus gros, autant profiter de l'excellent upscaling que l'IA peut faire ensuite. C'est ce que je fais pour passer ensuite en haute résolution mes couvertures, certains sites exigeant un format de 1200px de large minimum.

Le 03/06/2024 à 15h12

L'intelligence ce n'est pas simplement avoir acquis une somme considérable de connaissances. C'est savoir quoi en faire en faisant preuve de bon sens, d'analyse, de morale, de jugement.

Ou alors, on oublie trop souvent le terme qui vient après : artificielle...

Le 03/06/2024 à 16h10

Le 03/06/2024 à 16h26

La définition même d'intelligence n'est pas clairement arrêtée et reste sujette à débat entre la vision scientifique et celle philosophique. À partir de là, difficile de dire si ces outils sont intelligents ou non. Typiquement, il y a des populations pour qui un chien n'est pas intelligent alors que ces animaux sont bien doués d'une capacité d'apprentissage et de réflexion. Limitée, mais bel et bien présente.

Le 04/06/2024 à 11h22

Le 05/06/2024 à 21h36

Modifié le 04/06/2024 à 07h02

Si ont retenait le sens américain de "renseignement, collecte de données stratégiques" (celui de C.I.A.), on serait beaucoup plus proche de la réalité.

Le 04/06/2024 à 10h15

Modifié le 04/06/2024 à 11h19

Donc non, ce n'est pas une question de faux ami.

Modifié le 03/06/2024 à 15h55

Et si on parlait (plus/ mieux/ à leur juste valeur) de :

- La science derrière tout ça

- le nouvel esclavage des milliers de gens nécessaires pour corriger toute les bêtises que sort l'IA

- du caractère obligatoirement bullshitteux de l'intégration à marche forcé de l'IA dans toutes les boites qui veulent pas passer à côté d'un truc ?

- des 95% des usages actuels de l'iA qui sont mieux faits par des algo plus standards ou des humains

- du l'impact sociétal sur une société qui s'individualise déjà trop et à qui tu donnes du "Her" comme si c'était une bonne chose.

etc... (des licenciement en masse dans certains secteurs, du SEO de google qui amène à utiliser des IAs pour générer des sites pourris par milions...)

Oui bien sûr certaines publications font ressortir ça mais une toute petite minorité. Tout ce que font Gebru/Mitchell/Bender/Buolamwini (et d'autres bien entendu...) a tellement besoin d'être au coeur de nos discussions sur l'IA. Perso, savoir que c'est ChatGPT qui récolte le plus d'article de presse loin devant les autres, ça m'intéresse pas. Savoir que les kényan payés 2€/h partent en masse en burnout traumatisme, etc... ça me parait plus intéressant.

Le 03/06/2024 à 17h50

Commence par prendre une petite camomille (ou une verveine) et revient quand tu sera calmé.

Le 03/06/2024 à 18h05

C'est justement le rôle du contre-balancier. d'apporter de la nuance quand l’hégémonie est hyper orientée. Pour ça faut prendre un peu de recul.

ah et puis faut apprendre à lire tous les mots aussi. "Il faut parler plus, mieux, à sa juste valeur de..." ça veut exactement dire ce que la langue française a l'air de vouloir dire ... Que oui on en parle déjà mais mal, pas assez, etc... bref c'est de la nuance.

Le 03/06/2024 à 21h13

Mais c'est tellement ça...

Modifié le 03/06/2024 à 16h53

Melanie Mitchell, Artificial Intelligence: A Guide for Thinking Humans

(Google traduction) « Nous devrions avoir peur. Non pas des machines intelligentes. Mais des machines qui prennent des décisions qu’elles n’ont pas l’intelligence de prendre. J’ai bien plus peur de la stupidité des machines que de leur intelligence. La stupidité des machines crée un risque extrême. Les machines peuvent prendre de très nombreuses bonnes décisions, puis un jour échouer de manière spectaculaire à cause d’un événement extrême qui n’apparaît pas dans leurs données d’entraînement. C’est la différence entre l’intelligence spécifique et l’intelligence générale. »

Melanie Mitchell – Intelligence artificielle : Triomphes et déceptions

Le 03/06/2024 à 22h49

Modifié le 04/06/2024 à 01h52

Mais son prompt semble problématique, car il semble prendre pour acquis que GPT4 connait les possibilités de l'IA générative, ses limites et ses possibilités futures.

Partie du prompt en question:Du coup, l'étude se limite à connecter la base de données des taches métier O*NET à GPT4 et lui demander ce qu'il en pense.

Ça fait furieusement penser à une tache qui pourrait être automatisée par GPT4 tout ça

Le 04/06/2024 à 00h26

Le 04/06/2024 à 06h59

Modifié le 04/06/2024 à 10h29

Edit : clarification de ma pensée par l'ajout "concurrence entre usages"

Le 11/06/2024 à 01h32

Le 11/06/2024 à 10h17