NVIDIA annonce ses GeForce RTX 50 dès 649 euros : « + 1 » et « x2 », en résumé

Oui, ça fait tourner Doom en 480p !

C’était attendu : NVIDIA profite du CES de Las Vegas pour lancer sa nouvelle gamme de cartes graphiques RTX 50 (Blackwell). On retrouve quatre modèles pour les ordinateurs de bureau et quatre autres pour les portables. La disponibilité débutera le 30 janvier pour les RTX 5080 et 5090, puis continuera en février et mars… un nouveau cycle d’annonce débutera alors avec la GTC 2025.

Le 07 janvier à 13h26

6 min

Hardware

Hardware

Le fabricant a déjà présenté cette architecture Blackwell lors de sa GTC en mars 2024, avec son GPU B200 pour l’intelligence artificielle dans les datacenters. Les RTX de la série 50 utilisent une variante de Blackwell, comprenant 92 milliards de transistors contre 76 milliards pour le GPU des RTX 40 et 2x 104 milliards pour le B200. Ce dernier exploite pour rappel deux dies sur une même puce.

Tensor, Ray Tracing, PCIe, GDDR… : les RTX 50 font « + 1 »

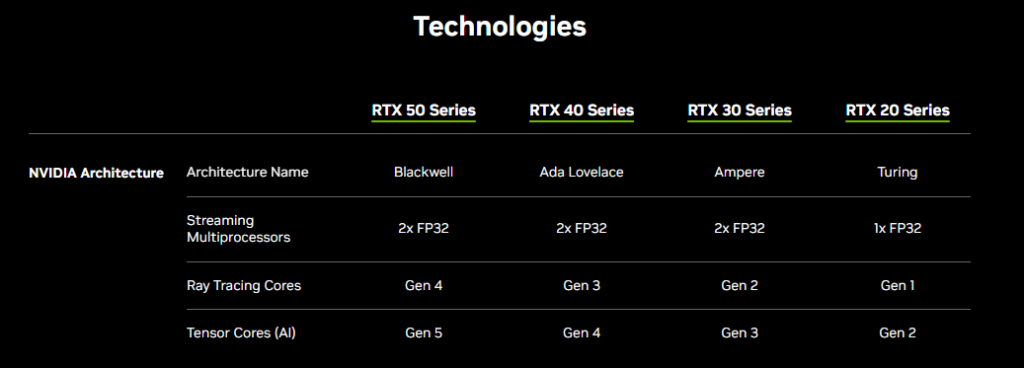

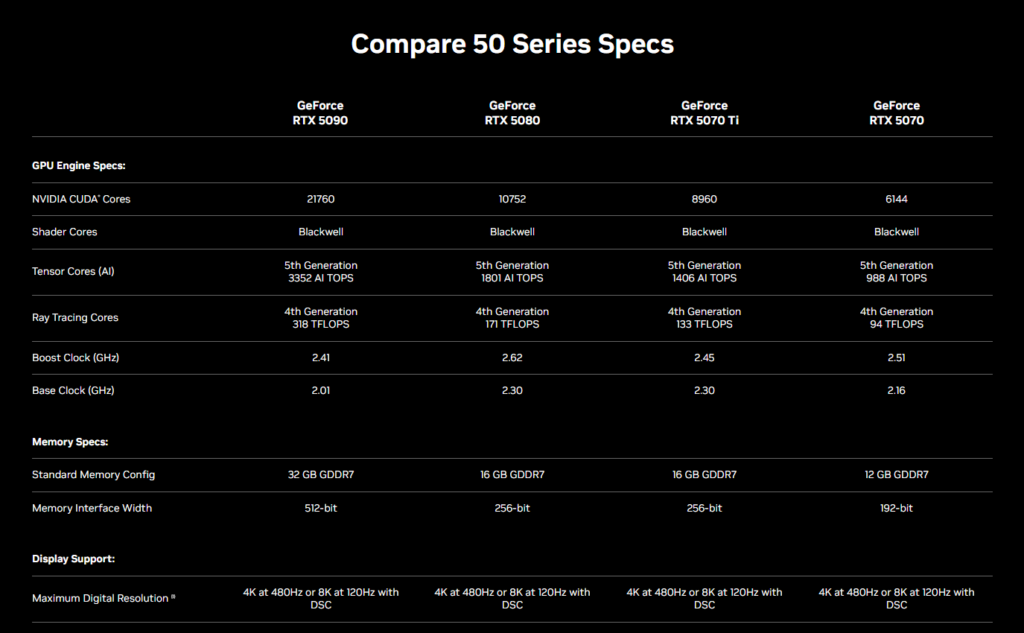

Quoi qu’il en soit, quatre modèles de RTX 50 sont annoncés pour commencer : les RTX 5070, 5070 Ti, 5080 et 5090. Dans les grandes lignes, les générations des différentes technologies font « + 1 » par rapport à la série RTX 40.

Le fabricant propose un tableau récapitulatif sur cette page, avec la même chose pour les RTX des générations précédentes.

Suivant les modèles, le nombre de CUDA Cores varie entre 6 144 et 21 760, avec une fréquence en mode Boost de 2,41 à 2,62 GHz. NVIDIA insiste sur les performances de la GDDR7 capable de monter jusqu’à 1 792 Go/s sur la RTX 5090, contre 1 008 Go/s sur la RTX 4090 en GDDR6x. La sortie vidéo DisplayPort 2.1b UHBR20 permet d’avoir du 8K à 165 Hz.

Les nouvelles RTX 50 exploitent ainsi des Ray Tracing Cores de 4ᵉ génération, des Tensor Cores pour l’IA de 5ᵉ génération (avec prise en charge du FP4), le PCIe 5.0, un encodeur NVENC de 9ᵉ génération, un décodeur NVDEC de 6e génération, le DLSS 4, de la GDDR7, etc. Sur les RTX 40 nous avions des RT Cores de 3ᵉ génération, des Tensors Cores de 4ᵉ génération, du PCIe 4.0, etc.

Au sujet des Ray Tracing Cores de 4e génération, NVIDIA annonce « un taux d'intersection entre un rayon et un triangle deux fois supérieur à celui de la génération précédente et une compression améliorée afin de réduire l'empreinte mémoire ».

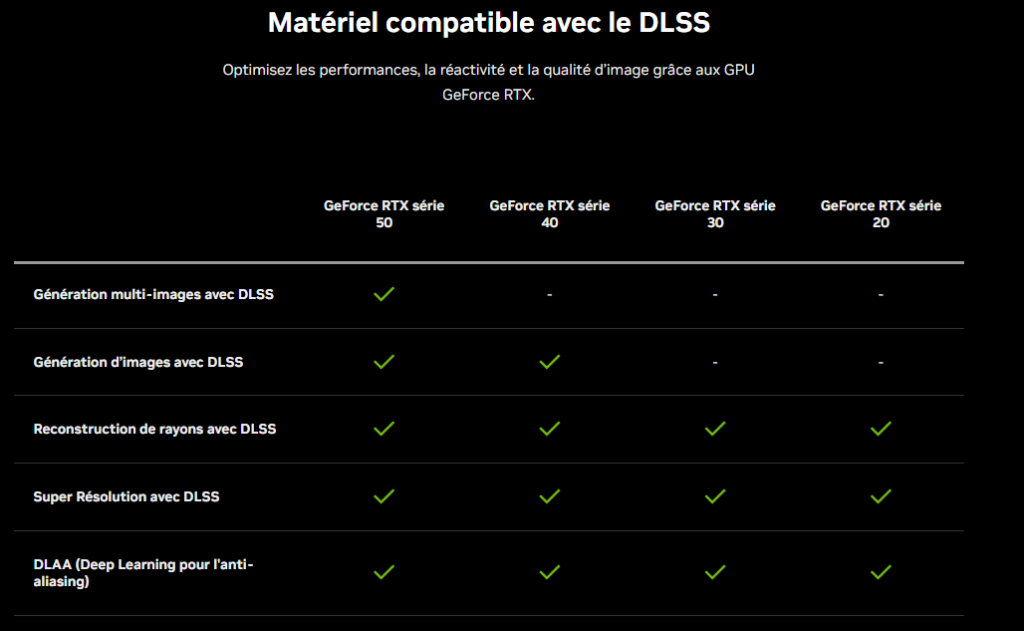

Voici DLSS 4 avec génération multi-images et Reflex 2

Un billet de blog dédié revient sur le fonctionnement et les performances de DLSS 4. Selon NVIDIA, cette version représente « la plus grande mise à niveau de ses modèles d'IA depuis la sortie de DLSS 2.0 en 2020 ». La génération multi-images avec DLSS (une exclusivité des RTX 50) « accélère la fréquence d’images en faisant appel à l’IA pour générer jusqu’à trois images par trame à afficher », explique NVIDIA

À titre d’exemple, NVIDIA affirme que sur la GeForce RTX 5090, « DLSS 4 avec Multi Frame Generation [génération multi-images dans la langue de Molière, ndlr] multiplie les performances par plus de 8X par rapport au rendu traditionnel dans cette scène Cyberpunk 2077 ».

NVIDIA en profite pour présenter Reflex 2 pour baisser la latence jusqu’à 75 %, contre 50 % avec Reflex de première génération, grâce à la technologie Frame Warp, « qui réduit encore davantage la latence en fonction du dernier clic de souris ».

Cette fonctionnalité arrivera prochainement, mais ne sera pas une exclusivité des RTX 50, on la retrouvera aussi sur les RTX 40, RTX 30 et RTX 20.

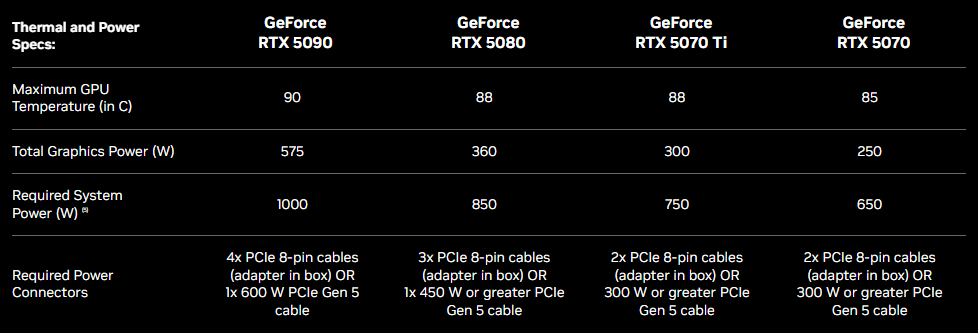

Alimentation requise de 650 à 1 000 watts

La consommation des GPU (Total Graphics Power) est de 575 watts pour la RTX 5090, 360 watts pour la RTX 5080, 300 watts pour la RTX 5070 Ti et enfin 250 watts pour la RTX 5070.

Côté alimentation, il faudra une puissance de 1 000 watts pour la RTX 5090 selon NVIDIA. On passe à 850 watts pour la RTX 5080, puis 750 watts pour la RTX 5070 Ti et enfin 650 watts pour la RTX 5070 de base.

Prévoyez quatre câbles d’alimentation PCIe à 8 broches ou un cable PCIe Gen 5 de 600 watts pour la RTX 5090, contre deux câbles 8 broches ou un PCIe Gen 5 de 300 watts pour les RTX 5070 Ti).

RTX 50 vs RTX 40 : les performances font « x2 »

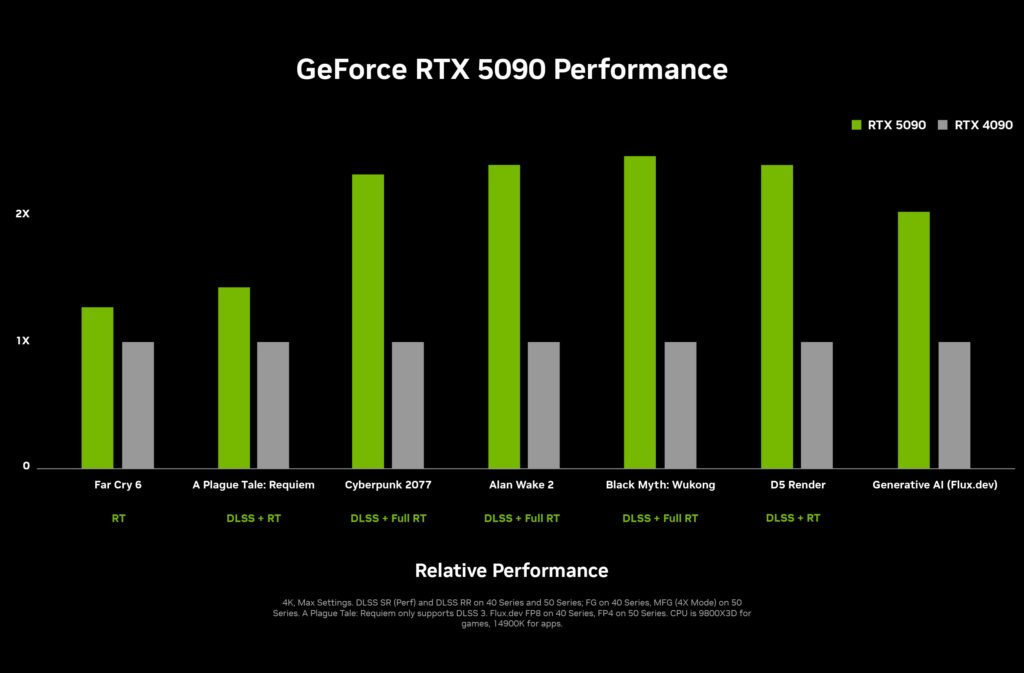

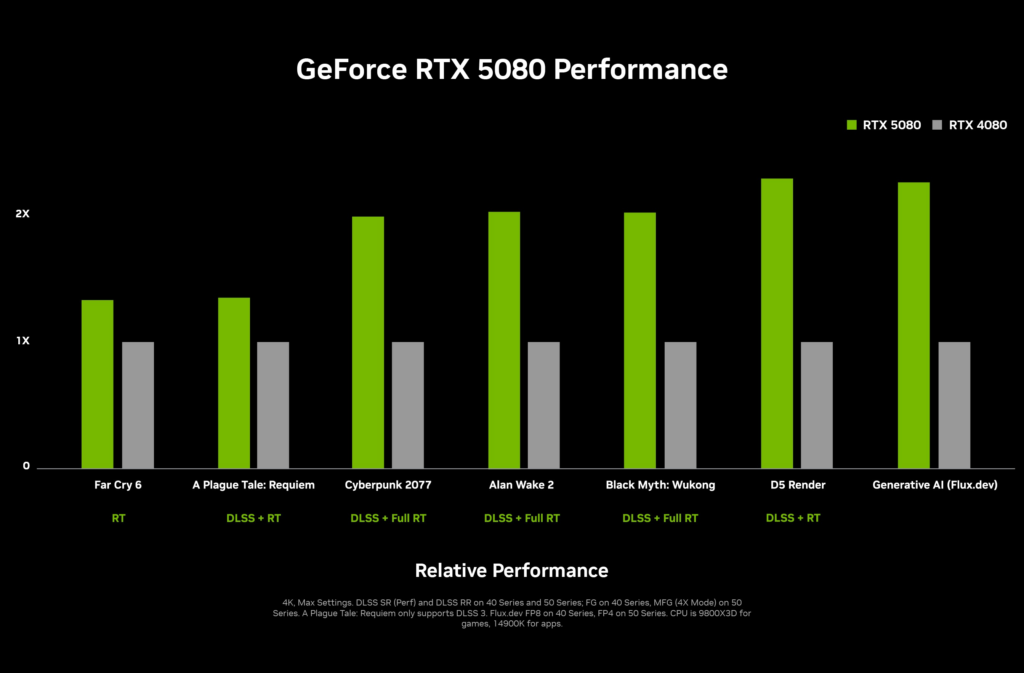

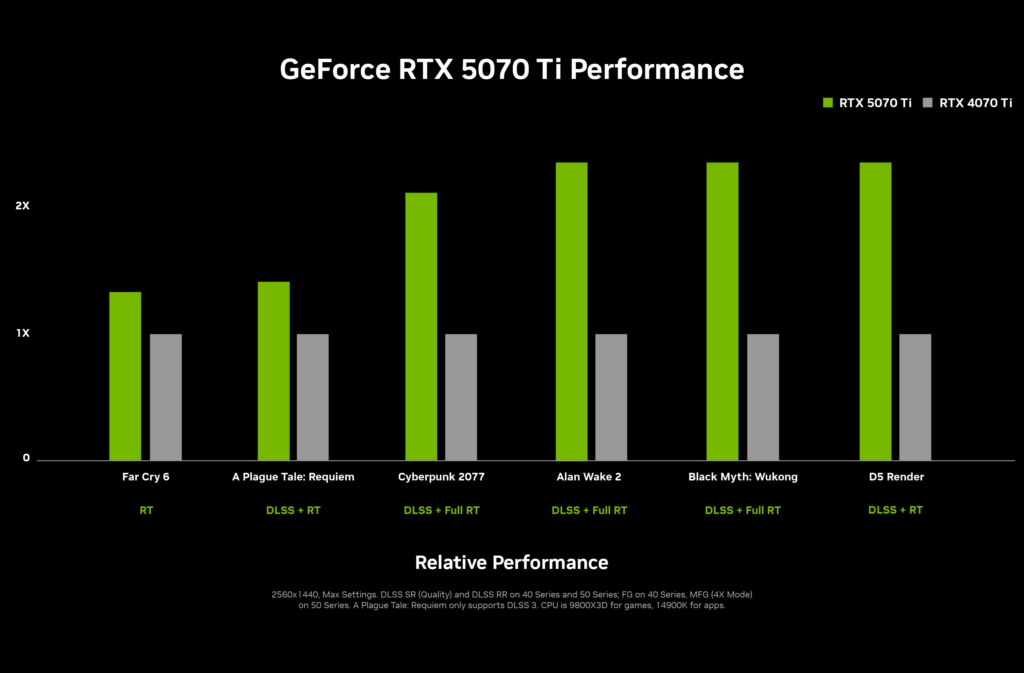

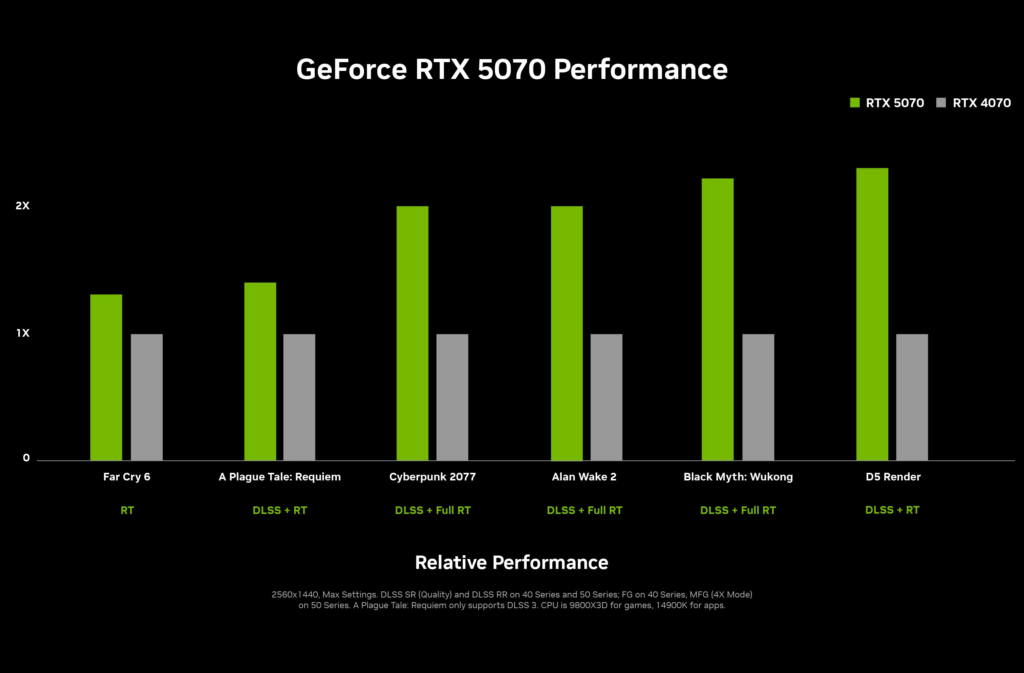

NVIDIA annonce que sa GeForce RTX 5090 est « deux fois plus rapide que la GeForce RTX 4090 », une promesse que l’on retrouve aussi sur la RTX 5080 par rapport à la RTX 4080, ainsi que les RTX 5070 (Ti) vs les RTX 4070 (Ti).

Le fabricant propose de nombreux graphiques sur des tests maison par ici. Un rapide coup d’œil permet de se rendre compte qu’il ne faut pas prendre ces performances doublées comme une promesse formelle mais plutôt comme le cas de figure optimal.

Les RTX 5080 et 5090 seront disponibles le 30 janvier

Des Founders Edition (cartes maison de NVIDIA) seront proposées pour l’ensemble des versions, sauf la RTX 5070 Ti. La RTX 5090 est annoncée à 1 999 dollars ou 2 349 euros avec une disponibilité au 30 janvier, alors que la RTX 4090 était à 1 599 dollars (1 949 euros) lors de son lancement.

La version Founders Edition de la RTX 5090 mesure 304 x 137 mm et occupe deux emplacements PCIe (contre trois pour la RTX 4090). Elle est « SFF-Ready », SFF pour Small Form Factor. Cette certification a été lancée au Computex de l’année dernière et permet d’assurer une compatibilité entre des cartes graphiques et des boitiers SFF.

La RTX 5080 sera vendue 999 dollars ou 1 179 euros, à partir du 30 janvier également. Les dimensions de la Founders Edition sont les mêmes que celles de la RTX 5090, avec donc la certification SFF.

Il faudra attendre le mois de février pour les RTX 5070 et 5070 Ti, qui seront respectivement proposées à partir de 549 et 749 dollars, ou 649 et 884 euros selon le site français de NVIDIA. La RTX 5070 Founder Edition mesure 242 x 112 mm et occupe également deux emplacements.

Bien sûr, les nombreux partenaires de NVIDIA ne vont pas se priver de proposer des modèles maison avec des ventirads plus ou moins extravagants et de l’overclocking plus ou moins marqué. La valse des annonces a d’ailleurs déjà débutée. TechPowerUp reprend les communiqués des fabricants à ce sujet.

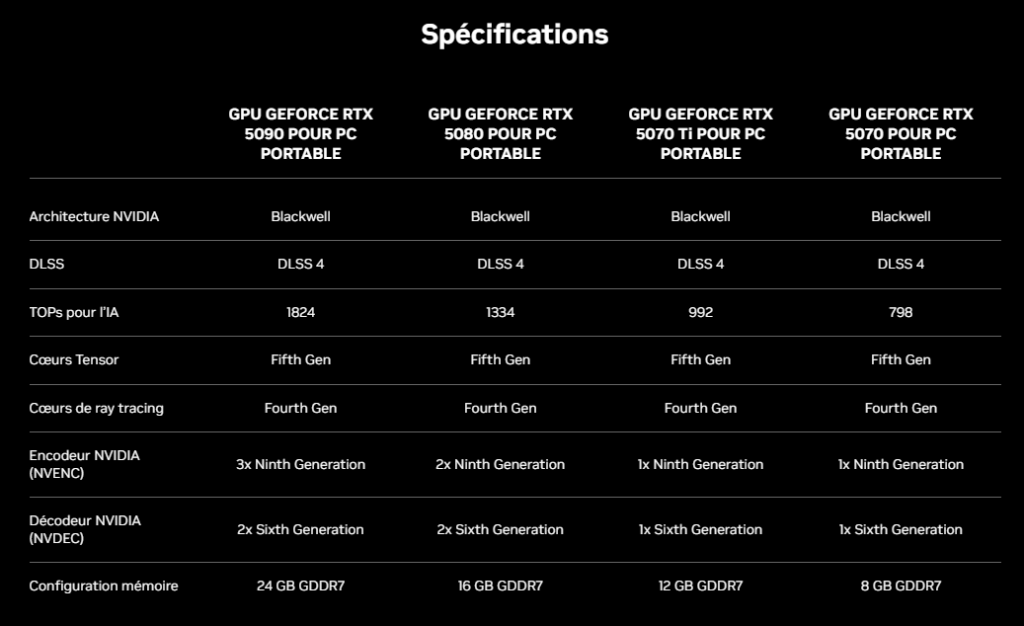

Quatre RTX 50 pour les ordinateurs portables en mars

Sur les ordinateurs portables, NVIDIA annonce aussi des RTX 50, et explique que sa technologie Max-Q profite de nouvelles fonctionnalités comme l’Advanced Power Gating, le Low Latency Sleep et l’Accelerated Frequency Switching qui « augmentent la durée de vie de la batterie jusqu'à 40 % par rapport à la génération précédente ».

On retrouve une RTX 5090 avec 10 496 CUDA Cores et une puissance de calcul de 1 824 TOPS pour l’IA, avec 24 Go de GDDR7. Avec la RTX 5080 on passe à respectivement 7 680 CUDA cores, 1 334 TOPS et 16 Go de GDDR7.

Deux GeForce RTX 5070 complètent là aussi la gamme. La RTX 5070 Ti avec 5 888 CUDA cores, 992 TOPS, et 12 Go de GDDR7 ainsi que la RTX 5070 avec 4 608 CUDA cores, 798 TOPS et 8 Go de GDDR7. Il faudra faire attention aux fréquences qui varient suivant les modèles d’ordinateur portable et des performances de son système de refroidissement.

Toutes les puces mobiles de la série RTX 50 seront disponibles en mars.

NVIDIA annonce ses GeForce RTX 50 dès 649 euros : « + 1 » et « x2 », en résumé

-

Tensor, Ray Tracing, PCIe, GDDR… : les RTX 50 font « + 1 »

-

Voici DLSS 4 avec génération multi-images et Reflex 2

-

Alimentation requise de 650 à 1 000 watts -

RTX 50 vs RTX 40 : les performances font « x2 »

-

Les RTX 5080 et 5090 seront disponibles le 30 janvier

-

Quatre RTX 50 pour les ordinateurs portables en mars

Commentaires (41)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousHier à 13h34

Une 4090 pour le prix d'une 5070, c'est une affaire très intéressante

Hier à 14h04

Hier à 14h37

Les perf sont toujours au top sur les powerpoint de présentation.

Reste aussi à voir le vrai prix de vente sur le marché, ça fait longtemps qu'on a pas vu de cartes aux prix annoncé.

Hier à 17h31

Hier à 22h32

Aujourd'hui à 10h01

Hier à 13h44

Et pis comme d'hab', il va falloir s'attendre à du DLSS4 que pour les RTX50, maintenu que pendant quelques années, compatible qu'avec Windows, etc ... et tout ça pour 400€ de plus. Mais à plus de 2000€ le bout, finalement, ça ne fait que 20% d'augmentation.

Hier à 19h56

C'est uniquement la génération d'images double qui est exclue avec les RTX 40 et maintenant la génération d'images x3x4 qui l'est avec les RTX 50. Il y a une image dans l'article qui résume bien.

Pour le coup ce que fait Nvidia avec le DLSS depuis le début est plutôt honnête, mais le nom donné aux versions est trompeur et fait penser à de nombreuses personnes que le DLSS 2 est pour les 20-30 ; le DLSS 3 pour les 40 et maintenant le DLSS 4 pour les 50. C'est juste une fonction qui s'ajoute à chaque génération tout en continuant à améliorer les autres fonctions pour tout le monde.

Aujourd'hui à 11h47

Hier à 13h52

Hier à 14h21

Hier à 14h43

Modifié le 07/01/2025 à 15h41

Puissance à laquelle il faut rajouter celle du CPU (compter 500W maximum). Rajouter quelques Watts pour les ventilos, LED, pompe à eau (si applicable), le facteur d'efficacité de l'alim + un petit coefficient de sécurité. On va y arriver à l'alim de 2000 W. Je vais pouvoir retirer le radiateur de mon bureau.

Aujourd'hui à 09h40

Il faut croire qu'une alim de qualité n'aura pas de souci même lors d'un pic.

Hier à 20h49

Cela me laisse à penser que la courbe perf/puissance est quand même plus efficiente de nos jours.

Hier à 13h57

A quand une gamme 200$-300$ du genre Intel Arc Battlemage...

Hier à 14h15

Modifié le 07/01/2025 à 14h28

Et le Battlemage est une déception. Il faut le meilleur CPU gaming actuel (9800X3D) pour espérer l'utiliser à pleine puissance. En deça, les FPS tombent si vite qu'il se retrouve à la ramasse contre une 4060 ou une 7600 qui lui seront préférables, surtout vu les prix en Europe où il est plus cher que les deux derniers.

Hier à 16h40

Hier à 17h23

Bref de quoi faire tourner un jeu récent en mode "joli" mais seulement en 1080p@60hz.

J'ai l'impression que ce milieu de gamme n'existe plus. Si tu veux les dernières nouveautés en terme de rendu graphique, c'est forcément un monstre pour le faire en 4K@240hz

Modifié le 07/01/2025 à 20h55

extrémement consprêts à payer une fortune pour un ordi, donc c'est à eux que les constructeurs s'adressent maintenant.Intel est limite une anomalie... encore que, car ils ont prôné le 1440p pour leur Battlemage montrant même des scores parfois supérieurs à ce qu'il fait en 1080p à la surprise des testeurs. Certaines langues diront qu'ils savaient pour le problème avec les CPU moyen/bas de gamme et c'est pourquoi ils prônaient cette résolution, mais je n'ai pas vu de tests qui aurait vérifié cette idée.

Hier à 16h58

les pauvres vont chez amd

Modifié le 07/01/2025 à 20h57

Aujourd'hui à 10h49

La CG Nvidia ou ATI moyenne/haute gamme à 3 ou 400€, la carte mère Asus premium à 100€, 1GB, voire 2 (

Et un mois après, il revient avec la CG qui a cramé.

Hier à 14h31

Hier à 14h55

Hier à 15h07

Je passe mon tour.

Modifié le 07/01/2025 à 15h26

Nvidia a bien compris la leçon de la 1080 TI et ses 11 Go bien trop tôt. Jensen doit encore faire des cauchemars chaque nuit où il voit des joueurs lui dire qu'ils n'ont toujours pas envie d'acheter une 30XX ou 40XX car leur 1080 TI est encore très bon pour leurs jeux.

Il ne recommencera jamais cette erreur, donc... sors ton portefeuille.

Hier à 16h46

Hier à 16h47

Hier à 18h31

Hier à 15h26

Hier à 17h00

blague à part ils ont mis une chambre à vapeur et les 2 ventilos serait en traversant le PCB est ultra petit d'après la vue en coupe

Hier à 15h41

Hier à 17h02

Hier à 16h22

Enfin, si c'est possible d'avoir une version Foundation, car en général, elles partent en 30 secondes, et les versions constructeurs sont 50% plus chère -_-

Hier à 18h42

Perso, je me suis engagé dans l'exacte inverse : baisser la conso de tout mon matos info, rationaliser le nombre d'appareils... quand tu as des factures de 200 balles et + en fin de mois, ça commence à piquer sévère

Ça fait 10 ans que j'ai une alim de 600W et j'adapte en fonction mes composants pour pas dépasser quitte à sacrifier certains aspects.

Modifié le 07/01/2025 à 21h51

Ce qui n'empêche pas de vouloir baisser

A ce stade je n'attends plus d'optimisation de la part des constructeurs, il va falloir s'habituer aux ± 300 W, que l'on tentera de compenser par undervolt.

Hier à 23h54

Et en plus, il faut considérer que ce surcout est gratuit l'hiver, car 99,99% de chaque W consommé par la CG est rejeté en chaleur, et donc diminue d'autant le nombre de W nécessaire à ton chauffage pour te chauffer.

Donc au final, le surcout est plutôt de 4,5€ à l'année pour 2h de gaming 7j/7 avec GPU à 100%.

Modifié le 08/01/2025 à 11h14

Limiter les FPS aura bien plus d'inpact sur la conso. Du moment que tu capes au taux de rafraichissement de ton écran (voire plus bas si ton écran a un taux très élevé, pas besoin de 240 fps dans l'immense majorité des cas), et que 2 cartes NVIDIA de générations différentes atteignent ce framerate à la même résolution, alors la plus récente consommera généralement moins.

Pour un usage "normal" (aka pas de minage ou IA), il faut aussi tenir compte de la consommation en idle, parce qu'au final, une carte qui consomme moins en charge, mais 2 fois plus en idle, coutera plus cher en électricité à la fin si on ne joue pas 10h/jour. Et là pour le coup c'est plus aléatoire et rester sur une ancienne carte peut être plus rentable.

Et il y a plein d'autres facteurs qui jouent. La gourmandise du jeu, le pourcentage d'occupation GPU, la config du GPU (par exemple ma 3090 underclockée consomme et chauffe beaucoup moins, -80W, plus de coil wine, et +5% de perfs, oui c'est contre intuitif mais c'est comme ça que fonctionne cette gen, et au passage, jamais dépassé 550W en benchmark et moins en jeu avec 3090 underclockée + i5 13600K@stock)...

Sur le plan purement financier, il y a l'option Tempo d'EDF à considérer, le kWh peut être aussi "bas" que 13 cts, et max 19 cts en dehors des heures pleines des 22 jours rouges (donc faut éviter le chauffage électrique à ce moment là).

Et au final, c'est se prendre la tête pour pas grand chose, la différence au bout du bout n'ira jamais chercher bien loin, à moins de jouer à des jeux super gourmands 12h tous les jours rouge Tempo (75 cts/kWh :)). Vaut mieux bien choisir son frigo et sa TV, les économies seront plus franches.

Aujourd'hui à 12h38