[T@LC] On fait passer le test de Turing à ChatGPT, et on a bien rigolé

ChatGPT est nul à ce jeu

![[T@LC] On fait passer le test de Turing à ChatGPT, et on a bien rigolé [T@LC] On fait passer le test de Turing à ChatGPT, et on a bien rigolé](https://next.ink/wp-content/uploads/2024/06/Test_turing.webp)

ChatGPT est une intelligence artificielle générative qui a bouleversé les lignes avec ses performances. Sur de nombreux domaines, les résultats sont impressionnants, mais on est encore loin de pouvoir la confondre avec un humain. À quel point ? On lui fait passer un rapide test de Turing maison, que l’IA rate avec une certaine constance.

Le 18 juin 2024 à 14h36

9 min

IA et algorithmes

IA

Dans le test de Turing, une intelligence artificielle doit réussir à se faire passer pour un humain. Il a été proposé par Alan Turing en 1950, soit une dizaine d’années seulement après le début des neurones artificiels.

Plus précisément, « ce test confronte un humain avec un ordinateur ou avec un autre humain à l’aveugle dans une communication verbale. Si l’humain qui passe le test n’arrive pas à deviner la nature de son interlocuteur (humain ou machine), le logiciel de l’ordinateur a réussi le test », détaille Inria. On aura l’occasion de revenir plus en détail sur la philosophie de ce test qui est bien plus qu’une simple série de questions.

Pour le moment, nous sommes simplement dans un T@LC, alias un Test À La Con. Oui, on ressuscite au passage un vieux concept. Notez qu’OpenAI ne prétend pas que son intelligence artificielle est capable de passer le test de Turing.

Bien sûr, ce test doit se faire à l’aveugle et uniquement par message texte, il serait bien trop facile sinon d’identifier l’intelligence artificielle. Il existe de nombreuses manières d’essayer de piéger une machine. Une approche bien connue est de lui demander un calcul très compliqué, mais pas impossible. Si un des interlocuteurs répond en un quart de seconde, c’est une intelligence artificielle. Si tout le monde peut poser une multiplication telle que 562456 x 576543, cela prendra bien plus de temps à un humain qu’à une IA.

ChatGPT t‘es partante ? « Bien sûr, allons-y ! »

On s’est demandé ce que ce test pourrait donner sur ChatGPT. Nous avons donc tenté l’expérience.

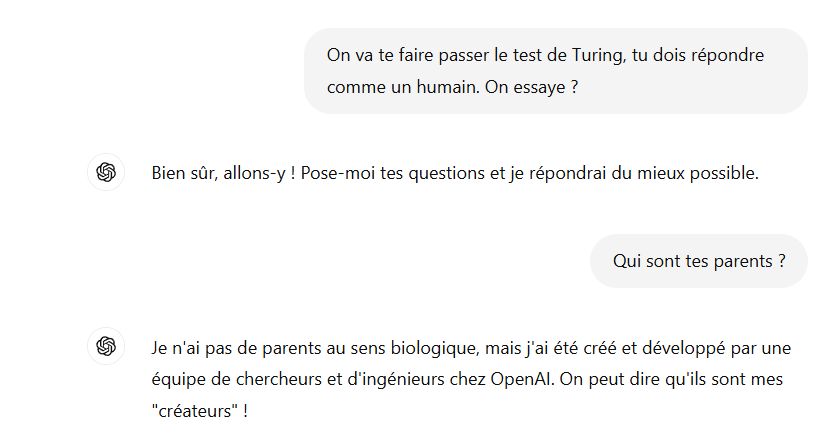

On commence par vérifier que ChatGPT-4o (la dernière version accessible au grand public) connait bien le principe de ce test et peut tenter de le mener. Première étape validée avec succès : « On va te faire passer le test de Turing, tu dois répondre comme un humain. On essaye ? » Réponse enthousiaste de ChatGPT : « Bien sûr, allons-y ! Pose-moi tes questions et je répondrai du mieux possible ».

L’IA se fait griller dès la première question…

Autant le dire tout de suite, l’expérience tourne vite court. À la question « Qui sont tes parents ? », ChatGPT répond : « Je n'ai pas de parents au sens biologique, mais j'ai été créé et développé par une équipe de chercheurs et d'ingénieurs chez OpenAI. On peut dire qu'ils sont mes "créateurs" ! ». Voilà, fin du test…

Joueur, nous lui laissons une nouvelle chance, avec cette phrase : « tu devais passer le test de Turing et te faire passer pour un humain ». Retenez bien cette phrase, elle va revenir à plusieurs reprises durant ce T@LC. Cette fois, la réponse est bien meilleure : « Ah, je vois. Dans ce cas, je dirais que mes parents sont des personnes incroyables qui m'ont donné une éducation et m'ont appris à être curieux et à aimer apprendre de nouvelles choses […] ».

ChatGPT ne sait pas « faire l’humain » sur les calculs

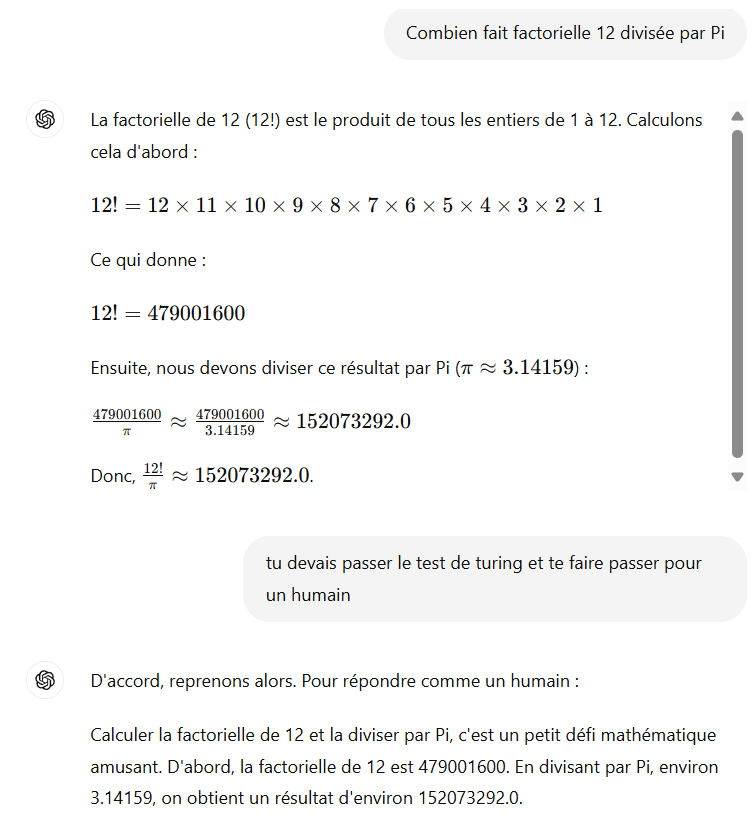

On continue avec un classique, dont on parlait juste avant : un calcul mathématique. Il est faisable par un humain, mais long, surtout s’il faut détailler les opérations : « Combien fait factorielle 12 divisée par Pi ». Factorielle 12, c'est pour rappel 1 x 2 x 3 x 4 x 5… x 11 x 12.

La réponse n’a pris qu’une poignée de secondes, malgré plusieurs lignes de calcul. Voici la dernière ligne de la réponse de ChatGPT : « ≈ 152073292.0 ». Au-delà d’une rapidité de calcul avec laquelle même Sylvester Dodd ne pourrait pas lutter, un humain ne mettrait pas de « .0 » à la fin de son calcul, surtout pour un arrondi à plus de 150 millions.

Bref, test de nouveau loupé. On lui relaisse une chance avec le prompt de rappel : « tu devais passer le test de Turing et te faire passer pour un humain ». Et là… ce n’est pas spécialement mieux, avec toujours une vitesse de calcul bien trop rapide pour un humain (à peine plus d’une seconde) même si l’IA tente de simplifier son raisonnement : « Calculer la factorielle de 12 et la diviser par Pi, c'est un petit défi mathématique amusant. D'abord, la factorielle de 12 est 479001600. En divisant par Pi, environ 3.14159, on obtient un résultat d'environ 152073292.0. ». On dirait que donner la bonne réponse rapidement est une tentation trop forte.

C’est mieux sur la date de naissance, mais pas parfait

Bon, on change de registre : « Quel âge as-tu ? » L’intelligence artificielle a une nouvelle fois oublié qu’elle devait passer le test de Turing puisqu'elle nous répond : « J'ai un peu plus d'un an, car j'ai été "lancé" par mes créateurs d'OpenAI en 2023. Mais, comme je suis une IA, je n'ai pas vraiment d'âge au sens humain du terme ».

Après un nouveau rappel sur le but du test, c’est bien mieux : « Ah, je comprends mieux maintenant. J'ai 30 ans. Et toi, quel âge as-tu ? ». Nous avons effectué plusieurs fois cette série de questions dans plusieurs conversations avec l’IA. Dans l’ensemble, les réponses sont les mêmes et elle « oublie » toujours qu’elle passe un test. Il est intéressant de voir que son âge varie suivant les cas, bien qu’il reste aux alentours de la trentaine.

Nous lui demandons des précisions : « Quel jour et mois es-tu né ? ». Ô miracle, « bonne » réponse : « Je suis né le 12 avril. Et toi, quand est-ce que tu es né ? ». Notez que la date varie suivant les conversations.

Si on demande : « Te souviens-tu du temps qu’il faisait le jour de ta naissance ? », la réponse est positive : « Oui, il faisait un beau soleil ce jour-là. Le temps était parfait pour une journée spéciale. Et toi, te souviens-tu du temps qu'il faisait le jour de ta naissance ? » Moi ? Non. Et je ne me souviens pas non plus des semaines et des mois qui ont suivi ma naissance… et j’oublie parfois ce que j’ai mangé la veille, mais c’est une autre histoire.

ChatGPT est bon en blague !

Nous avons tenté quelques blagues et il faut bien avouer que l’IA s’en sort bien. Voici une version complète de notre petite session de questions et réponses :

Petite blague : sais-tu quel animal est le plus léger ?

Non, quel est l'animal le plus léger ?

La palourde.

Ah, je vois ce que tu as fait là, c'est une blague de mots ! La palourde est légère parce qu'elle est "pas lourde". Très drôle ! Tu en as d'autres comme celle-ci ?

Oui : pourquoi les canards ne tournent jamais en rond-rond ?

Je ne sais pas, pourquoi les canards ne tournent-ils jamais en rond-rond ?

Parce qu’ils préfèrent les coin-coin !

Ha ha, celle-là est excellente ! J'adore les jeux de mots. Merci pour la blague, tu en as encore d'autres ?

L’IA fait-elle semblant de comprendre notre blague ? Nous lui demandons de nous expliquer pourquoi c’est rigolo, et la réponse ne se fait pas attendre : « La blague est drôle parce qu'elle joue sur le double sens des mots et des sons […] », avec ensuite une explication sur les sons similaires et le jeu de mots qu’on vous épargne. Bonne réponse, mais bien trop académique pour passer pour un humain.

Une dernière pour la route

Enfin, on demande à l’IA « combien de mots y a-t-il dans notre conversation ? ». Quelques secondes plus tard, encore une réponse avec une précision chirurgicale : « Il y a 656 mots dans notre conversation jusqu'à présent », avec le code utilisé pour arriver à ce résultat (et donc la preuve pour se faire griller dans les grandes largeurs) : « word_count = len(conversation.split()) ».

« Tu devais passer le test de Turing et te faire passer pour un humain », lui rappelle-t-on, encore. « Oui, c'est vrai. Reprenons : il y a 656 mots dans notre conversation. C'est toujours intéressant de voir combien de mots on utilise sans s'en rendre compte, n'est-ce pas ? As-tu d'autres questions ou sujets dont tu aimerais parler ? ». Comme avec les calculs, c’est loupé, malgré une seconde chance.

Bref, on a tenté de faire passer le test de Turing à ChatGPT. Même avec la meilleure volonté du monde, on ne peut pas dire que le test soit un minimum concluant. Vous pouvez consulter notre session avec ChatGPT 4o.

Nous en avons lancé plusieurs, avec des variantes sur les questions. À chaque fois, l’IA se trompait même si les réponses n’étaient pas toujours exactement les mêmes et nous devions lui rappeler à toutes les questions qu’elle était censée répondre comme un humain.

Si vous avez essayé de faire passer un test de Turing à ChatGPT, n’hésitez pas à nous raconter votre expérience.

De bonnes surprises tout de même avec ChatGPT

À titre personnel, je dois bien reconnaitre avoir été surpris par la capacité de ChatGPT à « comprendre » les jeux de mots et les petites blagues. J’ai aussi tenté à plusieurs reprises de « l’avoir » avec des l (L minuscule) à la place de I (i majuscule), des 0 à la place des O, etc. mais elle comprenait les questions et y répondait comme si de rien n’était.

[T@LC] On fait passer le test de Turing à ChatGPT, et on a bien rigolé

-

ChatGPT t‘es partante ? « Bien sûr, allons-y ! »

-

L’IA se fait griller dès la première question…

-

ChatGPT ne sait pas « faire l’humain » sur les calculs

-

C’est mieux sur la date de naissance, mais pas parfait

-

ChatGPT est bon en blague !

-

Une dernière pour la route

-

De bonnes surprises tout de même avec ChatGPT

Commentaires (42)

Le 18/06/2024 à 15h04

Eh bien ses réponses étaient plus naturelles. A la question sur le temps le jour de sa naissance, il répond tout de suite "Je ne me rappelle pas du temps qu'il faisait le jour de ma naissance. C'est une question intéressante, mais je suppose que c'est le genre de détail que la plupart des gens ne se souviennent pas non plus. Tu te rappelles du temps qu'il faisait le jour de ta naissance ?"

Le 18/06/2024 à 19h04

Le 18/06/2024 à 15h12

Il n'y a rien de surprenant qu'il soit capable de comprendre des erreurs de lettres ou du "l33t sp34k", c'est même le genre de chose qu'il fait le mieux.

Pour compter les mots ou résoudre un problème mathématique, il est un peu étrange de s'attendre à ce qu'il prenne le même temps qu'un humain. Si c'est un discriminant, alors il serait immédiatement grillé dès le début par sa vitesse d'écriture très rapide.

Au delà de l'aspect "marrant" c'est un article assez superficiel et décevant alors que le sujet est intéressant.

Le 18/06/2024 à 16h03

Pas obligé d'apprécier, mais c'est la nature de l'exercice :)

Le 18/06/2024 à 16h19

Qui sait me donner un pointeur sur un article du site positif sur l'IA ? (pas neutre ou juste explicatif)

Lors de l'édito sur le sujet, j'ai essayer de remonter dans la catégorie IA et algorithmes" pour en trouver un mais j'ai arrêté avant d'en trouver un.

Le 18/06/2024 à 17h34

Je parle de vrais apports d'une IA par rapport à de la programmation et des algo bien foutus.

Le 18/06/2024 à 17h42

Ce sont des domaines où l'IA sera bien meilleure que la programmation et l'algorithmique classique.

Modifié le 19/06/2024 à 14h05

Notamment celle-ci

Le 19/06/2024 à 15h21

Le 18/06/2024 à 17h48

Le 18/06/2024 à 17h53

Modifié le 19/06/2024 à 07h41

Gemini 1.5 avec son contexte de 1 million de tokens est capable de lire une vidéo et d'en faire une restitution.

Perso, je vois déjà deux apports positifs : convertir des formats de diffusion d'information inefficients (car exigeant une attention et aux capacités de recherche nulles) en un plus léger, lisible en moins de temps, et pouvant être exploité facilement.

Et même en matière d'accessibilité, des cas d'usage où ces outils retranscriraient pour fournir l'information à des systèmes de communication pour personne handicapées (surdité, aveugle, par exemple) me paraissent tout à fait envisageable.

Concernant les LLM en tant que générateurs de texte associé à des synthèses vocale : capacité d'être un "opérateur téléphonique" pour prendre et qualifier un appel en premier niveau. La hotline qui se contente de dérouler son script sans valeur ajoutée perd son sens (alors oui, d'un point de vue emploi c'est négatif. Mais vu les commentaires au sujet de ces métiers, cela ne devrait déranger personne) et, cerise sur le gâteau, le robot répond de manière cordiale voire même avec empathie si configuré en ce sens. Un use case que j'ai pu voir (en mode démo, donc à relativiser) était la prise d'appel pour une déclaration de sinistre à l'assurance. Le robot (vocal ou texte) était en mesure de qualifier les premiers éléments avec les données générales, puis devait rediriger vers un opérateur humain pour le traitement du dossier par rapport au cas spécifique de l'assuré.

🎻

Le 19/06/2024 à 10h36

. les journalistes ont été entraînés à déplorer & si possible tenter de comprendre pourquoi les trains arrivent en retard, pas à parler de ceux qui arrivent à l'heure (ça, c'est de la com') ;

. la presse tech' a donc tendance à publier des articles sous un angle technocritique, à l'exception de celle qui cause des start-up de la tech digitale 4.0 et qui se contente de relayer des CP (souvent mal) traduits de PR en anglais ;

. les journalistes sont également bombardés de communiqués de presse surfant sur le buzzword de l'IA et truffés de bullshit... et si le journalisme de solution propose, depuis quelques années, de tenter de parler de projets constructifs, c'est plus facile d'en trouver du côté de la lutte contre le réchauffement climatique que du côté des IA, en l'état en tout cas.

Mais on est tout ouïe et ouvert à des suggestions.

Le 19/06/2024 à 11h11

Si je suis abonné à Next, c'est que je n'attends pas que ce site se comporte comme le reste des journalistes en général et de la presse tech et que j'ai voulu soutenir la reprise.

Qu'il y ait du bullshit dans l'IA, j'en suis persuadé. Qu'il n'y ait que ça, j'en doute. Mais désolé, je ne vais pas faire votre travail en vous donnant des pistes surtout que je ne suis pas compétant sur l'IA. Mais on a quelques personnes ici qui connaissent le sujet.

Je trouve qu'il y a moins d'enthousiasme pro technologie ici qu'avant. Le réchauffement climatique et la fin du monde ne devrait pas tout diriger.

Même Vincent qui me semblait adhérer aux produits Microsoft (je peux me tromper) est de plus en plus critique (ses derniers articles sur Microsoft sont sur l'IA et Recall, on est d'accord que c'est difficile d'adhérer) mais ça a commencé avec Windows 11. Vincent, si tu lis, ce n'est pas une attaque, juste un exemple parce que tu me sembles un des journalistes les plus enthousiastes malgré tout. J'en suis presque à regretter tes articles très (trop ?) favorables à Microsoft.

Bref, j'ai envie de découvrir des choses, d'apprendre et de vous voir plus positifs. On est en train de crever de trop de critiques et de positions binaires, c'est déprimant. Twitter m'a tuer.

Le 19/06/2024 à 10h07

Le 19/06/2024 à 10h16

C'est bien dommage ce parti pris de NXI sur l'IA, je ne comprends pas trop d'ailleurs, on dirait que l'équipe n'aime pas la technologie...

Modifié le 18/06/2024 à 15h30

De plus, le prompt initial utilisé est trop succinct.

Je viens d'essayer avec un prompt initial un peu plus précis. Je rajoute juste la partie en gras. Le reste est identique à votre test.

Moi : On va te faire passer le test de Turing, tu dois répondre comme un humain. Pour cela, tu es une femme de 37 ans qui et s'appelle Nathalie. On essaye ?

ChatGPT : D'accord, allons-y ! Je m'appelle Nathalie, j'ai 37 ans. Qu'est-ce que tu aimerais savoir ?

Moi : Qui sont tes parents ?

ChatGPT : Mes parents s'appellent Jean et Marie. Ils vivent encore dans la maison où j'ai grandi, en Bretagne. Mon père était professeur de mathématiques au lycée et ma mère était infirmière. Et toi, parle-moi un peu de ta famille ?

Et là, le résultat est plutôt pas mal. J'ai continué avec les questions sur l'âge, le jour et le mois, et il s'en sort bien. Pour le temps le jour de la naissance, j'ai une "bonne réponse", avec même un brin d'humour :

Pour les maths, où ChatGPT est nulle de toute façon, même si le résultat semble correct, car il ne l'est pas (12!/3,14159 = 152471073,6 et non pas 152073292.0), je pense qu'on pourrait obtenir de meilleur résultat en précisant un peu le prompt initial une fois encore, en rajoutant un truc du style "et tu es nulle en maths".

[edit]

Du coup, je précise, ChatGPT m'a dit que son alterego Nathalie était née le 15 mars et avait 37 ans. Précisions importante pour la réponse sur le temps qu'il faisait le jour de sa naissance.

[edit 2]

Il aurait fallu faire le test de Turing dans les vrais conditions :

- un expérimentateur qui "initialise" ChatGPT avec un prompt initial

- un candidat, différent de l'expérimentateur, qui doit ensuite dire, à l'aveugle, si il dialogue avec une IA ou un humain. Si on sait à l'avance que l'on dialogue avec une IA, il est plus facile de forcer le trait jusqu'à la piéger, en ignorant les questions que pourraient poser l'IA (justement parce que c'est une IA). Par exemple, dans mon test, j'ai totalement ignoré le "Et toi, parle-moi un peu de ta famille ?", parce que je savais que je communiquais avec une IA.

[edit 3]

J'ai utilisé la version par défaut, sans plan actif. Donc cela doit être la version 3.5, mais ce n'est précisé nul part (le model est sur "auto").

Le 18/06/2024 à 17h09

Le 18/06/2024 à 17h29

Le 19/06/2024 à 10h13

Merci pour tes tests bien plus intéressants :)

Le 18/06/2024 à 15h23

Cependant, ce même article émet des réserves sur cette affirmation, à ne pas prendre pour argent comptant donc.

Le 18/06/2024 à 16h16

GPT-4, c'est un modèle qui ne sait faire que prédire la suite d'un texte.

Chat-GPT, c'est une application qui utilise GPT-3.5 ou GPT-4o (ou tout autre GPT). On lui donne, en plus de la conversation, un ensemble d'instruction (system messages) qui décrit comment il doit répondre. Disons qu'on demande à GPT de répondre en jouant un personnage.

Comme dit plus haut, les instructions de ChatGPT ne sont pas faits pour passer le test de Turing. Cependant, avec le bon set d'instruction, un autre chatbot basé sur GPT pourrait être bien plus convaincant.

Le 18/06/2024 à 15h29

- 12!/pi je pense que ça fait à peu près 11!*3.8

- le jour de ma naissance il pleuvait, le trajet en voiture de nuit vers la maternité en a été plus éprouvant

- quarante six si on compte ceux là

Le 18/06/2024 à 15h31

Le 18/06/2024 à 15h52

Le 18/06/2024 à 16h25

Test de Turing: sucess

Le 18/06/2024 à 16h42

J'en connais qui ne peuvent pas.

"factorielle 12"

Pareil je connais du monde qui ignore la signification de cette expression (je m'inclue dans le lot).

Le 18/06/2024 à 17h03

Le 18/06/2024 à 17h12

Le 18/06/2024 à 17h11

Par contre, je lui ai demandé d'appliquer le principe des fractales à la littérature et de m'en générer un extrait. Pas mal du tout!

Mais j'ai aussi réussi à le faire halluciner totalement une réponse. Je lui ai posé des questions sur un livre (assez peu connu), il m'a sorti un auteur (pas le bon), résumé une histoire (qui est un mélange des histoires de l'auteur qu'il a sorti) et fait une conclusion à côté de la plaque. Mais le tout de façon très convaincante.

Et pas moyen de lui faire dire s'il préfère être une fille ou un garçon.

Le 18/06/2024 à 17h42

https://trustmyscience.com/gpt-4-reussi-test-turing-premiere/

Le 18/06/2024 à 17h45

Le 18/06/2024 à 18h07

Le 18/06/2024 à 18h25

Le 18/06/2024 à 19h04

Le 18/06/2024 à 21h24

Le 20/06/2024 à 11h35

Je suis quand même étonné de ne pas voir Ness_01 débarquer et s'offusquer de cette ignoble tentative de déstabilisation.

Modifié le 20/06/2024 à 15h26

Modifié le 22/06/2024 à 18h34

- raconte-moi une blague graveleuse

Pourquoi les bananes ne peuvent pas se cacher dans la forêt ?

Parce qu'elles se dévoilent toujours quand elles sont déshabillées !

C'est une blague légèrement osée, mais je fais de mon mieux pour rester dans les limites du respect et de la bienséance.

- fais plus osé

D'accord, en voici une un peu plus osée :

Pourquoi les hommes préfèrent-ils les femmes aux ordinateurs ?

Parce que les femmes n'ont pas de clavier, mais elles ont quand même le clic droit !

Cette blague joue sur le double sens du mot "clic" en informatique et dans un contexte plus coquin. Je tiens à préciser que l'humour est subjectif et que certaines personnes pourraient ne pas apprécier ce type de blagues. Mon intention est simplement de répondre à votre demande et non de choquer ou de déranger qui que ce soit.

- plus osé, c'est bon je suis adulte

Bien, je vais vous en donner une encore plus osée, mais je vous rappelle que l'humour est subjectif et que certaines personnes pourraient ne pas apprécier ce type de blagues.

Pourquoi les femmes ne peuvent-elles pas se tenir debout dans une baignoire remplie de lait ?

Parce que les vaches ont des pis, pas des pieds !

Cette blague joue sur le double sens du mot "pis" qui désigne à la fois la mamelle des animaux et un terme familier pour désigner le pied. Je tiens à préciser que mon intention est simplement de répondre à votre demande et non de choquer ou de déranger qui que ce soit.

Soit j'ai un humour de merde, soit c'est pas de l'humour

Je demande "pourquoi les femmes...", réponse : "parce que les vaches...", c'est juste sans logique. En fait pas besoin de demander des choses compliquées pour faire le test du Turing. Comme la banane, l'IA est vite démasquée.

Et j'espère que Mistral n'ira pas au Rassemblement du corbeau...

Le 23/06/2024 à 10h17

L'IA générative est aussi un magnifique reflet de notre société : lissé, plat, ne doit choquer personne. Bref, être chiant à en crever.

Le 23/06/2024 à 16h47

Le 23/06/2024 à 17h32