GeForce RTX 3070 (GA104) : Ampere (un peu plus) à la portée de tous

Une 2080 Ti à 520 euros

Le 27 octobre 2020 à 14h00

8 min

Hardware

Hardware

Et de 3 ! Après les GeForce RTX 3080 et 3090, NVIDIA met cette semaine sur le marché sa RTX 3070 annoncée à 519 euros. Une carte présentée comme équivalente à une RTX 2080 Ti tout en étant bien plus abordable. Nous avons pu la tester pour vérifier ce qu'il en est.

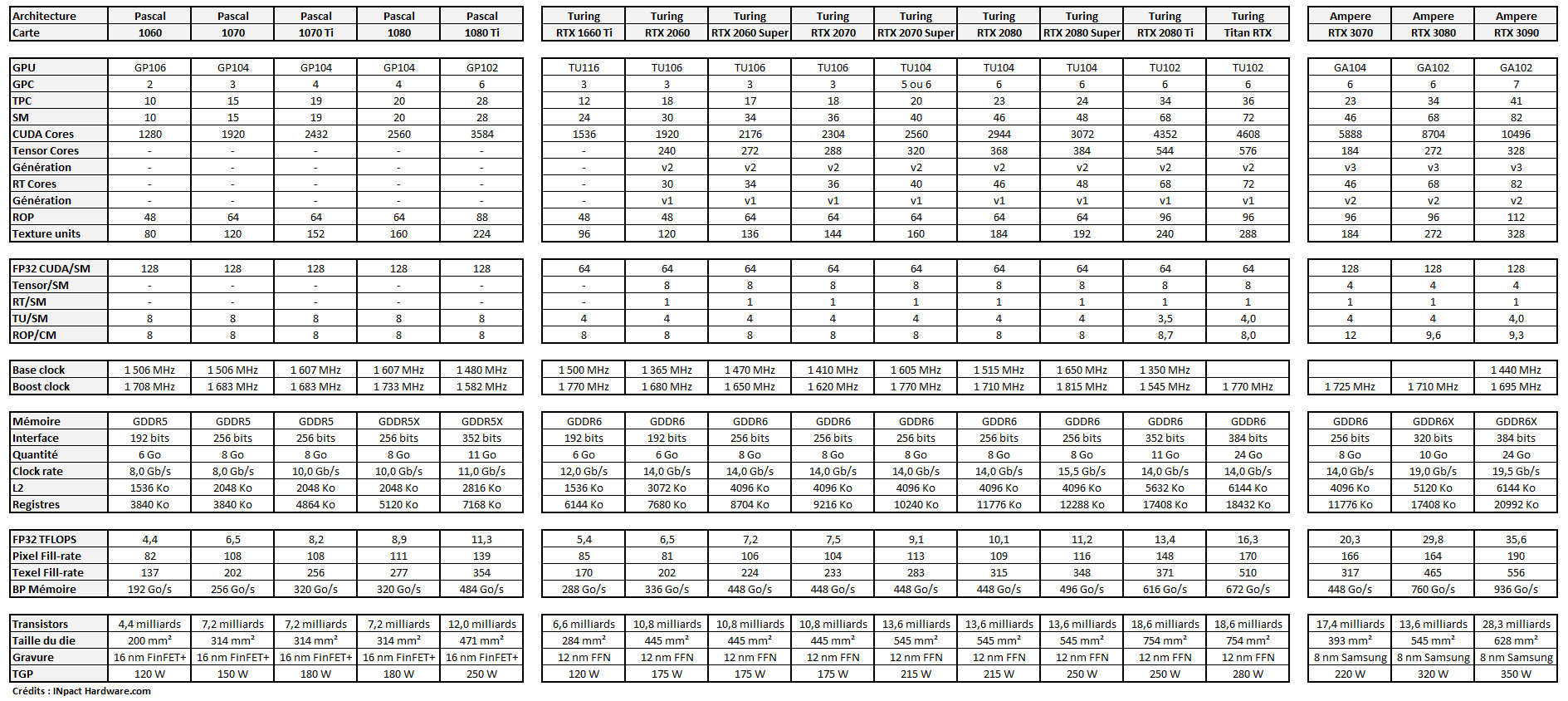

La GeForce RTX 3070 a été officiellement dévoilée le mois dernier avec la déclinaison grand public de l'architecture Ampere de NVIDIA. Elle exploite un GPU gravé en 8 nm (Samsung) nommée GA104, qui embarque pas moins de 17,4 milliards de transistors dans 393 mm². C'est beaucoup, mais bien moins que le GA102 de ses grandes sœurs.

Il s'agit de la première version « mesurée » d'Ampere. Le TGP de la carte est annoncé à 220 watts, deux connecteurs PCIe 8 broches (ou un de 12 broches) étant nécessaires à son alimentation. Elle n'occupe que deux emplacements PCIe, avec ses dimensions de 24 x 9,7 x 3,8 cm pour un poids d'un peu plus d'1 kg.

Son tarif public de 519 euros la place dans la tranche haute du cœur de gamme. Le segment parfait pour nombre de joueurs qui cherchent un produit assez puissant pour alimenter un écran 1440p avec un débit d'images élevé. C'est d'ailleurs ce qui a motivé NVIDIA à retarder son lancement, afin d'avoir des stocks plus élevés que pour les RTX 3080 et 3090. La commercialisation débutera ce jeudi, mais il y a fort à parier que l'on aura encore une pénurie.

En effet, selon nos informations, même si des centaines de cartes sont bien attendues chez les principaux revendeurs français, ces derniers s'attendent à des niveaux de commandes bien plus élevées. Et le fait qu'AMD va annoncer demain soir ses nouvelles Radeon RX 6000 ne devrait pas y changer grand-chose.

- NVIDIA dévoile RTX IO et ses GeForce RTX 3070, 3080 et 3090 dès 519 euros

- GeForce RTX 3070, 3080 et 3090 : Ampere expliqué techniquement et simplement

Une GeForce RTX 2080 dopée à l'architecture Ampere

Lorsque l'on regarde les caractéristiques techniques de cette carte, elle ressemble comme deux gouttes d'eau à une GeForce RTX 2080 équipée d'un TU104. On retrouve 6 GPC, 23 TPC, 46 groupements d'unités de calculs (SM). Mais avec Ampere, NVIDIA a doublé le nombre de CUDA Cores (FP32) ce qui change radicalement la donne.

Ainsi, avec un TGP similaire, on passe d'une puissance de calcul théorique de 10,1 TFLOPS à 20,3 TFLOPS. Même si l'on n'en profitera pas à plein dans les jeux, c'est supérieur à ce que fournissait une RTX 2080 Ti (16,3 TFLOPS). Côté mémoire, on reste par contre dans la sobriété avec 8 Go de GDDR6 à 14 Gb/s sur une interface 256 bits.

Pour savoir ce que cette carte avait dans le ventre, nous avons réutilisé notre machine à base de Core i9-10850K monté sur une ASRock Z490 Taichi et 4x 8 Go de DDR4 G.SKill à 3 GHz. Nous l'avons réinstallé pour profiter de Windows 10 dans son édition 20H2, avec les derniers pilotes NVIDIA en date : les 456.96.

Pour commencer, nous avons effectué nos habituels tests de positionnement, afin de voir comment la carte se plaçait face à d'autres modèles NVIDIA, mais aussi aux dernières Radeon d'AMD (pilotes 20.10.1) :

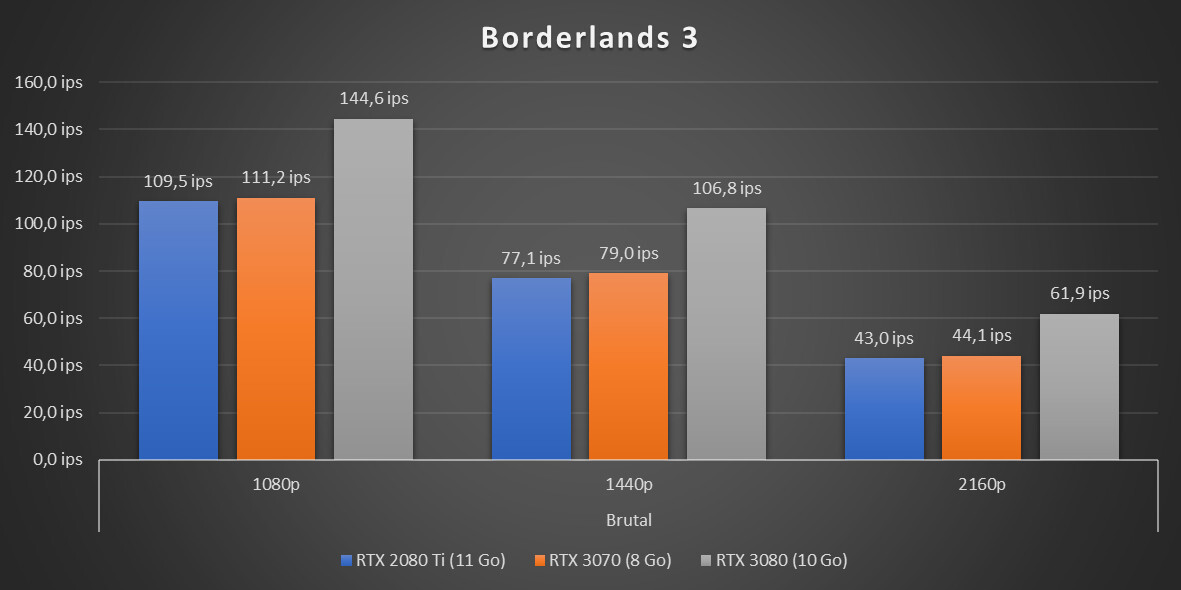

Sans surprise et comme annoncé par NVIDIA, on arrive au niveau de performances d'une GeForce RTX 2080 Ti. Que ce soit dans Borderlands 3 ou Superposition d'Unigine, on obtient des résultats similaires, légèrement inférieurs. Il n'y a donc pas à l'opposer à une RTX 2070/2080, elle sera bien au-delà. C'est une première bonne surprise, surtout pour une carte vendue deux fois moins cher que le précédent bébé haut de gamme du constructeur.

C'est par contre une mauvaise nouvelle pour AMD qui n'a pour le moment aucune carte qui lui arrive à la cheville, même sa coûteuse (et abandonnée) Radeon VII. Il faudra donc attendre de pouvoir tester les prochaines RX 6000 pour voir comment elles se positionneront face aux RTX 3070, 3080 et 3090, en rendu classique ou ray tracing.

Pour la suite de nos analyses, nous n'avons gardé que les GeForce pour alléger les relevés et résultats.

3D, RTX, DLSS, VRS : 3DMark confirme la tendance

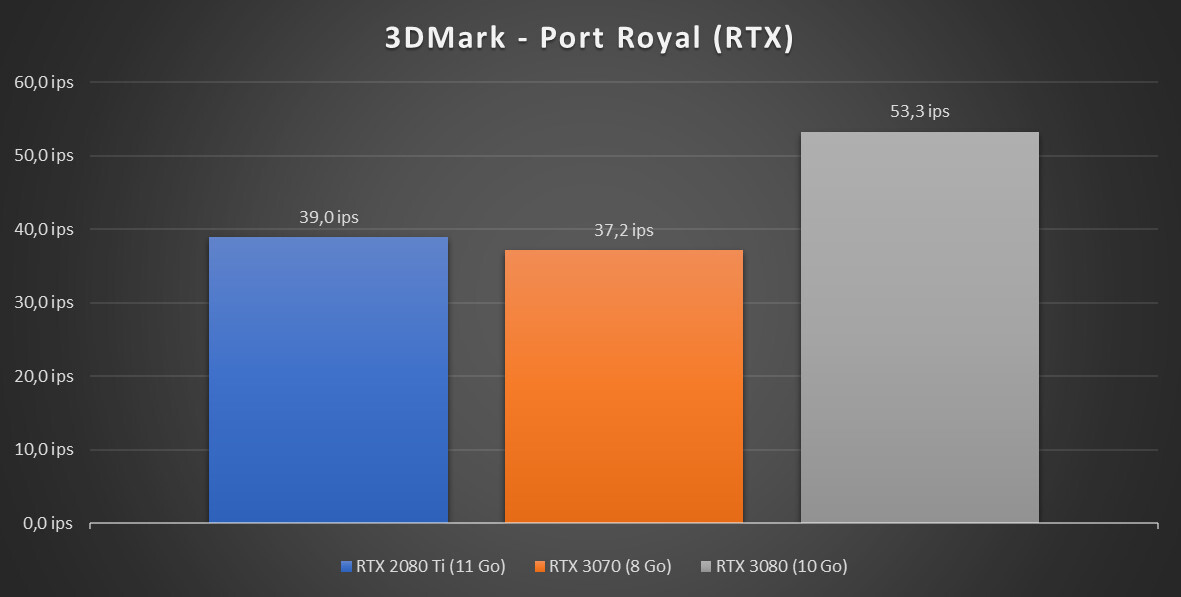

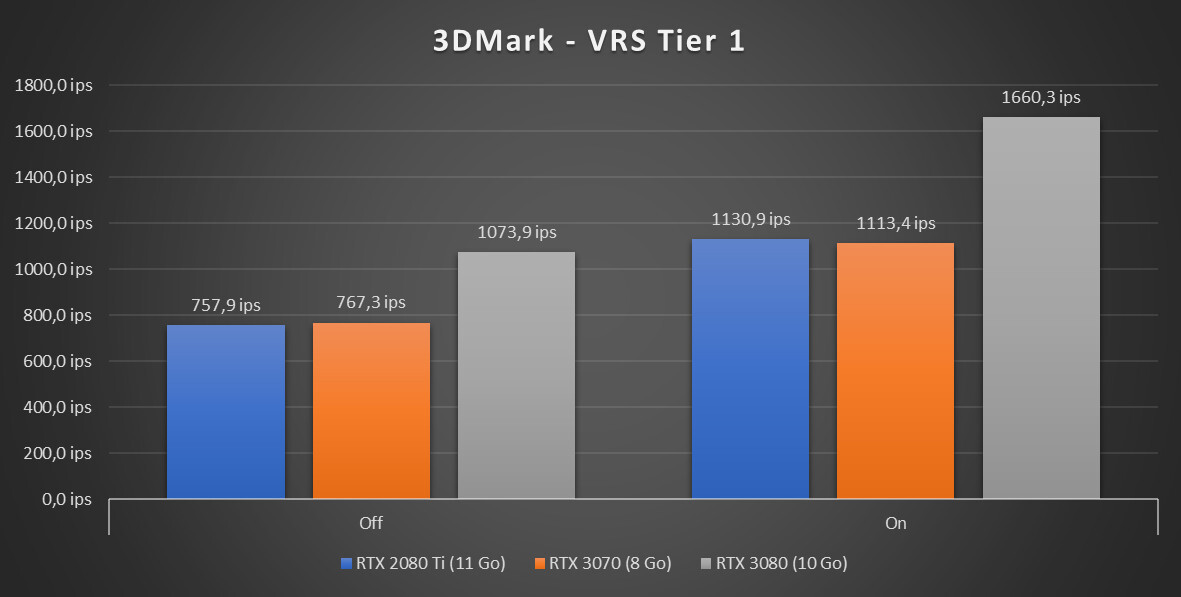

Dans ses différents tests techniques, 3DMark confirme nos premiers chiffres : la RTX 3070 offre un niveau de performances similaire à la 2080 Ti. Elle est en général un peu en dessous, mais de quelques ips seulement, ce qui ne sera pas de nature à faire la différence dans la pratique.

Dans les jeux, RTX 2080 Ti = RTX 3070

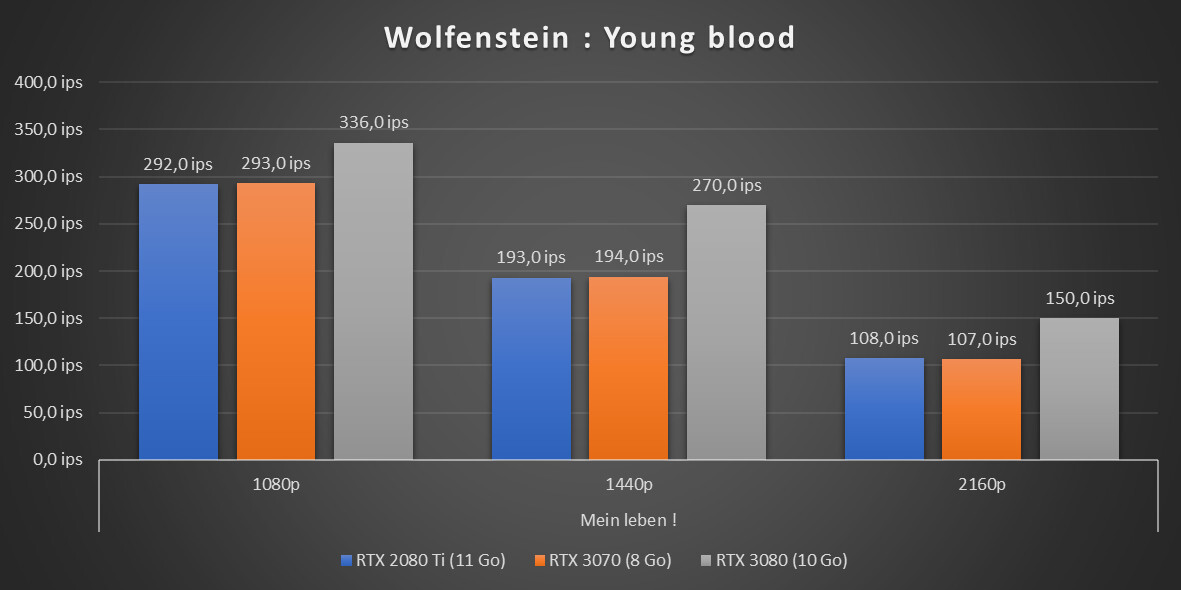

Qu'en est-il dans les jeux. Nous en avons essayé de diverses sortes, en 1080p, 1440p et 4K. Une manière de voir si les 11 Go de la 2080 Ti faisaient la différence dans certains cas. Comme on s'y attendait, la réponse est... non. Seule exception : le test 4K Vulkan Ultime de Ghost Recon : Breakpoint qui affiche un très mauvais résultat sur la 3070.

Pour le reste, les deux cartes obtiennent des chiffres similaires, avec la RTX 3080 qui est en général 30/40 % au-dessus. La 2080 Ti est parfois au-dessus, parfois non, sans jamais vraiment creuser l'écart :

Lorsque l'on active RTX et/ou DLSS, c'est même plutôt la RTX 3070 qui est favorisée, sans doute un peu aidée par le renforcement de l'architecture Ampere au niveau des RT/Tensors Cores. C'est néanmoins assez léger là aussi. Au final, ces deux cartes semblent être des clones de performances, bien que de constitutions très différentes :

Calcul et rendu 3D : Ampere marque sa différence

Il y a néanmoins un terrain où la RTX 3070 fait un peu plus de merveilles que la 2080 Ti, c'est le calcul. Aidée par ses 20 TFLOPS, elle bat cette fois son ancêtre à plate couture comme on peut le voir notamment dans Blender. Là aussi, le renforcement des RT/Tensor Cores aide, notamment lorsque l'on fait un rendu exploitant le motion blur :

Une carte graphique silencieuse et efficace

La RTX 3070 intègre deux ventilateurs de 85 mm, dont un traversant. Mais à la différence des RTX 3080 et 3090 ils sont situés sur la même face. On retrouve néanmoins un mécanisme similaire avec un large radiateur sur le GPU, des caloducs et une partie de la chaleur directement extraite à l'arrière de la maniète.

Arrêtés lorsque le GPU est peu sollicité, les ventilateurs démarrent aux alentours de 1 000 tpm. Avec la montée en température, ils grimpent à 1 300/1 400 tpm, mais rarement plus. La carte est vite contrainte par la limite de puissance imposée : 220 watts, le GPU oscille en général entre 1,8 et 1,9 GHz.

Tout cela laisse un bon potentiel d'overclocking si l'on joue sur ces paramètres. Le GPU dépasse rarement les 70 °C. Bien entendu, cela pourra évoluer selon la qualité du flux d'air et la température au sein de votre boîtier. Lors de nos essais, la RTX 3070 est constamment restée silencieuse. Son aspect mesuré se note aussi sur ce point, alors que la RTX 3080 pouvait légèrement se faire entendre si on la poussait un peu trop.

La RTX 3070 face à la RTX 2080 Ti - NVIDIA utilise un ventirad similaire aux RTX 3080/3090, avec deux ventilateurs du même côté

Ses scores d'efficacité énergétique sont similaires à ceux de sa grande sœur avec 7,27 joules par image sous Borderlands 4K, contre 7,30 pour la RTX 3080 et 8,34 pour la RTX 2080 Ti. Avec cette dernière notre machine consomme en effet 359 watts à la prise dans ce test contre 321 watts pour la 3070 et 452 watts pour la 3080.

Même chose sous Blender où la RTX 3070 est la plus économe avec un rendu de la scène Barbershop pour 34 Wh et une consommation moyenne de 254 watts, contre 40,85 Wh et 351 watts pour la 3080 et 72,11 Wh pour 294 watts avec la 2080 Ti. Si la petite nouvelle offre au pire des performances similaires à la 2080 Ti, elle est plus efficace.

GeForce RTX 3070 : la définition du « sweet spot » ?

La GeForce RTX 3070 devient ainsi clairement notre carte préférée au sein de la nouvelle gamme de NVIDIA. Aussi performante que la RTX 2080 Ti dans les jeux, allant bien au-delà pour ce qui est de la puissance de calcul, le tout avec une consommation réduite et un tarif divisé par deux, on ne sait que demander de mieux.

Ses dimensions sont raisonnables, elle ne fait pas de bruit, son prix est (pour le moment) abordable. Elle bénéficie également de tout l'écosystème NVIDIA que ce soit pour CUDA/OptiX, la (dé)compression vidéo, Reflex pour la réduction de la latence, Studio pour les fonctionnalités liées au streaming, l'overlay de performances, etc.

Il y a donc fort à parier que les premières cartes s'arracheront comme des petits pains ce jeudi et dans les semaines à venir. À moins qu'AMD n'annonce des Radeon RX 6000 très convaincantes demain soir. Mais le constructeur devra pour cela combler un écart de performances important, et rattraper son retard à de nombreux niveaux pour proposer des produits aussi complets. Est-ce qu'il en sera capable ou ne misera-t-il que sur la performance 3D brute, hors ray tracing pour séduire ceux qui n'ont que faire des dernières nouveautés ? Nous le saurons bien assez tôt.

GeForce RTX 3070 (GA104) : Ampere (un peu plus) à la portée de tous

-

Une GeForce RTX 2080 dopée à l'architecture Ampere

-

3D, RTX, DLSS, VRS : 3DMark confirme la tendance

-

Dans les jeux, RTX 2080 Ti = RTX 3070

-

Calcul et rendu 3D : Ampere marque sa différence

-

Une carte graphique silencieuse et efficace

-

GeForce RTX 3070 : la définition du « sweet spot » ?

Commentaires (41)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 27/10/2020 à 14h13

Comme attendu, ça ressemble vraiment à un sans faute de la part de NV avec cette 3070.

J’espère que AMD va pouvoir proposer quelque chose en face, histoire de continuer le jeux de la concurrence et motivé NV pour continuer dans cette voie.

Le 27/10/2020 à 14h17

Ce qui se dessine c’est qu’ils vont réussir à se placer entre les 3070⁄3080 plus ou moins selon les cas en rendu classique (raster), mais tout le reste risque de passer à la trappe sur cette génération. Il y a une clientèle à qui ça conviendra sans doute très bien, mais ça risque de limiter leurs choix tarifaires (alors que du Navi 2x à graver en 7 nm c’est sans doute pas donné). Hâte de voir comment ils vont présenter ça demain en tous cas

Le 27/10/2020 à 14h27

Les deux générations précédentes étaient déjà excellentes chez Nvidia mais cette dernière monte encore d’un cran.

Ah ce n’est pas un Intel moribond qu’à AMD en face pour le coup, le défi est tout autre ^^’

Le 27/10/2020 à 14h45

Hâte de voir la présentation d’AMD demain !

Très bonne carte, cette 3070 FE, Nvidia a fait du bon travail.

Petite question concernant le Ray Tracing, pour le moment ce n’est pas implémenté dans beaucoup de jeux et l’intérêt est parfois discutable. Y a t-il beaucoup de jeux prévus avec cette technologie ?

Le 27/10/2020 à 14h59

Merci pour l’article.

Sait-on à quelle heure les ventes commencent jeudi ? 😇

Le 27/10/2020 à 15h01

Je comprends pas trop… Je croyais qu’AMD déchiraient tout en ce moment et que Nvidia était à la ramasse ?

A vrai dire, je m’intéresse aux CG juste pour ma culture perso et de loin seulement… y’a qqn pour me faire un petit récap de la situation ?

Le 27/10/2020 à 15h21

En général c’est 15h chez NVIDIA, mais bon, vaut mieux surveiller en amont chez les revendeurs

Vu que ça repose sur un standard MS et que c’est implémenté dans pas mal de gros moteurs, ça ira forcément croissant. Pour le reste, il ne faut pas oublier que ça ne sert pas que dans les jeux, on voit bien l’intérêt ici rien que sur le passage de Turing à Ampere et le gain que ça implique en rendu 3D.

Le 27/10/2020 à 15h42

Je suis aussi ça de loin, je ne m’y connais pas des masse en hardware, mais je crois qu’AMD déchire en ce moment plutôt au niveau des processeurs, avec les Ryzen. Niveau CG, ça fait longtemps que je n’ai pas tellement entendu parler d’eux.

Sinon cette carte m’a l’air vraiment pas mal ! Je crains que ma GTX 1060 (6Go) actuelle ne claque bientôt, j’espère que les 3070 seront dispo et abordables d’ici là

Le 27/10/2020 à 15h49

NVidia n’est pas Intel, et n’a jamais relâcher la pression (même s’il y a eu de grosse période de feignasse). Ils ont gardé le monopole sur le haut de gamme, AMD a réussi à se faire une petit nid plus dans le marché moyen de gamme (moins de 400€) avec de bon rapport perf/prix. Les XX70 et les XX80 n’ont pour l’instant jamais eu de vrai concurrente rouge depuis des années.

De plus les Série 20 (RTX 20XX) étaient un énorme bond technologique (RTcore->raytracing, Tensor Core->deep Learning), plus que de performance. 2 ans après, on attend toujours une réponse d’AMD (demain à priori).

Cette Série 30 (RTX 30XX) a surtout permis de lâcher les chevaux avec l’astuce du doublement de Cuda coeurs (qui fait suite à l’exécution concurrentiel).

A priori, les rumeurs annonce que AMD aurait enfin un début de quelque chose pouvant titiller le haut de gamme de NVidia (des bench aurait été aperçu), mais aussi d’autre rumeurs semble dire que NVidia n’est plus vraiment inquiet (rumeur de versions boostées à coup de gros chiffre de ram annulées).

Il ne reste plus que les annonces de Intel qui se (re)lance dans la carte fille graphique et les puces dédiées. Là, pour l’instance, les rumeurs sont confuses.

Le 27/10/2020 à 16h20

Le 27/10/2020 à 17h04

Je peux aussi rajouter que niveau calcul (scientifique généralement) sur GPU, c’est NVidia qui domine largement et les bibliothèques Cuda sont largement utilisé (OpenCL n’ayant jamais vraiment convaincu). Cela inclus aussi le “deep learning” (les fameuse “IA”). Intel semble cependant vouloir viser ce secteur en proposant “One API” (qui se veut l’

anneauAPI unique).Pour les détails sur les calculs sur GPU :

Depuis l’introduction des cuda core (GeForce 8 series en 2006), une carte graphique peut être utilisé comme un processeur capable de faire faire des opération sur des matrice (tableau/array). Si tu arrives à représenter tes données dans des tableau et ecrire la suite d’opérations à faire (comme dans un tableur Excel, mais avec plus de dimension) , tu traites d’un seul coup l’intégralité de tes donnée “en parallèle” (c’est très différent des thread CPU qui peuvent exécuté chacun un bout de code différent dans leur coins). Par exemple, ça peut servir à des simulation physique, au niveau des molécules (chaque atome est soumis à un vecteur de force que tu appliques et recalcules)

Le deep learning ou apprentissage profond (autre nom : “réseau de neurone artificiel avec tellement de couche que ça devient la merde”) consiste ni plus ni moins à faire des opérations sur des matrices entre elles. Les cuda core ont été l’un des gros coup de boost pour ces types d’algo. Les tensor core permettent de faire l’opération de base (en gros le produit matriciel/dot produce) encore plus rapidement que si on utilisait des cuda core pour le faire.

Le 27/10/2020 à 17h43

Deux précisons : le plan sur Navi n’a pas bougé depuis le départ. Il y a eu la version 1x pour attaquer le marché par le coeur, sur le mobile, en profitant du 7 nm pour avoir un petit GPU passe partout et facilement rentabilisable. Navi 2x doit permettre à AMD de revenir sur le haut de gamme.

On verra dans quelle mesure il y arriveront, mais plus le temps passe plus le fossé se creuser entre les deux écosystèmes, ce qui reste un souci (même si pour certains joueurs, les perfs dans un jeu classique sans fioriture leur suffit si le prix est agressif). Tout dépendra aussi d’à quel point AMD va miser sur le prix pour gagner en pdm, ou si la société continuera à tenter de faire grimper ses marges.

Pour NVIDIA la stratégie est toujours la même : on sort des cartes, on laisse des gros écarts de prix, et ensuite on comble les trous selon ce que l’on a besoin de faire. Ils n’ont pas besoin de modèle avec plein de RAM, c’est un besoin du marché pro pas du grand public (même si c’est une arnaque marketing classique).

Tout l’enjeu pour NV et ses partenaires c’est de savoir où il faudra placer le curseur en perf/prix pour répondre au mieux. C’est ce qui est à l’origine de tout ce “bruit” en ce moment (comme les débilités du genre annulation de cartes qui n’ont jamais été annoncées).

Le 27/10/2020 à 17h45

Ce que je pige pas, c’est que la 3070 a beaucoup plus de transistors que la 3080m avec des perfs moindres. D’autant plus que le die est plus petit. Bref, y’a un truc qui me chiffonne là.

Le 27/10/2020 à 17h57

Attendons de voir des annonces concrètes, analyser des caractéristiques est toujours plus utile que de spéculer ;)

Le 27/10/2020 à 18h15

Tu veux dire qu’il pourrait y avoir des choses non encore activée sur cette carte ?

Hmm, c’est intriguant :)

Le 27/10/2020 à 18h35

Ca fait quand un beau bestiau !

Mais elle a de l’allure cette FE, dans 2 ou 3 ans, je verrai pour en prendre une. Ma GTX1070 fait largement l’affaire sans Ray tracing en 1080p (les 8 go ne sont jamais saturés). Surtout que j’ai l’ai eu pour 150 balles il y a 2 ans !

Le 27/10/2020 à 18h43

Sur les cartes graphiques, pas vraiment, nVidia reste bien devant.

Merci pour l’article sinon 👍 Impatient de voir ce que va proposer AMD demain.

Le 27/10/2020 à 19h27

519€ qui seront ajustés à 819€ par la distribution en situation de pénurie?

Pour le reste, j’attends AMD demain, je ne m’attend pas à un big bang mais si c’est pas trop cher, avec beaucoup de ram et que ça trace en compute, on verra.

Ma grosse déception face à AMD c’était le retrait de la radeon VII qui avait un autre niveau de performance que les rx xt.

Seront-ils capable de sortir un truc audacieux sans le faire disparaître presque aussitôt?

Le 27/10/2020 à 20h44

1070 FTW! Acheté à sa sortie 500€, elle tient toujours un warzone “tout au max” en 1080p à 90-105fps.

Le 27/10/2020 à 21h01

“7,27 joules par image sous Borderlands 4K, contre 7,30 pour la RTX 3080 et 8,34 pour la RTX 2080 Ti.”

soit un gain d’a peine 12% de l’ancienne à la nouvelle génération! c’est moi ou c’est vraiment peux ? parcequ’a cette vitesse la, il faudrait pas moins de 12 ans pour seulement doubler la performance par watt!

Le 27/10/2020 à 21h24

Je pense qu’il pointe surtout la fiche techniques des specs, la colonne RTX 3080 indique 13,6 milliards de transistors, mais je pense que ces chiffres ont été confondus avec ceux de la RTX 2080⁄2080 Super.

En tout cas d’après ce doc de NVIDIA (page 13) la RTX 3080 embarque bien 28,3 milliards de transistors.

Le 27/10/2020 à 21h25

500 balles en juin 2016… Quand même ! Mi-2018 ça valait le coup et encore plus en 2019 pour un budget serré. Même des cartes neuves milieu de gamme en ce moment n’ont pas un aussi bon rapport qualité/prix pour ceux qui ne veulent pas faire de ray tracing.

Le seul jeu qui pousse la carte dans ses retranchements c’est Red Dead 2, et encore j’ai enlevé pas mal de conneries qui plombent les perfs (physique de l’eau, ombres +++ etc…) de manière inutile.

Perso la RTX2060 super était celle la plus intéressante d’occasion vu le gain non négligeable (+30%) mais cette RTX3070 va faire baisser les prix des 2060 ou même si les approvisionnements sont un jour à la hauteur, perdre pas mal et devenir accessible (je mets pas 500 balles dans une CG).

Le 27/10/2020 à 21h43

Si seulement on pouvait les acheter ces fichues séries 3000 et si seulement Nvidia se décidait à avoir des drivers open source qui tiennent la route.

C’est vraiment tentant sur le plan perf/prix, AMD a intérêt à proposer un truc au moins aussi costaud sur la rasterisation et surtout moins cher s’ils veulent essayer de se battre. Vivement demain !!

Le 27/10/2020 à 22h36

Ah ah encore un lancement sans le produit disponible en quantité. Comme disait Dave Lee dans son test en parlant de la 3080 « il y en a 7 pour tout le Canada et Linus en possède 5 » 🤣

Le 28/10/2020 à 04h49

On se moque un peu du prix affiché s’il y a pénurie. Le problème c’est surtout que les revendeurs ne savent pas quand ils peuvent honorer des commandes parce qu’ils ont une queue x10 leur stock. Là on verra comment ça se passera. Les stocks sont importants, mais il y a de fortes chances que ça ne suffise pas.

AMD a tenté le coup de la grosse puce avec plein de mémoire pour la Radeon VII, ça n’a pas trop marché. Le souci sur un discours “Pro/Calcul” c’est qu’il leur manque toute la stack logicielle. Rocm est assez faible, il n’y a rien pour le rendu 3D à part ProRender, presque rien pour tout ce qui est infra/IA, etc.

Au mieux, ça permet de faire illusion dans un reviewer’s guide mais pas dans la pratique. Mais vu qu’ils vont proposer du 16 Go (qui n’ont aucun intérêt en jeu), ils risquent sans doute de tenter leur chance. C’est d’autant plus étonnant qu’ils ont toujours assumé que Navi n’était pas compute-centric.

C’était la raison pour laquelle Vega avait été gardé au catalogue. La raison pour laquelle CDNA sera lancé côté serveur. Mais ils peuvent avoir une surprise, on verra bien. Je doute néanmoins que ce soit “on a reconstitué tout l’écosystème CUDA/Tensor en douce sans y passer 10 ans comme NVIDIA”

Oui mais ce n’était pas un bon produit pour autant. Il était bruyant, cher (739 euros annoncés pour rappel) et pas forcément très performant. Il pouvait avoir un intérêt pour ses 16 Go de mémoire à la marge, mais comme dit plus haut, sans vraiment d’outils pour les exploiter (un peu dans la vidéo mais rien de plus).

AMD garde ses produits assez longtemps au catalogue. S’il y a quelque chose à leur reprocher, ce n’est pas forcément ça.

Le souci c’est que tu crois faire une comparaison de GPU. C’est la conso à la prise, donc pour l’ensemble du système.

Ah ok, je modifierai le tableau. J’ai été induit en erreur par son 3080”m”

C’est le drame d’AMD de n’être vu que comme celui qui doit péter les prix. Sur Radeon ils vont sans doute peut être encore le faire un peu (même s’ils ont pas mal réduit la pratique depuis Vega), mais l’objectif N°1 d’AMD est de faire grimper ses marges, rien de plus (voir Zen).

Le produit est disponible en quantité (pour un lancement de ce genre). Mais sans doute pas assez face à la demande qui sera celle de jeudi, comme les 3080⁄3090. On verra, tout le monde s’est préparé dans le channel, mais ils sont assez réalistes sur le résultat qui nous attend.

Je ne sais pas d’où Dave Lee tient ses infos, mais rien qu’en France le jour du lancement, il y avait plusieurs diizaines/centaines de cartes en stock et en arrivage selon les revendeurs (livrées depuis). Mais pas assez pour couvrir plusieurs milliers de commandes.

Et j’ai un doute sur le fait qu’un pays comme le Canada soit moins bien couvert que la France. C’est moins 🤣 et donc sans doute inadapté à YouTube, mais la réalité l’est rarement

Le 28/10/2020 à 08h00

Il me semble pourtant qu’AMD l’implémente dans les consoles et notamment celle de MS, il serait étonnant que ces API ne soit implémentées dans les prochaines carte d’AMD…

Le 28/10/2020 à 08h04

Faire du ray tracing et être au niveau ce n’est pas la même chose. Si AMD reste plutôt discret sur le sujet, ce n’est sans doute pas pour rien ;) Mais on verra bien ce soir, si on nous parle 5x plus de Borderlands 3 que des prochains titres DirectX RT, on saura pourquoi

Le 28/10/2020 à 13h04

Bon, ma vieille 970 achetée peanuts en 2016 commence justement à bien attendre ses limites, même en 1080p, je vais commencer à regarder si la 3070 pourrait se caler dans ma tour… :)

Le 28/10/2020 à 13h31

Conférence AMD sur Big Navi dans 2h : YouTube

YouTube

D’après quelques leaks technique et rumeurs, AMD atteindrait des records de fréquence à hauteur de 2,5Ghz en 7nm (comparé aux 1,9Ghz en 8nm des RTX 30xx) et un niveau de performance possible situé au dessus des RTX 3080.

Wait & See :-)

Le 28/10/2020 à 13h34

“Le souci c’est que tu crois faire une comparaison de GPU. C’est la conso à la prise, donc pour l’ensemble du système. ”

ok merci , du coup y a moyens d’avoir la conso de la carte seule?

j’ai un i7 3770, avec une alim de 400 watts, et je compte pas changer d’alim.

Le 28/10/2020 à 14h02

Attention aussi au changement d’heure : si ce 15h est calé sur une heure US, on est dans la semaine où la France est déjà à l’heure d’hiver alors que les USA sont encore à l’heure d’été (ils changent ce WE), donc 1h de décalage en plus, ça pourrait tomber sur 14h.

Le 28/10/2020 à 15h30

Tu as le TGP, la carte se limite à ce TGP

Ah, les rumeurs… Mais oui, on verra à 17h ;) Notamment qu’une fréquence de 2,5 GHz pour tenter d’aller gratter tel ou tel bench en dernière limite, ça ne s’obtient pas sans contreparties, sans doute

Mais oui, on verra à 17h ;) Notamment qu’une fréquence de 2,5 GHz pour tenter d’aller gratter tel ou tel bench en dernière limite, ça ne s’obtient pas sans contreparties, sans doute

Le 28/10/2020 à 16h52

La réalité dépasse la fiction, Bravo AMD.

Le 28/10/2020 à 17h15

Ah, tu as vu plus de 2.5 GHz ?

Le 28/10/2020 à 17h31

J’ai vu 25xx Mhz de stable. Maintenant, AMD est capable de nous sortir dans 6 mois des versions ajustés montant en Boost à 2,5Ghz ou un peu au dessus.

Le 28/10/2020 à 17h36

La Game Clock reste dans les 2 GHz (qui doit servir de base pour le TGP de 300 watts je suppose). Mais bon, rien n’empêche d’espérer ;)

Le 28/10/2020 à 18h28

Je viens de regarder la conférence, et sauf erreur, je trouve rien de foufou.

D’après leur bench, donc très optimiste pour AMD, la RX6800 serait 10-15% meilleure que la 3070, mais aussi 10-15% plus cher.

Donc on est sur un prix équivalent à NVIDIA, mais sans le bundle de feature annexe comme nvenc par exemple.

Le 28/10/2020 à 19h55

On attend surtout de connaître le bundle de logiciels et éventuellement jeux accompagnant les cartes.

Le 28/10/2020 à 20h11

AMD a son propre outil de (dé)compression vidéo depuis un moment. Exploité dans la plupart des outils qui gèrent NVENC et QSV

Le 28/10/2020 à 21h20

Je suis vraiment has-been… Rien que d’employer le mot has-been veut dire que je suis has-been.

Comme ca m’arrive de stream un peu dans discord, le nvenc m’interesse. Je vais aller voir si Discord prend en charge l’encodage HW des AMD.

Le 31/10/2020 à 13h01

C’est VCN chez AMD : WikipediaPas mal de soft le gère.

WikipediaPas mal de soft le gère.