Le GPU Blackwell B200 coûtera entre 30 000 et 40 000 dollars pièce

Le 20 mars à 07h01

1 min

Hardware

Hardware

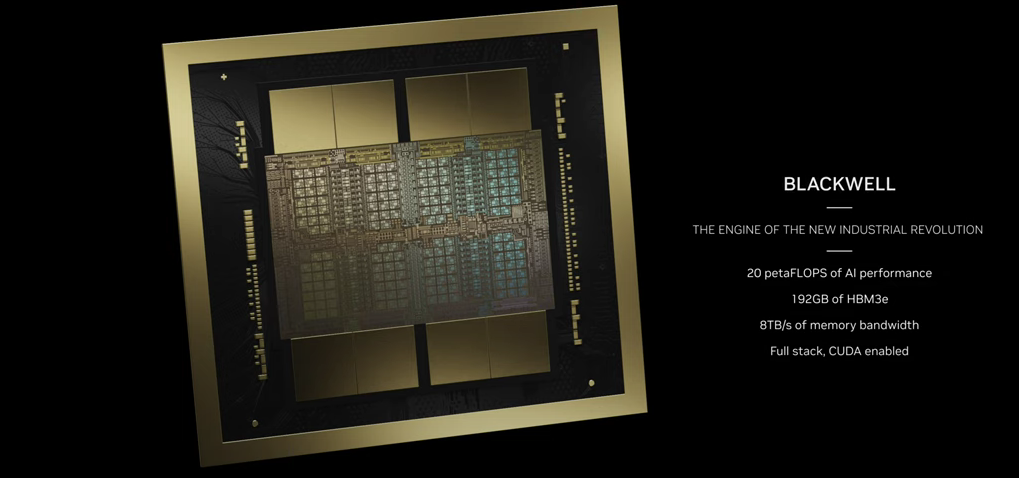

La déclaration a été faite par Jensen Huang lors d’une interview à CNBC, comme le rapporte Tweaktown. Ce nouveau GPU a été annoncé cette semaine durant la GTC de NVIDIA avec la promesse de largement dépasser les performances du H100 (Hopper).

Le patron de NVIDIA en profite pour annoncer avoir investi aux alentours de 10 milliards de dollars en recherche et développement pour Blackwell.

Le 20 mars à 07h01

Commentaires (19)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 20/03/2024 à 09h19

Le 20/03/2024 à 11h33

Le 20/03/2024 à 09h44

Le 20/03/2024 à 10h20

Le 20/03/2024 à 10h41

Là où NVidia fait fort depuis plus de 15ans (avec l'arrivée des cuda core et de la bibliothèque cuda), c'est qu'ils travaillent énormément en collaboration avec des équipes de recherches en leur apportant leur aide et eux ont des retours et peuvent améliorer et évoluer leurs outils en fonctions des besoins. Du coup, la majorité des outils de qui peuvent utiliser l'accélération par GPU le font d'abord via CUDA, les autres matos passant souvent au second plan. De ce fait, si tu veux faire du calcul sur GPU (ce qui inclut les réseaux de neurones) tu achètes du matos avec une puce NVidia.

Par exemple, la bibliothèque python "numba" (qui permet d'obtenir des performances élevées en python) est nativement compatible avec CUDA. Pour ROCm, d'après le git, c'est un adaptateur du code depuis CUDA vers ROCm, et le code n'a pas changé depuis 6 ans (et la dernière doc ne fait même plus référence à ROCm).

Modifié le 20/03/2024 à 11h35

Je veux dire, il ont 30000 salariés environ. Ça équivaut à plus de 5 ans de salariat à prêt de 33k/an pour chacun (pour TOUTE l'entreprise, donc c'est très approximatif comme calcul). Sauf que le H100 a été présenté en 2021, donc on peut en déduire que le debut des travaux sur le B200 date de 2021 au plus tôt... Ça fait 3 ans. En 3 ans, ils crament 10 milliards en R&D ? 🤔

Le 20/03/2024 à 13h55

Du coup, vu le domaine extrêmement pointu, cela ne m'étonne pas vraiment.

Le 20/03/2024 à 16h28

J'avais un souvenir que NVidia avait bien galéré pour produire les puces d'une génération de RTX à cause de leur taille. Le but étant de ne pas jeter 90% du wafer, il leur a fallu pas mal travailler avec TSMC pour optimiser le procédé de gravure. Là, avec des puces de telle taille (j'imagine que ça doit en plus poser des problèmes pour garder tout ça synchrone avec les tics d'horloge) et une conception MCM (Multi-Chip-Module, plusieurs puces soudé ensemble pour ne faire qu'une seule) qui est une première pour NVidia, ils ont dû passer du temps chez TSMC et bouffer des wafers pour arriver à un procédé industriellement viable.

Le 20/03/2024 à 17h05

Le prix élevé du produit qui en résulte c'est autre chose et ne relève plus de la R&D (même s'il y a sans doute l'amortissement de la R&D inclus dedans).

Le 20/03/2024 à 16h14

https://www.zdnet.fr/actualites/nvidia-se-porte-bien-la-moitie-de-ses-employes-gagnent-300-000-dollars-par-an-39964536.htm

Le 20/03/2024 à 12h34

Le 20/03/2024 à 14h47

Le 20/03/2024 à 16h25

Le 20/03/2024 à 16h36

(matériellement, je ne sais pas s'il y a tout ce qu'il faut pour faire un pipline 3D classique, et logiciellement, je crains qu'il n'y ait pas les bibliothèques nécessaires. Et de toute façon, il n'y a pas de sortie vidéo)

Le 20/03/2024 à 20h15

Le 20/03/2024 à 14h58

Le 20/03/2024 à 17h00

Le 20/03/2024 à 20h03

Faisons-en de même !

Nous parlerons donc de Generic Processing Unit

Le 20/03/2024 à 21h58