Proxmox VE 7.0 : installation sur un serveur et création d’une machine virtuelle

Virtualize everything

Notre dossier sur Promox VE 7.0 :

Le 25 août 2021 à 06h09

12 min

Hardware

Hardware

Depuis quelques années, Proxmox s'est taillé une certaine réputation avec ses systèmes et outils open source à destination des entreprises et autres geeks adeptes de « Home Lab ». Découvrons son environnement de virtualisation (VE), une alternative intéressante aux géants du marché.

Configurer un serveur sous Linux pour y installer directement des applications est une pratique de moins en moins courante. Ce n'est en effet pas la meilleure manière de maintenir une machine sur la durée et de s'adapter à des besoins divers et importants. Il est bien plus aisé d'y utiliser un hyperviseur et des machines virtuelles (VM).

Elles ont l'intérêt de pouvoir être créées, sauvegardées et supprimées facilement. On peut configurer différents environnements (Linux, Windows, etc.) fonctionnant en simultané, répartir les performances comme on le souhaite, attribuer des composants physiques comme une carte graphique à certaines et pas à d'autres, etc.

Une solution parfois préférable au fait de multiplier des Raspberry Pi, surtout lorsque l'on a un certain besoin de performances. D'autant que les outils dédiés à cet usage proposent une gestion distante via une interface web, plus ou moins aisée à prendre en main. Si des acteurs comme Citrix ou VMware se sont développés autour de cette idée, l'allemand Proxmox a su se démarquer et tirer son épingle du jeu avec son Virtual Environment (VE).

Un système open source, gratuit mais avec une offre payante pour les entreprises, construit sur une base Debian, avec QEMU/KVM pour la virtualisation et même une gestion des conteneurs LXC. L'outil se veut ultra-complet, avec sa gestion de clusters pour la haute disponibilité, du système de fichiers ZFS, de Ceph, etc.

Dans le dossier que nous ouvrons aujourd'hui, nous partons à sa découverte.

- Proxmox VE 7.0 : installation sur un serveur et création d'une machine virtuelle

- Linux Containers (LXC) dans Proxmox VE 7.0 : installez simplement des distributions et services

Installation sur un serveur

Le premier point intéressant est que l'équipe met régulièrement à jour son système avec un noyau récent, malgré la base Debian. Ainsi, elle dispose d'une compatibilité matérielle assez large et dans l'air du temps. Elle évite au passage la sélectivité d'un VMWare vSphere/ESXi qui a tendance à ne gérer que certaines cartes réseau par exemple.

L'image ISO se récupère de manière classique, via un téléchargement HTTPS ou BitTorrent. Il suffit ensuite de la placer sur une clé USB ou de booter dessus via l'outil de gestion distante de votre serveur (IPMI/BMC). C'est ce que nous avons fait dans notre cas avec notre serveur HPE ProLiant DL365 Gen10 Plus v2.

La procédure diffère d'une installation Linux classique, avec tout de même certaines questions basiques. Avant de la lancer, pensez à vérifier que les fonctionnalités de virtualisation de votre processeur sont activées dans le BIOS/UEFI.

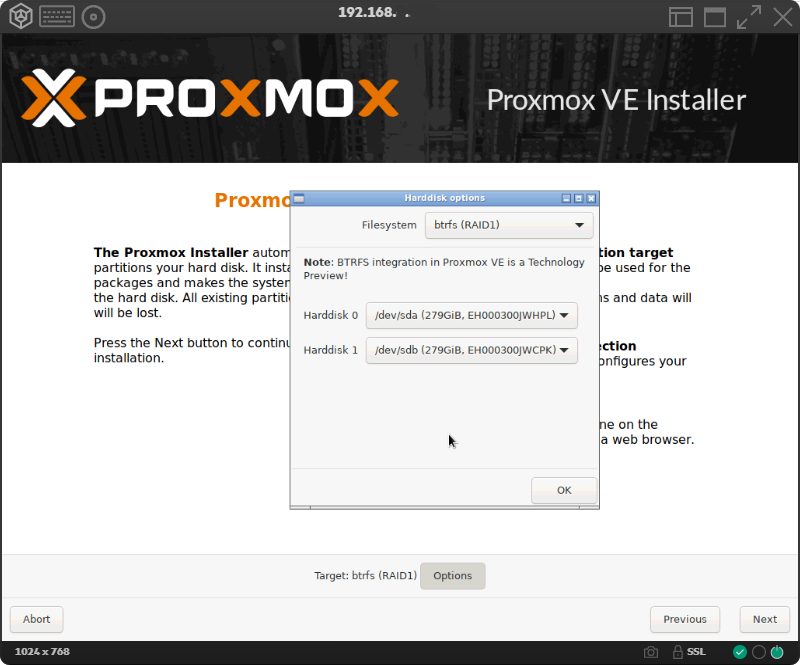

Après avoir accepté la licence utilisateur, la première chose qui vous sera demandée est de configurer le stockage. Une étape qui vient plutôt en fin de processus habituellement, mais qui est ici primordiale. Par défaut l'installation se fera sur le HDD/SSD sélectionné, qui sera effacé en intégralité. Vous pouvez également opter pour du RAID avec btrfs ou ZFS comme système de fichiers plutôt que l'habituel ext4. Nous avons opté pour btrfs en RAID 1 (Mirroring).

Notez qu'il n'est pas ici question de gérer finement l'organisation des partitions ou un éventuel double boot, vous montez un serveur dédié à la virtualisation : le stockage désigné est entièrement consacré au système.

S'en suivent des étapes plus classiques comme la désignation du pays et des options régionales, le mot de passe du compte root, un email pour que le serveur vous informe en cas d'urgence, et vos paramètres réseau. Si vous disposez d'un serveur DHCP, là aussi tout devrait normalement être configuré automatiquement.

Un résumé de vos choix est enfin affiché, avec la possibilité de revenir en arrière à tout moment. On passe alors à l'installation elle-même qui nécessite quelques minutes. La machine redémarre automatiquement et une fois Proxmox VE initialisé, l'URL d'accès à l'interface web vous sera donnée sous la forme suivante :

https://ip_du_serveur:8006

Gestion des mises à jour et fonctions de base

Vous arriverez par défaut à l'écran de connexion, en anglais mais que vous pouvez afficher en français. Le nom d'utilisateur est root, le mot de passe correspond à celui que vous avez indiqué pendant l'installation. Un message indiquant que vous ne disposez pas de licence sera alors affiché, c'est « normal ».

Ce même message reviendra dans certains cas, ce qui permet à l'équipe de rappeler son modèle payant qui donne accès à des dépôts logiciels spécifiques réservés à ses clients. Si vous n'en voulez pas, la première chose à faire est donc de les désactiver. Pour cela, cliquez sur votre serveur dans le menu de gauche (proxvm dans notre cas).

Une liste de choix s'afficher : cliquez sur Repositories dans Updates. Sélectionnez la ligne correspondant au composant pve-entreprise puis sur Disable. Rendez-vous ensuite dans Updates puis cliquez sur Refresh. Cela revient à vérifier si de nouveaux paquets sont disponibles pour votre système. Ce sera très certainement le cas.

Si des éléments s'affichent dans la liste, cliquez sur Upgrade pour procéder à la mise à jour. Notez qu'il est toujours possible de la faire manuellement via Shell qui donne accès à un terminal :

apt update && apt full-upgrade -y && apt autoremove

L'interface s'organise en différentes zones, avec la liste des tâches effectuées et des logs en bas, les fonctions principales, de gestion utilisateur et la recherche en haut, le menu de navigation à gauche et la partie centrale.

Notez que le menu est par défaut en « Vue Serveur » avec une arborescence qui va du Datacenter aux différents serveurs pouvant être regroupés en clusters, en passant par leurs composants. D'autres sont proposées, s'organisant sous la forme de dossiers, autour du stockage ou des « pools » de ressources.

Chaque élément dispose de (très) nombreux paramètres, n'hésitez pas à naviguer dans chacun d'entre eux pour découvrir les possibilités offertes par Proxmox VE, qui ont comme principal intérêt de donner presque systématiquement accès à des points précis de sa documentation depuis les options et paramètres.

Une première chose à faire peut ainsi être de créer un utilisateur différent de root dans la section Users des Permissions du Datacenter. Il suffit de lui donner un nom. Il peut aussi avoir une date d'expiration, être placé au sein d'un groupe, etc. Une fois créé attribuez-lui un mot de passe et activez la double authentification (TOTP ou U2F).

La zone consacrée aux Permissions permet de gérer ce que chaque utilisateur peut faire en lui attribuant un dossier d'accès, un rôle (prédéfini ou ajouté par vos soins), des jetons d'accès API, mais aussi d'ajouter des méthodes de connexion, pouvant passer par un serveur ActiveDirectory, LDAP ou OpenID (OAuth). Vous pouvez poursuivre la configuration par les réglages du firewall, des groupes de sécurité, du nom de domaine d'accès et son certificat, etc.

Téléchargement d'une image ISO

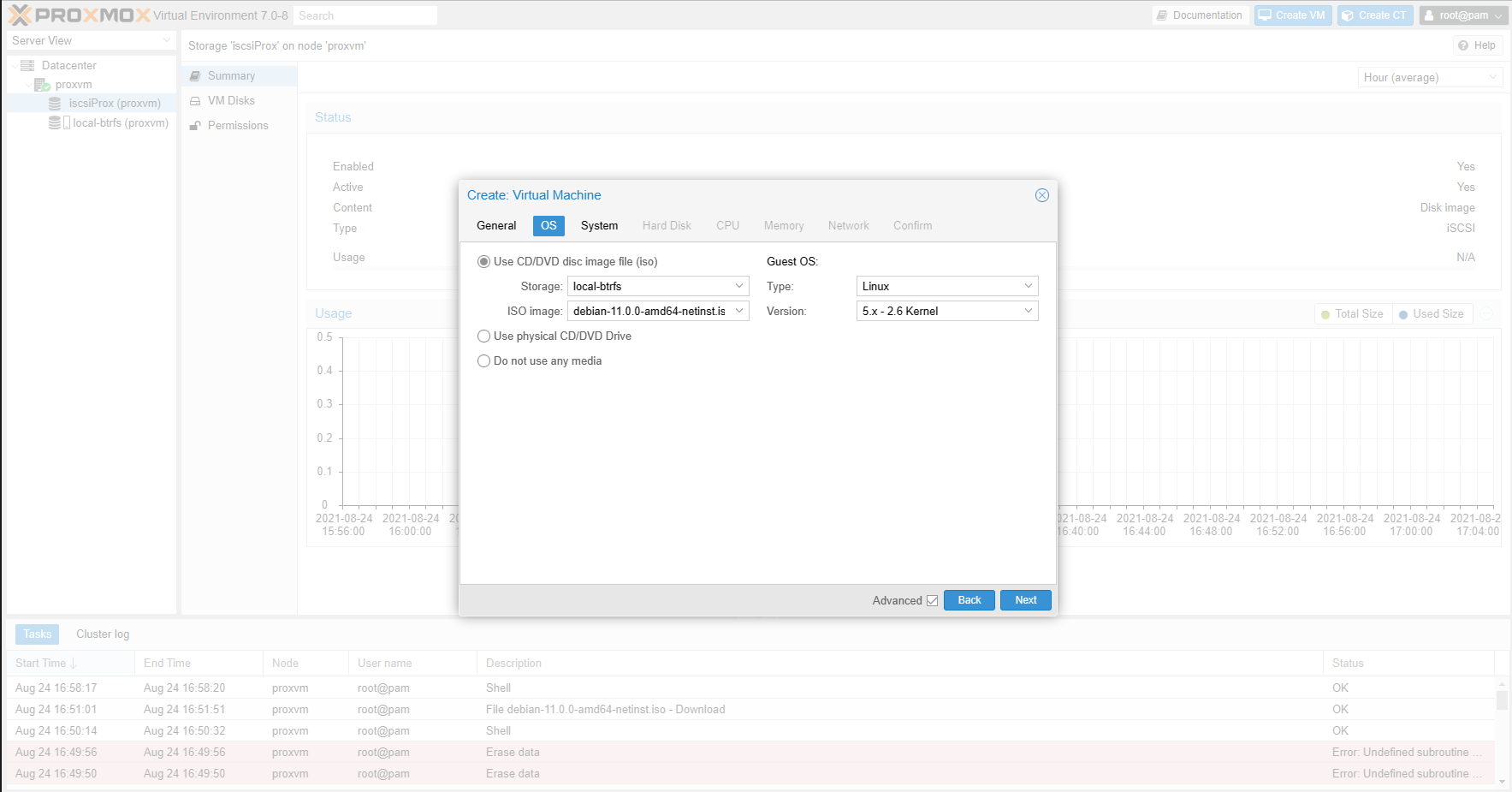

Passons à la création de notre première machine virtuelle. Pour cela, il faut tout d'abord récupérer l'image ISO d'un système d'exploitation et la stocker sur le serveur. Depuis peu, Proxmox VE permet de le faire directement depuis son interface graphique, avec une vérification de la somme de contrôle, ce qui est une bonne chose.

Pour cela, rendez-vous dans les paramètres du stockage dans le menu principal (local-btrfs dans notre cas), puis sur ISO Image. Upload vous permet d'envoyer l'image depuis votre machine, nous optons pour Download fom URL. Nous utiliserons l'image d'installation réseau de Debian 11, avec les paramètres avancés suivants :

URL : https://cdimage.debian.org/debian-cd/current/amd64/iso-cd/debian-11.0.0-amd64-netinst.iso

Type de somme de contrôle : SHA512

Somme de contrôle : 5f6aed67b159d7ccc1a90df33cc8a314aa278728a6f50707ebf10c02e46664e383ca5fa19163b0a1c6a4cb77a39587881584b00b45f512b4a470f1138eaa1801

Cliquez sur Query URL pour que l'adresse soit vérifiée, puis sur Download. Une fenêtre s'affichera alors, indiquant le statut du téléchargement. Une fois terminé, vous pouvez la fermer. L'image se trouvera dans le dossier suivant :

/var/lib/pve/local-btrfs/template/iso/

On peut maintenant passer à la création de la machine virtuelle (VM).

Création d'une machine virtuelle

Commencez par vous demander quels seront les composants de votre VM, notamment en matière de stockage. En effet, celui-ci peut être local (via les HDD/SSD du serveur) ou distant (via des protocoles comme NFS et iSCSI). L'ajout de nouveaux éléments sur ce point se fait dans la section Storage des paramètres du Datacenter.

Nous avons par exemple ajouté une cible iSCSI qui contiendra le volume de 100 Go dédié à notre machine virtuelle. Ensuite on clique sur Create VM en haut à droite dans l'interface, puis on répond aux questions habituelles : quel serveur héberge la machine, quel nom lui donner, où se trouver l'image ISO, quel système sera installé, etc.

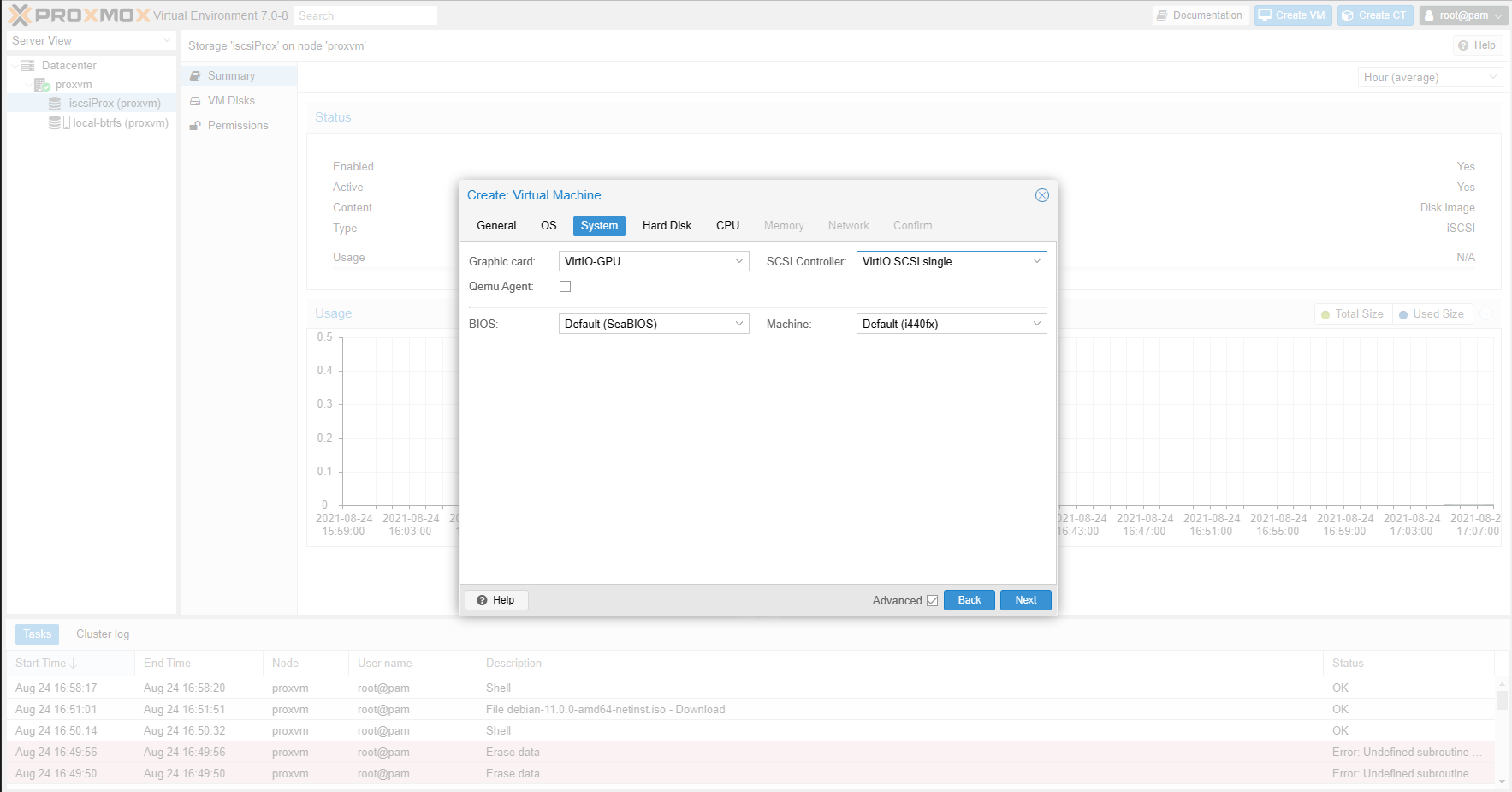

Viennent ensuite les paramètres techniques de la VM : carte graphique, contrôleur de stockage et espace disque, nombre de cœurs, quantité de mémoire, carte réseau. Ici, les choix seront à adapter selon vos besoins. Faites aussi attention à ne pas toujours vous contenter des choix par défaut et à lire la documentation.

Vous pourrez ainsi décider de privilégier le GPU VirtIO et son contrôleur SCSI, mais sous Windows il faudra alors en passer par des pilotes spécifiques à installer. Ils sont disponibles au format ISO à l'une des URL suivantes :

https://fedorapeople.org/groups/virt/virtio-win/direct-downloads/stable-virtio/virtio-win.iso

https://fedorapeople.org/groups/virt/virtio-win/direct-downloads/latest-virtio/virtio-win.iso

Vous pouvez ainsi les télécharger sur votre serveur et les monter comme un lecteur optique qui sera vu par la machine virtuelle pendant la procédure d'installation ou après celle-ci selon les cas et les besoins.

Pour le CPU, privilégiez le type host, qui le fera reconnaître comme celui de votre serveur, et donc avec les mêmes jeux d'instructions. Vous pouvez indiquer le nombre de cœurs que vous voulez, mais aussi jouer sur le nombre de sockets, de vCPU visibles par la machine virtuelle, activer ou non NUMA si votre processeur le nécessite, etc. On regrette cependant de ne pas pouvoir attribuer facilement des cœurs précis à une VM comme dans ESXi.

Côté réseau, on apprécie par contre de pouvoir attribuer un VLAN directement et limiter le débit en Mo/s.

Démarrage et installation de l'OS

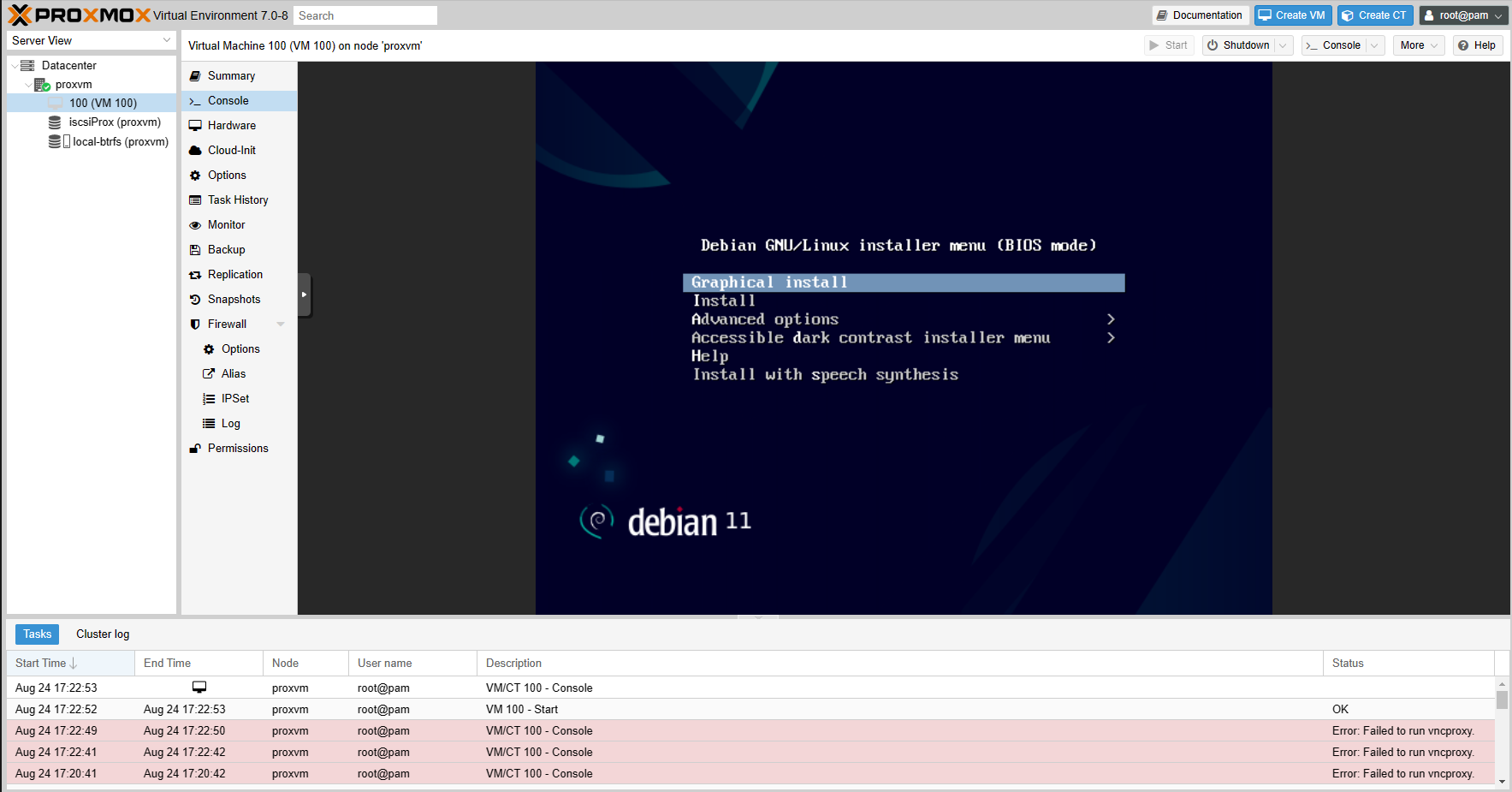

Une fois tous les choix effectués, la procédure est terminée. Vous pouvez décider de démarrer directement la machine virtuelle ou le faire manuellement. Optez plutôt pour la seconde méthode. Les différents onglets vous permettront en effet de peaufiner vos paramètres, en jouant sur certains détails qui peuvent avoir leur importance.

L'onglet Summary affiche le statut de la VM et de ses composants, comme pour le serveur ou Datacenter. Dans Hardware vous pouvez modifier ou ajouter des périphériques de stockage, attribuer un port réseau ou une carte PCIe (nous y reviendrons dans un prochain article). Cloud-init permet de préciser un script à exécuter selon le standard.

Dans les Options, pensez à activer QEMU Guest Agent qui permet à la VM de communiquer avec le serveur lorsque les pilotes VirtIO sont installés, et de remonter certaines informations complémentaires, comme l'IP de ses cartes réseau par exemple. C'est aussi dans cet onglet que vous pourrez modifier l'ordre de démarrage des périphériques.

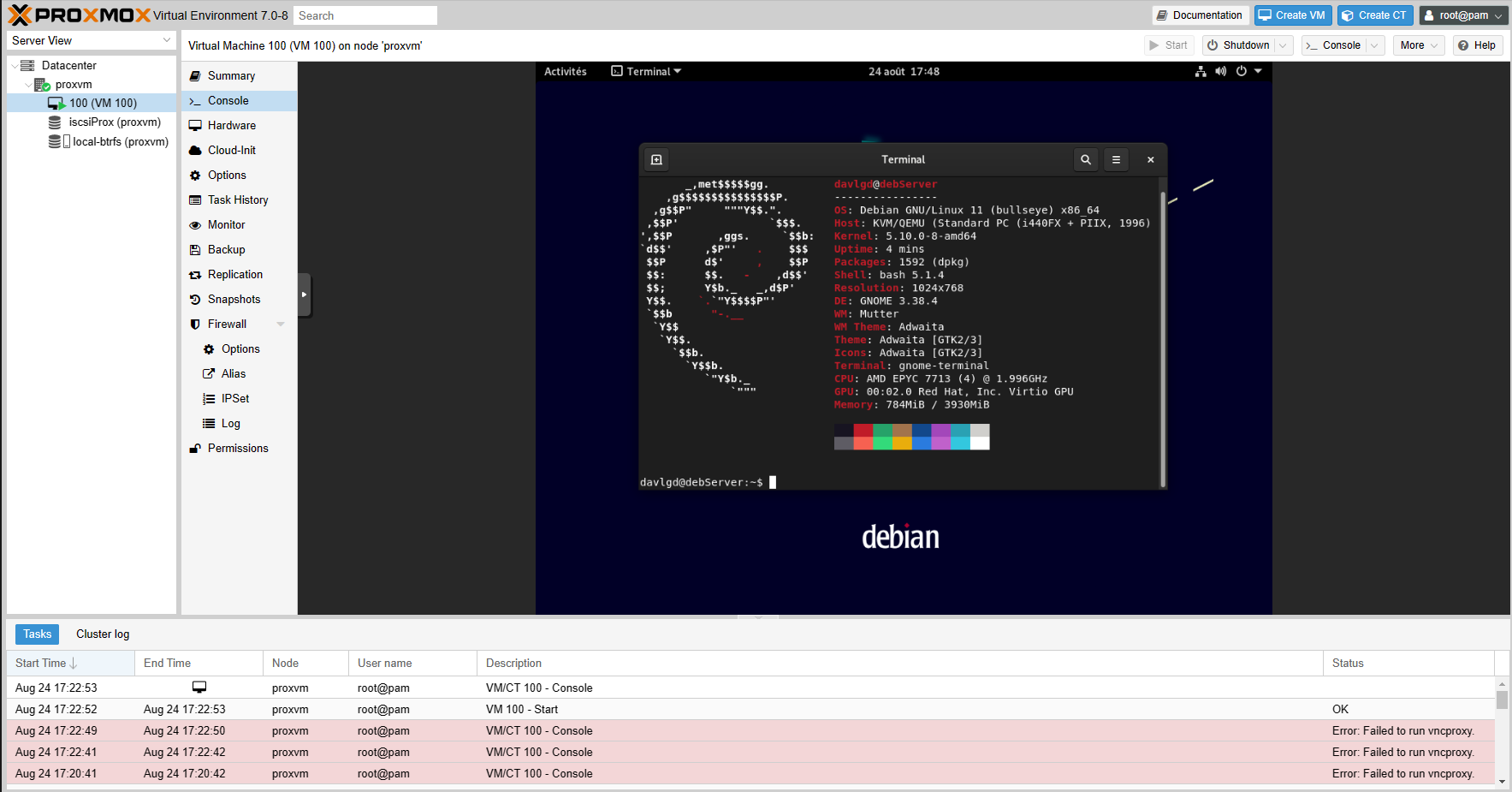

La machine peut avoir ses propres paramètres de Firewall, de Backup, Permissions, etc. L'accès à son interface graphique se fait via l'onglet Console. Par défaut, cela vous donnera un accès noVNC, ce qui vous permet de voir ce qu'afficherait un écran relié à une telle machine. Une fois tous les paramètres validés, rendez-vous dans cette zone et cliquez sur Start en haut à droite de l'interface, la machine démarre.

Vous pouvez alors procéder à l'installation de Debian. Elle se déroule comme pour une machine physique, même pour notre stockage iSCSI qui est vu par la VM comme un disque SCSI local. Une fois la procédure terminée, vous pouvez utiliser le système, via la Console ou en accès distant (SSH par exemple). Vous pouvez aussi installer d'autres machines virtuelles ou des conteneurs. Nous reviendrons d'ailleurs sur leur création dans un prochain article.

Proxmox VE 7.0 : installation sur un serveur et création d’une machine virtuelle

-

Installation sur un serveur

-

Gestion des mises à jour et fonctions de base

-

Téléchargement d'une image ISO

-

Création d'une machine virtuelle

-

Démarrage et installation de l'OS

Commentaires (58)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 25/08/2021 à 06h38

Proxmox est vraiment un produit remarquable, que j’utilise en production sur un cluster à 3 noeuds (Threadripper 2950, 128Go ECC), sous système disque Ceph à haute disponibilité via un segment réseau en 10Gbps. La stabilité est exemplaire. L’interfaçage avec un stockage distribué permet des sauvegardes automatiques.

C’est vraiment un excellent produit, qui justifie sa licence.

Le 25/08/2021 à 06h54

Personne d’autre ne regrette que ce ne soit pas basé sur libvirt ?

Le 25/08/2021 à 07h00

Super article !!

Ça fait un bout de temps que j’ai envie de changer et mettre à jour mon serveur de fichiers à la maison. J’aimerais centraliser un peu tout ça afin de me débarrasser de pleins de petites machines.

J’ai une question de noob surement idiote mais je la pose quand même .

.

Je pensais me servir de mon serveur de fichiers actuel qui est un peu trop puissant pour cette tâche et mettre Proxmox dessus à la place. C’est un boitier rack avec 20 emplacements HDD en façade. J’ai un disque interne pour le système mais je me demande comment est géré le reste du stockage.

Celui ci est géré via des pools ?

J’ai par exemple 16 HDD de 4 To, je peux donc créer des pools en fonction de mes besoins avec tous ces disques ?

Le 25/08/2021 à 07h16

Pour ton usage serveur de stockage + VM, pourquoi ne pas essayer Unraid ? :)

Sinon article intéressant, j’avais testé la V7 pour mon usage “perso” mais je n’ai jamais réussi à passer ma carte graphique à ma VM (une RX480 toujours un peu capricieuse mais bon).

Le produit est tout de même vraiment intéressant, très stable et performant (l’interface peut par contre un peu rebuter :))

Le 25/08/2021 à 07h17

Oui, tu peux gérer tes disques comme bon te semble. Néanmoins Proxmox est un hyperviseur avant tout et donc la gestion du stockage, bien que plutôt bien faite, reste limitée (créer du LVM, LVM-thin, zfs ou directory directement sur une partition). Mais comme le cœur du système repose sur Debian rien n’empêche de se log en SSH (ou sur le shell de l’interface comme le montre l’article) pour aller bidouiller plus finement dans la création de son storage et les exploiter via l’interface après .

.

Le 25/08/2021 à 07h22

Dans l’absolu en utilisant LVM ou ZFS aucun problème pour mettre en place ce type de solution.

Par contre au niveau de l’interface et des outils natif Proxmox l’intégration reste limité, donc faudra probablement passer par le shell et les outils natifs de Linux pour configurer ça comme tu le souhaites.

(edit grillé par Soraphitot)

Le 25/08/2021 à 07h23

J’ai essayé Unraid, il y a un certain temps et je n’avais pas aimé. Mon choix s’est porté sur OpenMediaVault.

Je souhaite regrouper pas mal de chose sur une machine, OMV, Jeedom, …

Le 25/08/2021 à 07h39

Pourquoi ne pas regarder true nass core?

Si l’usage principal c’est avant tout un nas, je partirais plus sur ça (perso c’est ce que je vais faire.

Proxmox je l’utilise quand le but principal c’est la virtualisation.

J’ai deux serveur dédié avec du proxmox, et je vais mettre un true nas core chez moi (ou j’aurais 1 ou 2 vm, dont un proxmox backup en réplication pour avoir les données à l’extérieur de l’hébergeur).

Le 25/08/2021 à 07h47

Truenascaore, c’est le nouveau nom de Freenas ?

En fait, je voulais un peu rationaliser mes ressources car j’ai des Raspberry Pi avec plein de conneries qui tourne dessus (Jeedom, lecteur RSS, …), un NAS Syno, un serveur de fichiers sous OpenMediavault, …

Le 25/08/2021 à 07h47

Mince … On ne peut plus éditer les messages ?

Le 25/08/2021 à 07h48

Pas au bout d’un certain temps, mais ça a toujours été comme ça.

Oui

Le 25/08/2021 à 07h51

Je voulais éditer le message que je venais d’écrire (2-3 minutes).

Le 25/08/2021 à 07h51

Le 25/08/2021 à 07h59

Oui c’est le nouveau nom.

Il y a une version en cours de dev qui sera basé sur debian d’ailleurs.

Et si tu peux éditer mais tu as une durée pour le faire. :)

True nas tu peux normalement faire tourner des vm aussi. Encore une fois tout dépend l’objectif principal.

Si c’est vraiment la virtu, il vaut mieux proxmox et mettre une vm nas dessus.

Si le but c’est le nas, et la virtu basique, l’inverse.

Le 25/08/2021 à 08h15

Il doit y avoir quelque chose qui bloque car le petit crayon n’apparait pas du tout même sur un message que je viens de poster

Le 25/08/2021 à 08h30

Sous quel navigateur?

Smartphone en mode mobile?

Ubloc/adblock actif?

Perso ras ça marche parfaitement sous chromium (ublock désactivé pour nextinpact/inpact hardware)

Le 25/08/2021 à 08h40

Ayant en prod un cluster de 6 Serveur avec PBS aussi pour les backup sur un NAS OpenMediaVault, je ne peux que valider l’efficacité de Proxmox :)

On a en prod aussi un Vsphere avec 4 ESX et du Veeam aussi, ben franchement, c’est 100 fois plus lourd à gérer que du Proxmox VE + PBS…, Y a que le PRA finalement en plus qui vaut le coup ^^

Le 25/08/2021 à 08h59

L’upgrade d’une version 6.x vers la 7.0 n’a pas été testé?

J’hésite actuellement à faire cet upgrade :)

Le 25/08/2021 à 09h00

Pas encore fait non plus.

J’attends encore un mois je pense histoire que ça se décante.

Le 25/08/2021 à 09h03

Tu peux te monter un Proxmox et faire une VM OpenMediaVault, avec accès aux disque en passthrough. Ensuite cette VM sert de serveur NFS/SMB pour tes autres VM et/ou containers LXC :)

C’est ce que j’ai de mon côté et ça fonctionne très bien, en plus de faciliter la gestion (je n’ai qu’une VM pour OMV, le reste ce sont des containers LXC - Plex, Seafile, Pihole, etc).

Pour info ma VM OMV utilise également SnapRaid et MergerFS, ce qui est largement suffisant pour mes besoins et me permet de garder un accès aux données de chaque disques individuellement en cas de besoin. Le seul hic ce sont les perf de NFS en local à cause de l’overhead ajouté par MergerFS :/

Le tout tourne sur une ancienne bécane sans soucis (core i3 8100 / 64 Go RAM / 23 To de stockage sur 5 disques).

Sinon faut que je pense à upgrader mon Proxmox qui est encore en version 6.4, même si ça ne presse pas. Je n’avais même pas fait gaffe que la v7 était sortie.

Le 25/08/2021 à 09h07

Tu veux tester quoi ? Les éventuels problèmes peuvent découler d’éléments spécifiques, que je ne pourrais de toutes façons pas tester dans le processus. Il n’y a pas grand chose à dire là-dessus.

Le 25/08/2021 à 09h07

Fait sur un Proxmox perso à la maison, pas de soucis particulier, le passage en Debian 11 s’est bien passé ^^

Après je déconseillerais de le faire sur une grosse infra en prod, ou en tout cas de bien assurer le rollback si ça foire

J’attendrais perso la 7.1 :)

Le 25/08/2021 à 09h08

Oui, idem, j’attends qu’il y ait plus d’historique et donc de corrections éventuelles.

Le 25/08/2021 à 09h08

SPOF bonjour (Pour une installation perso il peut y avoir une bonne complémentarité entre un NAS où le stockage et certains services sont déportés et un serveur Proxomox d’ailleurs, ce que j’ai fait ici).

(Pour une installation perso il peut y avoir une bonne complémentarité entre un NAS où le stockage et certains services sont déportés et un serveur Proxomox d’ailleurs, ce que j’ai fait ici).

Le 25/08/2021 à 09h10

Je sais bien, ça serait juste une expérience supplémentaire qu’il vaudrait ce qu’elle vaut: une validation sur un cas particulier, comme toutes les autres expériences.

Mais s’il y avait un problème, ça pourrait être un point de vigilance et de vérification pré-migration supplémentaire.

Le 25/08/2021 à 09h13

Pour ceux qui utilisent, il y a beaucoup de ressources/documentations/tuto sur le Web ? Une large communauté ? :)

Car sur Nxi, on découvre souvent l’aspect installation et utilisation basique (ce qui est super), mais on ne va pas dans la profondeur (ce qui est normal).

Du coup, quand on passe dessus pour essayer, on commence à faire “ah c’est cool”, donc on charge un peu la mule, et au premier blocage sur un truc spécifique, au premier message d’alarme, etc… On commence à creuser. Et c’est là que ca peut devenir compliqué si on ne trouve rien sur le Web.

Quand je vois qu’il faut prendre une licence pour accéder au support communautaire officiel, je me dis que c’est pas gagné. Donc avant de tester un peu, je préfère demander :)

Dans un autre domaine, je suis en train de passer de Eyes of Network (qui n’a plus de forum carrément) à Nagios XI. Et bien pareil, accès au forum communautaire pour les licenciés. Donc tu tombes souvent devant le mur “Vous n’avez pas accès a ce sujet avec votre compte”. C’est vraiment rageant même si tu comprends qu’ils doivent gagner leur vie. Après, Nagios c’est moins problématique car justement, large communauté. Mais c’était pour faire le lien avec Proxomox

Le 25/08/2021 à 09h15

Tout dépend le niveau d’info dont tu aurais besoin.

Perso pour l’instant j’ai trouvé toutes les informations nécessaires sur les docs officielles et après on papote sur un topic sur HFR.

Quel style d’installation tu envisagerais? Type pro avec cluster tout ça, ou usage simple d’utilisateur lamda chez soit?

Le 25/08/2021 à 09h18

J’ai jamais eu de soucis pour trouver des réponses à mes questions lorsque j’étais sur certains cas particuliers, c’est basé sur Debian déjà, ça aide à trouver des réponses quand / si tu es bloqué ^^

Le 25/08/2021 à 09h24

Dans un premier temps, juste tester, voir le fonctionnement, découvrir un peu tout. Je connaissais mais je ne m’y suis jamais attardé. Mais si ca convient et que c’est performant, ca pourrait passer en place sur du Pro, et c’est souvent la que ca devient différent… Les besoins et exigences ne sont pas les mêmes.

C’est vrai que c’est un bon point ! (D’ailleurs ce qui me plait aussi avec Nagios Xi sur le sujet évoqué)

Le 25/08/2021 à 09h34

Oui, tu peux affecter tes disques à des pools ou au contraire les mettre en accès direct à une VM qui fait le taf à la place de proxmox.

Je l’ai depuis plusieurs mois, très bien, ça se fait complètement oublier et c’est souple.

Par contre, j’ai tenté de passer de Intel (9500T) à AMD (3400GE sur Asrock x300), catastrophique: perte des SSD en marche au bout de quelques minutes, du coup pour le moment je le conseille sur Intel seulement autour de moi (mais je n’ai que mon expérience là-dessus, quoique je ne soit pas le seul à avoir les mêmes symptômes sur AMD d’après le forum)

Le 25/08/2021 à 09h52

Firefox 91 sous Windows 10, pas d’adblock et je suis au boulot.

Je regarderai ce soir à la maison.

Le 25/08/2021 à 09h53

Si usage simple, ça ne devrait pas être compliqué.

ça reste franchement ultra intuitif et la doc est pas mal faite je trouve. T’as de l’aide dispo pour tous les écrans.

Donc en dehors de cas poussés, nul doute que tu n’auras pas besoin d’aide. :)

Le 25/08/2021 à 12h23

Hello,

J’ai personnellement un HPe Gen8 microserveur légèrement boosté avec un Xeon E3-1270 V2 et 16Gb ram ECC…

Je le fais actuellement tourner avec ESXi 7.0 (boot sur clé USB)

les VM sont stockées sur un SSD 256Gb

Je l’utilise principalement pour une VM Xpenology, et à côté j’ai une VM ubuntu quand j’ai besoin de build certaines bricoles, une VM MacOS BigSur pour le POC…

J’ai une carte LSI HBA en passthrough sur la VM Xpenology avec 4 disques 4To…

Je lis régulièrement des avis sur Proxmox mais je n’ai jamais testé, je trouve l’interface ESXi assez aisée…

Y a-t-il un réel bénéfice de Proxmox comparé à ESXi ?

Le 25/08/2021 à 12h33

J’utilise Proxmox 7.0 sur un mini pc (AsRock 4X4 BOX 4500U) : Ryzen 5 4500U, 16 Go de Ram, SSD PNY CS3030 500 Go; je n’utilise pas d’autres disques ou SSD. Je n’ai que deux VM dessus : une avec openmptcprouter et une autre avec jeedom

Le 25/08/2021 à 12h36

Pour avoir les 2 au taff, je suis plus Proxmox (déjà philosophiquement ^^) que VMware, après pour ton utilisation, je ne pense pas que tu vois une différence entre les 2.

L’interface de Proxmox est plus claire que les ESX je trouve, quand on cherche un paramètre on galère plus dans vmware (et je parle pas de VSphere qui a été conçu par des gens qui détestent l’ergonomie…)

Sachant que si tu connais bien Debian, tu peux largement te débrouiller en CLI, alors que ESX c’est des commandes spécifiques.

Tu veux update ton proxmox: apt update && apt upgrade -y

Tu veux update ton ESX ? non tu veux pas, c’est chiant.

La partie réseau de Proxmox est peut-être plus compliquée à appréhender, moins user friendly que les esx.

Le 25/08/2021 à 12h40

Merci pour les infos.

Je vais suivre le développement du loader RedPill 7.0 pour Xpenology et en fonction de la nécessité ou non de migrer vers Proxmox je ferai mon choix…

Le 25/08/2021 à 12h50

Le principal intérêt pour un usage basique, c’est de pouvoir monter des VM à plus de 8 coeurs vs un ESXi Free, mais sinon, c’est plus des habitudes différentes (Proxmox étant quand même plus complet/souple sur pas mal de points).

Le 25/08/2021 à 12h51

Et ne pas oublier proxmox backup, il n’y a pas d’équivalent gratuit chez vmware…

Le 25/08/2021 à 12h51

Ah oui c’est clairement un SPOF ! Mais j’ai pesé le pour et le contre, renforcé le backup des données “sensibles” (avec backups distants) en conséquence. Ca m’évite d’avoir 40 machines pour des besoins au final assez basiques et de pouvoir faire mumuse.

Mais à terme c’est pas dit que je ne prenne pas un NAS en plus dédié à une partie du stockage :)

Le 25/08/2021 à 12h55

Ça fait 10 ans que j’utilise Proxmox en pro comme en perso. C’est vraiment une super solution meme dans sa version sans subscription.

Bien penser à lire la doc pour le passage à la v7, notamment le passage pour forcer une adresse MAC si besoin, car j’ai perdu le réseau sur mon dedié scaleway qui a un filtrage MAC pour l’IP publique.

A part ça c’est clairement rockstable et je viens de me monter un cluster@home de 2 noeuds + 1 VM quorum (qui tourne sur une autre machine) avec des Dell Optiplex micro en Intel i7-8700 et i5-10500T achetés en seconde main à prix d’or. 64Go par noeud, 1 SSD NVMe 1To + 1 SSD SATA 2To dans chaque et roule ma poule.

Seul inconvenient de ces micro-PC, l’absence de place pour mettre du réseau 10Gb proprement (en gros faut de la NIC USB 3… j’ose pas).

Le 25/08/2021 à 12h57

Oui et non, tu as quand même pas mal d’outils pour le faire, que ce soit via Veem, Synology (de mémoire QNAP le fait ou ça arrive), etc.

Le 25/08/2021 à 13h03

Pour la partie app/vm ça marche bien, mais en VM :

J’ai l’impression que tout ça risque de changer (en mieux) avec TrueNas Scale, vu qu’on repart sur une base Linux.

En app, j’ai un nextcloud et en VM, une ubuntu avec pleins de containers docker, et un Windows 10

Le 25/08/2021 à 14h31

Pareil, je suis passé des NUC à un Optiplex micro en 9500T - à part le problème du peu de disques et de l’USB3 only pour l’extension, c’est génial, on peut se lâcher :)

Je suis en 6 coeurs, j’ai 3 VM et environ 10 conteneurs… Effectivement j’ai vu des 10500T à un peu plus de 300€ sur ebay, j’ai failli craquer.

Le 25/08/2021 à 14h35

Oui, le résultat avec les Ryzen est aléatoire - selon le triplet CM, CPU, BIOS… Mais la majorité fonctionne.

Le 25/08/2021 à 15h25

Faut autre chose à côté, je préfère le truc prévue de base et qui marche au poil.

Et qui permet de faire même des réplications ailleurs donc avoir plusieurs backups facilement.

Le 25/08/2021 à 15h49

Upgrade de 6 vers 7.0 testé sur une infra pro encore en test avant l’upgrade, tout s’est bien passé, sauf la configuration réseau en openvswitch. Le /etc/network/interfaces valide en 6.x ne marchait plus du tout en 7.0 des heures d’énervement pour faire retomber le tout en marche. Et pire que ça un même /etc/network/interfaces qui fonctionnait sur un noeud ne marchait pas sur celui d’à côté (en changeant les IPs évidemment)

Heureusement que l’on n’était pas en prod, même si bien entendu, comme on met à jour noeud par noeud du cluster, la situation n’est pas désespérée.

Le 25/08/2021 à 16h09

Je note le soucis pour Openvswitch merci :) ça me permettra d’anticiper lors de la migration

Le 25/08/2021 à 17h19

Pour moi le plus gros avantage de Proxmox, c’est de pouvoir faire du container LXC à la mode VM.

Un container LXC tourne nativement sur l’OS au lieu d’avoir une couche de virtu qemu lourde. Pas besoin de sur-allouer de la RAM ou du disque.

At home, j’ai 24 containers LXC et 2 VMs qui tournent sur un PVE quad core celeron avec 16Go de RAM.

CPU chargé à 20%, RAM utilisée à 50%, impossible à tenir sur si petite config si j’avais 26 VMs.

Le 25/08/2021 à 17h22

Perso, j’ai eu des droles de comportement avec openvswitch en terme de conso CPU et de stabilité (plus de réseau, tout simplement). N’ayant pas besoin des fonctions avancés que ca propose, je suis revenu sur un basic rock-solid bridge + vlan et ca juste marche.

Bon après, comme dit sur mon commentaire précédent, c’est peut-être lié à ma config celeron + chip réseau realtek.

Le 25/08/2021 à 18h32

Comment ça ? Pour toute solution de sauvegarde il faudra une machine tierce (parce que faire la backup sur la même machine ça n’a pas vraiment de sens )

)

Le 25/08/2021 à 18h36

Oui, effectivement les containers LXC sont vraiment pratiques lorsque tu as besoin de peu de ressources pour un service en particulier :)

Le 25/08/2021 à 20h14

Ah bon. Pour avoir vu les deux, merci mais je reste sous VMWare ^^

Le seul véritable bénéfice à Proxmox est le parefeu distribué, qui est d’une simplicité angélique.

Le 25/08/2021 à 21h10

Pas encore fait mais j’ai lu ce post de blog intéressant : https://blog.zwindler.fr/2021/07/19/les-soucis-que-jai-rencontre-en-upgradant-proxmox-ve-7/

Il y a des points d’attention à avoir ;-).

Le 26/08/2021 à 00h26

Merci pour ce merveilleux article, je decouvre un environnement différent qu’esxi !

Le 26/08/2021 à 08h54

Je vais juste modérer un peu. Le cas du GPU passthrough est aléatoire sur proxmox. Mais c’est aussi lié au support matériel - avec un linux baremetal on y arrive mieux mais souvent à coup de recompilation de kernel. Souvent les tutos proxmox le font sur l’instance hôte directement dans les les fichiers de config.

Pour les autres passthrough: USB et PCIe, ça marche très bien quelque soit la config. SATA, c’est manuel dans le fichier de config de la VM (sauf que ça s’affiche bien dans l’interface Web)

Exemples:

Le 26/08/2021 à 17h30

Je sous entendais d’avoir un nas d’un constructeur ça revenait au final à acheter une solution vu qu’elle est inclue dedans.

Tu ne peux pas non plus recycler une machine en backup etc.

Perso je n’ai pas de nas, j’ai 2 Dédié l’un qui est en prod, et l’autre en backup pour repartir si problème (c’est lui qui fait tourner la vm de proxmox backup et c’est sur lui que je peux restaurer mes vm si besoin).

Et je fais backup répliqué de ce proxmox backup vers une vm chez moi (qui tourne sur une machine recyclée pour ça) pour être sûr que dans le pire cas ou tout cramerait chez l’hébergeur j’ai toujours mes vm.

Le 27/08/2021 à 22h36

Super! Merci beaucoup. Le plus gros point noir pour moi était cette histoire d’adresse MAC.

Le 28/08/2021 à 17h57

C’est justement l’inverse, les container lxc n’ont pas d’overhead de virtu et sont donc plus performante que les VMs. Sans compter le idle qui est réellement idle en lxc