Cartes graphiques : 30 ans d’évolution des GPU

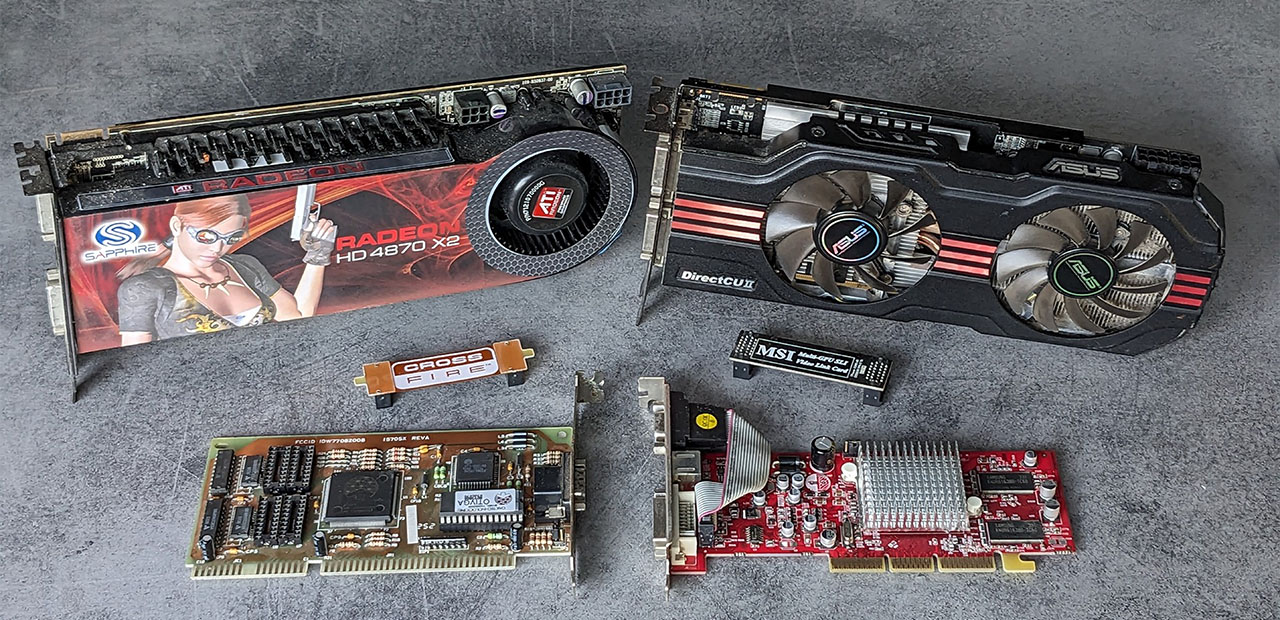

Ha… la bonne époque d’un CF de 4870 X2 !

AMD et NVIDIA se partagent aujourd’hui la part du lion dans le marché des cartes graphiques dédiées. Il n’en a pas toujours été ainsi : d’autres acteurs importants existaient dans les années 80, 90 et début 2000, avant une forte concentration du secteur. Détour par le passé avant de retracer 30 ans d’évolution des GPU, avec une explosion du nombre de transistors.

Le 08 décembre 2023 à 18h10

12 min

Hardware

Hardware

On remonte le temps à une époque où la 3D n’existait pas et les ordinateurs s’utilisaient en ligne de commande ; on est bien avant le premier Windows, dans les années 70 et début 80. Contrairement à AMD et Intel, NVIDIA n’existait même pas : la société a été fondée en 1993 (elle a le même CEO depuis 30 ans : Jensen Huang).

L’affichage n’était donc que 2D, avec des cartes au doux nom de CGA (Color Graphics Adapter), EGA (Enhanced Graphics Adapter) et VGA (Video Graphics Array). On est toujours dans les années 80. Au début des années 90, les premières cartes 3D débarquent, puis des cartes prenant en charge la 2D et la 3D, permettant ainsi de n’occuper qu’un seul emplacement sur la carte mère.

Diamond, Matrox, S3… morts sur-le-champ de bataille

Dans les années 90 et 2000, il existait pléthore de fabricants de cartes. Nous pouvons par exemple citer Matrox. La société s’était forgée une solide réputation dans le monde de la 2D, notamment avec sa Millenium. Elle s’est par la suite lancée dans la 3D, mais sans rencontrer le même succès et a fini par jeter l’éponge.

Il y a eu la Mystique en 1996 (suivi de la Mystique 220 en 1997) qui avait des atouts, mais qui n’a pas résisté à la déferlante 3dfx. Le constructeur a continué sur sa lancée à la fin des années 90 avec des déclinaisons G200, G400, G550, etc. de sa Millenium, sans convaincre. S’il a depuis quitté le marché des cartes 3D pour joueurs, Matrox propose toujours des produits pour les professionnels.

À la même période, STMicroelectronics et Videologic/Imagination étaient aussi présents dans le monde de la 3D avec leurs GPU PowerVR, Kyro et Kyro II. La 3D Prophet 4500 de chez Hercules (testée à l’époque par Hardware.fr) exploitait le Kyro II par exemple. Signalons aussi S3 Graphics avec ses Trio, ViRGE et Savage, Diamond avec ses Viper et Monster, etc. Des noms avec probablement un arrière-gout d’outre-tombe pour certains.

Les Voodoo de 3dfx ont marqué leur époque

Un autre fabricant qui avait défrayé la chronique au milieu des années 90 était 3dfx. À l’époque des cartes 3D « Rage » d’ATI et autre « Riva » de NVIDIA, il proposait ses Voodoo 1 et 2. Ces cartes PCI (pas encore Express) ne faisaient que de la 3D et devaient donc être utilisées en complément d’une carte 2D.

Un câble VGA se chargeait d’établir un pont entre la carte graphique 2D vers la Voodoo. On branchait ensuite son écran sur la Voodoo, qui ajoutait le rendu 3D au signal 2D par une simple superposition. Par la suite, 3dfx a proposé la Voodoo Banshee, qui prenait en charge à la fois avec la 2D et 3D. Aujourd’hui, toutes les cartes 3D gèrent également la 2D. Les Voodoo ont connu un rapide succès et une descente presque aussi rapide.

L’autre avantage des Voodoo était la possibilité de fonctionner en SLI (Scan Line Interleave). Oui, il s’agit bien de la technique utilisée ensuite par NVIDIA pour faire fonctionner de concert plusieurs cartes, sauf que SLI signifiait alors Scalable Link Interface.

Le fabricant jouait aussi les apprentis sorciers en multipliant les GPU comme des petits pains pour tenter de séduire les joueurs : deux sur la Voodoo 5 5500 et jusqu’à quatre sur la Voodoo 5 6000… avec des consommations électriques qui défrayaient la chronique à l’époque.

Fin du game : NVIDIA rachète 3dfx, AMD se paye ATI

Mais ce n’était plus suffisant pour lutter contre les cartes des concurrents de l’époque qu’étaient ATI et NVIDIA. En décembre 2000, NVIDIA se paye finalement 3dfx pour 120 millions de dollars. Quoi qu’il en soit, 3dfx a largement marqué la fin des années 90.

À partir de là, les GeForce et Radeon se sont livrées une guerre sans merci. Les Rage et Radeon étaient tout d’abord des marques ATI, mais cette dernière a ensuite été rachetée par AMD en 2006, pour 5,4 milliards de dollars. La marque ATI n’a pas été conservée, mais la dénomination Radeon oui.

Presque 25 ans plus tard, cette guerre continue de plus belle avec les GeForce RTX 40 chez NVIDIA et les Radeon RX 7000 chez AMD. Pour le moment, aucun autre challenger n’a réussi à se hisser au niveau. Intel s’est bien relancé sur ce marché avec ses cartes graphiques Arc, mais sans s’approcher d’AMD et de NVIDIA sur le haut de gamme.

La folle évolution de la densité des transistors

Avant d’entrer dans le détail de 30 ans d’évolution des cartes AMD et NVIDIA, il est important de préciser un point : nous ne parlons pas des performances dans le cas présent, mais uniquement de l’évolution du nombre de transistors, de la densité par mm² et de la finesse de gravure.

Comme les disques durs et les processeurs, les GPU ont connu une évolution très rapide au fil des années.

Signalons qu’AMD est à la peine depuis des années sur le très haut de gamme, laissant le champ quasiment libre à NVIDIA avec ses GeForce GTX et autres Titan. Sur la dernière génération par exemple, la Radeon RX 7900 XTX joue plutôt dans la cour de la GeForce RTX 4080 que dans celle de la RTX 4090.

Depuis des années, le Texan fait office de challenger et mise principalement sur le rapport performances/prix pour se démarquer. Conséquence directe : des baisses régulières sur les cartes dans les moyen et haut de gamme, là où le caméléon parvient généralement à maintenir le cap jusqu'au lancement d’une nouvelle génération. Dans la majorité des cas, NVIDIA a aussi l’avantage d’avoir une consommation inférieure à performances équivalentes.

Début de la guerre dans le milieu des années 90

Pour en revenir à nos moutons, la course à la 3D a réellement commencé à la fin des années 90 avec la série 3D Rage pour ATI, face aux Riva TNT et GeForce 256 pour NVIDIA. Rouge contre vert, la guerre venait de débuter.

Il n’est pas forcément évident de retrouver la superficie d’un die GPU et le nombre de transistors qu’il contient. En effet, les deux fabricants ne proposent pas d’outils ou de sites dédiés permettant de parcourir l’ensemble des caractéristiques techniques des cartes graphiques depuis les années 90 jusqu’à aujourd’hui. Nous avons donc joué les archéologues dans les actualités des dernières décennies, avec l’aide de la GPU Database de TechPowerUp.

GeForce2 vs Radeon 7200 en 2000

En 2000, les deux concurrents sont au coude à coude. NVIDIA lance sa GeForce2 (GTS, Ti, Pro, Ultra) avec 25 millions de transistors gravés en 150 nm sur un die de 81 mm², soit une densité de 0,3 million de transistors par mm².

ATI (AMD) proposait alors sa Radeon 7200 avec 30 millions de transistors sur un die plus gros de 115 mm² en 180 nm, soit une densité de 0,26 million par mm.

Pour comparaison, à cette même époque, Intel dépassait les 40 millions de transistors sur son Pentium IV en 180 nm, mais avec un die de 217 mm², soit une densité plus faible de 0,18 million de transistors par mm².

Chaque constructeur avance ensuite avec une constante chez les verts et les rouges : la superficie du die augmente avec toujours plus de transistors à l’intérieur. La finesse de gravure augmente elle aussi.

Plus d’un million de transistors par mm² en 2005

En 2005, NVIDIA lance sa GeForce 7800 GT(X), avec 302 millions de transistors gravés en 110 nm, pour une densité s’approchant du million de transistors par mm² (le die mesure 333 mm²). Ce cap sera allégrement dépassé par les GeForce 8800 GTX avec 681 millions de transistors pour un die de 484 mm².

En 2005 également, AMD présentait pour sa part la Radeon X1800 XT/XL avec 321 millions de transistors et une gravure en 90 nm. La superficie du die est de 288 mm², la densité dépasse donc de peu le million de transistors par mm².

Pour comparaison, Intel lançait de son côté les Core 2 Duo et Xeon de la génération Conroe, qui pouvaient contenir jusqu’à 291 millions de transistors et une finesse de 65 nm, mais avec une densité bien plus élevée de 2 millions de transistors par mm².

Les cartes bi-GPU « GX2 » et « X2 »

Dans les années 2000, les deux concurrents ont relancé des cartes graphiques avec deux GPU, un moyen « simple » de doubler les performances, du moins en théorie. Dans la pratique, c'était plus compliqué et les gains n’étaient pas toujours à la hauteur de la hausse de tarif.

NVIDIA a ainsi commercialisé ses premières cartes « Dual » ou « GX2 » avec deux GPU sur un même PCB, dans la lignée des dernières Voodoo. ATI/AMD n’était pas en reste. Il avait, lui aussi, ouvert les hostilités avant l’an 2000 avec sa Rage Fury Maxx intégrant deux GPU. Dans la seconde moitié de 2000, le constructeur a également relancé des cartes bi-GPU avec ses Radeon HD « X2 ».

Ce n’était par contre pas aussi simple qu’on pouvait le penser, comme l’expliquait notre collègue Damien Triolet dans le test de la Radeon HD 4870 X2 : « en pratique, de nombreux obstacles se posent : le routage PCI Express vers chaque GPU, le traçage de 2 bus mémoire distincts, la consommation élevée qui entraîne un étage d'alimentation conséquent ainsi qu'un système de refroidissement adapté ».

Certaines cartes mères proposaient aussi du SLI 3-way et 4-way, avec donc trois ou quatre cartes graphiques sur la même carte mère. On retrouvait la même chose chez AMD sous le nom de CrossFire. Il y a aussi eu des modes de fonctionnement hybride : l’iGPU (GPU intégré à la carte mère ou ou CPU) est utilisé pour la 2D, la carte graphique pour la 3D. But de l’opération : réduire la consommation en 2D en coupant la carte graphique.

Il était même possible d’installer deux GeForce GX2 ou deux Radeon X2 sur une même carte pour les faire fonctionner en SLI ou en CrossFire respectivement, avec donc quatre GPU. Depuis, les fabricants ont calmé leurs ardeurs dans ce domaine.

40 nm et plus de 3 milliards de transistors en 2010

Ni l’un ni l’autre ne parvient réellement à se démarquer en 2010 : les GeForce GTX 480/580 disposent certes d’un peu plus de transistors que la Radeon HD 6970 (3 milliards contre 2,6 milliards), mais rien d’alarmant pour autant, d’autant que les deux cartes sont en 40 nm.

Cependant, AMD dépassait largement NVIDIA sur la densité avec 6,8 millions de transistors par mm² contre 5,8 millions pour son concurrent. Cette fois, on retrouvait les Core de seconde génération chez Intel, avec « seulement » 1,16 milliard de transistors, mais une finesse de gravure plus grande de 32 nm.

NVIDIA et AMD passent tous deux au 28 nm en 2012 avec les GTX 680 et Radeon HD7970. Le 16 nm est ensuite arrivé en 2016 chez le caméléon avec la Titan X (architecture Pascal) et la GTX 1080. La densité grimpe entre 23 et 25 millions de transistors par mm².

La même année, AMD saute directement au 14 nm avec ses Radeon RX480, RX580 puis les Vega, pour une densité de près de 25 millions de transistors par mm².

80 milliards de transistors, la densité dépasse les 100 millions par mm²

2018 était synonyme de 12 nm pour les cartes graphiques grand public des deux ennemis. AMD a ensuite pris les devants en étant le premier à passer sur le 7 nm avec ses Instinct MI50/60 en 2018, suivis par les Radeon VII et RX 5700 (XT) en 2019. La densité explose puisqu’elle passe à 40 et 41 millions de transistors par mm².

NVIDIA dépasse par contre toujours son concurrent sur le plus grand nombre de transistors au sein d’une même puce : plus de 21 milliards sur les Tesla V et V100 avec un die de 815 mm², excusez du peu. Les GeForce RTX et Titan RTX sont en seconde position avec 18,6 milliards de transistors pour une densité de 25 millions de transistors par mm².

Avec sa GeForce RTX 4090, NVIDIA grimpe à 76 milliards de transistors dans 609 mm² seulement, soit une densité de 125 millions de transistors par mm². AMD est en retrait avec 58 milliards de transistors dans 529 mm², soit une densité d’un peu moins de 110 millions de transistors par mm². On est bien loin des 0,1 à 0,3 million de transistors par mm² en 2000.

La valse des renommages

Un dernier point sur ce qui a été pendant un temps un sport national : le renommage. Les GPU de certaines générations sont quasiment identiques. Les GeForce GTX 480/580 chez NVIDIA, les Radeon R9 290X et 390X, ainsi que les RX 480 et RX 580 sont de parfaits exemples : nombre de transistors, taille du die et finesse de gravure sont quasiment identiques. Il y a eu certes des améliorations, mais on ne peut pas non plus parler de générations différentes.

Pire, à défaut d’avoir de nouvelles cartes à présenter, AMD est même allée jusqu’à lancer des Radeon HD 8000 dédiées à ses partenaires (OEM) alors qu’il ne s’agissait que de Radeon HD 7000 renommées. Heureusement, AMD et NVIDIA semblent s’être calmés depuis.

Cartes graphiques : 30 ans d’évolution des GPU

-

Diamond, Matrox, S3… morts sur-le-champ de bataille

-

Les Voodoo de 3dfx ont marqué leur époque

-

Fin du game : NVIDIA rachète 3dfx, AMD se paye ATI

-

La folle évolution de la densité des transistors

-

Début de la guerre dans le milieu des années 90

-

GeForce2 vs Radeon 7200 en 2000

-

Plus d’un million de transistors par mm² en 2005

-

Les cartes bi-GPU « GX2 » et « X2 »

-

40 nm et plus de 3 milliards de transistors en 2010

-

80 milliards de transistors, la densité dépasse les 100 millions par mm²

-

La valse des renommages

Commentaires (32)

Le 08/12/2023 à 18h46

J'ignorais que ce sport a été réservé à la France.

Plus sérieusement, cet article est super.

Le 09/12/2023 à 07h51

Le 08/12/2023 à 19h00

Merci pour l'article.

Le 08/12/2023 à 19h33

Sinon 3dFX plus que la carte c'est le changement radical que ça apporté dans les jeux tant en beauté, immersion et jouabilité !

Souvenir souvenir.

Modifié le 08/12/2023 à 19h34

Modifié le 08/12/2023 à 20h00

Si on parle des GPU, il faudrait tout de même parler d'un des vrais pionniers qui fut le premier à offrir le support OpenGL sur pc et a grandement influencé l'évolution de ce standard. Si on parle de 30 ans d'évolution, il faut citer 3D labs, c'est autrement plus important que Matrox.

Le 10/12/2023 à 13h20

Modifié le 10/12/2023 à 16h58

Le premier GPU grand public reste le GeForce 256.

Le 08/12/2023 à 20h20

Si non je ne me rappelle plus de ma 1ère carte VGA, mieux de mes 3DFx et de l'AGP

Le 08/12/2023 à 20h21

Le 08/12/2023 à 20h36

J'ai commencé avec du ATI en 2005 et je suis en nVidia en 2023.

Car question software ATI en 2005 ce n'était vraiment pas ça. Je ne sais pas si en 2023 les soft made in AMD sont mieux élaborés mais maintenant que je suis chez le caméléon c'est autre chose.

Le 08/12/2023 à 20h55

Le 08/12/2023 à 21h12

Merci Seb de faire encore passer certains lecteurs pour des vieux c*

Le 13/12/2023 à 13h39

Et avant Orchid! (https://en.wikipedia.org/wiki/Orchid_Graphics_Adapter)

Oulala...

Le 09/12/2023 à 00h41

La carte VGA ne date pas de l'époque de la ligne de commande. Elle a fait tourner essentiellement des Windows 3. Petit souvenir ému de ma Tseng Labs ET4000, ça c'était une bonne carte graphique !

La 3Dfx est arrivée quelques années avant les ATI 3D Rage et autres Riva TNT.

Je suis aussi surpris de voir que ça ne parle que de PCI, mais pas un mot sur VLB ni sur l'AGP.

Modifié le 09/12/2023 à 09h42

Cet article a un gros problème car il parle de GPU, mais fait référence à de nombreuses cartes ne faisant pas une accélération des traitement géométriques.

De fait, les cartes accélératrices de première génération comme la Voodoo1, la Virge, les ATI mach, RIVA, TNT et autres sont toutes disqualifiées pour le titre de GPU car elles ne font pas de TCL (transform clipping and lighting) et laissent tout ce travail au CPU.

Les premières cartes accélératrices pour PC pouvant être qualifiées de GPU sortirent en 1995, et étaient équipées de la puce dédiée "Delta" (Geometry Processing Unit) de 3D labs, qui secondait l'accélérateur (Glint, puis plus tard Permedia) de rendu et faisait que la carte graphique pouvait enfin alléger la charge du CPU en finalisant le TCL slope/setup et les conversions FP. En 1997, 3Dlabs présente ses jeux de puces glint DMX et GMX incorporant respectivement les unités GPU delta et son successeur Gamma...

Il fallu encore attendre 2 ans pour que NVIDIA sorte son GPU complètement intégré: le geforce 256 qui mettait la barre un cran au dessus question performances et fonctionnalités, démarrant l'ère du GPU pour PC moderne.

*edit corrigé ... j'étais sûr que le delta datait de 94/95 mais je ne retrouvais pas les preuves, j'ai remis la main sur le manuel de référence de la puce, il est daté de Novembre 95.

*edit, ajout des GMX DMX.

Le 09/12/2023 à 14h44

Le 10/12/2023 à 18h41

Ceci dit, il me semblait que les cartes faisaient le triangle setup, la projection et le calcul d'orientation pour savoir quelle texture mettre, et dans leur majorité le z-buffering.

C'est quand même une bonne aide pour le cpu,même si ça paraît peu aujourd'hui.

Par contre pas trop d'accord avec l'amélioration d'image avec la 3dfx, j'ai eu la mienne sur le tard quand on en trouvait à 500€ des voodoo2, et le lissage tenait de la myopie, les LOD étaient hyper moches, et leur pseudo-22 bits avec le dithering donnait une impression de vieux. Malgré la relative lenteur et la résolution moindre, la carte ATI rage pro avait de meilleures couleurs

Le 11/12/2023 à 03h17

Du côté des cartes centrées sur OpenGl, c'était une autre histoire car le T&L pouvait être délégué à du matériel spécialisé. C'est pour cela qu'au début on trouvait des cartes professionnelles basées sur des chipsets avec une puce pour le T&L, une puce pour le raster, une puce pour la 2D, ... cela permettait de moduler l'offre avec des niveaux de charge cpu différents selon les bourses.

Le 10/12/2023 à 13h25

Le 11/12/2023 à 20h20

Le 09/12/2023 à 10h27

Les perf étaient raisonnables en DirectX, mais mauvaises en OpenGL. De mémoire toujours, c'était assez proche en perf des Matrox Gx00 (qui par contre avait un pilote aux-petits-oignons, avec support du multiscreen 5-6ans avant la concurrence)

Le prb est qu'on avait (déjà) de mauvais drivers chez Intel (je ne suis même pas certain que le pilote OgenGL ait existé en fait), et déjà une difficulté pour Intel à gérer la suite: À l'époque une TNT2 sortait 6mois après la TNT en quasi doublant les perfs.

Je ne suis pas certain qu'il y'ait eu un successeur, le successeur du i740 a fini en chips vidéo pour carte mère, qui indirectement fait que 20ans plus tard on trouve normal d'avoir une partie vidéo dans nos CPUs.

Le 09/12/2023 à 11h00

L'AGP introduit pour cette carte était surtout une occasion pour Intel pour sous-équipper cette dernière question RAM... ce qui était désastreux question perfs dans des jeux qui en demandaient de plus en plus, fait encore aggravé par l'absence d'un support pour la décompression compression de texture.

Vu le nombre de fonctions D3D non supportées, c'était le CPU qui s'en prenait plein la figure.

... et bien entendu, ce n'était pas non-plus de vrais GPU's car aucun accélération liée au TCL.

Le 10/12/2023 à 10h05

Et la i740 était un bon moyen de gamme je trouvais.

Modifié le 11/12/2023 à 11h30

(faudra que je trouve comment mettre un lien un de ces jours...)

Le 12/12/2023 à 15h45

Le 09/12/2023 à 13h36

Moi j'avais réussi à faire marcher une carte Jazz http://www.amoretro.de/2012/03/jazz-adrenaline-3d-3dfx-voodoo-rush-6mb-pci.html sur un power mac G3/266 en PCI à l'époque et faire tourner Unreal dessus. Ma TOUTE PREMIERE claque en terme de graphisme , quand on sort du vaisseau et qu'on arrive sur le paysage....

Modifié le 09/12/2023 à 14h09

Puis de ma TNT2 pour jouer à Quake 3 car les GeForce 2 c'était trop cher.

Quand je repense au fait que je savais choisir les pièces de mon PC puis le monter entre 12-15 ans je suis toujours trop fier 😄

Passer de 4 à 8 Mo ou 8 à 16Mo ram pour jouer à Death Rally.

Le 11/12/2023 à 15h02

merci pour l'article

mes premiers jeux 3d sur pc, grâce à une diamond monster 3d (probablement en 640480, je doute que le 800600 passait) :p

sympa à l'époque

l'étape d'après ce fut une tnt2, ut (99) avait été bluffant en opengl (bien mieux que directx : fluide, probablement en 12801024, alors que dx galérait probablement en 1024768)

par contre je sais plus ce que j'ai eu après dans l'ordi monté en 2003, faudra que j'ouvre la bête pour me rafraîchir la mémoire

la dernière, une radeon hd 5850 et son Go de vram tournent encore pour de petits jeux, mais il va falloir trouver sa remplaçante :s

Le 11/12/2023 à 17h22

Le 11/12/2023 à 17h45

Le 14/12/2023 à 09h57