GeForce RTX 3090 : 36 TFLOPS et 24 Go de GDDR6X sous le capot

Ça envoie du bois

Le 24 septembre 2020 à 13h00

12 min

Hardware

Hardware

Le nouveau « monstre » de NVIDIA est enfin disponible. Annoncée à partir de 1 549 euros, la GeForce RTX 3090 n'est pas là pour attirer les joueurs en mal de FPS, mais bien pour remplacer une Titan RTX tout en étant bien plus abordable. Un produit qui cache un vrai changement de stratégie.

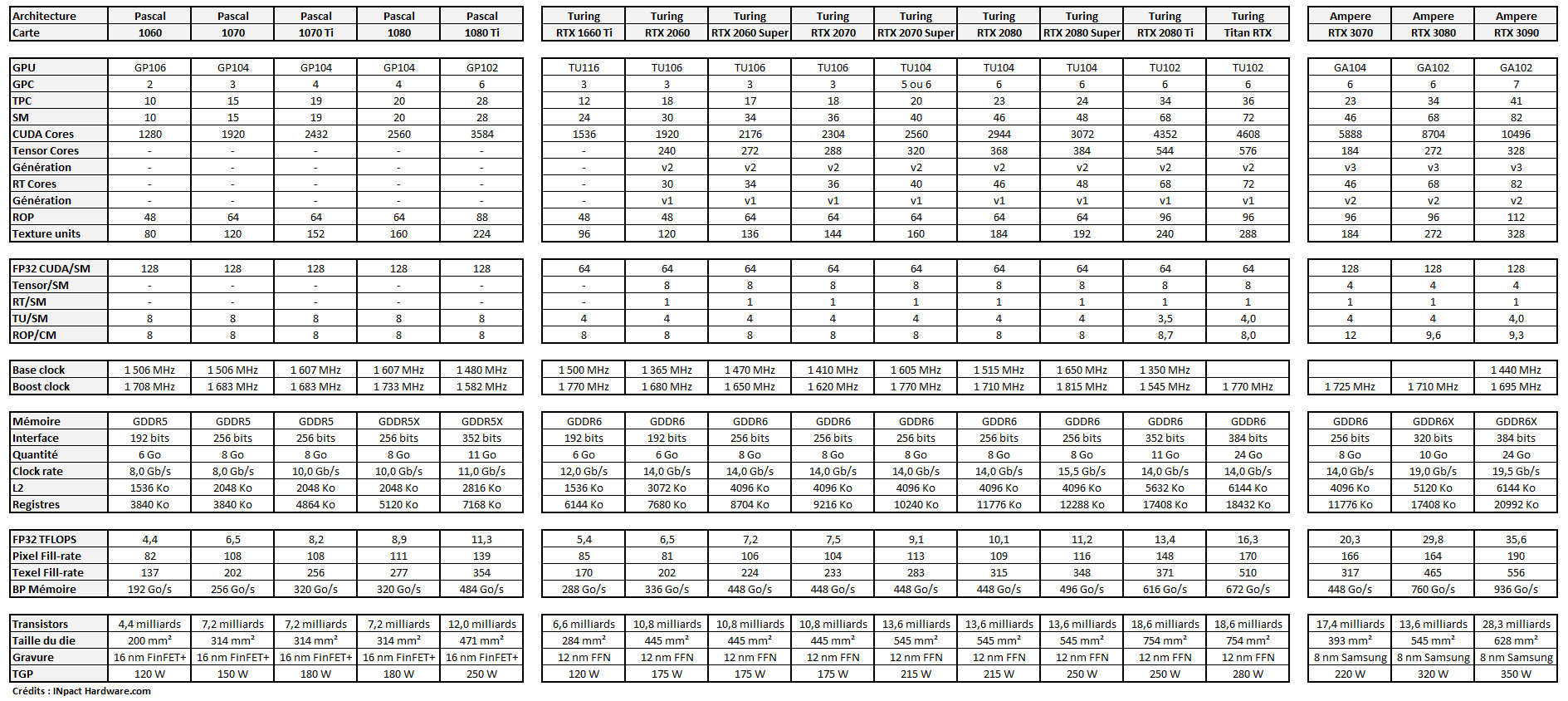

Lorsqu'il a annoncé l'implémentation grand public de son architecture Ampere et ses GeForce RTX de série 30, NVIDIA a dévoilé trois produits : les 3070, 3080 et 3090. Chacune avec ses atouts, ses points faibles et un marché visé.

Une stratégie en trois temps

Toutes partagent néanmoins les mêmes avancées comme l'évolution des RT/Tensor Core, la réorganisation de l'architecture, la montée en fréquence, le doublement des unités FP32, etc. Accompagnées par la gravure en 8 nm, cela permettait à NVIDIA de renforcer son positionnement : plus de performances pour un prix revu à la baisse.

En commençant par la RTX 3080, le constructeur ne s'y est pas trompé. Il a misé sur son « sweet spot » en termes de TFFLOPS/€, avec 10 Go de GDDR6X, et qui dépasse n'importe laquelle de ses anciennes cartes, même la Titan RTX. Le tout pour un prix public de 720 euros. Tout du moins, avant les milliers de commandes et la pénurie qui a suivi.

- GeForce RTX 3070, 3080 et 3090 : Ampere expliqué techniquement et simplement

- Notre analyse de la GeForce RTX 3080 : pensée pour la 4K, reine du rendu 3D

La RTX 3070 suivra ce 15 octobre. Elle s'adressera aux joueurs au budget plus limité, visant plutôt une définition de type 1080p avec un gros débit d'images ou du 1440p. C'est aussi elle qui devrait se retrouver face aux Radeon RX 6000 d'AMD. Restait la question de l'offre haut de gamme, la plus chamboulée avec Ampere.

Une GeForce RTX 3090 plutôt qu'une Titan

NVIDIA a fait un choix stratégique : ne pas proposer de nouvelle Titan. Lors de sa conférence, Jen Hsun Huang a indiqué que Turing avait prouvé qu'il existait un public pour des cartes graphiques très puissantes hors de l'offre Quadro. C'est ainsi qu'est née l'initiative Studio et la focalisation marketing autour des créateurs : ceux qui veulent utiliser leur GPU pour accélérer leurs tâches en rendu 3D, traitement vidéo, calcul, sans dépenser plusieurs milliers d'euros.

Les Titan étaient pensées comme des produits d'exception : proposées uniquement par NVIDIA, entre 2500 et 2 900 euros pour celle de la génération Turing. Désormais dépassée par une RTX 3080 à 720 euros, la question était donc de savoir comment NVIDIA allait s'adresser à sa clientèle cherchant le produit d'exception.

Le premier choix a été de la proposer plus largement, sous la forme d'une Founders Edition, et par le canal plus classique des partenaires. De quoi augmenter les quantités disponibles et assurer sa présence même dans les marchés où NVIDIA ne propose pas de vente en direct. C'est pour cela qu'il s'agit d'une GeForce.

Le second choix a été de rester sur une constitution identique à ce qui faisait la force des Titan : un GPU plus performant sans que les écarts ne soient excessifs, un connecteur NVLink et bien plus de mémoire. Car c'est là tout le secret de cette gamme : elle profite avant tout à ceux dont les usages sont très gourmands en données, comme le rendu 3D massif ou les calculs de type HPC, machine learning, etc... mais pas tant les jeux vidéo.

Mémoire, NVLink et SLI : un nouveau paradigme

La RTX 3080 a eu droit à 30 TFLOPS et 10 Go de GDDR6X. La RTX 3090 à 36 TFLOPS, 24 Go de GDDR6X et un bus dédié NVLink de 3e génération (112,5 Go/s). Tel est le nouveau deal proposé par Jen Hsun Huang et ses équipes : des performances bien plus abordables, mais les caractéristiques « Pro » réservées au plus gros modèle.

Car le Multi-GPU peut désormais passer par le moteur des jeux et les API modernes telles que DirectX 12 et Vulkan. C'est aussi ce qui explique que le SLI ait été mis de côté ces dernières années et peu à peu abandonné par NVIDIA (comme le CrossFire par AMD). Le PCIe 4.0 donne pour sa part des débits doublés par rapport au PCIe 3.0.

Ainsi, ceux qui veulent jouer et faire du calcul auront tout intérêt à miser sur la RTX 3080 et son excellent rapport performances/prix. On pourra même les utiliser par deux sans connexion dédiée. Mais si l'on veut avoir accès à 24 Go de GDDR6X pour satisfaire des besoins professionnels et potentiellement disposer de 48 Go à travers deux RTX 3090 et l'accès unifié rendu possible par le NVLink, il faudra payer le prix fort.

Cela étant, on aura deux RTX 3090 pour à peine plus que le prix d'une Titan RTX à son lancement. Une « subtilité » à côté de laquelle ne passeront sans doute pas les clients concernés.

La carte graphique la plus performante du moment

Il suffit d'une simple analyse pour comprendre que cette solution haut de gamme n'est pas pensée avant tout pour les joueurs. Son tarif est doublé pour un gain de performances théorique de 15 à 20 %. 24 Go n'ont aucun intérêt dans les jeux et n'en auront pas de si tôt. Comme nous l'avons vu avec la RTX 3080, 10 Go suffisent très largement, même en 4K avec l'ensemble des paramètres à leur maximum.

L'histoire nous a d'ailleurs prouvé que le besoin en puissance de calcul évoluait bien plus vite que celui en quantité de mémoire. Ainsi, lorsque 16 ou 20 Go seront réellement nécessaires dans le domaine des jeux vidéo, des GPU à 30/36 TFLOPS ne seront plus vraiment de dignes représentants de l'offre haut de gamme.

Pour autant, la RTX 3090 n'est pas dépourvue d'atouts puisqu'elle séduira ceux qui sont à la recherche de la carte la plus performante du marché et n'ont que faire de son prix. Ils sont peu nombreux, mais c'est un marché qu'un constructeur comme NVIDIA se doit de prendre en compte. Voici nos résultats sous 3DMark :

Comme vous pouvez le voir, les gains sont à la hauteur des chiffres théoriques : de 18 à 20 % en moyenne. Dans les jeux, on retrouve logiquement des chiffres similaires, bien q'un peu moins élevés. Dans un Quake II RTX on trouve 13 à 15 % selon la définition. Dans un Bordelands en 4K on est à 14,7 %. Dans Wolfenstein à 9 %. Tout dépendra comme bien souvent de la charge de calcul du jeu et des options activées.

Le jeu en 8K, déjà possible ?

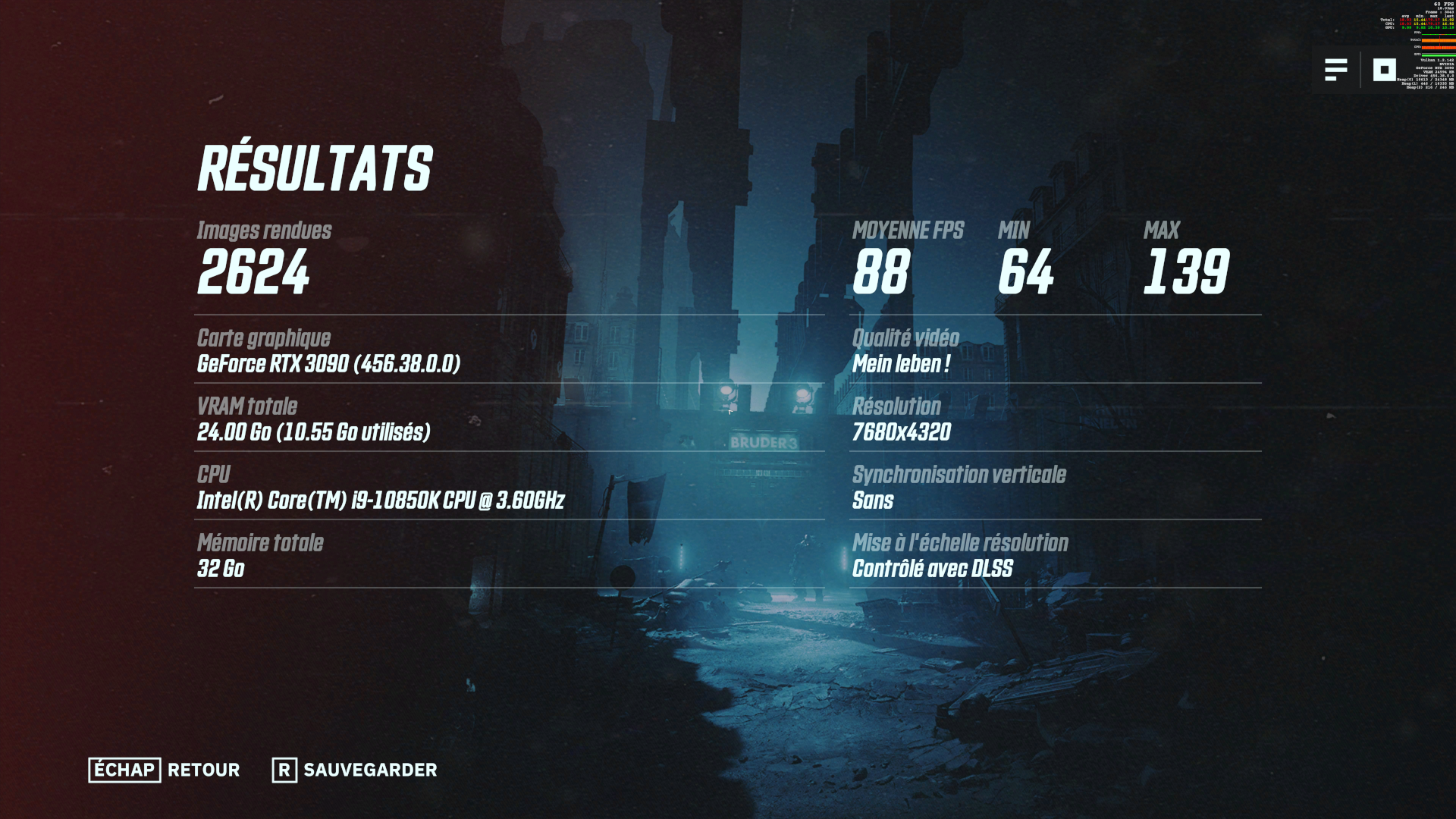

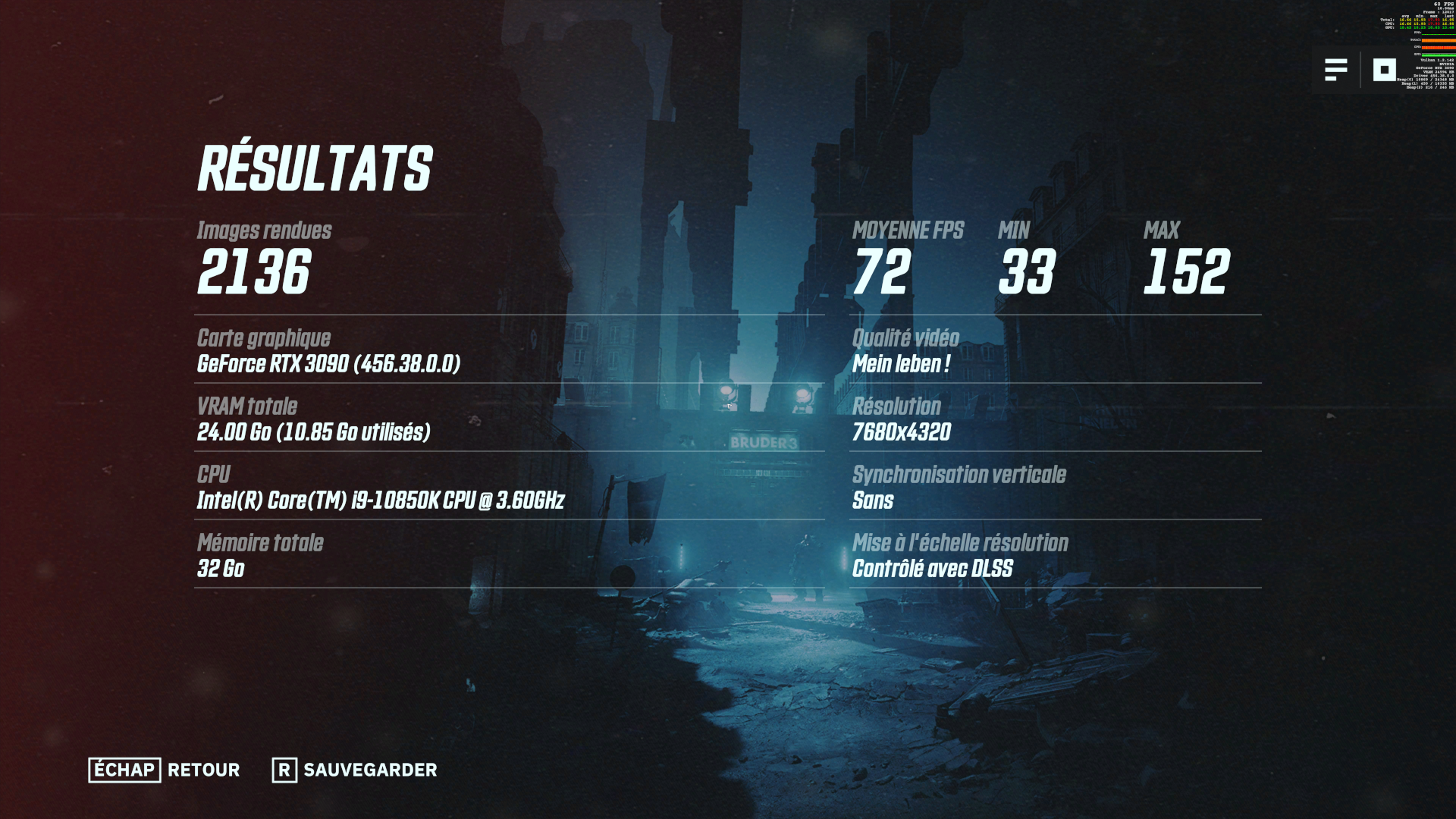

La promesse d'une carte haut de gamme c'est aussi les nouvelles possibilités qu'elle offre. NVIDIA a vanté la capacité de la RTX 3090 pour le jeu en 8K, notamment avec DLSS 2.1 qui gère désormais cette définition. Pour rappel, une image est alors constituée de quatre fois plus d'images que ce n'est le cas en 4K.

Des patchs auxquels nous avons pu avoir accès et qui seront bientôt rendus public permettent d'en profiter dans Control, Death Stranding et Wolfenstein : Youngblood. Ce devrait aussi être le cas de Watch Dogs : Legion à sa sortie. Petite subilité : ce mode de DLSS utilise un rapport de 1:9 pour afficher des performances décentes.

N'ayant pas d'écran 8K, nous avons eu recours à une astuce permise par les pilotes du constructeur : effectuer un rendu 8K affiché en 4K avec le mode DSR (Dynamic Super Resolution) 4x. L'impact estimé par NVIDIA est une perte de performances de 2 à 3 %. Suffisant pour se faire une première idée.

Selon nos relevés, il est effectivement possible de jouer en 8K, parfois même sans DLSS. Mais il faudra encore du temps pour que les téléviseurs à cette définition se multiplient sur le marché. NVIDIA mise pour le moment sur la nouvelle gamme de LG pour vanter les capacités de ses nouvelles GeForce (certifiées G-Sync).

Tests en 8K : Rainbow Six : Siege puis Wolfenstein : Youngblood avec et sans DLSS/RTX - Malgé la 8K : 10,8 Go de mémoire utilisés

36 TFLOPS et 24 Go de GDDR6X : les « Pro » d'abord

Comme nous l'avons évoqué plus haut, la GeForce RTX 3090 intéressera d'abord les professionnels. Pour une raison principalement : la quantité de mémoire qu'elle embarque. En effet, dans certains cas, la question des performances vient après la possibilité de pouvoir ou non charger un modèle et d'effectuer un calcul.

Dans certains cas, le rendu est possible, mais se fait au prix d'une baisse drastique des performances s'il n'y a pas assez de mémoire disponible. NVIDIA nous a ainsi mis à notre disposition une scène Redshift nécessitant plus de 10 Go de mémoire. Résultats : plus de 7 minutes sur une RTX 3080 contre 36 secondes sur une RTX 3090.

Le constructeur met également en avant la possibilité d'activer le rendu du Viewport (le modèle sera chargé en mémoire) dans des applications comme Blender, tout en effectuant le rendu d'une image et d'une scène en parallèle. Disposer d'assez de mémoire permet de ne pas avoir à choisir entre l'un et l'autre, donc de ne pas avoir à constamment désactiver le rendu du Viewport, avec un précieux gain de temps à la clé.

Même chose pour le traitement des vidéos, où certains effets nécessitent parfois de charger de nombreuses images en mémoire, ce qui pourra poser problème en 4K/8K. Autre exemple que le constructeur n'aborde pas, faute de solution simple à mettre dans la main des journalistes : les calculs tels que l'entrainement d'IA et autres solutions de machine learning, où disposer de beaucoup de mémoire est vital.

Des usages qui ne visent qu'un public particulier, mais qui sera sans doute ravi de trouver une solution désormais plus accessible à ses problèmes, tout en étant bien plus performante. Car là aussi, on est aux alentours de 15 % de gain en moyenne par rapport à une RTX 3080, qui doublait ou triplait presque le score d'une RTX 2080.

Une carte qui envoie du lourd (en silence)

Parlons maintenant plus spécifiquement de la Founders Edition que nous avons pu analyser pour ce test. Comme annoncé par NVIDIA, il s'agit d'un modèle imposant. Elle occupe trois emplacement PCIe (53,5 mm), pour un peu plus de 31 cm de long. Elle pèse pas moins de 2,2 kg sur la balance. Mais cela n'a pas que des désavantages.

Son design plus massif permet à NVIDIA d'utiliser des ventilateurs de 10,5 cm plutôt que 8,5 cm sur la RTX 3080. Ils ont donc besoin de tourner moins vite à débit d'air équivalent, ce qui se ressent sur le refroidissement du GPU. Malgré le TGP revu à la hausse (350 watts contre 320 watts), la carte ne fait presque jamais de bruit.

Même dans les quelques cas où nous avions réussi à mettre à mal le ventirad de sa petite sœur, on reste le plus souvent dans les 70/71 °C avec une vitesse de rotation dans les 1200 à 1300 tpm, plus rarement dans les 1500 à 1600 tpm. Si vous poussez la limite de puissance à fond (+ 15 %, près de 400 watts), vous le sentirez par contre passer, et l'on grimpera parfois à 2000 tpm. Vu le gain de performances à espérer, le jeu n'en vaut pas trop la chandelle.

Notez enfin que côté efficacité énergétique, on retrouve à peu près le niveau de la RTX 3080. Nous obtenons 6,85 J/image dans Borderlands 4K (Brutal) contre 6,91 pour la RTX 3090 et 8,26 pour la 2080 Ti. La consommation de la machine à la prise est respectivement de 491, 432 et 348 watts.

Si vous tirez trop sur la corde de l'overclocking, voilà ce qui peut se passer

Si vous tirez trop sur la corde de l'overclocking, voilà ce qui peut se passer

Carte mère, boîtier et alimentation : prévoyez votre coup

Attention tout de même : une carte graphique occupant trois emplacements PCIe ne se met pas dans n'importe quel boîtier et sur n'importe qu'elle carte mère, surtout si vous disposez de plusieurs cartes filles. Privilégiez donc des boîtiers avec un bon flux d'air, de l'espace et une carte mère où le port PCIe x16 ne sera pas collé à celui du CPU. Un conseil qui vaut pour toute carte graphique haut de gamme d'ailleurs.

Du côté de l'alimentation, sachez que nous avons pu faire une partie de nos tests avec notre modèle de 620 watts. Mais comme nous nous y attendions, c'était parfois bien insuffisant. Nous ne pouvons donc que vous conseiller, comme NVIDIA, d'opter pour un modèle de 850 watts avec un tel GPU si vous avez un CPU haut de gamme. Sinon, un modèle de 750 watts devrait être suffisant. Privilégiez des modèles de qualité à bon rendement.

Une carte graphique pour un public particulier

Vous l'aurez compris, comme la gamme Titan avant elle, la GeForce RTX 3090 n'est pas pour tout le monde. Elle n'intéressera que ceux à la recherche du modèle ultime, qui verront dans ce produit un rabais de près de 50 % par rapport à la Titan RTX. Que ce soit pour s'assurer d'avoir le meilleur, où par besoin des 24 Go et du NVLink.

Vous voulez un modèle à prix raisonnable ? Attendez la RTX 3070 ou même la 3060. Vous voulez de la haute performance avec un bon rapport FPS/€ ? Regardez du côté de la RTX 3080.

Bien qu'imposant, le design de ce produit est plutôt réussi. Ses larges ventilateurs et son dissipateur lui profitent clairement. Il est appréciable que même une telle référence, presque excessive par certains aspects, sache rester silencieuse presque en toutes circonstances. C'est aussi ce que l'on attend d'une Founders Edition.

Reste la question de la disponibilité et du prix. NVIDIA a prévenu : malgré les 1 549 euros demandés, même si les revendeurs ont déjà des cartes en stock, il y a fort à parier qu'il n'y en aura pas pour tout le monde. Tout du moins les premiers jours. Si vous êtes dans la cible de ce produit, préparez-vous donc à prendre votre mal en patience.

Les GeForce RTX 3090 des partenaires sont proposées chez les revendeurs dès 1 650 euros.

GeForce RTX 3090 : 36 TFLOPS et 24 Go de GDDR6X sous le capot

-

Une stratégie en trois temps

-

Une GeForce RTX 3090 plutôt qu'une Titan

-

Mémoire, NVLink et SLI : un nouveau paradigme

-

La carte graphique la plus performante du moment

-

Le jeu en 8K, déjà possible ?

-

36 TFLOPS et 24 Go de GDDR6X : les « Pro » d'abord

-

Une carte qui envoie du lourd (en silence)

-

Carte mère, boîtier et alimentation : prévoyez votre coup

-

Une carte graphique pour un public particulier

Commentaires (62)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 24/09/2020 à 13h04

Pour info, certains graphiques sont encore en cours d’intégration, n’ayez crainte, ça arrive

Le 24/09/2020 à 13h11

Merci pour ce test. Effectivement, c’est plus pour les pro. Question naive : vous en faites quoi des cartes ensuite ? vous devez les restituer à nvidia ou certains journalistes/youtubeurs peuvent les garder ?

Le 24/09/2020 à 13h13

ça dépend des cas, sur les FE on les garde souvent au long cours pour référence sur de prochains tests (notamment ce qu’on essaie de faire avec tout ce qui touche à l’IA en ce moment (que je ne désespère pas de finir un jour ).

).

Le 24/09/2020 à 13h14

Tu nous conçois la digitalisation de la Sword?

Le 24/09/2020 à 13h20

Il y a une vague de gros mythos chez les différents revendeurs.

Je voulais acheter la 3090 dès sa mise en ligne soit il y a quelques minutes.

Que ce soit LDLC, Top achat, Mat.net etc..

J’avais même un bout de code pour scripter la commande de A à Z sur Top achat

=> Dès l’upgrade avec les 3090 en db elles se sont affichées en +15 jours.

Il n’y a pas eu de carte chez les revendeurs dispo à la commande.

Vu la politique de distribution et la pseudo indispo organisée, je vais attendre la 6900 XT !

Vive le nouveau concept marketing foireux. En gros ceux qui veulent de la 3080 / 3090 les auront mi-octobre et là, il y aura du stock comme par hasard.

Le 24/09/2020 à 13h20

Mwouai les prix annoncés par les revendeurs sont déjà largement au dessus de ceux donnés par nvidia.

Le délire continue

Le 24/09/2020 à 13h36

La RTX 3070 sera probablement très a l’aise en 4K..

Je jouais déjà en 4K en 2015 sans trop de problème avec une GTX 970 (avec quelques compromis), et très bien aujourd’hui avec une 1660 Ti..

Le 24/09/2020 à 13h39

Très intéressant sur la consommation, mais je ne comprend pas pourquoi une consommation à la prise de 491W ne passe pas sur une alimentation 620W (en imagination une certification 80+ de qualité type Gold ou Platinium)

Le 24/09/2020 à 13h44

Petite question parce que je débarque, Quake 2 en RTX en 4K c’est même pas 50fps avec un monstre comme ça ?

C’est parce que Q2 est particulièrement vorace dans l’utilisation des effets ?

Le 24/09/2020 à 13h46

On le savait déjà que ce serait comme ça pour les prix et la dispo. Moi je suis plus intéressé par la 3080 donc j’attends déjà depuis 1 semaine ;).

@David : Il me semble que pendant la présentation, ils ont vendu aussi la 3090 pour le streaming. Certe, c’est un public très restreint, mais ça me semblait intéressant comme public pour ce genre de produit au vu des différents flux que les PC doivent gérer et des problèmes que l’on voit souvent sur les streams du genre “Ah ben là, c’est un jeu super beau, mais si je le mets à fond, je peux pas le stream à plus de 60 fps”. Qu’en penses tu ?

Le 24/09/2020 à 13h51

NVIDIA donne le tarif des FE, pour les revendeurs et les cartes custom les premiers chiffres montrent que ça fait comme la 3080 (dans une moindre mesure) tout le stock est parti en quelques minutes. Les ventes ont été coupées.

C’est du path tracing complet (donc sur toute la scène). D’où les performances limitées.

Le stream 3090 ou pas ça change rien, le moteur NVENC/NVDEC est identique. Après tu peux stream du 8K/DLSS

Parce que parfois ça consomme bien plus, ça dépend du workload côté CPU.

La 3080 est la seule vraiment à l’aise en 4K. Après 4K/DLSS pour la 3070 sans aucun doute ou dans des jeux pas trop chargés.

Les cartes sont en stock depuis la semaine dernière, tout est parti en moins de 5 minutes chez la plupart des revendeurs qui en avaient d’avance.

Le 24/09/2020 à 14h33

Je joue déjà en 4K Ultra sur certains jeux avec une 2080, le tout en Ultra.

Après, je n’atteins le 60 que dans les jeux bien optimisés comme Doom ou Gears 5.

Moralité, optimisez vos jeux bon sang !

Le 24/09/2020 à 14h42

Q2 a un rendu full ray tracing je crois, ce qui consomme beaucoup plus que d’avoir de “simples” effets RTX sur un rendu plus traditionnel.

Le 24/09/2020 à 14h48

En tout cas, la carte affichée n’est en réalité disponible nulle part… La faute (encore ?) à des pourris qui les ont squatté pour le revendre à prix d’or sur la baie du mal ?

Et les FE ne sont même pas référencées sur les revendeurs “officiels” de nvidia…

Non parce que là, ça commence à bien faire et nVidia devrait faire en sorte de mettre un terme à ces pratiques !

Le 24/09/2020 à 14h55

Edit : A si, j’en ai trouve une dernière chez CDiscount… Une Gigabyte O/C.

Le 24/09/2020 à 15h25

bonjour,

une 3090 qui prend presque 800 euros de plus qu une 3080 pour seulement 10% de perfs en plus pr le gaming c est mort , c est vraiment réservé aux pros ( ou à la limite les grands passionnés utilisant, par exemple, Blender)

Le 24/09/2020 à 15h29

Ps : Pour commencer sur blender j’attend une autre carte qui niveau durabilité/prix me conviendra bien mieux qu une 3080 ^^ et qui surtout sera, je pense, moins cher d au moins 100 euros… (wait and see again )

Le 24/09/2020 à 15h40

Je ne me doutais pas que tu finirais par venir ramener ta science Si c’est ce que tu retiens de cette carte, c’est que cette carte n’est pas pour toi, comme expliqué assez longuement dans l’article. Mais comme de toutes façons tu vas (dire que tu vas) craquer pour une RX 6000, qu’importe ton avis ici

Si c’est ce que tu retiens de cette carte, c’est que cette carte n’est pas pour toi, comme expliqué assez longuement dans l’article. Mais comme de toutes façons tu vas (dire que tu vas) craquer pour une RX 6000, qu’importe ton avis ici

PS : si tu veux faire du Blender, je te rappelle que les Radeon ne supportent Cycles que via OpenCL (qui n’est pas très performant) et que Navi n’a pas été pensé pour le calcul (CDNA est là pour ça). Il faut passer par le plugin ProRender qui est un moteur différent, sans accélération matérielle du RT/Denoising (mais ça devrait changer avec Navi 2 au moins partiellement pour le ray tracing je suppose).

Le 24/09/2020 à 16h03

Pour ce qui est des 10%/Rtx3080 et de son utilité pour les gamers ce n est pas “ ma science “(surtout que j ai pas le matériel nécessaire pour effectuer des tests de cartes graphiques) la mais ce que vos confrères ont écris sur d’autre sites qui en parlaient déjà hier…

Le 24/09/2020 à 16h05

Oui et aussi ce que l’on évoque dans l’article ;)

Le 24/09/2020 à 16h14

Il y a un monde entre le milieu des benchmarks avec les derniers jeux les plus gourmands avec tous les settings à fond et fonctions expérimentales activées, et ce que jouent les gens dans la vraie vie.

À 720 euros, la 3080 est la carte la plus haut de gamme pour les joueurs, la 3090 n’étant pas pensé pour ce marché comme indiqué dans l’article.

Pour un acheteur potentiel “normal” qui se demande si la 3070 sera suffisante pour de la 4K (même sans DLSS), la réponse me semble clairement Oui vu les caractéristiques annoncées (et ça implique probablement des centaines d’euros en moins pour une config).

Le 24/09/2020 à 16h26

Tu dis que la 3070 sera à l’aise en 4K, je te réponds juste que ce ne sera pas le cas. Parce que pour faire une généralité pareille il faudrait que la carte soit capable d’obtenir au moins 60 ips dans de nombreux jeux avec des paramètres élevés. Et la 3080 est la seule à y parvenir pour le moment.

Mais comme dit, si pour toi “à l’aise en 4K” = “ça passe à peu près sur les 2⁄3 jeux où je joue avec des paramètres moyens que ça craint trop”, forcément c’est différent. Ce n’est pas une question de différence entre “le milieu des benchmarks et la vraie vie”. C’est juste qu’on ne peut pas généraliser n’importe comment, sinon on en arrive à “la Xbox One X fait de la 4K (parce que Minecraft tourne en 4K).

Après tu peux conseiller qui tu veux en lui disant que la 3070 sera bonne en 4K, chacun est libre. Mais pense quand même à lui préciser dans quelles conditions, sinon il risque de déchanter. Parce qu’une 3070 c’est une 2080 améliorée. Et s’il veut dépenser moins, outre de préférer une 3070 à une 3080, il pourra préférer un bon écran 1440p à un 4K, ça lui fera des économies au carré ;)

Le 24/09/2020 à 16h32

Juste une question. L’assurance habitation-incendie est incluse dans le prix?

Ce n’est clairement pas une carte pour jouer. Cependant elle est vendue comme telle… L’épouvantail AMD auraient-ils filer la courante aux verts?

Le 24/09/2020 à 16h37

Ce qui me fait rire, c’est que tous les joueurs pros sur des FPS vont recevoir cette carte de leurs sponsors ou bien vont l’acheter et elle ne servira pas à grand chose à par faire la promo pour nvidia.

Suffit de voir leurs configs en jeu, ils mettent tout en low pour optimiser les fps et enlever les effets à la kikoolol.

Mais bon, je ne me fais aucun souci pour nvidia, tous les jeunes demanderont à papa/maman de l’acheter parce que leur joueur préféré l’a et ça leur donnera l’impression qu’ils deviendront meilleurs en jeu.

Le 24/09/2020 à 16h40

Et pour ce qui est de blender ca sera totalement impossible de le faire tourner avec une carte amd ?? dois- je tester d autres logiciels gratuits comme Daz 3D ou autres…

Le 24/09/2020 à 16h42

Non, elle n’est pas vendue comme telle. NVIDIA précise plutôt bien le contexte de ce produit même s’ils évoquent forcément les deux aspects (Jeu 8K/calcul). Personne n’est dupe sur la clientèle de cette carte (sauf ceux qui n’ont que fps/€ comme focus et n’avaient pas lu la fiche de specs).

Par contre j’ai du mal à comprendre la remarque sur AMD. NVIDIA a 80% de pdm du graphique PC, Navi est à peine au niveau des 2080, Navi 2 devrait dans le meilleur des cas dépasser la 3070 (et encore il faudra voir ce que donnera le RT et toute l’évolution de la couche logicielle où NV a quelques points d’avance). Qu’est-ce qui devrait effrayer NVIDIA et quel rapport avec une carte comme la RTX 3090 ?

Par contre, si tu déclenches un incendie avec un PC à 500⁄600 watts de consommation, je t’invite à faire renouveler ton installation électrique ;)

La plupart des outils de rendu 3D se font sur CPU ou sur GPU via CUDA/OptiX vu le travail abattu par NVIDIA sur le sujet depuis une dizaine d’années. Parfois il y a un rendu OpenCL mais ce n’est pas systématique.

AMD propose notamment ProRender comme un palliatif et s’intégrer à certains outils via ce moteur qui leur est spécifique. Comme dit dans le cas de Blender tu peux utiliser le moteur Cycles avec OpenCL (mais c’est lent et Navi n’est pas trop fait pour ça). Ou ProRender qui est proposé sous la forme d’un plugin pour Blender. Mais il s’agit d’un moteur tiers avec son fonctionnement propre.

Daz3D utilise notamment OptiX. Je ne sais pas s’il tire partie des Radeon par contre.

Franchement je pense que le focus sera plutôt sur la 3080, surtout que pour le compétitif, l’important sera de pouvoir profiter de Reflex (ce qui se fait sur toutes les GeForce depuis les 900). Précédemment on avait la Titan RTX, on ne la voyait pas dans toutes les configs de Gamers.

C’est aussi pour ça que ces produits sont excessivement chers avec un fps/€ bien moins intéressant : pour que les joueurs regardent ailleurs et que ces cartes servent à ceux qui en ont réellement besoin. Après il y a toujours des kékés, le marché du gaming n’échappe pas à cette règle (bien au contraire).

Le 24/09/2020 à 17h13

Ok c’est noté , merci beaucoup pour les informations sur Blender ^^

Le 24/09/2020 à 20h19

Les TFLOPS / FPS, c’est une échelle logarithmique ? Car 36 TFLOPS c’est plus que 2 fois les 15 de la 2080 TI et cela ne se retrouve pas vraiment dans les benchs.

Le 24/09/2020 à 21h17

14Go de ram en plus. Les semis-pro et plus vont en être fous.

Et je suis persuadé que cet excès de RAM aide le DLSS a mieux fonctionner à très haute résolution.

Après, si y’en a qui ont trop d’argent pour jouer.. pourquoi pas? C’est pas nvidia qui va les emmerder ;)

Le 25/09/2020 à 02h43

On écrit des papiers détaillés sur les architectures, ce n’est pas pour rien. C’est notamment pour s’éviter ce genre de commentaires ;) Pour rappel, le doublement des unités FP32 dans Ampere s’est fait avec une moitié d’entre elles pouvant être exploitées pour du calcul INT32.

Du coup, dans les jeux on ne profite pas à plein du doublement des FP32. Mais c’est plus le cas lorsque l’on fait du calcul complexe pur, typiquement le rendu 3D. Pour le vérifier il suffit de regarder les scores Blender. Pour le reste, 70% de plus que la 2080 Ti pour la 3090, c’est pas si négligeable ;)

Le 25/09/2020 à 04h09

La photo des RTX 30XX sur les buches de bois, c’est un message subliminale pour dire qu’au pire ça finira par faire un joli feu ?

ou c’est pour comparé la taille du monstre “ vous pouvez la mettre dans une cheminée comme une buche standard “

Le 25/09/2020 à 05h10

Vu que cette carte semble plus destiné aux pros, est-ce que tu as l’information sur les performances FP64, histoire de comparé avec des Quadro existantes et à prix délirant (genre GP100 / GV100) ?

Je n’arrive pas à trouver l’information, et pour des simulations FEA, il me faut du FP64.

Le 25/09/2020 à 06h14

Si tes buches font 30 cm de long, t’as un petit poêle

Comme dit dans les précédents papiers il y a un rapport de 1:64 en FP64 par rapport à FP32. Si tu veux beaucoup de FP64 dédié chez NVIDIA il faut regarder du côté des GPU pour serveurs (donc l’A100 sur la dernière génération).

Le 25/09/2020 à 07h34

Disons qu’ils veulent que la machine ne puisse avoir strictement aucun impact sur leurs performances, donc ne pas prendre le risque d’un drop en FPS, etc.

Globalement tu as raison, les pros sont avant tout des vitrines vivantes, comme dans tous les sports en fait, et c’est ce qui finance la compétition.

Mais c’est vrai que lorsqu’on est bombardé à longueur de journée de vidéos de youtubeurs qui ont des configs de malade, qu’on te vend des écrans 360Hz, ça peut donner l’impression que tous les joueurs vont améliorer leurs perfs avec. Mais là encore c’est exactement comme dans le milieu du sport traditionnel.

Le 25/09/2020 à 08h38

Pour du jeu, y a-t-il (de façon générale) un intérêt, un gain en termes de qualité d’image à faire calculer les scènes avec une résolution supérieure à celle de l’écran pour qu’elles soient downscalées pour l’affichage?

Le 25/09/2020 à 08h46

C’est une boutade j’imagine. C’est comment que ça fonctionne l’antialiasing déjà?

Sur tomshardware ils ont juste parler des 10% de gain dans les jeux pour 900 euros de plus..des vrais stars.

L’intérêt serait de montrer comment la diff de mémoire et le nvlink ouvre des portes dans les logiciels pro et à quelle point elle étends les capacités de calculs par la taille des fichiers qu’elle peut gérer, pour un prix bien inférieur à ce que proposait nvidia avant.

Le 25/09/2020 à 08h52

La 3090 n’est visiblement pas destinée pour les jeux.

Pour la 3080, tu auras besoin d’un écran 4k et d’un processeur ayant un nombre de cœurs suffisant pour profiter des performances de la carte (d’après ce que j’ai compris).

Par exemple, mon PC :

processeur Intel Core i7 5820K Cadencé à 3.30 GHz, Fréquence mesurée (core0): 2.70 GHz

Nombre de coeurs: 6 physique(s), 12 logique(s)

écran : BenQ XL2720Z, Resolution maximum: 1920 x 1080

Une 3080 ne me servira à rien avec cette config d’après ce que j’ai compris, je reste donc avec ma vieille gtx 980 ce qui me suffit pour les jeux auxquels je joue. (FPS et hearthstone).

Le 25/09/2020 à 09h05

La RTX 3080 à un intérêt proche de 0 pour du FHD. Elle est taillée pour la 4K.

Après, niveau processeur, je serais curieux de voir un test avec différents processeurs en 4K.

Je suis pour l’instant, persuadé (peu être a tord) que les perfs seront similaires (+/- 5%) Entre un vieux i5 7600K et les derniers modèles de chez intel ou AMD.

Car en FHD, c’est forcement CPU Limited.

Le 25/09/2020 à 09h21

Il y a eu des tests ici : https://www.tomshardware.com/features/nvidia-geforce-rtx-3080-ampere-cpu-scaling-benchmarks

Globalement à moins de jouer en 4k il faut un CPU très haut de gamme (et pour jouer en 4k aux RTS il faut de toute façon un CPU haut de gamme vu le nombre d’éléments à afficher à l’écran - mon vieux Phenom x4 9850 ramait à l’époque sur Starcraft II avec des dizaines de Zerglings, 8 Go de RAM et une GeForce 970 recyclée).

Le 25/09/2020 à 09h25

Attention : avoir une carte qui ne s’exprime pas à plein régime en 1080p (parce qu’on est dans un scénario CPU bound) ne veut pas dire qu’elle ne sert à rien. La 3080 reste bien au-dessus des modèles précédents (voir notre test), mais les écarts sont moins importants.

Le 25/09/2020 à 10h05

Merci pour le lien, je n’avais pas trouver avec une recherche rapide.

Cela confirme mes impressions, en 4K TAF, un monstre de puissance n’est pas nécessaire.

Hors jeux ayant une grosse utilisation CPU comme des RTS effectivement.

Ce n’est pas idéal effectivement, mais tout ce que ce situe au dessus d’un i7 de 2016 fera l’affaire. Et de nos jours, il commence a y avoir un paquet de ref.

N’étant pas abonné, je n’ai pas (encore?) pu lire l’article en entier. Cela dit, les test que j’ai pu lire annoncent tous un “plafond” de FPS en 1080p. Dans ce cas, quel intérêt de prendre une 3080 face a une 3070 par exemple ? Pour passer de 144 fps à 160⁄240 ?

J’ai été excessif avec le “sert à rien” mais sur le fond, je pense qu’il y a peu d’intérêt par rapport a une 2070S/2080S pour du 1080p

Le 25/09/2020 à 10h10

Euh … c’est exactement ce que j’ai dit, une 3080 n’est utile que si tu as un écran 4k, ce qui n’est pas mon cas.

Le 25/09/2020 à 10h20

Oui, on est d’accord :)

Le 25/09/2020 à 10h23

Pour le moment elle est la plus utile sur les écrans 4k, mais dans le futur ( 4- 5 ans) elle sera probablement à la traîne en 4k et très bien pour le 2k. J’ai une 970, taillé pour le 1080 et je ne peux presque plus rien lancé avec dans cette résolution…

Le 25/09/2020 à 10h43

Avoir ce genre de cartes (3080⁄3090) nécessite des périphériques compatibles hors de prix si on veut profiter pleinement des capacités de la carte.

Rien qu’un écran 4k 144 hz, rien à moins de 900 euros.

Et je doute que tout le monde possède ce genre d’écran chez lui.

Bref, ces cartes seront utiles dans quelques années quand le prix du matos compatible aura baissé (pour les particuliers).

Le 25/09/2020 à 10h50

Oui ça améliorera l’image. L’effet le plus visible, c’est que ça fait un très bon filtre antialiasing et un très bon filtre anisotrope. Mais de manière générale, la qualité de l’image sera plus net, moins d’effet de scintillement et tout problème dû à la façon dont est calculé la 3D….

Dans certains jeux, tu peux trouver une option genre “échelle de rendu”. Cette option permet de modifier la résolution initiale du rendu 3D (tu peux donc choisir une résolution supérieur qui sera downscaler ou une résolution inférieur qui sera upscaler) sur lequel l’UI 2D sera rajouté (ça ne correspond donc pas exactement à mettre à une résolution différentes)

Après, dans la réalité, il faut se l’avouer, ça coute trop cher en ressource pour le gain obtenu. Ca va avoir plus d’intérêt pour des rendus pré-générés.

Le 25/09/2020 à 11h02

J’ai deux 3K 100hz c’est top mais pas donné il est vrai dans les 800€ ils doivent être mon cher maintenant je pense .https://shop.hardware.fr/fiche/AR201809120135.html ils sont très bien pas les meilleurs mais top quand meme

Le 25/09/2020 à 11h17

L’Asus est pas mal, mais c’est vrai que c’est pas donné (450 euro)

https://www.lesnumeriques.com/moniteur-ecran-lcd/asus-tuf-vg27aq-p54127/test.html

Le 25/09/2020 à 11h25

Et c’est pas un écran 4K

Le 25/09/2020 à 11h39

Je ne sais pas lire effectivement ^^

Le 25/09/2020 à 11h54

Si c’était une question de plafond, tu auras la 2080 (Ti) au niveau de la 3080, ce n’est clairement pas le cas, même en 1080p (à moins d’avoir des paramètres graphiques super légers, mais là ça devient un bench de CPU ;)).

Comme dit, les écarts sont moins importants mais existent. Une 2080⁄3080 tu as un écart moyen de +70%. En 1080p en moyenne tu es à 35% (hors RTX/DLSS dans les deux cas, avec c’est plus). L’écart est moins élevé, mais il est là. Une 3070 sera toujours en dessous d’une 3080 (et heureusement).

Mais quand tu changeras d’écran, la 3070 montrera ses limites, pas la 3080. C’est un choix surtout à faire en fonction de ses besoins et de son rythme d’équipement (et du reste de la machine, forcément avec un Core i3/Ryzen 3, une 3080 c’est un peu du gâchis pour le jeu )

)

Le 25/09/2020 à 12h42

très bon article, bravo David_L (faut remercier des fois quand c’est largement mérité).

Ayant la “chance” d’avoir une 3080 actuellement et une 3090 ce weekend, je pourrai comparer pleinement la différence (sur un écran Samsung G9 mais bloqué à 120/165Hz à cause d’une mauvaise gestion pilote / firmware à priori) entre les 2 cartes.

Mais bravo encore en tout cas.

Le 25/09/2020 à 13h04

Tu vas faire des jaloux (et merci pour l’article

(et merci pour l’article  )

)

Le 25/09/2020 à 18h20

Ok, merci.

Je suis en double 4k, avec un CPU 8⁄16. Et ce n’est pas la 3090 qui m’intéresse de toutes façons, bien trop chère pour pas beaucoup d’intérêt pour moi. La 3080 sera suffisante, et même, c’est pas pour tout de suite, mais plutôt dans 1 à 2 ans, donc, ça risquerait même d’être la génération suivante :)

Le 25/09/2020 à 21h03

Bonjour,

petite suggestion de bench,

Boundary il a l’air magnifique et très gourmand :

https://www.surgicalscalpels.com/rtbenchmark.html

Le 26/09/2020 à 08h25

C’est l’un des benchs officiels poussés par NVIDIA. Mais bon sur le fond ça ne changera rien à la nature des résultats relevés. Comme je le dis souvent, on peut faire 200 benchmarks, mais quand c’est pour relever 200x le même résultat c’est surtout une perte de temps.

Il ne faut jamais oublier une chose : si les sites font des benchmarks sur beaucoup de jeux avec 1 page par jeu, c’est uniquement pour le référencement dans les moteurs de recherche, Google étant notamment friand de ce genre de trucs. Pas pour la finesse de l’information fournie.

Le 26/09/2020 à 15h32

Je ne savais pas du tout ça. Merci de l’info !

Le 26/09/2020 à 16h14

Des infos sur les problèmes de condensateurs ?

Le 26/09/2020 à 16h25

Oui, EVGA a confirmé que c’était un souci des samples presse corrigé pour les modèles définitifs commercialisés. Je continue de monitorer, mais j’attends qu’on y voit clair plutôt que de reprendre toutes les âneries qu’on voit ici ou là (parce que le clic, et qu’il faut bien s’occuper d’ici au 15 octobre).

Le 29/09/2020 à 06h44

j’entends toujours EVGA pour des problèmes sur les NVIDIA ventilo condo alimentation etc je me demande si y a un site qui référence les taux de retour/panne des CG par marque comme les disque dur

Le 29/09/2020 à 07h01

Non, pas de manière fiable. Seuls les revendeurs ont ces infos et refusent en général de les partager.

Le 29/09/2020 à 19h08

Apparemment MSI aurait sorti des v2 de ses cartes.