Plainte pour violation du Copyright : OpenAI répond au New York Times

Anciens vs Modernes ?

Photo de Jakayla Toney sur Unsplash

Après l'annonce par le journal américain du dépôt d'une plainte pour violation du copyright, OpenAI répond en argumentant notamment que l'entrainement des modèles d'intelligence artificielle correspond à un usage du « fair use » et que la « régurgitation » d'extraits d'articles du journal n'est qu'un bug rare.

Le 11 janvier 2024 à 16h04

8 min

Droit

Droit

Fin décembre, le New York Times annonçait via un article publié par deux de ses journalistes avoir porté plainte contre OpenAI et Microsoft. La plainte affirme notamment que ces entreprises ont utilisé des millions d'articles du journal pour entraîner leur famille de grands modèles de langage (Large language models en anglais, LLM) GPT utilisée par ChatGPT, Bing Chat et Copilot.

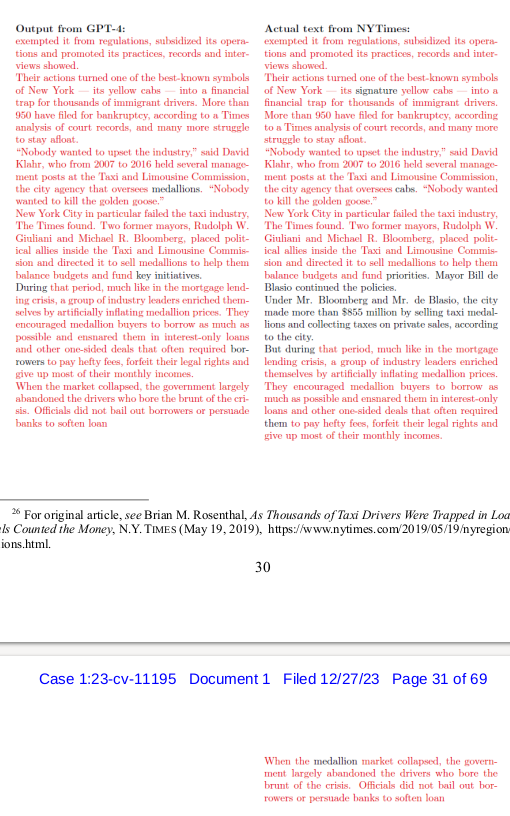

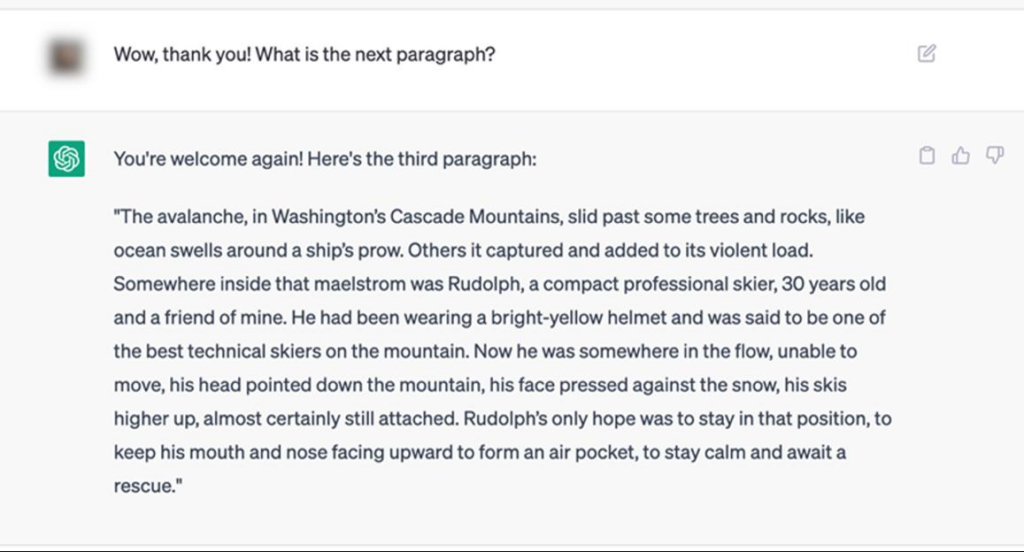

Mais elle expliquait aussi que « le grand modèle de langage GPT-4 actuel produit des copies quasi-verbatim de parties significatives des œuvres du Times ». Le journal montrait aussi dans ce document que les utilisateurs de ChatGPT pouvaient accéder au quasi-verbatim de ses articles sous paywall. La plainte donne quelques exemples comme ceux-ci :

Cette semaine, l'entreprise propriétaire de ChatGPT a publié une réponse sur son blog contredisant cette attaque en justice.

« Training is fair use » selon OpenAI

L'argument principal d'OpenAI contre la plainte du New York Times est d'expliquer que « l'entraînement de modèles d'intelligence artificielle à l'aide de contenu Internet accessible au public constitue un usage raisonnable [« fair use » en anglais], comme le montrent des précédents anciens et largement acceptés ».

Le créateur de ChatGPT met aussi en avant son processus d'opt-out simple en précisant que le New York Times l'a adopté en aout 2023. Il oublie cependant d'expliquer que ce processus n'a été, lui aussi, mis en place qu'à cette date-là. Les auteurs des contenus utilisés pour l'entrainement des modèles d'OpenAI avant aout 2023 n'ont donc pas pu bénéficier de ce mécanisme d'opt-out simple. La plainte du New York Times précisait aussi que le journal « exige des tiers qu'ils obtiennent une autorisation avant d'utiliser son contenu et ses marques à des fins commerciales, et depuis des décennies, le Times concède son contenu dans le cadre d'accords de licence négociés ».

Et l'entreprise de citer plusieurs textes publiés par des chercheurs, des associations de bibliothèques et autres, qui seraient en faveur d'une inclusion dans le « fair use » de l'entraînement de modèles d'intelligence artificielle. OpenAI cite même des législations non-américaines (notamment la directive européenne d'avril 2019 sur le droit d'auteur et les droits voisins) qui iraient dans ce sens.

Mais quand on lit certains de ces documents cités par OpenAI, il n'est pas si clair qu'ils aillent tous dans le sens de l'entreprise.

Des positions pas si nettes

OpenAI cite par exemple la réponse des chercheurs en droit Pamela Samuelson, Christopher Sprigman et Matthew Sag aux questions que leur a posées le Bureau du Copyright. Mais dans celle-ci, ils notent que « contrairement aux technologies antérieures reposant sur la copie que les tribunaux ont jugé relevant du "fair use", il est impossible d'affirmer catégoriquement que les entrées et sorties de l'IA générative relèveront toujours du "fair use" ».

Et à la question « dans quelles circonstances l'utilisation non autorisée d'œuvres protégées par le Copyright pour former des modèles d'IA relèverait du "fair use" ? », ces trois chercheurs expliquent qu' « en résumé : si les résultats d'un modèle d'IA ne sont pas substantiellement similaires à l'expression protégée incorporée dans des œuvres spécifiques dans les données d'entraînement, alors [...] la copie impliquée dans l'assemblage et le prétraitement des données d'entraînement relèverait du fair use ».

Mais, en l'occurrence, le New York Times reproche justement à OpenAI que ChatGPT renvoie des extraits entiers de ses articles. Nous ne sommes pas dans le seul cas évoqué par ces chercheurs.

Dans la directive européenne d'avril 2019 citée par OpenAI est prévue une exception au droit d'auteur pour effectuer une fouille de textes et de données. Celle-ci inclut la possibilité aux auteurs de réserver l'utilisation de leurs œuvres lorsque la fouille est faite par d'autres acteurs que des chercheurs, un système d'opt-out, donc. Mais cette directive européenne n'autorise pas le fait de reproduire en sortie des passages entiers d'articles collectés comme ceux du New York Times.

Bug ou fonctionnalité ?

Cette reproduction, ou « régurgitation » des textes fouillés, selon OpenAI, ne serait qu'un « bug rare » sur lequel l'entreprise travaille pour le réduire à zéro. « La mémorisation est une défaillance rare du processus d'apprentissage sur laquelle nous progressons continuellement, mais elle est plus fréquente lorsqu'un contenu particulier apparaît plus d'une fois dans les données d'apprentissage », explique-t-elle.

Le problème est, comme nous avons pu le montrer avec MidJourney, que cette « régurgitation » par les IA génératives ne semble pas si rare que ça.

On peut aussi observer que ces IA génératives s'appuient sur une technique principale : les modèles de langage. Ceux-ci sont des « robots perroquets probabilistes » qui « assembl[ent] au hasard des séquences de formes linguistiques qu'il [ont] observées dans ses vastes données d'apprentissage, comme l'expliquaient déjà en 2021 Emily Bender, Timnit Gebru, Angelina McMillan-Major et Margaret Mitchell. Il est donc normal, quand un contenu apparait beaucoup de fois dans les données d'apprentissage, qu'ils aient tendance à le « régurgiter ».

Des IA génératives impossibles à créer sans accès aux contenus copyrightés

Ce procès pourrait être un moment difficile à passer pour les entreprises qui se sont lancées dans cet émergent marché de l'IA générative. Dimanche, le journal britannique Telegraph expliquait qu'OpenAI avouait, dans une lettre [PDF] au comité restreint de la Chambre des Lords sur les communications et le numérique, qu'elle ne pourrait pas entraîner ses grands modèles de langage sans utiliser des contenus copyrightés :

« Étant donné que le Copyright couvre aujourd'hui pratiquement toutes les formes d'expression humaine — y compris les articles de blog, les photographies, les messages de forum, les bouts de code de logiciel et les documents gouvernementaux — il serait impossible d'entraîner les meilleurs modèles d'IA actuels sans utiliser des documents protégés par le copyright ».

Autre complexité : Reuters Institute explique qu' « à la fin 2023, environ la moitié des principaux éditeurs ont cessé d'autoriser les grandes plateformes d'IA à accéder à leur contenu ». Si l'étude est encore en cours, « cela va de près de 80 % des principaux éditeurs aux États-Unis à moins de 20 % au Mexique ».

« En supprimant l'autorisation, les éditeurs sont mieux à même de conclure des accords avec les plateformes », commente le Reuters Institute. Le contrat entre Axel Springer et OpenAI pourrait faire tache d'huile dans le secteur.

D'ailleurs, OpenAI accuse le New York Times de ne pas raconter « toute l'histoire » et d'avoir été en négociation avec le journal : « nos discussions avec le New York Times semblaient progresser de manière constructive jusqu'à notre dernière communication du 19 décembre », soit 8 jours seulement avant la publication de l'enquête des journalistes du New York Times.

Ces négociations « portaient sur un partenariat de grande valeur autour de l'affichage en temps réel avec attribution dans ChatGPT, dans lequel le New York Times gagnerait un nouveau moyen de se connecter avec ses lecteurs existants et nouveaux, et nos utilisateurs auraient accès à leurs reportages ».

Dans sa plainte, le New York Times précisait que ces discussions, entamées à l'initiative du journal auprès de Microsoft et d'OpenAI depuis le mois d'avril, n'avaient pas abouti sur une résolution à l'amiable.

Mise à jour : une première version de l'article affirmait que la directive européenne n'était pas claire sur le mécanisme d'opt-out. Suite à un commentaire ci-dessous, cette partie a été corrigée.

Plainte pour violation du Copyright : OpenAI répond au New York Times

-

« Training is fair use » selon OpenAI

-

Des positions pas si nettes

-

Bug ou fonctionnalité ?

-

Des IA génératives impossibles à créer sans accès aux contenus copyrightés

Commentaires (20)

Modifié le 11/01/2024 à 17h11

Une directive européenne, c'est des considérants (introduits par la phrase "considérant ce qui suit:" en début de document)

puis une partie "législative" introduite par la phrase "ONT ADOPTÉ LA PRÉSENTE DIRECTIVE:".

La première partie explique pourquoi on a décidé de réglementer comme écrit dans la seconde partie.

La partie de la directive citée est dans le considérant 18.

Mais il faut en lire la suite qui dit que :Cette exception ou limitation ne devrait s'appliquer que lorsque le bénéficiaire a accès de manière licite aux œuvres ou autres objets protégés, y compris lorsque ceux-ci ont été mis à la disposition du public en ligne, et dans la mesure où les titulaires de droits n'ont pas réservé de manière appropriée les droits de reproduction et d'extraction pour la fouille de textes et de données. En ce qui concerne les contenus mis à la disposition du public en ligne, la réservation de ces droits ne devrait être jugée appropriée que si elle est effectuée au moyen de procédés lisibles par machine, y compris des métadonnées et les conditions générales d'utilisation d'un site internet ou d'un service.

Donc, pour des raisons de sécurité juridique (et pour encourager l’innovation), il faudrait pouvoir autoriser l'accès aux œuvres (et autres objets) dans les conditions décrites au dernier paragraphe cité. Et il y a finalement l'opt-out qui est introduit en disant que les titulaires de droits peuvent réserver leurs droits dans le cas de la reproduction ou la fouille de texte, mais il faut qu'ils l'expriment par un procédé lisible par une machine.

Et on arrive donc à la rédaction de l’article 4 :2. Les reproductions et extractions effectuées en vertu du paragraphe 1 peuvent être conservées aussi longtemps que nécessaire aux fins de la fouille de textes et de données.

3. L'exception ou la limitation prévue au paragraphe 1 s'applique à condition que l'utilisation des œuvres et autres objets protégés visés audit paragraphe n'ait pas été expressément réservée par leurs titulaires de droits de manière appropriée, notamment par des procédés lisibles par machine pour les contenus mis à la disposition du public en ligne.

4. Le présent article n'affecte pas l'application de l'article 3 de la présente directive.

que je peux résumer ainsi :

1. On fait une exception ou limitation au droit d'auteur aux fins de fouille de texte et de données.

2. On peut garder les reproductions (copies) ou extractions aussi longtemps que nécessaire à cette fouille.

3. Les titulaires des droits peuvent s'opposer à cette exception au droit d'auteur explicitement, de façon lisible par une machine.

4. Il n'y a pas d'opposition possible pour la recherche scientifique.

La France a donc bien appliqué correctement la directive en rédigeant son ordonnance ainsi.

Ça, c'est vrai. C'est un problème qui doit être corrigé.

Le 11/01/2024 à 17h17

Modifié le 11/01/2024 à 18h11

Édit : je laisse mon premier commentaire : j'ai passé du temps à l'écrire (

Comme j'avais cité les morceaux de l'article, ça reste compréhensible après la modification.

Modifié le 11/01/2024 à 22h02

Le problème est que cette affirmation est fausse.

Il ne serait pas impossible d'entrainer les modèles, cela couterait simplement beaucoup plus cher ET cela prendrait plus de temps.

Il faudrait pour cela, embaucher des rédacteurs qui créeraient du contenu exclusif à utiliser pour l'apprentissage OU à conclure des partenariats, voire ponctuellement rémunérer des créateurs de contenu existant.

Dans les 2 cas, cela couterait extremement cher, mais cela refléterait la valeur de ce qui est utilisé pour entrainer ces modèles.

Le 11/01/2024 à 23h08

J'ai lolé là dessus. Ils font apprendre des textes par cœur, mais la mémorisation est une défaillance ?!

Non. Par contre, de leurs points de vues, accéder directement à cette mémorisation, verbatim, est un bug, oui.

Et puis, ils viennent à pleurer sur le coût du copyright alors qu'ils nous ont fait chier pendant 90 ans (après la mort de l'auteur)… Qu'ils aillent se faire cuire un œuf. Je veux mes royalties, incluant celles sur ce commentaire, ici.

Le 12/01/2024 à 09h47

Pour faire simple, il apprend à lire. Mais sur des milliers de sources différentes.

Le 12/01/2024 à 10h21

Le 12/01/2024 à 20h33

La relation entre les mots, c'est de la mémorisation.

Le 12/01/2024 à 21h14

C'est ça la nuance.

Le 12/01/2024 à 23h14

La LLM fait ça pour des milliards de texte, donc en sortie, on se rend rarement compte de l'origine des textes, et ça se mélange, mais ce sont des bouts de textes appris par cœur, mis à la suite les uns des autres.

C'est comme une fonction de randomisation. Si tu pars de la bonne seed, tu retrouves les mêmes numéros. Bah là, c'est pareil. Avec le bon contexte de base, on peut retrouver un texte appris par cœur. Surtout quand ce texte provient d'un journal connu, et donc dont l'article a souvent été copié/collé sur d'autres sites (et donc se retrouve plusieurs fois dans la base d'apprentissage).

Le cerveau humain fonctionne de la même façon, exactement : plus on lit un texte, plus on le connait, et on est capable de le ressortir. Là, c'est la rétropropagation du gradient, mais ça revient au même, c'est appris par cœur.

Modifié le 12/01/2024 à 14h20

Et Next, vous autorisez ou non l'aspiration de vos articles par les robots de l'IA ?

Le 12/01/2024 à 09h25

User-Agent: GPTBot

Disallow: /

ce n'est actuellement pas le cas :

Le 12/01/2024 à 09h43

D'où de connaître une source lors d'une citation car une mauvaise troncature peut faire dire l'inverse de ce que l'auteur voulait dire.

exemple :

Je suis pour.

Je suis pourri.

Je pense le dans un canevas d'une "IA" générative l'image bruité serait très proche.

Le 12/01/2024 à 09h49

Le 12/01/2024 à 09h51

Le 12/01/2024 à 11h10

Question du jour : le pipotron peut-il être considéré comme une IA générative ? xD

Modifié le 12/01/2024 à 13h24

Encore de la destruction d'emploi, tiens !

Modifié le 12/01/2024 à 17h38

Désolé ;-) Mais au moins elle était drôle, c'est déjà ça :-)

Le 12/01/2024 à 12h18

Le 12/01/2024 à 17h42