Sur Azure OpenAI, les images générées par DALL-E ont désormais un filigrane

Le 25 septembre 2024 à 09h56

2 min

IA et algorithmes

IA

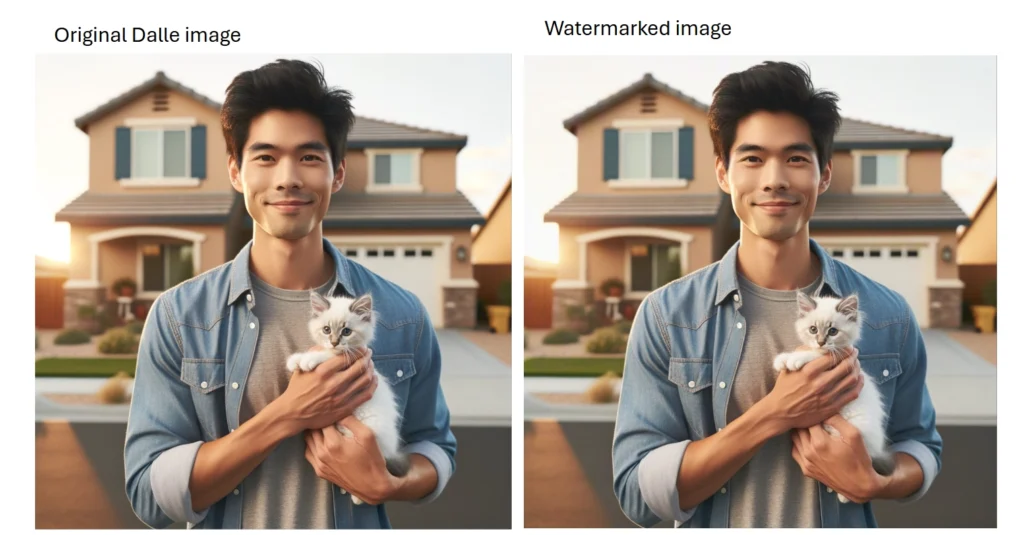

Microsoft a commencé l’année dernière à insérer des filigranes dans certains contenus. Le processus a démarré avec les voix générées par Azure AI Speech, présenté lors de la conférence Ignite 2023. L’éditeur passe à la vitesse supérieure avec les images générées par DALL-E dans Azure OpenAI.

Le filigrane, disponible en préversion, comporte des informations réparties dans plusieurs champs. Dans « Description », on trouve ainsi la mention « AI Generated Image ». « softwareAgent » contient la valeur « Azure OpenAI DALL-E » pour attester de sa provenance. Quant à « When », il comporte l’horodatage de la création du contenu.

Ces informations sont insérées dans un manifeste faisant partie intégrante de l’image. Ce manifeste est signé cryptographiquement par un certificat remontant jusqu’à Azure OpenAI. Le filigrane est invisible à l’œil et n’est pas altéré par des opérations comme le redimensionnement ou le recadrage.

Impossible bien sûr de ne pas penser à des techniques simples comme la capture d’écran pour récupérer le contenu sans son filigrane. Toutefois, l’objectif est d’abord d’assurer une circulation de confiance entre un nombre croissant d’acteurs.

Microsoft travaille pour rappel au sein de la Coalition for Content Provenance and Authenticity (C2PA) avec des partenaires comme Adobe, Arm, Intel, ou encore la BBC et la plateforme de vérification Truepic.

Le 25 septembre 2024 à 09h56

Commentaires (10)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousModifié le 25/09/2024 à 10h34

Le 25/09/2024 à 13h49

L'IA permettra potentiellement de ne modifier que certains détails d'une vraie photo.

C'est bien qu'il soit possible de certifier ou non qu'un contenu vient d'une IA.

L'idéal serait une interface/API de validation d'images générées qu'on puisse solliciter directement depuis les navigateurs/applis.

Ca permettrait au législateurs d'imposer potentiellement l'affichage d'un avertissement sur ces contenus.

Le 25/09/2024 à 15h49

Le 25/09/2024 à 18h07

Voulais-tu dire : "C'est bien qu'il soit possible de certifier qu'un contenu vient ou non d'une IA." ?

Le but recherché est que les images générées ne soient pas utilisées pour nuire (deep fake, fake news, etc.) mais tous les systèmes d'IA ne mettront pas l'info, entre autre les systèmes que l'on peut faire tourner chez soi et qui sont libres. En plus, il sera toujours possible de supprimer ces filigranes numériques en générant une autre image quitte à passer en bitmap avant de réencoder (c'est mieux qu'une copie d'écran qui ne se fait pas à la même résolution).

Il est évident que ce qui veulent nuire utiliseront ces solutions pour éviter ces filigranes et c'est automatisable.

On aura donc des images générées par IA qui permettront de savoir qu'elles l'ont été et d'autres qui ne le diront pas. Sur ces dernières, on ne saura rien de sûr sur leur génération.

On ne pourra pas certifier que des images ne sont pas générées par IA.

Ces procédés sont donc ridicules parce qu'ils donnent une fausse impression de sécurité.

Modifié le 26/09/2024 à 14h05

Voulais-tu dire : "C'est bien qu'il soit possible de certifier qu'un contenu vient ou non d'une IA." ?[/quote]

Oui

Le 25/09/2024 à 14h17

Le 25/09/2024 à 18h20

Généralement, une image comporte plus de points qu'affichés à l'écran. Faire une copie d'écran, donc d'une bitmap plus petite va perdre l'information qui était codée dans le codage jpeg de l'image. J'aurais tendance à dire que même à résolution identique, le fait de recompresser l'image (en jpeg par exemple) avec de paramètres différents de la compression initiale va aussi faire disparaître le contenu du filigrane.

Le 25/09/2024 à 21h34

Modifié le 26/09/2024 à 13h29

Avec les techniques de reconnaissance d'image actuel, ça ne devrait pas être complexe de retracer l'origine d'une image si déjà tous les "pro" enregistré/certifié leurs images sur différentes BDD de certification.

Ainsi tous les GAFAM pourrait déjà récupérer directement l'origine/la source de chaque fichier pour l'afficher...(ils le font déjà très bien pour les ayant-droit en photo comme en vidéo, à peine posté sur youtube, la moindre image/musique va t'afficher directement le possédant des droits).

Le 29/09/2024 à 15h44

« Le problème, c’est que Google fait remonter cette image de champignon générée par IA sans préciser qu’elle l’est, alors que la banque d’images Freepik d’où elle est issue, elle, “l’indique clairement comme telle”. »