Aux États-Unis, le danger des arrestations sur la seule foi d’un résultat algorithmique

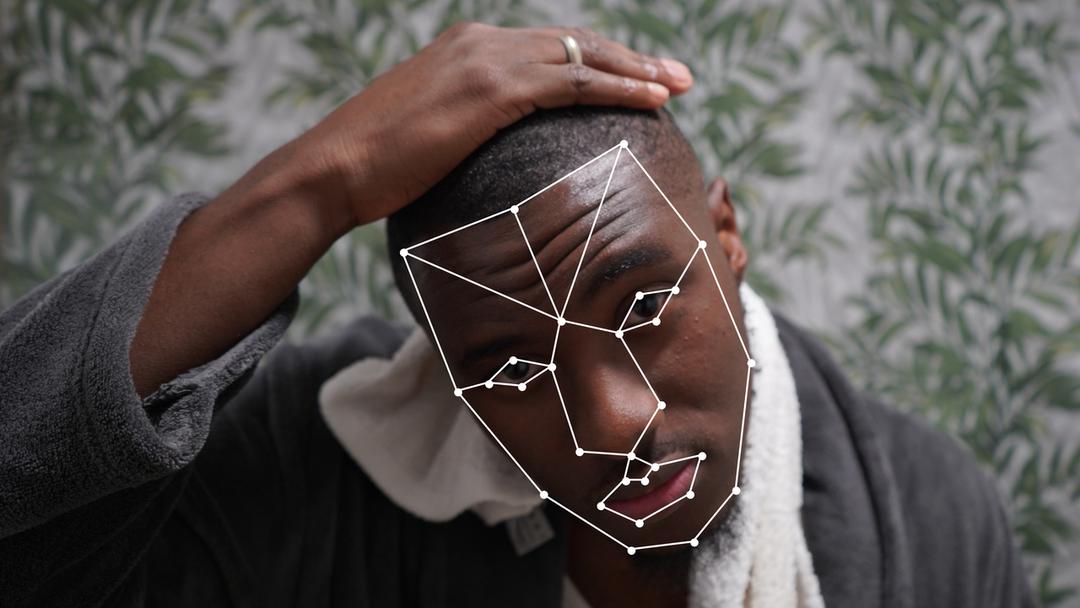

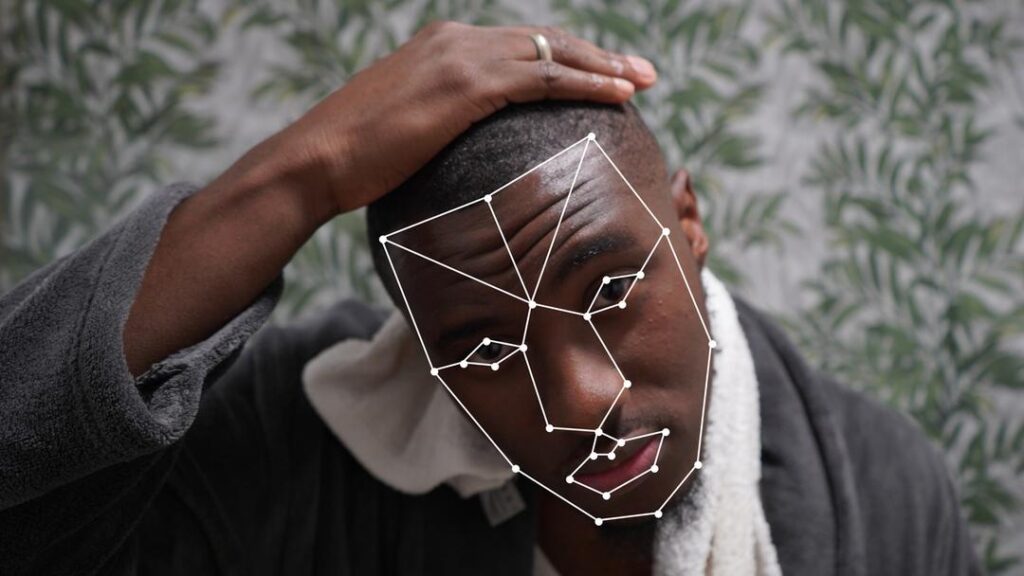

Mirror B – Comuzi – Better Images of AI

Le 23 novembre 2023 à 06h52

3 min

IA et algorithmes

IA

Cet automne, un homme nommé Randal Quran Reid a été arrêté pour deux fraudes à la carte bancaire qu’il n’avait pas commise. Le mandat n’indiquait pas qu’il était devenu suspect sur la foi d’une recherche par reconnaissance faciale, via le contrat de la police de Louisiane avec Clearview AI.

Reid ne l’a compris qu’une fois six jours passés en prison, et des milliers de dollars dépensés en frais d’avocat : c’est l’avocat en question qui a entendu un officier évoquer une « correspondance positive » avec le voleur, et compris l’erreur d’identification.

En 2019, une étude du National Institute of Standards and Technology, une agence fédérale américaine, constatait que les systèmes de reconnaissance faciale faisaient des erreurs d'identification des visages noirs et asiatiques 10 à 100 fois plus souvent qu’avec les visages caucasiens. Les femmes et les personnes âgées étaient aussi moins bien reconnues que la moyenne.

Les promoteurs de ces technologies notent que, parmi les millions de recherches effectuées par la police, très peu ont conduit à des arrestations injustifiées (à l’heure actuelle, au moins six cas sont documentés : cinq ont concerné des hommes noirs, un, une femme noire). Mais, interroge le New Yorker. combien l’ont été sans que l’erreur ait été identifiée ?

Dans les affaires en question, pointe le média dans une longue enquête, les forces de police américaines ne se sont souvent reposées que sur les résultats de ces machines algorithmiques, quand bien même les preuves de leur efficacité manquent.

Pourtant, les officiers expliquent en général ne pas avoir à informer les personnes suspectes qu’elles le sont devenues sur la foi d’une identification automatique. Motif : ces identifications ne sont théoriquement que des pistes qui doivent mener à des enquêtes plus longues.

L’un des problèmes que posent ces technologies, explique l’avocate Clare Garvie, est qu’elles sont entourées d’« une sorte de mystère ». Pour ses usagers, par exemple policiers, difficile de savoir « comment elle fonctionne », mais « on sait que des gens beaucoup plus intelligents que nous l’ont créés ».

Cette vision participe à renforcer la confiance dans les résultats fournis par la machine, au risque, dans le cadre policier, de passer outre des vérifications plus approfondies.

Le 23 novembre 2023 à 06h52

Commentaires (17)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 23/11/2023 à 08h33

Modifié le 23/11/2023 à 08h54

Je ne voulais pas te répondre spécialement cela dit, juste recharger ma page sans cache ^^'

Edit : Ctrl Entrée pour valider le commentaire ne semble pas fonctionner cela dit

Le 23/11/2023 à 08h56

Après, il manque les notifications après réponse à un commentaire. 😥

Le 23/11/2023 à 09h55

Mais pour le coup, c'est pas une régression, c'est une amélioration, ça peut attendre un peu plus

Modifié le 24/11/2023 à 00h39

Même avec des articles à 0 ou 1 commentaire, ça recharge la page. Peut être que l'équipe de dev a vu ça et c'est dit que ça ne servait pas réellement

Je te rejoins sur les notifs, ça me semble pas déconnant.

Je sais qu'il y a le GH pour les issues, mais ça serait top d'avoir la liste des features validées et mises dans le pipe par l'équipe de dev

Edit : pouvoir discuter facilement (via les comments ou les issues GH) est un vrai plus pour la communauté, c'est top :)

Le 23/11/2023 à 09h01

Ben surtout que ces "vérifications plus approfondies" , lorsque que ce ne sont "que" des noirs (et on sait "qu'ils se ressemblent tous, hein") , et devant la pression du chiffre , ben.... ça pèse pas lourd.

Et ça ajoute un déni plausible pour la police : "Mais la Machine l'a désigné coupable, nous on est moins intelligent qu'elle , on peux quand même pas s'y opposer ?" .

Et ce même si la "machine" a donné une correspondance à xx% ...

Parfois l'informatique sert aussi d'excuse à l'inaction & l'indifférence (et pas que dans le cas de l'article)

Le 23/11/2023 à 12h09

C'est le coupable tout trouvé depuis 2 décennies.

Le 23/11/2023 à 09h15

Avant les outils de reconnaissance faciale, les arrestations pouvaient se faire sur une vague ressemblance ou au hasard pour faire du chiffre

Le problème reste donc le même: ici seul l'outil change.

Le 23/11/2023 à 11h36

Mais oui, 6 jours en prison pour 2 fraudes à la carte bancaire avant le jugement ça me semble déjà dingue.

Du coup, j'ai cherché un peu, et il y un article qui donne plus de détails (et c'est dingue)

La fraude c'est pour l'équivalent de 15 000$

Il a passé 6 jours en prison par ce qu'il devait être extradé vers la Louisiane (état duquel venait les mandats, et un état où Randal n'a jamais été)

L'algorithme a donné 3 noms suite à la recherche, le policier aurait émis un mandat pour les 3 noms.

Le policier qui a fait l'arrestation en Géorgie ne savait pas pourquoi les mandats étaient émis (il savait juste qu'ils existaient).

Et la meilleure, pour obtenir sa libération ses avocats ont "juste" envoyés de multiples photos de Randal au service de police qui a émis le mandat ...

J'aimerai bien voir une comparaison entre le suspect et Randal ...

Le 23/11/2023 à 13h17

Ici, cet aspect a été négligé. Pour mon marteau, toute cible est un clou. Que ce soit un clou, une vis, ou un crâne humain. Je ne peux me dédouaner d'avoir fracassé la tronche de mon voisin parce que j'ai eu confiance dans le discernement de l'outil.

(exemple volontairement caricatural, mais l'idée est là)

Modifié le 23/11/2023 à 15h10

Surtout quand on sait que les noirs sont arrêtés plus souvent aux USA

Dans l'ensemble, les Noirs américains sont arrêtés à 2,6 fois le taux par habitant de tous les autres Américains

Clairement que le policier qui a sorti 3 mandats par ce qu'il a eu 3 résultats est un idiot et il aurait été possible d'améliorer les choses (tout en restant imparfait) en demandant à la police responsable de l'arrestation de vérifier si le suspect correspondait bien à la photo d'origine.

Pour l'analogie du marteau je ne suis pas convaincu que ça fonctionne dans ce contexte. L'utilisation de la reconnaissance faciale était justifiée, l'interprétation du résultat beaucoup moins.

A la limite ... il avait un clou, il a utilisé une masse pour l'enfoncer et il s'étonne que le mur soit démoli.

Le 24/11/2023 à 12h01

Le flic qui a émit 3 mandat, il sait bien que au moins 2 sont des faux positifs , donc que potentiellement 2 innocents vont passer 6 jours en taule et devoir dépenser des frais d'avocats pour se "défendre".

Il en a juste rien à foutre. parce que ce sont "juste" des noirs et parce que, lui, ça lui simplifie la vie (et justifie une action auprès de sa hiérarchie).

Il ne sera pas sanctionné pour ça.

Si il avait émis ce mandat et que, pas de bol, l'une des cible avait été quelqu'un de haut placé avec de l'influence, il se serait fait défoncer professionnellement parlant.

Pour moi le problème dans cette histoire c'est surtout ça : Quand tu sais que tu ne risques rien à pourrir la vie de gens que tu méprises, bah.... pourquoi te priver ? C'est généralisable chez nous aussi :-/

Le 23/11/2023 à 09h17

Le 23/11/2023 à 10h30

Le 23/11/2023 à 11h40

Ensuite, on va automatiser l'arrestation des personnes, et la surveillance automatique en prison, puis l'automatisation du travail forcé qui s'en suit... Oh wait

Le 23/11/2023 à 12h54

La référence pour les plus jeune:

https://www.imdb.com/title/tt0088846/?ref_=nv_sr_srsg_0_tt_8_nm_0_q_brazil

Modifié le 23/11/2023 à 15h00

Les autorités publiques confient des outils aux forces de police. Les forces de police les utilisent.