AMD annonce ses Radeon RX 7900XT(X) : un air de Zen et un zeste d’IA, dès 899 dollars

La bataille du GPU est enfin sérieuse !

Le 04 novembre 2022 à 08h33

6 min

Sciences et espace

Sciences

Après les GeForce RTX de série 40 de NVIDIA et les ARC Alchemist d’Intel, c’est au tour d’AMD de lancer ses cartes graphiques de nouvelle génération. Deux modèles haut de gamme seront disponibles dès le 13 décembre, leurs premiers atouts ont été dévoilés à l'occasion d'une conférence en ligne.

Si les CPU d’AMD ont révolutionné le marché depuis l’arrivée de l’architecture Zen, la réussite de la branche GPU du constructeur a toujours été plus mitigée. Il faut dire que l’entreprise fait ici face à un NVIDIA plutôt en forme, qui ne cesse de se développer et de faire évoluer ses produits, tant à destination du grand public que des entreprises.

Et la situation ne va pas en s’arrangeant pour le père des Radeon, puisqu’Intel est récemment entré dans la danse, espérant sans doute se tailler une place de numéro 2 d’ici quelques générations. Il fallait donc que les RX 7000 détonnent et marquent les esprits. On en connaissait déjà les grandes lignes, puisqu’AMD avait déjà indiqué travailler sur une architecture « chiplet », a fait de l’augmentation du cache sa marque de fabrique et a précédemment introduit certaines fonctionnalités dans sa gamme CDNA pour serveurs.

La composition des nouvelles Radeon, exploitant une architecture RDNA 3, est donc une évolution en profondeur tout en affichant une certaine continuité. Deux premiers modèles sont attendus pour le 13 décembre prochain : les Radeon RX 7900XT et XTX, pour 899 dollars et 999 dollars respectivement. Le message est donc clair : AMD ne se focalise pas sur l’entrée/milieu de gamme pour le moment (où se développe Intel) mais continue de s’opposer frontalement à NVIDIA qui lancera bientôt ses GeForce RTX 4080.

Chiplets et cache massif

Pour le moment, tous les détails de la nouvelle architecture n’ont pas été donnés. Mais que sait-on de ces cartes et de RDNA 3 ? Tout d’abord, que la puce est composée comme un « chiplet », avec un Graphic Compute Die (GCD) contenant les unités de calcul. Il occupe 300 mm², est gravé en 5 nm.

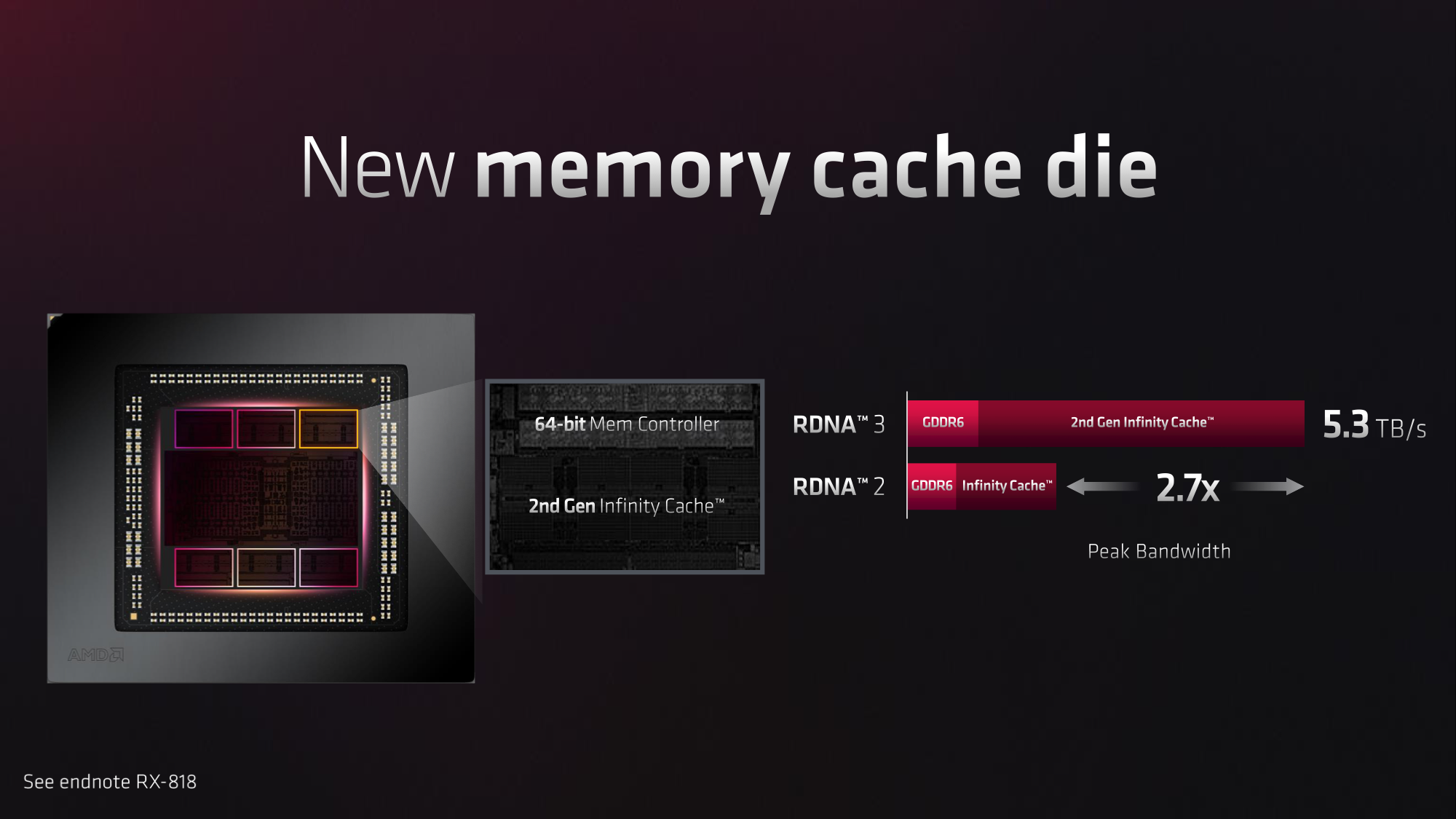

Il est accompagné d’un maximum de six Memory Cache Die (MCD) de 37 mm², gravés en 6 nm et contenant le contrôleur mémoire (GDDR6) ainsi qu'un Infinity Cache de seconde génération, sur lequel on sait peu de choses, si ce n’est qu’il passe à 5,3 To/s de bande passante, soit 2,7x celle de la génération précédente.

Au total, l’ensemble comporte pas moins de 58 milliards de transistors, peut traiter 61 TFLOPS, contre 23 TFLOPS sur la génération précédente, et 49/83 pour les GeForce RTX 4080/4090. Pour cela, les 64 Streams Processors des Compute Units (CU) doublent leur capacité à traiter des instructions (deux par cycle désormais).

Enfin de l'IA dans les Radeon, le multimédia superstar

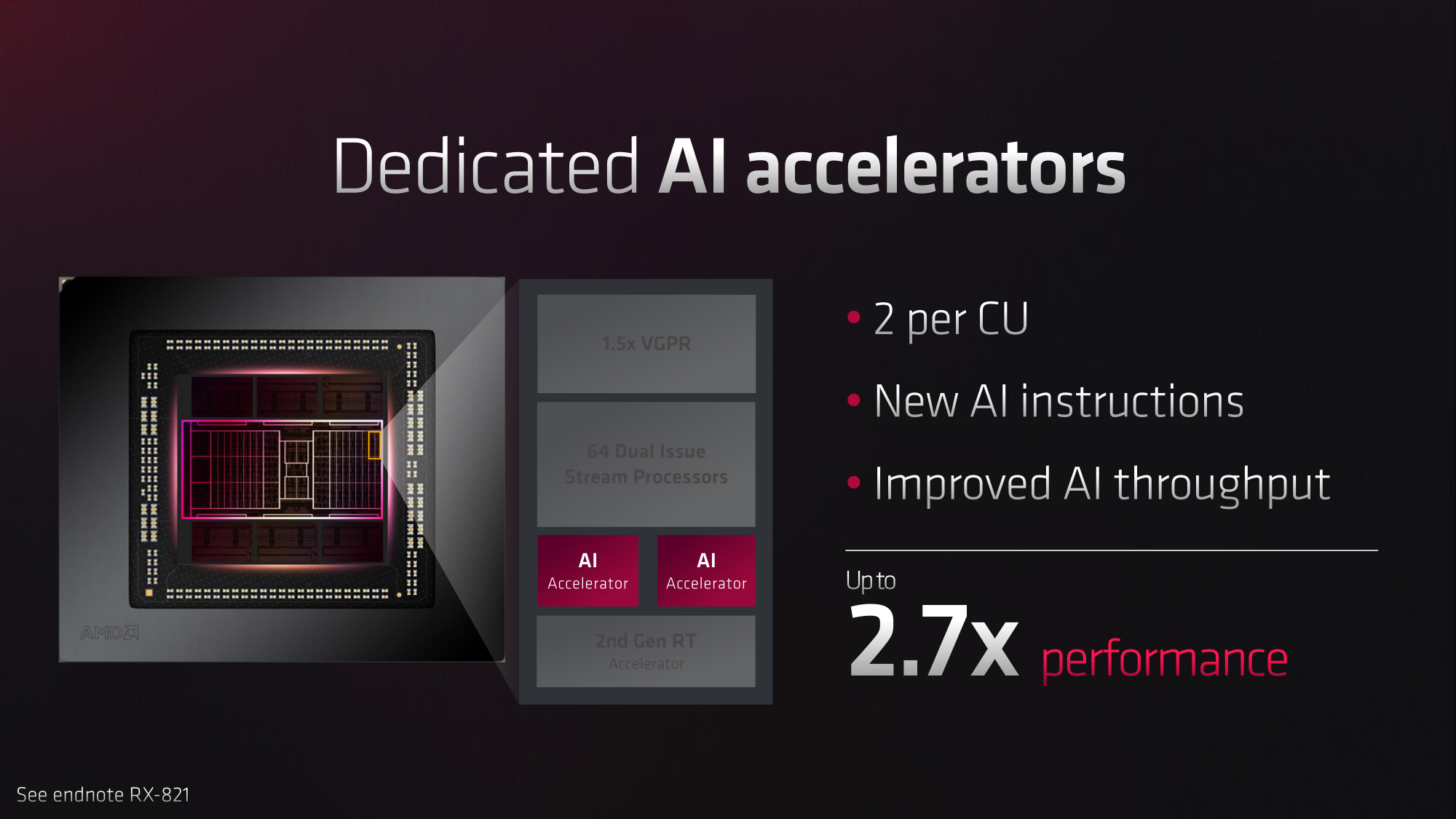

AMD indique avoir amélioré ses unités de ray tracing (50 % de performances en plus), ce qui ne sera sans doute pas un luxe puisque les RX 6000 étaient en retrait en la matière. L'entreprise fait également (et enfin) le choix d’intégrer des « accélérateurs IA », mais sans préciser leur fonctionnement ou les fonctionnalités qui leur seront rattachées.

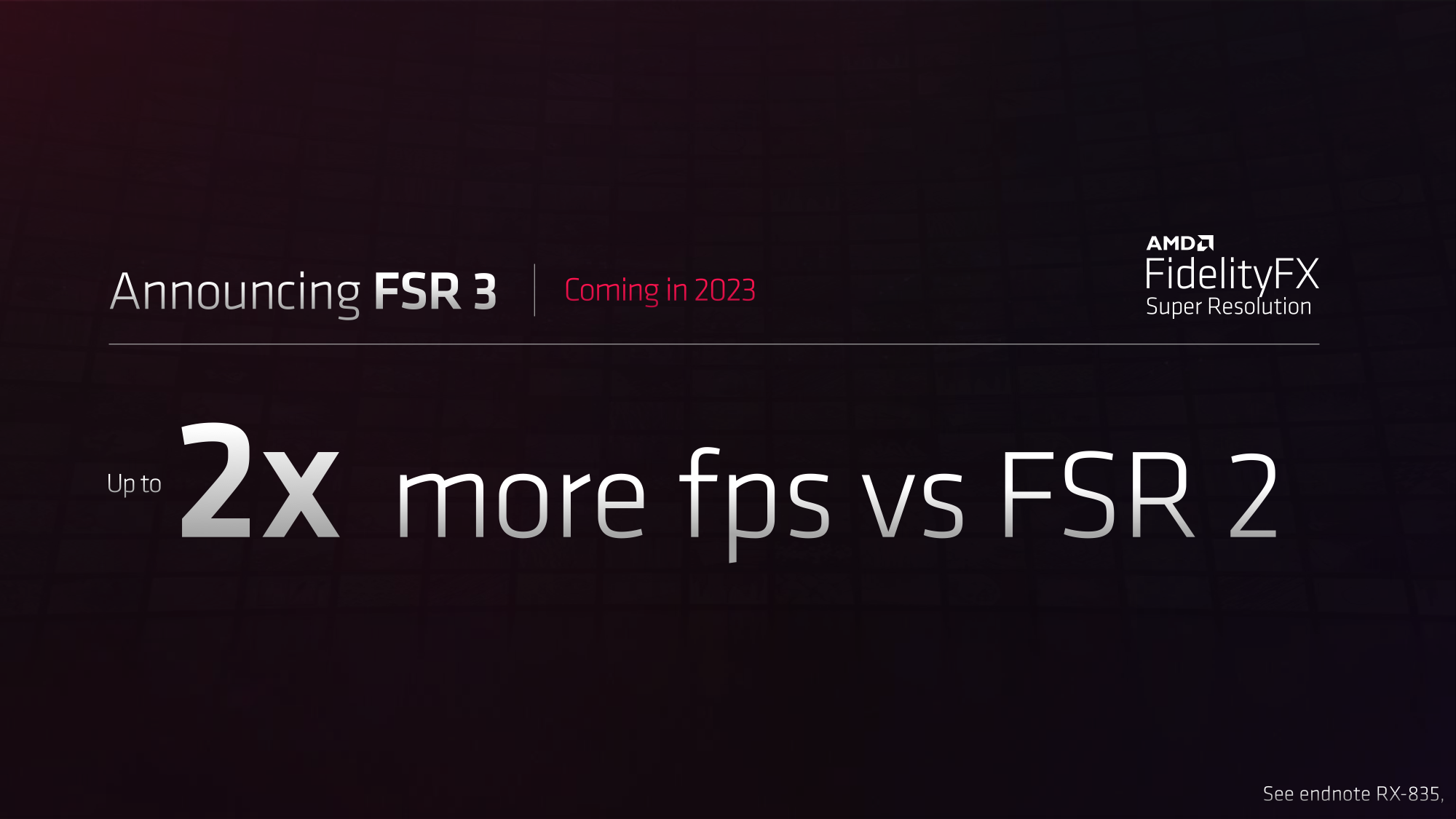

Est-ce qu'un FSR 3.0 exploitant l'IA est attendu pour faire face à DLSS 3 et XeSS ? Nous verrons. AMD annonce en tous cas une nouvelle révision pour 2023, sans en préciser les contours pour le moment. On apprend également qu'une fonctionnalité d'amélioration de la latence, sans doute similaire à NVIDIA Reflex, est prévue (HYPR-RX).

En la matière, on apprécie les efforts du constructeur, même si sa réussite passera par sa capacité à imposer ses innovations plutôt que de suivre la concurrence après quelques années de retard et de promesses déçues.

La puce pourra également utiliser des fréquences différentes en son sein, plus importantes pour une partie de son architecture (front end) que d’autres (shaders). L’objectif est ainsi de maximiser l’efficacité énergétique, avec une gestion plus fine de cet aspect. Nous verrons ce qu’il en est lors des tests.

Côté multimédia, AMD a également fait de grands travaux, avec un moteur désormais capable de gérer le DisplayPort 2.1, et donc des définitions de 8K jusqu’à 165 Hz, du 4K jusqu’à 480 Hz, etc. La bande passante maximale est ici de 54 Gb/s. C’est un point sur lequel les cartes de NVIDIA apparaîtront en retrait, ne gérant que le DP 1.4a pour le moment.

La compression AV1 est également de la partie, avec une définition maximale de 8K à 60 ips. Deux compressions peuvent être effectuées en simultanée pour l’AVC et le HEVC désormais, une Radeon pouvant travailler de concert avec un processeur Ryzen. AMD évoque également l’arrivée d’une compression « améliorée par l’IA ». De quoi relancer les tests comparatifs des performances des GeForce, Radeon et Intel ARC en la matière.

Des cartes taillées pour la compétition

Pour ses Radeon RX 7900 XT et XTX, AMD a choisi de ne pas faire dans l’excès, exposant deux cartes de référence occupant deux emplacements PCIe, avec différentes sorties vidéo : HDMI, DP et Type-C.

Leurs TDP respectifs sont de 300 et 355 watts. Deux connecteurs PCIe à 8 broches sont donc nécessaires. Une manière de se démarquer de NVIDIA, qui grimpe à 450 watts pour sa carte la plus haut de gamme, nécessitant un connecteur PCIe 5.0, qui semble poser problème chez certains constructeurs ayant apparemment lésiné sur la qualité de leur adaptateur, malgré le prix très élevé de ces produits.

Là encore, il faudra voir ce que cela donne en pratique face aux concurrentes, et les performances par watt qui seront fournies dans différentes situations. Rendez-vous d’ici le 13 décembre pour en savoir plus, et voir si AMD est enfin apte à revenir dans la course aux GPU haut de gamme. En tous cas, RDNA 3 semble avoir été pensée dans ce but.

AMD annonce ses Radeon RX 7900XT(X) : un air de Zen et un zeste d’IA, dès 899 dollars

-

Chiplets et cache massif

-

Enfin de l'IA dans les Radeon, le multimédia superstar

-

Des cartes taillées pour la compétition

Commentaires (31)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 04/11/2022 à 08h53

4k 480Hz euh lol :)

Le 04/11/2022 à 09h16

C’est juste la limite du port DP 2.1. Bien-sûr que ta CG (ou même ton ecran) ne va pas miraculeusement se mettre à te sortir du 4k 480Hz. Mais oui, les constructeurs aiment bien jouer sur la confusion.

Le 04/11/2022 à 09h05

En soit c’est mieux en terme d’annonce que nvidia mais la 7800XT rebrand 7900XT pour faire avaler la pillule d’une augmentation de prix de près de 40% (900\( 7900XT vs 650\) 6800XT), je vais certainement pas crié au génie pour ça, les annonces d’AMD ne sont des réussites que par comparaison avec celles désastreuses des verts. On note ainsi objectivement que comme nvidia AMD à fait monter le ticket d’entrée de manière substantielle. Mais on verra tout ça avec les tests

Le 04/11/2022 à 09h48

Les pri flambent parce que la production des puces voit ses prix flamber (plus la finesse de gravure est importante, plus les coûts de R&D et de production sont important), et en prime TSMC qui pdoruit pour tout le monde monte ses prix de production des galettes. Ils ont peut être pris un poil d’avance sur cette partie là, mais sont obligés, tu les voit t’annoncer dan 6 mois “vos cartes prennent +20%” ? En dehors des consoles en pénuries, c’est juste pas possible.

C’est un connecteur classique 8Pin chez AMD, je vois pas où tu peux avoir un soucis sur le connecteur. AMD avait par le passé des soucis sur les VRM par contre qui chauffaient pas mal.

Pour le support Unix/Linux ça dépend si tu veux utiliser les drivers libres ou proprio.

Le 08/11/2022 à 13h58

comment peux tu affirmer qu’AMD a fait passer l’évolution de la 6800XT à une 7900XT ? Il y a quoi qui te permet d’affirmer cela ?

6900XT > 7900XT

6950XT > 7900XTX

Le 04/11/2022 à 09h10

Bah espérons que leurs connecteurs ne fondent pas et ne prennent pas feu comme ceux de la “brique” de leur concurrent nvidia.

Sur les chaines YT des testeurs de matériel et addicts du hardware, passé les quelques “influenceurs” benêts qui relaient la comm’ de Nvidia, entre le poids, la consommation, le prix prohibitif, les drivers pas au top, l’utilisabilité loin d’être assurée sous GNU/Linux, ça semblerait plutôt défavorable pour les nouvelles cartes hautes performances nvidia ou alors j’ai mal compris.

Le 04/11/2022 à 10h37

bonjour,

Ils sont restés a du 2 * 8 broches classique, donc, sauf connecteurs de mauvaise qualité ou défectueux il ne devrait pas y avoir de soucis avec un tdp de 350 W.

Bon ok , je crois que tout le monde va dire que la concurrente directe c est pas la 4090 mais la 4080, justement cette futur 4080 si elle est aux alentours des 400 w au lieu des 350 w(qui reste a vérifier dans les futurs tests) des ati niveau perfs/conso les 7900xt/xtx resteront plus intéressantes que les 4080/4080ti et rien que niveau prix, même si les prix amd ont augmentés ca restera quand même bien moins cher que l équivalent nvidia ( svp n’utilisez pas comme seul argument de réponse le raytracing parce que pour le raytracing y a pas beaucoup de joueurs qui l’activent, et surtout devoir utilisé dlss ou fsr pour activer le raytracing j appel ca booster d’un côté [raytracing] pour affaiblir de l’autre[dlss/fsr]).

Et n’oubliez pas que le dlss/fsr ca reste de “ l’antialiasing (super)amélioré “

Le 04/11/2022 à 10h44

JE suis mitigé sur le Raytracing, j’ai une 3080 et je trouve que ça apporte pas mal niveaux reflets, etc… Et sur une carte qui approche les 1000€ je pense qu’on peut être en attente d’avoir de bonne perf Raytracing, surtout sur cette génération, sans que le DLSS ou FSR soit nécessaire.

Je vois plus le DLSS utilisé sur des cartes milieu de gamme qui voudraient utiliser le Raytracing, pas sur le haut de gamme.

Car effectivement, je suis d’accord que DLSS et FSR baissent la qualité, et entrainent pas mal d’artefacts chelous.

Le 04/11/2022 à 10h06

Manque plus que des jeux…

Le 04/11/2022 à 10h34

Ca fait un bail que j’attendais de voir enfin leurs chiplets appliqués aux GPU!

Vivement un milieu de gamme plus abordable!

La faible consommation annoncée par rapport à nVidia, le prix d’achat, l’encodage/décodage AV1, et manifestement une mise en avant des perf gaming avant tout (quid de la productivité, i.e. Blender, Unreal Engine, etc?), que d’arguments face à la concurrence ^^

Pour une analyse plus poussée sur la partie chiplet je vous recommande AdoredTV (en Écossais): YouTube

YouTube

Le 07/11/2022 à 10h57

Merci pour la vidéo.

Le 04/11/2022 à 10h52

Je vais sortir ma boule de cristal mais 4k 480Hz ça n’existera probablement jamais ! (Y’a-t-il vraiment des écrans 480Hz peu-importe-la-résolution ?)

DP 2.0 à quelques avantages surtout sur les portables qui sont souvent bridés en alt-mode. En alt-mode, tu peux encore gérer 3 écrans UHD à 144Hz en HDR avec DP 2.0 !

Sauf que là on est sur PC fixe donc l’alt-mode n’a presque aucun intérêt, du coup même DP 1.4a y’a de grandes chances que ce soit largement suffisant toute la vie du produit !

Le 04/11/2022 à 11h12

bonjour, ) de cet écran c est le prix d un pc gaming mais au moins on a la preuve que çà existe deja.

) de cet écran c est le prix d un pc gaming mais au moins on a la preuve que çà existe deja.

je sais pas si il y aura un jour, ou non , du 4k 480hz mais y a deja du 4 k 360hz :

https://www.materiel.net/produit/202207270144.html ok le prix (

Le 04/11/2022 à 11h12

Pas en 4k, mais des écrans 480hz ça va arriver en 2023. Aujourd’hui, on a déjà du 240Hz en 4K, il y a du 360Hz en 1440p.

C’est déjà à la limite, voire dépasse display port 1.4 (qui équipe la 4090 par ailleurs).

Et display port 2.0/2.1 c’est plus ou moins la même chose, pas de grosse différence.

Donc non, DP 1.4a ce n’est pas suffisant sur la vie du produit, parce qu’il y a déjà des écrans qui atteignent ou dépassent les capacités de cette version. Bon les écrans actuels n’ont pas de displayport 2.0 non plus, mais ça va arriver.

Le 04/11/2022 à 11h25

Sauf que la nature même du raytracing fait qu’il est virtuellement impossible d’en faire en temps-réel sans plomber les performances, d’où l’intérêt des solutions comme le DLSS ou le FSR pour compenser la baisse de performances. Personnellement, j’ai pas trop vu la différence avec ou sans sur les quelques jeux où je l’ai activé, en mode qualité justement par méfiance vis à vis de ces artefacts.

Le 04/11/2022 à 11h39

Pour avoir de bonne perfs avec le raytracing en admettant que tu joue en 1080p sans DLSS / FSR / ECT il faudrat au moins attendre la série 60 voir 70. C’est comme ça que fonctionne les jeux vidéos et la technologie en général.

Le 04/11/2022 à 11h49

Pour la faire courte :

Le raytracing ne veut pas dire grand chose si les détails ne sont pas spécifiés. Ce qui compte c’est de savoir sa résolution, le nombre de rebond, le nombre de rayons lancés et le nombre de source lumineuse.

Le 04/11/2022 à 12h54

Sur Cyberpunk je trouve que ça se remarque bien sur tous les reflets, eau par terre, vitres etc…

Le 04/11/2022 à 13h13

Bonjour,

A ces tarifs (au moins 1300 € TTC en France), le full HD a encore de beau jour sur STEAM…

Le 04/11/2022 à 14h27

Une 3060 / 3060 Ti suffit pour jouer en 1080p confortablement. Les cartes au dessus permettent le QHD et la 4k. Je joue sur un G9 DQHD avec une 6800 XT, ça marche très bien (hors RT).

On attend les gros jeux UE5 pour que nos cg prennent une claque. Pour l’instant tous les jeux tournent bien.

Le 04/11/2022 à 13h14

Cool !

Le 04/11/2022 à 15h54

AMD se garde sous le coude la possibilité de sortir une RX7950 si ça ne suffit pas

Le 04/11/2022 à 16h20

Tiens il sera intéressant de voir si les AI engines seront utilisables pour faire de l’IA généraliste comme on peut le faire avec le tensor cores chez NVIDIA.

Le 07/11/2022 à 21h00

Ca existe déjà: https://www.amd.com/en/graphics/servers-solutions-rocm-ml

Un peu l’équivalent de cuda/cudnn chez amd.

Le 08/11/2022 à 14h53

Y’a pas confusion là ? CUDA et ROCm c’est le calcul GPU, pas pour l’exploitation des tensor cores (pas directement en tout cas).

D’ailleurs j’allais poser la question : ça serait cool que AMD propose enfin quelque chose de solide et concret concernant GPU computing, car v’là les nombreux projets qui nécessitent CUDA… et certains même refusent de s’exécuter en pur CPU. Le support OpenCL a été longtemps et honteusement bancal.

Le 08/11/2022 à 20h29

En effet, rocm n’utilise pas les tensor core(d’ailleurs les tensor core run seulement en fp16) . Mais il optimise les run sur chip amd, cpu +gpu. https://www.theregister.com/2022/06/13/amd_ai_strategy/

Ils intègrent directement les optim sur les chip et non sur des core séparé dédié.

et en strat ils on l’air de miser sur l’inference via cpu, train via gpu et autres opti via fpga avec xilinx

Le 05/11/2022 à 08h07

Je parlais du DLSS. On voit effectivement assez bien la différence sans et avec le raytracing.

Le 05/11/2022 à 09h16

bah non :)

Bah non plus… les écrans UHD@240Hz et 1440p@360Hz sont tous les deux en DP1.4

Le 05/11/2022 à 10h43

Alors oui, mais avec des contraintes.

Normalement hdmi 2.1 et DP1.4 ne peuvent faire que 120Hz en 4k nativement. Ou même “que” 60Hz si les couleurs en 10 bits et HDR est activé.

Les écrans qui font plus que ça sont obligés d’utiliser de la compression vidéo, et potentiellement de ne pas utiliser l’intégralité des capacités de l’écran. Typiquement si on active couleur en 10 bits et hdr, tu ne pourras pas avoir plus de 120 Hz.

Si tu veux te renseigner un peu plus sur les capacités, la page Wikipédia de display port en anglais est pas mal. Le seul endroit où un tableau indique que 240Hz est possible en 4K avec Display port 1.4 c’est quand on est en 8bit et sans HDR avec compression (DSC).

Et si tu regardes des revues d’écran exubérant (donc typiquement des écrans 4k@240hz ou +) en display port 1.4, il n’est pas rare qu’ils passent dans un mode particulier pour atteindre les 240hz

Le 05/11/2022 à 15h07

Donc “il n’y a pas d’écrans qui atteignent ou dépassent les capacités de cette version” CQFD ;)

Concernant le DSC c’est lossless: il n’y a pas de perte de qualité. Avec cette info en tête le DP1.4 gère la 5k à 144Hz, et l’UHD à 240Hz (sans perte, mais je suppose sans HDR la page wiki n’est pas clair sur ce sujet)

Franchement je pense que les “limites” actuelles sont plus celles de l’électronique des écrans que la connexion qui en DP est largement en avance, ce n’est pas n’importe quelle puce qui peut encaisser 40 à 80 gb/s sans broncher

Le 09/11/2022 à 17h18

bonjour,

Hà, au fait “ En la matière, on apprécie les efforts du constructeur, même si sa réussite passera par sa capacité à imposer ses innovations plutôt que de suivre la concurrence après quelques années de retard et de promesses déçues. ” Ok amd “avait ou a encore un peu de retard ” sur le raytracing mais il se sont bien améliorés là dessus, pour la nouveauté de l’ IA peut-être qu ils ont suivis la mode alors qu’a la base une CG c est plutôt pour le gaming que la majorité des clients les achètent, et pour finir l’argument “ après quelques années de retard et de promesses déçues. faudra un jour trouver autres chose que cet argument qui devient pire que bancal, il était valable a l époque de l’architecture GCN mais là ca fait un bon moment qu on est passé à Rdna donc va falloir soit se renouveler soit avoir un peu plus d’objectivité, d’avance merci.

Et quid aussi de nous parler des problèmes de l’adaptateur 16 pin 12VHPWR parce que question déception c’en est un parfait exemple, non ????