Oasis, GameGen-X : quand l’IA s’attaque aux moteurs de jeu vidéo

Les moteurs 3D qui animent nos jeux vidéo cèderont-ils bientôt la place à des rendus générés à la demande par des intelligences artificielles génératives ? Si le scénario parait encore peu crédible, plusieurs projets récents illustrent des avancées significatives en la matière, à l’image d’Oasis, le clone de Minecraft généré par IA de Decart.

Le 08 novembre à 16h08

7 min

IA et algorithmes

IA

Après quelques minutes en file d’attente, notre navigateur finit par nous afficher l’environnement d’Oasis : un décor à la Minecraft, dans lequel on peut immédiatement regarder autour de soi, se déplacer, creuser le sol ou générer un objet. Les interactions se font sans délai, mais le rendu visuel laisse à désirer, avec un affichage fenêtré en 360p limité à 20 images par seconde. La simulation est néanmoins parfaitement fonctionnelle et, surtout, les interactions avec le « jeu » se déroulent sans latence perceptible pendant les 120 secondes de test autorisées.

Un tour de force, si l’on considère que le rendu n’est pas assuré par un moteur de rendu, mais par un modèle d’IA générative. Très vite, des incohérences que l’on ne rencontrerait pas dans un environnement 3D calculé de façon traditionnelle se font sentir. Des objets disparaissent, des flous brouillent le champ de vision…

Mise en ligne le 31 octobre dernier, Oasis a attiré plus d’un million de curieux en un peu plus de trois jours. À la manœuvre, on retrouve une jeune startup de la Silicon Valley, Decart. Fondée en septembre 2023, elle a annoncé le même jour une levée de fonds de 21 millions de dollars, réalisée auprès du fonds Sequoia Capital.

Un flux vidéo généré en quasi temps réel

D’après Decart, Oasis serait ainsi le « premier modèle IA jouable et en temps réel de monde ouvert ». La société estime surtout que ce démonstrateur préfigure une nouvelle génération d’environnements virtuels : « Un jeu pourrait par exemple être complètement contrôlé par du texte, de l’audio ou d’autres modalités, plutôt que par des actions ».

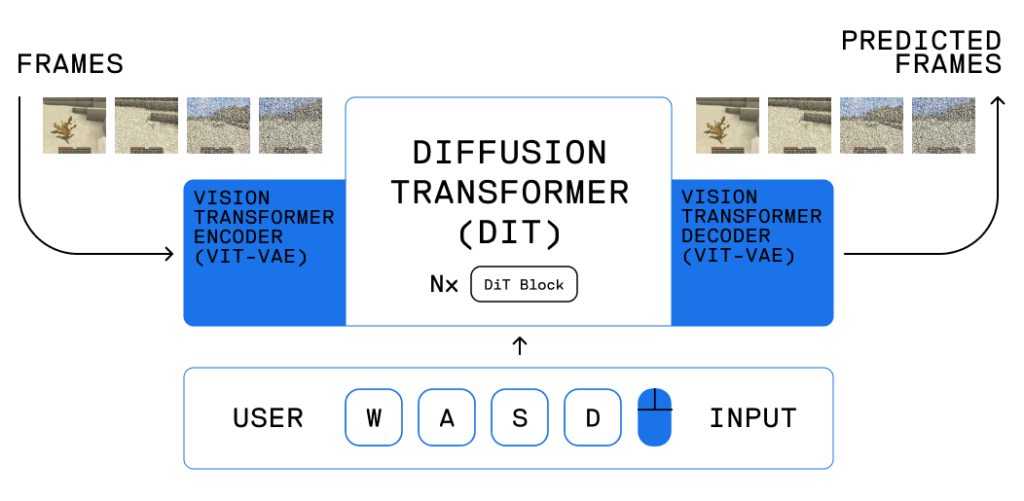

Sur Github, Decart explique les fondamentaux de son modèle et compare sa construction à celle des grands modèles dédiés à la génération de vidéos tels que Sora, le projet dédié d’OpenAI. Elle met par ailleurs à disposition une version limitée à 500 millions de paramètres de son modèle, accompagnée du framework dédié à la prise en compte des entrées dans la phase d’inférence en local.

« Contrairement aux modèles bidirectionnels tels que Sora, Oasis génère des images de manière autorégressive, avec la possibilité de conditionner chaque image en fonction des entrées du jeu. Cela permet aux utilisateurs d'interagir avec le monde en temps réel », explique la société, qui précise s’appuyer sur la méthode d’entrainement hybride dite du Diffusion Forcing, élaborée par une équipe du MIT et rendue publique début juillet.

Entraînée sur un ensemble de vidéos capturées au sein de Minecraft et collectées par OpenAI, Oasis est logiquement sujette aux erreurs, du fait de sa nature autorégressive. Decart explique avoir traité le problème grâce à l’introduction d’une fonction de « bruit dynamique » (bruit au sens photographique du terme), capable de masquer temporairement les incohérences à l’inférence jusqu’à ce que les transformations ultérieures aient permis de générer les bons détails.

Une génération à 20 images par seconde

Forte de ces différentes optimisations, Decart affirme que son modèle est capable de générer un flux de sortie à 20 images par seconde, là où il faut plutôt quelques dizaines de secondes aux modèles de type Sora ou Runway pour générer une seconde de vidéo, souvent à partir d’infrastructures richement dotées en GPU.

Bien que les rendus photoréalistes d’un Sora n’ait rien à voir avec l’environnement pixelisé d’un Minecraft, la comparaison se veut une démonstration de la logique économique qui sous-tend les travaux d’Oasis. « Nous pensons que le prix de la mise en œuvre des modèles comme Oasis constitue le goulot d’étranglement caché qui empêche la diffusion de vidéos génératives en production », écrit ainsi la société, qui se dit aujourd’hui capable de servir cinq utilisateurs simultanés sur un cluster de huit puces H100 de NVIDIA avec une version à 100 milliards de paramètres de son modèle.

Sur ce volet, Decart attend beaucoup d’une de ses voisines, la startup californienne Etched, qui développe un ASIC dédié à Oasis, baptisé Sohu, lequel permettrait de passer de cinq à plus de 60 utilisateurs simultanés dans les mêmes conditions.

Les projets de recherche se multiplient

La 3D interactive sera-t-elle le prochain sprint des géants de l’IA ? En attendant de premières applications concrètes, les projets de recherche se multiplient. Fin août, une équipe associant des chercheurs de Google et de l’université de Tel Aviv ont ainsi présenté GameNGen, un équivalent de Doom lui aussi généré par IA, grâce auquel ils estiment démontrer qu’il est possible de faire tourner un jeu complexe en temps réel grâce à un modèle neuronal.

Leur modèle, qui exploite lui aussi le bruit dynamique, souffre de limitations bien identifiées dans l’article dédié à sa présentation scientifique (PDF), mais il augure, selon les auteurs, un nouveau paradigme, autorisant par exemple des « processus de développement plus accessibles et moins coûteux, dans lesquels les jeux pourraient être développés et édités via des descriptions textuelles ou des images servant d’exemples ».

Une autre équipe, venue de Hong Kong cette fois, s’est jointe à la danse, avec un article publié le 1er novembre dernier, consacré à GameGen-X, un modèle de monde ouvert interactif, entraîné cette fois sur la base d’extraits vidéo issus de 150 jeux vidéo différents, et passés au crible de GPT-4o. Une courte bande vidéo laisse augurer des visuels dignes d’un jeu vidéo récent, sans toutefois fournir la moindre indication quant à la richesse fonctionnelle.

Dilemme de l’innovation ?

Verrons-nous bientôt des jeux vidéo ou des environnements 3D générés à la demande, et donc débarrassés des limites qu’implique la programmation d’un moteur de rendu ? Et le sujet doit-il être envisagé comme une innovation de rupture ?

Interrogé à ce sujet, Tim Sweeney, patron d’Epic (éditeur de l’Unreal Engine, l’un des moteurs de référence du marché) s’est dit plus enclin à croire à une approche intégrée.

« Les ordinateurs sont déjà incroyablement doués pour les calculs numériques tels que la simulation physique et le rendu des pixels, tandis que l’IA est incroyablement douée pour l’apprentissage de modèles dans des ensembles de données massifs. Le défi consiste à comprendre comment les réunir aux bons endroits pour tirer le meilleur parti des deux : concevoir des moteurs qui exposent des paramètres efficaces en entrée pour l’IA, et une IA multimodale capable de travailler dans ces contextes et d’apprendre à manipuler les paramètres des algorithmes pour planifier et atteindre un objectif final ».

Oasis, GameGen-X : quand l’IA s’attaque aux moteurs de jeu vidéo

-

Un flux vidéo généré en quasi temps réel

-

Une génération à 20 images par seconde

-

Les projets de recherche se multiplient

-

Dilemme de l’innovation ?

Commentaires (14)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousModifié le 08/11/2024 à 16h19

Le 08/11/2024 à 16h24

Le 08/11/2024 à 16h36

Un des cas d'usage de l'IA générative que je vois pour le domaine, c'est la prolongation de la durée de vie de ceux-ci. Quand on a fini un jeu et qu'on l'a torché à 100%, même si on aime l'univers, se balader dedans, explorer, etc, y'a plus rien à faire en dehors de rares perles qui permettent des combinaisons chiadées. On a bien la notion d'événements aléatoires, mais ils finissent souvent par se répéter car basés sur les mêmes patterns. Même si contenu peut s'auto-générer, à un moment on atteint la limite de ce qui a été prévu et le joueur tourne en rond.

La techno ouvre des possibilités intéressantes pour continuer d'étendre un jeu et ainsi continuer d'en profiter. Un point qui peut soulever des questions par contre, c'est le modèle économique. Les jeux s'enrichissent par extension et achats. Un jeu qui s'auto complète n'est pas rentable, donc le financement va devoir s'adapter (abonnement, notion de crédits, microtransactions pour débloquer les contenus, etc). Et ça peut aller au-delà de juste ajouter quelques PNJ avec des dialogues générés.

Ça m'a rappelé la dernière saison de Westworld qui avait bien imaginé le "duo" que pouvait former un scénariste et une IA générative.

Modifié le 09/11/2024 à 09h23

J'imagine la réduction de temps de création hors-ligne d'un open world avec une IA et les grosses bases de données de 3D.

Des discours plus réalistes de PNJ, ça serait top aussi. On pour même imaginer des discussions avec un LLM derrière et un micro pour le joueur 😅

Le 09/11/2024 à 10h21

Pour les dialogues, il me semble que ça a déjà été expérimenté dans des jeux à travers de mods. Le souci, c'est que ça reposait sur des API type GPT et que le modèle brisait souvent le 4ème mur à cause des limitations qu'on lui impose.

Les LLM étant plutôt bon dans le domaine du jeu de rôle, des modèles spécialisés et raffinés avec la personnalité du PNJ donneraient sûrement quelques surprises aux joueurs.

Le 11/11/2024 à 01h23

Tu risques même de te retrouver assez rapidement avec un serpent qui se mord la queue : plus l'IA générative sera utilisée dans les jeux, moins il y aura de nouvelles données humaines pour entraîner les modèles, plus ils seront entraînés sur des données synthétiques avec les effets de dégénérescence déjà observés dans ce genre de cas.

Le 11/11/2024 à 09h09

Je n'ai jamais parlé de remplacer les scénaristes par des LLM, c'est d'une débilité sans nom.

L'écriture principale doit dans tous les cas rester à la charge des humains qui, contrairement aux LLM, ont de l'imagination (même si la production industrielle tant déjà à prouver l'inverse - le taux de recyclage la rendrait presque écoresponsable).

Pour du secondaire à faible valeur ajoutée, le travail d'un LLM suffit. Ce qui est peu ou prou la même position que j'ai sur l'usage de l'IA générative dans le code, par exemple.

L'un ne doit pas remplacer l'autre, ils doivent bosser ensemble. C'est comme ça qu'on en tire le meilleur.

Le 09/11/2024 à 07h09

Le 10/11/2024 à 09h12

Le 12/11/2024 à 14h08

Le 10/11/2024 à 20h08

Le 11/11/2024 à 15h08

Le 12/11/2024 à 14h35

flux vidéoune facture d’électricitéLe 12/11/2024 à 13h20

même si au moins le framerate catastrophique permet de limiter la casse de se côté la, la machine qui devra recevoir le flux vidéo chez l'utilisateur, le refroidissement du datacenter, et pire que tout ça, l’entraînement du modèle). De toute façon, a 5000 balles la carte, ce genre de techno sera jamais exécuté en local