Apple annonce sa puce M4 Pro et de nouveaux Mac mini (12,7 cm de côté)

La marque à la pomme lance son nouveau Mac mini avec plusieurs déclinaisons de puces M4. Au modèle déjà connu, s'ajoute le SoC M4 Pro qui peut monter jusqu'à 14 cœurs CPU et 20 cœurs GPU.

Le 29 octobre à 17h44

3 min

Hardware

Hardware

Après les nouveaux iMac avec une puce M4, Apple continue de faire évoluer ses gammes de produits et lance son nouveau Mac mini. Ses mensurations sont de 12,7 x 12,7 x 5 cm (soit 7 cm de moins en largeur et en longueur, mais 1,42 cm de plus en hauteur), pour un poids de 670 à 730 grammes suivant les versions. Apple annonce « une surface réduite de plus de 50 % par rapport au modèle précédent ».

Voici la nouvelle puce M4 Pro

La machine peut être équipée d’un SoC M4 ou d’une nouvelle déclinaison baptisée M4 Pro. Le SoC M4 Pro monte jusqu’à 14 cœurs CPU (10P + 4E) là où le M4 se limite à 10 cœurs (4P + 6E), la différence devrait donc être notable sur les performances, avec 2,5x fois plus de cœurs « Performance ». Les cœurs E sont pour rappel ceux avec une plus grande efficacité énergétique.

Le GPU fait un bond en avant avec un maximum de 20 cœurs, contre 10 pour son grand frère. Sans surprise, le fabricant annonce que « le GPU de la puce M4 Pro est jusqu’à deux fois plus puissant que le GPU de la puce M4 », normale avec deux fois plus de cœurs.

Jusqu’à 64 Go de mémoire unifiée, 273 Go/s de bande passante

Apple annonce que sa puce « M4 Pro prend en charge jusqu’à 64 Go de mémoire unifiée et 273 Go/s de bande passante mémoire […] et prend également en charge le Thunderbolt 5 ». La M4 se limite pour rappel respectivement à 32 Go, 120 Go/s et Thunderbolt 4. Dans tous les cas, le Neural Engine dispose de 16 cœurs, il ne devrait donc pas y avoir de changement entre les M4 et M4 Pro.

Attention, ce sont les caractéristiques techniques maximales, le Mac mini en M4 Pro n’en profite pas toujours. Apple met en avant deux configurations sur sa boutique en ligne : avec 12 ou 14 cœurs CPU et 16 ou 20 cœurs GPU. La mémoire unifiée varie entre 24 et 64 Go sur les versions M4 Pro.

Apple Intelligence, « premier Mac neutre en carbone »

Bien évidemment, on n’y coupe pas : « Le nouveau Mac mini est également conçu pour Apple Intelligence, le système d’intelligence personnelle ». Apple annonce aussi qu’il « s’agit du premier Mac neutre en carbone, avec une réduction de plus de 80 % des émissions de gaz à effet de serre induites par ses matériaux, sa fabrication, son transport et son utilisation ».

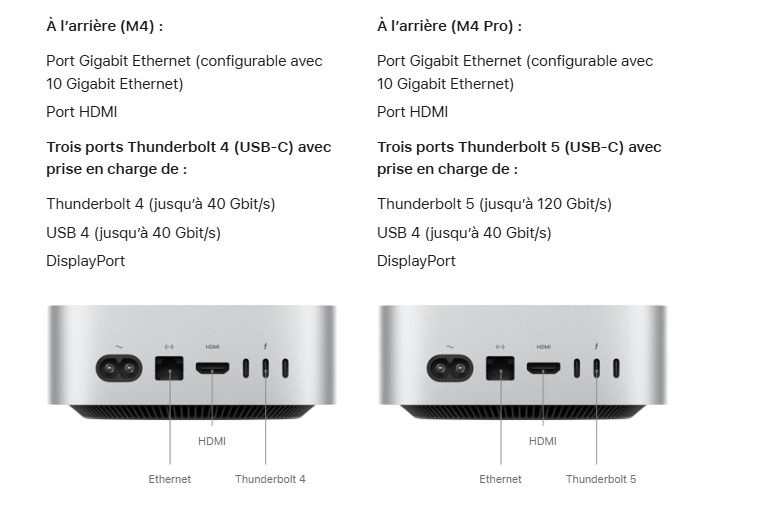

La connectique est la même : deux USB Type-C en façade avec une prise jack de 3,5", un port Ethernet (1 Gb/s par défaut, 10 Gb/s en option), une sortie vidéo HDMI et trois Thunderbolt 4 ou 5 suivant le SoC. On retrouve toujours du Wi‑Fi 6E et du Bluetooth 5.3.

Dès 699 euros en M4 ou 1 649 euros en M4 Pro

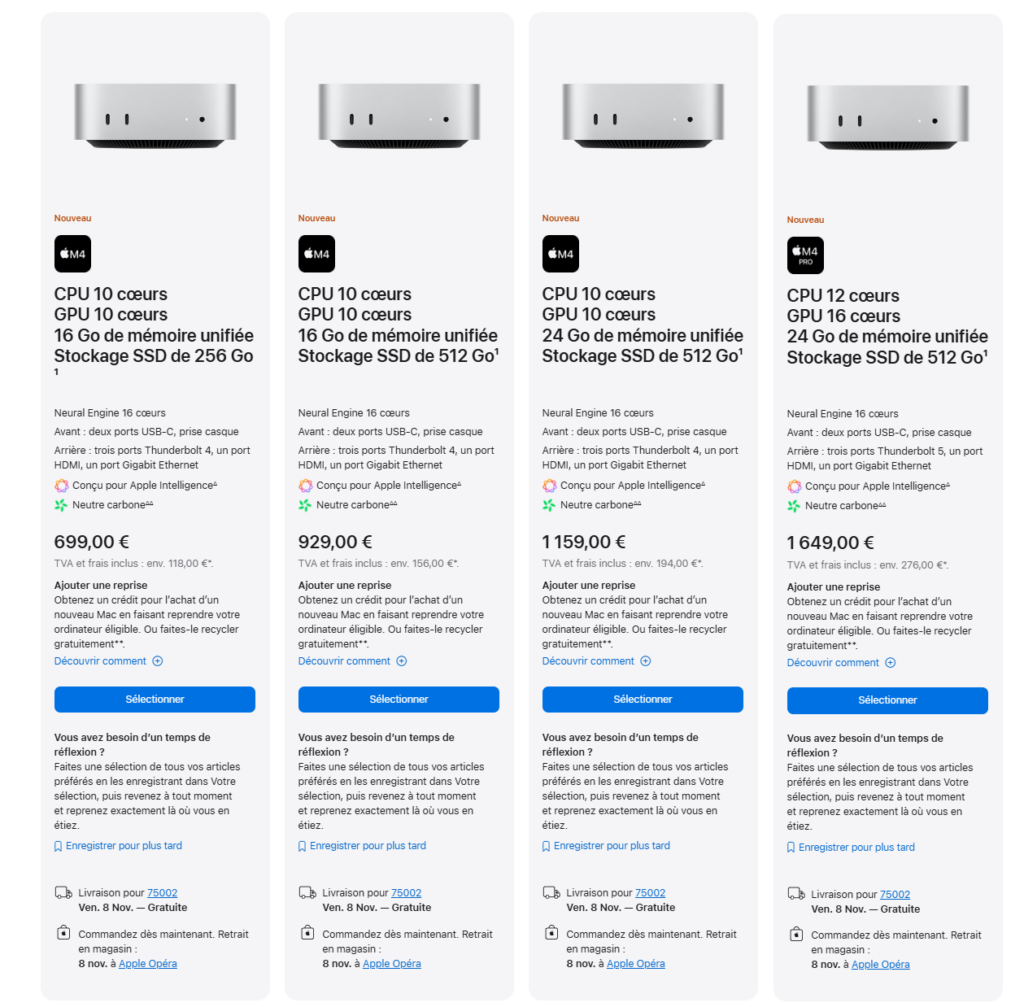

Le nouveau Mac mini est en précommande dès maintenant et sera disponible à partir du 8 novembre. Comptez au minimum 699 euros pour la version de base (M4 avec 10 cœurs CPU et 10 cœurs GPU, 16 Go de mémoire et 256 Go de SSD), contre 1 649 euros minimum pour profiter de la nouvelle puce M4 Pro. L’addition grimpe à 1 879 euros pour la puce M4 Pro au maximum de ses capacités (14 cœurs CPU et 20 cœurs GPU).

Apple annonce sa puce M4 Pro et de nouveaux Mac mini (12,7 cm de côté)

-

Voici la nouvelle puce M4 Pro

-

Jusqu’à 64 Go de mémoire unifiée, 273 Go/s de bande passante

-

Apple Intelligence, « premier Mac neutre en carbone »

-

Dès 699 euros en M4 ou 1 649 euros en M4 Pro

Commentaires (65)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousLe 29/10/2024 à 18h12

Le 29/10/2024 à 21h30

Le 29/10/2024 à 18h30

Un Mac sans écran ni batterie, ça me va!

Reste que le ticket d'entrée pour 16Go de RAM et un disque de 256Go, c'est… outch!

Le 29/10/2024 à 19h02

Le 29/10/2024 à 20h51

Déjà quasi 1.000EUR pour l'upgrade 2To sur l'entrrée de gamme.

C'est probablement leur meilleur geste écolo: inciter à ne pas consommer!

Le 31/10/2024 à 02h03

Le 31/10/2024 à 09h31

Le 29/10/2024 à 21h37

Le 29/10/2024 à 23h54

Le 29/10/2024 à 23h57

Modifié le 29/10/2024 à 19h08

Le 30/10/2024 à 00h02

Le 30/10/2024 à 07h59

Modifié le 30/10/2024 à 12h40

Modifié le 29/10/2024 à 21h34

Je pense que c'est surtout le SSD qui pêche. Après on peut rajouter du buffer (pris sur la RAM ) sur certains players... et comme un film, ce n'est pas 100% de l'action sans arrêt du début à la fin, le bitrate se calme un peu des fois et le buffer essaye de tenir le coup.

Le 30/10/2024 à 12h46

Le problème est qu'en HDMI, j'ai seulement 30Hz ou un 75Hz bâtard à 1600p, et DaVinci Resolve ne supporte pas ces fréquences et pète un plomb (et mon écran) en quelques minutes.

Et j'utiliserais bien le DP via USB4 mais j'ai qu'un port DP sur l'écran et j'aimerais le garder pour mon PC de jeux 😕

Pour la RAM, mon banquier m'a bien dit : "pas plus de 16Go ou je coupe tout !", donc bof pour le buffer 😂 Mais avec un bon boitier externe, j'arrive à 3000Gb/s en lecture écriture, ça compense le ssd pourri du M2 😅

Le 30/10/2024 à 14h12

Vu que le 75Hz est disponible, il n'y a aucun risque à rajouter du 60Hz.

Sinon il y a peut-être moyen avec un "hub USB-C" pas trop cher d'utiliser les ports USB-C en mode DP mais d'avoir une sortie HDMI quand même. Ça te donnera peut-être accès à d'autres fréquences d'affichage.

Le 30/10/2024 à 15h12

Pour les achats par contre, j'ai assez donné, entre les câbles HDMI premium, le convertisseur USB4-DP, le KVM DP qui comprends pas le DP via USB4 donc inutile... 😅 Tout ça pour un MacMini 😂😂

Le 31/10/2024 à 00h24

Un tour rapide sur Bing m'envoie vers ça.

Pour la suggestion du hub USB-C, oui je comprends la frustration de l'achat supplémentaire, je mentionnais juste ça parce que ça coute pas très cher (20~30€), et que ça fait bien le boulot pour mes appareils en USB-C (Windows/Linux/Android), et qu'au pire si ça marche pas pour ce cas précis, ça reste un gadget utile à avoir sous la main (c'est compact, donc ça fait très bien mini-dock de voyage).

Modifié le 31/10/2024 à 01h31

J’utilise depuis 4-5 ans un Samsung 4K U28E590 avec 3 ports : DP, HDMI1, HDMI2 (écran de moyenne gamme). Ma CM n'a pas de DP, seulement du HDMI.

J’utilise aussi ClickMonitorDDC@Windows qui permet de contrôler directement un écran, cad de changer la luminosité comme si on le faisait avec les menus OSD (On-Screen-Display) avec les doigts, plus pratique avec une souris, ainsi que accessoirement la mise en veille et l' extinction (comme avec les doigts aussi).

Windows lui ne le fait qu’artificiellement pour la luminosité (ça se voit à la conso à la prise), mise en veille & extinction : oui par contre... Il envoie l'instruction.

Bref...(Hors sujet).

Je me suis rendu compte assez rapidement (et confirmé sur des forums) que :

- Port HDMI N° 1 derrière l'écran: permet le contrôle DCC mais le rafraichissement limité à 30 Hz seulement car HDMI 1.4 (et sur le bureau Windows, oui ça se voit à l'oeil nu la fluidité du pointeur).

- Port HDMI N° 2 : ne permet PAS le contrôle DCC mais le rafraichissement est par contre à 60 Hz car HDMI 2.0.

Donc je débranche un coup sur 2 de prise HDMI pour changer de port si je regarde soit un film ou bien soit que je fasse de la bureautique ?

Même la spec technique officielle bien sûr ne le précise pas. Juste « 2 x HDMI » . Seulement quelques commentaires (et pas évident à trouver la réponse) dans des forums spécialisés IT qui donnent enfin la réponse au pourquoi.

Quand on achète un produit, on se base avant tout sur les spécifications techniques officielles de la fiche produit, comme pour 98% des acheteurs, non ? On ne passe pas 1/4h – 1/2h à fouiller dans des forums assez techniques de Geeks à vérifier le type de version de CHACUN des 2 ports HDMI à l’arrière l’écran ? Même pour des geeks… parce qu'un port HDMI, c'est un port HDMI, numéroté 1 ou numéroté 2 derrière l'écran, et puis tant ça rentre bien dedans par derrière, c'est tout bon, non ?

Qui dans l’ensemble de la population va creuser les specs et connait les différences techniques entre HDMI v1.4 vs v2.0/2.1 ?

= > 0,05% ? mais le marketing ne s'est pas privé de communiquer cette info "vitale" aux designers et surtout aux services Achats du groupe.

Bref, au final combien Samsung a économisé de $$ sur chaque écran vendu avec cette pauvre ARNARQUE à 2 balles ?

Bien sûr 99,95% des clients n'ont absolument rien remarqué...

Les specs techniques détaillées (interne) sont dispo à la FNAC et chez Boulanger en magasin ? Non... En ligne ? Non plus...

Honnêtement c'est juste du PUR Mensonge par omission ici.

SAMSUNG… Juste 100% minable ici…

.

Le 31/10/2024 à 01h39

Ton problème avec le DDC pourrait être que, dans mon expérience, DDC/VCP/MCSS ne marche que depuis le port actif.

Je ne suis pas sûr pour le changement de luminosité "artificiel" sous Windows. Je n'ai rien dans l'UI pour changer ça, par contre quand j'utilise l'API pas de problème, ça change comme dans l'OSD. Pas besoin de drivers. Et quand je monte trop haut l'OSD apparaît pour me dire que là ça va consommer plus.

Le 31/10/2024 à 22h47

pour le port 1, il est bien bridé à 30Hz en 4K (confirmé sur des forums).

Mesquin et p'tit bras...

Le 01/11/2024 à 06h05

Le 31/10/2024 à 22h51

.

Le 31/10/2024 à 23h51

Sur le PC fixe, le bouton n'existe pas, et sur les PC portables branchés à un écran externe, le bouton est grisé quand je suis sur l'écran externe.

Le 01/11/2024 à 06h09

Pareil pour la fonction "écran externe", mes portables récents ne supportent même plus l'affichage sur écran externe par exemple dans l'UEFI. Mes PC de bureau ont eu divers comportement mais ça doit venir des cartes graphiques... Affichage sur tous les écrans, affichage sur un ou deux...

Le 01/11/2024 à 06h14

Mon soft utilise cette fonction :

Comme il est dit il faut que l'écran supporte MCSS. C'est le cas des miens. Mais c'est vraiment hardware, si supporté. Sur certains écrans on peut même simuler les touches de l'OSD.

Ceci dit je ne sais pas comment Windows gère le multi écran (à part "pas"), mon logiciel est fait pour changer la luminosité d'un écran choisi à l'avance, ou de celui où se trouve le curseur souris.

Modifié le 02/11/2024 à 01h14

Oui le cas des portables en effet. La liaison physique Ecran - CM se fait en général par du LVDS (Low-voltage differential signaling) et non pas avec du HDMI ou DP (ou peut-être en surcouche logicielle par dessus, je ne sais pas).

J'utilise au quotidien du PC Desktop depuis quelques années déjà avec du moniteur externe donc j'avais zappé - oublié le cas du laptop et de sa liaison interne & directe.

Mais je pense quand même, que vu que sur un de mes 2 ports HDMI de mon écran externe, un logiciel spécialisé n'y arrive même pas, je doute que Windows lui y arrive... pour de l'externe.

Par exemple, changer la luminosité quand on regarde un film sur une TV branchée à un HTPC, soit dans le player ou dans les paramètres Windows, ce n'est que changer artificiellement la valeur "luminosité" des infos/ pixels qui envoyées à la TV, et non pas la luminosité des LED qui sont dans la TV (comme le ferait une télécommande par contre).

Pour info et pour l'avoir mesuré moi même, sur ma TV 55" LCD (2016) entre :

1 - Luminosité Min (on voit quasi plus rien)

et

- Luminosité Max (le soir, ça , ça explose les yeux),

on passe de 25W à 125W à la prise soit x5 plus d'énergie consommée pour le même appareil...

Bon je vais faire des tests ce weekend au wattmètre et en utilisant seulement les options de réglages de Windows pour les 2 ports HDMI de mon monitor Samsung... Je serai bien fixé.

Le 02/11/2024 à 15h49

Je suis passé de 3xTN + 3XIPS qui tiraient au total plus de 120W à 6xIPS qui consommaient 60W au total y'a pas loin de 10 ans. Cette année je suis passé à 1 seul 40" qui consomme... 20W. D'après ses specs il doit consommer 80W typique 88W max. La plupart du temps c'est luminosité 0 et contraste 30.

Pour regarder des films, c'est 50 contraste, 100 luminosité.

On peut utiliser les mêmes réglages pour bosser, c'est ce que j'appelle le mode "bronzage".

Jusqu'à mon dernier écran, tous les écrans que j'ai acheté étaient livrés en mode bronzage.

Modifié le 02/11/2024 à 16h29

Non... Impossible... soit l'un soit l'autre... Il faut choisir sa prise HDMI...

Sinon j'ai cherché, rien trouvé sur "MCSS" ... mais uniquement sur le protocole DCC (Display Data Channel) ici.

J'imagine que c'est en fait la même chose.

.

Le 03/11/2024 à 10h24

La spec la plus récente que j'ai est celle-ci : https://milek7.pl/ddcbacklight/mccs.pdf

Tu pourrais essayer de brancher les 2 entrées à ton PC, et essayer divers options (ne pas utiliser, étendre, mirroir...).

Du coup tu utiliserais l'entrée 60 Hz sur ton écran et tu enverrais les commandes à l'autres entrée.

NirSoft a un logiciel qui permet d'explorer ce que ton écran supporte de MCSS/VCP, peut-être qu'il pourrait faire mieux que ton autre logiciel.

Modifié le 04/11/2024 à 00h27

Je n'ai pas testé le DP. J'ai bien un adaptateur HDMI < = > DP et donc pouvoir connecter le port HDMI-CM sur le DP-SAMSUNG mais la logique voudrait que ça ne doit pas résoudre le problème.

Il faudrait que j'aille quand même finir par m'acheter un câble DP < = > DP pour test.

(oui je sais, un peu neuneu là dessus, la flemme, peut-être, sans doute, sûrement en fait...)

Le 04/11/2024 à 00h29

Lu trop vite...

Le 31/10/2024 à 09h04

Le 30/10/2024 à 00h00

Il y a une feinte avec le TB4/TB5 qui fait du DisplayPort 1.4 ou 2.1, mais le HDMI à l'air identique.

Le 30/10/2024 à 12h47

Le 30/10/2024 à 08h34

Le 29/10/2024 à 20h56

D'après la communication d'Apple, il est 6x plus rapide en montage vidéo qu'un PC au même prix.

Le 29/10/2024 à 21h27

.

Le 30/10/2024 à 08h55

car pour 600€ on a des PC avec un GPU dédié, donc en montage vidéo il doit être bien devant.

Le 30/10/2024 à 08h58

l

Le 30/10/2024 à 09h49

Le 30/10/2024 à 14h51

C'est le même prix. Que Apple soit plus rapide, pas de soucis. Mais je continuerai à prendre ce genre de machine plutôt (le prix peut être baissé en supprimant l'OS: -60€).

Sans compter que j'imagine que pour avoir le 6x plus rapide en montage, il faut adobe premiere, pas shotcut ou openshot ... Ca change aussi un poil le prix.

Le 31/10/2024 à 02h05

Le 31/10/2024 à 13h41

La config en question :

"Tests réalisés par Apple en septembre et octobre 2024 sur des prototypes de Mac mini équipés de la puce Apple M4 avec CPU 10 cœurs, GPU 10 cœurs, 16 Go de RAM et un SSD de 256 Go ainsi que sur des PC prêts à la commercialisation équipés d’un processeur Intel Core i7 avec carte graphique Intel UHD Graphics 770, 16 Go de RAM et un SSD de 512 Go, et de la toute dernière version de Windows 11 Famille disponible au moment des tests. Performances de la fréquence d’images du jeu No Man’s Sky (Build ID 13259642) testées à une résolution de 2 640 x 1 440 en mode Qualité Standard avec MetalFX réglé sur Performance et la fréquence d’images limitée à 240. Affinity Photo 2 v2.5.4 testé à l’aide du banc d’essai intégré version 25000. Adobe Lightroom Classic 13.5 testé à l’aide d’une image de 89,2 Mo. Adobe Premiere Pro 2024 v24.6.1 testé avec Détection du montage de scène à l’aide d’un projet de 3 minutes et 27 secondes avec des ressources H.264 à une résolution de 3 840 x 2 160 et une fréquence de 30 images par seconde. MotionMark 1.3.1 testé avec une préversion de Safari 18.1 sur macOS Sequoia. PC de bureau le plus vendu dans la même gamme de prix selon des données commerciales rendues publiques au cours des douze derniers mois."

Le 02/11/2024 à 07h24

Appréciable...

Le 31/10/2024 à 14h05

Apple M4 10 Core : 25080

iGPU 3x plus performant.

Connectique Thunderbolt 4

Sortie casque haute indépendance

Boitier aluminium

Alimentation intégrée

Totalement silencieux

C'est le jour et la nuit entre ces deux machines.

Le Mac Mini permet de faire de l'éditing vidéo en 4K et de la retouche photo sans broncher, le tout dans un silence total. Le Lenovo est suffisant pour de la bureautique, à la limite un peu de programmation, mais pas plus.

Certes, la majorité des acheteurs n'exploitera pas la toute puissance du M4, mais qui peut le plus peut le moins.

Le 31/10/2024 à 15h19

Le lien n'a pas gardé la config. POur être sur le même prix (699€) j'avais choisi un 8500GE - passmark: 22195, c'est déjà plus proche.

Sur cinebench il reste 30% sous le M4 en single et multi.

Pour un peu plus cher que le M4, le 8600GE est un meilleur choix (avec IA).

"Le Mac Mini permet de faire de l'éditing vidéo en 4K et de la retouche photo sans broncher, le tout dans un silence total. Le Lenovo est suffisant pour de la bureautique, à la limite un peu de programmation, mais pas plus."

Je ne nie pas que le M4 soit une bête, et un ordi très silencieux et très classe. Qu'il soit 6x plus rapide - en comparant à un Intel HD770 sur de la photo/vidéo certainement pas mal basé sur le GPU, je n'en doute pas.

Vu ce que je fais avec un 4650GE, je pense qu'on dépasse la bureautique de base :) (jeu, dev, rendu 3D et montage). Ayant eu un NUC avant, les NUC sont très limités face à ces PC qui sont en perf généralement beaucoup plus proches de la tour que d'un portable.

Et le mac mini n'est pas cher, mais il est totalement dans les eaux de ces mini PC qui ont aussi plein d'avantages: extensibilité (le mien a 1To de stockage en second disque et 16Go de RAM supplémentaires ajoutés après, 6 ports USB, 3 sorties vidéo avec la carte à 15€), garanti 3 ans de base - intervention à la maison (testé).

Bref, c'est cool d'avoir le choix, mais je ne panse pas du tout que les mac mini mettent tous les PC indéniablement au placard. C'est juste que la concurrence PC est assez peu connue.

Modifié le 02/11/2024 à 07h26

Un peu mais pas trop ? C'est où la limite entre "un peu" et "ça c'est trop ?"

Heureusement que les développeurs / programmeurs n'ont pas attendu un CPU 4 coeurs@4Ghz pour faire de la programmation...

Je me rappelle d'une caricature @ la Flock il y a une vingtaine d'années:

Un programmeur de jeu vidéo, plus que lui tout seul dans les bureaux, dans le noir, les yeux explosés @ 3h du mat, toujours devant son écran et qui finit par gueuler :

" Et puis merde à la fin, le matériel suivra bien " (ou pas des fois...)

A mon époque, l' IDE de TurboPascal de Borland (Integrated Development Environment) tournait très bien sur un 386DX@33Mhz, pas 4000Mhz, 33Mhz...

Il parait aussi que Bill Gates avait piqué une grave crise de nerf sur son CTO (Chief Technological Officer) à l'époque (véridique) :

Bill: "- Pourquoi notre Pascal à nous, il rame autant !?? "

CTO: "- Ben chez Borland, ils ont tout écrit en Assembleur de A à Z aussi..."

Borland est mort depuis bien longtemps, Microsoft par contre est la 2nde-3ieme valorisation financière la plus importante dans le monde, mais tous les 2 dont le job/la mission est (était) de pondre du code. Juste pas les mêmes choix stratégiques.

Tout comme le CP/M était technologiquement largement plus en avance que le DOS... (Multi-Users & Multi-Tasking... en 1984... sur un PC !)

Le CP/M, il est mort lui aussi... d'ailleurs ainsi que son créateur, dans une chute d'escalier dans un bar, portant ce soir là un blouson en cuir de motard "Harley-Davidson", détail pour pourrait expliquer sa chute "accidentelle" mais jamais prouvé malgré certains indices de la Police).

Bill Gates lui avait rendu hommage d'ailleurs peu après ( et aussi après avoir repompé un max de ses idées pour son PC/DOS...)

Bref... digression... désolé).

Le 03/11/2024 à 10h28

IDE très rapide, la compilation, bah, difficile de comparer. Peut-être plus rapide que Turbo-C je ne me souviens plus.

Une discussion qui revient régulièrement ici... on a juste des softs de plus en plus lourds (éventuellement sur des VM de plus en plus lourdes, Java, .NET, tout ce qui fait tourner du JS...)

Modifié le 04/11/2024 à 00h53

Un de mes amis de lycée (et toujours mon meilleur pote depuis cette époque là) avait lui un Kinetec (la boîte est morte elle aussi), donc un PC Kinetec 286@16Mhz et son PCSHELL à lui, il avait une grosse grosse patate, comparé à nous autres, en trotinette 8086/8088...

La vache... P'tain ! C'était y a 35 ans déjà !

Le 04/11/2024 à 15h17

Ceci dit il avait quand même 2 Mo de RAM (pas d'origine) hein ! (Assez inutiles en général, à part pour himem.sys et essayer de charger un max de trucs au dessus des 640 ko)

Les choses ont changé en 35 ans ! Pas toujours en mieux d'après moi ("obligation" d'écrire du code efficace vs énorme gaspillage par des programmes écrits avec les pieds)

Modifié le 04/11/2024 à 18h42

"286@16Mhz !!??"

Je voulais dire : " non, argh pas possible !!? ? Toi aussi t'avais un 286 comme mon meilleur pote au lycée !!"

et le jeu entre nous qui consistait à celui qui avait écrit le meilleur autoexec.bat pour dépasser 610Ko de RAM dispo...(la séquence dans le fichier avait son importance...)

Que des heures perdues pour ce qui est des futilités qui n'ont plus aucun sens maintenant... mais c'était marrant... quand on est jeune...

Juste pour remettre en perspective, un jour on avait essayé de lancer un jeu de simulation d'hélicoptère sur son 286.

Le programme a planté juste avant de s'exécuter.

Le message d'erreur, même à l'époque, nous avait fait bien rigoler quand même :

"Not enough memory, 1KB extra required"

1KB de libre qui manquait dans les 640KB

et maintenant on ne compte même plus en KB, même en MB mais en GB de RAM...

Gordon Moore (en plus de sa célèbre loi) avait dit aussi (milieu des années 90 déjà):

"Si l'industrie automobile avait évoluée aussi rapidement que celle des semi-conducteurs, vous auriez une voiture qui roule à 2000km/h, coûterait quelques US dollars seulement et tous les soirs en rentrant chez vous, vous jeteriez votre voiture à la casse pour en racheter une meilleure le lendemain matin..."

Modifié le 06/11/2024 à 15h51

Je faisais des autoexec/config.sys à menu pour avoir plusieurs configs, mais s'il fallait vraiment de la mémoire, c'était disquette de boot Ms-Dos 3.3 avec clavier en qwerty.

Modifié le 06/11/2024 à 18h13

La vache !! Ça met revenu instantanément en mémoire en lisant ta réponse !!!

CHAPEAU BAS !!!!

Modifié le 06/11/2024 à 18h22

Ensuite la 6.0 a finit le taff en s'asseyant définitivement dessus sur tous les moribons qui respiraient encore un peu...

Bye Bye Digital Research...

Le 07/11/2024 à 01h19

DR-DOS ? Je dois toujours avoir la boîte du 8 quelque part, on a eu PC-DOS 7 aussi, jamais trop vu la DIFFÉRENCE. Wikipedia dit qu'il n'y en avait pas vraiment.

Ceci dit MS-DOS est le seul sur lequel j'ai programmé je crois, même si je pense que les autres devaient avoir une int 21 compatible autant que possible.

Modifié le 07/11/2024 à 10h16

Moi je connaissais pas vraiment, je l'ai découvert juste il y a une dizaine années, et comme tu es aussi de cette époque apparemment, ça devrait t'intéresser :

l'histoire du CP/M et de son créateur :

Gary Kildall.

Si il avait fait l'effort de négocier un peu plus "cool" avec IBM en 1981, le monde de l'informatique serait sûrement très différent en 2024, avec une boîte qui s'appelait Microsoft morte et disparue depuis déjà bien longtemps. Mais à $250 contre $50 un MS-DOS, quasiment personne n'a acheté malgré une comptabilité multi plateforme.

Le système pouvait faire du multi user & multi tasking sur un simple PC en 1984 ! (64Ko mini).

Gary Kildall était clairement plusieurs niveaux au dessus de Bill Gates ( Williams Gates III qui lui a pourtant obtenu 600/600 à l'examen du SAT... environ seulement 300 étudiants par an aux US arrivent à atteindre un 600/600).

Kildall est le 1er programmeur a avoir écrit un dé-assembleur,- en plus du CP/M qu'il a écrit quasiment tout seul-, un dé -assembleur est mathématiquement complexe car il n'y a de bijection parfaite entre du code assembleur & du code de plus haut niveau...

Quand Gary Kildall est décédé à 52 ans, apparemment à cause d'une altercation dans un bar, Bill Gates lui a rendu hommage quelques jours plus tard , reconnaissant qu'il était réellement LE génie de la micro informatique de son époque.

Des fois on se prend à rêver au Multiverse de Marvel quand on lit ce genre d 'histoire...

Dommage...

CP/M

Gary Kildall

Le 30/10/2024 à 11h39

Modifié le 31/10/2024 à 08h01

Edit: Je veux dire: un peu comme les prises manettes de l'atari ST.

Edit2: Bien sûr que c'est une blague à tiroir, on est Jeudredi.

Modifié le 02/11/2024 à 07h32

2 fois (déposer - récupérer) un Samedi après-midi, mes parents ont dû m’emmener et faire 2 x 2 x 40km (~ 3h pour un 1 aller-retour porte à porte) pour aller au magasin qui était en plein centre-ville d’une grande ville pour faire réparer la (revenez dans 15 jours) ces p"tains de soudures de ports joystick d’un ATARI 520 STE… (à cause d’un design tout pourri et aussi car les joysticks lâchaient trop souvent et rapidement au passage, brancher-débrancher…).

En récupérant l’engin réparé, ils m’ont offert 2 petites rallonges de 10cm de long… Pas bien longues les rallonges mais largement suffisantes pour eux pour ne perdre encore plus tard 2 Samedi Après-midi « pour rien », surtout vu la tête de mon père :

« - C’est quoi un port DB9 de joystick ? Et c’est vraiment utile ça ? »

« - Ben oui évidemment Papa !!! ».

(C’était il y a 35 ans environ déjà... quand j'avais 15 ans )

Le 04/11/2024 à 15h20

Modifié le 04/11/2024 à 18h14

Bref un design pas vraiment intelligent...

D'ailleurs après, sur les modèles suivants, ATARI avait rajouté 2 ports joystick supplémentaires mais cette fois ci sur... le côté de l'ordi... là où on voit bien comment les brancher, cad en pleine lumière...

Le 31/10/2024 à 22h58

Modifié le 02/11/2024 à 07h38

De toute façon, pas grave, j'ai enlevé le boitier de la tour, retourné la carte mère vers moi, le tout posé sur un vieux tapis de souris et maintenant ça prend beaucoup moins de place et ça respire beaucoup mieux aussi...

Après certaines sociétés - ou certains gurus - ne supportent pas de voir un port de connexion enlaidir le design pur et unique de leurs produits et ont exigé de le cacher et masquer.

Exemple : sur certaines souris « haut de gamme », le port USB a été relégué EN-DESSOUS de la souris… (comme sur un ATARI ST mais en pire...)

« -Mais on fait comment pour bosser quand ça recharge ? »

« -On va prendre 20min de pause à la machine à café car plus de souris, mais attention, seulement une fois par mois pour la recharge d’après le manuel...

(pas pour un pause-café 1 fois par mois seulement, heureusement ! )

Steve J. l' avait exigé comme ça... Donc bon...