666e édition des LIDD : Liens Intelligents Du Dimanche

Le voilà, le tant attendu 666e !

Comme tous les dimanches (après une petite pause ces dernières semaines), voici notre sélection des liens les plus intéressants de ces derniers jours. Ils proviennent des commentaires les plus intéressants, utiles et/ou originaux de la semaine, mais aussi de nos recherches.

Le 19 mai 2024 à 00h00

8 min

Next

Next

Le floutage de demain passe dès aujourd’hui par l’IA

Dans sa revue des médias, l’INA propose un article très intéressant sur la nécessité d’inventer « le floutage de demain » : « Pendant longtemps, la télé a flouté les personnes qui souhaitaient témoigner de façon anonyme. Ces floutages sont désormais contournables grâce à l’intelligence artificielle. Pour trouver des solutions qui permettent de continuer à assurer la protection de ces témoins, une course contre la montre s'est engagée à France Télévisions ».

Nos confrères se sont posés la question de savoir si les méthodes d’anonymisation des visages étaient suffisantes, d’autant que cela soulève des questions déontologiques sur la nécessaire et obligatoire protection des sources. Résultat des courses : « le floutage tel qu’il existe aujourd’hui risque d’être compromis ». Une trentaine de sujets ont déjà été dépubliés.

Et si la solution venait de l’intelligence artificielle qui placerait un nouveau visage à la place de l’ancien, avec un autre intérêt que l’anonymisation : « L’IA permet d’envisager l’émotion qu’on nous partage, mais sans révéler le témoin. Le visage, c’est souvent la part d’humanité qui reste dans les zones du monde où il y a des conflits ou de la répression ».

Il y a déjà une utilisation concrète avec le documentaire Nous, jeunesse(s) d’Iran, cité par la Revue des médias. Il a été diffusé sur France 5 : « six récits de jeunes de moins de 25 ans donnent vie aux transformations en cours dans la société iranienne ».

Pour ce film, les réalisateurs ont « fait le choix de générer des visages via intelligence artificielle pour anonymiser ses témoins (au centre). Créer une simple mosaïque présente dorénavant trop de risques. Quant au carré noir, difficile de l'utiliser durant tout un film », explique l’INA.

Neurone et IA : la bonne connexion ?

France Culture propose un podcast sur l’histoire de l’IA : « Aux origines de l’intelligence artificielle, il y a la volonté de plusieurs chercheurs de décrypter les mécanismes de la pensée humaine. Quel rôle ont joué les premiers réseaux de neurones artificiels dans cette histoire à rebondissements ? ». L’invité du jour est Alban Leveau-Vallier, docteur en philosophie à Sciences Po Paris.

- Neurone et IA : la bonne connexion ? (podcast)

C’est quoi être « identifiable » au sens du RGPD ?

C’est la question à laquelle l’avocat spécialiste en droit de la création et de l’innovation Etienne Wery tente de répondre en s’appuyant sur une décision de justice de la Cour européenne.

La version courte : « Un communiqué de presse qui n’identifie pas la personne visée, mais contient des informations qui rendent l’identification possible sans « effort démesuré en termes de temps, de coût et de main-d’œuvre », de sorte que le risque d’identification n’est pas « insignifiant », est une donnée à caractère personnel ». La version longue est intéressante à lire :

Patch, Jeux olympiques et « biologie augmentée »

G Milgram revient avec une nouvelle vidéo sur le « patch bidon de Sanofi et…des Jeux Olympiques ». Le youtubeur explique avoir été contacté par plusieurs pharmaciens, ce qui l’a convaincu de se lancer dans l’analyse d’Initiv : « On va parler « « « biologie augmentée » » » et on va laisser la parole aux spécialistes ! ».

L’histoire de la soupe primordiale et du jeu de la vie

Il y a quelques semaines, EGO a proposé une vidéo sur le jeu de la vie. Il est extrêmement simple avec seulement deux règles et zéro joueur : placez-vous devant l’écran et regardez le « monde » évoluer. Changez quelques paramètres et modifiez complétement le résultat.

« Le Jeu de la Vie de Conway est un automate cellulaire où des cellules sur une grille bidimensionnelle évoluent à chaque tour selon des règles précises basées sur l'état de leurs voisines. Une cellule peut être "vivante" ou "morte", changeant d'état en fonction du nombre de voisins vivants. Ce jeu sans joueur illustre la complexité émergente et l'auto-organisation à partir de règles simples ».

-

- Le Jeu de la Vie (YouTube)

Si vous voulez en profiter pour retracer ce qui est probablement l’étape la plus importante de notre univers, sa première seconde de « vie », alors c’est le moment d’écouter ce podcast de France Culture. On y retrouve Julien Grain (cosmologiste, chargé de recherche à l’Institut d’Astrophysique spatiale d’Orsay) et Sébastien Renaux-Petel (physicien théoricien, spécialiste de cosmologie, chargé de recherche CNRS).

-

- Univers : l’affaire d’une seconde (podcast)

Combo perdant : masculinismes, identitaires et réseaux sociaux

France TV propose un documentaire dont le nom donne le ton : « Mascus, les hommes qui détestent les femmes ». Nos confrères reviennent sur des vidéos provocatrices sur les réseaux sociaux, qui cumulent des centaines de milliers de vues.

« Sous la forme d’une cyber-enquête, ce documentaire vise à décrypter la manosphère et à en montrer les dangers. Notre journaliste, Pierre Gault, s’est « infiltré » dans les forums, groupes Telegram ou WhatsApp et conversations privées. Banalisation des agressions sexuelles, appels au viol, propos misogynes mais aussi racistes, harcèlements… sa plongée au cœur des communautés masculinistes est vertigineuse et révèle une culture de la haine des femmes ».

France Culture propose de son côté un podcast intitulé « Masculinismes, identitaires : les réseaux au service d’une nouvelle vague réactionnaire », réalisé en partenariat avec Numerama.

« Alors que le sentiment de déclin de la population française ne cesse d'augmenter et que le pays semble traversé par une "fracture identitaire", une nouvelle vague d'influenceurs d'extrême droite émerge sur les réseaux sociaux ».

Le débarras des LIDD

La règle d’or « corrélation n’est pas causalité » est parfaitement illustré par ce site sur les fausses corrélations (en anglais). Saviez-vous, par exemple, que la qualité de l’air au Tennessee était quasi parfaitement aligné avec le nombre de films dans lesquels Orlando Bloom apparait ? Même chose pour les recherches « cat memes » sur Google et les rappels automobiles à cause de problèmes sur les Airbags. Coïncidences ? La fonction random permet de bien s’amuser et de tomber parfois sur quelques pépites.

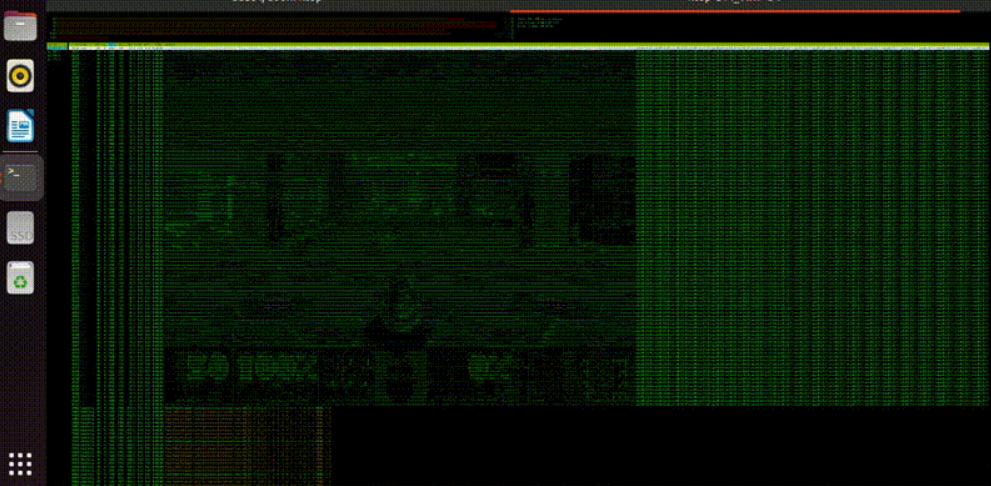

Doom dans Htop

Dans la pure lignée des choses les plus inutiles, il y a la fameuse question « Can it run Doom ? » dès que l’on parle d’un nouveau matériel, d’une application ou du moindre appareil avec un bout d’écran. C’est au tour du moniteur système Linux Htop de sauter le pas (GitHub). Je vous l’accorde, on a connu plus lisible…

Moins inutile (et donc moins indispensable ? Pas sûr…), The Nature of Code (en anglais) est un site proposant des exemples d’utilisation de la bibliothèque JavaScript p5.js avec des concepts physiques comme les vecteurs, les forces, les fractales. etc. L’Université de Genève propose une introduction à P5.js en français, qui permet de dessiner et de réaliser des animations.

Brouteurs broutés

Vous êtes encore là ? Alors allez lire un « petit » thread de Méta-Brouteur sur l’histoire du brouteur brouté. Attention toutefois, ces arnaques continuent de faire des victimes, ne vous laissez pas avoir ! Arnaquemoisitupeux aussi s’intéresse sujet et raconte « absolument n’importe quoi » à un brouteur depuis deux mois… et c’est peu de le dire.

Plus sérieusement, France Culture propose un podcast sur ce sujet avec deux chasseurs d’escrocs. L’un d’eux « s'invente des faux profils, hack les ordinateurs des arnaqueurs aux sentiments et vient en aide à leurs victimes ». L’autre, « modifie sa voix pour débusquer les escrocs. Et parfois, il réussit à les mettre hors d'état de nuire définitivement ».

Quoi, ce n’est toujours pas suffisant ? Alors voici de quoi terminer la journée : un rapport de plus de 500 pages (en anglais) de l’université de Stanford sur l’intelligence artificielle (si vous avez un résumé, je suis preneur !).

Meow ?

Et si vraiment cela ne suffit pas à vous endormir, alors on a la solution ultime avec meow.camera (en chinois, mais c’est pas grave). Oui oui, il s’agit bien de caméras installées dans des distributeurs de croquettes pour chat. Une croquette, deux croquettes, trois croquettes… Une sorte de CatRoulette.

666e édition des LIDD : Liens Intelligents Du Dimanche

-

Le floutage de demain passe dès aujourd’hui par l’IA

-

Neurone et IA : la bonne connexion ?

-

C’est quoi être « identifiable » au sens du RGPD ?

-

Patch, Jeux olympiques et « biologie augmentée »

-

L’histoire de la soupe primordiale et du jeu de la vie

-

Combo perdant : masculinismes, identitaires et réseaux sociaux

-

Le débarras des LIDD

-

Doom dans Htop

-

Brouteurs broutés

-

Meow ?

Commentaires (33)

Le 19/05/2024 à 00h29

Il doit même être possible d'avoir le résumé directement en français.

Le 19/05/2024 à 09h30

En fait, ça peut être pratique si tu veux générer un résumé d'un texte que tu connais, pour faire le gros du travail de rédaction et ne corriger que les parties problématiques. Mais si tu ne connais pas le contenu du texte d'origine, tu seras incapable de savoir si le contenu résumé est fidèle à la source ou pas. Un exemple, pour les plus curieux sur linuxfr, avec en particulier ce commentaire qui décrit les erreurs commises par l'IA (en l'occurrence, Bard)

Ensuite, un texte de 500 pages est bien trop long pour être résumé par les modèles actuels. Il faudrait le faire en plusieurs passes. Découper le texte initiale en différentes parties, puis résumer les parties, et faire un résumé des résumés (et potentiellement répéter le processus). Bref, je doute fortement de la qualité du résultat obtenu à la fin.

Le souci c'est que le résumé généré aurait une forme tout à fait correct. Mais le contenu peut être à des années lumières de ce qui est véritablement dit. Vérifier le contenu signifie... lire le document d'origine, et donc perdre tout intérêt du résumé !

Modifié le 20/05/2024 à 21h46

Sans juger du résultat voilà ce que donne Gemini (relativement facile même pour un journaliste humain si on considère que tout jusqu'à la page 26 est un résumé):

Le rapport AI Index 2024 de l'université de Stanford offre un aperçu complet du paysage de l'intelligence artificielle, mettant en lumière des tendances significatives en matière de recherche et développement, de performances techniques, d'IA responsable et d'impact économique. Le rapport constate que l'industrie continue de dominer la recherche de pointe en IA, les modèles de pointe devenant de plus en plus coûteux à entraîner. Il souligne également la prolifération des modèles de fondation, en particulier dans le domaine de l'IA générative, qui a connu une augmentation vertigineuse des investissements malgré une baisse globale des investissements privés en IA.

En termes de performances techniques, l'IA surpasse les capacités humaines dans plusieurs benchmarks, notamment la classification d'images, le raisonnement visuel et la compréhension de l'anglais. Cependant, elle est encore à la traîne dans des tâches plus complexes comme les mathématiques de niveau compétition, le raisonnement de bon sens visuel et la planification. Le rapport met en évidence l'émergence de l'IA multimodale, des benchmarks plus difficiles et l'utilisation croissante de l'IA pour générer des données spécialisées, ce qui stimule encore les progrès techniques. Fait notable, les LLM fermés surpassent considérablement les LLM ouverts en termes de performance.

L'IA responsable reste un sujet de préoccupation majeur. Le rapport révèle un manque de standardisation dans les évaluations de l'IA responsable, ce qui rend difficile la comparaison des risques et des limites des principaux modèles d'IA. Les deepfakes politiques sont faciles à générer et difficiles à détecter, tandis que les chercheurs découvrent des vulnérabilités plus complexes dans les LLM. Les entreprises du monde entier s'inquiètent des risques liés à l'IA, notamment en matière de confidentialité, de sécurité et de fiabilité. La transparence des développeurs d'IA est jugée faible, ce qui entrave les efforts de recherche. Le rapport met également en lumière les biais politiques des LLM et l'augmentation du nombre d'incidents liés à l'IA. L'opinion publique prend davantage conscience de l'impact potentiel de l'IA, ce qui entraîne une augmentation de la nervosité à l'échelle mondiale.

Le 20/05/2024 à 21h56

Après, cela n'enlève en rien ce que je disais : si le contexte n'est pas suffisamment grand (ce qui est le cas de la plupart des LLM disponibles), il faut découper le texte en portion plus petite, avec les inconvénients que cela à.

Le 20/05/2024 à 23h49

Par ailleurs tu as raison, c'est une grosse limite des modèles actuels et à ma connaissance aucun modèle ouvert n'a de contexte aussi grand.

Le 21/05/2024 à 08h12

Le 20/05/2024 à 21h33

Cet article s'insurge contre le fonctionnement du système de CVE et plus précisément contre la gestion par le NVD. L'auteur, membre de l'équipe de sécurité du projet curl, dénonce l'apparition d'un CVE (CVE-2020-19909) concernant une faille de sécurité dans curl sans que l'équipe en ait été informée.

Ce CVE, pourtant daté de 2020, semble avoir été publié récemment et est qualifié de "critique" par le NVD avec un score de 9,8 sur 10. L'auteur affirme qu'il s'agit d'une erreur d'appréciation grossière car la faille en question avait déjà été signalée en 2019, corrigée et ne constituait pas une menace sérieuse.

Le CVE en question concernait un débordement d'entier dans l'option de ligne de commande --retry-delay. Cette option permet de définir le délai d'attente de curl avant une nouvelle tentative en cas d'échec. Un débordement d'entier pouvait survenir avec des valeurs extrêmes, mais n'entraînait qu'un décalage dans le délai d'attente, sans aucune conséquence sur la sécurité.

L'auteur déplore que le NVD n'ait visiblement pas consulté le code source ni la correction apportée, se contentant d'un diagnostic superficiel basé sur la mention "débordement d'entier". La désinformation se propage maintenant à travers divers sites web qui reprennent le classement "critique" du NVD, créant une inquiétude injustifiée. L'auteur conclut en affirmant son intention de contester ce CVE auprès du MITRE.

Le 20/05/2024 à 21h58

Le résultat fourni est, sur cet exemple précis, mieux (ayant lu l'article d'origine, je confirme ^^). Cela ne veut pas pour autant dire que le résultat sera toujours mieux et ne sera jamais sujet à des hallucinations / contresens / etc.

Et pour ça, à moins d'avoir lu l'article d'origine, c'est impossible de le savoir.

Modifié le 20/05/2024 à 23h58

Les LLMs évoluent trop rapidement pour qu'un exemple de l'an dernier soit pertinent aujourd'hui.

Bard en particulier était reconnu pour halluciner énormément.

Le 21/05/2024 à 08h11

Pour attention, ne pas prendre pour argent comptant ce que dis une IA, cela reste tout à fait viable. Effectivement, pour illustrer mon propos, j'ai pris un exemple assez flagrant d'hallucination, où l'IA va jusqu'à dire l'opposé du papier original dans son résumé.

Attention aussi à ce que l'on appelle hallucination. Est-ce les erreurs commises par l'IA dans l'interprétation de ce qu'on lui demande, ou les erreurs dans le contenu appris ? Par exemple, 2 comportements, très différents d'un point de vue de l'utilisation :

- quelle est la date de naissance du Président de la République Française ? => 2 mars 1858

- quelle est la couleur du cheval blanc d'Henri IV ? => bleue

Dans les deux cas, j'ai volontairement répondu une erreur. Le premier relève d'une hallucination (il invente une information au lieu de dire je ne sais pas), tandis que le second correspond plutôt à une erreur de logique et ne nécessite pas savoir, juste de comprendre.

Le premier cas nécessite un apprentissage et si l'information n'était pas incluses dans le jeu de données d'entrainement, il ne pourra pas y répondre. Le second est indépendant du jeu d'entrainement.

De ce que j'ai vu jusqu'à présent, les hallucinations testées relèvent souvent du premier cas plus que du second.

Le 21/05/2024 à 07h41

Même si c'est la vitrine d'OpenAI, il ne faut pas le prendre comme argent comptant :)

Pour faire un parallèle chez Infomaniak, Mixtral est intégré sous forme de chatbot à l'outil de messagerie instantanée de la suite bureautique. Il est configuré pour un usage particulier, au même titre qu'il l'est pour la correction/rédaction de mails ou, plus récemment, l'assistance dans leur website builder. Par contre le modèle Mixtral dispo dans l'API LLM est "brut de fonderie" car charge au client de définir le system prompt et les usages.

Chez OpenAI, cela revient à utiliser les API de GPT.

Le 21/05/2024 à 08h03

Le 19/05/2024 à 01h19

😈 6️⃣6️⃣6️⃣

Prochaine étape : la 777e !

Le 19/05/2024 à 09h19

L'usage de cette technique est surtout étatique je suppose, non ?

Le 19/05/2024 à 10h08

Le 19/05/2024 à 15h22

Modifié le 19/05/2024 à 09h50

J'espère qu'ils mettent un gros encart en disant que le visage a été remplacé pour anonymisation, parce que sinon... une personne qui ressemblerait au visage utilisé pourrait se voir accuser du coup !

Pour ce type d'anonymisation (remplacer le visage), il serait pas mal d'utiliser tout le temps le même visage (ou un nombre restreint, en fonction du sexe et de la couleur de peau par exemple). D'une part, cela permettrait d'éviter l'écueil que j'énonce juste au dessus. D'autre part, à force, en voyant tel ou tel visage, il serait facile d'identifier le contenu comme un contenu anonymisé (flouté).

Pour les hommes, je propose Chuck Norris. Car personne n'ose s'en prendre là lui.

Modifié le 20/05/2024 à 07h36

On sent que la technologie n'est pas encore parfaite, mais le rendu était assez correcte.

Le 19/05/2024 à 09h42

Le 19/05/2024 à 10h09

Le 19/05/2024 à 11h06

Le 19/05/2024 à 10h25

Le 19/05/2024 à 10h59

Ce qui est bizarre, c'est que je l'avais désactivé il y a un bout de temps maintenant, car je ne l'ai pas mise à jour suite à toutes les mises à jour du site. Et là, elle est de nouveau active. Une MAJ de chrome peut être...

Mea culpa

Le 19/05/2024 à 10h31

Mais l’image est bien étalée sur toute la largeur chez moi.

Le 19/05/2024 à 11h07

Pour la taille, le "bogue" est chez moi. Voir ma réponse à Ferd en #5.2

Le 19/05/2024 à 15h03

Je vais pet-être réactiver l'extension de fdorin.

Le 19/05/2024 à 20h51

Le 19/05/2024 à 11h15

En gros : une IA générative de 100ko (oui oui, ko !!) par concept avec une durée d'apprentissage de 4min par nouveau concept.

Attention, ça ne veut pas dire que le modèle fait moins de 100ko. Il faut malgré tout un modèle préentrainé qui peut faire quelques Go. C'est juste que l'apprentissage d'un nouveau concept ce fait rapidement et pour un coût assez modique.

Le papier : https://research.nvidia.com/labs/par/Perfusion/

Une implémentation : https://github.com/lucidrains/perfusion-pytorch?tab=readme-ov-file

@SebGF : un avis ? Je sais que tu as fait pas mal d'essais avec plusieurs IA de génération d'images ;)

Modifié le 19/05/2024 à 13h02

Merci pour la notification, j'irai y jeter un oeil pour le mettre en concurrence avec SD :)

Le 19/05/2024 à 13h20

Après, l'implémentation que j'ai donné utilise a priori un modèle de Stable Diffusion. Donc les résultats obtenus doivent assez proche, sauf à l'entrainer spécifiquement sur un nouveau concept précis.

Modifié le 19/05/2024 à 16h19

Pour la génération d'image, au début j'utilisais Craiyon (une implem de DALL-E) puis quand j'ai découvert AUTOMATIC1111 pour SD, au début via le truc hébergé sur Google mais qui vite été limité, j'ai fini par recycler mon ancien PC de jeu. C'est surtout les modèles de SD que j'essaye de varier :)

Depuis je tourne avec InvokeAI.

Après c'est dans le cadre pro que j'ai eu l'occasion de tester le service managé OpenAI d'Azure.

Le 19/05/2024 à 11h58

* dans la séquence sur la « drague de rue », le journaliste reproduit du harcèlement de rue envers une femme sans même le mentionner, on aura juste le droit à ses états d'âme pour se consoler…

* achat de formation pour découvrir ce qu'elles proposent, j'aurais apprécié entendre les questions que cela a pu poser d'acheter ces formations, qui les paie (ce qui entretient/finance ces réseaux)…

* séquence vidéo du tueur de la fusillade d'Isla Vista sans avertissement (la pertinence de telles images est questionnable)

* présence d'images de scènes de crime sans avertissement (là encore l'intérêt journalistique de ces images reste flou)

* ça manque de vidéos de chatons (comme suggéré par Stéphanie Lamy) pour se remettre de tout ça sur la fin du documentaire (plus le documentaire devient trash moins il y a de chatons)

Ces éléments me questionnent sur l'intégration d'un comité d'éthique lors du processus de réalisation/production de ce documentaire.

Le 21/05/2024 à 12h47