Google fait un all-in sur l’IA avec Gemini

From Google I/O to Google I/A

Flock

Google a donné hier soir le top départ de sa conférence I/O 2024. Comme prévu, il n’a pratiquement été question que d’intelligence artificielle. Bon gré mal gré, l’entreprise diffuse Gemini dans tous ses produits, confirmant que pas un service n’y échappera. Dans la masse, certaines annonces sont particulièrement intéressantes.

Le 15 mai à 17h15

9 min

IA et algorithmes

IA

Pas question pour Google de se laisser distancer. Face à la toute-puissance d’OpenAI et de ses modèles GPT, la firme de Mountain View persiste et signe : elle sait où elle va. Les annonces de la conférence I/O vont ainsi toutes dans la même direction, du renforcement des modèles existants aux nouvelles fonctions affiliées Gemini dans les services de l’entreprise.

Si une partie des annonces concerne les développeurs, d’autres touchent directement les utilisateurs finaux. En revanche, tout ce qui concerne Android 15 ne sera dévoilé que ce soir. Concernant la partie matérielle, nous sommes déjà revenus sur le nouveau TPU de 6e génération.

On commence avec les annonces liées à Gemini. Nous en reviendrons plus tard sur les autres apports, notamment ceux pour Android.

Gemini 1.5 Pro grimpe à deux millions de jetons

Google a d’abord annoncé une nouvelle mouture de Gemini 1.5 Pro, disponible uniquement en préversion pour des clients triés sur le volet (comme pour les précédentes). Principal changement, le passage à deux millions de jetons, ce qui en fait le modèle acceptant la plus grande quantité de données en entrée. Son concurrent le plus proche, Claude 3, n’accepte « que » un seul million de jetons.

Rappelons qu’un jeton est une subdivision de données brutes. Deux millions de jetons représentent en moyenne 1,4 million de mots, 2 heures de vidéo ou 22 heures de son. Le nombre de jetons détermine ainsi directement le contexte que le modèle est capable de prendre en compte. Dans le cas d’une conversation, Gemini 1.5 Pro peut se baser sur des milliers de phrases pour adapter sa réponse aux nouvelles demandes.

L’accès à Gemini 1.5 Pro peut être demandé via Google AI Studio, en s’inscrivant sur liste d’attente. Google a toutefois prévenu que les invitations seraient limitées. La version précédente de Gemini 1.5 Pro avec un million de jetons sera disponible publiquement dans le courant du mois prochain. Elle aussi est toujours en préversion pour l’instant.

Gemini Flash et nouveaux outils

Google a présenté également une version Flash de son Gemini 1.5. Il s’agit d’un modèle nettement plus petit conçu pour des charges de travail réduites. Comme son grand frère Pro, il est multimodal. Il peut prendre en compte jusqu’à un million de jetons. Google le met en avant pour des tâches simples comme la création de résumés, les applications de chat, l’application de sous-titres sur des vidéos ou l’extraction de données.

Certaines nouveautés sont en outre communes à tous les modèles Gemini, notamment la mise en cache du contexte. Les développeurs peuvent ainsi déporter de vastes quantités d’informations dans une base de données ou de connaissances, en vue d’y relancer des analyses plus tard.

Citons également l’API Batch qui, comme son nom l’indique, permet d’envoyer une série de requêtes à plusieurs modèles en même temps. D’ici la fin du mois, une autre fonction permettra (en préversion) de contrôler les sorties de Gemini pour les envoyer vers des formats ou schémas spécifiques, comme JSON ou XML.

Gemini Live et Nano

Gemini Live n’est pas un modèle, mais une nouvelle manière d’expérimenter les capacités de Gemini. Il s’agit d’une capacité autorisant les conversations vocales directes avec l’assistant, comme une conversation entre deux personnes. On peut par exemple couper la parole à l’assistant, qui s’adapte pour réagir, le tout en temps réel, promet Google. La conversation peut être enrichie de photos ou de vidéos prises sur l’instant pour donner du contexte.

Live n’est pas à proprement parler une grosse nouveauté, davantage une démonstration de ce qu’il est possible d’obtenir avec Gemini : une conversation « naturelle », en temps réel, avec adaptation de l’assistant à tous les paramètres pour des réponses plus adaptées, le tout servi avec une prononciation plus expressive. La fonction doit arriver d'ici à la fin de l’année, mais ne sera pas gratuite. Elle sera réservée à l’abonnement Gemini Advanced, comprise dans l’offre Google One AI Premium vendue 21,99 euros par mois.

Nano, le plus petit modèle de la famille Gemini, devient à son tour multimodal. Il accepte donc en entrée les sons, photos et vidéos, en plus du texte. Une amélioration importante pour ce modèle qui peut être exécuté localement.

Nano va d’ailleurs être intégré à Chrome 126 (nous en sommes à la version 124). Les développeurs pourront y faire appel pour exploiter la puissance de l’appareil. Google s’en servira d’ailleurs pour certaines fonctions, notamment « Aidez-moi à écrire » dans Gmail. Selon l’entreprise, ce sont les progrès sur le support de WebGPU et WASM qui ont permis cette intégration. À noter qu’une ouverture est prévue vers les autres navigateurs, Google ayant indiqué être en pourparlers à ce sujet. À voir si l’inclusion d’un modèle de Google au sein de leurs produits les intéressera.

Enfin, Google a indiqué que Grammarly et Patreon se servent déjà de Gemini Nano.

Gemini pour Android, pour Gmail...

Vous voulez encore du Gemini ? On passe cette fois à des applications plus concrètes, avec l’arrivée de fonctions dans des services et applications connus.

L’intégration de Gemini dans Android va ainsi se renforcer et ajouter de petites fonctions çà et là. Par exemple, on pourra ajouter rapidement des images générées par IA dans Gmail, Messages et d’autres applications. Les abonnés Gemini Advanced pourront ajouter le questionnement de PDF à leur besace (jusqu’à 1 500 pages), avec possibilité de demander des renseignements précis sur des documents dans ce format.

Dans Gmail aussi la présence de Gemini va se renforcer. Google a montré plusieurs exemples de ce qu’il sera possible de faire, comme la possibilité pour un parent de demander un résumé des échanges de courriers avec l’établissement scolaire de leur enfant, y compris des pièces jointes. On pourra aussi demander à Gmail de créer une comparaison entre plusieurs devis, de chercher et récupérer tous les reçus de boutiques pour les envoyer vers un nouveau dossier Drive, de créer des flux automatisés pour ne pas avoir à répéter ce type d’opération, etc.

... et pour Maps, et pour Photos...

Gemini va bien sûr arriver dans Maps, d’abord sous la forme d’améliorations pour l’API Places. Les développeurs l’utilisant peuvent afficher des résumés générés par IA pour les lieux et zones, dans l’optique de leur éviter cette tâche rébarbative. Ces résumés s’appuieront bien entendu sur les notes et avis des plus de 300 millions de contributeurs du service. Cette même API permet aussi les recherches contextuelles dans les applications tierces, par exemple « restaurants adaptés aux chiens ». Cette recherche contextuelle est disponible dès maintenant partout, mais les résumés sont pour l’instant réservés aux États-Unis.

Quant à Photos, Gemini va y apporter une nouvelle recherche permettant de lancer des requêtes en langage naturel. On pourra ainsi demander de trouver des clichés ou images correspondant à une description ou un contexte précis. L’amélioration sera disponible dans le courant de l’été.

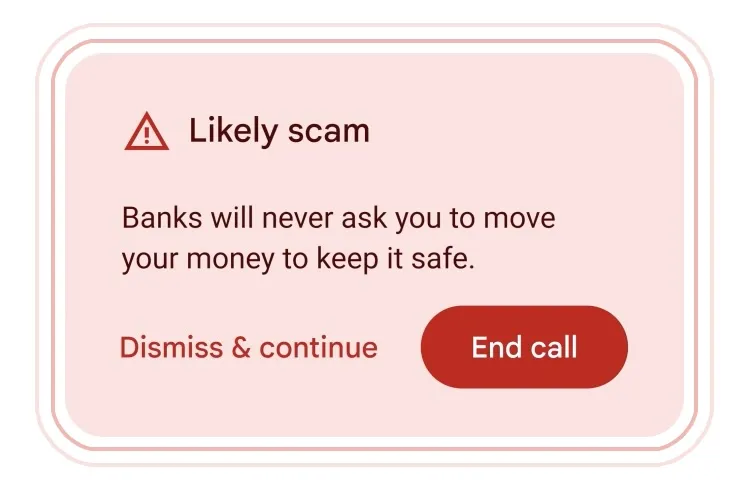

Une détection temps réel des arnaques téléphoniques

Autre exemple concret d’utilisation de Gemini, l’intégration prochaine dans Android d’une analyse en temps réel des conversations téléphoniques pour détecter des tentatives d’arnaque. La fonction sera basée sur Gemini Nano et sera exécutée localement. Il n’est pas censé y avoir communication avec les serveurs de Google.

L’idée est de détecter des « patterns » dans les échanges, comme lorsque qu’une personne se présente comme employée d’une banque ou d’un service client. La fonction se lancera à la recherche de mots-clés, de formulations et d’un comportement semblant se diriger vers la révélation d’une information sensible. Il s’agit d’une fonction optionnelle, qu’il faudra activer manuellement, probablement pour éviter l’immanquable levée de boucliers devant une analyse systématique de toutes les conversations. Même avec un modèle exécuté localement.

Astra, le multimodal en temps réel

La quasi-totalité des améliorations portées à Gemini sont le résultat du projet Astra, une initiative de DeepMind visant à créer une compréhension multimodale temps réel lors des échanges. C’est particulièrement vrai avec Gemini Live, représentant le plus visible et le plus éclatant de cette approche. Et ce, même si Google s’est fait couper l’herbe sous le pied par OpenAI et son nouveau modèle GPT-4o, qui permet de faire exactement la même chose si correctement exploité.

« Nous avons toujours voulu construire un agent universel qui serait utile dans la vie de tous les jours. Imaginez des agents capables de voir et d'entendre ce que nous faisons, de mieux comprendre le contexte dans lequel nous nous trouvons et de répondre rapidement dans une conversation, ce qui rendrait le rythme et la qualité des interactions beaucoup plus naturels », a ainsi déclaré Demis Hassabis, à la tête de DeepMind. À l’entendre, le film Her n’est plus si loin.

Google fait un all-in sur l’IA avec Gemini

-

Gemini 1.5 Pro grimpe à deux millions de jetons

-

Gemini Flash et nouveaux outils

-

Gemini Live et Nano

-

Gemini pour Android, pour Gmail…

-

… et pour Maps, et pour Photos…

-

Une détection temps réel des arnaques téléphoniques

-

Astra, le multimodal en temps réel

Commentaires (7)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousModifié le 15/05/2024 à 18h36

Je réinterprète le dernier paragraphe.

Bref, ce que Facebook voulait réaliser avec le metaverse, à savoir tout savoir sur vous tout le temps, Google compte bien y arriver grâce à l'IA

Le 16/05/2024 à 09h31

Le 15/05/2024 à 18h32

L'IA coute extrèment mais un outil extraordinaire, il permet de récolter énormément d'information utilisateur afin de dresser des profils extrèemement précis.

Dommage que les médias généralistes ne parlent pas de ces aspects novateurs.

Modifié le 15/05/2024 à 22h33

Je m'explique : avec ce type d'outil, on peut avoir accès à de la connaissance en direct, sans même passer par la source de l'information. Dès lors, les sources d'information sont invisibilisées et tomberont petit à petit dans l'oubli : au lieu d'aller chercher comment debugguer tel problème sur Stack Overflow, on demandera à une IA... et ça fonctionnera très bien. Par contre, on n'ira pas sur Stack Overflow, et on aura donc moins l'occasion d'y donner une petite précision du style "on peut aussi faire comme cela pour tel cas très particulier". Du coup, une information qu'on aura dans notre cerveau y restera (jusqu'à l'oubli), au lieu d'aller irrigué la Connaissance sur Internet.

Je pense que s'il n'y a pas moyen ou incitation à aller déverser de la connaissance à l'ère du Web IA, on va avoir une stagnation de la Connaissance au niveau mondial.

J'avoue que ça m'inquiète un peu et j'espère me tromper.

Le 16/05/2024 à 00h16

Nous aurons un accès instantané à une connaissance appauvrie et uniformisée.

Le 16/05/2024 à 05h23

C'est un phénomène qui s'était déjà bien amorcé depuis plus de 15 ans avec la masse de contenu de faible qualité qui exploite les algorithmes de Google, Facebook et co (déjà des formes primitives d'IA), ce qui a mené à la fin des revenus publicitaires suffisants pour les sources gratuites de qualité du début d'Internet, et le retour des paywalls.

Next en est d'ailleurs un bon exemple.

Le 06/06/2024 à 23h28

Bref tout ça pour dire que l’illustration de Flock pour cet article, c’est du génie !