Évolution de l’exposition aux ondes avec l’arrivée de la 5G : l’ANFR fait le point

Aller plus haut...

Le 18 septembre 2020 à 15h00

11 min

Société numérique

Société

L'ANFR publie une nouvelle étude, estimant que dans différents scénarios, on resterait bien en-dessous des limites réglementaires : « l’augmentation de l’exposition due à la 5G en bande 3,5 GHz resterait modérée ».

En France, la 5G se limite à des expérimentations. Au dernier décompte, il y en a près de 500 autorisées sur le territoire, dont plus de 350 rien que pour Orange. 67 pour Bouygues Telecom , 54 pour SFR, 9 chez Free.

Tous ont déjà manifesté leur intention de se lancer dans cette nouvelle évolution des réseaux de téléphonie mobile qui pourra utiliser la bande des 700 MHz, mais aussi celle des 3,5 GHz. Il s'agit de « la bande "cœur 5G" », actuellement utilisée pour le THD Radio et le WiMAX. Ils ont pour cela acheté à prix fixe 50 MHz de fréquences. Les prochaines enchères qui débuteront à la fin du mois visent à répartir les 110 MHz restant.

Une procédure qui s'ouvrira dans un climat plus que tendu, certains demandant un moratoire sur la 5G (nous y reviendrons dans la suite de ce dossier). C'est dans ce cadre que l’Agence nationale des fréquences (ANFR) publie un nouveau rapport. Plus précisément, il s'agit d'une « simulation de l’exposition aux ondes créée par la téléphonie mobile en zone urbaine dense, tenant compte de l’évolution envisagée en 4G et 5G ».

L'objectif est sans doute de répondre aux inquiétudes manifestées ici ou là, mais aussi de rappeler à tous certaines réalités : Avec ou sans 5G, il existe des règles à respecter et des niveaux à ne pas dépasser. Et même sans ce nouveau bond technologique, l’exposition aux ondes devrait continuer d’augmenter.

À défaut de pouvoir caractériser avec certitude ce que donnera le déploiement de la 5G, quatre scénarios sont étudiés afin d’obtenir une première estimation de ce à quoi sera soumis le public et s'y préparer.

Scénarios, estimations, majorant… de quoi parle l’ANFR ?

Une étude est réalisée en partenariat avec le Centre Scientifique et Technique du Bâtiment (CSTB), basées sur le 14e arrondissement de Paris, « représentatif d’une zone urbaine très dense » où la 4G est déjà largement déployée par les quatre opérateurs nationaux. Mais avant d'évoquer les résultats, il faut comprendre de quoi parle l’ANFR.

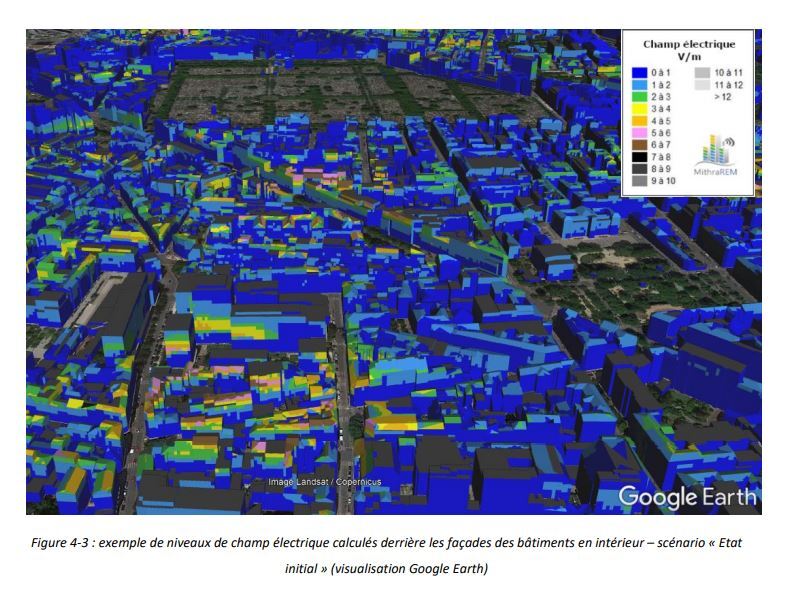

« Un modèle numérique a été construit, sur lequel ont été effectués les calculs de propagation afin d’estimer les niveaux d’exposition de champs électromagnétiques créés par les antennes de téléphonie mobile », via le logiciel MithraREM. Les autres sources d’ondes comme les émetteurs FM, TV, Wi- Fi, etc. ne sont pas pris en compte. Le protocole et les paramètres utilisés sont détaillés dans ce document.

On y apprend notamment que du simple vitrage et des bâtiments en béton léger sont pris par défaut, afin d’obtenir un niveau maximum d’exposition. Une sorte de « pire des cas » puisqu'avec du double vitrage ou du béton plus épais, l’atténuation serait plus importante. L’ANFR veut obtenir autant que possible des niveaux maximums.

Les quatre scénarios analysés sont résumés de la manière suivante :

- « État initial » : il reproduit l’état actuel des réseaux de téléphonie mobile

- « 4G optimisée » : il optimise la 4G, ce qui lui permettrait d’absorber une partie de l’augmentation du trafic

- « 5G seule » : il modélise l’exposition due à la 5G en bande 3,5 GHz

- « Majorant 5G » : il combine 4G optimisée et 5G seule, toutes les fréquences utilisées à leur maximum

La 4G poussée dans ses derniers retranchements, avec ou sans 5G

Cette étude a débuté en 2018, le scénario État initial correspond donc aux réseaux 2G, 3G et 4G tels qu’ils existaient fin 2017, mais « cette situation est restée très proche de l’état du réseau en 2020 », affirme l’ANFR. La 4G optimisée consiste à pousser cette technologie dans ses derniers retranchements, en « optimisant à la fois la puissance des émetteurs et la technologie utilisée », sans aucune 5G. C’est évidemment une approche théorique.

Ce scénario, établi après consultation des opérateurs, suppose un large refarming des bandes de fréquences : les 1 800, 2 100 et 2 600 MHz seraient ainsi uniquement utilisées pour de la 4G (contre 2G, 3G et/ou 4G actuellement), tandis que les 900 MHz resteraient en 2G/3G pour les terminaux qui en auraient besoin. La puissance des antennes serait également poussée à leur maximum, soit 4x 40 watts.

Ce scénario permet de « disposer d’un majorant de la puissance susceptible d’être mise en œuvre dans les bandes « historiques » (de 700 MHz à 2 600 MHz), lorsque celles-ci seront entièrement optimisées – qu’elles le soient en 4G ou en 5G ». Bref, une 4G poussée à son plein potentiels, dans les limites réglementaires, sans trace de 5G.

Le 5G seule porte bien son nom : « Seule la 5G est prise en compte, dans une seule bande (3,5 GHz), sans prendre en compte les autres contributeurs de la téléphonie mobile ». L’ANFR est parti sur une base de 80 MHz par opérateur (soit 320 MHz au total). En réalité, ils auront 50 MHz chacun et se partageront 110 MHz, soit 310 MHz.

Ce scénario ne sera jamais mis en place dans la pratique puisque la 2G, 3G et 4G continueront d’exister, et surtout les bandes historiques ne vont pas cesser d’être utilisées par les opérateurs. Il permet néanmoins de comparer le niveau d’exposition en 4G et en 5G dans des conditions équivalentes : « les localisation, disposition et azimut des émetteurs 5G sont identiques à ceux des aériens 4G ».

Enfin, le scénario Majorant 5G mélange 5G seule et 4G optimisée. Il « peut en effet être considéré comme un majorant a priori de l’exposition produite si tous les leviers d’optimisation étaient activés sur toutes les bandes disponibles », explique l’Agence. Elle ajoute qu’il « pourrait n’être jamais atteint », car « la conversion de bandes historiques à la 5G peut ne pas entraîner le même accroissement de puissance que celui envisagé pour la 4G, par exemple ».

Ce tableau récapitule les différentes situations analysées :

Trois types de calculs sont effectués afin de proposer une estimation de l’exposition aux ondes dans différents cas. En extérieur, on a des mesures à 1,5 mètre au-dessus du niveau du sol dans des espaces publics (usage d’un piéton) et tous les 2 mètres sur les façades des bâtiments. Il y en a également en intérieur, derrière les mêmes façades.

Cela représente un total de 3,2 millions points de mesures simulés par ordinateur (dont 2,1 millions au niveau des façades et 1,1 million au sol). Suffisant pour se faire une première idée assez précise.

Même sans 5G, l’exposition « devrait continuer de s’accroître »

Maintenant que le décor est posé, passons aux estimations obtenues par l’ANFR. Dans le cadre de l’État initial (censée représenter la situation actuelle), le niveau moyen varie entre 0,6 et 1,1 V/m (pour une médiane entre 0,4 et 0,8 V/m). En 4G optimisée on passerait entre 1 et 1,8 V/m (la médiane grimperait entre 0,6 et 1,3 V/m).

Ainsi, sans 5G, « l’exposition du public aux ondes devrait continuer de s’accroître pour répondre à la demande croissante en connectivité mobile en zone dense :+ 70 % par rapport à la situation actuelle ». On reste néanmoins en deçà des mesures in situ de l’ANFR qui donnent un niveau médian en milieu urbain de 0,40 V/m en 2017 et 0,45 V/m en 2019, le 14e arrondissement n’était donc a priori pas encore dans le cas 4G optimisée en 2018.

Selon l'ANFR « un hypothétique gel de l’évolution technologique n’aurait pas pour effet de stabiliser l’exposition du public au niveau actuel : s’il s’agit de répondre à la croissance du volume des données mobiles, la logique d’optimisation de la 4G conduira à un accroissement de l’exposition dans les zones denses ».

La 5G ne devrait pas être « le contributeur principal »

Sur la 5G seule, qui est une vue de l’esprit car il n’y aurait ni 2G, 3G ou 4G, le niveau moyen d’exposition aux ondes serait de 0,76 V/m derrière les façades et 1,36 V/m devant. Il n’y a pas d’estimation au sol pour la 5G seule.

Enfin, le dernier scénario d’anticipation est certainement le plus complet, mais aussi le plus hypothétique. Il combine pour rappel la 4G optimisée avec la 5G en prime. Le niveau moyen d’exposition est de 1,3 à 2,3 V/m (pour une médiane entre 0,9 et 1,8 V/m). Pour l’ANFR, la conclusion est sans appel :

« Les antennes à faisceaux orientables de la 5G dans la bande 3,4 - 3,8 GHz par rapport aux antennes classiques à faisceau fixe avec les hypothèses retenues ne devraient donc pas être à terme le contributeur principal de l’exposition, y compris en zone urbaine dense ou ces antennes devraient largement être déployées [...] Alors que la bande 3,5 GHz accroîtra la dotation en fréquences des opérateurs d’environ 50 %, elle ne contribuerait qu’à environ 30 % de l’exposition du scénario le plus défavorable ».

Vers une (forte) augmentation des points atypiques ?

Dans tous les scénarios et quelques soit le type de mesures (intérieur/extérieur), on est donc très loin de la limite réglementaire qui varie entre 36 et 61 V/m suivant les fréquences.

Le niveau maximum moyen serait pour rappel de 2,3 V/m dans le scénario Majorant 5G, avec une médiane à 1,8 V/m. Mais l’ANFR note une forte augmentation des points supérieurs ou égaux à 6 V/m derrière les façades, c’est-à-dire les points atypiques que l’Agence tente de faire résorber et qu’elle surveille de près.

Ils sont en effet « multiplié par environ 15 en intérieur, même si le pourcentage reste faible pour le dernier scénario (1,1 %) ». Devant les façades, le pourcentage de points atypiques est plus élevé : 6 % en Majorant 5G, mais la hausse (x11) reste par rapport à l’État initial reste dans le même ordre de grandeur.

D’une manière globale, l’étude fait apparaître « que la croissance du volume de données fera croître le nombre de points supérieurs à 6 V/m dans les zones urbaines très denses. Le nombre d’émetteurs entrant en procédure de "point atypique" sera donc plus élevé ». Notez ici qu’il s’agit bien de l’augmentation du volume de donnée, à laquelle les opérateurs doivent répondre d’une manière ou d’une autre : soit en optimisant la 4G et/ou avec de la 5G.

À moins que les consommateurs ne changent leurs habitudes et leurs pratiques, bien évidemment.

- Bilan de l’exposition du public aux ondes, un « point atypique » à plus de 28 V/m

- Exposition aux ondes en 2019 : 29 « points atypiques » et une injonction

Une étude qui sera affinée au fil des déploiements

Il ne s’agit là que d’une première étape dans l’étude l’exposition aux ondes de l’ANFR qui compte revoir ses scénarios en tenant compte des licences attribuées, et des politiques de déploiement des opérateurs.

Le scénario Majorant 5G se veut en effet un maximum théorique qui « pourrait n’être jamais atteint ». Chaque opérateur étant libre de ses choix (dans le respect de la réglementation), impossible pour le moment de prévoir le paysage de la 5G en France à moyenne et longue échéance.

Notez enfin que l’on parle bien ici de niveaux d’exposition aux ondes, pas des conséquences sanitaires que cela pourrait avoir. Ce dernier point n’est pas du ressort de l’ANFR, mais de l’ANSES (Agence nationale de sécurité sanitaire de l'alimentation, de l'environnement et du travail) qui doit rendre son rapport final, très attendu, sur les risques sanitaires de la 5G vers la fin du premier trimestre 2021.

Évolution de l’exposition aux ondes avec l’arrivée de la 5G : l’ANFR fait le point

-

Scénarios, estimations, majorant… de quoi parle l’ANFR ?

-

La 4G poussée dans ses derniers retranchements, avec ou sans 5G

-

Même sans 5G, l’exposition « devrait continuer de s’accroître »

-

La 5G ne devrait pas être « le contributeur principal »

-

Vers une (forte) augmentation des points atypiques ?

-

Une étude qui sera affinée au fil des déploiements

Commentaires (29)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 18/09/2020 à 15h55

Il y a problème… ou les valeurs sont exagérées et le blindage des façades est faible, ou bien les logements en attique sont clairement défavorisés par les faisceaux en rapport de la rue moins exposée.

Entre 5 et 6v/m sur une demi journée (occupation du logement) c’est pas la même norme… même si 1% de la ville est atypique ça nous fait pas mal de cas leur affaire.

Le 18/09/2020 à 16h34

Le 18/09/2020 à 19h43

Mais il y a pire. Les bâtiments ne sont pas tous en béton et les toitures en zinc. SI tu savais…

Ce genre de faisceaux ou modélisations devraient apparaître dans les P.L.U. partie graphique, ne serait-ce que pour contrôler la position des fenêtres et éléments réfléchissants. Au moins, on ne pourrait pas dire qu’il n’y a rien de fait pour le cas pratique du côté de la collectivité ou du régulateur.

Le 18/09/2020 à 17h15

Donc en été on s’en prend plein la tronche, la fenêtre ouverte

Le 18/09/2020 à 20h02

C’est intéressant parce qu’ils font une étude très précise, avec un logiciel très pointu, mais aucun des scénarios n’est réaliste.

On comprend évidemment le tendance et le message : ca augmentera de toutes façons et les niveaux d’exposition sont en deçà des seuils réglementaires.

Le 19/09/2020 à 05h43

La méthode est correcte et c’est déjà une avancée énorme…. la question c’est jusqu’à quel point on peut défendre des chiffres par moyenne ou médiane tant le problème reste dans les faits, individuel.

Le 19/09/2020 à 10h10

Toutes considérations de moratoire mises à part, je ne comprends pas trop pourquoi le rapport de l’ANSES est attendu pour… après le début du déploiement.

Le 19/09/2020 à 14h26

je ne comprends pas un point : antennes et azimuts identiques. j’ai cru lire que la 5G reposerait (aussi) sur des antennes très localisées à faibles portées, sans doute implantées dans des éléments de voiries (genre arrêt de bus). et que ce seraient ces antennes qui feraient de la 3.5GHz.

Le 19/09/2020 à 22h48

Encore de l’argent public foutu en l’air…

Bon l’ANFR fait le boulot qu’on lui demande, mais ça serait tellement mieux si on arrêtait de déconner sur ce sujet des “ondes”.

On sait qu’en-deça des UV, les ondes électro-magnétiques ne sont pas ionisantes, donc pas d’impact délétère sur la biologie. On le sait en gros depuis le début du 20e siècle avec ce qui a valu le prix Nobel à Einstein, l’explication de l’effet photo-électrique ; et bien sûr on a affiné depuis nos connaissances.

Ça fait 20 ans qu’on a des millions et puis des milliards de mobiles en fonctionnement. Avec les moyens dont on dispose au 21e siècle, s’il y avait la moindre amorce d’impact sur la santé, on l’aurait vu depuis longtemps.

Le 20/09/2020 à 16h18

Pas d’effet cancérigène causé par des ondes non ionisantes, sans doute, mais on sait aussi que les micro-ondes provoquent un échauffement interne du corps, qui peut ne pas être totalement négligeable en ce qui concerne les ondes émises par le téléphone collé à l’oreille. Quand aux effets des ondes sur les cellules nerveuses, notamment les neurones, je crois qu’on ne sait pas grand chose : migraines ? malaises ? troubles cognitifs ?

Notre exposition massive aux ondes est relativement récente, et elle augmente chaque jour.

Le 20/09/2020 à 00h09

Tu as peut-être raison, mais peut-être pas.

Jusqu’ici, on n’a effectivement pas constaté de problème grave, mais le nombre d’ondes/relais et l’augmentation des fréquences sont en croissance permanente et rien ne dit que, passé un certain seuil, on ne va pas, justement, commencer à constater d’impact sur la santé.

Moi je n’en sais rien, je laisse ce sujet aux scientifiques qui l’étudient, mais ton raisonnement est baisé.

Le 21/09/2020 à 08h05

Je le répète : en-dessous des UV, les ondes électro-magnétiques ne sont pas ionisantes. Même être face à un feu de bois, intense en ondes infrarouges (fréquences bien plus élevées que les ondes des mobiles, énergie par photo bien supérieure), ne crée aucun souci.

Le 21/09/2020 à 10h47

Le spectre est utile mais ne suffit pas à démontrer l’absence de danger. Les molécules selon leur configuration réagissent différemment. C’est de la chimie élémentaire…

D’où que la cuisson au micro-onde est justifiée car elle ne chauffe efficacement que l’eau par polarisation.

D’où aussi qu’un feu chauffe mieux toutes les molécules mais de manière non polarisée. (moins de transmission de la puissance de la source)

Le 21/09/2020 à 07h32

Le 21/09/2020 à 08h54

”…attendronT pas…” !

Le 21/09/2020 à 07h50

Le problème est que si Impact il y a il doit être très faible car non encore observé avec 30-40 ans de recule. Donc à moins de faire un blackout total et en utilisant des cobayes sur 10-20 ans on ne peut pas répondre immédiatement à la question. L’innocuité étant toujours sujet à question car dépendant du seuil que l’on veut bien se poser quesqu’on fait? et bien on extrapole avez les données que l’on possède déjà et on observe ce qu’il se passe. La question n’est donc pas pour ou contre la 5G mais quels moyens indépendants on se donne pour analyser ça à moyen et long terme.

Le 21/09/2020 à 08h24

Les micro-ondes ont un effet thermique, mais justement les puissances en jeu sont négligeables, il suffit de penser à l’échauffement lié à une exposition au soleil ou à un feu de bois, et quand on fait du sport intense l’échauffement est pas mal non plus (le corps régule avec la transpiration, dans ce cas).

Il n’y a pas d’exposition massive, c’est une idée fausse. La seule exposition massive qui existe, c’est au soleil (ou dans certains cas particuliers, comme le personnel navigant en avion). Je rappelle que le travailleur français qui était le plus exposé au monde, c’est Thomas Pesquet, avec ses 6 mois à bord de l’ISS.

On n’a même pas besoin d’autant de temps pour constater un effet (cf des études sur d’autres sujets dans les années 50).

C’est aussi qu’on ne saurait pas expliquer l’effet des ondes de mobiles, entre l’intensité négligeable et la fréquence qui ne peut pas avoir d’effet sur la chimie des cellules (contrairement aux UV ou rayons X, et là aussi, c’est la dose qui fait le poison).

Les rayonnements délétères ont été identifiés il y a longtemps (le plus lointain c’est pour les rayons X, il y a environ un siècle), il n’y a pas franchement de mystère.

Le 21/09/2020 à 16h02

Le sujet génère à chaque fois des commentaires (dont de moi), j’ai l’impression de tenter de vider un océan à la petite cuillère.

Autant la culture générale (littéraire et historique) est plutôt valorisée dans ce pays, autant la culture scientifique est ignorée ou considérée comme ne faisant pas partie de la culture générale, alors que la physique faisait partie de la culture des philosophes grecs, par exemple.

On peut aussi le voir avec l’engouement pour le docteur marseillais mégalomane et à la limite du charlatanisme dans ses déclarations et de la déontologie dans son comportement global (bon là on touche pas mal au complotisme ambiant aussi) ; une ignorance du fonctionnement de la recherche scientifique qui me paraît problématique.

On a aussi tous les marchands de peur pseudo-écolos, souvent côté EELV, qui vont contre la science ; il existe de vrais écologistes rationnels mais on en voit peu.

Le 21/09/2020 à 16h31

Mais ils étaient les seuls à s’en préoccuper sérieusement de ce qu’on en sait… la recherche de la vérité n’est pas mieux répartie aujourd’hui. Le problème étant qu’on avait pas autant de technos courantes gérables avec cette culture…. Maintenant il faut des cabinets d’expertise, des méta-analyses pour remplacer le Protagoras.

Le 22/09/2020 à 08h02

Vu leur faible portée, le nombre d’antennes 5G à déployer à tous les coins de rues va être colossal. Cela ira de pair avec un remplacement ovin massif de nombreux terminaux mobiles pour profiter de cette 5G.

Bref, je n’imagine même pas le gaspillage de ressource que cela va engendrer … et tout cela pour quoi ? Les bénéfices d’une vie encore plus omni-connectée? Que mon frigo me dise “va acheter du lait”? Low-tech is good tech dit l’autre article de NI !

Je vous recommande également la lecture de l’excellente BD Shangri-La (https://www.bedetheque.com/BD-Shangri-La-284743.html) qui met en perspective cette chute en avant vers le toujours plus de tech.

Le 22/09/2020 à 12h00

Bien vu ! C’est malheureusement trop courant…

SI on avait fait plus de tests sur la santé humaine avant d’imposer le nucléaire… Nucléaire que l’on présente comme “la clé de notre indépendance”, alors que la matière première est extraite en Afrique, dans des conditions de travail plus que douteuses (variable suivant les sources), mais chuuuttt… Ne réveillons pas le dictateur qui dort sur son matelas en or massif…

Le 23/09/2020 à 06h19

C’est tellement plus sain le pétrole qui va dans le réservoir facepalm

En se basant sur des tests liés à la santé humaine, les énergies fossiles seraient bannies et on utiliserait majoritairement du nucléaire filière REP comme en France, merci d’arrêter de propager des foutaises !

Le 23/09/2020 à 07h26

Les centrales nucléaires sont justement soumises à tout un tas de normes en terme de rejets, ce qui est justement le résultat de tout ce qu’on a étudié sur l’impact d’une faible radioactivité. L’impact des centrales nucléaires sur la santé humaine est un des plus faibles qu’on puisse avoir, surtout au regard de l’énorme quantité d’électricité générée.

À l’inverse, on n’a pas fait de tests concernant les combustibles fossiles, et rien qu’à l’époque du chauffage au charbon ça posait pas mal de soucis (dont le fameux “smog” londonien), et actuellement on a l’excès de CO2 dégagé dans l’atmosphère avec tous les inconvénients présents et à venir.

On extrait de l’Uranium ailleurs qu’en Afrique, et les conditions dépendent peu des acheteurs. En effet l’utilisation du nucléaire a permis de sacrément alléger la facture des importations de pétrole et autres fossiles depuis la fin des années 70, qui créent des problèmes d’une autre ampleur dans le monde (pas que le Moyen-Orient) que quelques mines d’uranium en Afrique.

L’Uranium ne compte que pour 5 % du prix de l’électricité d’une centrale nucléaire.

Son commentaire illustre à point nommé ce que je déplorais concernant le manque de connaissances dans le domaine scientifique.

Le 23/09/2020 à 08h06

Et en terme de radioprotection, la première cible ce ne sont pas les centrales à uranium, ce sont celles au charbon !

https://www.journaldelenvironnement.net/article/electricite-le-charbon-plus-radioactif-que-le-nucleaire

Le 23/09/2020 à 12h16

FAUT ARRÊTER DE TAPER sur le nucléaire !

d’autant qu’on est en passe de résoudre le problème* des déchets radioactifs !

Le 23/09/2020 à 13h19

Justement mtaapc tape sur les centrales charbon, qui font pire que les centrales nucléaires sur la radioactivité

Et ITER, en passe, c’est vite dit, il est prévu d’avoir un premier réacteur fonctionnel vers 2040-2050…

Le 23/09/2020 à 15h20

je NE le visai pas lui !

(je me suis ma exprimé)

Le 23/09/2020 à 19h33

Les centrales de génération IV sont à fission, ce qui ne les empêche pas de très fortement réduire la quantité de déchets (elles tournent au Pu239 qu’on peut produire à base d’U238, grâce à sa fertilité, qui est l’isotope le plus courant de l’uranium), et surtout, on sait déjà les produire et les faire fonctionner (Superphénix, BN-x00 russes, CEFR et CFR chinois, des constructions en Inde), et ils bouclent le cycle du combustible.

Le 25/09/2020 à 04h40

Fonctionnel pour la 18G c’est vague je trouve.