SynthID, le système de Google pour marquer au fer rouge les contenus générés par des IA

Synthetic quality certified

Depuis un an, les entreprises d'IA générative promettent d'ajouter des filigranes à leurs contenus. Google propose désormais son système nommé SynthID. Les chercheurs de Google DeepMind ont notamment décrit dans un article dans la revue Nature et publié sous licence libre la partie concernant les textes générés automatiquement.

Le 30 octobre à 15h44

5 min

IA et algorithmes

IA

Dans les divers problèmes liés aux contenus générés par l'IA, le fait de pouvoir les différencier de ceux créés autrement a été rapidement repéré comme le nez au milieu d'un visage. Les détecteurs d'IA générative sont pointés du doigt pour leurs faux positifs, ce qui engendre des tensions entre étudiants et enseignants.

Depuis l'avènement dans l'espace public de ces systèmes, l'ajout à ces contenus de filigranes est régulièrement évoqué pour qu'une sorte de tampon « made by AI » leur soit clairement assigné. OpenAI, Alphabet, Meta, Anthropic, Inflection, Amazon et Microsoft ont d'ailleurs promis à la Maison-Blanche l'an dernier de mettre en place ce système. En Europe, l'AI Act exige que cette disposition soit mise en place à partir du 2 aout 2026.

En aout, on apprenait qu'OpenAI avait mis en place un système permettant de tatouer les textes générés par ses IA. Mais l'entreprise hésitait à le mettre en place. En effet, cette technologie serait « efficace à 99,9 % », mais elle serait aussi relativement simple à supprimer.

Google vient, elle, de sauter le pas avec son système nommé « SynthID » développé par sa filiale DeepMind. L'entreprise indique que cet outil embarque « des filigranes numériques directement dans les images, le son, le texte ou la vidéo générés par l'IA ».

Bien sûr, le système de tatouage des divers contenus est différent selon le média. Il n'est pas possible, par exemple, d'utiliser un système de tatouage graphique pour identifier un texte. Et, à moins de trouver un très bon filigrane universel, le risque est d'harmoniser vers le bas l'utilisation de ces marques pour tous les types de médias.

Google a donc mis au point différents systèmes de filigranes dont elle présente des exemples.

Un outil libre de filigranes pour la génération de textes

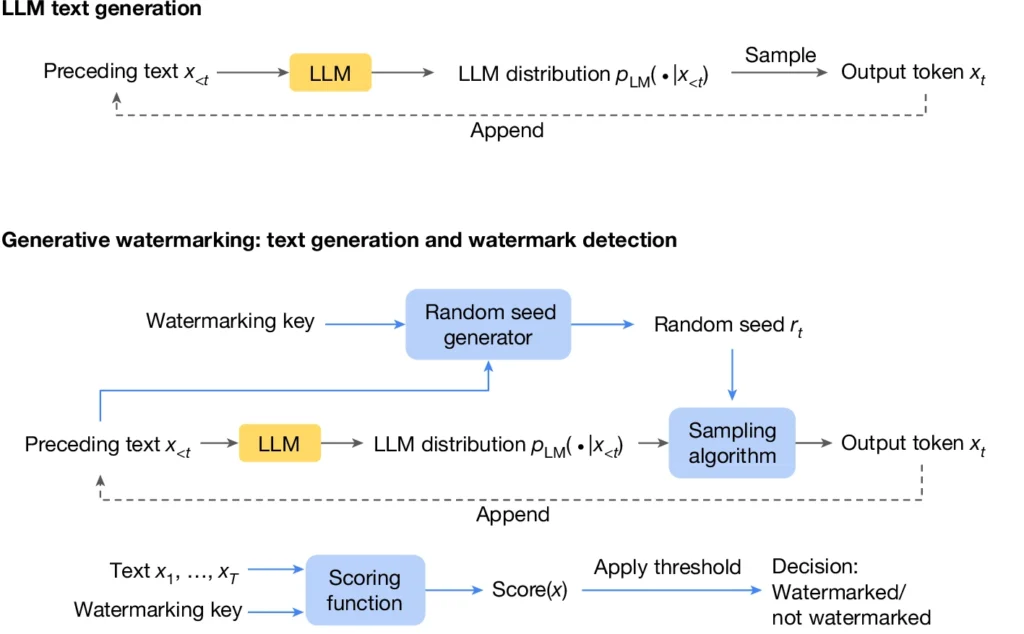

Pour son système dédié aux filigranes de textes générés par IA, Google DeepMind a publié le travail de ses 24 chercheurs dans la revue scientifique Nature la semaine dernière. L'idée est de créer une « signature statistique » dans le texte généré en modifiant légèrement la procédure de génération de chaque « prochain jeton ». Cette modification ne dépend pas d'une simple variable statique, mais se fait en fonction du contexte de génération.

« L'un des principaux avantages de cette approche est que le processus de détection ne nécessite pas la réalisation d'opérations coûteuses en termes de calcul, ni même l'accès au LLM sous-jacent (qui est souvent propriétaire) », expliquent-ils.

La détection se fait avec un outil probabiliste qui prend en entrée le texte à vérifier et une clé de filigrane spécifique.

L'entreprise a publié sur GitHub sous licence libre (Apache 2.0) cet outil et propose une documentation détaillée pour les développeurs d'IA génératives qui voudraient l'utiliser. Dans celle-ci , elle explique que SynthID Text propose plusieurs options pour la vérification : full-private qui « ne libère ni n'expose le détecteur d'aucune manière », semi-private qui « ne libère pas le détecteur, mais expose via une API » et public qui « permet de libérer le détecteur pour que d'autres utilisateurs puissent le télécharger et l'utiliser ».

Elle assure que « les filigranes de texte SynthID résistent à certaines transformations, c'est-à-dire les recadrages de texte, en modifiant quelques mots ou en paraphrasant légèrement ». Mais Google admet que sa méthode, comme celle d'OpenAI, a des limites qui permettent de facilement contourner son système :

- « L'application de filigranes est moins efficace sur les réponses factuelles, car il y a moins de possibilités d'augmenter la génération sans réduire la précision.

- Les scores de confiance du détecteur peuvent être considérablement réduits lorsqu'un texte généré par IA est entièrement réécrit ou traduit dans une autre langue ».

Google se garde l'exclusivité de ses outils de filigrane d'audio et d'images

Toutefois, concernant les filigranes d'audio, d'images et de vidéos, l'entreprise se contente de présenter succinctement des exemples d'utilisation qui, bien évidemment, ne montrent aucune différence entre le contenu sans filigrane et avec. Mais l'entreprise ne communique ni sur le fonctionnement des systèmes mis en place ni sur leurs limites.

Elle ajoute que ces filigranes sont disponibles pour les clients de Vertex AI qui utilisent les modèles de conversion de texte en image Imagen (version 2 et 3), pour les utilisateurs de son outil de génération d'images ImageFX et pour les quelques créateurs qui ont accès à son modèle de génération de vidéos Veo.

SynthID, le système de Google pour marquer au fer rouge les contenus générés par des IA

-

Un outil libre de filigranes pour la génération de textes

-

Google se garde l'exclusivité de ses outils de filigrane d'audio et d'images

Commentaires (10)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousLe 30/10/2024 à 16h15

When that fat old sun in the sky is falling

Summer evening birds are calling

Children's laughter in my ears

The last sunlight disappears

Le 30/10/2024 à 16h28

Le 30/10/2024 à 17h09

Autant pour le texte, comme je l'avais évoqué il y a peu en le qualifiant de chasse aux sorcières 3.0, le procédé me fait peur car il risque de générer du faux positif et de l'insécurité pour les auteurs. Surtout avec les outils de correction / reformulation qui utilisent eux aussi du LLM.

Exemple, j'ai utilisé l'assistant reformulation d'Antidote pour ma dernière phrase.

Elle a été remaniée par un système basé sur du ML qui fait partie du panel d'outils d'une solution de correction de texte avancée très en vogue dans le domaine de l'écriture. Mais, sauf erreur de ma part, je suis pourtant bien la personne à l'origine du propos. Si le détecteur dit "généré par IA", que se passe-t-il ? Remise en doute que tout mon message proviendrait d'un générateur de texte ?

Et si un texte entièrement tapé par mes petits doigts sur mon clavier pendant des mois (oui, c'est long d'écrire un roman, surtout quand on en est à la troisième réécriture) est détecté comme généré par IA ? Si demain Amazon KDP refuse ma publication sous prétexte que j'ai du "texte généré par IA" sur un roman alors que c'est faux, que se passe-t-il ?

(aujourd'hui, on peut cocher une case disant qu'on inclus du contenu généré par IA sur KDP. Texte, image et trad. Au début, il ne faisait pas le distingo, c'était débile. Ça n'engage à rien dans les CGU à ce jour, mais la géométrie variable de ces documents n'est plus à démontrer)

Vais-je devoir prouver mon innocence parce que Saint Outil a forcément raison ? (quel beau concept)

On retomberait dans le travers actuel des gens qui boivent les paroles d'un LLM ! Un comble.

Les faux positifs font partie des indicateurs qu'on travaille dans la sécurité IT pour éviter qu'une solution ne devienne contre productive à gueuler pour rien. L'exemple le plus typique, c'est la détection de secrets en dur dans du code ou des manifestes de déploiement (du style une valeur par défaut car clé obligatoire) qui en génère toujours et pour laquelle il faut définir des critères d'exclusion ou d'analyse.

Le 30/10/2024 à 17h33

Le gros problème du texte, c'est que c'est "trop simple" pour faire du watermarking efficace, car on trouvera toujours un moyen de "l'enlever".

La solution de jouer sur les tournures de phrases est intéressante, mais contre-productive si, par exemple, tu demandes à l'IA de respecter ton style littéraire...

Selon moi, le jeu du chat et de la souris au niveau des textes générés par IA est forcément gagné par l'IA. Ne serait-ce que parce que chaque humain n'aura jamais le temps de s'assurer que tel ou tel texte a été écrit par un humain. Et quand bien-même, comme tu le dis si bien, même si le texte ezt généré par une IA, rien ne dit que le contenu du texte a été fourni par un humain ou s'il a été lui aussi généré.

C'est triste à dire, mais je pense que les humains n'étaient pas et ne sont pas prêts pour l'arrivée des IA génératives grand public. Et maintenant, il va falloir payer l'ouverture de la boîte de Pandore.

Le 30/10/2024 à 18h47

Le 30/10/2024 à 19h17

Le 04/11/2024 à 16h09

Le 31/10/2024 à 08h22

Le 31/10/2024 à 10h38

Slip de brain.

Slip de drain.

Spip de daim.

Raaaahhhh, c'est trop fort cette technique !

Tant pis pour la fin du monde, pour patienter je vais aller faire quelques longueurs en slip de bain moi.

Le 04/11/2024 à 19h04