Informatique quantique : Microsoft passe de 4 à 12 qubits logiques en cinq mois

Physique ou logique, c'est pas pareil

Microsoft améliore son calculateur quantique en triplant le nombre de qubits logiques – c’est-à-dire ceux réellement utilisables pour des calculs – pour arriver à 12. Le nombre de qubits physiques (les petites mains du calcul quantique) ne sont que doublés. Malgré tout, le taux d’erreur est en baisse et la durée de calcul augmentée.

Le 17 septembre 2024 à 10h33

4 min

Hardware

Hardware

Qubits logiques vs physiques

En avril, Microsoft et Quantinuum annonçaient des « qubits logiques les plus fiables jamais enregistrés ». Les deux partenaires utilisaient une technique bien connue dans le monde du quantique : associer des qubits physiques entre eux pour former des qubits logiques avec un taux d’erreur bien plus faible.

- [FAQ] Notre antisèche sur l’informatique quantique

- Informatique quantique, qubits : avez-vous les bases ?

Un qubit n’est en effet pas l’élément le plus stable (loin de là même) et peut facilement provoquer des erreurs. Multiplier les qubits physiques pour ne former qu’un seul qubit logique permet de réduire le risque. Microsoft parlait d’ailleurs d’« un taux d’erreur 800 fois meilleur à celui des qubits physiques » dans son annonce d’avril.

Imaginons, pour simplifier, qu’un qubit logique soit associé à dix qubits physiques. Si un ou deux donnent une erreur lors du calcul, il en reste encore huit ou neuf qui tiennent le choc, le qubit logique n’a donc qu’à se ranger à l’avis du plus grand nombre pour continuer son aventure. Éric Brier (vice-président et CTO Cyber Defence Solutions chez Thales), rappelait l’année dernière que, « parfois, on est obligé d'utiliser 100 qubits physiques pour arriver à un seul qubit logique ». N’allez donc pas croire que cela se joue à la marge.

Les qubits logiques sont les qubits « utiles » pour les calculs. Il faut d’ailleurs bien faire attention à cette distinction quand un fabricant annonce une machine avec xx qubits : sont-ils logiques ou physiques ? Multiplier le nombre de qubits physiques pour un seul qubit logique permet ainsi de limiter les erreurs, mais assembler et faire fonctionner de concert de nombreux qubits physiques est compliqué à mettre en œuvre. Il faut donc trouver un juste milieu.

En 2024, Microsoft est passé de 4 à 12 qubits logiques

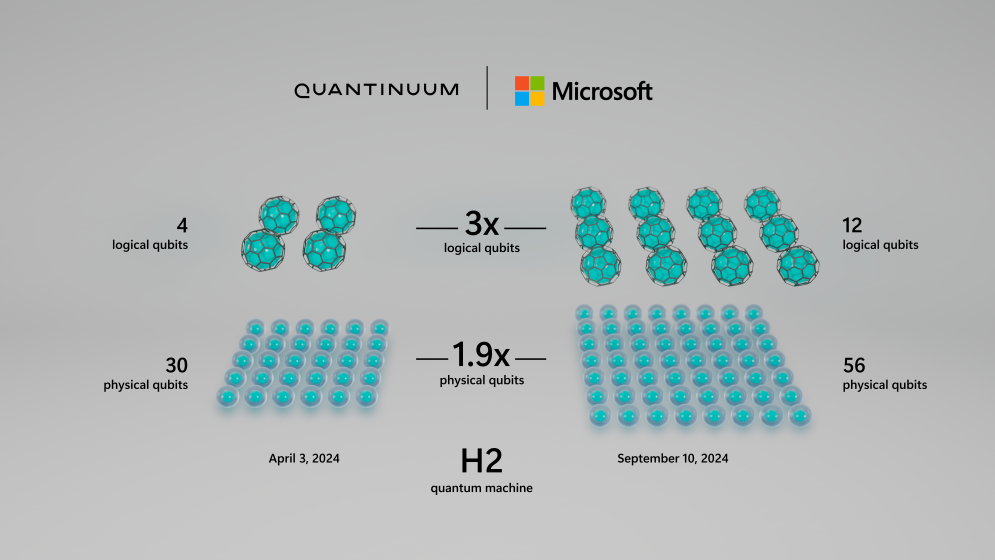

En avril dernier, Microsoft et Quantinuum annonçaient une machine avec 4 qubits logiques, utilisant un total de 30 qubits physiques. Aujourd’hui, le calculateur passe à 12 qubits logiques pour seulement 56 qubits physiques, soit 3 fois plus de qubits logiques avec seulement 1,9 fois plus de qubits physiques.

Une opération possible « en étendant les algorithmes de correction d’erreurs de Microsoft et en les optimisant pour la machine H2 de Quantinuum », explique la société de Redmond.

Les deux partenaires sont parvenus à utiliser les qubits pour un calcul quantique « plus profond » (on pourrait simplifier par le fait que les qubits passent plus de portes quantiques et donc effectuent davantage d’opérations). Microsoft annonce également une amélioration de 22 fois du taux d’erreur. Bref, des améliorations sur tous les plans.

Quid de la tenue dans le temps ?

Pour être complet, il manque néanmoins le nombre de portes quantiques que peut tenir la machine et/ou la durée d’utilisation des qubits pour des calculs. Ce sont également des paramètres importants pour cerner les capacités de la machine.

En informatique classique, les bits peuvent tenir dans le temps sans aucun problème, on peut donc réaliser de très longues opérations passant à travers énormément de portes logiques. En quantique, ce n’est pas aussi simple.

Microsoft n’est pas encore au bout du chemin, loin de là. La société est confrontée à une problématique de taille : « le bruit reste notre plus grand obstacle », d’autant plus quand le nombre de qubits physiques augmente. Elle rappelle « à quel point l’augmentation du nombre de qubits physiques ne suffit pas à elle seule à rendre possible une correction d’erreur quantique robuste […] Cela sera possible grâce aux progrès matériels et logiciels qui, ensemble, permettront d’exécuter des applications quantiques plus longues et plus fiables ».

Du pratique et commercialement pertinent

En guise de conclusion, Microsoft se montre pragmatique : « Un véritable changement de paradigme sur le calcul nécessite de se concentrer sur des applications pratiques et commercialement pertinentes ». Une manière de dire qu’empiler des qubits pour avoir « la plus grosse » sans pouvoir l’exploiter derrière ne sert pas à grand-chose. L’informatique quantique est une réalité, elle fonctionne. Microsoft veut maintenant appliquer la théorie dans le monde réel.

Informatique quantique : Microsoft passe de 4 à 12 qubits logiques en cinq mois

-

Qubits logiques vs physiques

-

En 2024, Microsoft est passé de 4 à 12 qubits logiques

-

Quid de la tenue dans le temps ?

-

Du pratique et commercialement pertinent

Commentaires (8)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousLe 17/09/2024 à 11h45

Modifié le 17/09/2024 à 11h52

Modifié le 17/09/2024 à 23h37

Le 17/09/2024 à 23h37

Le 18/09/2024 à 08h27

Le 17/09/2024 à 14h48

Modifié le 18/09/2024 à 14h01

-------------------------------------

Le principal problème des ordinateurs quantiques, c'est qu'en augmentant le nombre de qubit on augmente de façon exponentielle les problèmes de décohérence.

En ajoutant un qubit, on augmente donc certes la puissance de calcul de façon exponentielle, mais la "stabilité" du système s'en trouve dégradée de façon exponentielle.

Alexandre et Michel Gondran exposent cela dans leurs travaux, et proposent d'ailleurs une interprétation très intéressante pour la physique quantique (une extension de la théorie de De Broglie-Bohm). Un petit aperçu de leur théorie de la double échelle est dispo en ligne pour ceux qui aiment les maths.

Et je rajoute cet article qui traite du problème de décohérence et des limites de l'approche actuelle.

Le 17/09/2024 à 17h08