[Màj] OpenAI : l’équipe chargée de contrôler les IA n’avait pas accès aux capacités de calculs promises

Who will watch the superintelligence?

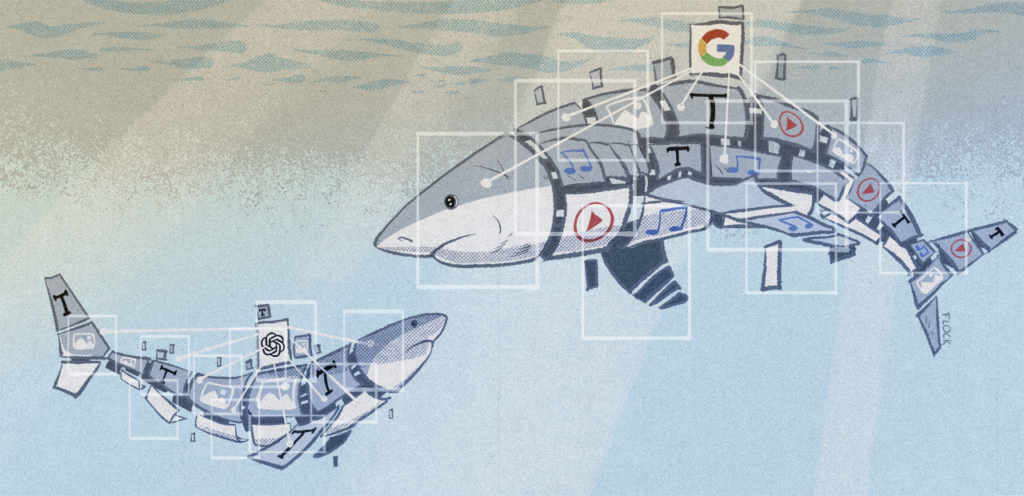

![[Màj] OpenAI : l’équipe chargée de contrôler les IA n’avait pas accès aux capacités de calculs promises [Màj] OpenAI : l’équipe chargée de contrôler les IA n’avait pas accès aux capacités de calculs promises](https://next.ink/wp-content/uploads/2023/11/Mathildegemini7.png)

OpenAI a subi mercredi 15 mai les départs de deux de ses chercheurs qui dirigeaient son équipe nommée « Superalignment » : Ilya Sutskever et Jan Leike. Ceux-ci travaillaient au sein d'OpenAI sur des travaux de recherche en vue de maitriser l'avènement d'une potentielle IA générale que toute l'équipe dirigeante de l'entreprise affiche comme imminente.

Le 22 mai 2024 à 08h50

7 min

IA et algorithmes

IA

Mise à jour du 22 mai à 8h50 : ajout de la partie « Un accès aux capacités de calculs moins important que promis » suite à la publication de l'article de Fortune.

Article initialement publié le 16 mai à 11h10 :

Sam Altman a publié un billet de blog pour annoncer la nouvelle : « Ilya et OpenAI vont se séparer. C’est très triste pour moi ; Ilya est sans aucun doute l’un des plus grands esprits de notre génération, un phare dans ce domaine et un ami cher. Son génie et sa vision sont bien connus. Sa chaleur et sa compassion sont moins connues, mais non moins importantes ».

Ilya Sutskever est co-fondateur d'OpenAI et était depuis le début son responsable scientifique.

Jan Leike, un autre membre de l'équipe de recherche d'OpenAI, a annoncé en parallèle son départ d'un bref « j'ai démissionné » sur Twitter. Tous les deux étaient à la tête de l'équipe « Superalignment » d'OpenAI.

La persuasion d'un avènement proche de l'intelligence artificielle générale

Persuadés que l'intelligence artificielle générale (AGI) est proche, ils ont monté cette équipe au sein de l'entreprise il y a un peu moins d'un an dans le but de trouver des solutions « pour piloter et contrôler des systèmes d'IA beaucoup plus intelligents que nous ».

Sans aucune pincette ni fondement scientifique, cette équipe affirmait que « la superintelligence sera la technologie la plus importante que l'humanité ait jamais inventée et pourrait nous aider à résoudre bon nombre des problèmes les plus importants du monde ».

« Mais l'immense pouvoir de la superintelligence pourrait aussi être très dangereux et conduire à la déresponsabilisation de l'humanité, voire à son extinction », expliquaient-ils, ce qui justifiait la création d'une telle équipe au sein de l'entreprise leader de l'IA générative.

Dans son tweet annonçant son départ, Ilya Sutskever ré-affirme être « convaincu qu'OpenAI construira une AGI à la fois sûre et bénéfique ».

Pourtant, Ilya Sutskever fait partie des membres du Conseil d'administration qui avaient voté pour le départ de Sam Altman au début de la semaine de folie de novembre dernier pendant laquelle le CEO d'OpenAI a été limogé puis réintégré, après un passage éclair chez Microsoft.

Il avait ensuite regretté sa participation « aux actions du conseil d'administration ». Comme l'expliquait à l'époque The Atlantic, les tensions au sein d'OpenAI étaient dues, en partie, à cause d'une divergence profonde : « alors qu'Altman et Greg Brockman [qui a suivi Sam Saltman dans ses allers-retours, ndlr], président d'OpenAI, encourageaient une commercialisation accrue, le responsable scientifique de l'entreprise, Ilya Sutskever, s'inquiétait de plus en plus de savoir si OpenAI respectait la mission de l'association à but non lucratif qui consistait à créer des IAG bénéfiques ».

À la réintégration de Sam Altman, Ilya Sutskever a quitté le conseil d’administration tout en restant à son poste de responsable scientifique.

Dans son billet, Sam Altman annonce qu’Ilya Sutskever sera remplacé par Jakub Pachocki, qui était jusque-là responsable de l’équipe de recherche de l’entreprise sur l’optimisation du deep learning et de l’apprentissage par renforcement à grande échelle.

De son côté, Jan Leike devrait être remplacé par John Schulman qui était responsable de l’équipe qui travaille sur l’apprentissage par renforcement.

Depuis le début de l’année, Daniel Kokotajlo, William Saunders, Leopold Aschenbrenner et Pavel Izmailov, d’autres membres (ou ex-membres) de l’équipe « Superalignment » ont, eux aussi, quitté le navire. Dans le cas des deux derniers, il s’agit d’un licenciement suite à des fuites d’informations.

Si John Schulman doit prendre la tête de cette équipe de plus en plus vide, il n’est pas sûr que Jakub Pachocki reprenne aussi cette responsabilité.

Peu de résultats de recherche

À la création de l’équipe « Superalignment » en juillet 2023, celle-ci se donnait quatre ans pour résoudre le « problème » du manque de moyens « pour piloter et contrôler des systèmes d'IA beaucoup plus intelligents que nous ».

L’équipe a, en un an et depuis sa création, mis en ligne un seul article dans laquelle elle se pose la question « Peut-on utiliser un modèle plus petit (moins performant) pour superviser un modèle plus grand (plus performant) ? ». Elle y expliquait que « lorsque nous supervisons GPT-4 avec un modèle de niveau GPT-2 en utilisant cette méthode pour des tâches de Traitement automatique du langage naturel, le modèle résultant a généralement des performances comprises entre GPT-3 et GPT-3.5 ». Les chercheurs de l’équipe concluaient néanmoins qu’ « il existe encore d'importantes disparités entre notre configuration empirique actuelle et le problème ultime de l'alignement des modèles surhumains ».

Il reste trois ans à leurs remplaçants pour atteindre le but que s’était fixé l’équipe, si la volonté est encore là de pousser la recherche de l’entreprise dans ce sens.

Car ces départs montrent que ceux qui affichaient les positions les plus effrayées face à l’arrivée prochaine d’une intelligence artificielle générale n’ont plus un poids significatif au sein d’OpenAI.

Un accès aux capacités de calculs moins important que promis

Dans son article de présentation de l’équipe « Superalignment », OpenAI promettait de dédier 20 % de ses capacités de calcul pour « résoudre ce problème ». Mais, selon une demi-douzaine de sources de Fortune, l’entreprise n’a jamais donné ces moyens à l’équipe.

Celle-ci aurait au contraire dû batailler pour avoir accès aux GPU d’OpenAI et ne se serait jamais approchée des 20 %, la direction de l’entreprise refusant plusieurs fois ses demandes.

Selon une source du média américain, le calcul des 20 % n’aurait jamais été clair. Celle-ci explique même à Fortune qu’elle ne savait pas si cela correspondait à « 20 % par an pendant quatre ans » ou « 5 % par an sur quatre ans ». Remarquons que cette deuxième option est une étrange manière de calculer un pourcentage. Cette personne évoque même la possibilité que ce pourcentage aurait pu signifier une répartition en « 1 % ou 2 % pour les trois premières années et le reste de l’engagement pour la dernière année ». La direction aurait aussi rejeté régulièrement les demandes occasionnelles d’augmentation de capacités de calculs.

Selon l’article de Fortune, ces refus réguliers d’accès aux GPU auraient bridé l’équipe et expliqueraient son peu de résultats.

Les difficultés de l’équipe pour accéder aux machines se seraient accentuées suite à la semaine de folie où Sam Altman avait été licencié puis réintégré. Certaines sources de Fortune assurent que, suite à cet épisode, Ilya Sutskever n’avait plus accès aux travaux de l’équipe et ne jouait plus aucun rôle de direction.

[Màj] OpenAI : l’équipe chargée de contrôler les IA n’avait pas accès aux capacités de calculs promises

-

La persuasion d'un avènement proche de l'intelligence artificielle générale

-

Peu de résultats de recherche

-

Un accès aux capacités de calculs moins important que promis

Commentaires (9)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousModifié le 16/05/2024 à 14h41

Modifié le 22/05/2024 à 12h36

Modifié le 16/05/2024 à 17h45

la crise climatique?C'était aussi succulent de voir tout le monde au secours de la victime Sam Altman grand défenseur de "peu importe" fonçons pour faire du fric.

Monde de merde !

Modifié le 16/05/2024 à 22h23

Le pompier pyromane ?

Pour ma part je pense de plus en plus par mes lectures, dont les articles de Mathilde sur le long-termisme etc, que tout cela consiste à simplement agiter un épouvantail (l'IAG) pour mieux détourner l'attention de ce qui se passe réellement : la création d'un nouveau capitalisme, encore plus prédateur, qui s'infiltrera encore plus dans la sphère privée et donc... politique.

D'ailleurs les récents propos de Altman (encore) sur le revenu de base universel mettent quelque peu la puce à l'oreille sur ses ambitions réelles. Il semble bien illustrer ce que j'avance.

Je n'ai rien en soit contre les IA. Au contraire elles peuvent être de merveilleux outils si bien utilisées.

Mais je me méfie de ceux qui hurlent sans cesse au loup alors qu'ils laissent la bergerie grande ouverte.

Le 22/05/2024 à 09h55

Très interessant.

Le 22/05/2024 à 10h06

Le 17/05/2024 à 09h38

Le 22/05/2024 à 13h48

Tiens, ça me donne envie d'écrire un livre : "Bullshit gpt et la notion d'intelligence, quand algorithme et pipotronic se rencontre"

https://www.pipotronic.com/ (pour ceux qui ne connaissent pas, chatgpt n'a rien inventé, enfin si, la complexité de l'algo)

Le 23/05/2024 à 14h32

Vous comprendrez mieux mon scepticisme concernant cette soi disante notion d'intelligence)...