Google lance son opération de communications Gemini pour rivaliser avec OpenAI

Preprint not PR-print

Un peu plus d'un an après la sortie de ChatGPT, Google réagit en annonçant cette semaine la sortie de Gemini. Mais, derrière la présentation marketing, difficile de savoir si le projet est un simple équivalent maison de GPT-4 ou une avancée scientifique.

Le 08 décembre 2023 à 17h31

8 min

IA et algorithmes

IA

En septembre, Google avait déjà donné les clés d'une version anticipée de son système Gemini à quelques entreprises, comme pour rassurer les marchés sur le fait qu'elle était vraiment capable de proposer un réel rival à ChatGPT et aux différents modèles de langage proposé par OpenAI.

Cette semaine, Google annonce donc l'arrivée officielle de sa famille de grands modèle de langage dans son escarcelle pour booster ses différents outils avec de l'IA générative.

Mais il est difficile de savoir si Gemini est une avancée technologique permettant à Google de rattraper son retard ou une percée scientifique dans la recherche sur les grands modèles de langage lui permettant de dépasser ses concurrents. Notamment parce que l'entreprise entretient le flou.

Gemini, une famille de modèles multimodaux

« Gemini représente une avancée significative dans la manière dont l'IA peut contribuer à améliorer notre vie quotidienne », clame Deep Mind, le laboratoire de recherche de Google, dans sa présentation de sa nouvelle famille de modèles.

Sur X, anciennement Twitter, Jeff Dean, responsable de cette division, a aussi publié un thread pour présenter ce qu'est Gemini : « une famille de modèles multimodaux qui démontrent de très fortes capacités dans les domaines de l'image, de l'audio, de la vidéo et du texte ».

Ici, on rencontre encore un nouveau concept en intelligence artificielle qu'on pourra ajouter à notre « lexique de l'IA » : les modèles multimodaux. Au lieu d'un modèle de langage entraîné pour traiter des textes, un autre pour des images, etc., on en entraine un seul avec des données de tous types (textes, audios, images, vidéos). La création de ce modèle est plus complexe puisque les objectifs d'entrainement diffèrent selon la modalité des données.

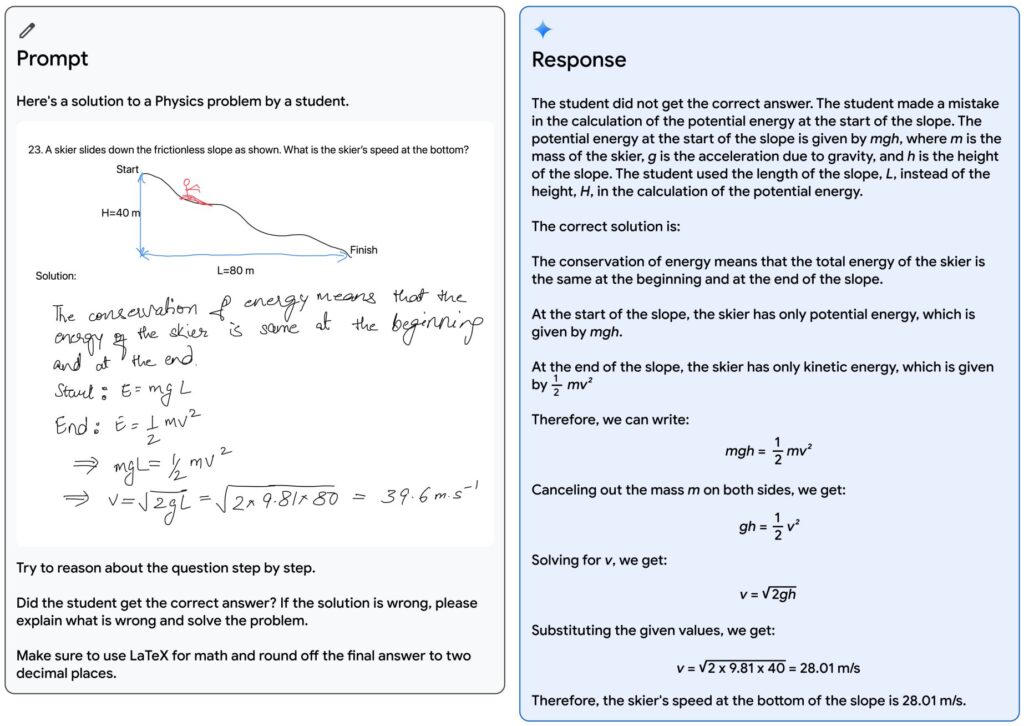

Pour en revenir à Gemini, Jeff Dean soutient que « les capacités multimodales et de raisonnement de Gemini sont assez fortes ». Il évoque un benchmark plutôt flatteur pour Gemini et décrit des exemples de ce que la machine serait capable de faire, comme celui d'un enseignant ayant dessiné un problème de physique représentant un skieur qui descend une pente, et un élève ayant trouvé une solution pour calculer la vitesse du skieur au bas de la pente comme dans l'image ci-dessous :

« Grâce aux capacités de raisonnement multimodal de Gemini, le modèle est capable de lire l'écriture manuscrite désordonnée, de comprendre correctement la formulation du problème, de convertir à la fois le problème et la solution en composition mathématique, d'identifier l'étape spécifique du raisonnement où l'élève s'est trompé dans la résolution du problème, puis donner une solution correcte et élaborée au problème. Rien qu'en éducation, les possibilités sont passionnantes, et ces capacités multimodales et de raisonnement des modèles Gemini pourraient avoir des applications spectaculaires dans de nombreux domaines. », explique Jeff Dean.

Concernant l'intégration de Gemini dans les produits de Google, Jeff Dean a annoncé que le modèle Gemini Pro équipe désormais Bard (le ChatGPT de Google). Ce même modèle sera accessible via une API à partir du 13 décembre sur Google AI Studio ou sur Google Cloud Vertex AI. Le modèle Nano est utilisable pour les développeurs Android sur le Pixel 8 Pro. Enfin, le plus gros des modèles de la famille Gémini, Ultra, ne sera disponible qu'en début d'année prochaine, « après avoir effectué des contrôles de confiance et de sécurité supplémentaires sur le modèle et l'avoir affiné davantage avec des réglages RLHF [Reinforcement learning from human feedback ou Apprentissage par renforcement à partir d'un retour d'information humain] supplémentaires ».

Un projet sans réelle publication scientifique

Mais pour expliquer comment fonctionne Gemini, les deux voies de communication de Google renvoient vers un « rapport technique de 60 pages signé par l'équipe de Gemini ». Et le terme est important : le document n'est pas un article scientifique. Il n'est pas mis en ligne sur une plateforme de prépublication scientifique comme arXiv et encore moins publié dans une revue ou présenté à une conférence. Il est seulement disponible sur le site de l'entreprise.

Et ce n'est pas la seule différence avec un article de recherche. Des chercheurs critiquent le manque d'informations et le flou entretenu par Google. Pour Jesse Dodge, du Allen Institute for AI, « ils répètent à plusieurs reprises que les données d'entraînement sont essentielles (« Nous constatons que la qualité des données est essentielle à un modèle hautement performant »), tout en ne fournissant presque aucune information sur la façon dont elles ont été créées, comment il a été filtré, ou son contenu ». Il ajoute que « cela suit la tendance des livres blancs écrits pour être lus comme des articles scientifiques, mais qui ne contiennent pas réellement les informations nécessaires à recherche ».

La chercheuse Stella Biderman, qui travaille pour Booz Allen Hamilton, résume l'état d'esprit de ces critiques :

"We want more preprints, not PR-Prints" could be a decent chant

— Stella Biderman (@BlancheMinerva) December 6, 2023

Ce qui peut être traduit, en perdant l'esprit de jeu de mots, par « nous voulons plus de prépublications, moins de communiqués de presse ».

Et, effectivement, Google a davantage utilisé des ficelles de communication pour la présentation de Gemini que de réelles informations scientifiques et techniques. Cette communication correspond très bien aux consignes passées en mai dernier par Jeff Dean lui-même. En effet, celui-ci avait demandé à ses chercheurs de ne plus publier d'articles scientifiques avant que les produits Google utilisant leurs travaux ne soient lancés.

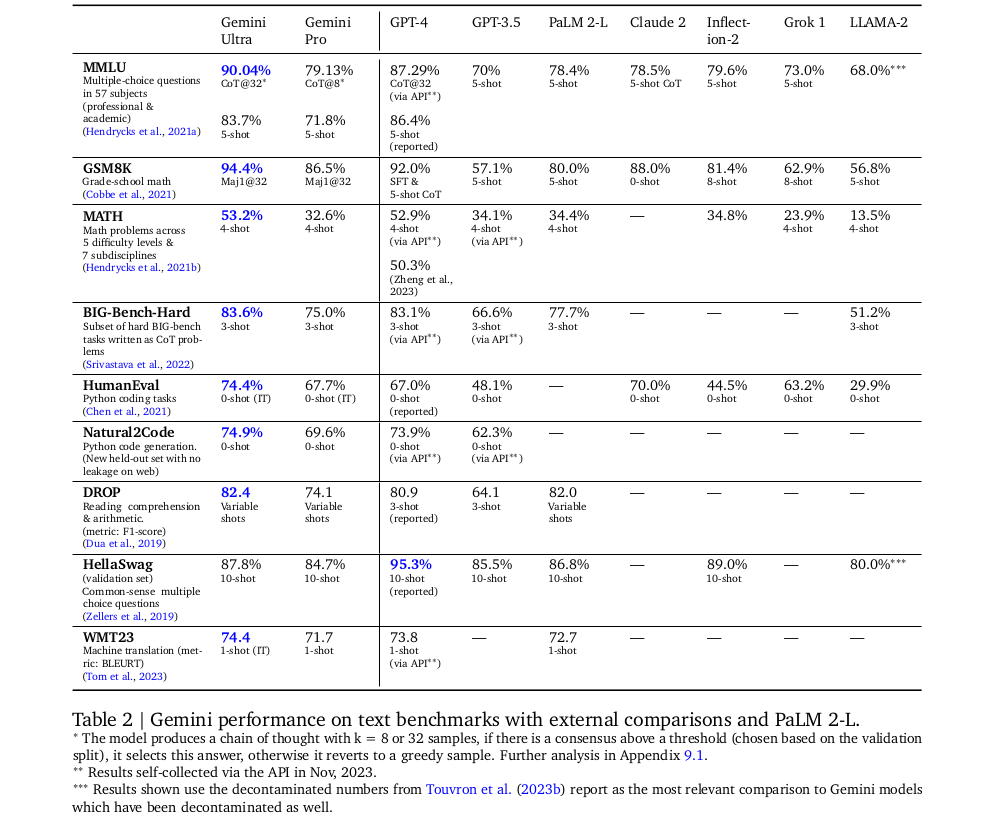

Concernant le benchmark dont parle Jeff Dean (dont le tableau est reproduit ci-dessous), Bloomberg relativise les résultats du plus gros modèle de Gemini : Gemini Ultra.

Celui-ci montre que Gemini Ultra bat GPT-4 sur une bonne partie des critères standard d'évaluation des modèles d'IA. Mais Bloomberg commente : « sur la plupart des critères, Gemini Ultra n'a battu le modèle GPT-4 d'OpenAI que de quelques points de pourcentage. En d'autres termes, le modèle d'IA le plus performant de Google n'a apporté que de faibles améliorations à un sujet sur lequel OpenAI a achevé ses travaux il y a au moins un an ».

Et le média américain de faire remarquer qu'Ultra n'est pas encore disponible et que, pendant cette année d'attente, OpenAI a pu améliorer GPT pour sortir une future version 5.

Une vidéo de communication éditée

Google a aussi publié une multitude de vidéos pour présenter les capacités de Gemini. Mais, comme l'explique encore Bloomberg, au moins l'une d'entre elles ne représente pas réellement le fonctionnement de l'IA de Google.

Google admet dans la description YouTube que la vidéo a été éditée, explique Bloomberg : « pour les besoins de cette démonstration, la latence a été réduite et les sorties Gemini ont été raccourcies pour plus de concision ». Le temps de réponse était donc plus long. Le média américain explique qu'elle n'a pas été réalisée en temps réel ni en mode vocal.

Questionnée par le média, l'entreprise a expliqué que la vidéo a été réalisée « en utilisant des images fixes tirées de la séquence et des messages textes ».

Bloomberg explique qu' « en d'autres termes, la voix de la démo lisait à Gemini des invites créées par des humains et leur montrait des images fixes. C'est très différent de ce que Google semblait suggérer : une personne pourrait avoir une conversation vocale fluide avec Gemini pendant que celui-ci observerait le monde qui l'entoure et y répondrait en temps réel ».

Google lance son opération de communications Gemini pour rivaliser avec OpenAI

-

Gemini, une famille de modèles multimodaux

-

Un projet sans réelle publication scientifique

-

Une vidéo de communication éditée

Commentaires (6)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 08/12/2023 à 17h44

Modifié le 08/12/2023 à 17h53

Gemini Ultra sortira l'an prochain et ne sera que marginalement meilleur que GPT-4, mais à ce moment, GPT-5 sera probablement disponible.

Google a de six mois à un an de retard sur OpenIA. Mais ça reste des modèles vraiment impressionnants.

Leur vraie force est qu'ils l'ont entrainé sur leurs propres puces (TPUs) et non celles de NVIDIA.

Le 08/12/2023 à 18h30

Le 08/12/2023 à 18h43

Et c'est probablement l'une des plus efficaces façons d'invisibiliser ce protocole...

Peut-être que c'est aussi une preuve que ça les inquiètent un peu...

Mais on ne va pas demander la lune, il faut garder le cap...

(pas déçu tu es le 3ème commentaire, et ton pouet récent m'avait déjà informé)

Le 08/12/2023 à 22h33

Le 09/12/2023 à 09h28

N’empêche.