ASUS PG259QNR : qu’apporte un écran à 360 Hz avec analyseur de latence intégrée ?

Promis, c'est plus fluide !

Le 20 octobre 2020 à 13h30

12 min

next

Non content de proposer avec ses partenaires de premiers écrans G-Sync à dalle IPS pouvant atteindre 360 Hz, NVIDIA leur a fait ajouter un analyseur de latence. Si de tels produits ne sont pas attendus avant l'année prochaine, nous avons pu tester une préversion du ROG Swift PG259QNR d'ASUS.

Avec ses GeForce RTX de série 30, NVIDIA a annoncé plusieurs évolutions technologiques. L'une d'entre elles était Reflex, profitant également à ses GPU d'ancienne génération, à partir de la génération des GTX 900.

Face à l'engouement pour l'eSport, le constructeur ne veut pas se contenter de maximiser les performances brutes ou réduire la consommation de ses puces. Il s'intéresse également à un aspect qui préoccupe de plus en plus son public adepte de jeu compétitif et qui ne concerne pas que les cartes graphiques : la latence.

Ainsi, depuis plusieurs années déjà, des solutions sont mises en place pour la réduire au maximum. Mais on faisait en général face à deux problèmes : les actions entreprises passaient uniquement par les pilotes, tant chez AMD que NVIDIA, avec toutes les limitations que cela implique. De plus, ce « délai » est difficile à mesurer précisément.

Et c'est à ces deux aspects que l'initiative Reflex entend s'attaquer. Comment ? C'est ce que nous allons détailler, avec notre premier test d'un écran avec NVIDIA RLA (Reflex Latency Analyser) : le PG259QNR d'ASUS à 360 Hz (IPS).

La latence, c'est quoi, pourquoi s'en préoccuper ?

Pour faire simple, on explique le plus souvent que dans le domaine des jeux vidéo, la latence est le temps qui sépare une action telle que le clic sur un bouton de souris, de sa manifestation à l'écran, comme un flash de tir.

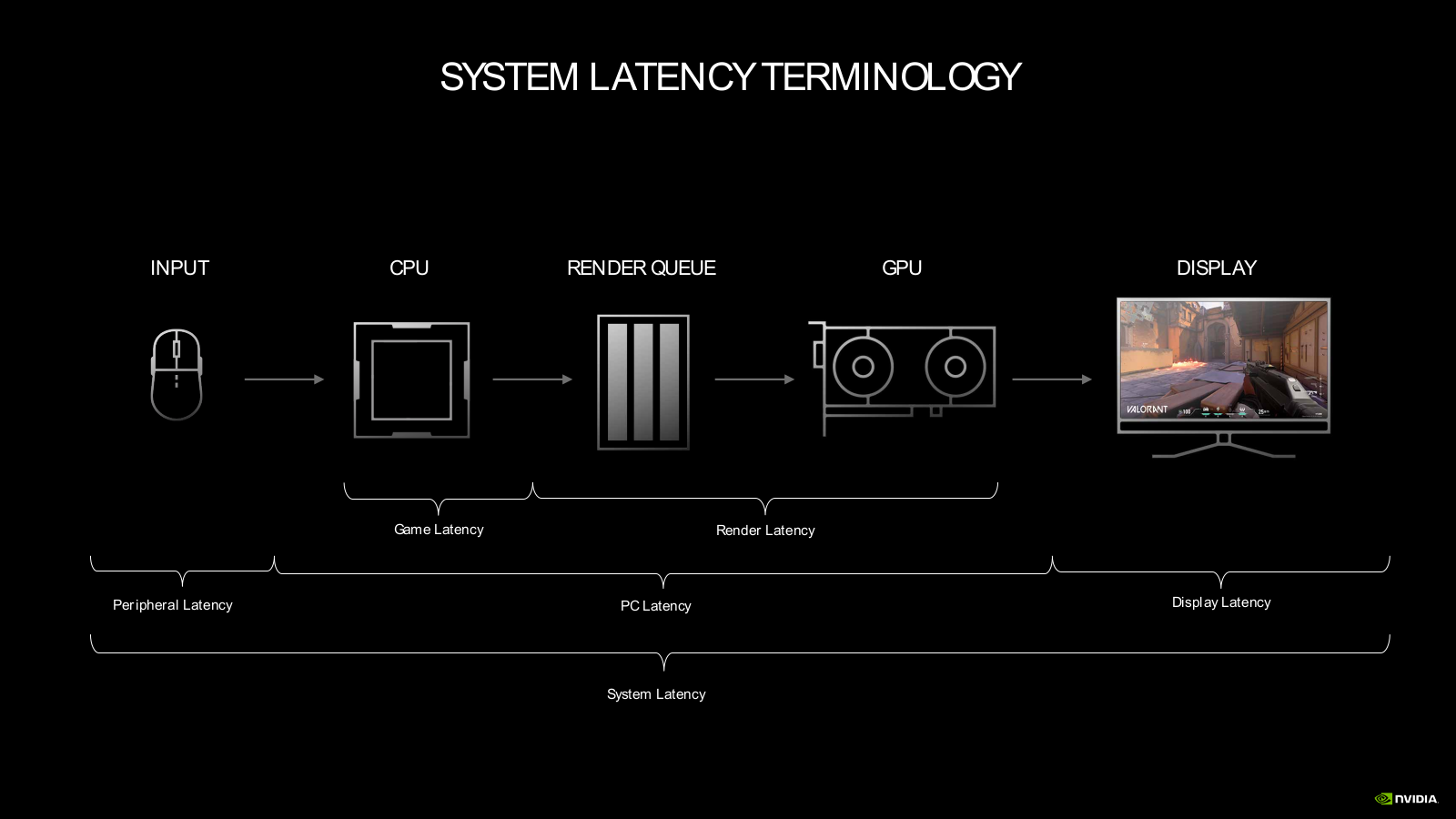

En réalité, c'est un peu plus complexe que cela. Car il n'y a pas une, mais des latences. En effet, chaque composant dispose de son propre temps de réaction qui s'additionne : souris, calculs effectués par le CPU, le GPU, organisation de la queue de rendu, écran. Pour le jeu en ligne, s'ajoute aussi la latence réseau qui est loin d'être négligeable.

Chaque constructeur vise donc à réduire cette latence au maximum à son niveau. Depuis quelques années, on voit ainsi des souris et écrans promettre monts et merveille. Pourquoi ? Parce que mis bout à bout, ces quelques millisecondes récupérées ici ou là peuvent devenir un avantage compétitif non négligeable.

Un joueur assez réactif pourra ainsi voir plus tôt un ennemi arriver dans son champ de vision, prendre plus tôt la décision de tirer. Les constructeurs jouent beaucoup de ces arguments pour justifier de leurs investissements en la matière. NVIDIA Research produit d'ailleurs des papiers plutôt intéressants sur le sujet.

Comme toujours, il faut néanmoins se méfier de la manière dont le marketing des marques s'empare de tout cela. Car la réduction de la latence ne vous transformera pas demain en joueur professionnel. Ce qui fait la force de ces derniers, c'est avant tout leur entrainement constant pour acquérir la stratégie et les réflexes nécessaires à prendre les bonnes décisions, être au bon endroit, au bon moment... et faire mouche.

Comme dans d'autres sports, disposer d'un bon équipement, et donc dans le cas présent d'un matériel à faible latence, d'une haute fréquence d'affichage, aide les champions à se réaliser. Un joueur moyen pourra y voir une béquille l'aidant à se démarquer. Mais si vous êtes mauvais... cela ne changera rien (nos tests le confirment).

NVIDIA Reflex : la réduction de la latence au-delà du pilote

La première composante de Reflex est un SDK mis à disposition des développeurs. Il leur permet d'intégrer à leurs moteurs ou à leurs jeux des mécaniques permettant de réduire la latence. Ainsi, l'utilisateur peut activer une option allant dans ce sens, qui s'exprime surtout dans les scénarios « GPU bound », où le CPU attend le GPU.

Il permet de réduire au maximum la queue de rendu, en s'arrangeant pour que le CPU envoie au plus tôt des images à calculer au GPU puis de s'occupe ensuite des actions de la souris. Si nécessaire, le processeur graphique voit sa fréquence de boost ajustée pour envoyer au plus tôt des images à l'écran dans des scenarios « CPU Bound ».

C'est pour cela que vous verrez en général deux niveaux d'options Reflex dans les paramètres des jeux compatibles, vous permettant de vous adapter à vos réglages. NVIDIA nous confirme que cette façon de faire est similaire à ce qui était intégré à ses pilotes, en bien plus efficace puisque contrôlé directement depuis le moteur du jeu.

Le constructeur a suffisamment préparé son coup pour que plusieurs titres soient d'ores et déjà compatibles. C'est notamment le cas d'Apex Legends, Fortnite, Call of Duty : Modern Warfare (2019) et Warzone mais aussi la beta de Cold War ou encore Valorant. D'autres devraient suivre dans les semaines et mois à venir.

RLA : des écrans et souris pour mesurer la latence

Réduire la latence est une chose, mais encore faut-il pouvoir mesurer les gains apportés. Jusqu'à maintenant, les solutions à mettre en place sur le sujet étaient assez coûteuses puisqu'il fallait une caméra à très haut débit d'images, des mécaniques pour faire le lien entre le clic de la souris et l'apparition à l'écran, etc.

Les constructeurs ont de tels moyens, ou les sociétés travaillant dans des domaines où la latence est critique comme le cloud gaming. Mais ce n'est pas forcément le cas des testeurs et encore moins des joueurs. NVIDIA a donc travaillé à une amélioration de ses écrans G-Sync qui pourrait apporter une solution.

Ainsi, certains écrans à 360 Hz qui seront mis sur le marché l'année prochaine intègreront une fonctionnalité nommée Reflex Latency Analyser (RLA). Utilisée avec une souris compatible (certaines sur le marché le sont déjà), envoyant un signal à chaque clic, ils peuvent afficher la latence globale, mais aussi permettre de la décortiquer et donc de savoir quelle est la part de la souris, du rendu et de l'écran dans le total. Mais là encore, rien n'est simple.

Que faire par exemple lorsqu'une souris n'envoie pas le signal ? NVIDIA a mis en place une base de données référençant la latence des 30 modèles les plus populaires pour les prendre en compte dans son calcul. Quelle zone doit être analysée pour détecter l'effet du clic ? Jeux et écrans ont leur rôle à jouer.

Les écrans et souris compatibles RLA

Les écrans et souris compatibles RLA

ROG Swift PG259QNR : un premier modèle RLA par Asus

Pour nous permettre de mieux comprendre le fonctionnement de RLA, NVIDIA nous a fourni un écran ROG Swift PG259QNR d'ASUS. Nous ne reviendrons pas ici sur ses caractéristiques en détail puisqu'il s'agit d'un PG259QN dont il reprend tous les avantages, dont une dalle mate 1080p IPS pouvant atteindre 360 Hz via G-Sync.

À quoi sert une telle fréquence ? Sur le bureau, pas grand-chose. En effet, si l'on perçoit une nette différence de fluidité en passant de 60 à 120 Hz, apportant un réel confort même en bureautique, l'écart existe mais est plus difficile à percevoir au-delà. C'est dans les jeux, notamment compétitifs, qu'une telle solution a un réel intérêt.

En effet, cela permet d'avoir une synchronisation entre le rendu de l'image et son affichage à l'écran même lorsque l'on joue avec un très gros débit d'IPS. Il est ainsi courant que dans de tels jeux on dépasse les 200 ou 300 ips en 1080p avec une carte graphique haut de gamme. Un tel écran permet d'en profiter au mieux.

Est-ce nécessaire ? C'est à chacun d'en juger selon sa pratique et ses besoins. Nous ne pouvons dans tous les cas que vous recommander le plus possible d'utiliser des dalles à 120 Hz ou plus, et du rafraichissement variable.

Cet écran profite aussi du HDR, DisplayPort 1.4, HDMI 2.0, hub USB 3.0, jack (3,5 mm), montage mural (VESA 100), d'angles de vue de 178° et d'une luminosité de 400 cd/m² (contraste à 1 000:1). Plutôt robuste dans sa conception, il peut pivoter jusqu'à 90° (son pied de - 25° à 25°), s'incliner de - 5° à 20°, être ajusté jusqu'à 120 mm.

Bref, il s'agit d'un modèle haut de gamme auquel nous n'avons finalement que la taille de son pied (un peu imposant) à reprocher. Nous avons mesuré sa consommation à la prise entre 25 et 40 watts selon le niveau de luminosité. En passant de 360 Hz à 60 Hz, la valeur maximale a été réduite de 10 watts.

Le tarif du modèle classique est de 700 euros environ. ASUS nous a confirmé que sa déclinaison QNR serait plus chère, sans pouvoir nous confirmer de prix pour le moment. Elle n'est pas attendue avant début 2021. Nous l'avons utilisé pour nos tests avec une souris Chakram Core du constructeur. Un modèle dont il vante la très faible latence avec quelques raffinements comme un joystick programmable, une forte configurabilité, jusqu'à 16 000 DPI, etc.

Quelles sont ses différences concrètes de l'écran ? Tout d'abord un port spécifique, rouge, où connecter la souris. Fonctionnant en passthrough, il permet de récupérer le signal du clic qui servira de base au calcul de la latence.

L'OSD permet de définir une zone d'une taille plus ou moins importante, visible ou non (selon votre choix) qui sera analysée. L'évolution des pixels dans la zone sera considérée comme signal de fin de la mesure de latence. Certains jeux, comme Fortnite, disposent d'une option faisant apparaitre un rectangle blanc sur l'écran à chaque clic.

De quoi permettre d'effectuer des mesures plus nettes en y plaçant la zone d'analyse.

L'OSD de l'écran ASUS avec les paramètres RLA, le flash Fortnite, le résultat affiché par l'écran et l'overlay NVIDIA

L'afficheur de performances de GeForce Experience mis à jour

L'écran peut afficher en temps réel sa fréquence, adaptée constamment par G-Sync, mais aussi la latence totale du système. Il ne peut en effet que déterminer le temps qui sépare l'envoi du signal de l'évolution de la zone de détection. Pour décortiquer ce résultat, NVIDIA passe par l'overlay de performances de GeForce Experience.

Celui-ci récupère l'information de latence calculée par l'écran, qu'il mixe avec ses propres relevés. En lien avec les pilotes de la carte graphique, il peut différencier la latence de rendu, celle de l'écran et celle restant à la souris. Le tout affiché au sein de l'overlay en temps réel. Une moyenne des valeurs est aussi calculée.

Pour le moment, cette version de GeForce Experience (3.20.6.5) n'est pas encore disponible. Notez d'ailleurs que l'overlay de latence s'ajoute aux autres préconfigurations proposées. On continue d'espérer que NVIDIA proposera à terme de sélectionner les valeurs que l'on veut voir apparaître ou non indépendamment les unes des autres.

Lors de nos relevés, nous avons ainsi pu constater des gains significatifs. Par exemple dans Fortnite en passant de 36,2 à 26,1 ms de latence système moyenne, celle de l'écran et du PC (DLSS Moyen, graphismes Ultra, RTX). Elle était réduite de manière similaire sur différents titres sur notre système de test équipé d'une GeForce RTX 3080.

Sur un jeu comme Apex Legends, peu gourmand, il ne faut pas espérer de gros gains excepté si vous utilisez une carte graphique d'entrée ou de milieu de gamme. Nos relevés étaient dans tous les cas autour de 15 ms.

Les paramètres de latence dans Fortnite pour NVIDIA Reflex

Une technologie très intéressante, visant un public limité

Assez ironiquement, les premiers intéressés par une telle technologie seront sans aucun doute les testeurs. En effet, disposer d'une solution permettant de décortiquer la latence de bout en bout dans différents scénarios est intéressant pour tester certains composants, mais aussi des services de cloud gaming par exemple.

On imagine également que les joueurs compétitifs seront très friands de produits certifiés RLA, qui leur permettront de régler leurs jeux de manière à réduire la latence au maximum et faire les bons choix d'accessoires. Pour le grand public, RLA comme un écran à 360 Hz seront d'un intérêt plus limité, surtout vu le surcoût de l'ensemble.

Mais cela peut aider à l'émergence d'un discours cohérent et technique que la question du jeu à hautes fréquences et de la latence, alors que ces sujets sont trop souvent mis de côté. De quoi vous inciter à enfin sauter le cap du 60 Hz ou d'aller un peu plus loin dans les options de vos jeux et de vos pilotes ? On l'espère.

On imagine également que l'initiative de NVIDIA ne manquera pas de faire réagir AMD qui pourrait également chercher à renforcer ses atouts côté latence. Nous le saurons bien assez tôt.

ASUS PG259QNR : qu’apporte un écran à 360 Hz avec analyseur de latence intégrée ?

-

La latence, c'est quoi, pourquoi s'en préoccuper ?

-

NVIDIA Reflex : la réduction de la latence au-delà du pilote

-

RLA : des écrans et souris pour mesurer la latence

-

ROG Swift PG259QNR : un premier modèle RLA par Asus

-

L'afficheur de performances de GeForce Experience mis à jour

-

Une technologie très intéressante, visant un public limité

Commentaires (33)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 20/10/2020 à 14h12

Dans beaucoup de sport on fabrique des équipements spécifiques pour les professionnels, et la R&D sur ces produits finit parfois par arriver sur les modèles de série.

Je vois ces écrans comme ça, du matériel de pro qui ne justifient pas le surcoût pour 99,9999% des joueurs.

Mais comme les pro gramers et surtout les streamers, ils vont assurer une promo de fou et ça va forcément convertir certains joueurs.

Le 20/10/2020 à 15h10

Bah euh. Faudrait déjà prouver que ça sert à quelque chose cette course à la fréquence et à la latence. Même pour des pro !

Aaaaaah.

Donc au lieu de garder ma GTX 1080 et mes 144Hz je vais me prendre une écran 360Hz ainsi qu’une RTX 3080 tout ça pour avoir 360 im/s. Bon, ça sert à rien mais au moins j’ai la plus grosse. :-)

Le 20/10/2020 à 15h16

Ce que je dis dans le premier passage, c’est que la sortie de ce genre de produits, qu’on apprécie ou pas, qu’on soit client ou pas, ça permet de se focaliser sur les questions de fréquence/latence. Qu’on met souvent de côté (à tort, après tu peux penser qu’un 60 Hz en mode osef de la latence suffit hein, ça ne me pose aucun souci, chacun est libre de ses opinions sur le sujet).

Pour le reste, je ne dis pas que tu dois mettre à jour ton PC. Si ton PC te convient, tout va bien. Si quelqu’un veut plus de perf à 144, 240, 360 Hz, libre à lui. De mon point de vue, et comme je le dis dans l’article. Le seul conseil qui me semble bon à donner c’est d’en finir avec le 60 Hz si possible parce que ça apporte un réel confort de passer à plus (en bureautique ou en jeu).

Après le niveau de fréquence c’est comme les IPS et la puissance des GPU : il y a une offre diverse, pour des besoins divers.

Le 20/10/2020 à 15h19

Merci pour cette présentation et ce test :)

Je suis surpris d’une si forte réduction sur Fortnite, moi qui le classait (arbitrairement) dans les jeu “très peu gourmands”.

Par curiosité, quels autres jeux ont été testés ?

Le 20/10/2020 à 15h22

Sur Fortnite c’est le plus simple à mettre en avant, parce que tu peux vite monter en “lourdeur” et donc être GPU bound, et c’est là que les écarts sont les plus grands. On peut faire pire d’ailleurs, mais je reviendrais plus en détails sur les perfs de Reflex dans un papier dédié (et sur différents GPU, Là c’était surtout histoire de présenter les grandes lignes Pour les tests aussi sur CoD (Valorant peu de gains avec une RTX 3080), je finalise quelques relevés et je mettrai un graphique un peu plus propre

Pour les tests aussi sur CoD (Valorant peu de gains avec une RTX 3080), je finalise quelques relevés et je mettrai un graphique un peu plus propre

Le 20/10/2020 à 15h35

Je ne pense pas qu’un joueur pro va vraiment chercher ce genre de matos.

Tout d’abord, la première chose qu’un pro fait, c’est de mettre tout au minimum pour 2 raisons :

Ensuite, il ne reste plus que le matos lui même à l’origine de la latences, mais là, la latence sera déjà connu pour ce matos : plus la peine de mesurer.

Enfin, les pros tiennent compte s’il sont à l’aise ou pas. C’est pour ça que chaque joueur va avoir une config et un matos différents.

Le 20/10/2020 à 15h42

J’ai du mal à comprendre ton commentaire. Tu dis que le joueur Pro va chercher à maximiser son débit d’image, mais pas avoir l’écran pour les afficher ? Pour la latence, tu dis qu’elle est connue, mais du coup sans la mesurer concrètement tu la connait comment ? (vu que ça dépend quand même pas mal de tes réglages, du jeu, qu’une latence annoncée et celle mesurée peut être différente, etc. ?

Le 20/10/2020 à 15h49

C’est pas gentil de dire qu’ils sont limités ; c’est qu’ils sont susceptibles parfois ces e-sportifs

Le 20/10/2020 à 16h00

Autant les 360Hz, je trouve ça surtout marketing, autant la diminution de la latence, c’est quelque chose d’appréciable. Car un écran “banal” peut facilement avoir l’équivalent de 2 ou 3 images de retard. Sur certains jeux où la réactivité compte, ça devient palpable pour un joueur correct (même pas besoin d’être un pro pour le percevoir).

J’avais fait l’expérience en branchant un cathodique à côté d’un LCD, c’est flagrant.

Le 20/10/2020 à 16h04

L’intérêt surtout de Reflex c’est que ça profite à toutes les GeForce récentes et plus aux modèles entrée/milieu de gamme. C’est assez rare comme “move” pour être apprécié. Après le 360 Hz n’est pas forcément que marketing, mais ça vise un public particulier.

Le 20/10/2020 à 21h27

Comme dit au début de l’article, la latence réseau n’est pas négligeable.

Quelles sont les ordres de grandeur de la lantence réseau par exemple en lan (en comptant la latence du stack) vs la latence des cpu/gpu ?

En tout cas ces améliorations profiteront à moyen terme sans doute à tous. Un peu comme freesync/g-sync

Le 21/10/2020 à 04h25

Difficile à dire parce que ça peut dépendre de pas mal de facteurs (filaire, sans fil, organisation du réseau). Mais bon sur un réseau local tu restes en général sous la milliseconde, au pire 2 ou 3 si vraiment le réseau est chargé mais il n’y a pas de raison d’aller au-delà.

C’est surtout en fibre/cuivre que tu es plus dans la dizaine/centaine de ms selon la distance du serveur, la connexion, etc.

Le 21/10/2020 à 07h28

2 ou 3ms pour le réseau, auquel il faut ajouter la couche réseau du jeu, les logiciels de priorisation du réseau (qui bufferise forcément :-/ )… Bref c’est le même problème que pour la partie affichage, il faudrait voir la globalité.

Et à côté de ça on branche un console limitée à 30FPS sur un téléviseur avec du post-processing optimisé pour le cinéma

Honnêtement même les pubs pour les jeux console semblent ramer je me demande parfois si on a réellement les 30FPS tellement on voit les micro-saccades.

Le 21/10/2020 à 07h34

Je trouve ça vraiment ridicule. On est déjà capable de faire des pipelines de rendus sous les 12 ms avec des écrans 90Hz (en VR notamment). Faire transpirer du Watt à nos GPU pour en afficher plus c’est gâcher de l’énergie, purement et simplement.

Le 21/10/2020 à 08h11

Oui surtout dans les multi-joueurs où les A/R incessant d’infos ajoutent pas mal de complexité à l’ensemble.

Le 21/10/2020 à 08h32

Je retroune la question : à quoi bon afficher une stat lorsque de toute façon tu ne peux plus rien régler pour l’améliorer ?

Comme j’ai dit, la première chose qu’un joueur pro va faire dans les réglages, c’est tout mettre au minimum, il y a peu de chance qu’ils puissent faire beaucoup de chose de plus au niveau des réglages du jeu.

Du coup, les seuls éléments qui reste à modifier, c’est son matos. Mais comme tu l’a dis dans l’article, ce genre d’écran va permettre de faire des bench de latence. Mais une fois la mesure réalisé, on peut supposer que la latence du matos reste la même, on ne peut pas vraiment agir dessus plus que ça. Ca n’est qu’un critère de choix à l’achat du matos.

Dans les compétitions pro, de toute façon, dès qu’ils jouent sur scènes (ou même dans des structures), les joueurs n’ont pas beaucoup de marge de manœuvre, l’UC, l’écran, les casques, le système… tout ça est fournis.

Le 21/10/2020 à 09h08

Parce que dire ça c’est penser que te coller CPU bound c’est réduire ta latence au max. Alors que ce n’est pas aussi simple. Tu maximises ton débit d’images mais tu ne réduis pas forcément ta latence au max. D’où les options dans les pilotes, Reflex. Sans parler de celle des compos que tu ne connais pas sans la mesurer.

Le 21/10/2020 à 10h03

Hâte de lire la suite alors :smile:

:smile:

Le 21/10/2020 à 11h30

Jusqu’à preuve du contraire ça sert à rien sinon de permettre aux constructeurs de vendre du matériel.

En attendant tu fais passe-plat du marketing nvidia & co : YouTube

YouTube

Le 21/10/2020 à 11h34

Cela va être utile pour les journalistes pro qui testent du matériel. Cool pour eux et pour nous si on cherche à gagner 1 micro-seconde sur un clic de souris.

Mais les joueurs pro ont toujours essayé de gagner de la latence en :

En sachant que le vrai bottleneck c’est le réseau et ça sauf miracle cela écrasera pendant encore longtemps les “améliorations” des outils type Reflex.

Le 21/10/2020 à 12h40

Si tu mets tout au minimum tu risques d’augmenter le frame rate fourni par le CPU, et donc le nombre d’images calculées en avance dans les frames buffers. Avoir plus de FPS par rapport à ce qui est affiché risque d’augmenter la latence. Je vais exagérer pour illustrer : si le CPU calcule 3000 images / secondes mais que ton système graphique n’en affiche que 60 fps, tu vas calculer 50 images de plus qu’afficher réellement : Ton clic de souris risque d’être pris en compte dans le frame buffer mais de rater un 60ème de seconde et être affiché au rafraîchissement d’écran suivant (donc augmentation de la latence d’1/60sec = 17ms)

Le principe de ce système est de baisser le frame buffer au strict minimum. En gros le CPU commence à calculer l’image le plus tard possible, donc il travaille avec des données les plus fraiches possibles (ex: récent clic de souris)

Après on est en phase que c’est probablement assez anecdotique pour la majorité des gens, par contre pouvoir vérifier & ajuster par jeu est utile, mettre tout au minimum n’est pas le réglage optimum pour baisser la latence.

Le 21/10/2020 à 12h41

Oui, c’est tout à fait mon genre ;) Après tu es libre de penser que ni la hausse de la fréquence ni la réduction de la latence sont utiles tout comme les efforts en la matière (où qu’ils se situent dans la chaîne de rendu). Mais je suis plutôt du genre à penser que rien n’est jamais si absolu.

Clairement, même si comme dit dans l’article, une intégration de ce type vise un public limité. Ce sera d’ailleurs intéressant de voir si ça se généralise/démocratise avec le temps (et le discours d’AMD sur ces sujets la semaine prochaine, vu qu’ils ont aussi mis en place des optimisations de latence dans leurs pilotes).

Le 21/10/2020 à 14h16

Je n’ai évidemment pas tout expliqué. Par exemple le premier truc à faire c’est dégager le buffer justement. Reflex c’est surtout pour jouer avec une plus petite latence si tu fous tout en high. Si t’es déjà à 144 im/s stable sur un écran à 144Hz il va pas miraculeusement changer ta vie.

Le 21/10/2020 à 14h22

Inversement, les très bons écrans LCD ont de nos jours moins de latence qu’un CRT (8.3ms sur du 60 Hz).

Le 21/10/2020 à 14h28

Il est préférable de bosser sur le netcode (et qu’un génie fasse un netcode rollback sur les fps, t’as pas envie Carmak ? https://www.youtube.com/watch?v=0NLe4IpdS1w ). Sauf si nvidia trouve un moyen d’optimiser le netcode avec un gpu ça les intéresse pas vraiment. Mais te faire croire qu’avoir un frame en 2.8ms c’est méga important et que tu dois acheter un écran à 1000€ + un gpu (nvidia évidemment) RTX 3080.

Le 21/10/2020 à 14h51

Grace à

Je vois un peu mieux (je ne comprenais pas à quoi correspondait cette queue).

Mais là encore, ce n’est pas justement le boulot de l’outil Reflex ? Et je n’ai pas l’impression que cette outils ait besoin du “Reflex Latency Analyser” de l’écran et de ses mesures pour faire son boulot, non ?

Le 21/10/2020 à 15h19

Reflex ne nécessite ni écran à 1000 euros ni RTX 3080. Comme dit plus haut, c’est même plus utile sur des cartes milieu de gamme ou le gaain en latence sera plus net puisque l’on est plus rapidement dans des cas GPU bound.

Le 23/10/2020 à 07h13

C’est justement le role de reflex de pouvoir modifier le comportement du buffer qui est géré par le moteur graphique, il n’y a jamais de réglage taille du buffer dans les jeux.

A 144fps parfaitement stable, il sera aussi utile de baisser le buffer pour ne pas jouer avec quelques images de décalage (correspondant à la taille de ce buffer).

Si tu dégageais totalement le buffer dans tous les cas tu auras probablement des saccades : sans buffer si l’image suivante n’est pas prête c’est la précédente qui reste affichée. Avec un buffer d’images d’avance tu auras un état intermédiaire un peu plus à jour que celle affichée depuis un cycle complet de rafraichissement.

Bref c’est loin d’être binaire, ce réglage est un délicat équilibre entre fluidité et latence.

Le 23/10/2020 à 12h56

De quel buffer parles-tu ?

Le buffer dont je parle c’est le double ou triple buffer lié au vsync. Vsync (et buffer) à désactiver en prio’ pour baisser la latence.

Le 23/10/2020 à 13h05

Le GPU bound survient car le joueur souhaite jouer en ligne tout en gardant une qualité d’affichage correct. Chercher une latence courte, et des graphismes highend, c’est antinomique et donc la cible est bien le casual-gaming à qui on souhaite vendre du matos d’une façon ou d’une autre.

Ce n’est pas un souci pour un pro sauf si il est aussi un homme sandwich qui doit vendre du GPU nvidia.

En attendant j’attends toujours un test des écrans hautes fréquences et de son intérêt réel, qui ne soit pas sponsorisé par nvidia.

Le 24/10/2020 à 02h47

J’ai arrêté la vidéo au moment des souris spéciales à brancher sur l’écran, ce qui permettrait d’analyser du coup la latence sans en ajouter. J’ai rarement vu du passthrough “sans latence”, désolé de douter. Même si c’est sûrement très faible, je n’apprécie que peu le discours marketing mensonger.

Sans compter que cela semble requiérir Geforce Experience au final. On a déjà du mal à contrer la télémétrie maintenant pleinement intégré au driver donc… non, pas la peine d’en rajouter.

Quand à inciter à “enfin” sauter le cap du 60 Hz… Encore faut-il avoir eu l’occasion de le tester. Ça n’a jamais été le cas pour ma part, je ne connais personne avec ce genre d’équipement. Je ne vois donc d’intêret que pour les FPS et clairement PAS pour de la bureautique (sauf à aimer les animations dans Word ou les transitions entre fenêtres ?). Donc cramer des centaines d’euros pour remplacer 2 ou 3 écrans pour un doublage de fréquence qui supposera aussi de changer la carte graphique pour que ça puisse supporter le double du travail précédent (car je fonctionne toujours en Vsync pour ne pas stresser l’équipement) n’a rien de pertinent.

Ça ressemble plutôt à du discours marketing comme on en a eu pour la supposé révolution de la TV 3D ou de la VR. Tout est bon pour nous faire changer d’équipement.

Le 24/10/2020 à 06h03

Je comprends qu’on ne se comprends pas, mais libre à toi. PS : ce papier n’est pas sponsorisé, ceux qui le sont ne sont pas rédigés par la rédaction et sont indiqués comme tels.

Tout a forcément une latence, même le câble au bout de la souris, celui qui relie à l’écran, mais il faut raison garder ;) Le besoin d’une souris spécifique pour disposer d’un signal à récupérer reste une limite de l’exercice, même si je trouve que NVIDIA a bien fait de trouver une raison de le contourner à la marge pour maintenir un calcul et un affichage de résultat.

Il y a deux choses : la mesure de latence intégrée à l’écran ne nécessite pas GFE. Reflex non plus. Ce qui nécessite GFE c’est l’overlay, comme expliqué dans le papier dédié. Je comprends qu’on y soit opposé, au quel cas, une telle fonctionnalité n’aura effectivement pas d’intérêt pour les utilisateurs concernés.

Je maintiens : le fait de garder la limite de 60 Hz comme référent n’a plus vraiment de sens. On sait produire plus rapide facilement, ce chiffre n’a aucune raison d’être utilisé comme valeur de base plus qu’un autre.

Quand on renouvelle son écran, mon conseil est le plus possible de choisir un écran capable d’aller au-delà. Comme c’est aussi d’éviter un TN au profit d’un IPS ou autre, même si c’est un peu plus cher. Je comprends que le prix soit une contrainte, un critère. Cela ne doit pas être le seul, c’est un juste milieu à trouver.

Comme dit ici ou ailleurs, je ne peux que t’inviter à tester des écrans à plus de 60 Hz pour te faire un avis sur le sujet. Crier au complot marketing est aisé, le faire en connaissance de cause est préférable. Et personne ne te force à renouveler : je précise juste un critère à prendre en compte quand tu le feras.

Libre à toi de rester à 60 Hz la prochaine fois si tu préfères, ça me va aussi ;) Le principe d’un conseil c’est qu’on peu le suivre ou non.

Il n’est pas nécessaire de “cramer des centaines d’euros” ou de changer de carte graphique pour profiter de plus de 60 Hz. Forcément, si tu as plusieurs écrans, ce sera plus coûteux au renouvellement, mais le surcoût n’est pas toujours si important (sauf à prendre des 22” TN en promo comme base de calcul).

C’est juste plus coûteux d’avoir un écran qui a une large plage d’adaptation de fréquences qui peut être utile en jeu (pour avoir constamment un alignement entre GPU et écran à ce sujet). FreeSync a pas mal contribué à se focaliser sur le chiffre maximal sans regarder le minimal (qui ne va pas jusqu’à 0 les concernant en général) avec un résultat parfois décevant “mais c’est pas cher”.

Mais il y a de plus en plus de bons modèles disponibles à des tarifs raisonnables, même avec de bonnes dalles et définitions, surtout avec la généralisation du VRR et du DisplayPort/HDMI 2.1 qui facilitent les choses. Il faut être vigilant, mais trouver de bons produits accessibles n’est pas impossible.

Par exemple, ici tu as un modèle avec dalle VA, en 1080p, qui gère de 48 à 144 Hz (FreeSync Premium). je doute qu’on soit dans une tarification excessive comme tu le suggères. On pourra sans doute trouver meilleur écran en dépensant un peu plus, mais ça montre que ce n’est pas réservée à une élite.

Le 26/10/2020 à 21h56

J’avais mal saisi pour le GFE donc je pensais qu’il était requis

Pour l’écran, à part en acheter un je ne peux pas tester, et clairement mes priorités sont autres. Cependant mon 27” devrait bientôt s’éteindre à jamais. Je tenterai de le réparer si ça arrive mais j’envisagerai un achat si le coût ne se justifie pas (et ça risque, car le Royaume-Uni nous quitte or pour avoir des capaciteurs à un prix inférieur à leurs frais de transport, il n’y avait pas mieux).

Ce AOC est vraiment pas mal, mais il lui manque une fixation Vesa et une capacité de mode portrait. Aussi il ne semble pas démontable, bien que je cherche encore des informations là-dessus.