La GeForce RTX 3070 Ti face aux RTX 3070 et 3080

Quelle est votre préférée ?

Le 09 juin 2021 à 13h00

8 min

Hardware

Hardware

Après la GeForce RTX 3080 Ti, nous avons pu tester la RTX 3070 Ti. Nous avons ici cherché à répondre à une première question : comment se positionne-t-elle face aux RTX 3070 et 3080 ?

La semaine dernière, NVIDIA mettait sur le marché sa GeForce RTX 3080 Ti, un modèle dont on a vu que le positionnement était complexe, apportant peu de gain par rapport à la RTX 3080, sans avoir les avantages de la RTX 3090. Le tout avec un tarif situé entre les deux modèles. Aujourd'hui, découvrons sa petite sœur, la RTX 3070 Ti.

Ici, le constructeur se retrouvait face à un choix plus simple puisque le prix était presque écrit d'avance. Les modèles inférieurs et supérieurs étant à 519 euros et 719 euros, la RTX 3070 Ti a logiquement été annoncée à 619 euros. NVIDIA a surtout dû décider quelles caractéristiques mettre derrière ce tarif.

Il pouvait en effet opter pour une solution proche de la RTX 3070 ou de la RTX 3080, son objectif principal étant sans doute de proposer une alternative à la Radeon RX 6800 XT d'AMD qui est annoncée à 641 euros.

C'est donc la première option qui a été choisie, avec un GPU GA104 doté de 6 144 CUDA Cores contre 5 888 pour la RTX 3070 et 10 240 pour la RTX 3080 (GA102). Les fréquences sont légèrement en hausse. Côté mémoire, on retrouve 8 Go (256 bits), mais de GDDR6X à la bande passante plus élevée. De quoi assurer des gains entre 5 et 10 % en théorie.

Et en pratique ? C'est ce que nous avons vérifié dans nos tests.

Configuration de test

Nous avons utilisé la même machine que précédemment, plutôt orientée « créateur ». Elle était ainsi composée d'une carte mère ASUS Pro WS W480-ACE sur laquelle était monté un Core i9-10850K surmonté d'un ventirad Noctua et accompagné de 4x 8 Go de DDR4, avec un SSD PCIe 4.0 de 2 To. Le tout sous Windows 10 21H1.

L'alimentation choisie était une bequiet! Straight Power 10 de 500 watts. Ici, nous comparerons uniquement cette carte aux autres modèles de référence de NVIDIA (RTX 3070 et 3080). Nous reviendrons dans une analyse dédiée sur la manière dont ces modèles se positionnent face à RDNA 2 et la Radeon RX 6800 XT.

Limiteur de hashrate : toujours présent

Notez que le modèle Founders Edition que nous avons testé, intègre, comme toutes les GeForce RTX 3070 Ti et 3080 Ti, le limiteur de hashrate. Nous avons d'ailleurs eu plusieurs questions à ce sujet, il nous semble donc utile de préciser que cette fonctionnalité est dans tous les derniers GPU mis sur le marché de NVIDIA, avec deux cas :

- GeForce RTX 3060 Ti, 3070, 3080, 3090 : seuls les modèles récents, marqués « LHR » sont concernés

- GeForce RTX 3060, 3070 Ti et 3080 Ti : tous les modèles sont concernés

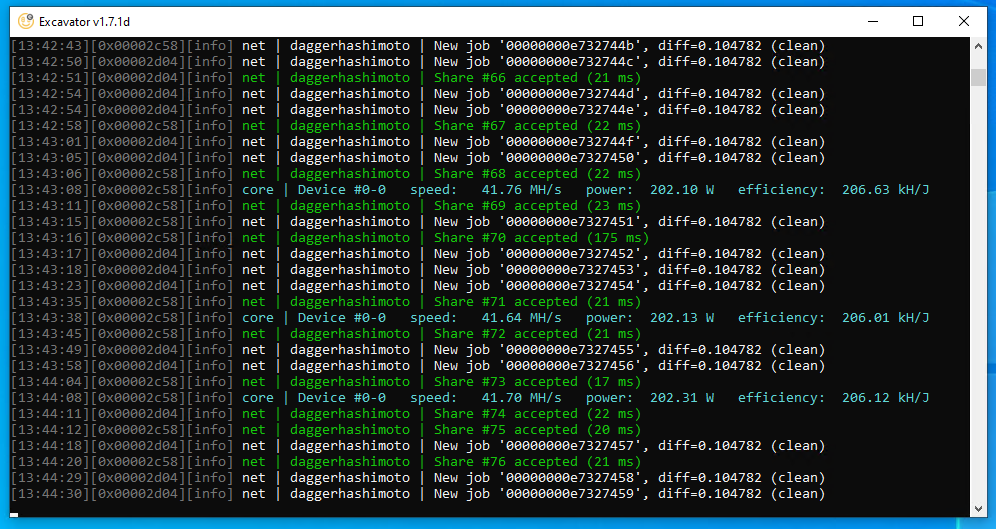

Pour vérifier son fonctionnement sur ce modèle, nous avons utilisé le même protocole que dans un précédent article, reposant sur le client de NiceHash. Nous avons baissé la fréquence du GPU de 900 MHz et augmenté celle de la mémoire d'autant, pour obtenir une bonne efficacité au minage. Voici le résultat :

On arrive à une moyenne de 42 MH/s, contre 63/97 MH/s pour les RTX 3070/3080, ce qui correspond là encore à la moitié environ. Cela pénalise donc la performance énergétique (210 kH/J) et la rentabilité d'une telle carte pour le minage de cryptomonnaies, ce qui est l'objectif recherché par NVIDIA qui espère bien que cela permettra de calmer la demande, afin que les joueurs puissent se payer ces GeForce à un tarif raisonnable.

À notre connaissance, aucun contournement n'a été trouvé pour ce limiteur de hashrate.

Jeux sans RTX/DLSS : des écarts conformes aux attentes

Passons maintenant aux tests dans les jeux en commençant par un classique : le benchmark Superposition d'Unigine. Assez gourmand, il pousse les cartes dans leurs retranchements, en 1080p/4K, via DirectX ou OpenGL :

Dans les deux cas, on voit deux groupes qui se distinguent : les RTX 3070 (Ti) et les RTX 3080 (Ti) avec un net écart entre les deux. On constate donc que si le tarif de la RTX 3070 Ti a été placé de manière équilibrée entre les 3070 et 3080, ce n'est pas le cas de ses performances, qui se rapprochent plutôt de la première. Ce nouveau modèle doit donc bien être vue comme un « coup de boost », de 7 à 9 % selon les résultats de ce premier test.

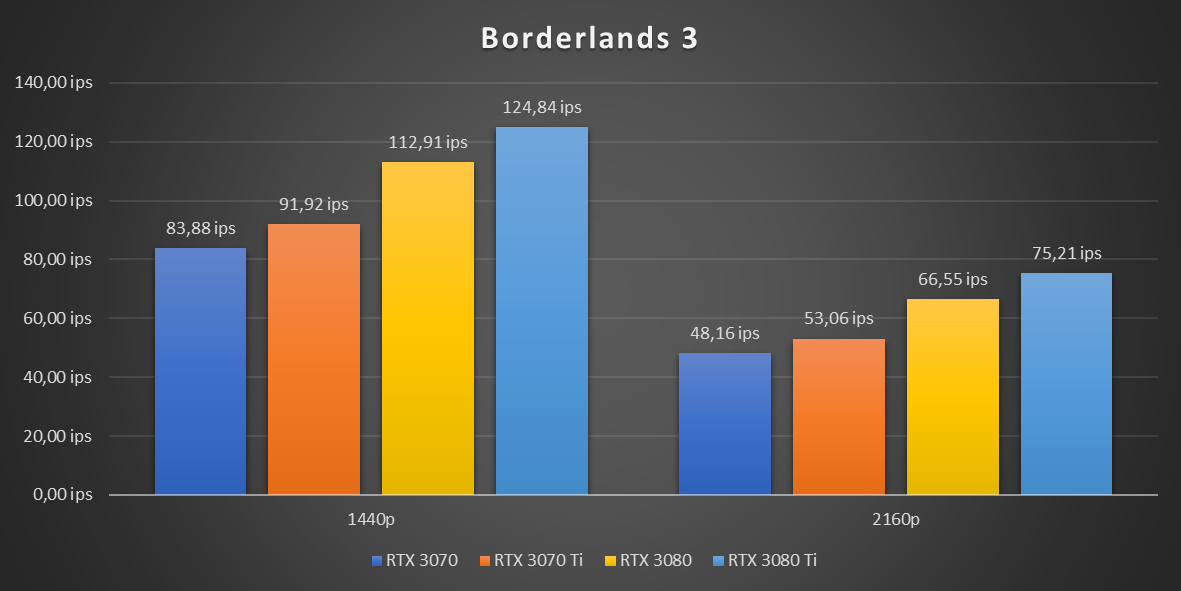

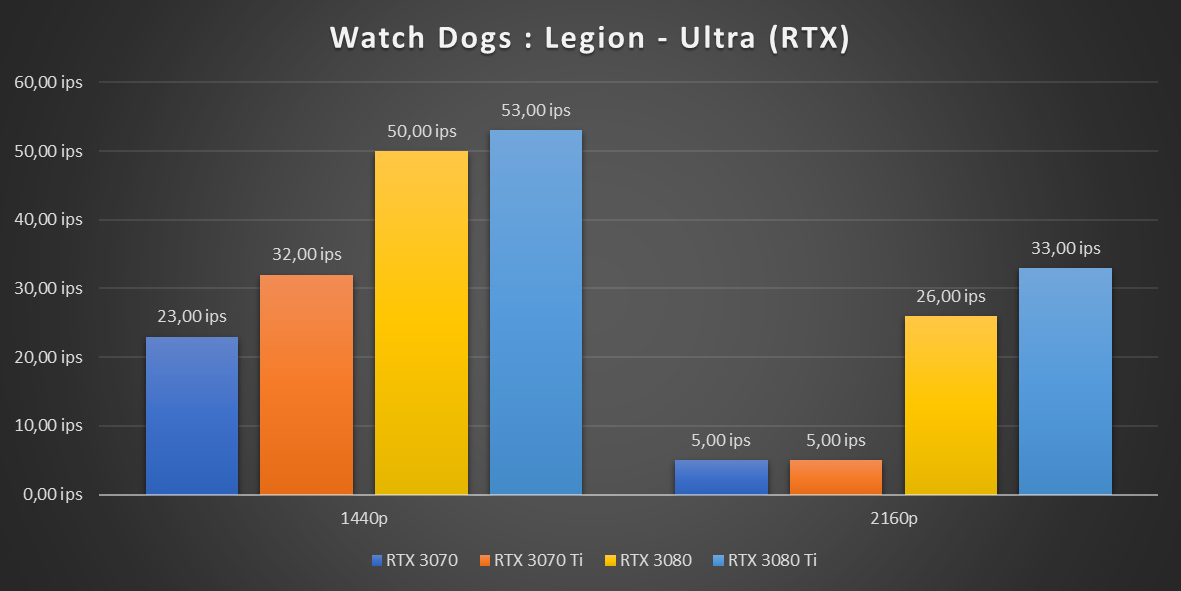

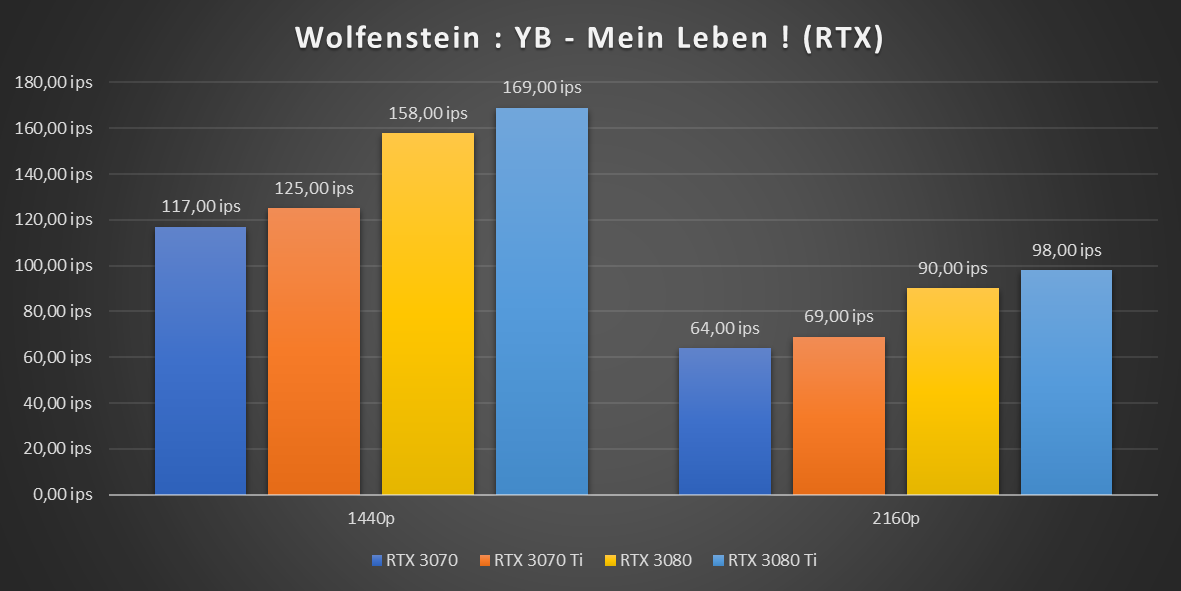

Passons maintenant à différents jeux. Nos relevés sont réalisés en 1440p et 2160p :

Ici, le constat est identique, même si l'écart avec la RTX 3070 est parfois légèrement plus élevé, pouvant atteindre 11/13 %. Il reste néanmoins plus faible que ce qui la sépare de la RTX 3080, plus performante de 23 % en moyenne. Notez que les RTX 3070 (Ti) s'effondrent en 4K sur Watch Dogs : Legion, un mode conçu pour saturer leurs 8 Go de mémoire. Mais c'est l'un des rares cas où cela arrive, même les RTX 3080/3090 ne faisant que s'approcher des 60 ips.

Jeux avec RTX/DLSS : même constat (ou presque)

Passons maintenant à des situations où le ray tracing est activé, avec ou sans DLSS pour l'épauler :

Les résultats se suivent et se ressemblent, avec un écart entre 7 et 10 %. Ce dernier se vérifie surtout quand la charge est lourde. Seules exceptions : Shadow of the Tomb Raider sans DLSS où 3070 et 3070 Ti ont obtenu des résultats similaires, et Watch Dogs : Legion qui est injouable sans DLSS (le mode performance étant conseillé).

Rendu 3D : aucune surprise

Voyons maintenant ce qu'il en est dans une situation où le GPU est bien plus lourdement sollicité, notamment les nombreuses unités FP32 présentes au sein des CUDA Cores de l'architecture Ampere. Pour cela nous utilisons Blender 2.92 avec le moteur de rendu Cycles, profitant d'OptiX pour exploiter l'accélération des RT Cores. Nous effectuons deux tests sur la scène Droid Chase de NVIDIA, l'une avec et l'autre sans motion blur :

Le constat est le même dans les deux cas : la RTX 3070 Ti met 8 % de temps en moins pour effectuer le rendu par rapport à la RTX 3070. Mais la RTX 3080 met 20 % de temps en moins par rapport à la 3070 Ti.

Bilan énergétique

Avant de conclure, nous avons effectué nos relevés habituels concernant la gourmandise énergétique de ces cartes. Nous obtenons ainsi la quantité d'énergie consommée (en Wh) à la prise lors du test Blender (sans motion blur) et de Borderlands 3 (en 2160p). Nous calculons ensuite la consommation moyenne :

Outre le prix, les scores ici relevés sont le seul point noir de la RTX 3070 Ti. Elle s'est en effet montrée plus gourmande que les 3070 et 3080 avec une consommation moyenne en hausse de 25 % par rapport à la RTX 3070. Ainsi, elle nécessite plus d'énergie pour effectuer le rendu 3D et 7,3 joules par image dans Borderlands 3, contre 6,3/6,6 joules par image pour les GeForce RTX 3070 et 3080.

La carte, qui reprend le châssis de la RTX 3070 Founders Edition (plus compact que la RTX 3080) est toujours aussi silencieuse, son ventilateur s'arrêtant lorsque le GPU n'est pas sollicité. Bien entendu, les partenaires de NVIDIA ne manqueront pas de proposer des modèles avec leurs propres systèmes de refroidissement.

Envie d'un petit coup de boost ?

Comme pour la GeForce RTX 3080 Ti, on note que le rapport performances/prix est en baisse. Nous l'avons calculé à 13,83 ips par tranche de 100 euros, contre 15,33 pour la RTX 3070, 14,89 pour la RTX 3080 et 9,44 pour la RTX 3080 Ti.

Bien que le GPU évolue, les gains affichés de 6 à 13 % nous donnent presque l'impression de nous retrouver face à un modèle overclocké. Ce n'est pas vraiment le cas puisque les fréquences n'ont été que très peu revues à la hausse, mais certains arriveront sans doute au même résultat en poussant leur RTX 3070 dans ses retranchements.

NVIDIA avait besoin d'un modèle intermédiaire à positionner face à la RX 6800 XT d'AMD, c'est désormais chose faite. Il est moins cher (en théorie), plus complet au niveau des fonctionnalités (Broadcast, DLSS, Reflex, etc) et sera sans doute mieux taillé pour le rendu 3D et le ray tracing. Nous verrons cela en détail dans un prochain article.

Mais au final, faut-il craquer ? Tout dépend. Contrairement à la RTX 3080 Ti, la hausse tarifaire par rapport à la RTX 3070 n'est pas énorme, certains pourraient accepter de payer un peu plus cher pour obtenir de meilleures performances sans effort (d'autant que la RTX 3070 Ti peut elle aussi être overclockée). Il faudra de toute façon voir quels seront les tarifs réels pratiqués et le niveau de la demande pour en juger. Dans le contexte actuel, acheter une carte graphique telle que celle-ci relève pour beaucoup de l'impossible ou de l'inaccessible.

La RTX 3080 reste néanmoins le modèle qui vous fera passer un réel palier à tous les niveaux. Il aura donc la préférence de beaucoup. NVIDIA aurait sans doute gagné à mieux équilibrer cette RTX 3070 Ti, dont le tarif grimpe de 20 % mais les performances de 10 %. Cela ne semble néanmoins pas l'objectif de cette édition 2021 des « Ti ».

On a même plutôt l'impression que NVIDIA regrette presque d'avoir été si « généreux » dans le positionnement de ses RTX 3070/3080 à leur lancement, et qu'il cherche aujourd'hui un peu à se rattraper.

La GeForce RTX 3070 Ti face aux RTX 3070 et 3080

-

Configuration de test

-

Limiteur de hashrate : toujours présent

-

Jeux sans RTX/DLSS : des écarts conformes aux attentes

-

Jeux avec RTX/DLSS : même constat (ou presque)

-

Rendu 3D : aucune surprise

-

Bilan énergétique

-

Envie d'un petit coup de boost ?

Commentaires (38)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 09/06/2021 à 13h53

Ça me rend triste les journalistes hardware qui continuent à faire des articles sur du matériel, comme si on pouvait encore en acheter aux tarifs annoncés.

Le 09/06/2021 à 13h57

Ces produits existent, des tarifs sont annoncés, on fait avec. Après pour les modèles de partenaires, c’est à chacun de juger selon les tarifs pratiqués, ses besoins et son budget. Je suis plus triste de passer du temps à tester des produits pour lire de tels commentaires à titre personnel.

Le 09/06/2021 à 14h03

Disponibilité, zéro :)

Le 09/06/2021 à 14h07

Attention, je ne remet pas en cause la qualité du travail, au contraire je regrette juste qu’au vu de la situation actuelle, tout ce travail de qualité perd une grande partie de son interet.

Le 09/06/2021 à 14h16

Mouais, dans mon cas 500€ ça reste un cap à passer, si ils n’avaient pas été “généreux” j’aurai regardé un autre modèle (même si ça aurait certainement été une 3060 …)

Le 09/06/2021 à 14h30

Le lancement commercial est demain, mais comme à chaque lancement en ce moment, il y aura sans doute peu de cartes par rapport à la demande. On verra sur la durée.

Le 09/06/2021 à 15h52

La 3070Ti m’a l’air pas mal, y’aura plus qu’à voir selon les disponibilités pour aller me faire un devis chez mon revendeur préféré pour une config basée dessus.

J’aimerais l’associer à un Ryzen 7 (car j’en ai un sur mon PC de geekage et mon portable pro Tuxedo est aussi basé dessus, et je les adore), est-ce que c’est cohérent entre eux ou bien l’un d’eux risque d’être sous exploité dans le lot ?

Sachant que j’aimerais que la base tienne dans le temps et évolue avec un simple changement de CG. (si d’aventure cela était nécessaire)

Je précise : je ne suis quasi pas le hardware donc hésitez pas si vous avez des suggestions. J’ai une contrainte Nvidia à cause d’un écran G-Sync.

Le 09/06/2021 à 16h19

En ce quj me concerne, c’est un ryzen 9 5900X et une 3080. Aucun problème de compatibilité. Dans le pire des scénarios tu perdras une fois de temps en temps 1 à 2 % de perfs dans un jeu donné pour des fréquences d’images très élevées (au dessus de 100) en full hd ou moins. Certains te diront sans doute “IPS avant tout”, moi pas :). La différence de perfs varie d’un jeu à l’autre en plus. Certtains sont très avantagés par Intel, d’autres par AMD, donc bon.

Pour l’exploitation du processeur, ça dépendra de ce que tu comptes en faire. Dans mon cas, le 5900X est clairement overkill pour les jeux, mais je ne fais pas que ça.

Le 09/06/2021 à 16h25

Précisément, non, on ne verra pas sur la durée.

Ou alors définis la durée, car pour les grandes sœurs, on parle de pratiquement 10 mois depuis la sortie pour un disponibilité nul ou presque.

Si ta position, c’est de considérer que c’est pas un soucis car 2 ans après le lancement on trouvera enfin ces cartes dans le commerce sans devoir dépenser 2,5 fois leur MSRP, navré, mais c’est vraiment une très mauvaise position.

Le 09/06/2021 à 16h41

Une bonne carte qui se place entre une 3070 et une 6800, mais vu la situation, je vais rester sur ma 5700 encore longtemps, qui me suffit amplement.

Le 09/06/2021 à 17h44

Celle que l’on trouve au prix prévu…

Le 09/06/2021 à 18h15

Bien sur que c’est un souci, mais la réalité du marché est ce quelle est, la tension sur les approvisionnement aussi. Et spoiler : grogner dans un article ou des commentaires n’y changera rien, ça touche l’ensemble des acteurs et du marché.

Ma position c’est simplement de dire qu’il y a des produits mis sur le marché (que des gens achètent), qu’on analyse donc ces produits. Pour les ratio perf/prix on le fait forcément sur les tarifs publics, à chacun ensuite d’adapter par rapport aux modèles qu’il vise et la réalité du marché (même si à mon sens le seul conseil qui vaille c’est “passez votre tour à moins d’un besoin vital”). C’est la même chose dans les lancements classiques, avec toujours un différentiel entre le MSRP et la référence ASUS ROG par exemple.

Le 09/06/2021 à 18h57

Merci pour le test. Après plusieurs tests lus, j’en conclus que c’est pas une mauvaise carte mais qu’elle n’a pas toutes les qualités qu’elle aurait dû avoir pour supplanter la 3070. Sa conso moyenne à +25% me fait dire qu’elle n’est pas si bien née que ça…. Après tout dépendra quel GPU on remplace.

A l’heure actuelle j’imagine que le but de beaucoup restera quand même de ne pas cramer son GPU sinon grosse galère en perspective…..

Le 09/06/2021 à 20h06

Merci pour l’article 👍

Bon forcément j’espérai qu’elle soit plus proche de la RTX3080, ou au minimum a mi-chemin entre 3070 & 3080.

Je pense tout de même en commander à moyen terme (je pense qu’au lancement ça va être très compliqué), en espérant que la disponibilité soit meilleur que la 3070 😅

Le 09/06/2021 à 21h02

Merci.

Dans le cas présent, je serai clairement sur une machine dédiée au jeu. Après, le CPU overkill ne me dérange pas outre mesure car ça permet d’être un peu plus futur-proof.

Ma tour actuelle a eu droit à une upgrade de CG il y a trois ans, mais d’un, la CG montre des signes de faiblesse (instabilité, je crains qu’elle n’ait pris un coup durant les périodes de canicules car c’est arrivé peu après l’été dernier), de deux la base est un Intel core i5 moyenne gamme qui a bientôt 7 ans donc c’est plus devenu un boulet qu’autre chose. C’était une tour materiel.net catégorie gaming moyenne gamme à 800€ car à l’époque mon budget était assez limité.

Aujourd’hui, ayant pu mettre largement ce qu’il faut de côté, je vise la durée dans le temps.

Mon profil de joueur n’est pas compliqué : je suis sur écran ultrawide en 3440x1440, et ma priorité est la fluidité quitte à sabrer dans la qualité graphique. Donc je pense avec un couple Ryzen 7 + 3070Ti je serais tranquille pour un bout de temps.

Le 10/06/2021 à 05h08

Ca me semble cohérent comme choix. en plus, tu as un écran G-sync.

Le 10/06/2021 à 06h47

C’est la pire niveau performance énergétique de la branche 30x0. C’est franchement pas le bon plan, sauf disponibilité au juste prix.

Le 10/06/2021 à 10h05

Merci pour ce test.

Assez décevante cette génération intermédiaire, et le suffixe TI me semble peu justifié, sans même parler du gros problème de consommation électrique.

Seul problème, les prix sont tellement délirants que même une 3070 ti à son prix de base serait quand même une excellente affaire

A ce rythme, ma bonne vieille 1080 va attendre tranquillou les RTX 4xxx

Le 10/06/2021 à 10h10

Pareil, ma 1080Ti va ptet encore bien attendre un an ou deux du coup

Le 10/06/2021 à 12h55

A mon avis tu va pouvoir la garder bien plus longtemps que ça…

J’ai regardé pas mal de vidéo sur l’unreal engine 5 avec son fameux lumen + nanite et je pense que ça va au moins faire sauter deux voir peut être trois génération de carte graphique. Et d’après ce que j’ai compris tout projet qui tourne sur l’ue4 est très facilement transposable sur l’ue5.

Et encore, ça c’est en partant du principe que tu va jouer en ultra… Si tu te tourne vers des réglages moins gourmand tu va surement pouvoir conserver ta carte pendant 5 / 6 génération.

Le 10/06/2021 à 14h45

Ça me semble très optimiste. Avec des jeux un peu lourd, actuellement, il faut déjà se limiter à du FHD dans mon cas (et peut être du QHD sur une TI), en rognant un peu sur les taquets graphiques (en tout cas pour coller à un 60fps stable).

Avec le gap technique des consoles next-gen, on va voir apparaître des jeux bien plus gourmands en terme de ressources (cpu et gpu), et en conséquence, j’ai tendance à penser qu’on va voir un vieillissement accéléré des “vieux” GPU, qui ne font pas de RT, ni de DLSS.

J’avoue que si je me passe du RT sans trop de difficulté, j’aurais été preneur d’un DLSS 2 sur ma 1080 histoire de fluidifier un peu.

Le 10/06/2021 à 15h11

Je vais entrer un peu dans des détails techniques :

Actuellement un modèle 3d dans un jeu possède environ 10.000 polygones ( chiffre au doigts mouillé ), ce qui est très peu. L’artiste doit donc rajouter une texture de bump mapping pour augmenter virtuellement la résolution du modèle 3d.

Vu les limites des cartes graphique il est absolument impossible dans les anciens moteurs de charger des centaines de modèles ayant chacun 10.000 polygones. L’artiste est donc obligé de créer plusieurs modèles à des résolution différentes. Non seulement cela prend beaucoup de temps mais aussi de la place et c’est repérable à l’euil nu.

Avec l’unreal engine 5 ( et d’autre suivront je pense ) tu n’a plus vraiment besoin d’avoir une texture de bump mapping. A la place tu charge un modèle 3d ayant 100.000 polygones et le moteur optimise le nombre à afficher selon la distance de la caméra.

Un modèle de 100.000 polygones prend bien moins de place qu’une texture de bump mapping en 4k et au passage ça rend les ombres et la géométrie bien plus réaliste.

Les next gen sont déja dépassée techniquement… Un pc avec une 2080 est bien plus puissant. La meilleur preuve à ce jours c’est la décision de EA / DICE d’avoir des cartes plus petites sur ces fameuses next gen sur le prochain battlefield.

Le jeu n’est même pas sortit et les consoles n’ont même pas un an et il est d’ailleurs difficile d’en trouver une. Et le premier “jeux cross” plateforme qui va sortir n’est déjà pas identique.

Le seul véritable “boost” pour les console next gen c’est le SSD. C’est la seule ressource qui va progresser ces prochaines années et c’est comme ça que l’ue 5 fonctionne.

Le 10/06/2021 à 19h53

Bon bah j’étais sur le site de Nvidia à 15h avec refresh automatique toutes les 5 secondes. La 3070ti est passé de “Me notifier” à “Plus de stock” directement.

Moi qui comptait remplacer ma 3060ti FE pour sa grande sœur, tant pis.

Cette génération de carte est vraiment virtuelle. Tout le monde en parle, mais personne n’en a. Pour le coup, je rejoins certain commentaire. A quoi ça sert d’en parler et de montrer des tests, vu que de toute façon, c’est impossible d’en avoir sans lâcher 2x le prix.

Bon l’avantage avec la nouvelle référence de GPU qui est la GTX1650, c’est que ça va peut être ralentir la course au pixel, et forcer les studios a optimiser et inventer de nouveaux jeux plutôt que de parier sur la perf brut.

Le 11/06/2021 à 05h06

A ce stade, les seules cartes nouvelles générations disponibles sont les AMD RX 6700 XT. Les prix sont délirants. Quand je pense que le 27/07/2016, j’avais acheté ma Nvidia 1060 379 €TTC !! Ça fait réfléchir.

Si AMD Fidelity FX démontre des premiers résultats encourageants, vue le support des carte AMD sous linux, l’ indisponibilité des cartes nvidia, elle pourrait remplacer ma 1060 qui commence à souffrir. A voir ce que donneront les 6600 et si il y a du stock. Finalement entre une 3060 Ti et 3070, pour conso éngertique inférieure, amd tient le pavé..

C’est vraiment frustrant cette pénurie qui perdure depuis si longtemps. Mais entre le “cloud Gaming”, l’IA et les cryptos monnaies, les voitures autonomes, on est pas prêt de retrouver une situation normale.

En attendant, je vais amortir ma 1060 sous ETS2, The witcher 3. Je reste virtuellement en 2016 ;-)

Le 11/06/2021 à 06h07

Comme déjà dit, ce n’est pas tant une question de dispo que ça. Tout le stock part aux prix affichés, dans le cas de la 6700XT, c’est surtout qu’il n’y a pas grand monde à dépenser 1000 euros pour un tel produit. Le stock actuel partira ou pas à ce prix, si ce n’est pas le cas les prix baisseront, on verra. Mais tous les modèles sont touchés de la même manière par le problème, chez AMD et NVIDIA. Ce sera sans doute la même chose pour les RX 660 quand AMD aura décidé de les annoncer (hors gamme Pro).

Pour “Fidelity FX” je suppose que tu parles de FSR (FFX n’est pas une technologie en particulier, c’est la marque qui regroupe plusieurs solutions logicielles chez AMD). Ne compte pas trop dessus pour le moment, comme dit dans l’article dédié, ce sera un support très limité au départ (et pas garanti que ça fonctionne sous Linux d’ailleurs, hors cas comme Proton/DLSS). AMD n’a pas précisé si Vulkan faisait partie des API supportées par FSR ou pas pour le moment.

Le 11/06/2021 à 06h32

De mes premières recherches rapide, un seul modèle de 3070Ti dans la gamme de prix citée de l’article et le reste à 1000€+.

Ma première pensée fut : Go fuck yourself.

On verra quand le marché aura retrouvé sa raison, si tant est que ça arrive un jour.

Le 11/06/2021 à 17h39

Je pense que Nvidia et AMD vont se prendre une hué générale à l’annonce des prochains GPU.

Alors tant mieux pour eux si les mineurs leur achètent tout leur stock x% plus cher, et sans demander de garantie à la fin. Mais pour la partie gaming, exactement du même avis que toi: GFY.

Comme je le disais avant, si ca peut faire bouger les studio de dev a faire des jeux moins gourmand/mieux optimisé, ca leur fera une belle jambe d’avoir des GPU surpuissant qui ne seront plus autant nécessaire.

On verra ce que ca va donner avec Intel et Apple qui je pense, ont une carte à jouer. Si ca pouvait foutre un coup à Nvidia et AMD, j’en serait bien heureux.

Le 11/06/2021 à 19h20

Sauf erreur de ma part, cette technique existe déjà (et a supplanté le LoD il y a de nombreuses années). Par contre, de ce que tu me dis, c’est à priori plus efficace.

Mais malgré cette optimisation à priori intéressante, ce n’est pas le seul facteur qui va solliciter les ressources.

Bien sûr, on fait des bécanes plus puissantes qu’une console, même next-gen (à 500 balles, on peut pas non plus s’attendre à un avion de chasse, malgré la subvention des constructeurs).

Ce que je voulais dire par là, c’est que l’ancienne génération à considérablement ralenti la gourmandise des moteurs graphiques (en tout cas, pour les jeux multi plate formes, soit une écrasante majorité).

Ce n’est pas un hasard si nos PC gamers ont rarement aussi bien vieillis, et que même une config d’il y a 3⁄4 ans comme la mienne fait encore tourner honorablement à peu près tout, en 1080p/60fps et avec des taquets graphiques assez élevés.

La next-gen étant présente, je pense simplement que la config minimale PC va se prendre un gros lvl up sur les jeux à venir qui exploiteront les capacités des nouvelles consoles.

Et que de fait, une 1080 comme la mienne va bien plus montrer ses limites dans les 1 ou 2 ans à venir, que ça n’a été le cas jusqu’à présent.

Le 12/06/2021 à 07h29

Apple utilise les mêmes usines qu’AMD, et un GPU ce n’est pas un SoC mobile à produire. Même si AMD allait sur ce marché (spoiler, non), ils feraient face à la même problématique. Comme déjà dit, les soucis d’approvisionnement ne sont pas spécifiques à deux acteurs ou même à un marché.

Le 13/06/2021 à 19h42

Le marché des GPU n’a rien à voir avec les autres. Il y a des pénuries dans plusieurs secteurs, mais celui des GPU éclate tous les sommets. C’est simple, il n’y a aucune carte graphique disponible chez les revendeurs, et sur le marché du scalp, c’est minimum x2.

Pour avoir une idée du vrai tarif actuel, voilà les ventes terminées des RTX: https://www.ebay.fr/sch/i.html?_from=R40&_nkw=rtx3070ti&_sacat=0&rt=nc&LH_Sold=1&LH_Complete=1

Je ne suis clairement pas objectif car en recherche d’une RTX3070ti, mais publier un test de RTX, c’est comme publier un guide d’achat sur les avions de chasses. C’est juste impossible d’en acheter.

Le 14/06/2021 à 04h46

Non, il s’en vend régulièrement chez les revendeurs, mais il y en a moins à vendre que d’acheteurs, parce que comme sur le reste du marché, la situation est tendue (mais plus sur le marché des GPU oui, pour les diverses raisons qu’on a déjà évoqué 50x). Le fait de ne pas réussir à en acheter à titre personnel ne donne pas droit de dire n’importe quoi (et de dénigrer nos articles au passage).

Le 14/06/2021 à 20h21

Je ne dénigre par l’article, que j’ai lu, comme quasiment tout les articles d’IH, car excellent, précis et inédit (dans le sens ou ça n’est pas du copier/coller d’ailleurs).

Je peste contre le fait qu’on a plein de site de news et de youtubeurs tech qui testent la 3070ti FE presque comme si ne rien était. Alors que certain se goinfre, msi, asus, ldlc? Ou va le pognon, qui se gave? On n’en entend pas parler.

Tu as beau dire ce que tu veux sur la dispo des cartes graphiques, mais les 3070ti FE, j’en ai vu uniquement chez les journalistes et youtubeurs. Pour avoir 2 pages autorefresh 5s sur le site de nvidia lors de la sortie, je te garantie que les 3070ti FE sont passé de “Notifier moi” à “Rupture de stock”.

Donc je suis désolé, mais quand nvidia nous sort des 3070ti à 619€, c’est du mensonge car impossible à acheter.

Pour info, les 3070ti sont actuellement disponible sous 15j entre 1199€ et 1599€ sur materiel.net (+fdp), soit au minimum 1,9x le MSRP, soit au même prix que les scalpeurs sur ebay.

Le 15/06/2021 à 04h06

Comme déjà dit, regarde les comptes twitter de revendeurs, justement pour couper court à ce genre de remarques, ils publient régulièrement des photos de clients qui reçoivent leurs cartes. Mais oui, comme dit, comme il y a plus de demande que d’offre, les prix sont bien plus élevés que le MSRP.

Le 15/06/2021 à 06h43

Le 15/06/2021 à 15h54

Les 3070 TI FE n’ont pas été vendus en France ni UK.

J’ai refresh sans arret la page et c est passé direct à plus de stock. Aucune carte mise en vente sur ebay ou autre et personne n’a signalé l’avoir acheté sur les réseaux sociaux contrairement aux autres éditions FE.

Un point important révélé par IH c est le LHR sur la FE.

Nul part j’avais lu cette information et au contraire le consensus était qu’elle ne serait pas bridée.

Il serait intéressant de savoir pourquoi elles n’ont pas été vendues comme annoncé en France.

Le 15/06/2021 à 15h57

Non, on a rien révélé du tout, comme dit, NVIDIA n’avait jamais dit que les FE ne seraient pas bridées. Certains ont fantasmé ça ou mal compris et comme souvent c’est devenu une info. Mais sur le fond, la règle à toujours été la même.

Le 15/06/2021 à 16h17

Citation de Nvidia:

Une Founders Edition est une carte graphique de production limitée vendue au Prix de vente conseillé (…) et pour le moment, nous n’avons pas l’intention de créer des versions avec LHR

Je pense que le commun des mortels non coutumiers du langage de politicien a compris de travers et que si on interroge des gamers/techos 90% diront que les FE ne sont pas bridé contrairement aux LHR …. alors oui je parle de révélation pour ma part.

Le 15/06/2021 à 16h25

Oui, comme dit, certains n’ont pas compris (ou pas voulu comprendre) parce qu’ils ont lu sans réfléchir (enfin en partant du principe que ta citation de NVIDIA est correcte). NVIDIA dit qu’il n’y a pas de version LHR de ses FE, et c’est vrai, je ne dis rien d’autre d’ailleurs. Pour rappel, il y a deux cas :

NVIDIA dit juste qu’il n’y aura pas, dans le second cas, de modèle LHR des cartes déjà mises sur le marché en founders edition (donc des 3060 Ti, 3070, 3080, 3090). Par contre, comme toutes les autres cartes 3060, 3070 Ti et 3080 Ti, le GPU intègre un limiteur, il est actif, il n’y a pas de distinction LHR dans le nom parce qu’elle n’est pas nécessaire.