La Chine ne partage plus les performances de ses meilleurs supercalculateurs

Super

Getty Images & Unsplash+

Après avoir dépassé le nombre de supercalculateurs des États-Unis, en 2017, puis en avoir répertorié jusqu'à 226, en 2020, la Chine n'en dénombre plus que 80 cette année au classement Top500 des supercalculateurs les plus rapides du monde. En réponse aux restrictions dont elle fait l'objet, Pékin chercherait ainsi à empêcher les États-Unis de pouvoir mesurer ses capacités de calcul.

Le 29 juillet à 12h30

6 min

Hardware

Hardware

La Chine a cessé de participer au Top500 des supercalculateurs les plus rapides du monde, relève le Wall Street Journal. Le dernier classement, publié mi-juin et qui classe en tête trois ordinateurs états-uniens, ne reflèteraient dès lors plus l'état de l'art en la matière.

« Les Chinois ont des machines plus rapides », explique Jack Dongarra, cofondateur de Top500, « mais ils n'ont pas communiqué leurs résultats ». Plusieurs analystes, interrogés par le WSJ, pensent que la Chine craint que les États-Unis n'en profitent pour durcir leurs restrictions en matière d'importations :

« Selon eux, il serait difficile pour la Chine de maintenir son avance en matière de supercalculateurs sans les puces de pointe, dont beaucoup sont fabriquées par NVIDIA, le leader de la Silicon Valley. Sans ces puces, la Chine devrait recourir à une solution de force brute en assemblant des centaines de milliers de puces d'ancienne génération qui consomment beaucoup d'énergie. »

En 2015, les États-Unis avaient en effet réduit l'accès des développeurs chinois de superordinateurs aux puces Intel et à d'autres matériels. Quatre ans plus tard, l'administration Trump avait placé cinq organisations chinoises de supercalculateurs sur une liste noire, au motif qu'elles utilisaient des supercalculateurs à des fins militaires et nucléaires, rappelle le WSJ. Depuis, l'administration Biden a continué à renforcer ses entraves et restrictions à l'exportation.

- La pression américaine monte encore d’un cran contre le Chinois Huawei

- Guerre froide technologique : la Chine bannit AMD, Intel et Windows de ses administrations

Après avoir battu les États-Unis, la Chine ne veut plus participer

Le Top500 est né en 1993, lorsque Dongarra (professeur à l'université du Tennessee) et des collègues allemands distribuèrent un problème mathématique à des superordinateurs. Ils classèrent ensuite les machines en fonction du temps qu'elles mettaient à le résoudre.

Pendant plus de deux décennies, les machines américaines dominèrent le classement, publié deux fois par an à partir des données partagées par les équipes en charge des supercalculateurs. Jusqu'à ce que, en novembre 2017, la Chine répertorie 202 machines sur la liste, contre 143 pour les États-Unis.

« Ce fut un tournant majeur », explique M. Dongarra. Après s'en être initialement félicité, la Chine commença à moins participer. Interrogés à ce sujet, des collègues chinois lui ont répondu qu'ils n'étaient plus autorisés à soumettre des informations, se souvient M. Dongarra.

Et ce, d'autant que les derniers modèles chinois utilisent des processeurs produits dans le pays, depuis que ceux d'Intel, NVIDIA et d'autres sociétés américaines sont moins accessibles.

Au Top500, la Chine est passée de 226 supercalculateurs à 80

En mai 2023, Top500 relevait déjà que « les États-Unis ont augmenté leur avance en passant de 126 machines sur la dernière liste à 150 sur celle-ci, tandis que la Chine est passée de 162 systèmes à 134 ».

« Une fois de plus, la Chine et les États-Unis sont les pays qui ont obtenu le plus grand nombre d'entrées sur l'ensemble de la liste Top500 », souligne le communiqué associé au classement de juin 2024. Il note cela dit que le nombre de machines enregistrées par la Chine a depuis été divisé par deux :

« Les États-Unis ont ajouté 7 systèmes par rapport à la liste précédente, ce qui porte leur nombre total de systèmes à 168. La Chine a une fois de plus réduit son nombre de machines représentatives sur la liste, passant de 104 à 80 systèmes. En fait, la Chine n'a pas signalé une seule nouvelle machine pour cette nouvelle liste. »

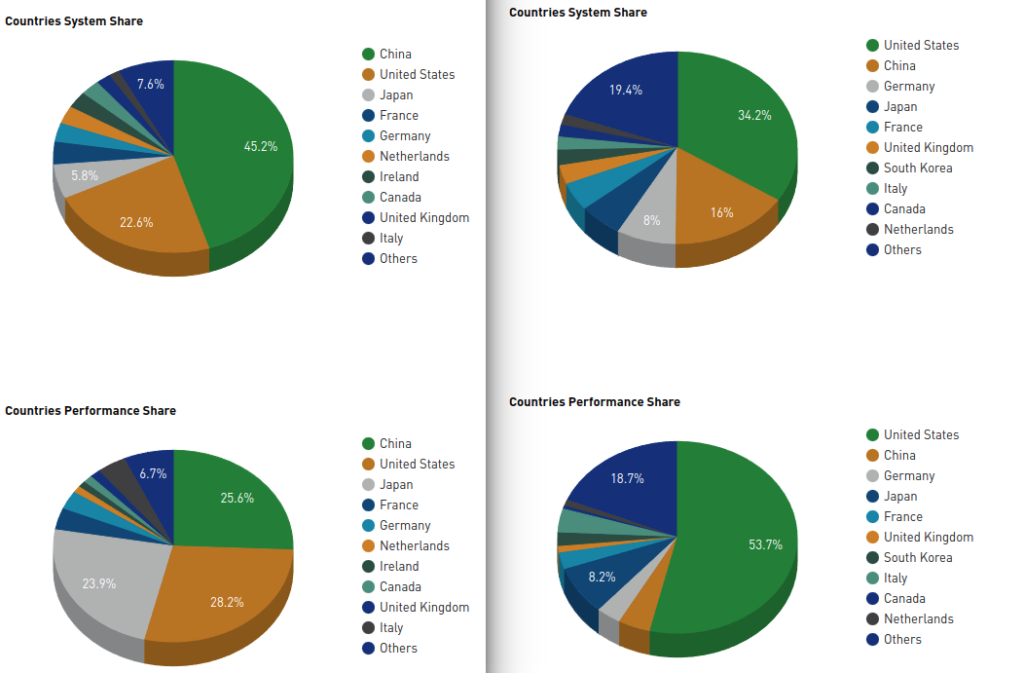

En juin 2020, les statistiques du Top500 dénombraient 226 supercalculateurs chinois (soit 45,2 % du total), contre 113 états-uniens (22,6 %). En termes de performances, la Chine représentait 25,6 % du total, les États-Unis 28,2.

En juin 2024, les 80 machines chinoises ne représentaient plus que 16 % du total, contre 34 % pour les 171 supercalculateurs états-uniens. Leurs performances sont respectivement passées à 4,3 et 53,7 % du total.

Un supercalculateur avec 42 millions de cœurs

« Officiellement », souligne le WSJ, l'ordinateur le plus rapide du Top500 se trouve au laboratoire national d'Oak Ridge, dans le Tennessee, sous l'égide du ministère de l'Énergie. Frontier, qui figure en tête du classement depuis son lancement en 2021, « a la taille de deux courts de tennis » et sa construction a coûté 600 millions de dollars. Sa facture d'électricité s'élève à « environ 20 millions de dollars par an », précise M. Dongarra, qui travaille également à Oak Ridge.

M. Dongarra estime cela dit que Frontier n'est probablement pas le superordinateur le plus rapide du monde. Il ajoute qu'une cinquantaine de superordinateurs, dont certains appartenant à des services de renseignement, figureraient dans le Top500 si leurs propriétaires étaient autorisés à y participer, et donc à transmettre des données sur leurs capacités, résume le WSJ :

« Des articles scientifiques suggèrent que certaines machines chinoises sont meilleures. L'une d'entre elles a été désignée dans les médias d'État comme le prototype Tianhe-3, d'après un terme chinois désignant la Voie lactée, tandis que l'autre est un modèle de la série de superordinateurs Sunway. »

Dans un article scientifique présenté l'an passé pour le prix Gordon Bell de l'Association for Computing Machinery, les « Oscars des supercalculateurs ». Sunway était présenté comme ayant 42 millions de cœurs, soit quatre fois plus que le nombre de cœurs dont dispose Frontier, laissant supposer qu'il pourrait être plus puissant que celui qui figure pourtant en tête du classement Top500. Ce dernier avait déjà présenté les prototypes des machines Tianhe-3 et Sunway en 2018, affirmant qu’ils étaient « maintenant opérationnels, selon les médias locaux ».

De plus, si la Chine dispose de son propre classement, le HPC Top100, les supercalculateurs les plus puissants n'y sont décrits qu'en termes génériques, sans qu'un nom ou une institution d'exploitation ne soient indiqués. M. Dongarra pense en outre que sa liste ne tenait pas compte des principaux superordinateurs chinois.

Pour mesurer les avancées des scientifiques chinois, il tente alors d'assister à leurs conférences, et de poser des questions, comme il s'en explique au WSJ : « C'est en quelque sorte ma méthode de vérification : lorsque je leur parle, il est clair qu'ils disposent d'une telle machine », en référence aux supercalculateurs qui seraient, selon lui, encore plus puissants que ceux du TOP500.

Le 29 juillet à 12h30

La Chine ne partage plus les performances de ses meilleurs supercalculateurs

-

Après avoir battu les États-Unis, la Chine ne veut plus participer

-

Au Top500, la Chine est passée de 226 supercalculateurs à 80

-

Un supercalculateur avec 42 millions de cœurs

Commentaires (16)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 29/07/2024 à 13h31

#1

Modifié le 29/07/2024 à 17h21

#2

Cela n'intéresse en fait que les politiques, les ingénieurs top-niveau et les organismes d'espionnage / surveillance, et enfin les scientifiques.

(EDIT: et, peut-être, certaines administrations (ex. : INSEE), qui peuvent louer du temps partagé en fonction des besoins...)

Tata Lucette s'en bât l'oeil et le mollet, de ces super-machins auxquels elle n'aura jamais accès, même pas en rêve.

Le 29/07/2024 à 19h33

#2.1

Ces machines hors-sol utilisent des processeurs communs (e.g., Adastra est basé sur de l'EPYC, Pangea sur du Xeon E5) et les paramètres que tu évoques (e.g., efficacité conso, puissances...) sont des critères importants aussi dans les supercalculateurs.

Vu le coût de conception et de fabrication d'un processeur, les constructeurs essayent de toucher tout les terrains à la fois avec une même micro-architecture. Et comme l'x86-64 est maintenant extrêmement répandu...

La consommation d'un centre de calculs, c'est pas uniquement le supercalculateur en lui-même c'est aussi les clims pour maintenir cette bestiole à bonnes températures de fonctionnement. Et ce coût n'est pas négligeable.

Ces machines ne sont pas hors-sol. Leur puissance n'est rarement pas pour un seul usage et par une seule entité réduite. Ces machines sont conçus pour disposer d'une puissance de calculs phénoménales pour différents usages et pour être utilisés par plein de monde et de différents domaines.

Les politiques ne s’intéresse pas à ce genre de sujets, sauf pour se faire mousser par les mass merdia ! As-tu vu un politique au chevet de la recherche scientifique ? Moi non. As-tu vu un politique comprendre les enjeux du numérique ? Non plus. As-tu vu un politique comprendre le fonctionnement de base d'un ordinateur ou d'Internet ? Non plus. Ils ne pigent rien à ses sujets et donc ils s'en foutent. Surtout qu'électoralement, c'est pas ce qui va faire qu'un scientifique ira mettre son bulletin dans l'urne pour lui.

Ce qu'on leur demande, c'est juste de signer le bon pour achat.

Tata Lucette ne sait même pas ce qu'est un super-calculateur et à quoi ça peut lui servir. Pourtant Tata Lucette est bien contente lorsqu' elle entendant à BFM TV qu'une équipe de recherche à trouver un nouveau médicament pour soigner telle maladie. Tata Lucette est bien content que les supercalculateurs servent à lui mettre de l'essence dans son réservoir (l'exploration pétrolière demande de grandes quantités de calculs pour le traitement des signaux). Tata Lucette est bien contente de ne pas se faire passer dessus par une armée étrangère parce que les supercalculateurs servent à la dissuasion nucléaire et à la modernisation de l'armée française (e.g., simulation de la signature radar d'un avion).

Bref Tata Lucette fera mieux d'aller éteindre sa TV et d'aller lire Next Inpact. Même si elle ne verra jamais un supercalculateur de sa vie, au moins elle sera à quoi ça sert dans son quotidien.

PS : Pour Tata Lucette :elle peut visiter gratuitement le supercalculateur Japonais Fugaku depuis chez elle, sans prendre l'avion.

Modifié le 29/07/2024 à 21h05

#2.1.1

Tout cela évidemment demande une énorme puissance de calcul mais surtout une rapidité de réaction sans précédent... Les autres usages, je pense que tout le monde les connaît : météo, impôts, statistiques... J'ai bien sûr déjà mentionné la recherche scientifique, mais...

...Quel est l'intérêt véritable du Top 500 ? C'est quoi, des JO du computing ? Ça nous apporte quoi, concrètement ? Surtout sachant le secret nécessaire qui entoure ces hyper-machins, lorsqu'ils sont utilisés à des fins stratégiques et / ou politiques ?

Oui, savoir que des gens de savoir ont découvert une solution à long terme contre le SIDA, ça fait du bien, ça donne de l'espoir aux malades et à leur entourage, bref c'est juste génial ! Les découvertes scientifiques en général, c'est admirable et édifiant, ça nous fait avancer, même si c'est seulement d'un mm, pour moi c'est déjà très bien !

Autre exemple : lorsque le CERN a débusqué le Boson de Higgs, il y a eu en même temps des infos techniques sur le GRID, un réseau de calculateurs finalement assez classique que nos ami.e.s les physicienn.e.s ont utilisé pour accomplir le boulot... Tu vois la différence entre les deux ?

Dans ce dernier exemple, nous avons une application éclatante de la puissance de calcul pour une (re)découverte / confirmation incontestable du modèle standard de la Physique Quantique, avec en cerise sur le gâteau pour les geeks que nous sommes, une description étonnement précise du matos, du réseau et des protocoles utilisés.

Du côté du Top 500, tu as un concours de celui qui pisse le plus loin, sachant que certaines données sont invérifiables (cf l'article) : ça m'étonnerait fort (fort lointain

Et même en admettant qu'un accès exceptionnel à distance soit possible à des fins de vérification, il est toujours possible de truquer des données / résultats de calculs dont on ne connaîtra jamais la provenance précise... On peut toujours pré-calculer un résultat, lorsqu'on connaît d'avance l'énoncé précis d'un problème de maths, etc...

Bref de la grosse baudruche politique / stratégique, qui ressemble de façon troublante à un énoncé de l'armement nucléaire que posséderaient (toujours mettre le conditionnel, en vrai on saura jamais) l'une ou l'autre superpuissance...

« Méfie-toi ! j'ai de gros cigares qui peuvent t'exploser à la figure et faire de gros, gros dégâts !

- Pfff, billevesées et calembredaines ! Regarde cet énoooorme... porte-truc de cent dix mètres de long ! Ça c'est de la bonne came, ça te fait disparaître des villes de la taille de New-York en dix fois moins de temps qu'il ne me faut pour le dire !

- Et si tu te mettait ton truc de 110 mètres là où est sa vraie place ?

- Malotrou ! Bachibouzouk ! Je vais te faire manger tes fusées en forme de cigare ! »

Voilà, en vrai, ou à peu près, comment le Top500 est fait.

...Ben quoi ?

Le 29/07/2024 à 23h47

#2.1.2

Je vois par ailleurs à tes élucubrations sur la triche éventuelle qu'au fond, tu n'as aucune idée de comment la performance Linpack est mesurée. Le problème n'est pas connu à l'avance, puisqu'il est généré de façon aléatoire.

Le 30/07/2024 à 05h50

#2.1.3

Un exemple : la plupart de ces super-calculateurs ne sont pas en accès direct, mais uniquement interrogés à distance.

Qu'est-ce qui m'empêche de réaliser un groupement de super calculateurs situés à des endroits différents, et de te faire croire que les résultats viennent tous du même endroit ?

Je peux très bien te faire croire que mon SC a passé l'épreuve Linpack avec seulement 5000 processeurs, alors qu'en fait j'en ai employé 10 000. Avec les technos actuelles je peux très bien simuler le nombre de procs.

Peux-tu me prouver que tu es capable de détecter toute forme de tricherie, sachant que tu n'as pas un accès physique au bâtiment contenant mes serveurs ? Et même ainsi, qu'est-ce qui m'empêche d'interconnecter discrètement mon SC à d'autres SC, et de te faire croire que je dispose de bien plus de puissance et de capacité que celle physiquement présente dans un lieu donné ?

Le 30/07/2024 à 10h13

#2.1.4

D'abord, le Boson de Higgs, c'est de la physique des particules et pas de la physique quantique (même si la séparation n'est pas aussi franche).

Et non je ne vois pas la différence entre GRID et le Top500. Les deux protocoles sont connues, le matériel également. Éventuellement, le CERN est plus pédagogue en simplifiant le discours pour les non-experts et en concentrant l'information en un même point.

Comme l'a dit @alex.d. le Top500 ce n'est pas destiné au grand public. Cependant, il ne tient qu'à toi de faire l'effort d'aller chercher les infos et de les comprendre. Et je t'assure c'est moins violent que les démonstrations théoriques du Boson de Higgs.

Je reconnais que le Top500 a un petit coté kikimètre, oui ça s'est vrai. Suffit de voir comment les américains ont mal digéré la pilule japonaise Fugaku

Mais le Top 500 permet également de faire des statistiques et est une source interessante pour les personnes (chercheurs comme amateurs) qui veulent retracer l'évolution de l'informatique et de l'évolution de la puissance de calcul.

Pour la partie LinPack. LinPack est un bench reposant sur la résolution d'un système matricielle dense carrée de la forme Ax=b. Il est utilisé car ce type de calculs est représentatifs des calculs effectués dans une simulation numérique. Mais ce n'est pas parfait. Il en existe d'autre tests.

L’intérêt du LinPack est de vérifier expérimentalement l'écart entre puissance de calculs théoriques du supercalculateur et la réalité. Ce genre de test ne sert pas uniquement au Top500 mais il permet aussi de vérifier que le supercalculateur fonctionne bien.

Par aléatoire, @alex.d. entend que la matrice A et le vecteur b ne sont pas connus à l'avance.

Pour ce que tu dis qui ressemble à du délire de complotiste. Mais je vais prendre le temps de te répondre. La résolution d'un système matricielle via LinPack fait appel à un algorithme parfaitement connu et publié dans le monde entier. En outre, en connaissance la taille de la matrice A, on peut calculer précisément le nombres d'opérations flottantes nécessaire pour le résoudre (polynome de degré 3). Si quelqu'un s'amuse à tricher on verra vite un écart entre ce qui est prédit et ce qui est attendu.

Non tu peux pas simuler tes coeurs avec les technos actuelles sur du calculs de ce type. LinPack pour atteindre les performances maximales demandent d'être correctement optimisé pour la micro-architecture des processeurs cibles, et nottament en saturant constamment le pipeline du front-end du CPU et du back-end du CPU et de ses unités flottantes. Ce genre de calculs, si c'était si trivial pour les fabricants de CPU, ça ferait longtemps qu'on aurait des processeurs dédiées à cette tâche dans le monde des supercalculateurs et des enthousiates.

LinPack ne permet pas de détecter toute les formes de tricheries. Mais d'autres benchmark existent et son utilisé pour tester les performances de la machine, mais ausis pour diagnostiquer des anomalies. Et l'interconnexion se mesure également. Alors, tu peux bien brancher ton supercalculateur à un autre supercalculateur secret, mais lors de la publication des résultats avec que tu as construit ça se verra que ça ne colle pas. Et l'excuse du "oui mais une techno secrète..." ça ne tient pas la réalité du marché industrielle et technologique à l'échelle de Frontier.

Dernier point pour la tricherie, ces bestioles ne sont pas construites par des états mais par des boites privées (e.g., HPE, Eviden, Fujitsu...). Si ces boites s'amusent à mentir, elles se feront vite découvrir et elles perdront de juteux marchés. Et ça, ce n'est pas dans leur intérêt. Surtout qu'on achète pas un supercalculateur tout les jours.

Juste pour te donner un ordre de grandeur. Une connexion "classique" (et encore je pense qu'il se fait mieux maintenant, mais la flemme de chercher) pour interconnecter un supercalculateur c'est du 100 Gb/s . En négligeant le payload de la communication, 100 Gb -> 12.5 Go. Quelle est la dimension (le n de tout à l'heure) d'une matrice carrée dense stocké sur du FP64 pour représenter 12.5 Go de données ? ça te fait une matrice d'environ 39528x39528. ça peut te paraître énorme mais pour des modèles de météos, de simulations de galaxies ou autres, je t'assure que c'est petit.

Le 30/07/2024 à 19h08

#2.1.5

Qu'est-ce qui t'empêche d'utiliser des noeuds ailleurs ? En vrai, rien. Mais si tu vas plus vite pour du Linpack sur une grille de calcul que sur un supercalculateur, tu seras le premier au monde, donc ne perd pas ton temps à falsifier une entrée Top500 qui ne rapporte rien et postule direct au prix Gordon Bell (qui lui, a une récompense financière).

Modifié le 31/07/2024 à 11h27

#2.1.6

Secundo, pour ce qui est de tricher sur le nombre réel de processeurs physiques, je me suis basé sur le fait qu'il existe depuis un moment des technos sophistiquées de VM à base d'Hyperviseur.

Si j'ai bien tout compris (corrigez-moi si trompette !), lorsque tu démarres ton bousin, l'hyperviseur prends le relais à un très bas niveau, et peut simuler X nombres de machines incluant X nombre de processeurs avec X Go de RAM, etc...

C'est cela que j'appelle "simulation" (manifestement un terme impropre, désolé...). Puis-je régler un hyperviseur de façon à ce qu'il "prétende" avoir 4999 machines dispo, alors qu'il n'y a en fait que 3990 machines physiques dans ma salle, le reste étant situé ailleurs ?

(Là, si j'ai bien tout compris, on peut détecter la tricherie en examinant le timing des opérations, du fait qu'une connexion même optique entre deux SC distants sera toujours plus lente que la même connexion optique entre deux racks physiquement présents... Si je ne m'abuse ?)

....Ou le contraire : Puis-je prétendre, en réglant finement l'hyperviseur, avoir "seulement" 3990 machines, alors que j'en ai en réel 4990 ?

Là je me base sur mon expérience du Hackintosh : aux tous débuts de cette aventure, on pouvait se servir de PearPC pour "simuler" un processeur PowerPC et faire croire à OSX Tiger qu'il était lancé sur un vrai Mac...

S'il est possible de "simuler" un PowerPC (ses instructions, son jeu de données...), ne serait-il pas possible de "simuler" un bon vieux Intel ou AMD x86 ?

Exemple : "réunir" quatre processeurs x86, et grâce mon couple "hyperviseur + émulateur" , prétendre qu'il n'y a qu'un seul processeur physique...

EDIT : En partant de l'hypothèse que mon émulateur est "parfait" et réagit exactement comme le ferait un proc x86 physique Cela me parait aller de soi, mais cela va mieux en le disant... Enfin je crois...

Et lorsque je parle de "simulation", ou encore de "tricherie", je ne pointe pas du doigt les constructeurs / architectes / concepteurs, pas du tout même, mais plutôt les utilisateurs "étatiques" qui pourraient avoir un intérêt - politique ou stratégique - de mentir (en positif ou en négatif) sur leurs capacités de calcul réelles.

Je sais, tout cela n'est qu'hypothétiques hypothèses, rêves éveillés de béotien qui se complet dans son costume d'ignorance en queue-de-pie....

Le 31/07/2024 à 17h49

#2.1.8

Enfin, même si c'était possible, ça voudrait dire qu'une ressource virtuelle qui n'a plus de tâche de calcul laisse sa place à une autre et donc ce n'est pas simultané. Donc ça se verra dans les résultats.

Enfin, rajouter une couche d'hypervision pour gérer du calcul, je ne sais pas si c'est pertinent, car ça doit rajouter une couche intermédiaire de traitement.

Autant avoir un système dédié qui alloue les ressources matérielles du cluster HPC directement. Mais je ne sais pas comment c'est fait en vrai.

Le 31/07/2024 à 19h01

#2.1.10

En pratique, ça simplifie l'administration, l'usage des ressources (mouais, pas convaincu) et la sécurité (possiblement utile, mais je n'ai jamais envoyé un exécutable directement au calculateur).

Quand à l'impact sur les performances, je n'ai pas de chiffres :(

Le 31/07/2024 à 18h58

#2.1.9

Ces unités sont en nombres assez limités, tu peux les voir dans les slides sur l'article de Next à propos de Zen5. Cherche des mots-clés comme FMA, FADD, FDIV. Et comme tu vas le constater, elles ne sont pas en nombres importants, et ça virtuellement tu ne peux en émuler plus sauf à sacrifier de la performance, ce qui n'est pas le but.

Là, si j'ai bien tout compris, on peut détecter la tricherie en examinant le timing des opérations, du fait qu'une connexion même optique entre deux SC distants sera toujours plus lente que la même connexion optique entre deux racks physiquement présents... Si je ne m'abuse ?)

Oui sur ce point, tu as entièrement raison pour deux points. Déjà la latence pour connecter tes deux SC n'est pas anodin. Et ensuite, il faut transférer un sacré volume de données et que ce volume soient réceptionnés sur les différentes machines de ton SC, et enfin que les calculs tournent et que le résultat revienne (même si pour le coup, ça peut rien en volume de données).

Également, les technologiques que l'on utilise pour connecter un SC dépend aussi de la distance. Pour les connections racks à racks ont utilise des connexions extrêmement rapides (faible latence et gros volumes de données), mais ces connectiques sont coûteuse et peuvent avoir des inconvénients. (e.g., InfiniBand et son dégagement de chaleur).

En revanche, tu n'utilises pas les même type de liaison entre différents "block" de rack ou même différentes machines. (Toutes les machines d'un SC ne sont pas dédiés à du calculs, certaines servent aussi au stockage).

Tu peux trouver un exemple ici de topologie réseau.

Pour l'émulation c'est une autre histoire, mais idem à la fin ton processeur réel à un nombre de ressources (unités de calculs) limitées.

Le 31/07/2024 à 22h44

#2.1.11

Quant à tricher avec du cloud, bon courage. Linpack est un code à grain très fin ; avec la latence induite par le cloud, plus tu ajouteras de ressources, moins ça ira vite, donc aucun risque de ce côté. La seule façon d'avoir un bon score Linpack, c'est d'avoir une machine qui atteigne effectivement la performance. Libre à toi de mentir sur les specs de ta machine, mais si tu veux cacher des choses, tu as aussi parfaitement le choix de ne pas participer au Top 500.

Le 31/07/2024 à 12h44

#2.1.7

Bref, avant de dire "Non mais oui mais non .. " ce serait bien de vérifier un minimum.

De plus, dansle TOP500 les données sont publiques et vérifiables.

Modifié le 01/08/2024 à 10h25

#2.1.12

(....et en tant que musicien, la latence de mon système est une donnée extrêmement importante, sachant que la musique sur ordi ce n'est que du calcul en temps réel : les instruments virtuels et effets utilisés (synthés, samplers, reverbs, delais, distortions, compresseurs...) sont autant de formules mathématiques à appliquer aux sons numérisés, et ce le plus vite possible SVP !

Parce que si, entre le moment ou j'enregistre ma note de guitare ou de clavier avec effets et le moment où elle est restituée il s'écoule plus que quelques ms (une dizaine de ms grand maximum), je vais me retrouver décalé par rapport à l'orchestration, elle aussi calculée simultanément en temps réel... Je peux toujours corriger ces micro-retards après coup, mais c'est ch*ant, une vraie perte de temps...)

Même problème pour l'émulation de procs virtuels, on perd du temps pour un avantage douteux. Bref, tout cela n'est pas très malin (Plus aucun doute à ce sujet...

Pour finir un nouveau merci @BlackLightning pour ton exemple de topologie réseau complexe, je vois que certaines parties du système se contentent d'une "simple" liaison 10G, alors que d'autres - les parties critiques - sont en "Infiniband 4X". D'après wikipedia eng, au paragraphe "Specification - Performance", je vois que ce bus optique en version 4X peut aller jusqu'à 1600 Gbit / sec... Wooow... Ça fait rêver...

.

.

. . .

(Du coup je me demande ce que pourrais donner, sur un SC, un projet musical très complexe de type musique de film / de jeu vidéo, avec des centaines de pistes orchestrales + choeurs + une armée de synthés + une palanquée d'effets à n'en plus finir, le tout bien sûr à calculer en temps réel... :bave:

Le 01/08/2024 à 12h33

#2.1.13