Les Copilot+ PC sont là : prise en main de l’IA et explications de Microsoft

Le NPU c’est la vie !

C’est le jour J pour les Copilot+ PC de Microsoft. Il s’agit d’une gamme d’ordinateurs portables avec de l’intelligence artificielle et un NPU pour certaines opérations. Lors d’une présentation de Microsoft, nous avons pu prendre en main une machine et poser des questions à l’éditeur.

Le 18 juin 2024 à 17h07

8 min

IA et algorithmes

IA

Windows on Arm et émulateur Prism

Les Copilot+ PC sont pour le moment tous équipés d’une puce Snapdragon X Plus ou Elite de Qualcomm, avec Windows on Arm. Il est prévu (d‘ici à la fin de l’année) que des machines avec un CPU AMD et Intel (x86) soient également certifiées Copilot+ PC et profitent des nouvelles fonctionnalités via une mise à jour de Windows. Microsoft nous l’a encore confirmé ce matin.

Interrogé sur ce lancement en deux temps, Microsoft reste évasif, mais la tendance de fond semble être que Qualcomm aurait été le plus rapide à répondre à l’appel du père de Windows. Il n’est à priori pas question d’une « exclusivité » temporaire avec Qualcomm, mais d’adapter les fonctionnalités aux puces AMD et Intel en x86.

Un mot d’ailleurs sur Windows on Arm : selon l’éditeur, entre 95 et 98 % des applications sont natives. Les autres passent par un émulateur baptisé Prism. Microsoft met en avant les (très) bonnes performances du système aussi bien en natif qu’en émulation. Mais on voit mal la société dire le contraire.

Dans tous les cas, on nous promet un usage classique, avec un accès à toutes les applications. Le passage de l’intégralité de la gamme des nouvelles Surface sur Arm montre en tout cas que Microsoft croit en cette solution.

C’est quoi un Copilot+ PC ?

Pour être « certifié » Copilot+ PC, un ordinateur doit disposer d’un NPU avec une puissance de calcul de 40 TOPS au minimum. Un GPU, même plus puissant, n’est pas suffisant, car sa consommation sera plus élevée que celle d’un TPU, nous explique Microsoft.

Quant à la barrière de 40 TOPS, elle a été jugée comme suffisante pour les cas d‘usage. Nous avons demandé quelle était la précision associée aux 40 TOPS (INT8, INT16, INT32…) mais n’avons pas eu de réponse pour le moment. Comme expliqué lors du lancement des puces M4 d‘Apple, cette précision est très importante.

Un Copilot+ PC doit aussi avoir au moins 16 Go de mémoire et 250 Go de SSD. Microsoft n’a pas pu nous confirmer s’il devait forcément être en NVMe ou si du S-ATA était possible. Dans tous les cas, il semblerait que Microsoft doive valider une machine avant qu’elle puisse être certifiée Copilot+ PC.

Images Creator et Cocreator pour générer des images

Pour le moment, les fonctionnalités d’IA de Copilot+ mises en avant sont Cocreator, Live Captions, Windows Studio Effects et Recall. La question de cette dernière est vite réglée : le lancement de Recall a été décalé face à la grogne des utilisateurs.

Dans la création et la modification des images, deux programmes sont disponibles pour ce lancement. Images Creator permet de générer une image à partir d’un prompt, comme le ferait un Dall.E ou Copilot par exemple. Avec une différence : tout se passe localement.

Des options permettent de modifier un peu le style, et un curseur laisse plus ou moins de créativité à l’IA. Il est important de jouer avec, les résultats pouvant varier de manière importante. La définition de l’image générée est par contre limitée à 512 x 512 pixels.

Plutôt qu’une longue explication, voici une vidéo :

Dans Paint ensuite, on retrouve Cocreator. Il utilise un croquis ou une image comme base, puis la modifie en fonction de vos demandes (via un prompt).

Pour le moment, seul l’anglais est pris en charge, même si certaines phrases en français sont tout de même reconnues. Cette fois, la définition pour le support de base (image, croquis…) est de 1497 x 998 pixels. Là encore, des options permettent d’avoir des variations sur un même thème.

Là encore, voici une vidéo de la démonstration proposée par Microsoft :

Certaines informations peuvent remonter en ligne, pour vérification

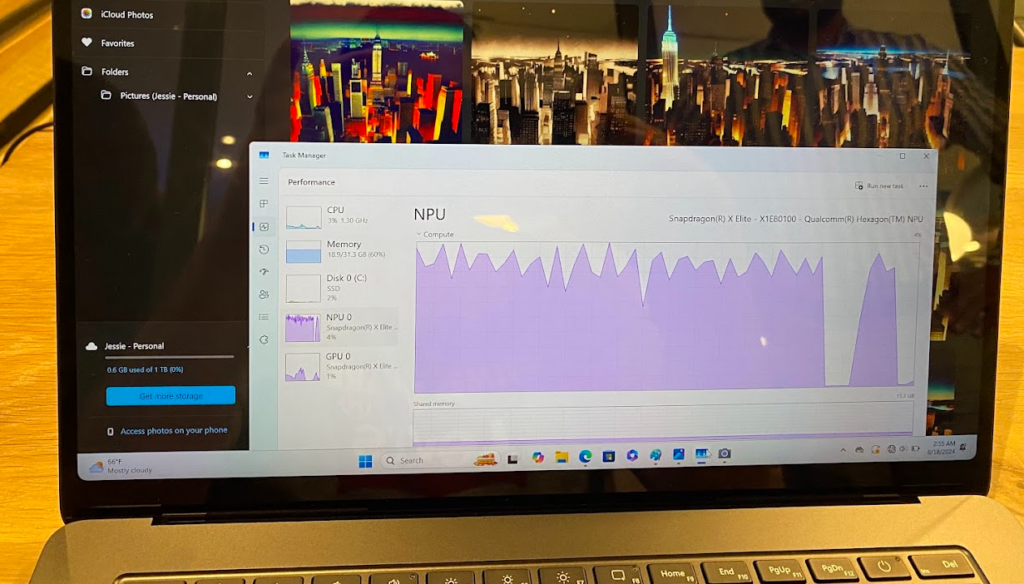

Dans tous les cas, les opérations se font en local via le NPU. Lors des tests, Microsoft expliquait que le CPU et le GPU n’étaient quasiment pas utilisés. On peut le voir dans les graphiques d’utilisation des ressources dans le gestionnaire des tâches.

Une connexion à Internet n’est pas nécessaire. Nous avons d’ailleurs pu générer des images en local sans être connectés à un réseau.

L’IA de Microsoft doit cependant envoyer parfois des informations sur les serveurs de Microsoft. Par exemple, pour vérifier que certains prompts ne vont pas générer des « images inappropriées », qui peuvent donc être violentes, sexuellement explicites, etc.

Des images peuvent aussi remonter sur les serveurs de Microsoft pour « des histoires de copyright ». Mais là encore, les personnes sur place n’avaient pas tous les détails du fonctionnement. Nous n'avons donc pas plus d'informations pour l'instant.

Quid des droits ? Bonne question…

Passons maintenant à la question des droits associés aux images générées par l’IA de Microsoft. La réponse va être courte : Microsoft n’a, là encore, pas toutes les réponses. La ligne actuelle est : « tout ce que vous générez par IA à des fins personnelles, il n’y a aucun souci ». Par contre, « un usage commercial, c’est non ».

Une réponse avec de nombreuses zones d’ombre, notamment pour une éventuelle utilisation sur des réseaux sociaux. Et ce d’autant plus si le compte sert de relai à un site qui génère des revenus (publicités, abonnements…), appartient à un influenceur, etc. Dans tous les cas, Microsoft nous affirme ne jamais récupérer les images créées en local pour ensuite les utiliser pour son compte.

Live Caption : sous-titre et traduction automatiques, en anglais

Passons à Live Caption qui, comme son nom l’indique, propose des sous-titres automatiques sur des vidéos et/ou de l’audio, toujours avec un traitement local des données.

44 langues sont supportées en « entrée » avec une traduction automatique dans une petite poignée de langues seulement pour l’instant : anglais, chinois et chinois simplifié. Le français arrivera plus tard, sans autre précision.

Live Caption fonctionne aussi avec les micros de l’ordinateur portable pour de la traduction lors d’une conférence, par exemple. Il n’est pas encore question de lire le texte traduit à haute voix, mais cela pourrait arriver par la suite.

Windows Studio Effects : du flou avec NPU

Windows Studio Effects permet d’ajouter du flou à l‘arrière-plan d’une visioconférence. Cette fonction ne dépend pas de l’application utilisée : Windows récupère directement le flux vidéo de la caméra et le modifie avant de l’envoyer à l’application de visioconférence.

On peut aussi activer le suivi du ou des interlocuteurs afin de les centrer dans la vidéo. Studio Effects permet en outre de laisser les yeux de la personne face à la caméra lorsqu’il regarde son écran ou ses notes, etc. Des fonctions que l’on retrouve déjà sur certaines applications, mais avec ici un traitement local via le NPU intégré, bien moins énergivore qu'un traitement par le CPU ou GPU affirme Microsoft.

Cachez ce Recall que je ne saurais voir

Enfin, pour Windows Recall, on repassera. Aucune démonstration n’était proposée. Microsoft a revu sa copie et va renforcer la sécurité et le respect de la vie privée de son application. Fort heureusement d'ailleurs, car la première version présentée était inquiétante.

Recall sera réservée aux Windows Insider dans un premier temps, sans limitation géographique. Les Insider français pourront en profiter en même temps que les autres à travers le monde. Recall pourra occuper jusqu’à 25 Go sur des SSD de 250 Go avec un historique sur trois mois. Sur des SSD de 500 Go, on peut doubler ces chiffres et les quadrupler sur 1 To, et donc arriver aux alentours d’un an d’historique selon Microsoft.

Les fonctionnalités Copilot+ PC vont s’étendre au fil des mois, via des mises à jour de Windows. Microsoft joue la carte de l’ouverture et les développeurs peuvent intégrer les fonctionnalités d’intelligence artificielle à leur application.

Copilot+ peut se résumer en une phrase : utiliser le NPU pour réduire la consommation (par rapport au CPU et GPU) afin d’augmenter l’autonomie de la machine et de renforcer la confidentialité par un traitement local.

Les Copilot+ PC sont là : prise en main de l’IA et explications de Microsoft

-

Windows on Arm et émulateur Prism

-

C’est quoi un Copilot+ PC ?

-

Images Creator et Cocreator pour générer des images

-

Certaines informations peuvent remonter en ligne, pour vérification

-

Quid des droits ? Bonne question…

-

Live Caption : sous-titre et traduction automatiques, en anglais

-

Windows Studio Effects : du flou avec NPU

-

Cachez ce Recall que je ne saurais voir

Commentaires (13)

Le 18/06/2024 à 23h39

Le 19/06/2024 à 08h30

Le 20/06/2024 à 09h46

Modifié le 19/06/2024 à 07h20

Edit : ça semble bien être du Dall.E 2 (512 x 512) vu que DALL.E 3 (version actuelle) fait du 1024 x 1024 voir du 1792 x 1024

Le 19/06/2024 à 11h19

Donc, je parierai plus sur des modèles allégés, dégraissés, optimisés.

De plus, je ne pense pas que la taille de l'image créée soit un bon critère pour dire si c'est tel ou tel modèle. En effet, je n'ai pas encore regardé les modèles de diffusion en détail, donc je peux me tromper, mais ce type de modèle ne semble pas avoir de problèmes (autre que le temps de calcul et la quantité de mémoire) pour créer des images de taille arbitraire.

Modifié le 19/06/2024 à 18h21

Dans le cas de SD, il génère l'artefact aléatoire de base, le compresse, applique les couches successives de denoise via le scheduler, puis une fois l'itération terminé il décompresse l'image de l'espace latent pour produire le résultat final.

Les algo d'upscalling d'image étant également excellents, il ne sert de toute façon à rien de chercher à produire des tailles supérieures à celles pour lesquelles les modèles ont été optimisés. Il suffit de lui demander ensuite un x2 ou x4.

Perso je travaille sur un format genre 1300x800 (car il me sert à rendre des scènes pour de l'écriture, et faire la couverture du bouquin) et ça donne d'excellents résultats sur une conf de 2018 avec une 1080GTX, un i5 de l'époque (voire plus vieux) et 21GB de RAM.

(PS : me demande pas les concepts mathématiques derrière, kernel panic)

Le 19/06/2024 à 08h56

Modifié le 19/06/2024 à 10h25

Modifié le 19/06/2024 à 13h38

Contrairement aux bécanes d'avant (Windows RT), le gros plus c'est qu'on peut installer ce qu'on veut ou presque et ca fonctionne que ce soit compilé pour ARM ou pas. J'ai une vingtaine d'onglets ouvert dans mon navigateur (chrome désolé, les habitudes tout ca) et ca fonctionne au poil.

Il n'y a que lorsqu'on lance un jeu que le front se met à perler, car une question va arriver vite :"marche" ou "marche pas" ? Ca fait vraiment bizarre de dire qu'"Intel roxxe avec ses IGP" par rapport à ce qui est proposé par Qualcomm.

Le 19/06/2024 à 16h47

Le 19/06/2024 à 18h01

Pour le GPU faut revenir, ça suffit pour le navigateur.

Heureusement que Qualcomm a changé d'avis sur la prise en charge de l'AV1, sur le 7c c'est cata en décodage software.

Le 20/06/2024 à 16h27

Qu'est-ce que ça peut faire à MS, puisque "tout est local" ? Ou alors, je n'ai pas compris...

Le 20/06/2024 à 16h56

Comme ils censurent tous à tout va les images inappropriées, MS ne va pas prendre le risque d'une mauvaise réputation à ce sujet.

Mais, on est bien d'accord sur l'ineptie de cette censure.