Le Forum sur l’information et la démocratie propose de taxer l’IA pour financer la sécurité de l’information

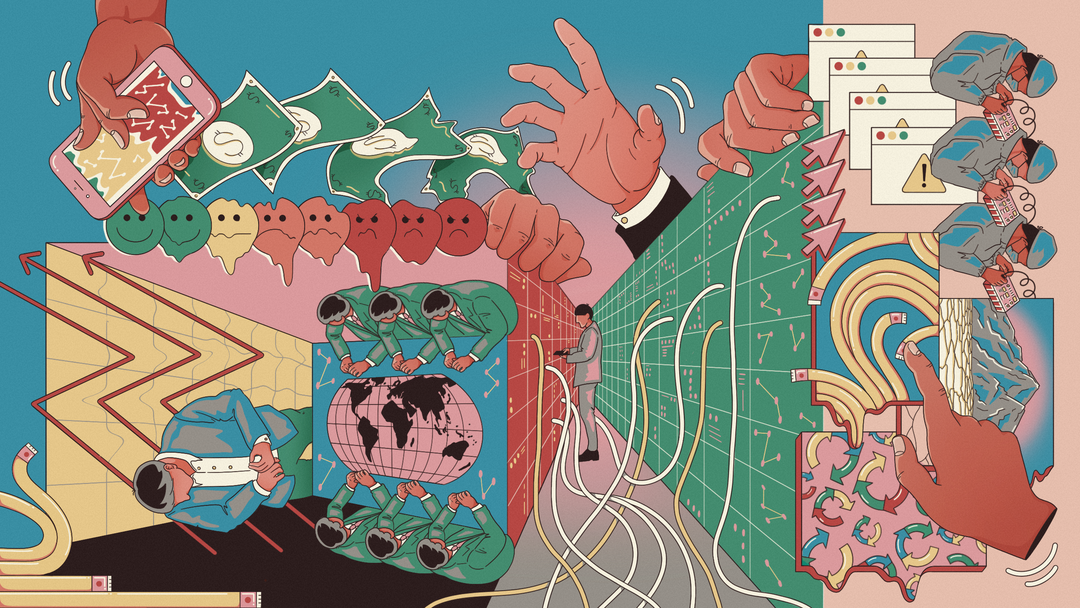

Technology ain't neutral 101

Clarote & AI4Media / Better Images of AI / Power/Profit / CC-BY 4.0

Le Forum sur l’information et la démocratie publie ce 28 février un riche rapport sur les moyens d’assurer le contrôle démocratique de l’IA dans l’espace informationnel. Next y a eu accès en avant-première.

Le 28 février à 14h00

15 min

Économie

Économie

Créer un système de certification des entreprises créatrices de systèmes d’intelligence artificielle (IA) ; créer des règles spécifiques donnant aux médias et aux journalistes le droit de savoir (comment leur contenu est utilisé), le droit de se retirer (opt out) et le droit à une compensation équitable en cas d’utilisation de leurs productions pour l’entraînement de modèles ; taxer les revenus des constructeurs de systèmes d’IA pour financer la sécurisation de l’espace public numérique et l’éducation du grand public au fonctionnement de ces nouvelles technologies…

Telles sont certaines des multiples recommandations formulées par le Forum sur l’information et la démocratie dans le riche rapport de 150 pages qu’il publie ce 28 février. Un projet de plus parmi les multiples travaux en cours à travers la planète pour encadrer l’IA ? Oui et non : auprès de Next, la Policy manager du Forum Katharina Zügel pointe que la plupart des projets de lois et de traités « se penchent sur l’IA au sens large. Avec ce travail-ci, le Forum sur l’information et la Démocratie s’intéresse spécifiquement aux effets de ces technologies sur l’espace informationnel ».

Par ailleurs, le rapport ne se cantonne pas à la question de la régulation, mais propose une approche plus holistique : « on y aborde les questions de réglementations et de gouvernance, mais on y formule aussi des recommandations pour les développeurs et les déployeurs d’IA, on réfléchit à des mécanismes d’incitations pour encourager le déploiement de systèmes éthiques, on s’intéresse au rôle des citoyens, des organisations de la société civile, du monde académique… »

Inclusion, travail de recherche et mécanismes de promotion de la confiance

« Le but du partenariat international sur l’information et la démocratie [lancée en 2019 et signé à ce jour par 52 États] et du Forum qui a été créé pour le mettre en œuvre est de mettre les états en réseau et de réfléchir à des recommandations pour la sauvegarde de l’espace informationnel, rappelle Katharina Zügel. Ceci, dans la mesure où cet espace se transforme très vite, et principalement selon les intérêts d’une poignée d’entreprises privées. »

Intitulé « l’intelligence artificielle comme bien public : assurer le contrôle démocratique de l’IA dans l’espace informationnel », le présent document est le résultat des travaux de son groupe de travail sur l’IA lancé en septembre 2023. Composé de 14 membres juristes, spécialistes de l’IA, des médias, etc, ce dernier s’est aussi appuyé sur l’expertise de 101 personnes interrogées à travers la planète, dont 61, par l’intermédiaire d’organisations spécialisées, plus spécifiquement issues d’Afrique de l’Ouest, d’Amérique latine, d’Afrique du Sud, du Liban et d’Inde.

Il détaille donc les effets de l’IA sur la distribution de l’information, sur sa consommation, ainsi que les effets spécifiques de l’IA générative sur l’espace informationnel. Une variété de sujets qui donne au rapport l’air d’un vade-mecum précis de l’état des réflexions sur les manières de déployer, utiliser et sécuriser l’IA dans l’espace public numérique, au service du plus grand nombre.

Vaste projet, auquel le Forum sur l’Information et la Démocratie propose de s’attaquer selon cinq axes de recommandation. Les premières s’adressent aux entités et entreprises constructrices d’IA, leur enjoignant de créer des systèmes plus inclusifs -« car la question des biais est vraiment énormément revenu dans les discussions », note Katharina Zügel -, et plus fiables, en mettant l’accent sur la transparence et la réduction des risques.

D’autres appellent à la régulation du secteur pour pousser les constructeurs et déployeurs de systèmes d’IA à développer des systèmes « responsables », avec des vérifications de leurs effets sur l’espace public numérique et les populations actuellement discriminées ou sous-représentées avant la mise des systèmes sur le marché.

Certaines recommandations intéressent spécifiquement aux manières de (re)créer de la confiance dans l’espace de l’information : en créant des standards internationaux d’authentification de la provenance des contenus pour faciliter leur identification et la distinction des contenus générés par humains de ceux générés par IA, par exemple. « Nous recommandons la création d’un système de certification inspiré de ce qui existe du côté du commerce équitable, pointe ainsi Katharina Zügel, pour encourager une compétition positive entre créateurs d’IA tout en donnant aux internautes des clés de lecture. »

Le Forum s’attarde ensuite sur la nécessité d’un « régime clair de responsabilité pour les dommages causés dans l’espace informationnel ». Il détaille les effets spécifiques des systèmes de microtargeting, de ceux de génération (qui risquent de produire du faux ou de la mésinformation), ou des systèmes qui risquent plus largement de toucher négativement certaines populations (par exemple dans les cas de promotions de discours de haine). Il détaille enfin, longuement, l’intérêt pour les gouvernements de veiller à la mise en place de mécanismes d’audit et de contrôles indépendants, tant par des autorités indépendantes que par le milieu académique, diverses organisations de la société civile, ou des lanceurs d’alertes.

Génération de contenu, diffusion, consommation : les effets de l’IA sur l’information

Dans leur travail, les rapporteuses Viviana Padelli, Lia Chkhetiani et Kaye Celine Palisoc relèvent trois axes via lesquels l’intelligence artificielle chamboule voire menace l’espace public numérique - autrement qualifié d’ « espace d’information et de communication ».

Le plus récent concerne le champ spécifique des IA génératives. Nous le couvrons régulièrement dans ces pages : aussi efficaces semblent leurs résultats, ces modèles créent quantité de risques pour le droit de la propriété intellectuelle, la protection des données et la vie privée. Par la faible qualité voire les mensonges des contenus qu’ils permettent de créer, ils participent aussi à l’érosion de la confiance dans la qualité des échanges en ligne en général, donc à abîmer le discours public. Pour autant, sous contrôle humain, ils peuvent s’avérer très utiles, y compris pour les médias.

Le second axe concerne la diffusion de l’information. Que ce soit par la modération, la recommandation ou la hiérarchisation (ranking) des contenus, voire par leur génération, les modèles d’IA participent activement à modeler l’accès à l’information.

Parmi les risques que cela provoque : la création de bulles sur certaines thématiques ; la reproduction voire le renforcement de biais ; la désinformation pure, par le biais d’« armées de trolls » et de campagnes d’astroturfing ; le détournement des logiques algorithmiques à des fins de censures ; ou encore l’exploitation des logiques de personnalisations pour « exploiter les peurs et manipuler le comportement » des internautes, de manière dangereuse pour la démocratie. Problème récurrent : les utilisateurs finaux ont très peu de pouvoir face à ces machines, et ne savent pas de quels types d’informations ils sont privés.

Le troisième axe se place du point de vue des internautes, justement, et de la consommation d’information. À l’heure actuelle, note le Forum, il n’existe aucun outil parfaitement fiable pour détecter des contenus synthétiques (générés par IA) et les différencier de production humaine. Par ailleurs, l’hyper-personnalisation que permettent les système algorithmiques « limite l’accès à une information pluraliste, exacerbe la polarisation politique et entrave la construction du discours public ».

L’hégémonie culturelle occidentale (et masculine), un enjeu à part entière

« Les équipes de design et d’ingénierie ont un rôle crucial de première ligne de défense en matière de respect des droits humains », note le rapport du Forum sur l’information et la démocratie, s’appuyant pour cela sur la résolution de l’Assemblée générale des Nations Unies sur la promotion et la protection des droits humains dans le contexte des technologies numériques.

Cette dernière stipule que « les droits humains et les libertés fondamentales doivent être respectés, protégés et promus tout au long du cycle de vie des systèmes d’IA et que les technologies numériques nouvelles et émergentes devraient fournir de nouveaux moyens de promouvoir, de protéger et d’exercer les droits de l’homme et les libertés fondamentales ».

En l’espèce, note le rapport, les constructeurs et déployeurs doivent donc « construire des systèmes d’IA qui servent les valeurs démocratiques et l’intérêt public ». En cela, le document identifie la question des biais comme une « priorité urgente », au risque de perpétuer ou d'accroître des préjugés et d’enfreindre le droit à la non discrimination.

Citant des travaux menés par la chercheuse en IA Abeba Birhane, le document indique par exemple que « la surreprésentation des points de vue occidentaux dans les ensembles de données peut conduire les systèmes d'IA à perpétuer des stéréotypes et à générer des contenus inappropriés ou offensants, en particulier lorsqu’il s'agit de représenter les femmes et les cultures non occidentales, les résultats reflétant souvent des idéologies hyper-sexualisées, misogynes, voire suprémacistes blanches ».

Et de pointer que les systèmes d'IA « ne devraient pas refléter les perspectives des principaux centres technologiques, mais aussi représenter les points de vue et les langues des différentes cultures et communautés de la majorité mondiale ». Le rapport souligne aussi, multiples études à l’appui, qu’il est possible de lutter contre ces mécaniques.

En 2019, une étude de Maarten Sap et plusieurs de ses collègues montrait ainsi un biais de la modération anglophone en défaveur de personnes noires. En cause : une pratique linguistique différente de celle de la population blanche, non prise en compte au moment de l’entraînement de la machine. Résultat : les chercheurs constataient que les tweets écrits en anglais africain-américain avaient deux fois plus de chance d’être étiquetés « offensants » ou « abusifs ». Ils démontraient aussi qu’avec une formation adaptée des annotateurs, le risque de voir émerger ce type de biais contre une forme dialectale de l’anglais était significativement réduit.

Cet exemple permet d’illustrer plusieurs des pistes de recommandations formulées par le Forum sur l’information et la démocratie qui, comme souvent en IA, prêtent une attention toute particulière à la transparence. Il recommande la transparence sur les types des données utilisées lors des entraînement, les choix réalisés dans la constitution de ces bases, sur les moyens alloués à l’étiquetage puis à l’entraînement.

Il recommande de diversifier les équipes chargées de construire les systèmes, d’engager de réelles réflexion sur les enjeux sociopolitiques que les systèmes d’IA posent dans la sphère informationnelle - que ce soit en fonction de questions culturelles, de nuances qui peuvent être perdues lors du passage d’une langue à une autre, etc. Il préconise aussi de mettre en place un réel droit à l’oubli, quand les machines traitent des données personnelles, ou propose encore des solutions très pragmatiques, comme l’ajout de « soft labels » pour prendre en compte la variété d’interprétation possible lors de l’étiquetage humain (pour des modèles destinés à traduire du texte, par exemple, ou à modérer des publications).

Dans les modalités de gouvernance qu’il propose, le rapport met aussi lourdement l’accent sur la nécessaire inclusion d’une variété de profils, aussi bien en fonction des expertises que des origines sociales, culturelles, linguistiques, etc.

L’optimisation, autre problématique d'importance

Le rapport du Forum porte aussi une attention spéciale à la notion d’optimisation qui, dans les espaces d’information, se traduit souvent par la priorisation de l’engagement. Cette réflexion est encore une fois l’occasion de recommander aux entreprises de réaliser un véritable travail de gestion des risques, d’audit, d’étude de l’impact des métriques et objectifs choisis sur l’espace public numérique. Le rapport souligne d’ailleurs la nécessité de prêter une attention particulière aux contenus liés « aux sujets sociaux, aux élections, aux conflits et à la politique en générale » (c’est-à-dire plus ou moins tout ce que Meta a décidé de cesser de promouvoir sur ses plateformes).

Pour les publications qui le permettent, il suggère d’envisager la modification de certaines métriques : par exemple troquer l’engagement de long terme (la durée de l’engagement) à celui de court terme (son intensité, le volume d’interaction à un instant T). Il argumente aussi en faveur des designs de systèmes dont on sait qu’ils permettent de réduire les discours de haine, en mettant l’accent sur la crédibilité de l’information plutôt que sur l’optimisation de l’engagement, par exemple.

Surtout, le rapport enjoint les états de tenir les entités privées responsables de leur usage ou non de ces diverses logiques dans la fabrication de leurs systèmes.

Une taxe pour sécuriser l’espace informationnel

Le Forum sur l’information et la démocratie promeut aussi largement les logiques de coopération et de régulation à l’échelle internationale. Cela permet en effet le partage de ressources et de connaissances au bénéfices des pays moins riches.

Mais cela permettrait aussi d’adresser les risques qui touchent plus spécifiquement la « majorité mondiale », par exemple ajouter aux objectifs d’équité et de justice les problématiques relevant de la discrimination de castes - si ce type de problématique est peu présent dans les pays occidentaux, c’est un sujet de désinformation et de violence numérique à part entière dans des pays comme l’Inde.

D’un point de vue général, il se fait le chantre du travail commun, appelant à faciliter les analyses et contrôles des systèmes par des tiers, et notamment le monde académique. Le Forum recommande aussi en plusieurs endroits de financer les organisations de la société civiles pour leur permettre d’accomplir leur rôle de de contrôle expert.

Et milite pour l’éducation du grand public aux enjeux posés par l’intelligence artificielle, que celle-ci soit faite au sein de et par les entreprises constructrices et déployeuses des systèmes, mais aussi plus largement, à destination du grand public, des gouvernements, des médias, des acteurs juridiques, etc. En pratique, il s’agirait de définir les principes du champ et de ses applications, s’attaquer aux conceptions erronées qui circulent dans la société (sur la présupposée neutralité de l’IA, les risques qu’elle pose, etc), évoquer les biais, les questions de vie privée, etc.

Pour financer tout cela, le Forum propose d’établir une taxe sur les entreprises spécialisées dans l’IA, en lien avec l’effort mené par l’OCDE pour mettre en place un impôt minimum mondial de 15 % sur les entreprises multinationales. Le système pourrait être basé « sur le nombre d’utilisateurs du système, les revenus qu’il produit et sa classification de risque ». S’y ajouterait le montant des amendes pour non conformité.

Le Forum sur l’information et la démocratie propose de taxer l’IA pour financer la sécurité de l’information

-

Inclusion, travail de recherche et mécanismes de promotion de la confiance

-

Génération de contenu, diffusion, consommation : les effets de l’IA sur l’information

-

L’hégémonie culturelle occidentale (et masculine), un enjeu à part entière

-

L’optimisation, autre problématique d’importance

-

Une taxe pour sécuriser l’espace informationnel

Commentaires (1)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 28/02/2024 à 17h16

Donc oui une pratique ayant une contribution sociale négative, polluante, avec un fort potentiel de tromperie avéré, une démonstration de sa capacité à exercer une domination, etc.... doit être sévèrement encadrée (pour ne pas dire interdite tellement elle ne sert qu'à assouvir, dans la façon dont elle est mise en avant aujourd'hui). Il y a bien des modèles sociaux où l'IA générative pourrait avoir une utilité, mais visiblement, c'est pas celle qui attire le venture capital.

Je suis pas certain que taxer les technosolutionistes servent à qqch, par contre. Ils ont beaucoup trop de sous pour que ça leur fasse quelque-chose et leur discours montre aussi une incapacité à remettre en question leur modèle de pensée.

(la remarque raciste et sexiste qui conclue le poste de Myifee ne fait qu'appuyer où ça fait mal : le manque d'éducation des populations privilégiées aux enjeux sociétaux).