Les chercheurs essayent de faire le tri dans la jungle de l’édition scientifique

Predators !

Unsplash

Le mouvement de l'open access a bien évolué depuis ses débuts. Des entreprises d'édition y ont vu leurs intérêts. Au point que de nouvelles dérives pointent le jour. Les communautés de recherche en informatique tentent de réagir en proposant des recommandations pour les éviter.

Le 18 janvier à 11h32

8 min

Sciences et espace

Sciences

De plus en plus d'articles scientifiques sont accessibles dès leur publication. L'année dernière, le baromètre de la science ouverte indiquait que deux tiers des articles publiés en 2021 étaient disponibles en open access fin 2022. Rançon de cette gloire, les éditeurs scientifiques commerciaux n'y ont pas vu une menace pour leur business plan mais plutôt une opportunité.

En utilisant ce qui est appelé dans le milieu le modèle « Gold » ou « auteur- payeur » (c'est -à-dire que les éditeurs font payer les chercheurs qui veulent publier dans leurs revues), certains éditeurs ont utilisé l'open access pour augmenter leurs revenus, souvent au détriment de la qualité des articles scientifiques publiés.

Comme nous l'expliquions l'année dernière, cela a eu pour effet de faire exploser le coût de l'accès ouvert à la recherche française : 31 millions d'euros pour les institutions de recherche françaises en 2020. Mais ce n'est pas la seule conséquence.

À la recherche de nouveaux créneaux éditoriaux

Pour certains éditeurs, l'open access est aussi l'ouverture de nouvelles opportunités et de nouveaux marchés. Par exemple, les éditeurs MDPI, Frontiers et Hindawi, qui étaient jusqu'alors très peu présents dans la publication en sciences mathématiques et informatiques, ont flairé la possibilité de vendre à de nouvelles populations de chercheurs des possibilités de publication. Pourtant, dans ces disciplines, l'utilisation des serveurs de prépublication comme arXiv est bien établie. Et la pratique de la présentation de ses travaux en conférences aussi. Mais à coup de mails commerciaux bien ciblés envers les chercheurs, il faut croire que ces éditeurs arrivent à leurs fins.

En tout cas, ces pratiques deviennent assez courantes pour que le Conseil scientifique de l’Institut des sciences de l'information et de leurs interactions du CNRS et les sections du Conseil national des universités et du Comité national de la recherche scientifique concernées par l'informatique et les mathématiques proposent des recommandations [PDF].

Pour ces instances, « ce modèle, attisé par la mouvance par ailleurs vertueuse de la science ouverte, incite les éditeurs à des pratiques proactives et agressives à l'attention des personnels de la recherche quant à la soumission d'articles, le pilotage d'éditions spéciales, ou la réalisation d'expertises en temps très contraint, au détriment de la qualité ».

Si elles citent aussi ces trois éditeurs ( Frontiers, MDPI et Hindawi) expliquant que ces pratiques sont « notamment connues » de leur part, ces instances expliquent qu'elles « ont été également observées dans un panel bien plus large d'éditeurs. Il est ici inapproprié de résumer le propos à une liste d'éditeurs spécifiques. En effet, de nombreux éditeurs ayant des pratiques de cette nature hébergent par ailleurs des revues de référence pour certaines communautés ».

Elles ajoutent que « le modèle "auteur-payeur" favorise également l'émergence de méga-journaux (tels que IEEE Access, PLOS One, Scientific Reports) qui, même parfois indépendamment du processus d'évaluation qui peut être rigoureux, publient plusieurs dizaines de milliers d'articles par an de par leur politique d'acceptation très libérale ».

Ces trois « méga-journaux » sont pourtant gérés par des institutions qui sont reconnues dans le milieu de la recherche et de l'ingénierie. IEEE access est géré par la très influente association américaine « Institute of Electrical and Electronics Engineers » IEEE. PLOS One est l'un des piliers de l'open access mondial. Quant à Scientific Reports, elle émane de l'éditeur d'une des revues scientifiques les plus connues : Nature.

Ces instances de la recherche françaises font aussi remarquer que « le modèle « auteur-payeur » est aussi présent depuis longtemps dans les conférences scientifiques dont une partie des frais d'inscription (parfois très élevés, surtout quand la conférence est en ligne) cache le paiement de frais de publications ».

Du côté d'Inria, qui a publié des recommandations sur les « éditeurs de la zone grise » l'année dernière, on pointe aussi les numéros « spéciaux » (en anglais, « special issues ») dans lesquels se retrouve « une très grande proportion d’articles publiés » mais qui sont « gérés par des éditeurs externes ». L'institut de recherche en informatique explique que, « par exemple, d’après le site de la revue, Sensors (MDPI) a eu 806 « special issues » avec une date de soumission en 2022, (i.e., plus de deux par jour de l’année), et 1903 nouveaux numéros spéciaux sont actuellement ouverts à la soumission ». Ces « special issues » permettent aux éditeurs de publier des articles à la pelle, d'engranger les frais de publication, tout en protégeant un peu la réputation de leur revue en dédouanant l'équipe d'édition de toute responsabilité.

Bref, ce n'est pas si simple que ça de s'y retrouver dans le monde de l'édition scientifique. Savoir quel éditeur publie n'importe quel texte, lequel incite à la publication ou n'est pas très regardant sur les avancées scientifiques de la recherche et lequel fait un travail toujours sérieux. De plus, cette politique peut évoluer au gré des décisions des « boards » des différents éditeurs.

Identification de pratiques non « conformes à l'esprit de qualité scientifique »

Jusque dans les années 2010, une bonne partie des acteurs de la recherche ne se fiait qu'à un seul chiffre pour évaluer la qualité d'une revue : son « facteur d'impact ». Mais en 2013, le mouvement de l'open science, dans la Déclaration de San Francisco sur l’évaluation de la recherche, mettait à l'index cet indicateur présentant « un certain nombre d’insuffisances bien documentées en tant qu’outil d’évaluation de la recherche ».

Reste que les chercheurs ont besoin d'identifier les éditeurs et revues qui ne sont pas « conformes à l'esprit de qualité scientifique », en clair qui sont les éditeurs « prédateurs ». Les instances de la recherche françaises citées précédemment expliquent que « la présence d'APC [Article Processing Charges ou frais de publication] est l'un des critères potentiellement pertinents, le CNRS recommandant par ailleurs explicitement de refuser de se plier à leur paiement ; d'autres critères incluent des invitations répétées à soumettre un article, un nombre disproportionné d'éditions spéciales, des temps d'expertise très réduits, ou encore des incitations à réaliser des expertises rapides en échange de l'annulation d'APC pour un futur article ».

Tout ceci est clair en théorie. Mais en pratique, de plus en plus d'éditeurs, même sérieux, demandent des frais de publication. C'est le cas, par exemple, de l'Association for Computing Machinery (ACM), un éditeur connu et reconnu en informatique.

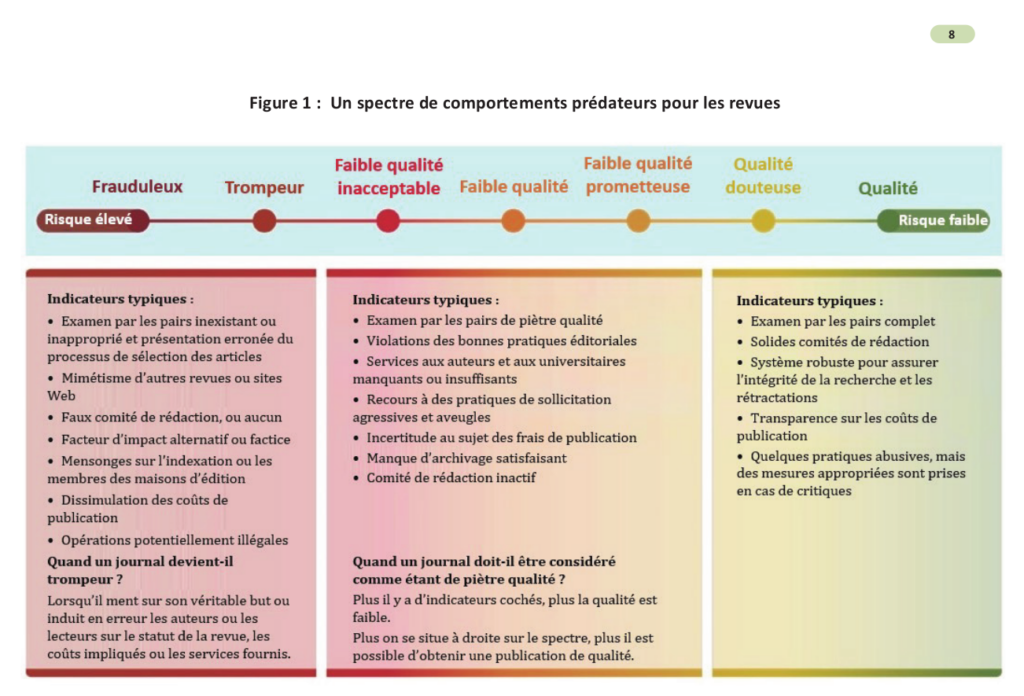

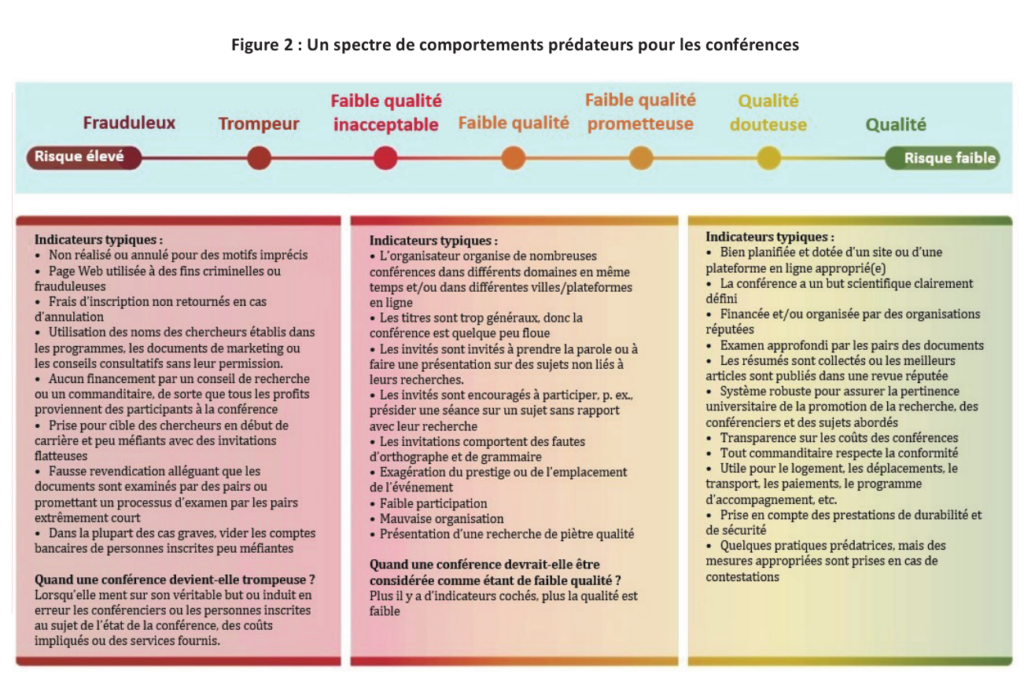

Pour une liste de critères plus complète, ces instances renvoient vers le rapport de l'InterAcademy Partnership et notamment ces « spectres de comportements prédateurs » pour les revues et pour les conférences :

Comment évaluer le travail des chercheurs et chercheuses ?

Cette question de l'évaluation de la qualité des revues dans lesquelles publient les chercheurs et chercheuses se pose notamment quand il s'agit de savoir s'ils font de la « bonne recherche » ou non.

Plutôt que d'évaluer le prestige des revues dans lesquelles ils publient, les instances proposent d'évaluer une sélection d'articles jugés les plus significatifs pour lesquels les chercheurs explicitent « la contribution de chaque publication ».

Mais une liste complète des articles en plus permet de « bien cerner la typologie et l'étendue de l'activité du chercheur ou de la chercheuse, qui se doit d'être prise en considération en complément des articles mis en avant ».

Ces instances scientifiques soulignent aussi qu'il ne faut pas éliminer directement un travail publié par un éditeur considéré comme « prédateur » : « certaines communautés, parfois interdisciplinaires, ont des revues de référence de leurs domaines propres, parfois toujours très sélectives, chez des éditeurs cités pour leurs pratiques prédatrices ».

Vu de l'extérieur, il est souvent compliqué d'évaluer la qualité d'un travail de recherche. Mais, on voit, avec ces « recommandations » pas toujours très nettes, que les chercheurs ont, eux aussi, du mal à évaluer la qualité du travail de leurs collègues sans devoir lire attentivement l'intégralité des articles en question.

Les chercheurs essayent de faire le tri dans la jungle de l’édition scientifique

-

À la recherche de nouveaux créneaux éditoriaux

-

Identification de pratiques non « conformes à l’esprit de qualité scientifique »

-

Comment évaluer le travail des chercheurs et chercheuses ?

Commentaires (12)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 18/01/2024 à 12h49

Concernant l'évaluation du travail scientifique, il n'y a pas de formule miracle. Et je pense que la meilleur reste l'évaluation anonyme par des pairs. Qu'and c'est fait sérieusement.

Depuis des années l'Inserm et le CNRS poussent les chercheurs à publier dans des journaux open access, mais ne prennent pas en charge des frais de publication. Résultat, ça coute des fortunes aux labos, argent qui pourrait être mieux utilisé pour les projets de recherche. Par exemple, publier dans un journal très prestigieux comme Nature peut coûter 4000€! C'est un gros problème...

Modifié le 18/01/2024 à 13h51

https://www.science-ouverte.cnrs.fr/service/publier-en-acces-ouvert/

Le 19/01/2024 à 17h49

Le 28/01/2024 à 23h27

Le 28/01/2024 à 23h27

Le 18/01/2024 à 13h53

Plutôt que d’évaluer le prestige des revues dans lesquelles ils publient, les instances proposent d’évaluer une sélection d’articles jugés les plus significatifs pour lesquels les chercheurs explicitent « la contribution de chaque publication ».

Quand je travaillais dans le milieu de la recherche, c'était déjà le discours officiel mais ce n'était absolument pas mis en pratique. Je ne sais pas si ça a évolué depuis.

Le 18/01/2024 à 13h55

Le 18/01/2024 à 15h43

Modifié le 18/01/2024 à 22h13

https://peercommunityin.org/

Dans beaucoup de domaines (bio, math, numérique), avec un journal généraliste à la Plos One gratuit, tout open de la review à la publication

https://peercommunityin.org/current-pcis/

Voie diamond

Le 19/01/2024 à 15h06

Je lance par ailleurs un appel, si vous connaissez une revue sérieuse, en open access en gestion/informatique/droit informatique/éthique de la donnée avec peer review, reconnue, lue, et qui ne demande rien ou moins de 50 euros de frais pour une publication, je suis preneur.

Le 21/01/2024 à 06h09

Le 21/01/2024 à 19h20