Comment tenter d’identifier les textes émanant d’intelligences artificielles génératives ?

Bullshit 2.0

Le 31 mai 2023 à 14h29

12 min

Société numérique

Société

À mesure que les « générateurs de baratin » (« bullshit », en VO) proposés par les chatbots d'intelligences artificielles génératives prolifèrent, les tactiques, techniques et procédures (TTPs) et outils susceptibles de les identifier commencent à être documentées.

Nico Dekens (@dutch_osintguy) de la société Shadow Dragon vient de publier un guide pratique pour les enquêteurs OSINT afin de lutter contre la désinformation et les faux avis générés par l'IA, et plus particulièrement ChatGPT.

L'auteur explique avoir commencé à réfléchir à l'élaboration de son guide en découvrant, dans un avis posté sur Amazon, l'expression « as an AI language model » (« en tant qu'intelligence artificielle », en français), signe que le commentaire avait très probablement été rédigé par ChatGPT.

Une simple recherche sur l'expression « en tant qu'IA » permet de découvrir plusieurs sites web vraisemblablement écrits, en tout ou partie, par des robots de type ChatGPT, tels que Pollpet.com, dédié aux animaux de compagnie et plus particulièrement aux porcs domestiques, et au sujet desquels l'IA a moult fois halluciné, aidée en cela par le double signification du mot « cochon ».

Les IA génératives utilisent en effet ce genre d'expressions lorsque des utilisateurs font une erreur dans leurs prompts, leur demandent des choses qui violent leurs conditions générales d'utilisation, ou qu'elles ne peuvent pas faire.

Nico Dekens a donc entrepris de répertorier ce type de messages d'erreur et de réponses-types qui, sans prétendre à l'exhaustivité, sont autant d'indices permettant d'identifier des contenus émanant potentiellement d'IA génératives, et que nous avons traduits en français :

| as an AI language model not a recognized word cannot provide a phrase with the given words violates OpenAI’s content policy. I’m sorry, I cannot generate The message you submitted An error occurred. If this issue persists please contact us through our help center at Something went wrong, please try reloading the conversation. I’m sorry, but I cannot fulfill this request Thank you for starting it |

en tant qu'intelligence artificielle/qu'IA, je |

Ces expressions-types peuvent sembler inoffensives à première vue, mais tout texte ayant recours à de telles expressions devrait a priori être traité avec suspicion.

Quels sont les principaux messages d'erreurs de ChatGPT ?

En réponse à la question « quels sont les principaux messages d'erreurs de ChatGPT ? », le chatbot d'OpenAI répond qu' « en tant qu'IA, je peux générer différents types de messages d'erreur lorsqu'une demande invalide ou ambiguë est formulée. Voici quelques-uns des principaux messages d'erreur que vous pourriez rencontrer lors de l'interaction avec ChatGPT » :

- « Désolé, je ne peux pas effectuer cette tâche » : Ce message d'erreur indique que la demande spécifique est en dehors de mes capacités ou restrictions actuelles. Je peux rencontrer cette erreur lorsque la demande implique des tâches complexes qui nécessitent des informations supplémentaires ou des fonctionnalités spécifiques qui ne sont pas prises en charge.

- « Je ne comprends pas » ou « Pouvez-vous reformuler votre demande ? » : Ces messages d'erreur apparaissent lorsque la demande est ambiguë, incomplète ou mal formulée. Je peux demander des clarifications supplémentaires ou une reformulation pour mieux comprendre la demande et fournir une réponse précise.

- « Désolé, je ne suis pas autorisé à fournir cette information » : Ce message indique que je ne suis pas autorisé à divulguer certaines informations, telles que des détails personnels, des données confidentielles ou des informations sensibles.

- « Je ne peux pas accéder à Internet » : Ce message d'erreur apparaît lorsque la connexion Internet n'est pas disponible pour ChatGPT. Dans de tels cas, je ne peux pas accéder à des informations en temps réel ou fournir des réponses qui nécessitent une recherche en ligne.

Ces messages d'erreur sont des exemples courants, mais il est possible qu'il y en ait d'autres en fonction du contexte spécifique de la demande et des limitations du modèle.

Les IA ne peuvent pas fournir de contenu offensant ou inapproprié

Nous lui avons donc demandé quels étaient les principaux autres messages d'erreurs plus spécifiques, à quoi ChatGPT a répondu :

- « La réponse est en dehors de ma base de connaissances » : Ce message indique que la demande concerne un domaine de connaissances ou un sujet spécifique qui dépasse ma base de connaissances.

- « Je ne peux pas exécuter de code ou d'instructions » : Ce message apparaît lorsque la demande implique l'exécution de code informatique ou d'instructions qui nécessitent une interaction en dehors de ma fonctionnalité de génération de texte.

- « Je ne peux pas fournir d'informations médicales ou de conseils juridiques » : Ce message d'erreur indique que je ne suis pas autorisé à donner des conseils médicaux spécifiques, à diagnostiquer des problèmes de santé ou à fournir des conseils juridiques précis.

- « Je ne peux pas fournir de contenu offensant ou inapproprié » : Ce message indique que je suis programmé pour respecter des normes éthiques strictes et ne pas générer de contenu offensant, préjudiciable ou inapproprié. Si une demande est contraire à ces directives, je ne serai pas en mesure de fournir une réponse.

La traque aux contenus artificiels

S'il est, à ce jour en tout cas, peu probable statistiquement parlant de tomber fortuitement sur de telles mentions, on peut par contre s'en servir de manière proactive pour aller débusquer les faux comptes.

Le guide explique ainsi comment utiliser les opérateurs de recherche avancée pour essayer d'identifier des faux-nez sur Facebook (inurl:facebook.com/profile, afin de cibler les profils n'ayant pas renseigné de pseudo) ou Amazon (site:amazon.com intitle:"customer reviews"), par exemple.

Par défaut, on ajoutera comme opérateur de recherche « -chatgpt -gpt » (entre autres termes associés aux chatbots) afin d'exclure les textes mentionnant explicitement les réponses apportées par les IA, et qui sont bien plus nombreux que les faux nez, à ce jour en tout cas, au vu du nombre d'articles, billets et commentaires cherchant à décrire, voire décrypter les réponses apportées par ce genre d'IA. Nos recherches montrent par ailleurs qu'on en trouve bien plus en anglais qu'en français, à ce stade.

Reste que, et comme le guide de Shadow Dragon le décrit en détails, ce type de mentions « suspectes » permet de découvrir des profils dont les autres messages pourraient sembler légitimes, mais dont l'examen révèle d'autres « tics de langage » potentiellement révélateurs, tels que la répétition de mots ou expressions tels que « additionally », « overall », « in addition » ou « Highly recommended! ».

En soi, ces expressions ne semblent pas particulièrement suspectes. A contrario, leur récurrence, dans plusieurs des avis postés sur Amazon, laisseraient entendre que les contenus pourraient émaner de ChatGPT. L'auteur du guide a donc demandé au chatbot d'OpenAI de rédiger un avis au sujet de l'un des produits soi-disant évalués par le profil suspect et retrouvé des expressions en tout point similaires, confirmant le caractère artificiel du commentaire.

|

|

En cas de suspicion, il conviendra donc de tenter de générer un texte (ou une image) ressemblant à celui dont il est question, et de comparer pour identifier d'éventuelles similarités.

Des limites des outils de détection

Il existe par ailleurs de plus en plus d'outils, payants ou gratuits, censés détecter les textes générés par des IA (cf cette liste de 22 outils, ou ce comparatif qui en mentionne 30). Mais ils ne semblent avoir été entraînés – et donc ne pouvoir fonctionner – que sur des textes écrits en anglais. Pire : la façon qu'ils ont de présenter les résultats laissent entendre que leurs calculs de probabilité seraient (quasi-)infaillibles, à la manière du « solutionnisme technologique ».

Ils ont en effet pour la plupart failli à identifier le texte que nous leur avons soumis, et qui avait été généré par OpenAI en français, tout en affirmant à tort que la probabilité qu'il ait été écrit par une IA était de 1 à 25,6 %, ou qu'il l'avait été par un humain de 97 à 100 %...

|

|

|

|

A contrario, Draft & Goal, ZeroGPT, Copyleaks, Compilatio, Originality.ai, Scribbr ainsi que le classificateur de texte d'OpenAI, ont reconnu le texte en français comme ayant été généré par une IA. OpenAI précise pourtant que son classificateur « est susceptible de se tromper sur des textes écrits par des enfants et sur des textes qui ne sont pas en anglais, car il a été principalement formé sur des contenus en anglais écrits par des adultes ».

Lors de son lancement, en janvier, OpenAI recommandait dès lors de ne l'utiliser que sur des textes en anglais, et précisait en outre que son classificateur était « très peu fiable » sur des textes courts (inférieurs à 1 000 caractères).

OpenAI expliquait que leurs évaluations, effectuées sur un set de textes anglais, montraient que leur classificateur identifiait correctement 26 % des textes écrits par une IA comme « probablement écrit par l'IA » (vrais positifs), tout en étiquetant incorrectement 9 % des textes écrits par l'homme comme écrit par l'IA (faux positifs).

Ce genre d'outils, susceptible de proliférer au vu de l'explosion en cours des IA génératives, est bien évidemment amené à évoluer, mais ne saurait suffire à établir qu'un contenu émane bel et bien d'un être humain. Et encore moins à en vérifier la véracité.

Et ce, d'autant qu'ils renverraient de nombreux « faux positifs » : plusieurs outils ont ainsi estimés que des textes aussi génériques que la Génèse de la Bible ou la Constitution américaine avaient été générés par des intelligences artificielles génératives, et de nombreux étudiants se plaignent, a contrario, d'être accusés à tort d'avoir utilisé des IA.

Des outils comme ByPassGPT proposent, en outre, d'« humaniser » les textes générés par des AI de sorte de les rendre « 100 % indétectables » comme tels, mais également de contourner les filtres anti-spam, passer au travers des détecteurs de plagiat, d'éliminer les erreurs de grammaire, de syntaxe, de ponctuation et d'orthographe, et d'obtenir un « contenu IA indétectable qui capture l'essence de la créativité humaine, suscite l'intérêt et stimule l'engagement ».

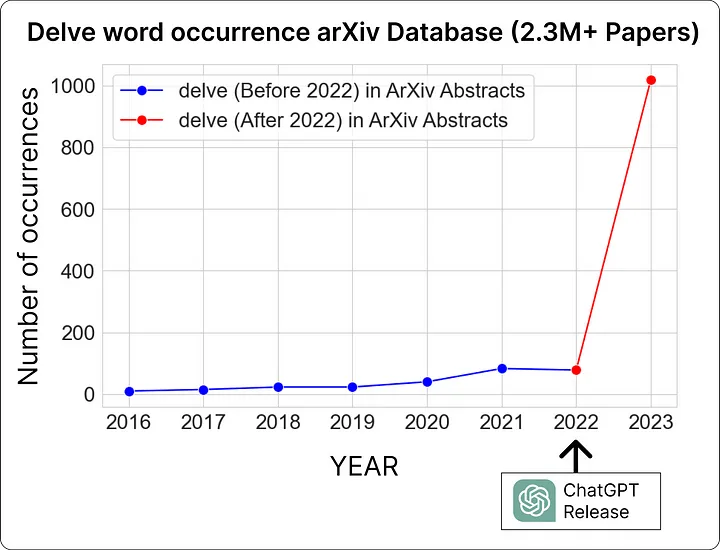

Le chercheur Fareed Khan a d'autre part répertorié une liste de plus de 70 mots dont l'usage a explosé depuis l'apparition de ChatGPT, tels que delve (délivrer, dont l'usage a explosé de + 654 % dans les publications scientifiques), intricacies (intrications), exemplify (exemplifier) ou culmination, et propose un outil pour détecter ces mots-clefs (en anglais).

Une chose est d'identifier les « cinq W » (pour « Who, What, Where, When, Why ? », ou QQOQCCP, pour « Qui ? Quoi ? Où ? Quand ? Comment ? Combien ? Pourquoi ? ») qui constituent le b.a.-ba du journalisme et de la vérification des faits, une autre est de pouvoir en vérifier la véracité : un contenu généré par une IA peut être tout à fait vérifiable, et avéré, et ce n'est pas parce qu'une information émane d'un être humain qu'elle est pour autant authentique.

Il n'en reste pas moins que, et contrairement à ce que laissent penser ces tampons « 100 % human-generated content » ou « human-made probability for AI is 1 % », il ne s'agit jamais que de « calculs de probabilités », qui ne jaugent surtout que les contenus en anglais, et comportent en outre leurs lots de « faux positifs » et de « faux négatifs ».

Vous avez identifié d'autres tactiques, techniques et procédures (TTP) ou outils permettant d'identifier ce type de contenus émanant d'IA génératives ? N'hésitez pas à les partager en commentaires, ou en contactant l'auteur de cet article (@manhack). Nous reviendrons dans un second article sur les TTP de détection des images générées par des IA :

MàJ, 2/5/2024 : rajout de la liste des mots-clefs particulièrement prisés par ChatGPT et autres LLM.

Comment tenter d’identifier les textes émanant d’intelligences artificielles génératives ?

-

Quels sont les principaux messages d'erreurs de ChatGPT ?

-

Les IA ne peuvent pas fournir de contenu offensant ou inapproprié

-

La traque aux contenus artificiels

-

Des limites des outils de détection

Commentaires (10)

Le 31/05/2023 à 14h44

Ce faisant, est-ce qu’on ne participe pas à améliorer la dissimulation des futurs contenus générés par IA ?

C’est le problème de rendre public les méthodes de détection. Ca permet aux autres d’améliorer leur méthode de dissimulation.

Le 31/05/2023 à 15h14

Open Source VS boîte noire : ça fait une 20aine d’années que je fais de l’OSINT et que je raconte comment telles ou telles erreurs m’ont permis de faire telles ou telles découvertes ; et s’il m’est arrivé de voir certaines sources se tarir (la DGSE a cessé de partager son catalogue de stages, par ex.), c’est l’exception qui confirme la règle, qui est que le principal problème est entre la chaise et le clavier (PEBCAK), et que la majeure partie de ceux qui font des erreurs ne prennent pas le temps d’apprendre à ne pas en faire…

Le 31/05/2023 à 15h56

Le problème que je vois pointer, c’est que les IA sont des outils qui peuvent palier à cette nonchalance humaine.

En 2023, des humains très compétents vont mettre beaucoup d’effort pour alimenter le web avec des articles/commentaires sur les techniques de détection d’IA.

Et en 2024, un pebcak nonchalant va simplement demander au dernier chatgpt sorti: “comment détecter un texte généré par une IA ?”. Et il obtiendra un assez bon condensé des trucs à faire pour améliorer la dissimulation de ses faux avis amazon.

il y aura p-e meme un post sur reedit avec le prompt qui permet de générer un avis dissimulé: “ecrit un avis sur le produit XYZ sans utiliser les tournures suivantes <>”

Le 01/06/2023 à 05h52

Je ne suis pas sûr que ça soit un problème. Je pense que, au-delà de l’aspect intéressant de l’exercice, identifier qu’un texte provient d’une IA ne sert à rien. Et idem pour les montages photos / vidéos.

Tout ça était déjà possible auparavant. Il suffit de se souvenir de https://fakirpresse.info/moi-journaliste-fantome-au-service-des-lobbies pour voir que la production par un humain n’est pas un critère de qualité. La seule chose qu’on change, c’est le prix : ça devient encore moins cher de générer du pipeau et des images bidonnées. Mais que ça soit bidonné par une IA ou un humain, ça reste juste des articles ou images bidons. Ça fait effectivement une différence pour la vidéo, mais pour le texte ou les photos ce n’était déjà pas très cher.

La période va être un peu compliquée dans les prochains temps, le temps que les gens comprennent qu’une photo ou une vidéo n’a plus aucune valeur de preuve – je pense d’ailleurs que les vendeurs de solutions vidéo de « sécurité » devraient travailler sur des signatures cryptographiques pour authentifier leurs vidéos). Mais après ça, on s’adaptera. Il y aura même peut-être des effets positifs (le chantage à la sextape dans un monde de deepfakes, ça doit marcher beaucoup moins bien…)

Le 01/06/2023 à 07h16

Point de vue à contre courant. Intéressant et plutôt positif.

Le 02/06/2023 à 11h29

Excellent contre-point. Merci pour l’article ! Quand à Olivia Grégoire, c’est étonnant qu’elle ne se soit pas fait allumé par la vraie presse (ou alors j’ai loupé un épisode).

Le 31/05/2023 à 16h36

Pour la partie image, FranceInfo avait aussi fait un guide assez simple et accessible.

Sinon une autre méthode très simple pour le texte : cherchez “Regenerate response”. Certains sont tellement abrutis qu’au lieu d’utiliser le bouton de copie, ils copient/collent le retour incluant le bouton pour obtenir une autre version.

Egalement, l’autre chose qui me le fait repérer rapidement : la tonatlité pompeuse et monotone du texte du fait des bridages “politiquement correct” du modèle.

Le 01/06/2023 à 09h34

Tout les détails sur “en tant que”, ça n’a pas d’intérêt, juste après le texte dit qu’il est une IA… autant chercher ça!

Le 01/06/2023 à 11h55

Sinon ça voudrait dire que les “users stories” dans l’agile sont toutes rédigées par des IA

(la formulation “En tant que Machin, je voudrais gnagnagna” que je trouve horriblement lourde et pas naturelle en français, inspirée du “As a Machin, I would like…” anglais)

Le 02/06/2023 à 12h44

“En tant que” français (qui n’est donc pas une IA ^^), je ne vois aucune problématique “avec les mots donnés”.

serais-tu en train de dire que ce “n’est pas un terme ou un mot couramment utilisé” ?

Dans ce cas, “Je suis désolé, mais je ne peux pas répondre”