Apple Intelligence réclame 7 Go d’espace libre sur les produits compatibles

Le 07 janvier à 10h23

2 min

IA et algorithmes

IA

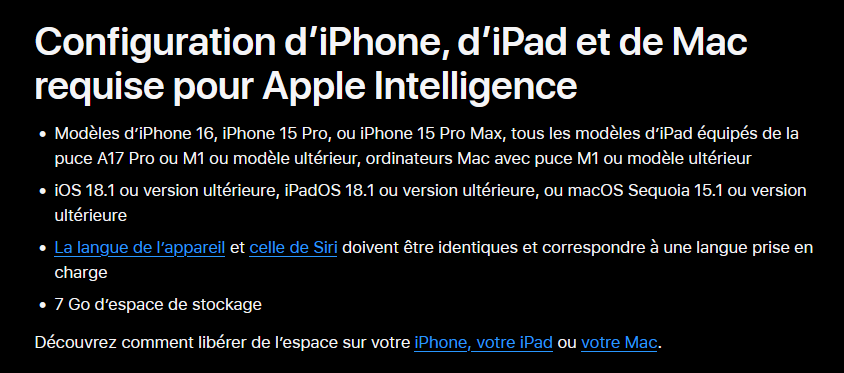

Comme l’ont repéré nos confrères d’iGen, une fiche d’assistance d’Apple a été mise à jour. On y apprend qu’Apple Intelligence, le bouquet de services IA de la société, réclame 7 Go d’espace disponible sur les appareils compatibles, contre 4 Go il y a peu.

Cette augmentation est directement liée au nombre de fonctions. Nos confrères rappellent ainsi que la recommandation officielle était de 4 Go d’espace libre sur iOS 18.1, quand les premières fonctions dopées à l’IA sont sorties. Le passage à 7 Go prend en compte iOS 18.2 et les fonctions supplémentaires, notamment la génération d’images avec Playground.

Il se pourrait ainsi que le besoin en espace continue de croitre avec les versions 18.3 et 18.4. La première est en phase bêta et la deuxième est attendue pour avril, lors du lancement d’Apple Intelligence en Europe.

Or, cette évolution est loin d’être anodine. Selon Apple, la grande majorité des opérations d’IA sont effectuées sur les appareils. En conséquence, les besoins en RAM augmentent (seuls les produits ayant au moins 8 Go fonctionnent), de même que ceux en espace de stockage.

Durant ces derniers mois, Apple a augmenté la quantité de mémoire vive sur ses appareils. Actuellement, aucun appareil mobile vendu n’a moins de 8 Go et tous les Mac ont désormais au moins 16 Go. 7 Go de stockage représentent toutefois un besoin significatif, surtout sur un appareil mobile, en plus des applications, photos et vidéos. Si les Européens ne seront concernés que dans trois mois environ, la question se pose : Apple va-t-elle également fournir plus de stockage dans ses prochaines configurations pour tenir compte des besoins croissants de l’IA ?

Le 07 janvier à 10h23

Commentaires (9)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousHier à 10h28

Hier à 11h20

Quant au besoin en RAM, il est nécessaire uniquement quand le modèle tourne. Sinon, il est déchargé. Il est possible que Apple garde un petit morceau en RAM pour accélérer la latence de prise en compte du prompt, cela dit.

Pour donner une idée, la liste des LLM que j'ai installé sur Ollama :

llama3.1:latest 4.7 GB

phi3:14b 7.9 GB

phi3:3.8b 2.2 GB

mistral:7b 4.1 GB

codellama:13b 7.4 GB

mistral-nemo:latest 7.1 GB

Vu qu'on parle aussi de génération d'image (et donc de reconnaissance, accessoirement), Llama 3.2 avec Vision fait 7.9GB en version 11b params.

(et je viens de le pull, j'avoue n'avoir jamais testé celui-là

Hier à 11h26

On va arriver sur un marché où les flagships seront moins performants que certains milieux de gammes à cause de tout cet ia bullshit forcé partout.

Hier à 12h35

Hier à 13h28

Aujourd'hui à 09h25

Aujourd'hui à 10h51

Hier à 14h00

Hier à 23h56