Les Xeon Scalable de 3e génération passent au 10 nm (Ice Lake-SP), jusqu’à 40 cœurs

Et plein de nouveaux SSD

Le 08 avril 2021 à 07h42

15 min

Hardware

Hardware

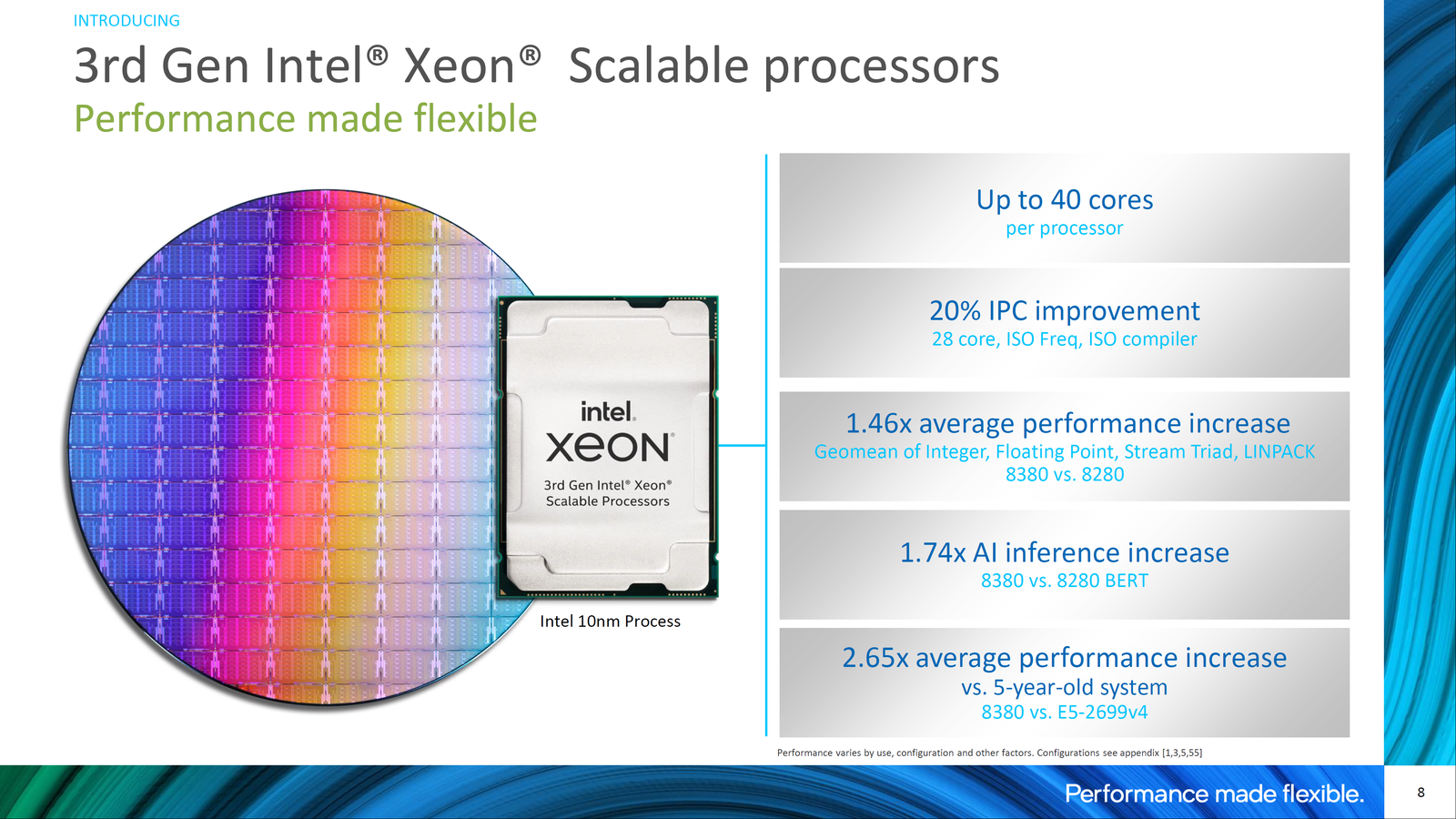

Attendu depuis des mois, Ice Lake-SP est enfin une réalité. Intel officialise ainsi sa première gamme de Xeon gravés en 10 nm, avec de nombreuses améliorations architecturales et un maximum de 40 cœurs. De quoi opposer un peu de résistance à AMD et ses EPYC 7003... en attendant Sapphire Rapids.

Mardi soir, Intel tenait une conférence en ligne pour annoncer ses nouveaux Xeon Scalable de 3e génération, les premiers gravés en 10 nm. Une finesse de gravure déjà utilisée depuis plus de deux ans pour les processeurs destinés aux PC portables. Un choix qui étonne néanmoins, puisque les Core de 11e génération (Rocket Lake-S) n'ont eu droit qu'à du 14 nm. Un process de gravure qui a l'avantage de monter à plus de 5 GHz. Certains y verront aussi l'expression des priorités du fondeur vis-à-vis de ses différents marchés.

Ice Lake-SP, nouveau roi de la densité d'Intel

D'autant qu'Ice Lake-SP, le nom de code de cette gamme, était un challenge technique. Il s'agit en effet d'une puce au design monolithique contenant jusqu'à 40 cœurs. Comprendre qu'il ne s'agit pas, comme pour AMD et ses EPYC, de faire travailler de concert plusieurs chiplets au sein d'un même packaging. Ici, c'est du tout-en-un (hors chipset).

Autre choix étonnant, celui du nom. Car il existe déjà des Xeon Scalable de 3e génération, lancés l'année dernière. Il s'agissait alors de Cooper Lake, gravé en 14 nm avec une architecture de la génération précédente, des puces prévues pour fonctionner sur 4 ou 8 sockets. Autant dire que cela n'avait rien à voir. Et pourtant...

Un choix assez représentatif de la situation dans laquelle se trouve Intel, qui paie encore ses erreurs du passé tout en commençant à regarder vers un avenir que la société espère un peu plus serein. On vous explique tout ça.

Cooper Lake et Ice Lake sont plus cousins que frères, mais après tout, c'est une même famille

Cooper Lake et Ice Lake sont plus cousins que frères, mais après tout, c'est une même famille

Le datacenter du futur selon Intel

On ne peut que vous conseiller de passer outre la présentation faite mardi soir, on y apprend peu de choses. Pat Gelsinger, qui n'était présent que pour sa conclusion, avait laissé les manettes à un Navin Shenoy ayant tout misé sur les interventions de partenaires et autres vidéos promotionnelles, au détriment des détails techniques. La seconde partie, tenue par Lisa Spelman était plus concrète, mais avec là encore un trop plein de marketing.

Le thème récurrent y était la résolution de problèmes (X), oubliant au passage que pour un nombre croissant d'entre eux, ce sont désormais des GPU ou des puces spécialisées qui en ont la charge. Cela tombe bien, Intel propose des accélérateurs sous diverses formes et sa OneAPI pour unifier leur programmation. Mais voilà, aujourd'hui il était principalement question de processeurs Xeon, pas des GPU Xe HPC à venir...

La société s'est néanmoins rattrapée en évoquant sa vision du datacenter de demain : plus petit, mieux distribué sur le territoire, mais aussi dans sa conception, avec la puissance de calcul et le stockage organisés en pools exploitables selon les besoins. Des évolutions déjà en cours chez de nombreux acteurs du marché.

Une manière aussi de nous reparler de la stratégie IDM 2.0 qui vient d'être annoncée, le fondeur se proposant de personnaliser ses processeurs pour un nombre croissant de ses clients. Et l'entreprise de vanter ses partenaires, dont quelques intégrateurs français tels que 2CRSi, Atos, ou Cap Gemini. Ou même Hugging Face côté logiciel.

Ne cherchez par contre pas de CSP bien de chez nous. Du top des acteurs du Cloud, Intel retient surtout des américains (AWS, DigitalOcean, Google, IBM, Microsoft, Oracle) et asiatique (Alibaba, Baïdu, Tencent). On note tout de même la présence de quelques européens : Atnorth (Islande), G-Core Labs (Luxembourg) ou Terra Cloud (Allemagne).

OVHcloud et Scaleway, partenaires de longue date du fondeur en France, apprécieront.

Les partenaires d'Intel pour Ice Lake-SP, peu de CSP européens (à droite), aucun français

Ice Lake-SP, ça change quoi ?

Passons maintenant au (gros) morceau du jour, Ice Lake-SP. Il s'agit donc de processeurs gravés en 10 nm, exploitant jusqu'à 40 cœurs Sunny Cove, prévus pour fonctionner sur 1 ou 2 sockets LGA 4189 (Whitley). Pour rappel, celui-ci était déjà utilisé par Cooper Lake sur 4 ou 8 sockets. On peut y voir la raison de leur nom similaire.

C'est en tous cas le tour de passe-passe qu'Intel a trouvé pour contourner tous les retards et changements de la feuille de route de ses processeurs pour serveurs. Cooper Lake et Ice Lake sont ainsi présentés comme complémentaires, se focalisant chacun sur une part du marché, même si cela n'était pas prévu ainsi au départ.

Ces CPU viennent remplacer Cascade Lake (LGA 3647), lancé il y a deux ans. Un design monolithique qui n'était que de « seulement » 28 cœurs. Ils sont désormais de génération Sunny Cove, qui bénéficiait déjà de 18 % de gain au niveau de son IPC mais est encore en retrait vis-à-vis de la dernière en date (Willow Cove) et donc de Zen 3.

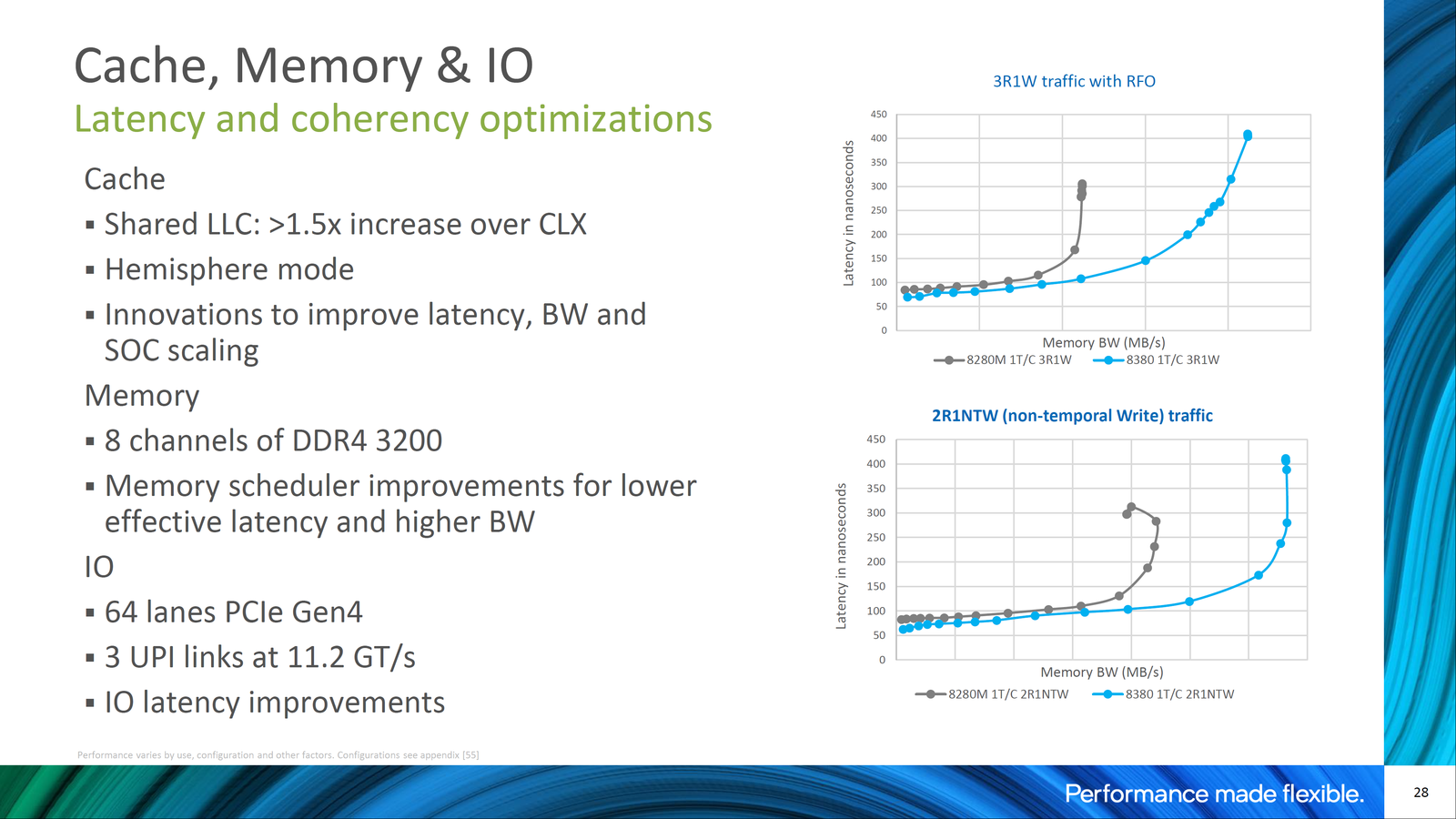

Les améliorations se trouvent également un peu partout ailleurs : des caches plus élevés, 8 canaux de DDR4-3200 plutôt que 6 canaux de DDR4-2933, 64 lignes PCIe 4.0 plutôt que 48 lignes PCIe 3.0, toujours deux ou trois liens UPI mais à 11,2 GT/s plutôt que 10,4 GT/s et de nouvelles instructions d'accélération.

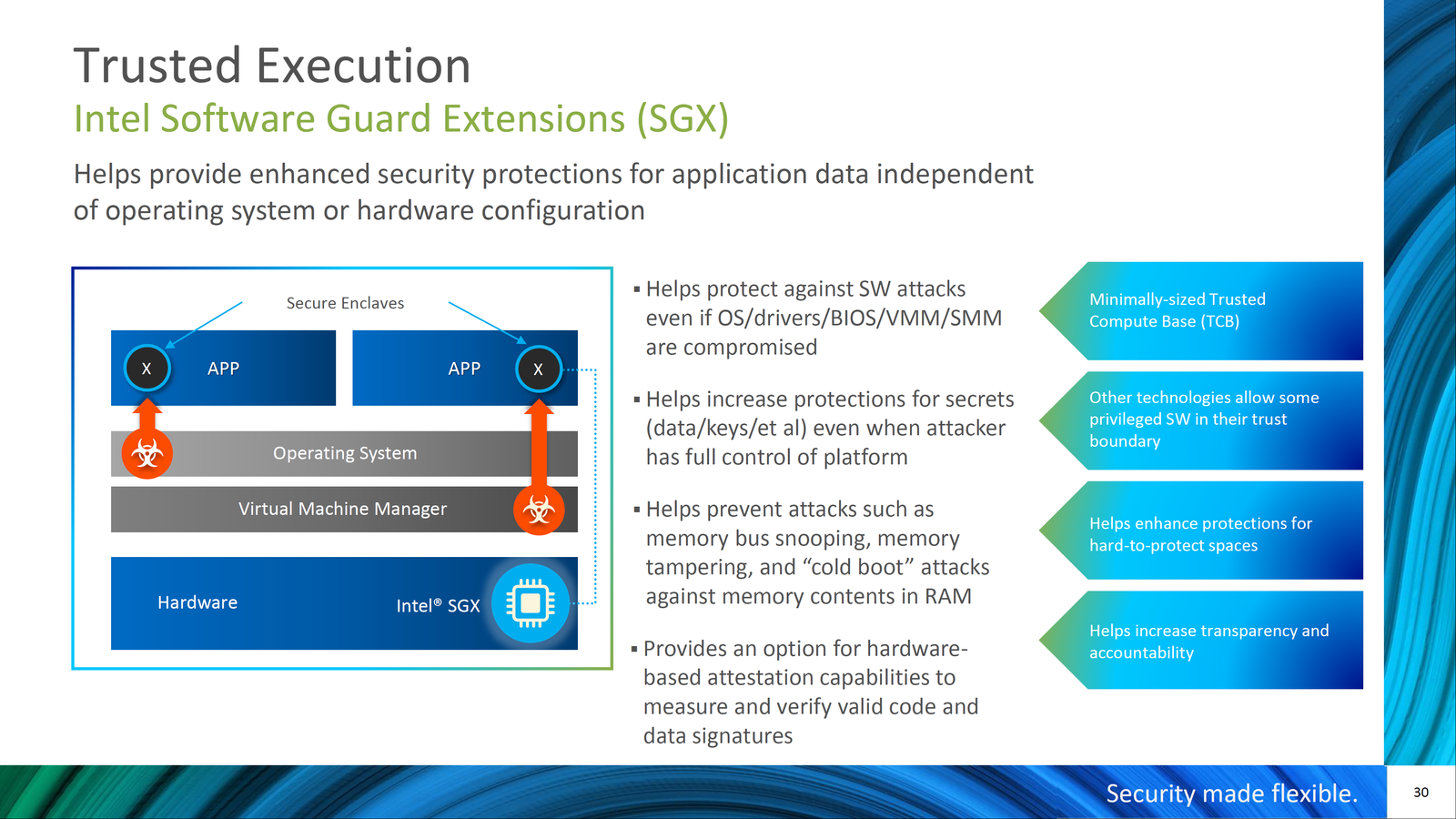

C'est l'un des points sur lesquels Intel appuie, notamment pour le chiffrement, puisque c'est un sujet d'importance pour les entreprises. Intel a visé large, que ce soit avec SHA-NI, GFNI (Galois Field), Vector AES/CLMUL ou VPMADD52. D'autres instructions visent cette fois la (dé)compression de données (VBMI, Bit Algebra). SGX est aussi beaucoup mis en avant, chaque processeur proposant des enclaves de 8 Go à 512 Go.

Intel dit d'ailleurs déjà travailler avec Nasdaq à des solutions exploitant le chiffrement homomorphe, accéléré via AVX512, pour des tests de dispositifs de détection de fraude ou anti-blanchiment, afin de traiter des données sans les exposer à des tiers. Pour rappel, la société est aussi partie prenante dans un projet de puce spécialisée dans ce type de chiffrement pour la DARPA. Nous n'en sommes pour le moment qu'au début de la mise en pratique.

Les gains annoncés par cœur sont élevés, tant pour du RSA que de l'AES ou de l'ECDSA/ECDHE : de 1,5x à 5,63x.

De manière plus générale, Intel rappelle que le gain d'IPC de Sunny Cove est de 18 %, les fréquences étant plus élevées à TDP et nombre de cœurs identiques du fait de la gravure en 10 nm. Avec l'ensemble des avantages d'Ice Lake-SP, l'écart moyen entre un 8280 (28C) et un 8380 (40C) serait de 46 %, avec un TDP passant de 205 watts à 270 watts. Jusqu'à 74 % si l'on se focalise sur certains modèles BERT en inférence, exploitant les différents accélérateurs.

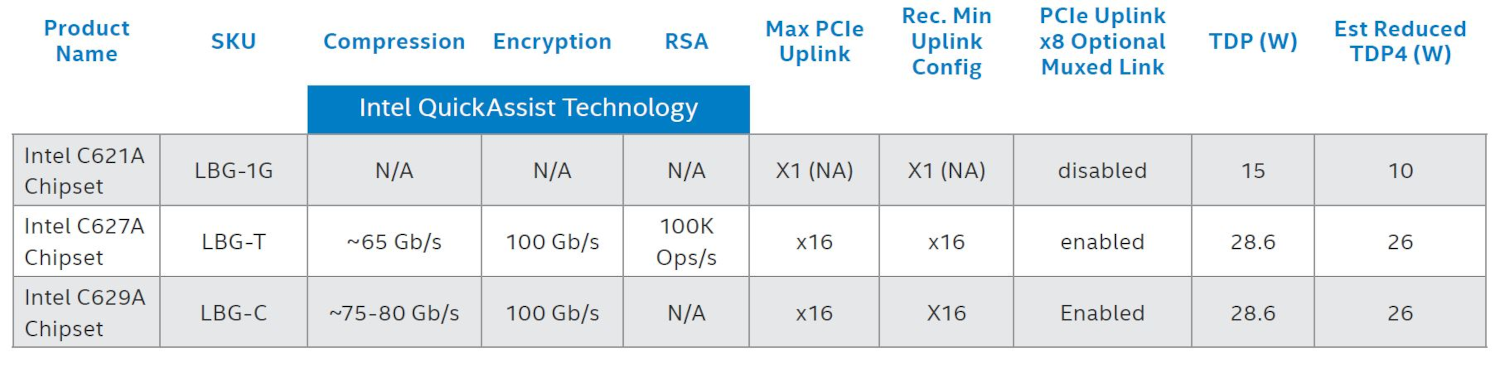

Anandtech, qui a pu opposer ces deux modèles confirme un gain tant en termes de performance par watt, que de performance pure, que ce soit à TDP identique ou plus élevé. Côté E/S, on a droit à de « nouveaux » chipsets C62xA (Lewisburg Refresh), toujours avec 20 lignes PCIe 3.0, 10 ports USB 3.0, 14 USB 2.0 et 14 ports S-ATA 6 Gb/s, mais un seul lien réseau intégré contre cinq auparavant. Une manière d'en simplifier le design.

On retrouve bien entendu les fonctionnalités habituelles d'Intel (QAT, RAS, gestion distante, etc.).

Une gamme complète et ciblée

Comme à son habitude, Intel détaille ses nouveaux modèles via son service en ligne ARK mais propose également une grille récapitulative, organisée par gamme. On y retrouve les Xeon de 3e génération reconnaissables à leur « 3 » dans la référence, dont les Cooper Lake (modèle H/HL) et les Ice Lake-SP (tout le reste). Un tableau évoquant les différences entre les gammes Silver, Gold et Platinum est également proposé :

Comme souvent, il faut parfois regarder dans le détail pour comprendre les différences entre certaines références (SKU). Comme celles avec Speed Select, qui permet de modifier à la volée la gestion des fréquences ou le nombre de cœurs via les profils de performance (SST-PP) pour l'adapter à des besoins particuliers par exemple.

On trouve aussi des SKU favorisant les fréquences sur 1 cœur ou lorsqu'ils sont tous actifs. On remarque également la présence d'un modèle « Liquid Cooled » (8368Q) à la Tcase plus faible que la moyenne.

On note surtout des prix en baisse, débutant à 501 dollars pour 8 cœurs. Bien que bien plus rapide et efficace, un Xeon Platinum 8380 est affiché à 8 099 dollars, contre 10 009 dollars pour son prédécesseur (8280). Bien entendu, ces tarifs ne correspondent pas à ce qui est réellement payé par les plus gros clients, mais c'est un indicateur.

On peut y voir l'influence d'AMD et ses EPYC 7003, qui viendront s'opposer à Ice Lake-SP, chacun pouvant attirer tel ou tel type de clients selon ses besoins. Intel compte sur ses nouvelles instructions, son écosystème et les offres Market Ready et Select Solutions développées depuis 2017. Mais surtout son design monolithique à 40 cœurs qui lui confère certains avantages pratique, le client n'ayant pas à se préoccuper de la communication inter-chiplets.

AMD a de son côté une plateforme plus avancée, notamment en nombre de liens PCIe 4.0, un coût par cœur en général plus faible et un maximum de 128 cœurs par plateforme à deux sockets, contre 80 pour Intel.

Optane PMem passe la seconde

Les processeurs ne sont pas le seul élément de l'offre Serveur d'Intel à évoluer. On a également droit à de nouveaux modules Optane Persistent Memory (série 200), à mi-chemin entre mémoire et stockage flash.

On peut en utiliser jusqu'à 6 To par socket, à une bande passante de 3,2 GT/s (2,67 GT/s auparavant) avec l'extended asynchronous DRAM refresh (eADR). Cette fonctionnalité étend aux caches du CPU la protection des données en cas de perte de courant. Elle améliore au passage les performances, les applications n'ayant plus à gérer le flush des caches via des instructions spécifiques. Le système s'en charge automatiquement.

Des modules de 128 à 512 Go sont proposés, compatibles uniquement avec la plateforme Whitley. Les débits maximum sont de 8,1 Go/s en lecture, 5,6 Go/s en écriture. Le TDP de 15 watts. Les tarifs ne sont pas précisés.

SSD Optane DC P5800X : jusqu'à 7,4 Go/s

Toujours dans la gamme Optane, mais au format 2,5" (15 mm) voici les SSD DC P5800X (Alder Stream), avec une interface PCIe 4.0 x4 (NVMe). Des modèles exploitant des puces 3D XPoint avec des débits de 7,2 Go/s au maximum en lecture/écriture séquentielle, jusqu'à 1,5 MIOPS en lecture/écriture 4K aléatoire, avec une latence jusqu'à 5 µs.

Intel a trouvé une façon « parlante » de présenter les choses : Il suffit de 2 ou 3 SSD pour saturer un lien 100 GbE à 90 %, contre 4 à 7 sur la génération précédente (D7-P5600). Trois modèles sont proposés : 400, 800 et 1 600 Go. Attention néanmoins à la consommation, chaque SSD consommant entre 14 et 21 watts en pleine charge.

L'endurance est de 100 DWPD (Disk Write Per Day). Là aussi, aucun tarif n'a été donné.

QLC 144 couches en différents formats

Si vous cherchez du stockage plus accessible avec une bien meilleure densité, vous pourrez vous tourner vers la gamme D5-P5316 (Arbordale Plus Refresh). Elle repose sur la flash NAND QLC à 144 couches et proposée en 2,5" (15 mm), U.2 (15 mm) ou E1.L (réglette). Dans des capacités de 3,84 To à 30,72 To selon les cas.

Avec les réglettes E1.L on peut atteindre 1 Po de stockage dans un seul serveur 1U, tout en bénéficiant d'une connectique PCIe 4.0 x4 (NVMe 1.3c) et donc de débits élevés, surtout en lecture (QLC oblige). Intel indique qu'ils vont jusqu'à 7 Go/s en lecture séquentielle et 3,6 Go/s en écriture. On tombe à 510 Mo/s en écriture aléatoire 64K.

La latence est de 82/15 µs dans le meilleur des cas, la consommation entre 5 watts (au repos) et 25 watts (en charge). L'endurance est de 0.41 DWPD pour l'ensemble de la gamme, la garantie pouvant aller jusqu'à 5 ans.

Nouveaux Xeon D, produits PCIe 4.0 & compagnie

Intel a également évoqué ses prochains Xeon D (Ice Lake-D), sans trop en dire si ce n'est qu'ils seront plus denses et proposés de 25 à 125 watts, pouvant être intégrés à des machines fonctionnant en intérieur ou en extérieur. Ils profiteront aussi des dernières accélérations maison, dont Deep Learning Boost ou VNNI.

Certaines fuites évoquent deux dies, pouvant atteindre 8 ou 20 cœurs selon les cas, avec un maximum de 56 lignes PCIe 4.0. On ne sait pas si une déclinaison grand public est prévue, ce n'est en général pas le cas des Xeon D que l'on retrouve surtout dans des cartes mères spécifiques, serveurs et autres NAS.

Le constructeur en a profité pour vanter les mérites de sa carte réseau PCIe 4.0 E810-2CQDA2 2x 100 GbE (QFSP28) lancée au début de l'année. Ou de ses FPGA Agilex, actuellement en 10 nm avec PCIe 4.0 et pouvant donc profiter de la dernière plateforme Xeon Scalable de 3e génération. Ils se préparent à passer au PCIe 5.0.

En ligne de mire, à nouveau : les solutions 5G. Non pas au sein de vos smartphones, mais des opérateurs. Plus globalement, le message d'Intel est que ce sont les performances de sa plateforme qui évoluent dans leur ensemble avec cette génération, que ce soit pour le stockage des données, leur traitement ou les interconnexions.

Ice Lake-SP, et après ?

Cela devrait d'ailleurs continuer, puisque le fondeur travaille déjà sur la prochaine génération : Sapphire Rapids. Gravée en 10 nm, elle exploitera l'architecture Golden Cove (implémentée dans les Core de 12e génération, Alder Lake), mais avec un support de la DDR5 et du PCIe 5.0/CXL 1.1, via la plateforme Eagle Stream (LGA 4677).

Devant intégrer de nouvelles instructions/accélérateurs comme AMX, elle poussera un peu plus loin les avancées en la matière, mais bénéficiera surtout de plus de cœurs (jusqu'à 56) avec une architecture en tuiles et HBM2. Elle fera au passage le ménage sur le mélange des genres tel qu'on a pu le voir entre 14 nm et 10 nm sur cette génération.

Son lancement pourrait avoir lieu avant la fin de l'année, quand la production de masse débutera (de premiers clients étant déjà livrés). Intel devrait alors se retrouver dans une position un peu plus confortable face à un AMD qui lancera Zen 4 (Genoa, SP5, 5 nm) pour opérer des changements similaires.

Le passage au 7 nm n'est pas attendu avant l'année suivante (2022 - 2023) avec Granite Rapids (Golden Cove) puis Diamond Rapids (Ocean Cove, plateforme Mountain Stream). Des évolutions qui doivent régulièrement être accompagnées de nouvelles versions d'Optane Persistent Memory (Crow Pass puis Donahue Pass).

Le 10 nm jusqu'à l'année prochaine, les Xeon passeront au 7 nm ensuite

Le 10 nm jusqu'à l'année prochaine, les Xeon passeront au 7 nm ensuite

Un concert de partenaires

Comme il est de coutume, ces annonces étaient accompagnées de nombreuses déclarations de partenaires, évoquant l'utilisation de ces nouveaux Xeon, auxquels ils ont accès pour certains depuis des mois.

C'est notamment le cas de Microsoft qui les utilisera pour son offre de Confidential Computing, accessible sur inscription. AWS va bien entendu proposer ces processeurs dans de nouvelles instances.

Dell avait déjà évoqué ses PowerEdge C6520, MX750c, R750, R750xa et R650 attendus pour mai. La société organisait d'ailleurs il y a peu une conférence en ligne pour présenter l'ensemble de ses nouveaux serveurs dans cette période d'évolution des plateformes techniques, tant chez AMD qu'Intel.

HPE a également annoncé l'intégration des Xeon Scalable de 3e génération à ses ProLiant DL360 Gen10 Plus, DL380 Gen10 Plus, DL110 Gen10 Plus, HPE Synergy 480 Gen10 Plus, Edgeline EL8000(T), Apollo 2000 Gen10 Plus et Cray EX. ASRock Rack a référencé de nouvelles cartes mères à base de chipset C621, Gigabyte a lancé 7 cartes mères et 18 serveurs au sein de ses différentes gammes. Lenovo a annoncé de nouveaux ThinkSystem, SuperMicro a multiplié les serveurs pouvant accueillir ces nouveaux processeurs, tout comme Tyan. La liste est longue.

Plus inhabituel : NVIDIA a vanté la compatibilité de ses dernières cartes graphiques et solutions réseau avec le PCIe 4.0, renvoyant à sa liste de serveurs qualifiés, contenant déjà des modèles avec processeurs Ice Lake-SP.

Les Xeon Scalable de 3e génération passent au 10 nm (Ice Lake-SP), jusqu’à 40 cœurs

-

Ice Lake-SP, nouveau roi de la densité d'Intel

-

Le datacenter du futur selon Intel

-

Ice Lake-SP, ça change quoi ?

-

Une gamme complète et ciblée

-

Optane PMem passe la seconde

-

SSD Optane DC P5800X : jusqu'à 7,4 Go/s

-

QLC 144 couches en différents formats

-

Nouveaux Xeon D, produits PCIe 4.0 & compagnie

-

Ice Lake-SP, et après ?

-

Un concert de partenaires

Commentaires (11)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 08/04/2021 à 08h51

Mais surtout son design monolithique à 40 cœurs qui lui confère certains avantages pratique, le client n’ayant pas à se préoccuper de la communication inter-chiplets.

Comment ça, se préoccuper de la communication inter-chiplets ?

des caches plus élevés

le cache L3 passe à seulement 1,5 Mb, par rapport à certains EPYC qui ont 128 Mb ou 256 Mb c’est ridicule

Le 08/04/2021 à 08h56

Dans le cas du monolithe tu n’a pas a savoir sur quel coeurs tu travailles, ils discutent tous à la même vitesse entre eux, pas de latence différente, de mémoire cache différente (L2 il me semble), etc ….

Dans le cas du système chiplet AMD, il vaut mieux utiliser les coeurs qui sont sur un même chiplet plutôt que 2 coeurs sur des chiplet différents afin de maximiser les perfs, ce qui est généralement le souhait en DC.

Le 08/04/2021 à 08h59

Un EPYC est composé de plusieurs chiplets, l’IO die est une autre puce intégrant le contrôleur mémoire. Il faut donc passer par des bus spécifique pour assurer la communication qui se fait hors de la puce de départ, ce qui ajoute de la latence (et parfois des limites de débit mais c’est moins le cas depuis Zen 2). Cela nécessite de s’organiser quand tu es dans des workloads avec pas mal d’échange intercoeur, ou quand tu positionnes tes VM au sein du CPU, etc.

Intel et AMD ont des stratégies de cache différent, ce qui explique le dimensionnement (attention à ne pas comparer cache par cœur et cache global). Notamment, AMD mise de plus en plus sur de gros caches pour compenser ses architectures CPU/GPU (ce qui fonctionne assez bien dans pas mal de situations).

De manière plus générale, je sais qu’il est classique de tout voir par le prisme de l’opposition de machin contre bidule, chacun ayant son préféré. Mais IRL, et encore plus dans le marché entreprise, choisir un CPU, ce n’est pas principalement choisir un camp. Il serait bien de le comprendre un jour

Le 08/04/2021 à 09h00

Dans ce cas-là on a aussi le même problème en utilisant plusieurs CPUs quand on a un serveur avec plusieurs sockets

Le 08/04/2021 à 09h02

Oui. Mais avec un CPU à 40 cœurs monolithique tu ne l’as qu’à partir de cette limite. Dans un design en chiplets comme EPYC, tu l’as pour chaque groupe de 8 cœurs et pour chaque socket.

Le 08/04/2021 à 10h10

Des DC 5800X yeeeehaaaa. J’espère qu’ils vont aussi sortir en HHHL (comme les 4800X). Je connais des vSAN qui vont s’envoler en termes de performances.

Et ainsi nacquit NUMA. (Non-Uniform Memory Access)

Le 08/04/2021 à 13h09

‘tain des CPU de 38 coeurs, ça va bien faire chier pour les partitionnement un multiple de 19

Le 08/04/2021 à 22h17

Intéressant tout ca… Ceci dit, on va rester combien de temps à 8C/16T pour le haut de gamme “grand publique” ? Même à l’époque où Intel proposait du 4C/8T en haut de gamme, on trouvait déjà bien plus de cores pour les serveurs.

Au moins, Intel semble se bouger les fesses !

Le 09/04/2021 à 07h42

Le 09/04/2021 à 08h20

Les améliorations se trouvent également un peu partout ailleurs : des caches plus élevés, 8 canaux de DDR4-3200 plutôt que 6 canaux de DDR4-2933,

Tous les modèles Ice Lake ne supportent pas la DDR4-3200 d’après Anandtech qui ont mis à jour leur analyse, il y en a qui se contentent seulement du support de la DDR4-2933 et d’autres de la DDR4-2666 : https://www.anandtech.com/show/16594/intel-3rd-gen-xeon-scalable-review/2

Le 09/04/2021 à 08h46

Oui, quand on parle de la génération on parle de maximum possible sur la plateforme. Après il y a la granularité de chaque modèle. On renvoie vers ARK notamment pour ça, mais tu vois la différence de débit (officiel) du contrôleur mémoire dans le tableau par gamme (silver, gold, platinum)