OpenFlex Data24 de Western Digital : 6x 100 Gb/s et 154 To de SSD NVMe-oF dans 2U

Enfin un NAS à la hauteur !

Le 12 septembre 2022 à 10h08

10 min

Sciences et espace

Sciences

Le monde du datacenter change, la manière dont on pense et organise les serveurs informatiques évolue progressivement. Après une longue phase de concentration des fonctions et la tendance « hyper convergée », on désagrège, à commencer par le stockage. Avec sa plateforme OpenFlex Data24 NVMe-oF, Western Digital compte bien tirer parti de cette révolution.

Il y a quelques années encore, le rêve de certains était un serveur équipé de gros CPU, de beaucoup de mémoire, de multiples SSD rapides, pourquoi pas de GPU et d’autres accélérateurs. On pouvait tout y faire : calcul, stockage, réseau, le tout aidé par une couche de virtualisation permettant de segmenter les usages. Et en cas de panne ? On déporte sur une autre machine.

La désagrégation, petite révolution des datacenters

Mais voilà, ce modèle n’a pas que des avantages, notamment à une époque où chaque composant est plus efficace mais consomme plus individuellement, où il faut s’adapter à différents besoins, fournir des ressources à la demande, parfois de manière déséquilibrée. En effet, certains veulent profiter surtout de stockage ou d’accélérateur, mais pas du reste. Dès lors, comment faire pour organiser l’accès et la répartition des composants ?

Crédits : Marvell

Pendant des années, il n’y a guère eu de solution convenable à cette problématique, mais le secteur a planché sur le sujet. On a vu apparaître des initiatives dans le domaine de ce que l’on nomme « désagrégation », terme qui désigne la mise à disposition des ressources sur le réseau, non plus à travers du tout-en-un, mais des serveurs très spécialisés.

Amazon Web Services a été un des pionniers de cette tendance, mais le mouvement global est en marche. La norme NVMe a notamment fait monter en puissance sa déclinaison « over Fabric » permettant d’exploiter des SSD très rapides à travers une connexion InfiniBand, Fibre Channel ou Ethernet. Dans ce dernier cas, RDMA et/ou TCP permettent de disposer de solutions plus ou moins accessibles à tous et efficaces, notamment en termes de latence.

- NVMe-over-Fabrics (NVMe-oF) : partagez vos SSD NVMe sur le réseau

- Fungible, GRAID, Kalray : dans le serveur, la guerre du stockage fait rage

Cette tendance s’étend à d’autres composants, comme on le voit dans le domaine de la mémoire avec la croissance de Compute Express Link (CXL) ou des initiatives pour déporter des GPU sur le réseau comme Fungible GPU-Connect et Endgame chez Intel (sur lequel on sait peu de choses).

Particuliers ou professionnels, NVMe-oF change la donne

Antériorité oblige, c’est dans le secteur du stockage que les initiatives sont les plus nombreuses et que l’on rencontre des usages de plus en plus courants de NVMe-oF. Il faut dire qu’à travers des évolutions comme NVMe/TCP, n’importe qui peut en profiter, même avec un simple Raspberry Pi. On regrette d’ailleurs qu’aucun fabricant de NAS ne s’en saisisse réellement.

Mais ce n’est pas toujours simple à mettre en place, surtout de manière efficace. Des constructeurs ont donc travaillé à des solutions spécialisées et clé en main. C’est notamment le cas de Western Digital, géant du stockage disposant d’un avantage de poids : il a racheté en 2019 la société Kazan Networks afin de disposer de puces dédiées au NVMe-oF, la gamme RapidFlex.

Il s’agit d’ASIC disposant d’accélérateurs spécifiques, proposés depuis sous la forme de cartes PCIe mais aussi dans une gamme de serveurs dépourvus de CPU au sens habituel, OpenFlex. Ils laissent donc la place à du réseau très rapide, de la redondance et, comme leur nom l’indique, une grande flexibilité d’usage. Nous avons pu tester le dernier né de cette gamme, la Data24 NVMe-oF Storage Platform, équipée de 24 SSD SN840 de 6,4 To du constructeur pour mieux comprendre comment cela fonctionne et les possibilités offertes.

OpenFlex Data24 : un serveur, de nombreuses possibilités

Soyons clairs : ce n’est pas le genre d’appareil que n’importe qui va placer dans son garage. L’OpenFlex Data24 est un serveur destiné aux professionnels que l’on trouve, vendu à l’unité, entre 41 000 euros HT et plus de 42 000 euros HT avec 12 SSD de 3,84 To, soit 90 centimes HT du Go. Des tarifs qui peuvent sans doute être négociés avec Western Digital lors de l’achat en volume. La garantie proposée sur ce produit est de 5 ans, des options complémentaires étant proposées.

La machine livrée est au format 2U (711 x 448 x 88 mm) de 32 kg à vide, avec 24 emplacements 2,5" en façade pouvant accueillir des SSD U.2. La redondance est un élément clé de ce serveur qui gère le Dual Port, permettant d’attacher chaque SSD à deux éléments de contrôle. Cela tombe bien, on dispose justement de deux modules indépendants (IOM), chacun ayant son alimentation (2000 watts, 80PLUS Platinum), de sa gestion distante (BMC) et de ses propres ventilateurs. En cas de panne d’un module, l’autre peut prendre le relais.

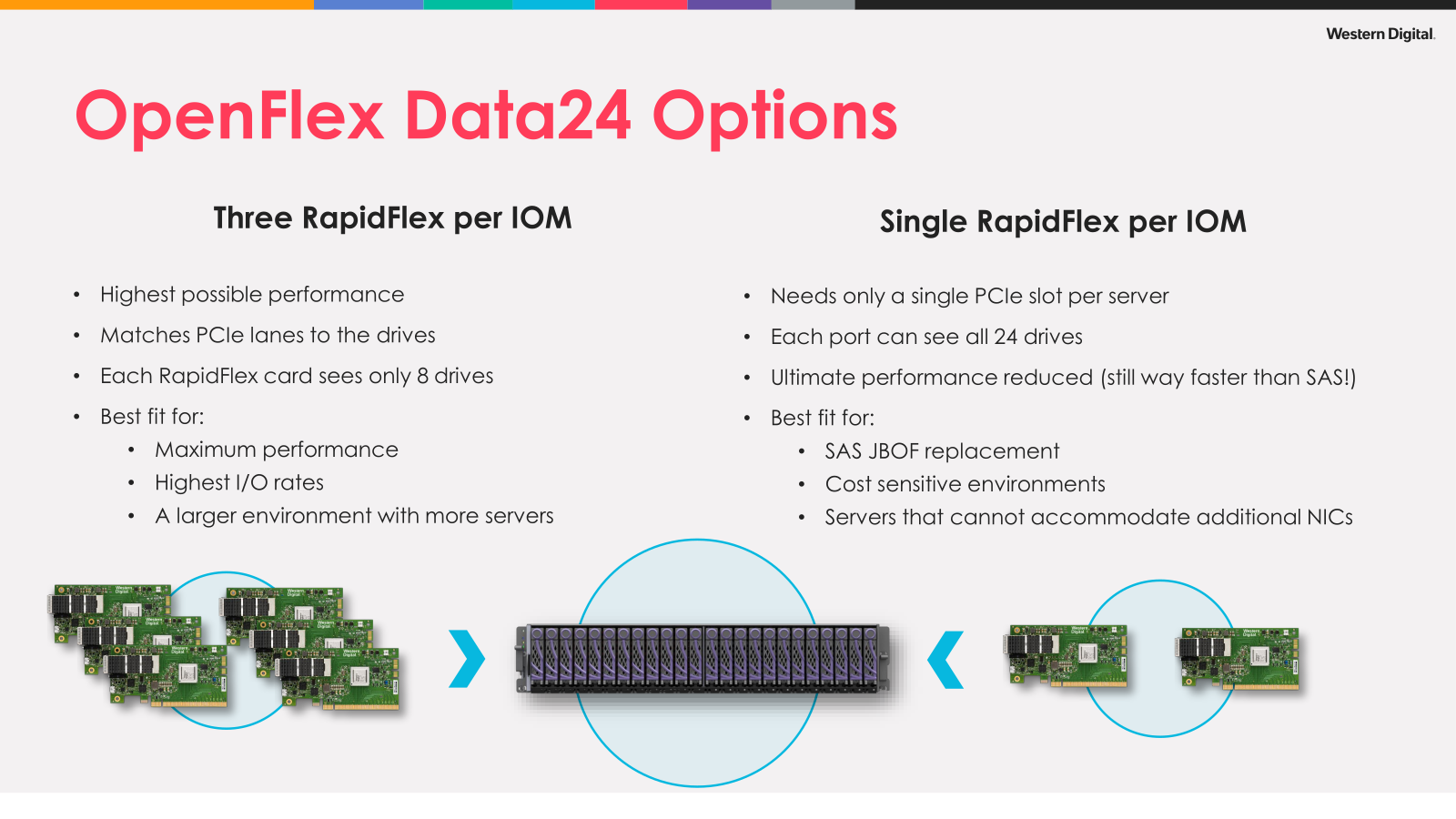

Chaque module peut être équipé d’un maximum de trois cartes PCIe 4.0 x16 RapidFlex C1000 dotée chacune d’un port pouvant atteindre 100 Gb/s (QSFP28). Chacune contrôle alors un groupe de huit SSD. Mais il est également possible de n’utiliser qu’une carte par module. Dans une telle configuration, les performances sont limitées, chacune gérant l’ensemble des 24 SSD. « Mais c’est toujours bien plus rapide que du SAS », précise le constructeur.

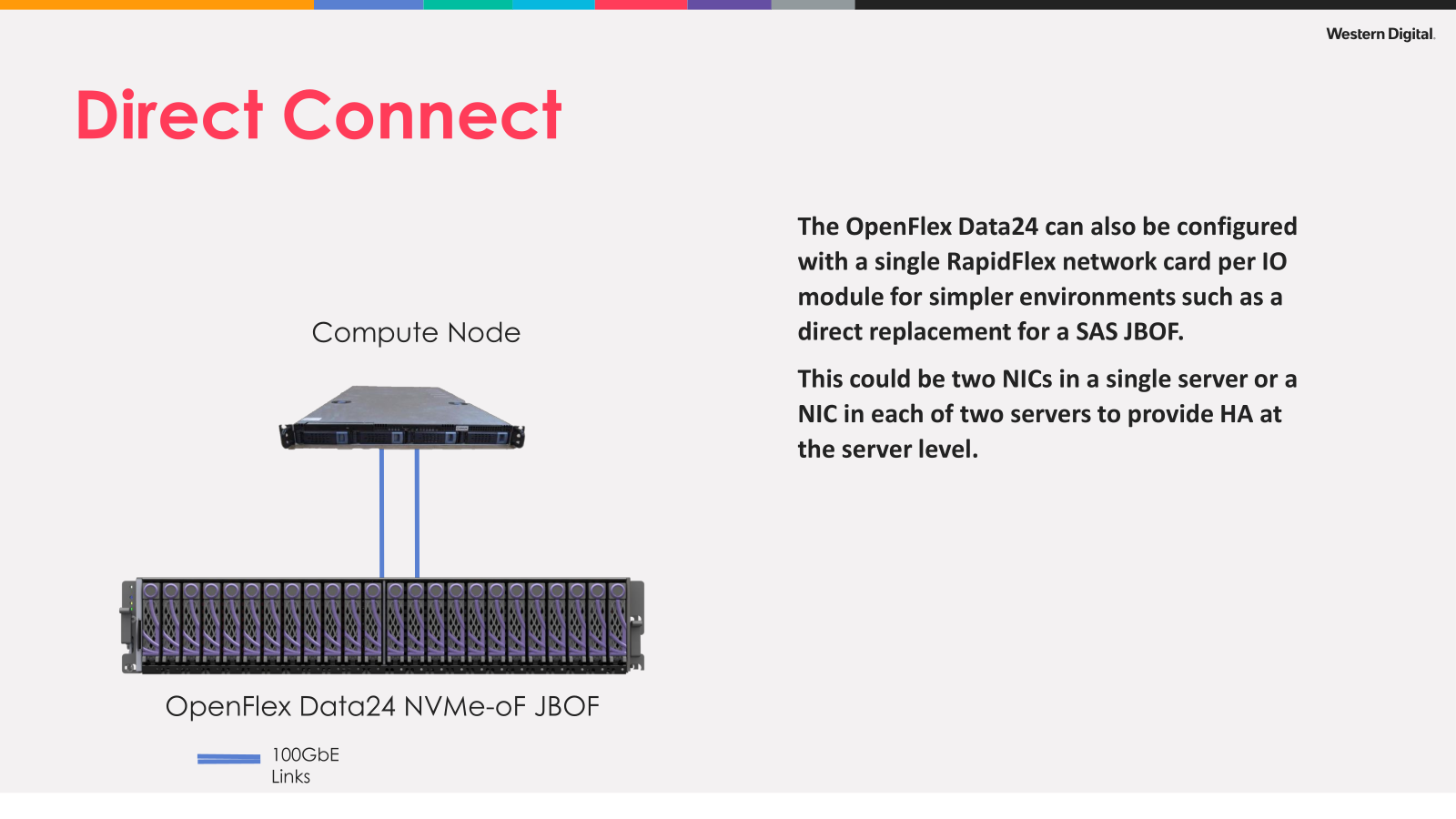

La flexibilité se retrouve également dans les méthodes de déploiement. On peut relier des serveurs directement à un OpenFlex, chacun avec 2x 100 Gb/s. Selon le nombre de cartes présentes au sein des IOM, il faudra alors disposer de plus ou moins de nœuds. On peut également passer par des switchs compatibles avec la norme RoCE v1/v2. Notez d’ailleurs que vos serveurs devront être équipés de cartes réseaux gérant cette norme, des modèles de Broadcom, Cavium et Mellanox étant qualifiés par Western Digital.

Le constructeur recommande bien entendu d’utiliser ses UltraStar DC SN840 prévus spécifiquement pour les centres de données et de tels usages (1 ou 3 DWPD selon les modèles). Il annonce des performances pouvant atteindre jusqu’à 71 Go/s en lecture à 6x 100 Gb/s et 42 µs de latence (4k QD1) en écriture à 2x 100 Gb/s.

L’installation et l’utilisation en pratique

Le montage des SSD dans leur cage se fait sans outil. Il suffit d’écarter deux membranes et d’y placer le périphérique de stockage. On note qu’une carte est présente afin d’assurer la connexion à travers un connecteur à broches plutôt que le port natif des SSD U.2. Le reste est composé de la même manière, on peut aisément retirer les IOM et alimentations. Au pire, il faut en passer par une vis à main. Pour accéder aux ventilateurs, il n'y a qu'à soulever un capot en façade.

Deux prises C13 suffisent à alimenter la machine. Comme détaillé précédemment, chaque IOM dispose de trois cages QSFP28 et d’un port RJ45 pour son contrôle à distance. Ici, vous avez le choix : Western Digital fourni une API complète pour les amateurs de la ligne de commande et des scripts. Sinon, vous pouvez passer par une interface web unifiée pour la gestion des deux IOM.

Pour notre test, nous avons passé le firmware du serveur à jour dans sa version 3.0 datant de décembre dernier. La procédure est relativement simple, un fichier .bin étant fourni, ainsi qu’un ensemble de scripts, permettant là aussi d’opter pour la procédure de son choix.

L’interface est complète et simple à prendre en main. On y voit par défaut la température du serveur et certaines informations comme son uptime, le statut des SSD, différents onglets permettant ensuite d’accéder aux différents paramètres, notamment la configuration des cartes et des IOM. On peut ainsi fixer une IP lors d’une connexion directe ou se reposer sur un DHCP, selon son besoin.

Et dans la pratique ?

Dans notre cas, Western Digital nous a fourni un serveur complet avec trois cartes par IOM et 24 SSD SN840 de 6,4 To. Malheureusement, nous n’avions pas trois serveurs sous la main pour utiliser l’ensemble dans une configuration idéale. Nous avons donc utilisé le serveur Gigabyte R182-NA1 en y plaçant une carte Mellanox 2x 100 Gb/s qui nous avait été fournie. Nous disposions d’assez de ports pour connecter 16 SSD à travers deux IOM différents. 8 étaient toujours disponibles pour un autre serveur, avec la possibilité de redondance.

Nous avons installé Proxmox VE et avons pu connecter les SSD via NVMe-oF sans le moindre problème. Tout était géré nativement. Les SSD étaient vus comme des périphériques NVMe locaux, pouvant être utilisés pour des machines virtuelles.

Un Windows 11 virtualisé nous a permis de tester les performances obtenues à travers VirtIO SCSI, entre 2,5 Go/s et 3,5 Go/s sous CrystalDiskMark avec un SN840 utilisé au sein du serveur, entre 910 Mo/s et 1,5 Go/s lorsqu’il est utilisé à travers la connexion réseau. Et une très bonne latence.

Et lorsqu’on en utilise plusieurs en parallèle ? Nos tests sous fio nous ont permis de grimper à 22 Go/s en lecture et 14 Go/s en écriture, soit à peu près les performances annoncées par Western Digital dans une configuration 2x 100 Gb/s. On peut bien entendu aller plus haut lorsque les 24 SSD et l’ensemble des IOM sont utilisés, notamment dans une configuration à trois serveurs. L'équipe de MinIO a d'ailleurs publié des résultats en ce sens.

Une solution simple et clé en main

L’OpenFlex Data24 de Western Digital remplit le contrat initial : le serveur est facile à mettre en place, à utiliser et à configurer, les performances sont au rendez-vous. L’ensemble est assez flexible pour convenir à différents besoins, qu’il s’agisse de petites entreprises ou de sociétés ayant de plus grosses exigences en termes de déploiement, voulant disposer de stockage sur le réseau en masse.

Le fait de pouvoir assurer une gestion via une interface web ou la ligne de commande est un plus. Il ne faudra par contre pas vouloir sortir du cadre défini par Western Digital ou des fonctionnalités trop poussées comme une gestion du RAID côté serveur, utiliser les puces pour des besoins de calcul autre, etc.

Il faudra également accepter d’avoir une approche presque 100 % Western Digital, et donc dépendre du constructeur et de ses exigences, notamment du côté des composants certifiés. Mais pour le public visé, qui veut déployer du stockage performant et l’utiliser sans avoir à monopoliser des équipes entières, une offre sous la forme d’un écosystème prêt-à-l’emploi conviendra parfaitement.

OpenFlex Data24 de Western Digital : 6x 100 Gb/s et 154 To de SSD NVMe-oF dans 2U

-

La désagrégation, petite révolution des datacenters

-

Particuliers ou professionnels, NVMe-oF change la donne

-

OpenFlex Data24 : un serveur, de nombreuses possibilités

-

L’installation et l’utilisation en pratique

-

Et dans la pratique ?

-

Une solution simple et clé en main

Commentaires (11)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 12/09/2022 à 11h13

“Nous avons pu tester le dernier né de cette gamme”

@david, tu mutualises ton nouveau “homelab” entre NXI et clever ?

chouette machine, un peu overkill à la maison ;)

Le 12/09/2022 à 11h19

Non, pas de mélange ;) Et c’était même un produit/papier sur lequel j’ai commencé à travaillé bien avant mon départ et mon intégration à Clever (qui n’utilise pas d’OpenFlex). Mais travailler sur des solutions Pro ça prend du temps et ce n’est pas toujours simple, surtout quand il faut recevoir trois palettes à la maison (Et pour mon Home Lab je vise plus accessible

(Et pour mon Home Lab je vise plus accessible  )

)

Le 12/09/2022 à 11h21

Mais pourquoi 2000W/alimentation ? Un SN840 c’est 18W max et c’est déjà énorme pour un SSD. Une carte infiniband 100Gbit/s c’est de l’ordre de 10W et le processeur pour relier le SSD au réseau ne doit pas être très élaboré, le gros du travail devant être des transferts directs entre le SSD et la carte réseau. En pratique combien est-ce que ça consomme ? 750W ?

Pour le reste, je sais le retard que j’ai sur les technos à la mode, mais le besoin de réattribuer à la volée des SSD NVME d’un serveur à un autre me semble quand même assez particulier, hors gros hébergeur. Je suppose que l’objectif est d’attribuer physiquement le SSD à une VM donnée (en gardant la possibilité de déplacer la VM).

Le 12/09/2022 à 11h36

C’est quand même vachement particulier comme gestion de stockage. Ça oblige a passer par des solution tierce pour le RAID. Ou pas si on a que des serveurs clusteurisés, et la pour le coup c’est assez élégant de supprimer les disques “sacrifiés”. Par contre faut vraiment pouvoir tout avoir un cluster ^^.

Le 12/09/2022 à 12h08

Comment ça des solutions “tierces” ? Tu attaches le SSD à ton client, tu gères ton RAID comme si c’était local. Après on peut considérer mdadm comme tiers, mais bon.

Le 12/09/2022 à 13h10

ESXi ne gère pas de stockage nativement par exemple, il ne fait que « l’accrocher ». Mdadm c’est possible sur proxmox parce que c’est une debian, le raid logiciel d’hyperv c’est possible aussi mais ça veut dire qu’on sacrifie une partie de la bande passante juste pour la redondance. Et on reporte la charge de traitement du raid sur les cpu du serveur plutôt que sur les contrôleurs…

Non ?

Le 12/09/2022 à 18h26

J’ai aussi un peu de mal à imaginer l’exploitation en pratique (même si je ne doute pas que ça se fasse très bien).

Au delà de la centralisation du stockage, un SAN permet une abstraction du stockage très confortable (là je pense à de la réplication entre sites vu que je suis en plein dedans) qu’on se retrouve à devoir gérer avec des OS/applis pas forcément outillés pour.

Idem avec les solutions de stockage distribué (et donc HCI aussi), l’abstraction c’est sympa.

Sur des trucs qui gèrent tout au niveau applicatif (minio, elastic…) je vois bien l’intérêt par contre : faire ça sur autre chose que des devices gérés localement c’est contre productif donc ça doit être cool avec une infra de ce genre.

Le 13/09/2022 à 03h36

Ton SAN en général c’est du SAS attaché ou iSCSI qui n’est pas fait pour le Flash. Là c’est exactement la même chose en pratique, mais avec un protocole d’accès/découverte natif au NVMe.

Le 13/09/2022 à 06h44

Même si on a des trucs type Dell MD1400 qui renvoient juste les disques, la plupart des baies SAN que j’ai vu sont d’un niveau d’abstraction bien plus élevé (RAID, souvent volumes logiques, snapshot, réplication, tiering…) Mais si j’ai vu des cartes RAID gérant le NVME, je n’ai pas vu de baies SAN élaborées sortant en NVMEoF. Bon, ce ne serait de toutes façons pas dans les moyens de là où je travaille.

Le 13/09/2022 à 07h35

Les DELL Powerstore ? Elles font du NVMe-oF over FC et TCP. Et leur prix d’entrée a baissé avec le changement de nom, depuis les Compelent d’il y a quelques années.

Le 12/09/2022 à 21h02

Toujours pas eu l’occasion d’essayer le NVMe réseau, c’est cool d’avoir un remplaçant au vieux iSCSI.