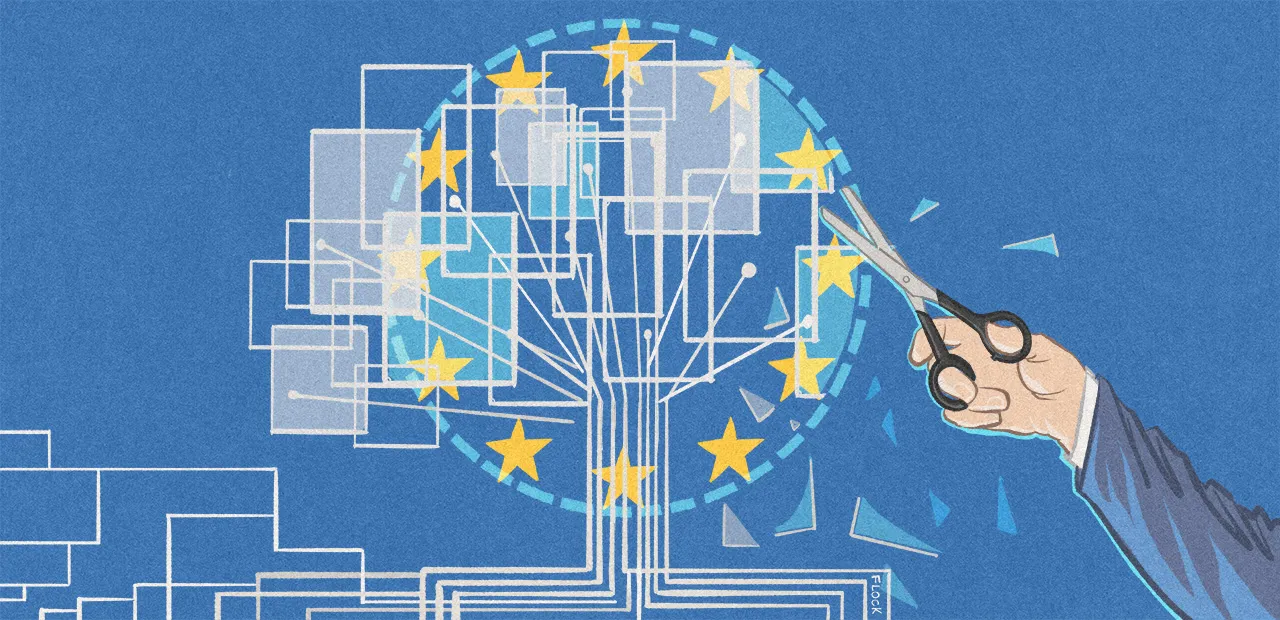

Dans son rapport The lobbying ghost in the machine publié le 23 février, le Corporate Europe Observatory (CEO, principale entité œuvrant pour la transparence des entreprises en Europe) décortique les actions mises en place par les Big Tech pour éviter une régulation des intelligences artificielles générales (IAG ou general purpose AIs en anglais, GPAI).

Le document détaille notamment comment Google et Microsoft argumentent contre l’application du règlement européen sur l’intelligence artificielle aux fournisseurs de grands modèles de langage (LLMs, le type de technologie qui permet à ChatGPT et Dall-E de fonctionner) et d’autres IA généralistes.

À la place, ces géants numériques poussent pour que les régulations soient appliquées plus loin sur la chaîne de valeur, notamment sur les entreprises qui utiliseraient ces technologies à des fins jugées dangereuses.

Dans TechCrunch, notre consœur Natasha Lomas alerte sur le fait qu’une telle approche risquerait de déplacer la responsabilité de la sécurité et de la confiance dans les outils déployés vers les utilisateurs finaux, sans leur donner le même type de moyens ni d’échelle pour corriger les machines que ceux dont les constructeurs d’IAG disposent.

Comme l’ont noté nos confrères d’Euractiv puis de Reuters, les discussions sur le règlement sur l’intelligence artificielle ont pris du retard à cause de débats toujours très intenses sur la définition même de ce qu’ils cherchent à encadrer. Les législateurs peinent à s’accorder, en particulier, sur le type de modèles algorithmiques qui se verraient qualifié de « à haut risque », et donc soumis aux règles les plus dures.

Or, comme on l’a vu dans une précédente brève, la sortie de modèles génératifs très performants participe à compliquer la discussion.

Commentaires (2)

#1

les IA selon mon avis, ce n’est pas de l’Intelligence Artificielle, mais de l’Intuition Artificielle, comprendre que le moteur se base sur des expériences et absolument pas sur de la logique. D’où les biais : selon la sélection des expériences par les “développeurs” il y aura des résultats très différents. Exemples nombreux (délinquants parce que noirs, personnes à virer parce que féminines, …). Aussi incertain que des pronostiques de Vote lorsqu’on ne fait pas d’“échantillon représentatifs”, ce que semblent ignorer les “développeurs”.

#2

Encore heureux.

Certes il y a des biais qu’on juge immoraux et qu’on voudrait idéalement gommer, mais il y a aussi des biais moraux qui rendent les décisions/réponses des IA socialement acceptables.

Supprimer tous les biais sur une IA et se limiter à la pure logique ca donnerait des réponses qu’on n’est pas prêt à entendre.