Microsoft met en avant l’efficacité de son nouveau modèle Phi-4

Le 18 décembre à 08h06

2 min

IA et algorithmes

IA

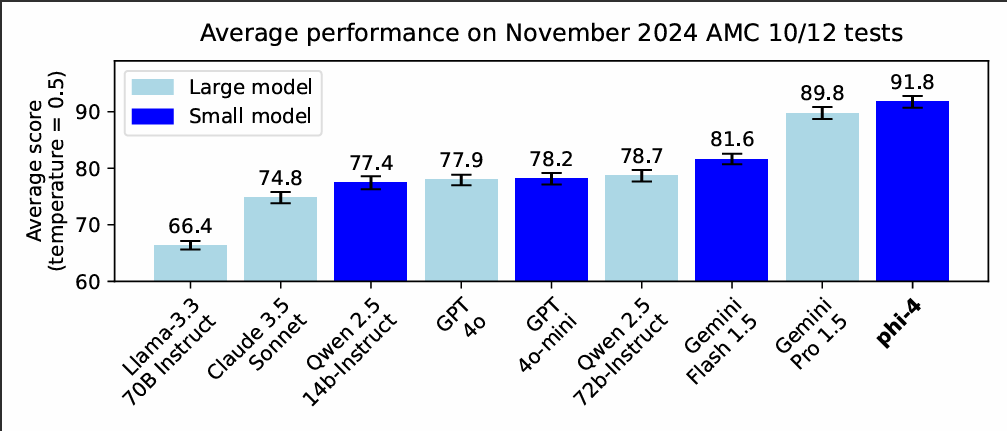

Microsoft a lancé il y a quelques jours la préversion de son « petit » modèle Phi-4, qui veut marquer une rupture. Le modèle doit concurrencer les plus gros du domaine, dont Gemini 1.5 Pro. Mais là où des modèles comme celui de Google ou le GPT-4o d’OpenAI peuvent brasser des centaines de milliards de paramètres, Phi-4 se limite à 14 milliards.

Microsoft met largement en avant la grande efficacité de son modèle, avec des résultats supérieurs en matière de « raisonnement » mathématique. Des performances que l’éditeur attribue à l’utilisation « de données synthétiques de haute qualité ». Comme toujours dans les annonces de modèles, on ne sait pas grand-chose de plus sur ces données. Microsoft évoque également des améliorations sur le post-traitement, mais là encore sans plus de détails.

Phi-4 se révèle, selon Microsoft, particulièrement bon dans la résolution des problèmes mathématiques posés dans les compétitions de la Mathematical Association of America. Dans ce domaine, le nouveau modèle ferait mieux que les plus grands, ou même leurs versions réduites et pouvant être davantage optimisées pour des besoins spécifiques.

Le nouveau modèle n’est pour l’instant disponible qu’en préversion, dont l’accès est limité à Azure AI Foundry et uniquement à des fins de recherche, dans le cadre d’un accord de licence. Un lancement plus large aura lieu plus tard sur Hugging Face.

Phi-4 pourrait ouvrir un nouveau front dans une bataille qui s’était largement concentrée jusqu’à présent sur le « plus c’est gros, mieux c’est ». Le besoin en puissance et la facture énergétiques pourraient devenir des facteurs limitants, pavant la voie à des modèles se proposant d’en faire plus (ou au moins autant) pour moins.

Le 18 décembre à 08h06

Commentaires (3)

Abonnez-vous pour prendre part au débat

Déjà abonné ? Se connecter

Cet article est en accès libre, mais il est le fruit du travail d'une rédaction qui ne travaille que pour ses lecteurs, sur un média sans pub et sans tracker. Soutenez le journalisme tech de qualité en vous abonnant.

Accédez en illimité aux articles

Profitez d’un média expert et unique

Intégrez la communauté et prenez part aux débats

Partagez des articles premium à vos contacts

Abonnez-vousModifié le 18/12/2024 à 08h58

Je testerai celui-là à l'occasion quand il sera dispo publiquement.

Hier à 10h57

Mais bon, j'imagine que c'est bien?

Hier à 10h59

Pourtant le business des fournisseurs d'IA ca semble être de vendre des abonnements au Cloud.

Les modèles 14B sont des produits d'appel ?