Build 2024 : Microsoft encourage la création de copilotes personnalisés

IA d'la joie

Depuis hier soir, Microsoft tient sa grand-messe annuelle pour les développeurs. Comme on pouvait s’en douter, il n’est pratiquement question que d’intelligence artificielle, avec de nombreuses annonces liées au nouveau Copilot Studio. L’éditeur compte ainsi garder son avance.

Le 23 mai à 10h06

13 min

Logiciel

Logiciel

Par son investissement de plusieurs milliards de dollars dans OpenAI, Microsoft s’est assurée une place de choix dans la course à l’intelligence artificielle. La première place, en fait. L’entreprise multiplie les annonces et est maintenant prête à répandre de nouveaux usages chez le grand public. Pour preuve, l’annonce d’une nouvelle génération de PC, baptisées « Copilot+ » et renvoyant à son assistant, décliné à presque toutes les sauces.

Sans surprise, la conférence Build a été le théâtre de nombreuses annonces en rapport avec l’IA. Pas question pour Microsoft de se laisser rattraper alors que ses modèles sont déjà presque partout, tout du moins les modèles GPT d’OpenAI. Si l’on en croit les rumeurs, Apple devrait annoncer bon nombre de fonctions alimentées par l’IA, basées sur des modèles d’OpenAI, ce qui mettrait la société une nouvelle fois sur le devant la scène.

Microsoft, en attendant, continue son bonhomme de chemin et cherche à diversifier les usages. Rappelons que la société a déjà annoncé plusieurs fonctions pour Windows 11, présentes dans les PC Copilot+, notamment Recall, qui garde l’inventaire des activités et permet de retrouver ce que l’on a fait, et Super Resolution, spécialisé dans la restauration de vieilles photos. Leur efficacité et leur impact sur la vie privée restent cependant à évaluer.

Team Copilot veut simplifier la collaboration et la gestion de projet

Team Copilot est ainsi présenté comme une solution permettant « d’améliorer la collaboration » et de « rationaliser la gestion de projet ». Bien que le nom soit proche, il ne fait pas seulement référence à Teams, composant central de la stratégie entreprise de Microsoft. L’éditeur est connu pour ses choix douteux au moment de nommer ses produits.

Team Copilot est envisagé comme un « membre précieux de l’équipe » et s’intègre partout où l’on trouve des fonctions de collaborations. Dans Teams bien sûr, mais aussi dans Loop, Planner et autres. Les fonctions proposées sont du même acabit que ce que l’on trouve dans divers produits de Microsoft et d’autres éditeurs : gestion de l’ordre du jour et prise de notes pendant les réunions, mise en lumière des informations « importantes », suivi des actions et problèmes non résolus, création et attribution de tâches, information à d’autres personnes ou équipes quand leur contribution est nécessaire…

La présentation de Microsoft, qui insiste sur l’aspect « personne à part entière », se voit davantage dans plusieurs exemples donnés. Tout particulièrement dans Planner. Il est ainsi possible de demander à Team Copilot de diviser les tâches en étapes, de mettre en avant les personnes disponibles pour les accomplir en tenant compte de leur agenda, de l’interroger sur l’avancement de ces étapes, etc.

Rien n’est cependant finalisé. Team Copilot ne sera disponible que plus tard dans l’année sous forme de préversion, accessible aux entreprises ayant une licence Copilot for Microsoft 365.

Copilot Studio : des agents, des connecteurs, des extensions

Le nom Copilot recouvre désormais de nombreux produits. Et les nouveautés fusent de toutes parts. Par exemple, GitHub Extensions permet d’étendre les capacités du Copilot d’origine avec des fonctions supplémentaires. DataStax, Docker, LambdaTest, LaunchDarkly, McKinsey & Company, MongoDB, Octopus Deploy, Pangea, Pinecone, Product Science, ReadMe, Sentry ou encore Stripe ont répondu présents.

« La programmation en langage naturel va continuer à abaisser la barrière à l'entrée pour tous ceux qui veulent créer des logiciels. Aujourd'hui, nous nous rapprochons d'un avenir où un milliard de personnes pourront construire sur GitHub, avec Copilot comme plateforme intelligente qui s'intègre avec n'importe quel outil de la pile technologique du développeur, entièrement en langage naturel », a proclamé Mario Rodriguez, vice-président produit de GitHub.

Les extensions seront proposées sur les places de marché GitHub et Microsoft 365, selon la finalité. Les entreprises clientes pourront cependant développer leurs propres extensions et les garder privées.

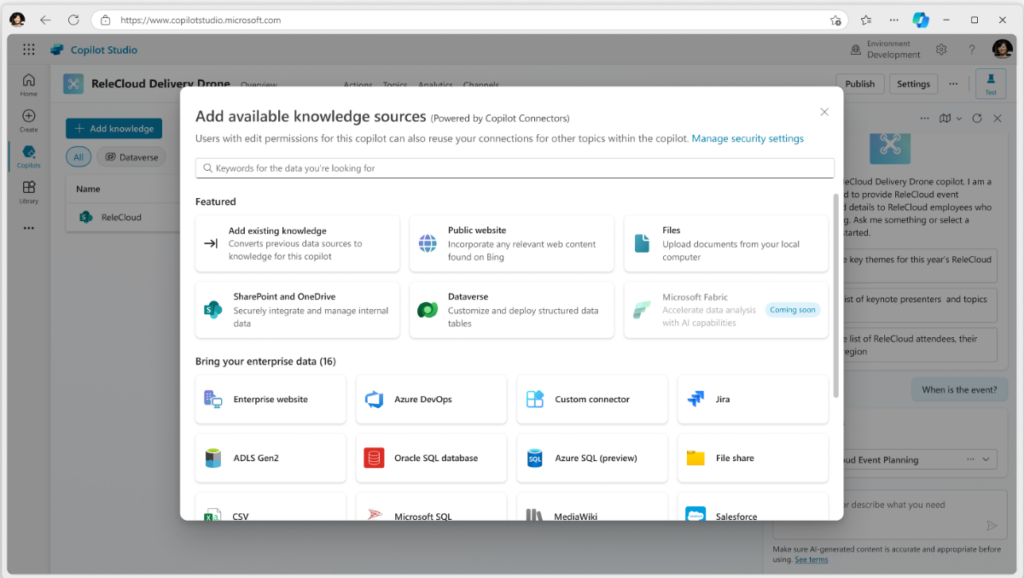

Les connecteurs sont un autre ajout important. Disponibles en préversion, ils assurent une connexion entre un Copilot et les données de l’entreprise pour en personnaliser l’analyse et les résultats. Les connecteurs présents comprennent les sites web publics, SharePoint, OneDrive, des tables Microsoft Dataverse, Fabric OneLake (plus tard cette année), Microsoft Graph et des produits d’entreprises tierces.

Aux côtés des extensions et connecteurs, on trouve les agents. Il s’agit de robots personnalisés indépendants, que l’on peut orienter vers des tâches spécifiques. Par exemple, l’automatisation des processeurs opérationnels de longue durée, l’exploitation des données en mémoire pour en retirer du contexte, l’apprentissage basé sur les commentaires des utilisateurs, la prise de commande, etc.

Pour cette dernière, utilisée en exemple, Microsoft indique que le processus peut aller de la prise de commande proprement dite à l’expédition au client, avec traitement des opérations, recommandations, gestion des stocks et autres. Il s’agit encore une fois d’une préversion.

Azure AI Studio : pour construire son propre Copilot

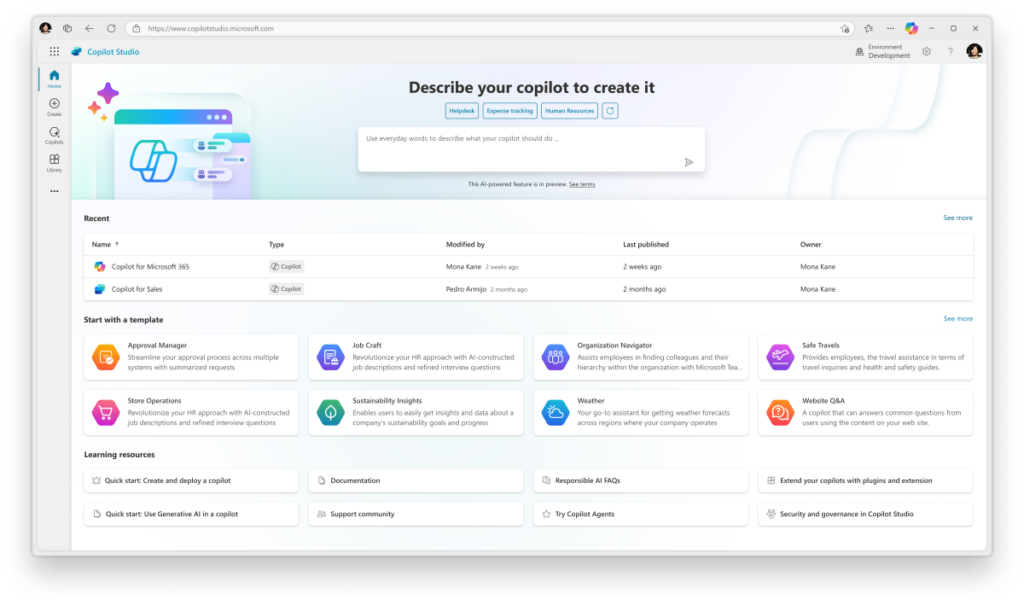

Les entreprises ayant besoin d’aller plus loin pourront construire leur propre Copilot. Pour cela, elles passeront par Azure AI Studio, un nouveau service en préversion disponible dans Azure OpenAI.

Une entreprise pourra ainsi sélectionner un modèle d’IA générative dans la liste, dont tous les modèles d’OpenAI bien sûr. À l’aide d’une requête en langage naturel, elle pourra décrire l’objectif général du Copilot et la manière dont il devrait fonctionner. Le service proposera alors une solution, qu’il sera possible de retravailler en cas de besoin.

Après quoi, il faudra ajouter une source de stockage dans le cloud afin que le modèle ainsi créé soit entrainé sur les données de l’entreprise. Les résultats obtenus sont privés, Microsoft affirmant n’avoir aucun regard sur les informations de l’entreprise.

Les capacités des Copilot personnalisés peuvent être étendues au moyen des extensions, connecteurs et agents, comme pour les Copilot classiques. Microsoft espère beaucoup de cette fonction, qui pourrait pousser les entreprises à se lancer dans l’IA, avec la perspective d’avoir rapidement des chatbots adaptés à ses besoins, en conformité avec leurs politiques et sans devoir – a priori – une vaste réflexion sur les droits d’accès, les données restant privées. À noter que ces dernières peuvent aussi provenir d’autres sources.

Dans l’idée d’exploiter les données déjà présentes, Microsoft permettra plus tard dans l’année (en préversion) d’exploiter directement les informations stockées dans OneDrive et SharePoint.

Windows Copilot Runtime

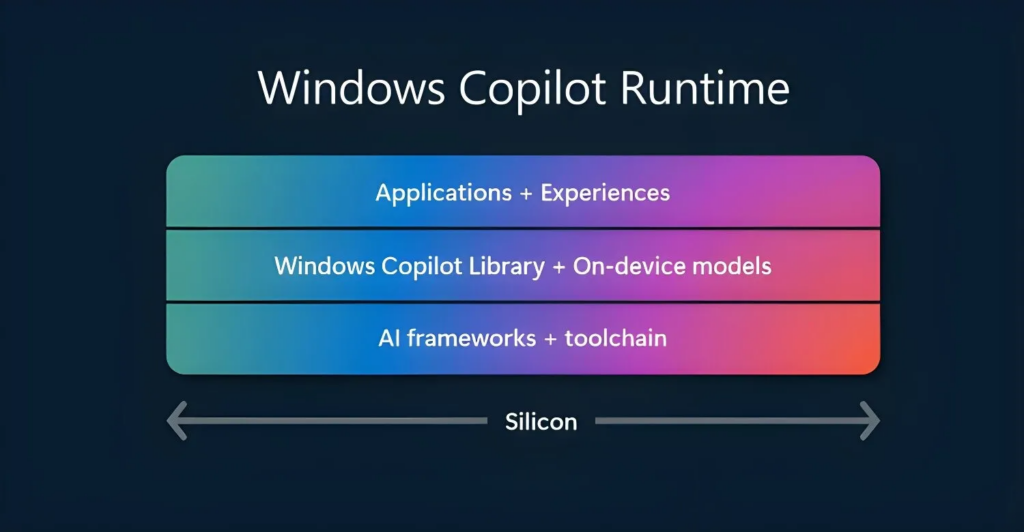

Autre annonce importante et qui devrait permettre à Microsoft de focaliser les efforts sur ses produits, le Copilot Runtime. Il s’agit d’un nouveau composant de Windows, donc prêt à l’emploi par les développeurs, pour fournir des API liées aux capacités IA du système. Ces API seront présentes dans le Windows App SDK.

Le Runtime, en plus de fournir des API, comprend une quarantaine de modèles de diverses tailles, beaucoup pouvant fonctionner hors ligne. C’est l’un des objectifs du composant : permettre aux développeurs tiers de tirer partie de fonctions telles que Studio Effects, Live Captions translations, la reconnaissance de texte ou encore Recall pour leurs propres besoins.

Plusieurs entreprises ont déjà annoncé qu’elles exploiteraient ces capacités. ByteDance, par exemple, va se servir du Copilot Runtime pour accélérer ses propres fonctions d’IA dans l’éditeur vidéo CapCut. Meta reprendra de son côté les Studio Effects pour ajouter des fonctions, comme le floutage de l’arrière-plan lors d’un appel vidéo sur WhatsApp.

Microsoft étoffe la famille Phi-3 de petits modèles

Puisque l’on parle de modèles, Microsoft en a ajouté plusieurs à sa famille Phi-3. Parmi eux, Phi-3-vision est mis avant. Multimodal, il se distingue par ses capacités de langage et d’analyse visuelle, pouvant « raisonner » sur les contenus. Il peut ainsi fournir des renseignements à la suite de requêtes en langage naturel, par exemple après lui avoir demandé d’analyser un graphique.

Le modèle se veut léger et peut être exécuté sur tout appareil muni d’un NPU (moteur neuronal matériel). Il peut prendre en charge 128 000 jetons et dispose de 4,2 milliards de paramètres.

La disponibilité de la famille sur Azure s’étend désormais à quatre membres, avec en plus les versions mini, small et medium de Phi-3 :

-

- Phi-3-mini : 3,8 milliards de paramètres, avec deux longueurs de contexte, 128K ou 4K

-

- Phi-3-small : 7 milliards de paramètres, avec les mêmes contextes

-

- Phi-3-medium : 14 milliards de paramètres, avec les mêmes contextes

Microsoft ajoute que des versions optimisées avec ONNX Runtime et DirectML sont disponibles.

À ces quatre modèles utilisables presque n’importe où, Microsoft en présente un cinquième. Baptisé Phi Silica, il s’agit d’un tout petit modèle, pensé pour une utilisation locale et à destination uniquement des PC Copilot+. Avec 3,3 milliards de paramètres, il est le plus petit de la famille. Sa rapidité de traitement annoncée est de 650 jetons par seconde pour une consommation de 1,5 watt. Il n’a pas besoin de connexion pour fonctionner.

Recall : on en apprend un peu sur la vie privée

Recall, présentée lundi soir en même temps que les PC Copilot+, est une fonction permettant de retrouver une activité réalisée au cours des derniers mois sur l’ordinateur. Pour cela, elle enregistre globalement tout ce qui est fait avec la machine, prenant notamment des captures d’écran pour redonner du contexte aux résultats. Ces derniers s’obtiennent en lançant une requête en langage naturel dans la recherche de Windows.

On en sait un peu plus sur cette partie, car Microsoft a abordé un élément nommé Windows Semantic Index. L’index sémantique a la mission de stocker les informations via l’analyse du texte, des images, du son et de la vidéo. Cette analyse se fait à partir de plusieurs SLM (Small Language Model) multimodaux (dont la famille Phi-3).

Windows Semantic Index désigne plus précisément le magasin vectoriel dans lequel toutes ces informations sont stockées. Microsoft affirme que le stockage est local et que les informations ne vont jamais sur ses serveurs. Il n’est pas clairement indiqué cependant que l’entreprise n’y accède jamais.

Les Vector Embeddings l'API Retrieval Augmented Generation (RAG) seront ajoutés plus tard dans l’année dans la bibliothèque Windows Copilot. En clair, les éditeurs tiers pourront proposer des compléments pour exploiter cette masse d’informations, afin de fournir des services supplémentaires.

Outre la question de la vie privée, on peut se demander si le fonctionnement de plusieurs SLM ne va pas entrainer une hausse de la consommation générale de la machine.

Un kit de développement Snapdragon

Qualcomm a profité de la Build pour annoncer son Snapdragon Dev Kit for Windows. Il contient un Soc Snapdragon X Elite légèrement plus rapide que la plus grosse référence présentée jusqu’ici. On y trouve ainsi 12 cœurs cadencés à 3,8 GHz, avec une fréquence turbo de 4,3 GHz (Microsoft évoque une édition spéciale pour développeurs). La puce est épaulée par 32 Go de LPDDR5x, 512 Go de stockage (SSD PCIe 4.0) et une alimentation 80W. Le kit peut supporter jusqu’à trois écrans.

Le kit peut être précommandé pour 899 dollars. Les livraisons et la disponibilité débuteront le 18 juin.

Et du côté de Visual Studio ?

Visual Studio Code for Education, actuellement en préversion, sera finalisé d’ici la fin du mois, avec disponibilité immédiate. Ce programme d’étude est conçu pour apprendre le développement logiciel, avec une accessibilité pour plusieurs plateformes ainsi qu’une version web. Plusieurs langages sont présents dans l’enseignement, dont le Python.

« Visual Studio Code for Education simplifiera le processus d'apprentissage grâce à une expérience d'édition de code rationalisée et optimisée pour l'enseignement. Il comprendra une fenêtre de contenu pour le matériel d'apprentissage, une interface utilisateur simplifiée et une présentation intuitive, ce qui permettra aux étudiants de maîtriser plus facilement les concepts essentiels de développement. La fonctionnalité de développement en un clic de la plateforme élimine tout obstacle à l'installation, ce qui permet aux étudiants de commencer à coder immédiatement », indique Microsoft.

En attendant, la préversion reste disponible, mais uniquement en anglais.

Puisque l’on parle de Visual Studio, la nouvelle mouture 17.10 de l’environnement intègre définitivement GitHub Copilot, jusqu’ici disponible sous forme d’extension. D’autres apports ont été présentés, comme l’utilisation de paramètres JSON pour la personnalisation de l’interface, les révisions du code assistées par IA, un meilleur support du débogage et du diagnostic, ou encore l’intégration de .NET Aspire. Ce dernier est disponible en version finale et doit faciliter le développement .NET de services cloud.

.NET 9 sera centré sur les performances

Concernant .NET, Microsoft continue son avancée vers la version 9, dont la Preview 4 est maintenant disponible. Il s’agit d’une version particulièrement axée sur les performances, qu’elles proviennent de C# 13 ou des autres composants. On note ainsi un nouveau ramasse-miettes entrainant une baisse de la consommation de mémoire, des exceptions gérées deux à quatre fois plus vite, des boucles plus rapides ou encore un code Arm64 prenant son envol grâce à la gestion des instructions SIMED SVE/SVE2 de l’architecture.

Build 2024 : Microsoft encourage la création de copilotes personnalisés

-

Team Copilot veut simplifier la collaboration et la gestion de projet

-

Copilot Studio : des agents, des connecteurs, des extensions

-

Azure AI Studio : pour construire son propre Copilot

-

Windows Copilot Runtime

-

Microsoft étoffe la famille Phi-3 de petits modèles

-

Recall : on en apprend un peu sur la vie privée

-

Un kit de développement Snapdragon

-

Et du côté de Visual Studio ?

-

.NET 9 sera centré sur les performances

Commentaires (7)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 23/05/2024 à 10h29

[Mode complotiste: ON] Une coïncidence ? Je ne pense pas [Mode complotiste: OFF]

Le 23/05/2024 à 15h48

Modifié le 23/05/2024 à 11h04

Le 23/05/2024 à 11h56

Mais quid de l'évolution de ces langages ? de la création de nouveau ? et du coup, de la capacité de ces IA ou bien à apprendre en temps réel la nouveauté, ou bien la créer ?

On part d'une base extrêmement solide de données, mais si la plupart des développeurs futurs n'utilisent que des IA, on restera en une version de Python fixe pour l’éternité ?

Le 23/05/2024 à 12h19

Et les langages qui sont compensé par du haut niveau se figeront un peu, histoire d’économiser le coût humain et le compensant par un coût machine même si moins optimisé.

On fait juste une boucle de plus.

Et le prompt generation tuera les copilotes d’aujourd’hui avec du plus haut niveau dans quelques années.

Le 23/05/2024 à 14h12

Le 23/05/2024 à 14h51