CPU Axion, TPU v5p, A3 Mega et Confidential, GPU Blackwell : Google tire (encore) tous azimuts

Accio Neoverse v2

Lors de sa conférence Cloud Next 2024, les annonces étaient en grande partie centrées sur l’intelligence artificielle. Sur la partie matérielle, Google travaille depuis longtemps sur des puces personnalisées et donc adaptées/optimisées à ses usages. Nous reviendrons dans un second temps sur les annonces logicielles.

Le 10 avril 2024 à 11h00

5 min

Hardware

Hardware

Axion : un CPU Google à base de Neoverse v2

Le géant du Net annonce ainsi « la dernière incarnation de ce travail : les processeurs Google Axion, nos premiers processeurs personnalisés basés sur Arm et conçus pour le centre de données ». Ils seront disponibles pour ses clients « dans le courant de l’année », sans plus de précision.

Comme bien d’autres avant – notamment NVIDIA avec Grace Hopper et Amazon avec Graviton4 – Google utilise des cœurs Arm Neoverse V2 (instructions Armv9) pensés pour les datacenters. Les v3 viennent pour rappel tout juste d’être annoncés par Arm, mais ne sont pas encore disponibles (et certainement pas avant des mois). Microsoft mise aussi sur Arm pour son processeur Cobalt 100, mais sur des Neoverse CSS (à base de N2 probablement).

Des promesses, mais pas de détails techniques

Google annonce que des instances avec Axion auront « jusqu’à 30 % de performances en plus par rapport aux instances basées sur Arm pour un usage général les plus rapides dans le cloud aujourd’hui, jusqu’à 50 % de performances en plus et jusqu’à 60 % d’efficacité énergétique en plus par rapport aux instances x86 comparables de la génération actuelle ».

Aucune précision n’est donnée sur les processeurs/SoC utilisés pour les comparatifs. Pas de détails techniques non plus sur la puce, comme le nombre de cœurs ou la quantité de mémoire cache.

Le fabricant indique simplement qu’Axion exploite le système de microcontrôleurs de sécurité Titanium. Il comprend des microcontrôleurs de sécurité Titan, des cartes d'accélération matérielle pour les services de virtualisation et des « processeurs de déchargement Titanium (TOP) » afin de « décharger le réseau et le traitement d'E/S du processeur hôte ».

Google précise que de nombreux services – BigTable, Spanner, BigQuery, Blobstore, Pub/Sub, Google Earth Engine et la plate-forme YouTube Ads– fonctionnent déjà sur des systèmes à base de cœurs Arm. L’entreprise prévoit de les migrer sur Axion et d’en ajouter de nouveaux.

De leur côté, les clients pourront « utiliser Axion dans de nombreux services Google Cloud, notamment Google Compute Engine, Google Kubernetes Engine, Dataproc, Dataflow, Cloud Batch… ». À Reuters, Mark Lohmeyer (vice-président de Google en charge du cloud) affirme que les clients pourront « facilement transférer leurs charges de travail existantes vers Arm ».

Disponibilité générale des TPU v5p

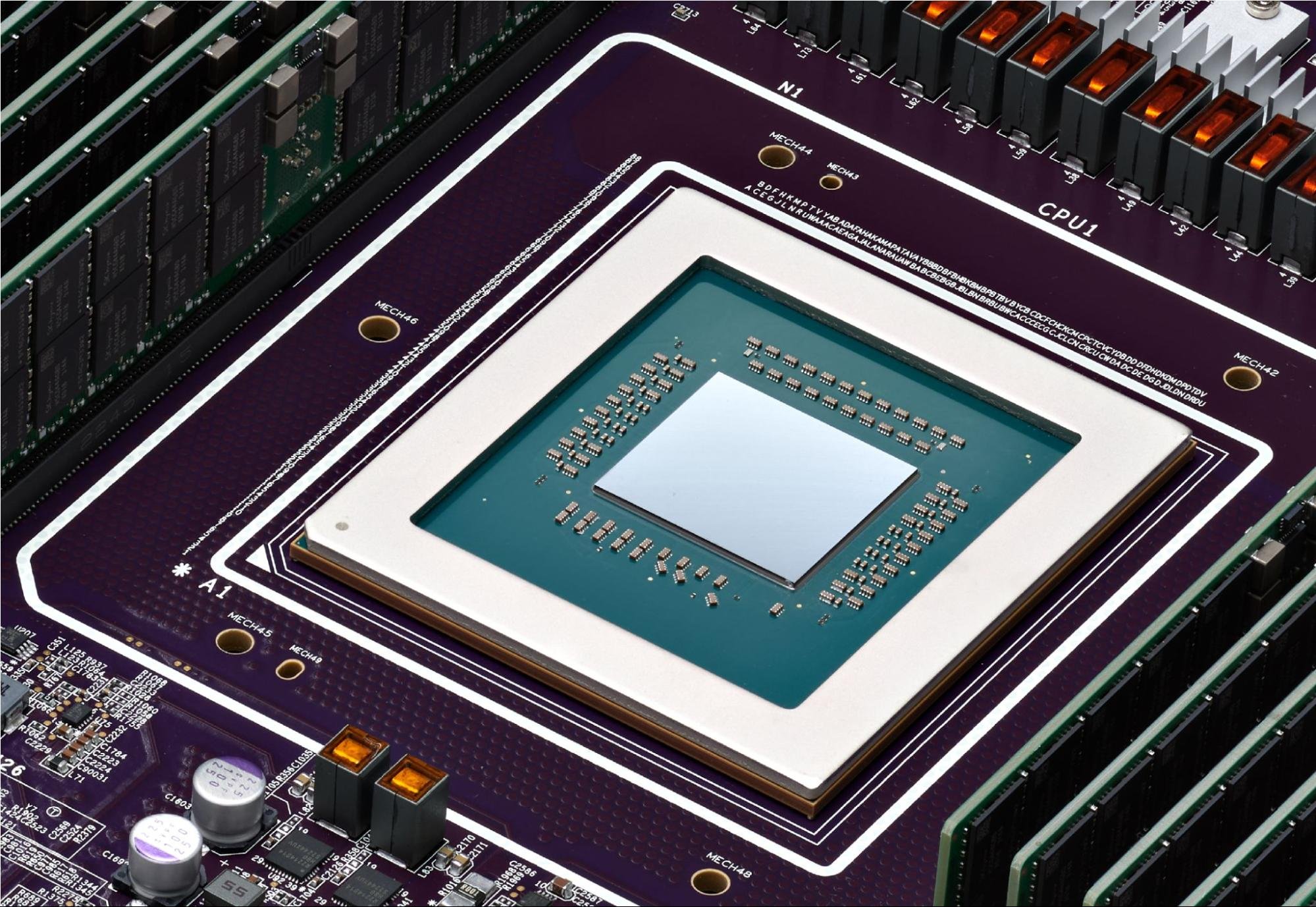

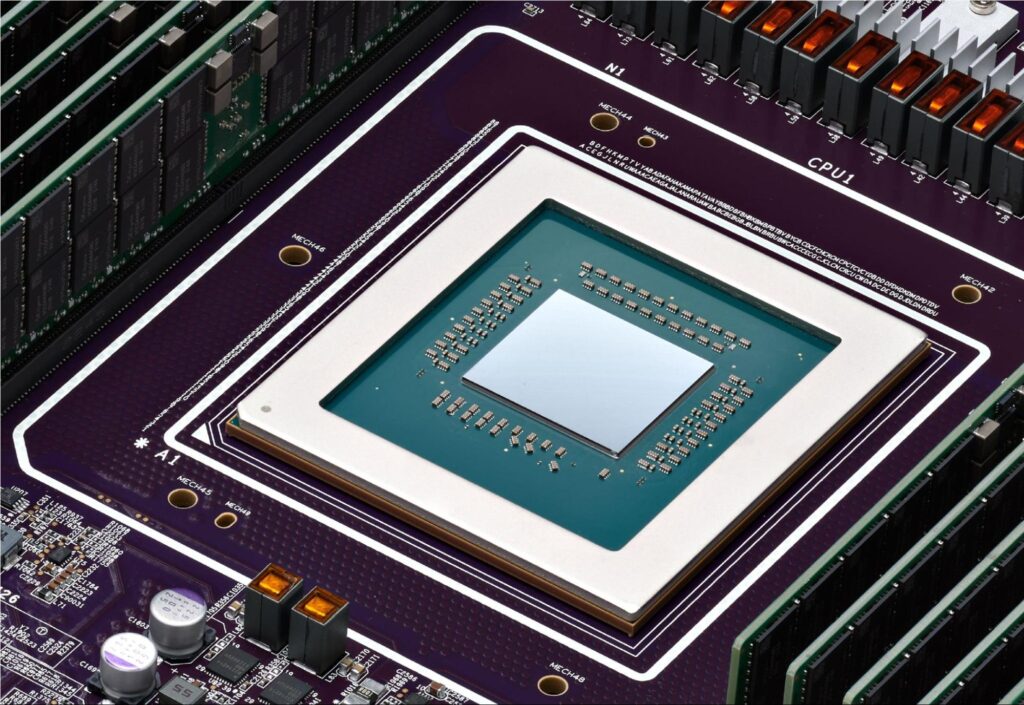

Google profite de sa conférence pour annoncer la disponibilité à tous de son dernier TPU v5p. Comme son nom l’indique, il s’agit de la cinquième génération de Tensor Processing Unit. Ce sont pour rappel des « circuits intégrés spécifiques aux applications (ASIC) conçus par Google pour accélérer les charges de travail de machine learning ».

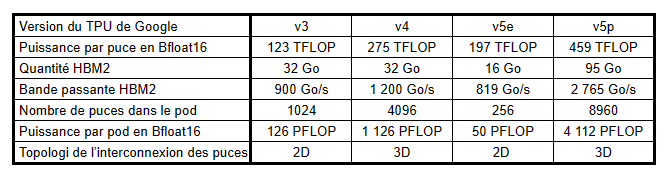

Les TPU v5e avaient été présentés lors du Cloud Next de l’année dernière et se plaçaient en dessous des v4 en performances brutes, mais sur une forte augmentation du rapport performances/prix, selon le fabricant.

Les v5p sont arrivés quelques mois plus tard, avec une hausse significative des performances. Chaque puce passe à 459 TFLOP en v5p contre 275 TFLOP en v4. 8 960 puces peuvent être interconnectées pour former un Pod avec une puissance de plus de 4 000 PFLOP. Voici un rapide résumé des caractéristiques techniques, avec un rappel des précédentes générations de TPU :

Crédits : Next.ink

Crédits : Next.ink

Instances A3 Mega et A3 Confidential

Restons dans les instances avec plusieurs autres annonces de Google. Tout d’abord, les A3 Mega avec des GPU H100 de NVIDIA seront « disponible le mois prochain » et proposeront deux fois plus de bande passante par GPU comparés aux instances A3.

« Nous annonçons également les instances A3 Confidential, qui permettent aux clients de mieux protéger la confidentialité et l'intégrité des données sensibles et des charges de travail d'IA pendant l’apprentissage et l'inférence ». Sur le même créneau, Microsoft a lancé pour rappel ses Confidential VM en novembre dernier.

Blackwell en 2025 dans Google Cloud

Enfin, Google ne pouvait pas passer à côté des nouveaux GPU Blackwell (B200) et du système GB200 NVL72 de NVIDIA. Ce dernier est pour rappel un assemblage de 18 Compute Node, chacun étant composé de deux GB200 (1x CPU Grace et 2x GPU B200 par GB200). Le système GB200 NVL72 comprend donc 36 CPU Grace et 72 GPU Blackwell B200. NVIDIA annonce jusqu’à 1 400 PFLOPS en FP4 (ou 1,4 EFLOPS, avec un E pour Exa).

Selon Google, « Le HGX B200 est conçu pour les charges de travail d'IA, d'analyse de données et HPC les plus exigeantes, tandis que le GB200 NVL72 permet l'inférence de grands modèles de langage en temps réel et des performances de haute volée pour la formation pour des modèles avec plusieurs milliards de paramètres ». Les deux arriveront en 2025 dans Google Cloud.

CPU Axion, TPU v5p, A3 Mega et Confidential, GPU Blackwell : Google tire (encore) tous azimuts

-

Axion : un CPU Google à base de Neoverse v2

-

Des promesses, mais pas de détails techniques

-

Disponibilité générale des TPU v5p

-

Instances A3 Mega et A3 Confidential

-

Blackwell en 2025 dans Google Cloud

Commentaires (3)

Le 10/04/2024 à 17h08

Et si c'est base ARM, ca veut dire qu'ARM touche des royalities dessus aussi ?

Le 10/04/2024 à 21h45

Mais d'un autre côté il y a moins de royalties pour Intel avec son x86, ils ne payent pas Intel foundries, et ils vont payer moins d'électricité.

Quand tu vois que NVIDIA vend ses puces 40 000 € et Intel 3 000 €, avec des royalties en centaines d'€ pour ARM et la facture EDF qui baisse, ils doivent s'y retrouver je pense.

Sinon ils ne le dépenseraient pas autant d'énergie pour convertir leurs DCs.

Le 18/04/2024 à 17h45

Ensuite pour l'inférence, t'as le choix entre le package nVidia et ... le package nVidia .. donc tu prends ... le package nVidia, avec son SoC Grace.

nVidia vends du Hooper et du Blackwell associé à Grace obligatoirement pour certains form factor et certains volumes de ventes.

Si tu veux la partie GPU, t'as forcément la partie SoC "en cadeau" alors t'adapte ton infra en conséquence.

nVidia est aujourd'hui largement devant avec son matériel et l'écosystème qu'il a réussi à mettre en place.

Pour cette raison qu'Amazon, Google et MS développent leurs propres APU et SoC.