Fugatto : l’IA « couteau suisse du son » selon NVIDIA

L'IA audio façon Oulipo

Des chercheurs employés par NVIDIA ont publié leurs premiers travaux relatifs à un nouveau modèle de fondation capable de modifier des sons existants sur la base d'instructions textuelles, mais aussi de générer des propositions sonores qui n'existaient pas dans les données d'entraînement.

Le 28 novembre à 12h00

4 min

IA et algorithmes

IA

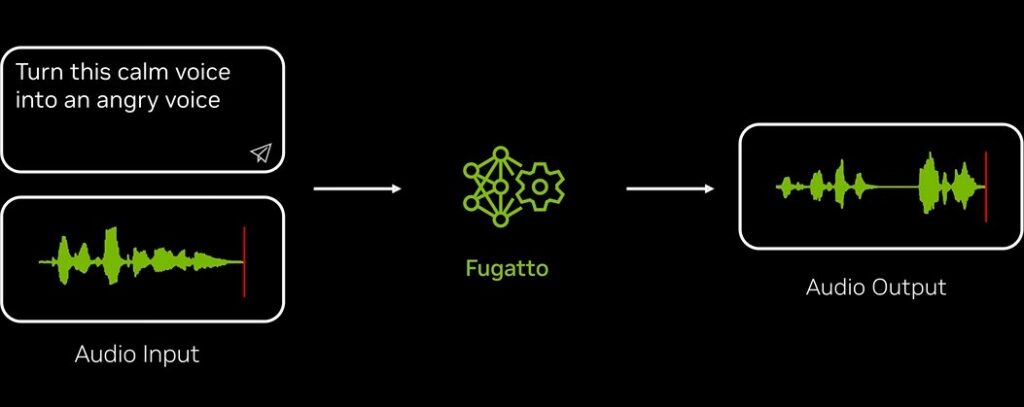

NVIDIA a publié mardi ses travaux relatifs à un nouvel outil d’IA générative, capable de synthétiser des sons complexes à partir d’instructions mêlant aussi bien du texte que des sons. Baptisé Fugatto, pour Foundational Generative Audio Transformer Opus 1, ce modèle de fondation n’est pour l’instant pas mis à disposition du public. L’équipe à l’origine du projet a cependant publié une série de courts extraits audio qui permettent de se faire une idée des possibilités offertes par ce que les chercheurs qualifient de futur « couteau suisse du son ».

« Synthétise un saxophone qui aboie »

Les exemples retenus illustrent les principales promesses de Fugatto : générer des sons à partir de descriptions textuelles, bien sûr, mais aussi modifier des enregistrements existants à partir d'instructions écrites, voire générer des sons qui n’existaient pas dans les données d’entraînement, avec des requêtes telles que « Synthétise un saxophone qui aboie et un saxophone qui miaule », ou « Conçois des machines d’usine qui hurlent dans une agonie métallique ».

Les chercheurs présentent Fugatto comme un framework, un environnement cadre dans lequel sont réalisées plusieurs tâches spécifiques dédiées respectivement à la synthèse du chant, de la voix et de la scène musicale.

Dans l’article scientifique qui accompagne leur projet (PDF), les chercheurs rappellent que les grands modèles de langage textuels délivrent des résultats très convaincants, même quand ils fonctionnent de façon non supervisée. Ils sont capables d’inférer les instructions à partir de la donnée fournie en entrée. « Cependant, de telles instructions sont généralement absentes dans le domaine audio », remarquent les auteurs. Ils expliquent avoir pallié cette lacune grâce à une « stratégie de génération de données et d’instructions à multiples facettes qui élargit considérablement la palette de tâches du modèle de génération audio ».

Inférence temporelle

Ils y ajoutent, comme chef d’orchestre, une « technique d’inférence temporelle », baptisée ComposableART. Elle est chargée de combiner les différentes instructions avant la sortie, pour éventuellement générer des paysages sonores évolutifs et moduler l'intensité des différents paramètres fournis en entrée. « Cette approche permet à Fugatto de gérer des opérations complexes basées sur des instructions, telles que l'interpolation fluide entre les instructions ou la négation d'instructions spécifiques pour exclure les effets indésirables », soulignent-ils.

Testé sous forme de modèles utilisant respectivement 800 millions, 1,4 milliard et 2,5 milliards de paramètres dans sa version complète, Fugatto a fait l'objet d'un entraînement sur un jeu de données réunissant 20 millions de lignes mêlant textes et sons issus de sources ouvertes, pour un total d'audio équivalent à environ 50 000 heures.

« Nous voulions créer un modèle qui comprenne et génère les sons comme le ferait un humain », résume Rafael Valle, l'un des membres de l'équipe d'une dizaine de personnes qui a planché sur Fugatto pendant un an.

Entre autres débouchés, les chercheurs imaginent qu'un éditeur de jeu vidéo pourrait faire appel à son modèle pour modifier à la demande des situations sonores en fonction des décisions du joueur. De la même façon, ils imaginent qu'une campagne de publicité, ou une session d'apprentissage de langues étrangères, pourrait être personnalisée en fonction du destinataire du message. « Imaginez un cours en ligne prononcé par la voix d’un membre de votre famille ou d’un ami », suggère NVIDIA.

Fugatto se positionne comme une alternative à des initiatives telles que AudioBox (porté par Meta), le modèle multimodal NExT-GPT d'OpenAI, ou d'autres projets de recherche comme UniAudio et VoiceLDM.

Fugatto : l’IA « couteau suisse du son » selon NVIDIA

-

« Synthétise un saxophone qui aboie »

-

Inférence temporelle

Commentaires (1)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousAujourd'hui à 12h47