[Interview] Promesses et limites de l’éthique de l’intelligence artificielle

Éthique et tech

![[Interview] Promesses et limites de l’éthique de l’intelligence artificielle [Interview] Promesses et limites de l’éthique de l’intelligence artificielle](https://cdn.next.ink/inpactv7/data-next/images/bd/wide-linked-media/12535.jpg)

Le 06 février 2023 à 15h39

10 min

Droit

Droit

Elle est célébrée par des scientifiques comme des acteurs privés en 2018, potentiellement relayée, désormais, par des projets de lois nationaux et internationaux. Mais aujourd'hui, quels défis recouvrent les réflexions sur l’éthique de l’intelligence artificielle ?

Magistrat en disponibilité employé au Conseil de l’Europe, Yannick Meneceur est aussi chercheur à l’université de Strasbourg où il termine une thèse sur l’éthique de l’intelligence artificielle (IA).

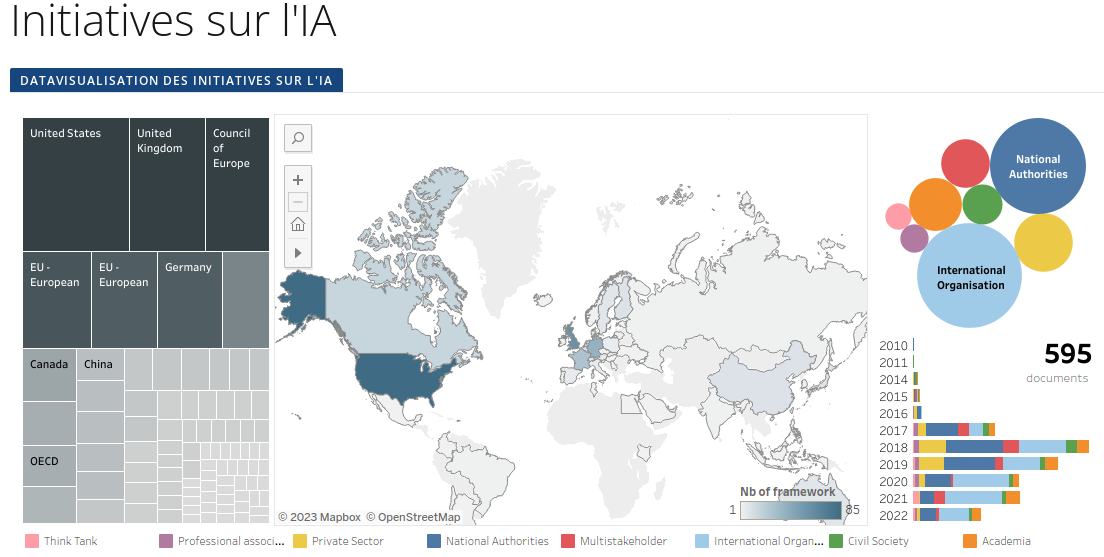

Alors qu’il annonce terminer le travail de recension qui lui a permis d’explorer 595 documents produits aussi bien par des représentants de la société civile, du monde académique, du secteur privé, que par des organisations étatiques, internationales, ou encore par des groupements multipartites, nous lui avons posé quelques questions sur l’état des débats autour de l’éthique de l’intelligence artificielle.

- Les CNIL européennes rendent leur avis sur le projet de règlement sur l’IA

- La Commission européenne propose de nouvelles règles pour une IA « digne de confiance »

« Quand j’ai rejoint le Conseil de l’Europe, en 2014, j’ai commencé par travailler pour la Commission européenne pour l’efficacité de la justice », raconte le magistrat. Au sein de l’entité, en charge d’améliorer « l’efficacité et le fonctionnement de la justice dans les États membres », Yannick Meneceur se met à étudier les projets informatiques liés à la justice prédictive que différentes magistratures adoptent à travers le continent.

« Au départ, j’étais assez fasciné par ce que j’observais. Mais en soulevant le capot, on a rapidement réalisé que beaucoup de ces machines utilisaient des statistiques simples et du traitement automatique de la langue (TAL) de manière un peu désordonnée. » L’équipe s’attelle donc à la rédaction puis à la proposition d’une charte européenne d’utilisation de l’intelligence artificielle dans les systèmes judiciaires, un texte non contraignant adopté en décembre 2018.

Quand le champ de l’éthique de l’IA montre ses limites

2018, se rappelle le magistrat, c’est aussi l’année où l’éthique de l’intelligence artificielle prend une importance jusque-là inégalée. L’année précédente, Microsoft s’est doté de principes pour une conception éthique de l’intelligence artificielle. Bientôt, Google puis Facebook lui emboîtent le pas :

« À l’époque, l’idée même de textes contraignants sur le développement de l’IA paraissait saugrenue. Le secteur estimait assez largement que pour protéger l’innovation et ne pas ralentir les progrès économiques et sécuritaires, il fallait éviter de mettre en place des régulations. »

Avec ses collègues, Yannick Meneceur travaille tout de même à l’idée d’un cadre et à la création d’un Comité intergouvernemental sur l’intelligence artificielle. « On est entré dans le sujet par l’angle de l’éthique, pour convaincre les gouvernements, petit à petit, qu’il fallait aller un peu plus loin. » À la même période, le nombre de textes académiques estimant que l’éthique est insuffisante pour encadrer le développement des algorithmes se fait croissant, note le juriste, citant notamment le travail de l’Oxford Internet Institute.

- La science aux limites de l‘éthique, Zuckerberg et Musk en prennent pour leur grade

- Google, IA et éthique : Margaret Mitchell annonce avoir été licenciée

Fin 2019, un article vient enfoncer le clou : dans the Intercept, le chercheur en sciences sociales et techniques Rodrigo Ochigame décrit comment la prestigieuse université du MIT sert de « blanchisseuse » aux Big Tech. En finançant toutes sortes de travaux sur l’éthique de l’intelligence artificielle, celles-ci se donnent le beau rôle et orientent la recherche dans le sens qui les arrange.

Un an plus tard, Mohamed et Moustafa Abdalla soutiendront une thèse similaire dans un article de recherche étudiant les fonds déversés par les géants numériques dans la recherche scientifique.

Répondre à l’explosion du secteur avec des outils précis

Quoi qu’il en soit, l’intérêt pour l’IA du secteur économique et des gouvernements appartenant au Conseil de l’Europe ne s’éteint pas. Ces derniers sont préoccupés par trois grandes questions, résume Yannick Meneceur :

- le respect des droits fondamentaux ;

- la concurrence mondiale – « La logique étant de dire : si on ne s’y met pas, les États-Unis et la Chine vont le faire, explique le chercheur. De ce point de vue, l’arme réglementaire peut être facteur de concurrence, puisqu’elle peut obliger des acteurs extérieurs potentiellement très avancés technologiquement à s’aligner sur nos exigences de respect des droits fondamentaux » ;

- et la question sécuritaire – « les systèmes algorithmiques sont perçus comme présentant de nombreux avantages en termes de sécurité publique. Il leur semble donc impensable de ne pas tester et investir des solutions proposant de la reconnaissance faciale, par exemple, pour alimenter le sentiment de sécurité. »

En parallèle, Yannick Meneceur répertorie une grande partie des productions qui continuent d’être publiées sur l’éthique des algorithmes (dans la limite d’un « fort biais occidental », précise-t-il). Il y repère trois grandes préoccupations.

La première concerne la transparence des modèles : « c’est un sujet lié à l’exploitabilité des systèmes, notamment ». Un autre axe de travail concerne la responsabilité « des constructeurs, des entreprises qui utilisent les modèles, etc. » Le troisième angle récurrent est celui des droits humains, « qui sont toujours perçus et utilisés comme le socle de la démarche éthique. Les questions de respect de la vie privée y sont souvent liées ».

Transparence et responsabilité

Un des reproches qui revient fréquemment dans ces documents porte sur la gestion des discriminations. « On sait qu’il y en a, mais elles ne sont pas recherchées par les constructeurs ».

Et de citer le cas emblématique du logiciel COMPAS (pour Correctional Offender Management Profiling for Alternative Sanctions – profilage de la gestion des délinquants en milieu correctionnel pour les sanctions alternatives), développé par Northpointe (devenue Equivant), utilisé depuis 2001 par les forces de police américaines pour évaluer le risque de récidives de délinquants. Ce n’est qu’en 2016, avec l’enquête du média ProPublica, que les biais racistes récurrents de la machine seront mis au jour.

Les logiques de transparence et de responsabilité sont « centrales » pour pallier ce type de problématiques, estime Yannick Meneceur. « La force publique pourrait se tourner vers des logiques de certification et de labellisation des systèmes ».

Ces logiques, qui ont déjà cours dans l’industrie, « répondent au problème concurrentiel que poserait l’obligation de permettre à tout le monde de venir observer le fonctionnement de la machine, mais qui assureraient tout de même d’avoir l’audit d’un tiers. »

Mais ce qui inquiète Yannick Meneceur, c’est l’ « énorme confusion » qui peut exister chez toutes sortes d’acteurs entre questions d’éthique et problématiques de droits humains ou de vie privée – qui, elles, « relèvent directement du droit ».

Dans les discussions sur les recommandations de l’Unesco sur l’éthique de l’intelligence artificielle, « certains états voulaient placer les droits humains au même niveau que de grands principes éthiques, alors que ce sont des socles », illustre-t-il.

Les textes éthiques sont non contraignants : contrairement à des lois, ils ne proposent pas de sanction directe en cas de manquement. La complexité des débats autour de l’éthique des algorithmes, c’est donc qu’ils sont utiles et importants, mais qu’ils « peuvent être instrumentalisés pour édulcorer les droits humains » constitue le chercheur. Un risque est qu’ils soient détournés pour « niveler par le bas des éléments fondamentaux ».

De l’éthique aux cadres légaux

Au gré de son travail pour la rédaction de son essai L’intelligence artificielle en procès - Plaidoyer pour une réglementation internationale et européenne (Bruylant, 2020) puis pour sa thèse, Yannick Meneceur a ainsi vu les avis évoluer :

« Au début, il semblait hautement improbable que des régulations contraignantes voient le jour, aussi les textes éthiques ont semblé utiles pour pousser des axes de régulations et des valeurs précises dans les activités des entreprises. »

Au fil de son travail, le chercheur découvre des démarches « sincères, très bien faites ». Il prend pour exemple la déclaration de Montréal pour un développement responsable de l’IA, réalisée « grâce à de vrais mécanismes de consultation publique, une logique de démocratie participative réelle ».

Mais ces initiatives n’ont pas empêché l’émergence d’autres applications d’IA, bien plus contestables. En Californie, par exemple, le juriste cite un projet déposé pour remplacer le paiement d’une caution par une estimation du dossier de la personne gardée à vue par un système algorithmique de « prédiction » du risque criminel :

« Des partenariats entre intérêts économiques, recherche et société civile permettent aux constructeurs d’arriver avec une grille éthique maison et de dire, en gros, "n’ayez pas peur de nos algorithmes". »

Sauf que les études sur le sujet sont claires : « utiliser des mathématiques pour tenter de prédire la criminalité est une pente glissante. Les politiques devraient prendre la responsabilité de dire que scientifiquement, ça ne fonctionne pas ».

Les législateurs éviteront-ils les pièges ?

Yannick Meneceur salue d’ailleurs le travail engagé par l’Union européenne pour créer une directive sur l’IA. Comme les autres travaux législatifs engagés dans le monde, celui-ci témoigne de l’évolution des points de vue sur la régulation du secteur.

Mais le magistrat émet des réserves sur l’usage adopté pour le moment par la Commission européenne de sa classification des systèmes algorithmiques entre différentes classes de risques (inacceptables, élevés, acceptables et risques minimes).

« Des technologies proposant de la détection du mensonge ou des émotions sont pour le moment considérées comme des applications à haut risque alors qu’il n’y a même pas de bases solides pour prouver qu’elles fonctionnent. » Il évoque les technologies de reconnaissance biométrique testées aux frontières européennes : « Qu’est-ce qu’on détecte vraiment avec ça ? Qu’est-ce qui provoque l’émotion, le stress que la machine enregistre ? »

Des chercheuses comme Kate Crawford et d’autres s’inquiètent de voir dans ce type de technologies le retour de pseudo-sciences très discriminantes comme la physiognomonie. « Or, comment blanchit-on des technologies dangereuses ? Ça peut être par des travaux éthiques détournés de leur fonction première, mais ça peut aussi être en les plaçant dans des listes d’outils présentant des dangers alors qu’il serait possible de simplement les évacuer. »

Yannick Meneceur se dit inquiet à l’idée que les législateurs tombent dans le piège qui a déjà été tendu aux réflexions éthiques. Et se fait l’avocat du temps long : « On a besoin de tester plus ces technologies, d’attendre qu’elles atteignent une certaine maturité, avant d’envisager de les mettre sur le marché. »

Or, pour certains modèles, notamment ceux reposant sur de la biométrie, « on est en train d’essayer de négocier avec les droits humains sur la base de technologie dont les effets ne sont même pas encore certifiés. »

Retrouvez ici la datavisualisation des publications relatives à l’éthique de l’intelligence artificielle recensées par Yannick Meneceur.

[Interview] Promesses et limites de l’éthique de l’intelligence artificielle

-

Quand le champ de l’éthique de l’IA montre ses limites

-

Répondre à l’explosion du secteur avec des outils précis

-

Transparence et responsabilité

-

De l’éthique aux cadres légaux

-

Les législateurs éviteront-ils les pièges ?

Commentaires (5)

Le 06/02/2023 à 16h17

Je ne vais pas trop me leurrer sur les promesses éthiques.

Au final, ces règles éthiques seront transcrites en texte légaux. La tentation va être grande pour chaque pays de faire prévaloir ses intérêts (économiques, militaires, politiques…) plutôt que réfléchir à rationaliser de grands principes moraux.

Si nos dirigeants doivent s’entendre pour trouver un cadre commun, ca sera certainement sur leur domaine de compétence et d’intérêt… donc pas vraiment sur la morale :)

Le 06/02/2023 à 21h21

Google dévoile son rival de ChatGPT, un robot conversationnel baptisé Bard (20mn, 6/02/23)

Le 07/02/2023 à 05h55

Ah ben j’espère qu’il sera utilisable gratuitement comme ChatGPT, pour pouvoir comparer les 2 :)

Le 07/02/2023 à 09h14

Ce n’est certainement pas la limitation principale de ChatGPT, ce n’est qu’un détail, facile à corriger. ChatGPT a des problèmes autrement plus graves comme l’impossibilité d’évaluer ses réponses (« il me semble que mais je ne suis pas sûr ») ou comme le fait qu’il invente des réponses aberrantes.

Le 07/02/2023 à 09h47

Oui, d’ailleurs, dans l’article Un juge colombien a utilisé ChatGPT pour rendre une décision de justice, on lit :

Qu’en sera-t-il de Bard ?