Gen11 : Intel donnera le coup d’envoi le 20 mars

De quoi tuer les GPU d'entrée de gamme ?

Le 04 mars 2019 à 07h30

3 min

Hardware

Hardware

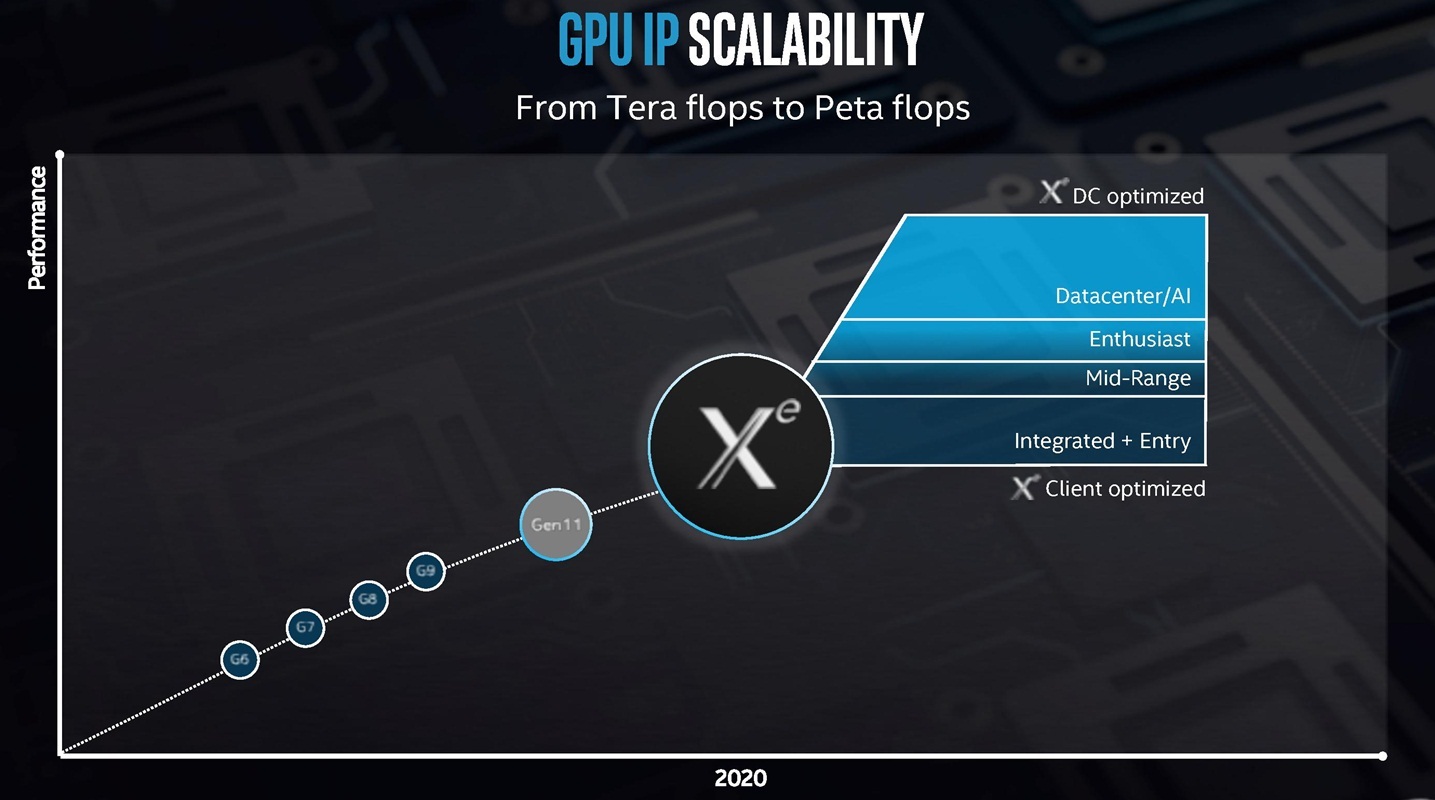

Alors que tout le monde attend des nouvelles de son GPU Xe, Intel se prépare pour un lancement à la GDC, conférence de presse à la clé. Il ne devrait pourtant être presque que question du nouveau GPU intégré Gen11, beaucoup plus puissant que les générations précédentes.

L'équipe marketing d'Intel est à fond ! « Ce n'est pas une conférence de presse, c'est une odyssée » a ainsi tweeté Chris Hook il y a quelques jours, faisant référence au nouveau slogan maison.

Il y évoque le 20 mars, date à laquelle le géant de Santa Clara tiendra une conférence de presse, en pleine Game Developers Conference. Le sujet ? Pas le GPU Xe rappelle Hook, mais bien Gen11. Il s'agit de la dernière évolution de l'architecture graphique d'Intel, préparée ces dernières années et devant intégrer les CPU Ice Lake.

Elle ne devrait pas beaucoup porter la trace de la nouvelle équipe mise en place ces derniers mois, si ce n'est au niveau marketing, mais doit servir de tremplin pour l'arrivée de Xe en 2020. La communication s'accélère donc.

Avec Gen11 tout sera plus mieux

Ces derniers jours, des « fuites » de scores sont venues alimenter les informations concernant les performances de ce produit, qui seraient bien plus importantes. Et pour cause, plutôt que 24 unités de traitement, un IGP Gen11 pourra en intégrer jusqu'à 64 (+ 166,7 %). Reste à voir avec quel impact sur la taille du die, quelle fréquence et quelle consommation.

Cela devrait néanmoins permettre à Intel de venir lutter avec les APU Ryzen, alors qu'AMD prépare sa nouvelle génération de puces gravées en 7 nm.

C'est également sur le terrain multimédia où Intel devrait attaquer, alors que NVIDIA vient de renforcer son moteur de (dé)compression vidéo NVENC, qui peut être exploité aussi bien par les joueurs pour la diffusion de parties en direct, que dans le secteur professionnel. Intel y propose d'ailleurs déjà des outils.

Teasing, teasing, teasing

Ces derniers jours, la société revient donc avec insistance sur ces points, évoquant la qualité d'image, les performances, la gestion des espaces colorimétriques, etc. Il est aussi question de besoins plus orientés grand public comme le support de plusieurs écrans, d'adaptive sync ou du HDR, mis en avant dans le cadre de l'utilisation de Netflix.

Une chose est sûre : il faudra attendre encore quelques semaines avant d'en savoir plus et d'avoir droit à des informations plus concrètes, et plusieurs mois avant que les produits ne soient effectivement disponibles. Espérons que d'ici là, nous aurons enfin des nouvelles des pilotes et du panneau de contrôle « nouvelle génération ».

Gen11 : Intel donnera le coup d’envoi le 20 mars

-

Avec Gen11 tout sera plus mieux

-

Teasing, teasing, teasing

Commentaires (3)

Vous devez être abonné pour pouvoir commenter.

Déjà abonné ? Se connecter

Abonnez-vousLe 04/03/2019 à 12h35

Gneuh ? 64 / 24 = 2.667

Je pense que c’est +166,7%, il manque le 1 ^^’

Source: https://www.linleygroup.com/mpr/article.php?id=12091

Le 04/03/2019 à 13h18

Merci, typo corrigée. Mais il y a un bouton pour signaler les erreurs ;)

Le 08/03/2019 à 14h56

Mouais, ça restera du GPU bas de gamme qui rame partout et qu’on nous refourguera sur la moitié des laptops.

Sur mon laptop j’ai qu’un Intel HD 4600 et c’est juste bon pour afficher l’OS. Pour la 3D et les jeux il faudra repasser, ou accepter d’avoir un affichage bien buggué avec 3 FPS.

Déjà le concept de se servir de la RAM du CPU pour le GPU est bien pourrave.

Je ne vois pas pourquoi Intel s’acharne avec ses GPUs moisis.

Si seulement il existait des cartes graphiques externes performantes et abordables, ce serait déjà mieux.