Suivre au quotidien la modération des très grandes plateformes listées par le DSA

Flock

Avec le DSA, les très grandes plateformes en ligne – TikTok, Twitter, Wikipédia, Stripchat... – doivent fournir des données sur les suppressions ou les restrictions d'accès aux contenus qu'elles publient. La Commission a mis en place un outil pour les suivre au quotidien.

Le 06 février 2024 à 16h50

6 min

Droit

Droit

La liste des très grandes plateformes en ligne (VLOP) et très grands moteurs de recherche en ligne (VLOSE) a été publiée au Journal officiel de l'Union européenne ce lundi 5 février, sans modification depuis l'ajout de Pornhub, Xvideos et Stripchat en décembre dernier.

L'article 17 du DSA les contraint à informer clairement leurs utilisateurs qui ont signalé un contenu sur leur décision et leurs motifs. Et l'article 24 les oblige à envoyer tous ces motifs à la Commission.

Base de données des motifs

Celle-ci a mis en place une base de données pour regrouper les exposés des motifs. Elle est toujours en développement, mais on peut télécharger ces exposés de motifs regroupés chaque jour dans un fichier zip.

Les motifs peuvent être d'ordre légal ou d'incompatibilité avec les CGU de la plateforme. Pour chacun des exposés, les informations comprennent, entre autres, la restriction mise en place, le ou les motifs, les faits et le contexte de la décision de modération.

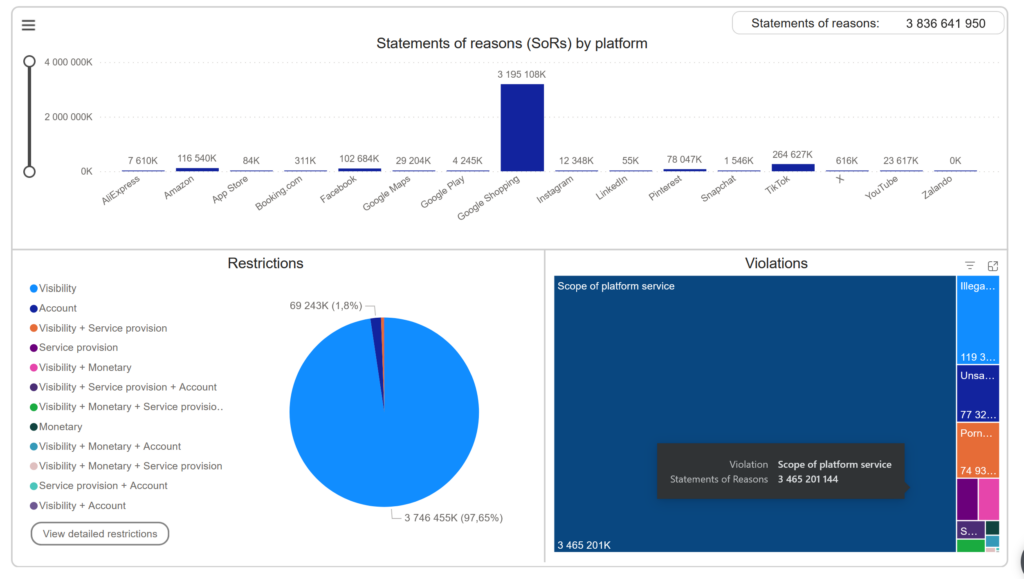

Ce dernier mois, chaque jour, entre 40 et 150 millions des décisions figurent dans ce fichier zip. Et depuis le 25 août – date à laquelle la conformité au Digital Services Act (DSA) a commencé à être imposée – , plus de 3,7 milliards de décisions ont été justifiées et envoyées à la commission par les plateformes.

Mais une grande disparité apparait entre elles. Google Shopping représente la plupart de ces décisions, et de loin : 3,1 milliards à lui seul. La plateforme de vente de Google noie donc la base de données de ses décisions.

Visualiser en direct

Comme tout le monde ne va pas télécharger tous les jours le lourd fichier des exposés des motifs (7 Go zippé, 156.75 Go le fichier csv, pour la date qui rassemble le plus de décisions), la Commission propose un « tableau de bord ». Cet outil de visualisation permet d'entrer dans les détails de ces décisions en utilisant Power BI de Microsoft. Par défaut, les graphiques représentent tous les motifs de décision pris par les plateformes depuis le 25 septembre 2023, un mois après la date pour laquelle le DSA les oblige à être en conformité.

On peut remarquer que Pornhub, Xvideos et Stripchat ne sont pas (encore ?) dans la liste. Elles ont été ajoutées à la liste des VLOP il y a un peu plus d'un mois.

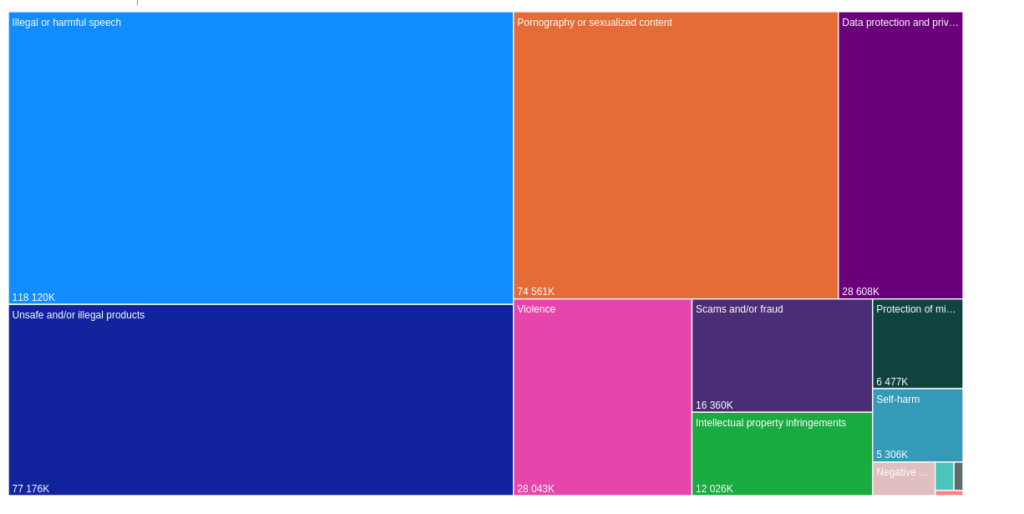

Principalement des propos illégaux ou nuisibles

Comme nous l'indiquions, les graphiques affichés par défaut (notamment ceux en première page du tableau de bord) sont noyés par les décisions de Google Shopping. La plupart de celles-ci sont motivées par des contenus non conformes au service de la plateforme (Scope of platform service).

Si l'on exclut cette raison, le motif le plus utilisé par les plateformes est que le discours serait « illégal ou nuisible » (118 millions), suivi par un contenu considéré comme pornographique ou sexuel (74,6 millions), puis par des produits illégaux ou dangereux. 28,6 millions des décisions de modération seraient motivées par la protection de données privées et presque autant seraient des contenus violents.

Le scam et la fraude ne représenteraient que 16 millions des contenus concernés. Il y aurait eu 12 millions de contenus considérés comme des infractions à la propriété intellectuelle sur ces plateformes. Et 6,5 millions de contenus signalés seraient modérés pour des questions de « protection des mineurs ».

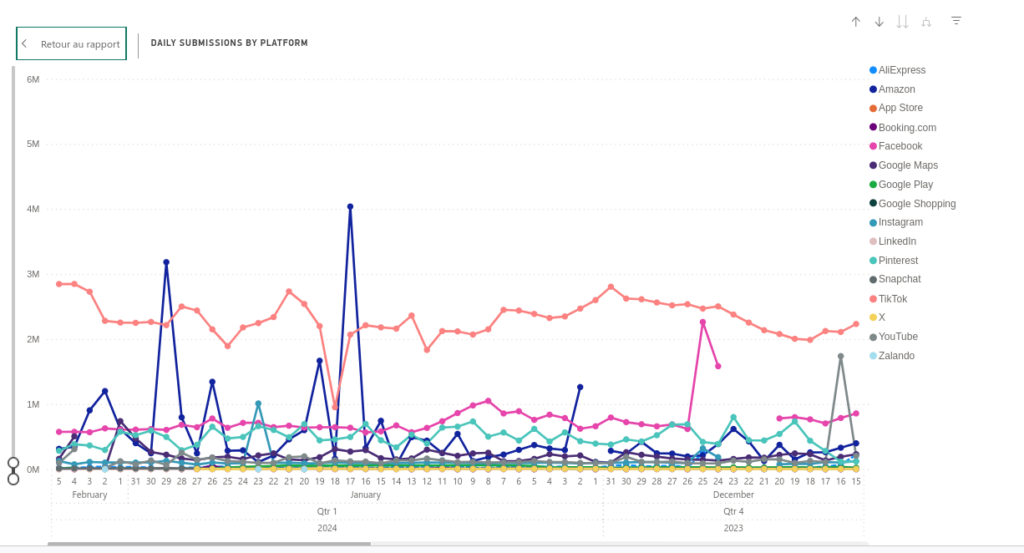

Toujours sans prendre en compte Google Shopping, TikTok est la plateforme qui fait remonter le plus de décisions à la Commission (entre 2 et 3 millions par jour), suivi par Facebook et Pinterest avec moins d'un million par jour. On peut remarquer que certaines plateformes, comme Facebook et Amazon, ont eu des trous de quelques jours dans les relevés. Du côté de X (ex-Twitter), les signalements remontés à la Commission ne dépassent généralement pas les 10 000 par jour et n'apparaissent plus depuis le 28 janvier.

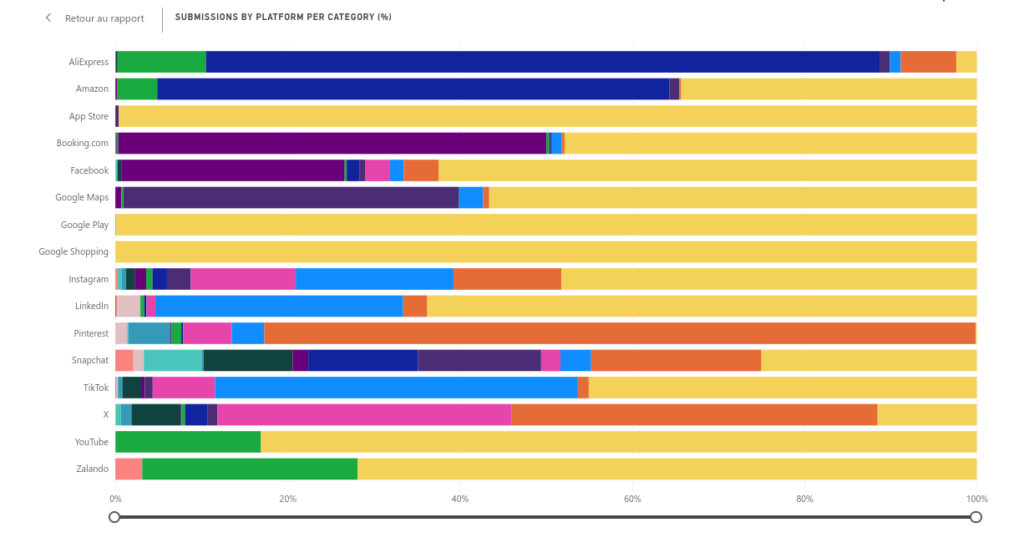

Essentiellement des produits illégaux et dangereux sur les sites de vente

Le « tableau de bord » de la commission contient aussi une visualisation des modérations selon les plateformes. Ce graphique permet bien de voir que Google Shopping ainsi que Google Play et l'App Store ne s'embarrassent pas de justifier réellement leur modération. Ces trois plateformes considèrent par défaut que les contenus modérés ne sont pas conformes à leur service (en jaune).

Pour les sites d'achats en ligne hors Google Shopping, AliExpress et Amazon modèrent essentiellement des produits illégaux ou dangereux (en bleu) et un peu pour des raisons de propriété intellectuelle (en vert). Zalando ne recense pas de modération de produits illégaux ou dangereux (mais ceux-ci peuvent être cachés dans les contenus non conformes à son service, comme pour Google Shopping).

10 % des contenus modérés pour « protection des mineurs »

Du côté des réseaux sociaux, 10 % des contenus modérés par Snapshat le sont pour « protection des mineurs ». Il faut remarquer que cette plateforme est la seule à ne pas mettre ses modérations dans la catégorie très pratique et vague de « non conformes à son service ». Sortir honnêtement les modérations de cette catégorie en fait apparaître d'autres, plus problématiques.

Chez Pinterest, les contenus modérés pour pornographie et sexe (82 %) ressortent. Le site de publication d'images modère aussi beaucoup de contenus d'automutilation (5 %) et de violence (5 % également).

Pour TikTok, Linkedin et Instagram, les discours de haine ou illégaux sont les plus modérés (respectivement à 42 %, 29 % et 18 %).

Si le nombre de modérations chez X doit nous faire relativiser les données collectées ici, le réseau social fait remonter 42 % de contenus modérés pour pornographie, 34 % pour violence et 5,75 % pour protection des mineurs.

Sur la plateforme de vidéo YouTube, l'essentiel des modérations, quand elles ne sont pas rangées dans la catégorie « non conformes au service », est effectué pour infractions à la propriété intellectuelle.

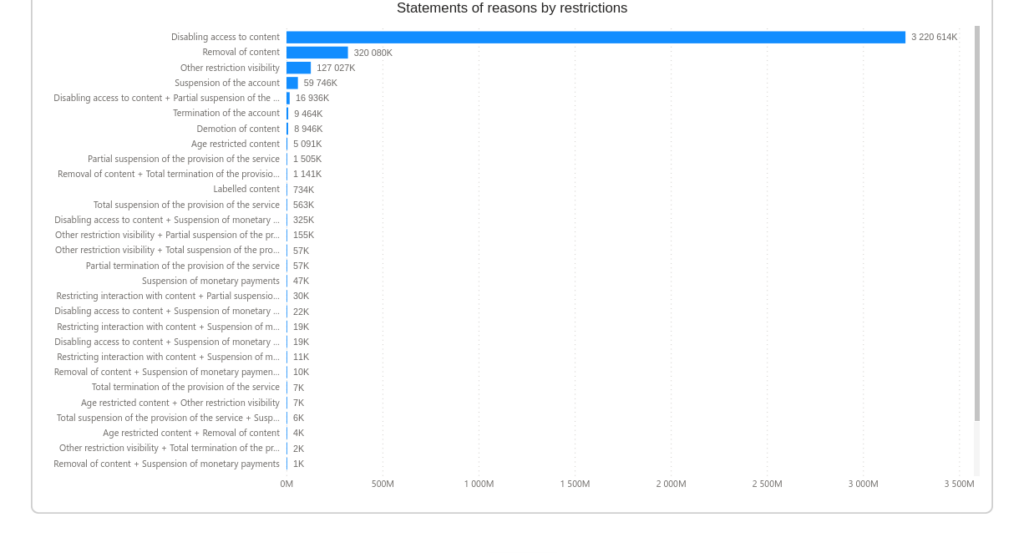

Le blocage de l'accès au contenu comme principale mesure

Dans les données collectées par la Commission, la plupart des décisions de modération résultent, si la plateforme considère qu'il y a lieu de modérer, en un blocage de l'accès au contenu ou la suppression complètement du contenu (mais dans une moindre mesure).

Suivre au quotidien la modération des très grandes plateformes listées par le DSA

-

Base de données des motifs

-

Visualiser en direct

-

Principalement des propos illégaux ou nuisibles

-

Essentiellement des produits illégaux et dangereux sur les sites de vente

-

10 % des contenus modérés pour « protection des mineurs »

-

Le blocage de l’accès au contenu comme principale mesure

Commentaires (3)

Le 06/02/2024 à 19h55

1. s'il y a eu intervention humaine (si oui, ça peut être intéressant de voir si c'est signicatif, ou si comme je l'imagine l'écrasante majorité est purement du fait d'algorithmes)

2. s'il y des méta-données qui permettent de reconstruire un tant soit peu le contenu (titre, mots-clés, liens divers)

Sinon, l'intégration d'une vue Power-Bi, c'est facile à faire ? Si oui, sans 36 trackers Microsoft?

Hâte de découvrir vos prochains articles sur le sujet si les données sont intéressantes et réellement exploitables.

Le 06/02/2024 à 20h33

Effectivement, il y a un champ "Automated Detection" et un autre "Automated Decision".

Pour l'intégration du Power-Bi, j'ai bricolé un peu et j'ai oublié de regarder les trackers. Y en a pas 36 mais y en a quand même 6 selon Kimetrak. Il faudra que je vois demain si je peux faire autrement ou si je le retire.

Le 07/02/2024 à 13h52